Scraperr : outil de scraping de données web auto-hébergé

Introduction générale

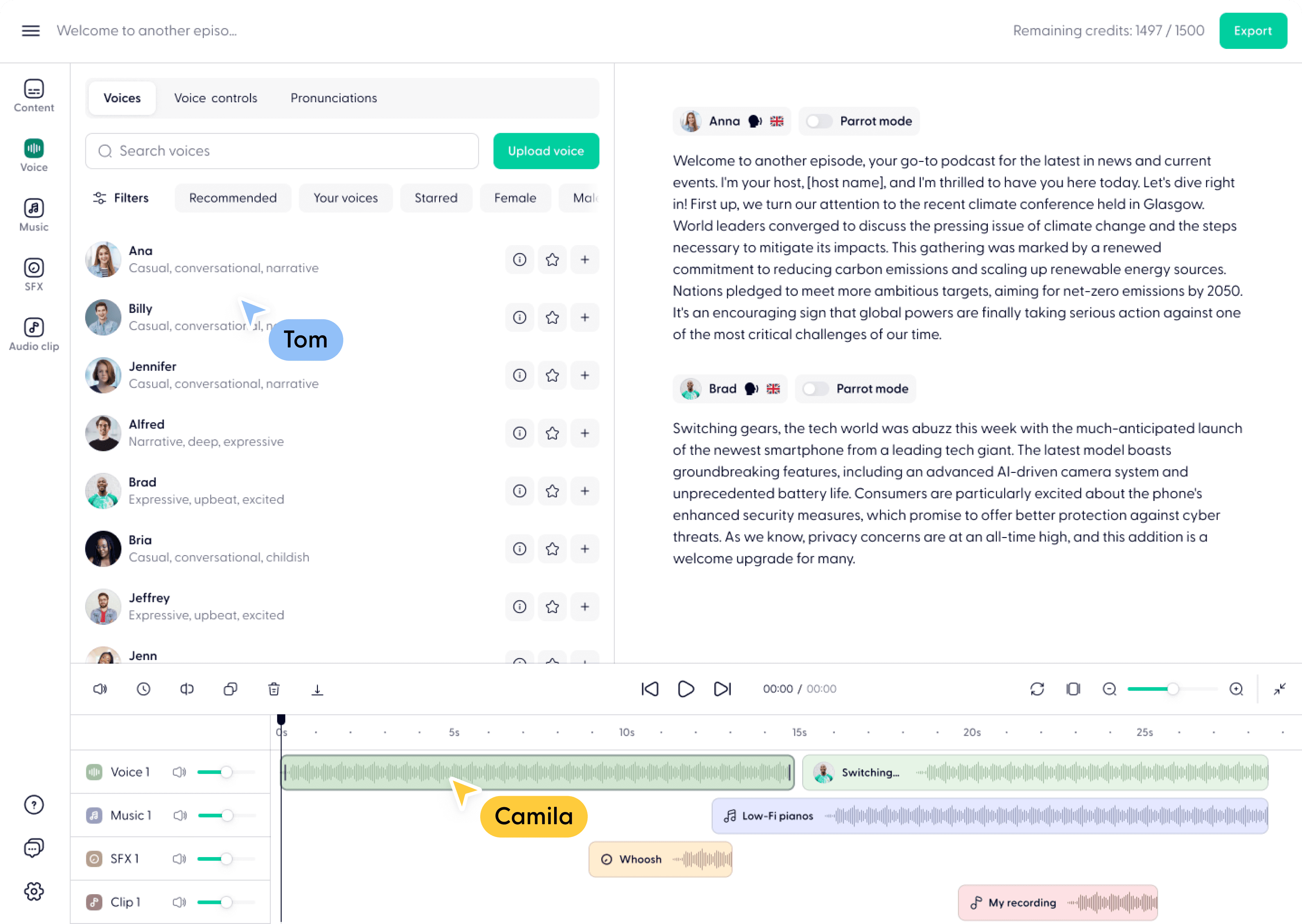

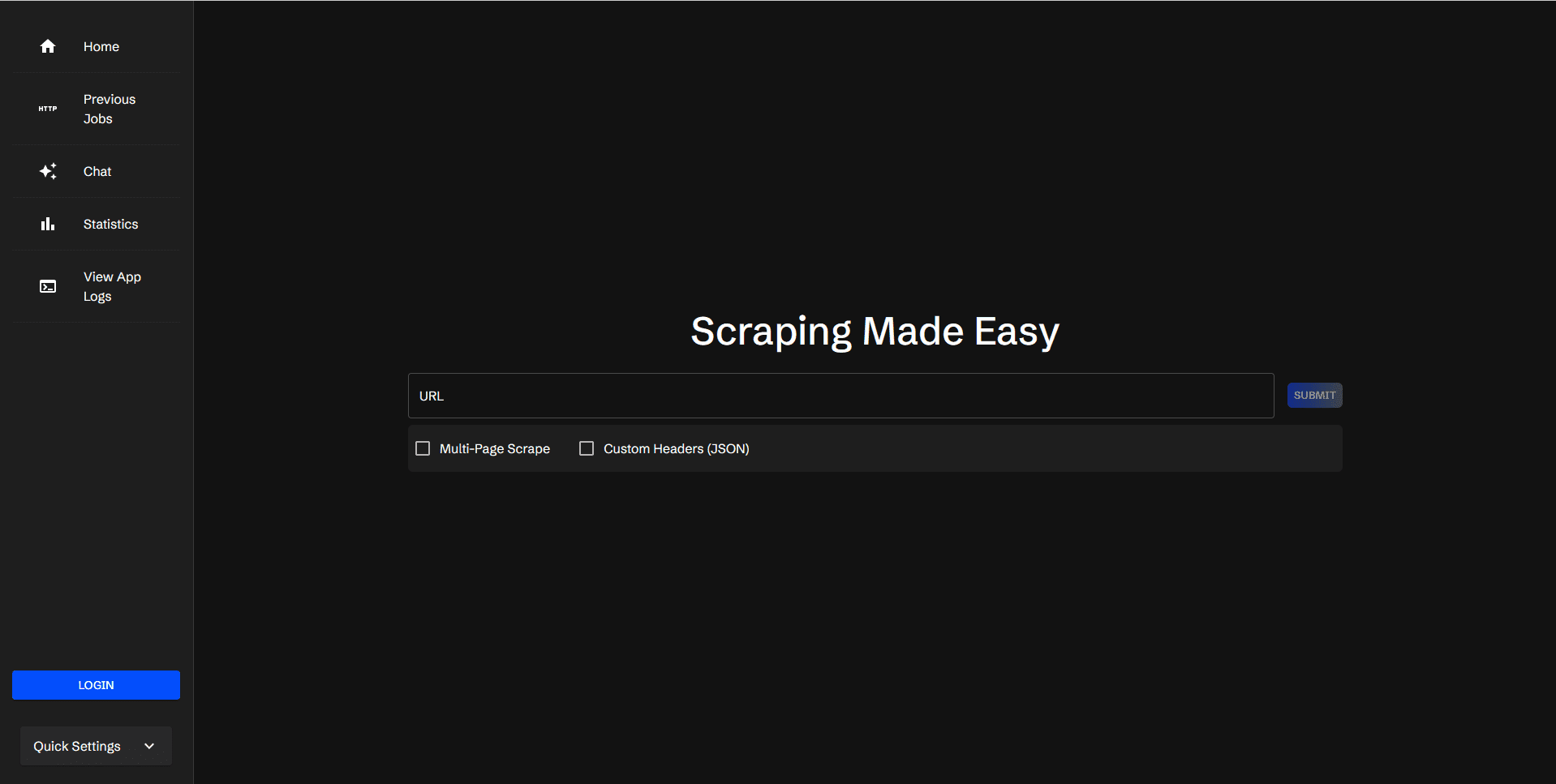

Scraperr est un outil d'exploration de données web auto-hébergé qui vous permet de spécifier des éléments XPath pour explorer des données web. Les utilisateurs soumettent une URL et les éléments d'exploration correspondants, et les résultats sont affichés dans un tableau qui peut être téléchargé sous forme de fichier Excel.Scraperr prend en charge la connexion de l'utilisateur pour gérer les tâches d'exploration, et fournit un affichage des journaux et des statistiques.

Liste des fonctions

- Soumettre et mettre en file d'attente des URL pour l'exploration du web

- Ajouter et gérer des éléments de crawl avec XPath

- Parcourir toutes les pages sous le même nom de domaine

- Ajouter des en-têtes JSON personnalisés pour envoyer des requêtes

- Affichage des résultats des données saisies

- Télécharger le fichier CSV contenant les résultats

- Réexécuter la tâche de capture

- Visualisation de l'état des tâches en file d'attente

- Mise en signet et visualisation des tâches mises en signet

- Connexion/enregistrement des utilisateurs pour organiser les tâches

- Consulter les journaux d'application

- Voir les statistiques des tâches

- Intégration de l'IA pour faciliter l'inclusion des résultats du crawl dans le contexte d'un dialogue

Utiliser l'aide

Processus d'installation

- Entrepôt de clonage :

git clone https://github.com/jaypyles/scraperr.git - Définition des variables d'environnement et des balises : Dans la section

docker-compose.ymlpour définir des variables d'environnement et des étiquettes, par exemple :scraperr: labels: - "traefik.enable=true" - "traefik.http.routers.scraperr.rule=Host(`localhost`)" - "traefik.http.routers.scraperr.entrypoints=web" scraperr_api: environment: - LOG_LEVEL=INFO - MONGODB_URI=mongodb://root:example@webscrape-mongo:27017 - SECRET_KEY=your_secret_key - ALGORITHM=HS256 - ACCESS_TOKEN_EXPIRE_MINUTES=600 - Démarrer le service :

docker-compose up -d

Processus d'utilisation

- Soumettre une URL à l'exploration: :

- Après vous être connecté à Scraperr, rendez-vous sur la page des tâches de scraping.

- Saisissez l'URL à explorer et l'élément XPath correspondant.

- Après avoir soumis une tâche, le système la met automatiquement en file d'attente et commence à la capturer.

- Gestion des éléments Crawl: :

- Sur la page de la tâche d'exploration, vous pouvez ajouter, modifier ou supprimer des éléments XPath.

- Permet d'explorer toutes les pages d'un même domaine.

- Voir les résultats du crawl: :

- Une fois la capture terminée, les résultats seront affichés dans un tableau.

- L'utilisateur peut télécharger un fichier CSV contenant les résultats ou choisir de réexécuter la tâche.

- gestion des tâches: :

- Les utilisateurs peuvent vérifier l'état des tâches en attente, mettre en signet et afficher les tâches mises en signet.

- Fournit la vue Statistiques des tâches, qui affiche les statistiques des tâches exécutées.

- Vue du journal: :

- Sur la page Journal de l'application, les utilisateurs peuvent afficher le journal du système pour obtenir des informations détaillées sur la tâche de capture.

- Intégration de l'IA: :

- Soutien à l'intégration des résultats de la capture dans les contextes de dialogue. Ollama et OpenAI.

© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Articles connexes

Pas de commentaires...