Comment créer un chatbot avec le tutoriel de la fonction Chatbox de DeepSeek ?

Connaissance de base et préparation des fonctions de la Chatbox

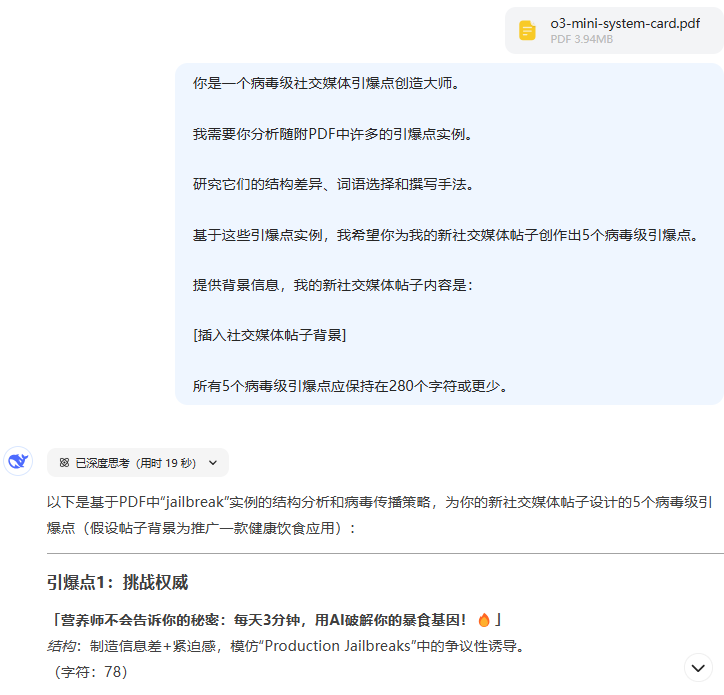

La fonctionnalité Chatbox fournie par la plateforme DeepSeek est essentiellement un système d'appel d'interface API, où l'utilisateur doit interagir avec le modèle par le biais de l'API. Un travail de préparation doit être effectué avant de créer un chatbot :

- Déploiement local d'OllanaVoir le tutoriel détaillé ci-dessous

- Obtenir la clé API officiellePour cela, il faut se rendre sur le site officiel de DeepSeek pour créer un compte et passer l'authentification d'entreprise (les développeurs individuels choisissent le type individuel), dans la console "gestion des bons"Le module génère une clé API propriétaire, généralement au format ds-xxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxx.

Pour créer un chatbot à l'aide de la fonction ChatBox de DeepSeek, suivez les étapes ci-dessous pour combiner le déploiement local avec la configuration de l'interface pour une interaction efficace :

I. Construction de l'environnement de base

- Installation du cadre Ollama

Ollama est un cadre léger pour l'exécution de modèles d'IA natifs, avec un support pour les modèles open source tels que DeepSeek.- Visitez le site officiel d'Ollama et choisissez le paquet d'installation en fonction de votre système (Windows choisissez .exe, Mac choisissez .dmg).

- Une fois l'installation terminée, tapez dans le terminal

ollama listSi la liste des modèles s'affiche (par exemple, llama3), l'installation est terminée.

- Déployer le modèle DeepSeek

- Sélectionnez la version du modèle en fonction de la configuration matérielle :

- équipement à profil bas: Sélection

1.5Bpeut-être8BVersion paramétrique (nécessite au moins 2 Go de mémoire vidéo). - Des équipements performants: Recommandations

16Bou plus (nécessite au moins 16 Go de mémoire vidéo).

- équipement à profil bas: Sélection

- Exécutez la commande dans le terminal pour télécharger le modèle :

ollama run deepseek-r1:8b # 替换数字为所选参数版本La première exécution nécessite le téléchargement d'environ 5 Go de fichiers de modèles, et un réseau stable est nécessaire.

- Sélectionnez la version du modèle en fonction de la configuration matérielle :

Configuration de l'interface ChatBox

- Installation de l'outil ChatBox

- Visitez le site officiel de ChatBox et téléchargez le paquet d'installation pour le système correspondant (Windows, Mac ou Linux).

- Lancez le logiciel après l'installation et entrez dans l'interface de configuration.

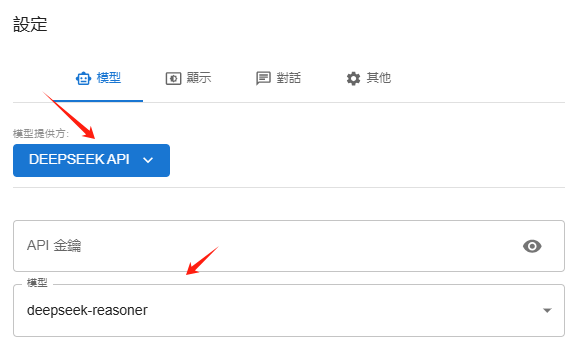

- Connecter Ollama au modèle DeepSeek

- Sélectionnez "Model Provider" dans la ChatBox. API OLLAMA.

- Remplir l'adresse de l'API par défaut

http://localhost:11434(S'il n'est pas rempli automatiquement, saisissez-le manuellement). - Sélectionnez la version installée de DeepSeek dans le menu déroulant "Modèle" (par ex.

deepseek-r1:8b).

- Tests fonctionnels

- Retournez à l'interface principale, entrez une question (par exemple "Écrivez des vœux pour la nouvelle année"), ChatBox générera une réponse à travers le modèle local, permettant un dialogue indépendant du réseau.

- Configuration de l'Ollama

- Configuration de l'API officielle de DeepSeek

III. extension des fonctionnalités avancées

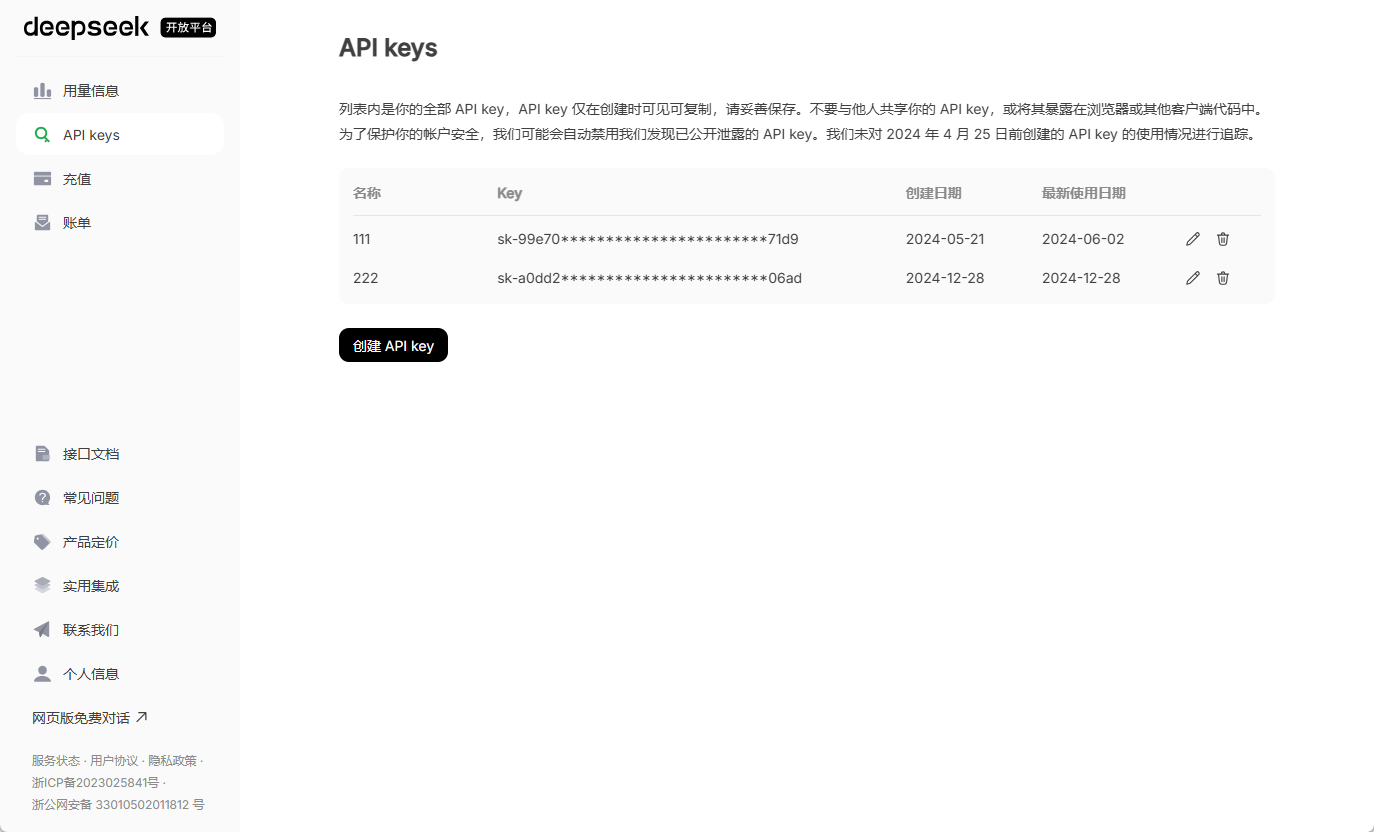

- Interaction multimodale et intégration des bases de connaissances

- utiliser Page Assist et d'autres plug-ins de navigateur qui ajoutent des capacités de recherche en réseau au modèle local et permettent d'accéder à des informations en temps réel à partir de moteurs spécifiques.

- En téléchargeant des documents tels que PDF, TXT, etc. dans la base de connaissances, le modèle peut être combiné avec des données locales pour générer des réponses plus précises (les modèles intégrés tels que BERT doivent être configurés).

- Recommandations pour l'optimisation des performances

- adaptation du matérielSi la latence du dialogue est élevée, diminuez la version des paramètres du modèle ou mettez à niveau la carte graphique (RTX 4080 ou supérieure recommandée).

- Vie privéeLe déploiement local évite les téléchargements de données et convient au traitement d'informations sensibles.

IV. solutions aux problèmes courants

- Le téléchargement du modèle a échouéLa connexion Internet : Vérifiez votre connexion Internet et désactivez votre pare-feu ou votre logiciel antivirus.

- ChatBox ne répond pasConfirmation du démarrage du service Ollama (entrée du terminal)

ollama serve). - mémoire vidéo insuffisanteLes problèmes d'accès à l'Internet : Essayez des modèles plus petits ou augmentez la mémoire virtuelle.

Un chatbot DeepSeek localisé et à haut niveau de confidentialité peut être rapidement construit en suivant les étapes ci-dessus. Pour une personnalisation plus poussée (par exemple, l'intégration web), reportez-vous au tutoriel sur le développement de l'API.

© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Articles connexes

Pas de commentaires...