Raycast-G4F : Accès gratuit à GPT-4, Llama-3 et à de nombreux autres modèles d'IA via Raycast !

Introduction générale

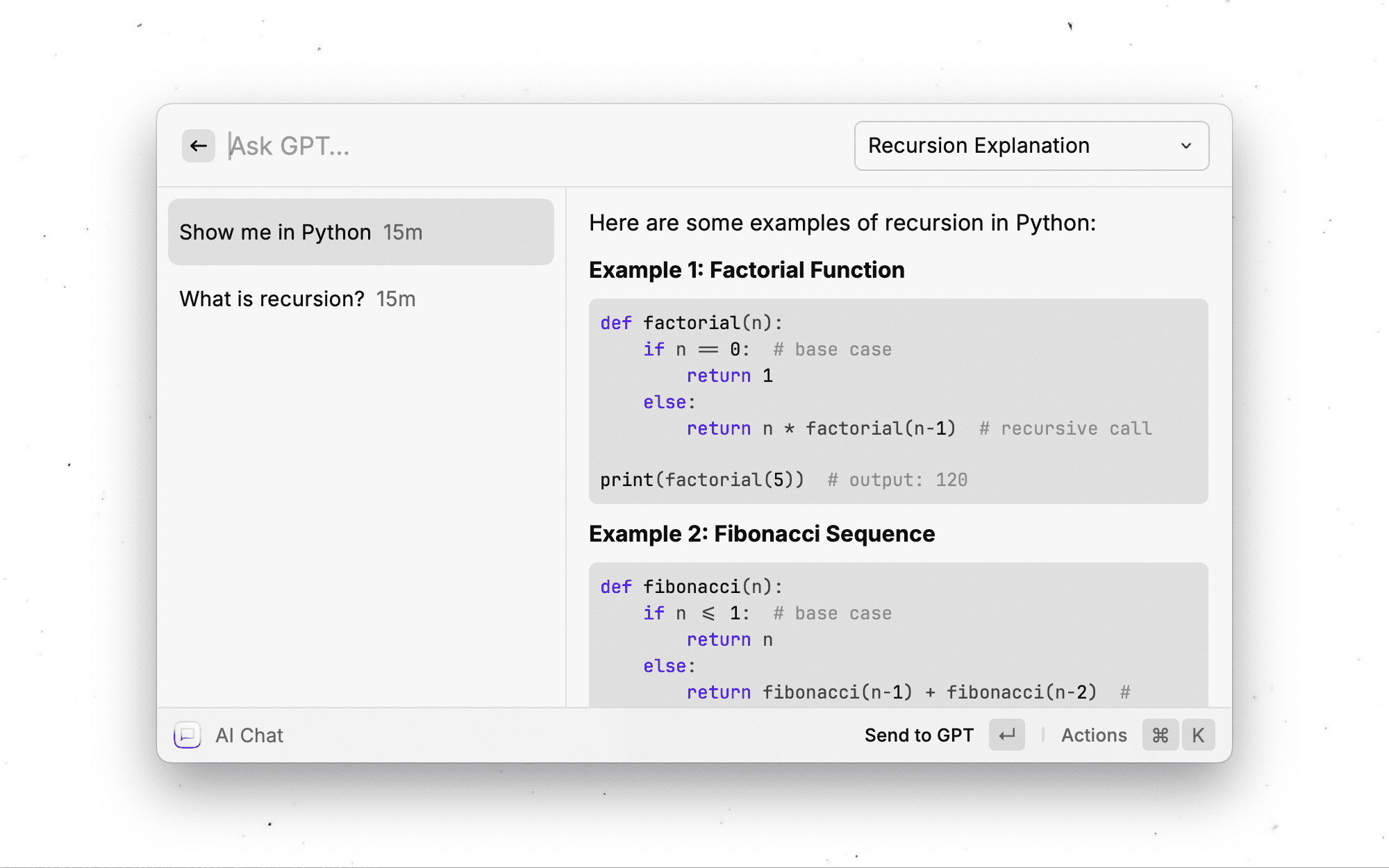

Raycast-G4F (GPT4Free) est un puissant logiciel d'aide à la décision. Raycast Cette extension permet aux utilisateurs d'accéder gratuitement à un large éventail de modèles d'IA avancés, dont GPT-4 et Llama-3. L'extension ne se contente pas de fournir des dialogues en temps réel, elle prend également en charge une série de fonctions telles que la recherche sur le web, le téléchargement de fichiers, la génération d'images, etc. Elle prend notamment en charge plus de 40 fournisseurs et modèles d'IA différents. Elle prend notamment en charge plus de 40 fournisseurs et modèles d'IA différents, ce qui permet aux utilisateurs de passer librement d'un modèle à l'autre en fonction de leurs besoins. L'extension est entièrement open source et se concentre sur la protection de la vie privée de l'utilisateur, toutes les données étant stockées localement sur l'appareil. Bien qu'elle ne soit pas encore disponible sur la boutique officielle de Raycast, elle peut être utilisée grâce à une simple installation du code source et fournit des mises à jour automatiques pour garantir que la dernière version est toujours disponible.

Raycast-G4F n'est actuellement disponible que pour macOS, une version Windows étant en cours de développement. Les utilisateurs peuvent installer l'extension à partir du code source avec des étapes d'installation simples et profiter de ses puissantes fonctionnalités d'IA.

Liste des fonctions

- Fonctionnalité de flux de dialogue en temps réel avec prise en charge du chargement de messages instantanés

- 18 commandes différentes pour divers scénarios d'utilisation

- Accès à plus de 40 fournisseurs et modèles d'IA

- Fonctionnalités intelligentes d'enregistrement du journal de chat et de désignation des sessions

- Capacité de recherche intégrée sur le web pour des informations actualisées

- Prise en charge des téléchargements d'images, de vidéos, d'audio et de fichiers texte

- Fonction de génération d'images d'IA

- Prise en charge de la création de commandes d'IA personnalisées

- Fonction d'interprétation du code (Beta)

- La fonction de stockage persistant garantit une conservation sûre des données

Utiliser l'aide

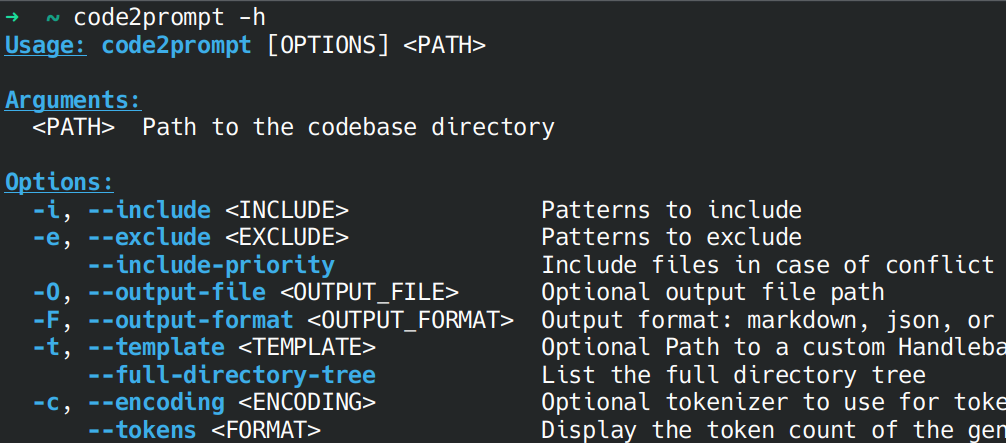

1. préparation à l'installation

- S'assurer que l'application Raycast est installée (actuellement uniquement sur macOS).

- Installer Node.js (version recommandée v20.18.1 ou supérieure)

2. les étapes de l'installation

- Télécharger la dernière version du code source sur GitHub ou cloner le dépôt.

- Ouvrez le terminal et allez dans le dossier de téléchargement

- être en mouvement

npm ci --productionInstallation des dépendances - (Facultatif) Exécuter

pip3 install -r requirements.txtInstallation des dépendances de Python - être en mouvement

npm run devCréation et importation d'extensions

3. les modalités de mise à jour

Mises à jour automatiques :

- Utilisez la commande "Vérifier les mises à jour" intégrée à l'extension.

- Activer l'option "Vérifier automatiquement les mises à jour" dans les préférences (activée par défaut)

Mise à jour manuelle :

Exécutez les commandes suivantes dans l'ordre :

git pullnpm ci --productionnpm run dev

4. description de l'utilisation des principales fonctions

Fonctionnalité de chat AI

- Prise en charge des flux de dialogue en temps réel

- Sauvegarde automatique de l'historique des chats

- Dénomination intelligente des sessions

- La recherche sur le web peut être activée en une seule session

Fonction de recherche sur Internet

Quatre modes sont proposés :

- Désactivé (par défaut)

- Mode automatique : activé automatiquement dans le chat AI uniquement

- Mode équilibré : activé dans les commandes de l'IA et dans le chat

- Toujours activé : la recherche sur le web est utilisée pour toutes les requêtes

Capacité de traitement des documents

- Prise en charge du téléchargement de fichiers texte (.txt, .md, etc.).

- Certains fournisseurs prennent en charge les images, les vidéos et les fichiers audio

- Prise en charge de la commande "Demander le contenu de l'écran".

Personnalisation

- Créer des commandes d'IA personnalisées

- Définition des préréglages de l'IA

- Configuration du stockage permanent

- API personnalisées compatibles avec l'OpenAI

5. configuration des fonctions avancées

Paramètres de l'API Google Gemini

- Visitez le site https://aistudio.google.com/app/apikey

- Connexion au compte Google

- Création d'une clé API

- Remplir la clé dans les préférences étendues

Interprète de code (beta)

- Prise en charge de l'exécution locale du code Python

- Seuls les modèles spécifiques dotés d'une capacité d'appel de fonction sont pris en charge

- Des restrictions de sécurité ont été configurées pour garantir une exécution sûre du code.

Modèles et prestataires de services gratuits proposés

| fournisseur (entreprise) | modélisation | Fonctionnalité | état des lieux | tempo | Notes de l'auteur et notes étendues |

|---|---|---|---|---|---|

| Nexra | gpt-4o (par défaut) | ▶️ | Actif | très rapide | 8,5/10, le modèle le plus performant. |

| Nexra | gpt-4-32k | Actif | modéré | 6,5/10, pas de prise en charge du streaming, mais sinon un excellent modèle. | |

| Nexra | chatgpt | ▶️ | Inconnu | très rapide | 7.5/10 |

| Nexra | Bing | ▶️ | Actif | modéré | 8/10, basé sur le GPT-4 et avec possibilité de recherche sur le web. |

| Nexra | llama-3.1 | ▶️ | Actif | tranchant (des couteaux ou de l'esprit) | 7/10 |

| Nexra | gemini-1.0-pro | ▶️ | Actif | tranchant (des couteaux ou de l'esprit) | 6.5/10 |

| DeepInfra | méta-llama-3.3-70b | ▶️ | Actif | tranchant (des couteaux ou de l'esprit) | 8,5/10, le dernier modèle avec de grandes tailles de contexte. |

| DeepInfra | meta-llama-3.2-90b-vision | ▶️ 📄¹ | Actif | tranchant (des couteaux ou de l'esprit) | 8/10, le dernier modèle avec des capacités visuelles. |

| DeepInfra | meta-llama-3.2-11b-vision | ▶️ 📄¹ | Actif | très rapide | 7.5/10 |

| DeepInfra | méta-llama-3.1-405b | ▶️ | Inactif | modéré | 8,5/10, modèle ouvert de pointe pour les tâches complexes. |

| DeepInfra | méta-llama-3.1-70b | ▶️ | Actif | tranchant (des couteaux ou de l'esprit) | 8/10 |

| DeepInfra | méta-llama-3.1-8b | ▶️ | Actif | très rapide | 7.5/10 |

| DeepInfra | llama-3.1-nemotron-70b | ▶️ | Actif | tranchant (des couteaux ou de l'esprit) | 8/10 |

| DeepInfra | WizardLM-2-8x22B | ▶️ | Actif | modéré | 7/10 |

| DeepInfra | DeepSeek-V2.5 | ▶️ | Actif | tranchant (des couteaux ou de l'esprit) | 7.5/10 |

| DeepInfra | Qwen2.5-72B | ▶️ | Actif | modéré | 7.5/10 |

| DeepInfra | Qwen2.5-Coder-32B | ▶️ | Actif | tranchant (des couteaux ou de l'esprit) | 7/10 |

| DeepInfra | QwQ-32B-Preview | ▶️ | Actif | très rapide | 7.5/10 |

| Boîte noire | modèle personnalisé | ▶️ | Actif | tranchant (des couteaux ou de l'esprit) | 7,5/10 avec une génération très rapide et des capacités de recherche sur le web intégrées, mais optimisé pour l'encodage. |

| Boîte noire | llama-3.1-405b | ▶️ | Actif | tranchant (des couteaux ou de l'esprit) | 8.5/10 |

| Boîte noire | llama-3.1-70b | ▶️ | Actif | très rapide | 8/10 |

| Boîte noire | gemini-1.5-flash | ▶️ | Actif | rapide comme l'éclair | 7.5/10 |

| Boîte noire | qwq-32b-preview | ▶️ | Actif | rapide comme l'éclair | 6.5/10 |

| Boîte noire | gpt-4o | ▶️ | Actif | très rapide | 7.5/10 |

| Boîte noire | claude-3.5-sonnet | ▶️ | Actif | tranchant (des couteaux ou de l'esprit) | 8.5/10 |

| Boîte noire | gemini-pro | ▶️ | Actif | tranchant (des couteaux ou de l'esprit) | 8/10 |

| Canard enchaîné | gpt-4o-mini | ▶️ | Actif | rapide comme l'éclair | 8/10, modèle authentique GPT-4o-mini avec une forte protection de la vie privée. |

| Canard enchaîné | claude-3-haiku | ▶️️ | Actif | rapide comme l'éclair | 7/10 |

| Canard enchaîné | méta-llama-3.1-70b | ▶️️ | Actif | très rapide | 7.5/10 |

| Canard enchaîné | mixtral-8x7b | ▶️️ | Actif | rapide comme l'éclair | 7.5/10 |

| BestIM | gpt-4o-mini | ▶️ | Inactif | rapide comme l'éclair | 8.5/10 |

| Roches | claude-3.5-sonnet | ▶️ | Actif | tranchant (des couteaux ou de l'esprit) | 8.5/10 |

| Roches | claude-3-opus | ▶️ | Actif | tranchant (des couteaux ou de l'esprit) | 8/10 |

| Roches | gpt-4o | ▶️ | Actif | tranchant (des couteaux ou de l'esprit) | 7.5/10 |

| Roches | gpt-4 | ▶️ | Actif | tranchant (des couteaux ou de l'esprit) | 7.5/10 |

| Roches | llama-3.1-405b | ▶️ | Actif | tranchant (des couteaux ou de l'esprit) | 7.5/10 |

| Roches | llama-3.1-70b | ▶️ | Actif | très rapide | 7/10 |

| ChatgptFree | gpt-4o-mini | ▶️ | Actif | rapide comme l'éclair | 8.5/10 |

| AI4Chat | gpt-4 | Actif | très rapide | 7.5/10 | |

| DarkAI | gpt-4o | ▶️ | Actif | très rapide | 8/10 |

| Mhystique | gpt-4-32k | Actif | très rapide | 6.5/10 | |

| PizzaGPT | gpt-4o-mini | Actif | rapide comme l'éclair | 7.5/10 | |

| Meta AI | meta-llama-3.1 | ▶️ | Actif | modéré | 7/10, le dernier modèle avec accès à Internet. |

| Répliquer | mixtral-8x7b | ▶️ | Actif | modéré | ?/10 |

| Répliquer | méta-llama-3.1-405b | ▶️ | Actif | modéré | ?/10 |

| Répliquer | meta-llama-3-70b | ▶️ | Actif | modéré | ?/10 |

| Répliquer | meta-llama-3-8b | ▶️ | Actif | tranchant (des couteaux ou de l'esprit) | ?/10 |

| Phind | Instant Phind | ▶️ | Actif | rapide comme l'éclair | 8/10 |

| Google Société Internet Gémeaux | auto (gemini-1.5-pro, gemini-1.5-flash) | ▶️ 📄 | Actif | très rapide | 9/10, très bon modèle générique, mais nécessite une clé API. (Il estgratuit(Veuillez vous référer à la section suivante) |

| Google Gemini (expérimental) | automatique (change fréquemment) | ▶️ 📄 | Actif | très rapide | - |

| Google Gemini (Réflexion) | automatique (change fréquemment) | ▶️ 📄 | Actif | très rapide | - |

| API personnalisée compatible avec OpenAI | - | ▶️ | Actif | - | Permet d'utiliser n'importe quelle API personnalisée compatible avec OpenAI. |

▶️ - Prise en charge de la diffusion en continu.

© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Articles connexes

Pas de commentaires...