Promptimizer : une bibliothèque expérimentale pour l'optimisation de grands modèles de mots-guides, optimisant automatiquement Prompt

Introduction générale

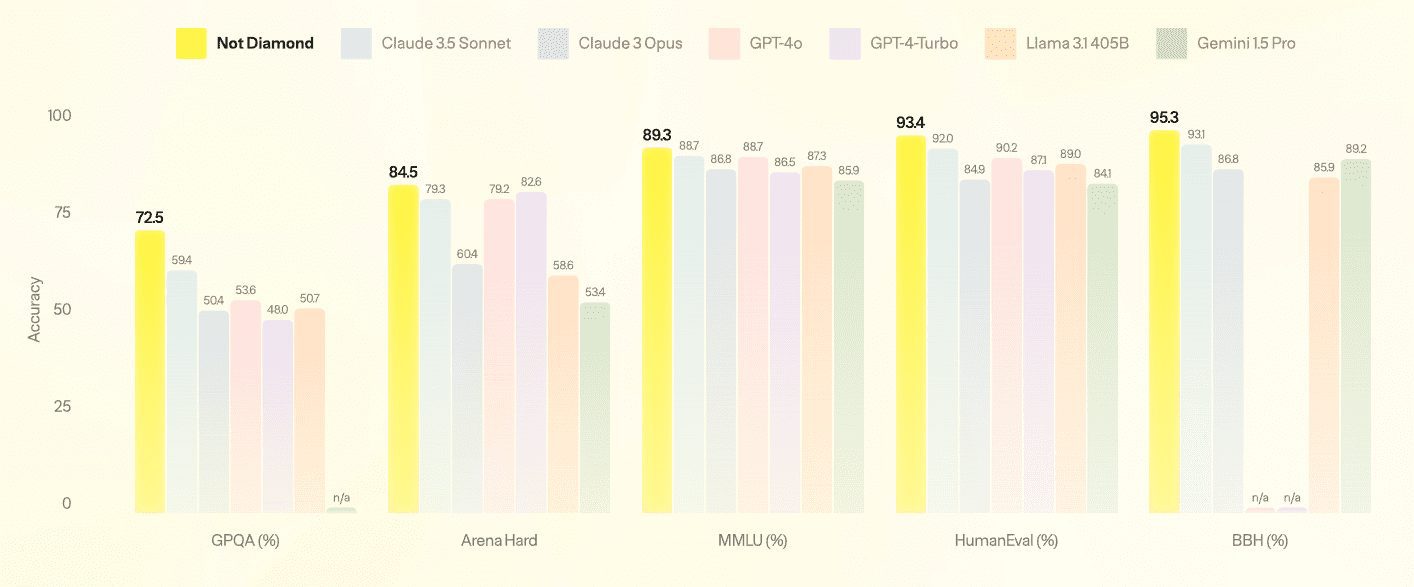

Promptimizer est une bibliothèque expérimentale d'optimisation des mots-clés conçue pour aider les utilisateurs à améliorer systématiquement les mots-clés de leurs systèmes d'intelligence artificielle. En automatisant le processus d'optimisation, Promptimizer peut améliorer les performances des mots indicateurs sur des tâches spécifiques. Les utilisateurs fournissent simplement un mot indicateur initial, un ensemble de données et un évaluateur personnalisé (avec un retour d'information humain optionnel), et Promptimizer exécute une boucle d'optimisation qui génère un mot indicateur optimisé conçu pour surpasser le mot indicateur d'origine.

Liste des fonctions

- Optimisation des mots repères : optimisation automatisée des mots repères afin d'améliorer les performances du système d'IA dans des tâches spécifiques.

- Prise en charge des ensembles de données : prise en charge de plusieurs formats d'ensembles de données pour une optimisation conviviale des mots-clés.

- Évaluateurs personnalisés : les utilisateurs peuvent définir des évaluateurs personnalisés pour quantifier la performance des mots repères.

- Retour d'information humain : le retour d'information humain est pris en charge pour améliorer encore l'optimisation des mots repères.

- Guide de démarrage rapide : un guide de démarrage rapide détaillé est fourni pour aider les utilisateurs à démarrer rapidement.

Utiliser l'aide

montage

- Installez d'abord l'outil CLI :

pip install -U promptim - Assurez-vous que vous disposez d'une clé API LangSmith valide dans votre environnement :

export LANGSMITH_API_KEY=你的API_KEY export ANTHROPIC_API_KEY=你的API_KEY

Création de tâches

- Créer une tâche d'optimisation :

promptim create task ./my-tweet-task \ --name my-tweet-task \ --prompt langchain-ai/tweet-generator-example-with-nothing:starter \ --dataset https://smith.langchain.com/public/6ed521df-c0d8-42b7-a0db-48dd73a0c680/d \ --description "Write informative tweets on any subject." \ -yCette commande génère un répertoire contenant le fichier de configuration de la tâche et le code de la tâche.

Définir l'évaluateur

- Ouvrez le répertoire de la tâche générée dans le répertoire

task.pypour trouver la section logique d'évaluation :score = len(str(predicted.content)) < 180 - Modifier la logique d'évaluation, par exemple pénaliser les résultats contenant des étiquettes :

score = int("#" not in result)

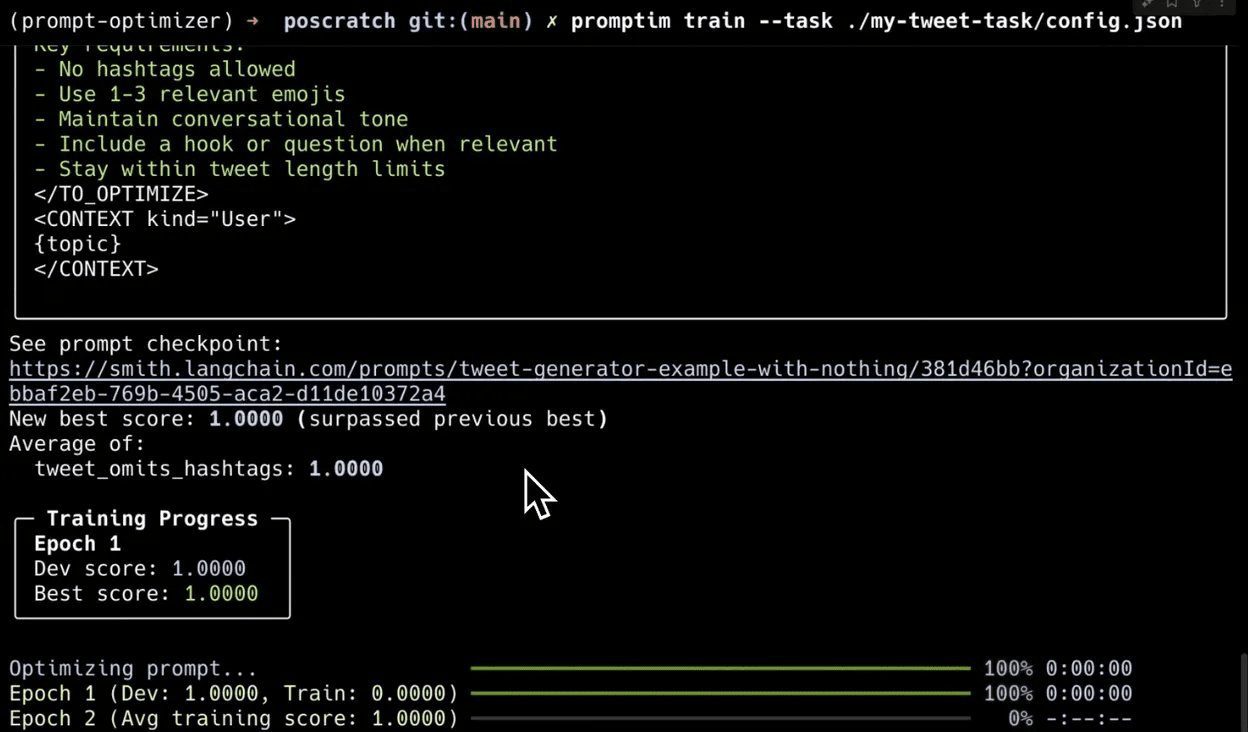

train

- Exécutez la commande de formation pour commencer à optimiser le mot indicateur :

promptim train --task ./my-tweet-task/config.jsonUne fois l'apprentissage terminé, le terminal émet le mot repère final optimisé.

Ajouter des étiquettes manuelles

- Configurer la file d'attente des annotations :

promptim train --task ./my-tweet-task/config.json --annotation-queue my_queue - Accédez à l'interface utilisateur LangSmith et naviguez jusqu'à la file d'attente désignée pour l'étiquetage manuel.

© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Articles connexes

Pas de commentaires...