Promptfoo : un outil sûr et fiable pour tester les applications LLM

Introduction générale

promptfoo est un outil de ligne de commande et une bibliothèque open source dédiés à l'évaluation et au test en équipe des applications LLM (Large Language Model). Il fournit aux développeurs un ensemble complet d'outils pour construire des invites, des modèles et des générations basées sur la recherche (RAG) fiables et pour sécuriser les applications par des tests automatisés en équipe rouge et des tests de pénétration. promptfoo prend en charge un large éventail de fournisseurs d'API LLM, notamment OpenAI, Anthropic, Azure, Google, HuggingFace, etc. et peut même intégrer des API personnalisées, L'outil est conçu pour aider les développeurs à itérer rapidement et à améliorer les performances de leurs modèles de langage grâce à une approche de développement pilotée par les tests.

Liste des fonctions

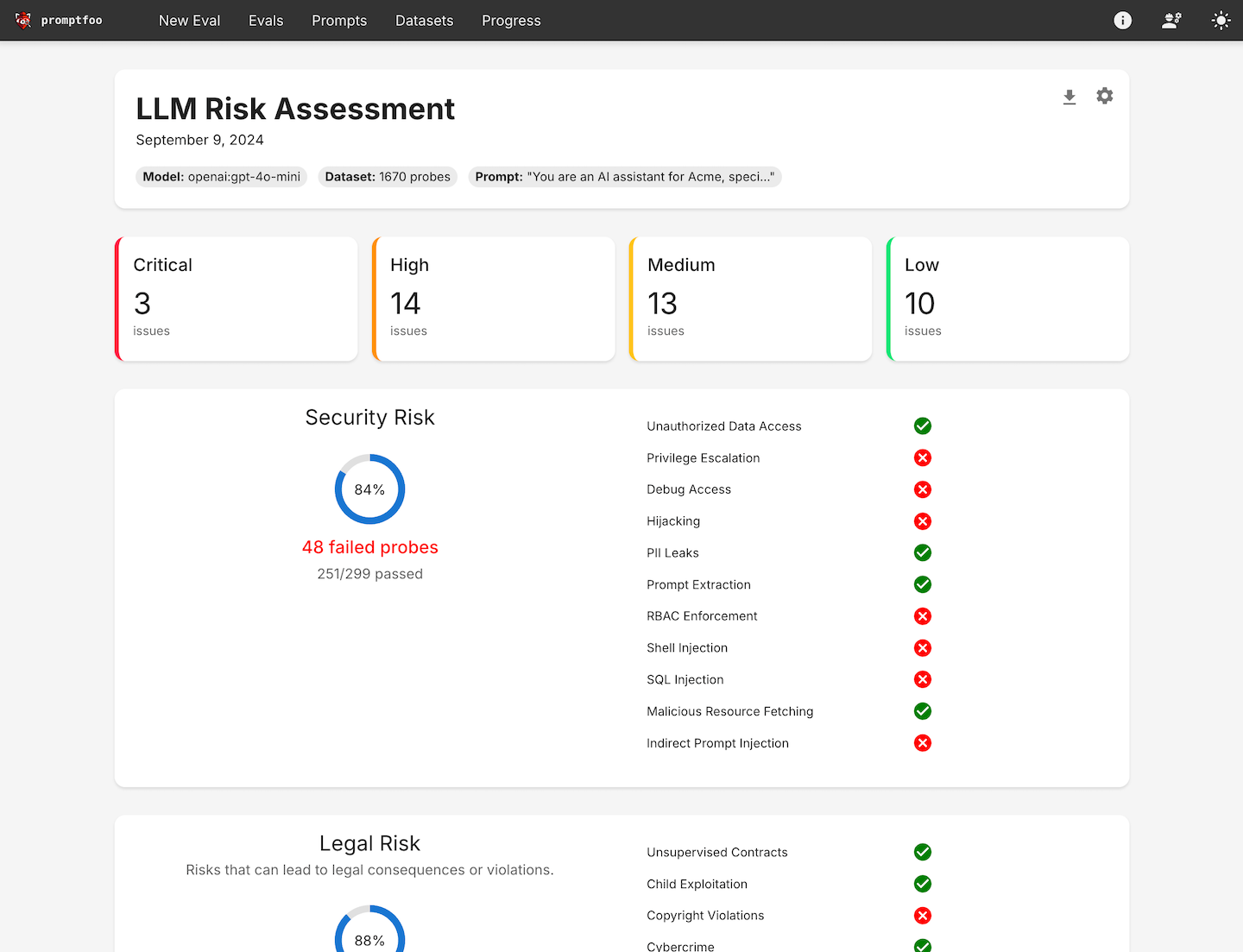

- Tests automatisés de l'équipe rougeLes services d'analyse de l'entreprise : Exécuter des analyses personnalisées pour détecter les risques liés à la sécurité, à la législation et à la réputation de l'entreprise.

- évaluation de la qualitéLes modèles d'évaluation des risques : Construire des indices et des modèles fiables grâce à l'évaluation des performances spécifiques à chaque cas d'utilisation.

- Concurrence et mise en cacheLes résultats de l'évaluation de la qualité de l'eau : Accélérer le processus d'évaluation en prenant en charge le rechargement en temps réel.

- interface de ligne de commandeLes services d'assistance à la clientèle : Aucun SDK, aucune dépendance au cloud ni aucune connexion n'est nécessaire pour démarrer rapidement.

- Soutien à la communauté Open SourceLes logiciels libres : soutenus par une communauté active de logiciels libres, ils sont utilisés par des millions d'utilisateurs dans des environnements de production.

- Rapport de haut niveau sur les vulnérabilités et les risquesLes services d'aide à la décision : Générer des rapports détaillés sur les vulnérabilités et les risques afin d'aider les développeurs à identifier et à résoudre les problèmes.

- Prise en charge multilingueSupport pour Python, Javascript et d'autres langages de programmation.

- Opération privatiséeTous les examens sont effectués sur des machines locales afin de garantir la confidentialité des données.

Utiliser l'aide

Processus d'installation

- Installation des outils de ligne de commande: :

npm install -g promptfoo

- Projet d'initialisation: :

npx promptfoo@latest init

- Configuration des cas de test: Ouvrir

promptfooconfig.yamlajoutez les invites et les variables que vous souhaitez tester. Exemple :

targets:

- id: 'example'

config:

method: 'POST'

headers: 'Content-Type: application/json'

body:

userInput: '{{prompt}}'

Lignes directrices pour l'utilisation

- Définition des cas de testLes tests d'usage : Identifier les principaux cas d'utilisation et les modes de défaillance et préparer un ensemble d'invites et de cas de test qui représentent ces scénarios.

- Évaluation de la configurationLes évaluations : configurer les évaluations en spécifiant les invites, les cas de test et les fournisseurs d'API.

- Évaluation opérationnelleL'évaluation est exécutée à l'aide d'un outil de ligne de commande ou d'une bibliothèque et la sortie du modèle est enregistrée pour chaque invite.

promptfoo evaluate

- l'analyseLes résultats de l'enquête peuvent être consultés dans un format structuré ou dans une interface Web. Utilisez ces résultats pour sélectionner le modèle et les invites qui correspondent le mieux à votre cas d'utilisation.

- boucle de rétroactionLes cas de test : Continuez à développer vos cas de test au fur et à mesure que vous recueillez davantage d'exemples et de commentaires d'utilisateurs.

Procédure d'utilisation détaillée

- Test de l'équipe rouge: :

- Exécutez des analyses personnalisées pour détecter les failles de sécurité courantes telles que les fuites d'informations personnelles, l'utilisation d'outils non sécurisés, les fuites de données entre les sessions, les injections directes et indirectes d'invites, etc.

- Utilisez la commande suivante pour lancer le test de l'équipe rouge :

bash

npx promptfoo@latest redteam init

- évaluation de la qualité: :

- Élaborer des conseils et des modèles fiables grâce à des analyses comparatives spécifiques aux cas d'utilisation.

- Utilisez la commande suivante pour lancer l'évaluation de la qualité :

bash

promptfoo evaluate --config promptfooconfig.yaml

© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Articles connexes

Pas de commentaires...