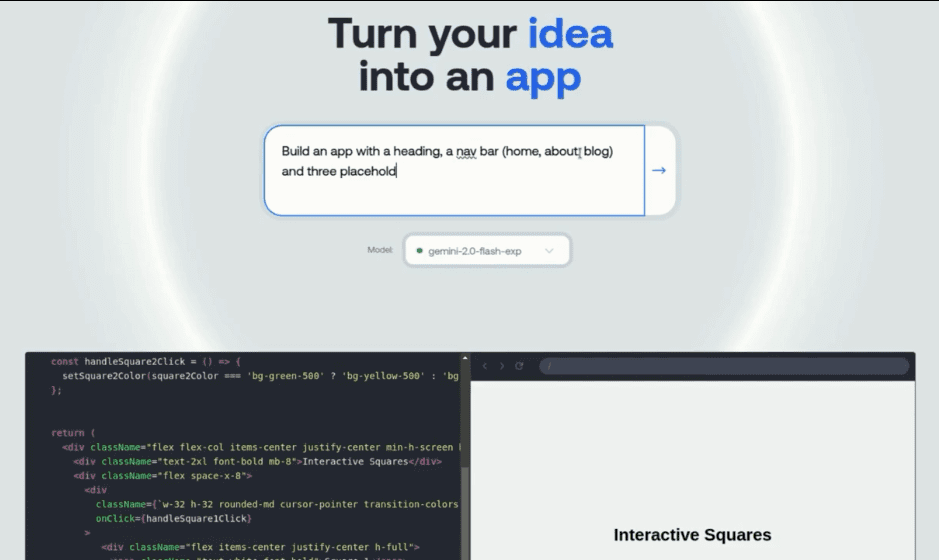

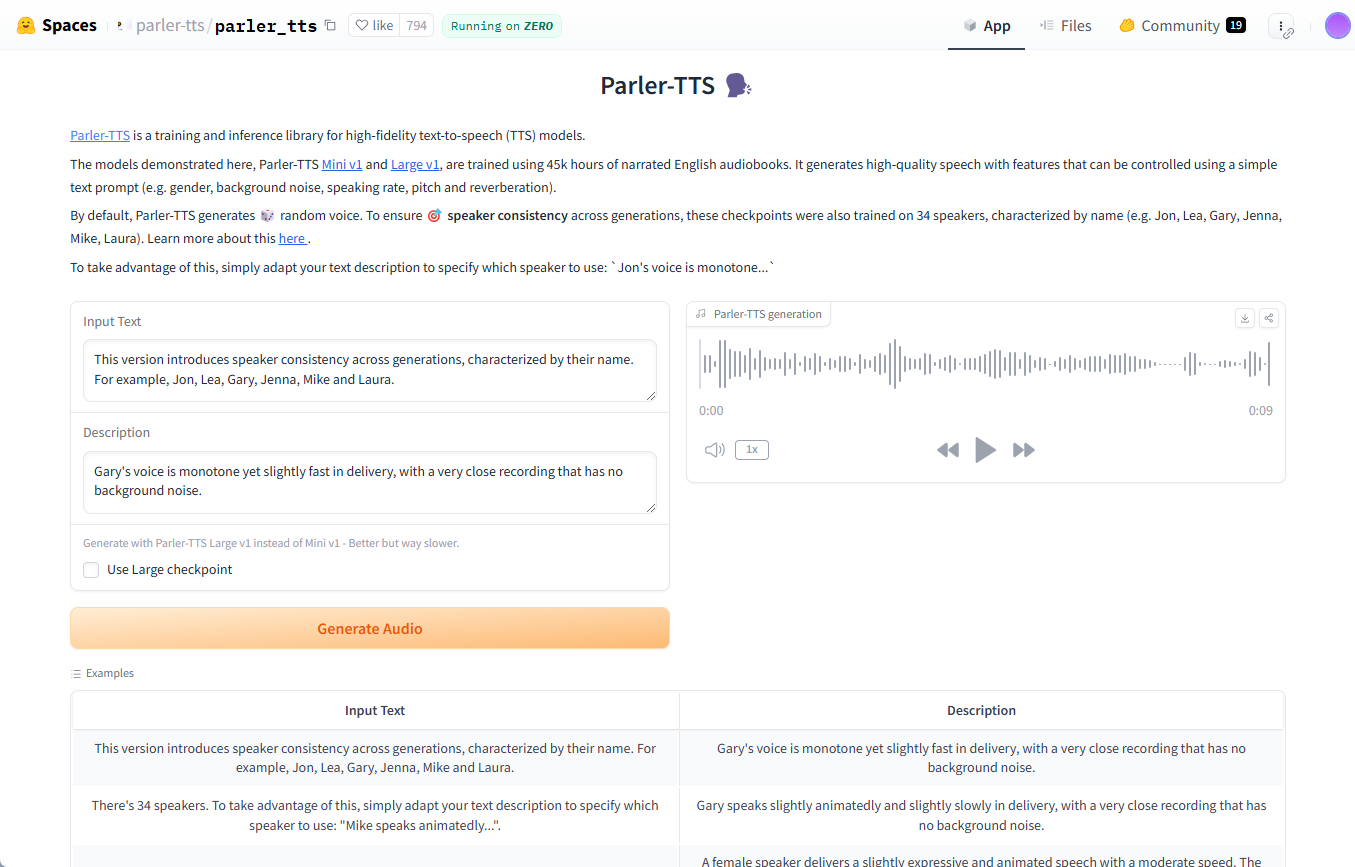

Parler-TTS : générer des modèles de synthèse vocale spécifiques au locuteur à partir d'un texte d'entrée

Introduction générale

Parler-TTS est une bibliothèque de modèles de synthèse vocale (TTS) open-source développée par Hugging Face pour générer une parole de haute qualité et à consonance naturelle. Le modèle est capable de générer de la parole avec un style de locuteur spécifique (par exemple, le genre, la hauteur, le style d'élocution, etc.) basé sur le texte d'entrée.Parler-TTS est basé sur les résultats de la recherche dans l'article "Natural language guidance of high-fidelity text-to-speech with synthetic". Parler-TTS est basé sur les résultats de recherche de l'article "Natural language guidance of high-fidelity text-to-speech with synthetic annotations", et est entièrement open source, avec tous les ensembles de données, le prétraitement, le code d'entraînement, et les poids publiquement disponibles, permettant à la communauté de les développer et de les améliorer.

Liste des fonctions

- Génération de discours de haute qualitéGénération de discours naturels et fluides avec prise en charge de plusieurs styles de locuteurs.

- source ouverteLes poids des codes et des modèles sont mis à la disposition du public à des fins de développement et d'amélioration de la communauté.

- Dépendances légères: Simple à installer et à utiliser, avec peu de dépendances.

- Plusieurs versions de modèlesParler-TTS Mini et Parler-TTS Large : Des versions du modèle avec différents nombres de paramètres sont disponibles.

- Génération rapideLa vitesse de génération est optimisée grâce à la prise en charge de SDPA et de Flash Attention 2.

- Ensembles de données et pondérationsLe système de gestion des données : Il fournit des ensembles de données riches et des poids de modèles pré-entraînés pour faciliter l'entraînement et l'ajustement.

Utiliser l'aide

Processus d'installation

- Assurez-vous que l'environnement Python est installé.

- Utilisez la commande suivante pour installer la bibliothèque Parler-TTS :

pip install git+https://github.com/huggingface/parler-tts.git

- Pour les utilisateurs d'Apple Silicon, exécutez la commande suivante pour prendre en charge bfloat16 :

pip3 install --pre torch torchaudio --index-url https://download.pytorch.org/whl/nightly/cpu

Utilisation

Générer un discours aléatoire

- Importer les bibliothèques nécessaires :

import torch

from parler_tts import ParlerTTSForConditionalGeneration

from transformers import AutoTokenizer

import soundfile as sf

- Modèles de chargement et séparateurs :

device = "cuda:0" if torch.cuda.is_available() else "cpu"

model = ParlerTTSForConditionalGeneration.from_pretrained("parler-tts/parler-tts-mini-v1").to(device)

tokenizer = AutoTokenizer.from_pretrained("parler-tts/parler-tts-mini-v1")

- Saisissez du texte et générez de la voix :

prompt = "Hey, how are you doing today?"

description = "A female speaker delivers a slightly expressive and animated speech with a moderate speed and pitch."

inputs = tokenizer(prompt, return_tensors="pt").to(device)

outputs = model.generate(**inputs, description=description)

sf.write("output.wav", outputs.cpu().numpy(), 22050)

Générer un discours dans un style spécifique

- Les descriptions qui utilisent le style d'un locuteur particulier :

description = "A male speaker with a deep voice and slow pace."

inputs = tokenizer(prompt, return_tensors="pt").to(device)

outputs = model.generate(**inputs, description=description)

sf.write("output_specific.wav", outputs.cpu().numpy(), 22050)

Modèles de formation

- Télécharger et préparer le jeu de données.

- L'apprentissage du modèle est effectué à l'aide du code d'apprentissage fourni :

python train.py --dataset_path /path/to/dataset --output_dir /path/to/output

Raisonnement optimisé

- Optimisé à l'aide de SDPA et Flash Attention 2 :

model = ParlerTTSForConditionalGeneration.from_pretrained("parler-tts/parler-tts-mini-v1", use_flash_attention=True).to(device)© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Articles connexes

Pas de commentaires...