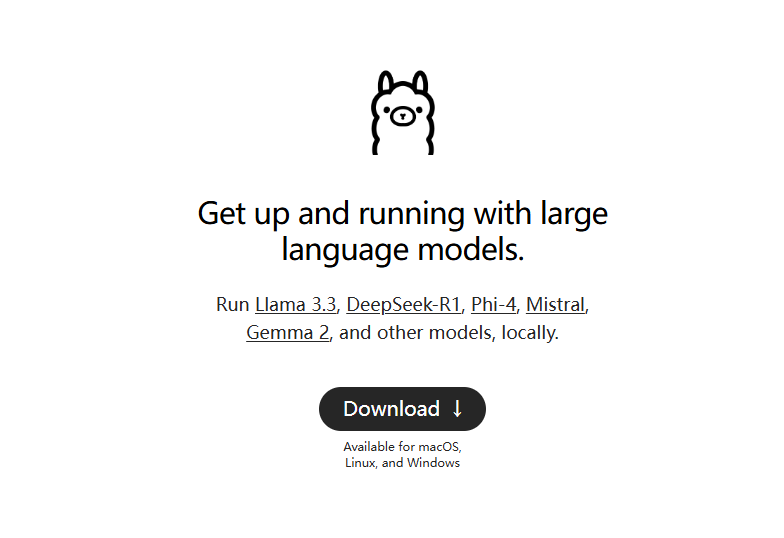

Ollama : Déploiement natif en un clic de grands modèles linguistiques Open Source

Ollama Introduction générale

ollama est un framework léger pour l'exécution de modèles de langage natifs, permettant aux utilisateurs de construire et d'exécuter facilement de grands modèles de langage. Il offre de multiples options de démarrage et d'installation rapides, prend en charge Docker et inclut un riche ensemble de bibliothèques parmi lesquelles les utilisateurs peuvent choisir. Il est facile à utiliser, fournit une API REST et dispose d'une variété de plugins et d'extensions qui s'intègrent à la communauté.

ollama est un outil en ligne de commande pure pour les ordinateurs personnels, recommandé pour déployer des interfaces de chat locales, telles que : Open WebUI, Lobe Chat, NextChat.

Modifier le répertoire d'installation par défaut : https://github.com/ollama/ollama/issues/2859

Liste des caractéristiques d'Ollama

Mettre en place et faire fonctionner rapidement de grands modèles linguistiques

Prise en charge des systèmes macOS, Windows et Linux

Fournit des bibliothèques telles que ollama-python, ollama-js, etc.

Y compris le lama 2. MistralGemma et al. Modèle préconstruit

Prise en charge des installations locales et Docker

Fournir des fonctionnalités de modèle personnalisées

Prise en charge de la conversion de modèles à partir de GGUF et PyTorch

Fournir un guide d'utilisation du CLI

Assurer la prise en charge de l'API REST

Commandes ollama couramment utilisées

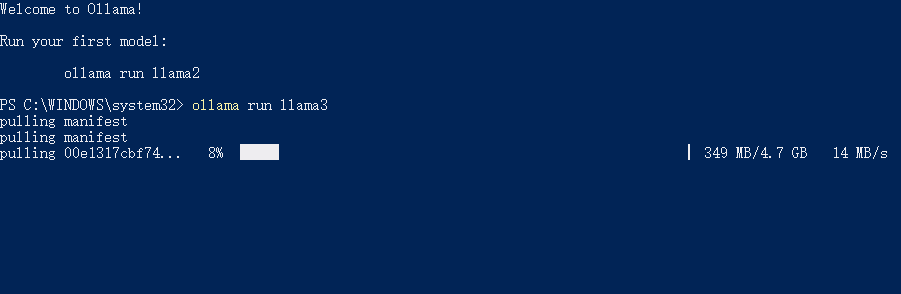

Modèle de tirage : ollama pull llama3.1

Modèle en cours d'exécution : llama run llama3.1

Supprimer le modèle : llama rm llama3.1

Liste de tous les modèles disponibles : liste ollama

Demander l'adresse du service API : ollama serve (par défaut http://localhost:11434/)

Aide Ollama

Les scripts d'installation et les guides sont disponibles sur le site web d'ollama et sur la page GitHub.

Installation à l'aide de l'image Docker fournie

Création, extraction, suppression et copie de modèles via des opérations CLI

Initialisation et exécution d'une compilation locale

Exécuter le modèle et interagir avec lui

Quelques-uns des modèles pris en charge par Ollama

| Modèle | Paramètres | Taille | Télécharger |

|---|---|---|---|

| Lama 2 | 7B | 3,8 GO | ollama run llama2 |

| Mistral | 7B | 4.1GB | ollama run mistral |

| Dolphin Phi | 2.7B | 1.6GB | ollama run dolphin-phi |

| Phi-2 | 2.7B | 1.7GB | ollama run phi |

| Chat neuronal | 7B | 4.1GB | ollama run neural-chat |

| Étourneau | 7B | 4.1GB | ollama run starling-lm |

| Code Llama | 7B | 3,8 GO | ollama run codellama |

| Llama 2 Uncensored | 7B | 3,8 GO | ollama run llama2-uncensored |

| Llama 2 13B | 13B | 7.3GB | ollama run llama2:13b |

| Llama 2 70B | 70B | 39GB | ollama run llama2:70b |

| Orca Mini | 3B | 1.9GB | ollama run orca-mini |

| Vicuna | 7B | 3,8 GO | ollama run vicuna |

| LLaVA | 7B | 4.5GB | ollama run llava |

| Gemma | 2B | 1.4GB | ollama run gemma:2b |

| Gemma | 7B | 4,8 GO | ollama run gemma:7b |

Ollama Télécharger

© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Articles connexes

Pas de commentaires...