o3 Démonstration pratique de la supériorité des modèles d'inférence génériques sur les modèles de programmation spécialisés dans le domaine de la programmation

Texte original :Une étude de la compétence en matière de concours de programmation basée sur un modèle de grand raisonnementPour faciliter la lecture, un bref résumé est fourni ci-dessous.

1. introduction

1.1 Contexte et motivation

Ces dernières années, les grands modèles de langage (LLM) ont fait des progrès significatifs dans la génération de programmes et les tâches de raisonnement complexes. Les concours de programmation, en particulier les plateformes telles que les Olympiades internationales d'informatique (IOI) et CodeForces, sont des bancs d'essai idéaux pour évaluer les capacités de raisonnement des systèmes d'IA en raison de leurs exigences rigoureuses en matière de pensée logique et de compétences de résolution de problèmes.

1.2 Objectifs de l'étude

Cette étude vise à répondre aux questions suivantes :

- Comparaison des performances des modèles de raisonnement génériques et spécifiques à un domaineLes modèles d'inférence : Comparer les performances des modèles d'inférence à usage général (par exemple, o1 et o3 d'OpenAI) avec les modèles spécifiques à un domaine conçus spécialement pour les concours IOI (par exemple, o1-ioi).

- Le rôle de l'apprentissage par renforcement dans l'amélioration des compétences en matière de raisonnement par modèle: Évaluation de la performance de grands modèles d'inférence formés par apprentissage par renforcement (RL) dans des tâches de programmation complexes.

- L'émergence de stratégies de raisonnement autonomes et modéliséesLe modèle peut développer de manière autonome des stratégies de raisonnement efficaces sans intervention humaine.

2. la méthodologie

2.1 Introduction au modèle

2.1.1 OpenAI o1

OpenAI o1 est un modèle de langage à grande échelle entraîné par apprentissage par renforcement pour générer et exécuter du code. Il résout les problèmes étape par étape en générant une chaîne de raisonnement interne, optimisée par l'apprentissage par renforcement.

2.1.2 OpenAI o1-ioi

o1-ioi est une version améliorée de o1, ajustée spécifiquement pour la compétition IOI. Il utilise une stratégie de temps de test similaire au système AlphaCode, qui consiste à générer un grand nombre de solutions candidates pour chaque sous-tâche et à sélectionner la meilleure soumission par regroupement et réorganisation.

2.1.3 OpenAI o3

o3 est le successeur de o1 et améliore encore la capacité d'inférence du modèle. Contrairement à o1-ioi, o3 ne s'appuie pas sur des stratégies de test-temps conçues manuellement, mais développe de manière autonome des stratégies d'inférence complexes par le biais d'une formation RL de bout en bout.

2.2 Méthodologie d'évaluation

2.2.1 Concours de simulation CodeForces

Nous avons simulé l'environnement de compétition CodeForces, en utilisant la suite de tests complète et en imposant des contraintes de temps et de mémoire appropriées pour évaluer les performances du modèle.

2.2.2 Concours IOI 2024 en direct

o1-ioi a participé à la compétition IOI 2024, dans les mêmes conditions que les concurrents humains.

2.2.3 Évaluation des tâches de génie logiciel

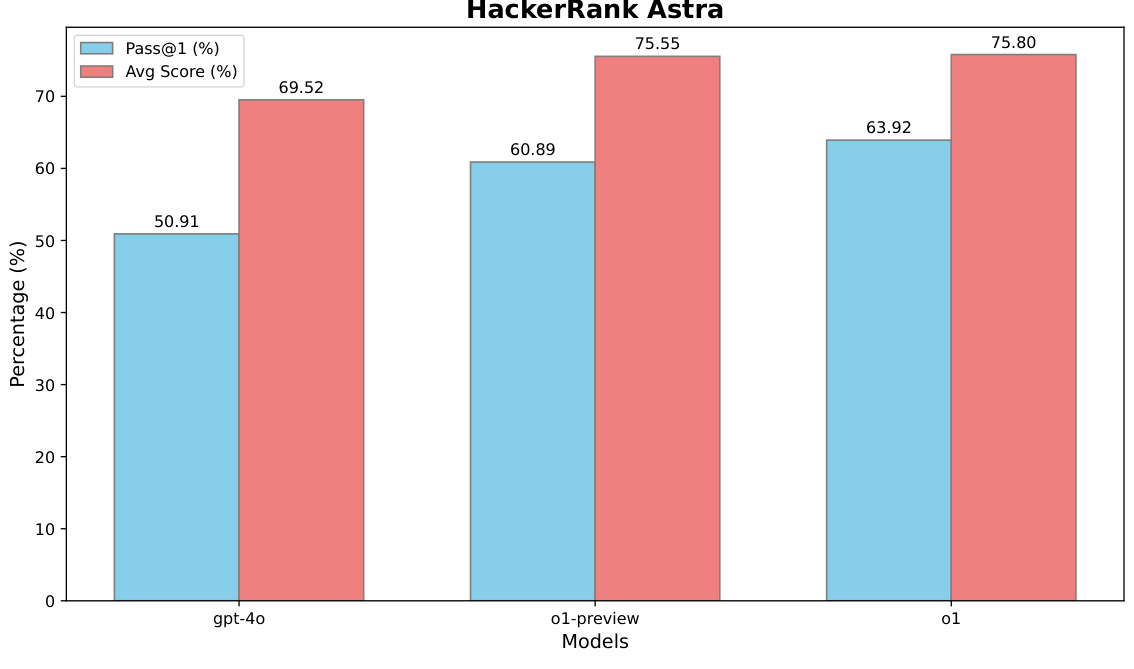

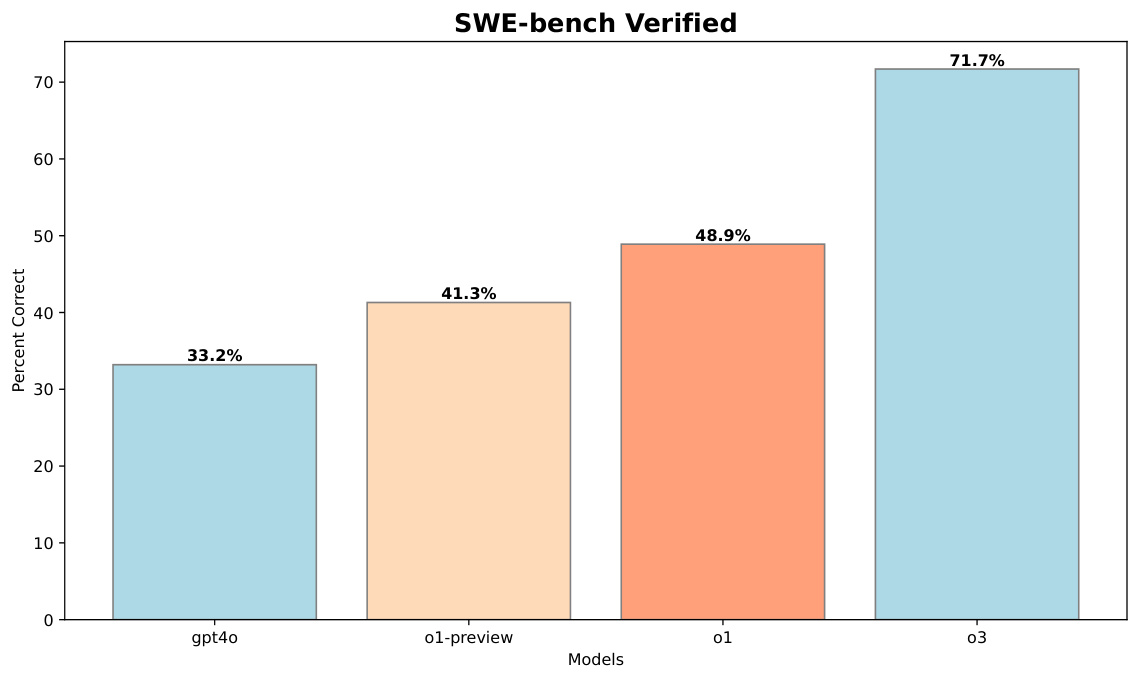

Nous avons également évalué les performances du modèle sur les ensembles de données HackerRank Astra et SWE-bench Verified afin de tester ses capacités dans des tâches réelles de développement de logiciels.

3. la découverte

3.1 Modèles génériques et modèles spécifiques à un domaine

- o1-ioi dans le concours IOIDans la compétition 2024 IOI, o1-ioi a obtenu 213 points et s'est classé 49%. Après avoir assoupli les restrictions de soumission, son score s'est amélioré pour atteindre 362,14 points, ce qui est supérieur à la ligne de score de la médaille d'or.

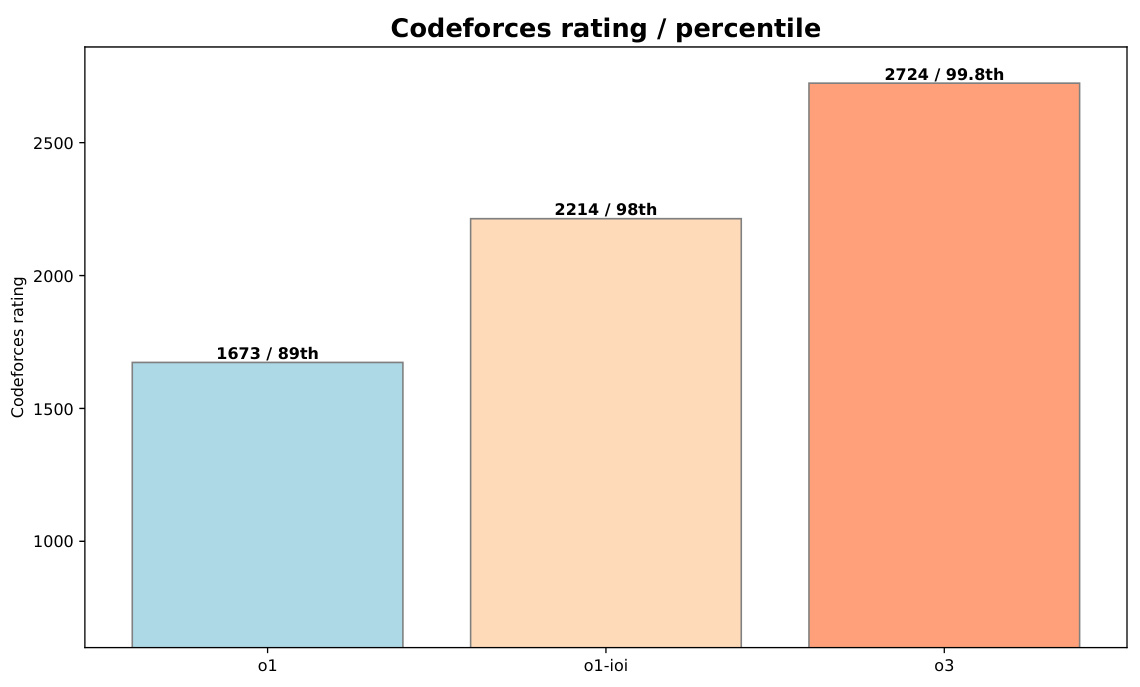

- o3 excellenceo3 a obtenu de bons résultats dans les tests CodeForces avec une note de 2724 (99,8e percentile), nettement supérieure à celle de o1-ioi (2214, 98e percentile). Dans le benchmark IOI 2024, o3 a également obtenu un score de 395.64, dépassant la ligne de score de la médaille d'or, avec une limite de seulement 50 soumissions.

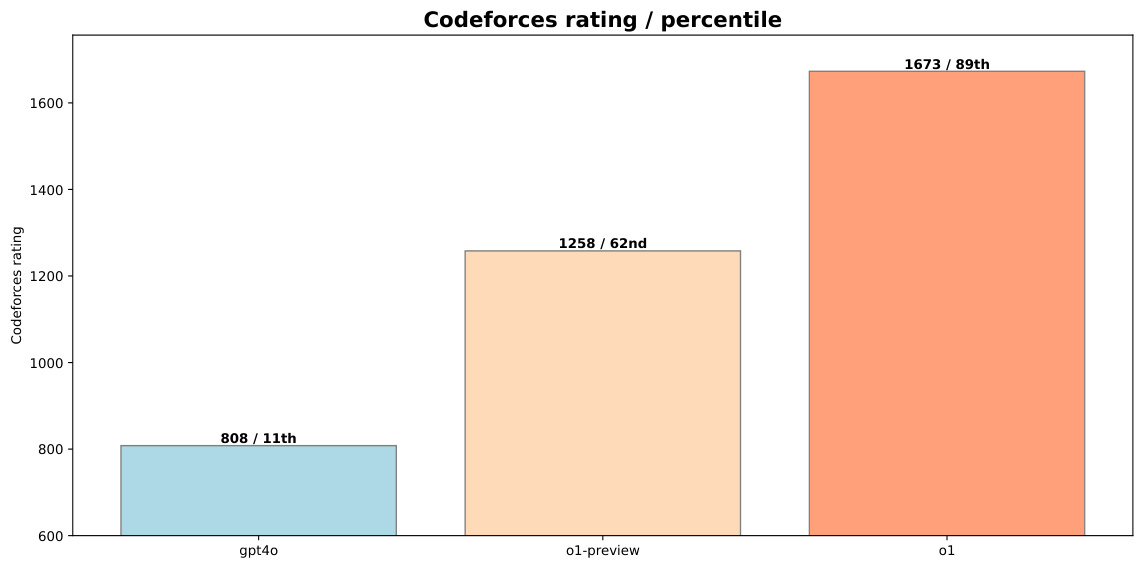

Figure 1 : Comparaison des performances de o1-preview et de o1 avec gpt-4o à CodeForces

3.2 Renforcer le rôle de l'apprentissage

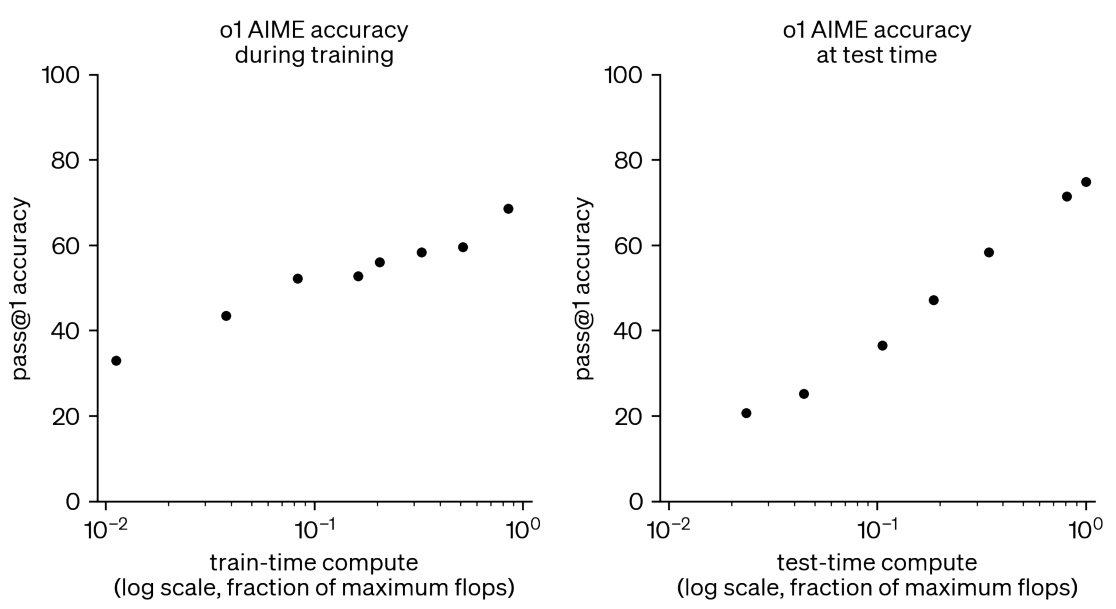

- Augmentation des calculs lors de l'apprentissage et du test du RLComme le montre la figure 2, l'augmentation des ressources informatiques pendant l'entraînement et le test du RL peut améliorer de manière significative les performances du modèle dans les tâches mathématiques concurrentielles.

Figure 2 : un entraînement RL supplémentaire et un calcul en temps réel améliorent les performances dans les tâches mathématiques compétitives.

3.3 Émergence de stratégies de raisonnement autonome par modèle

- Stratégies de raisonnement autonome pour o3o3 présente des chaînes de raisonnement plus complexes et plus réfléchies lorsqu'il est testé. Par exemple, pour les problèmes nécessitant une validation, il génère des solutions simples par force brute, puis compare ses résultats à une implémentation plus optimisée de l'algorithme afin de détecter les erreurs potentielles.

Figure 3 : La solution o3 test itself, reflétant une implémentation partielle de la stratégie test-time utilisée par o1-ioi dans IOI 2024

4) Conclusion

4.1 Principales conclusions

- Supériorité des modèles généralisésLes modèles spécifiques à un domaine (par exemple, o1-ioi) donnent de bons résultats pour des tâches spécifiques, mais les modèles généraux (par exemple, o3) entraînés dans le cadre d'un RL à grande échelle sont capables de dépasser ces résultats sans s'appuyer sur des heuristiques d'inférence conçues à la main.

- Efficacité de la formation en LRLe rapport de la Commission européenne sur l'état de la science et de la technologie : L'ajout de ressources informatiques pour l'entraînement à la RL et les tests permet d'améliorer régulièrement les performances des modèles et de les rapprocher de celles des meilleurs joueurs humains du monde.

- Modélisation de la capacité à développer de manière autonome des stratégies complexeso3 démontre la capacité du modèle à développer de manière autonome des stratégies d'inférence complexes, éliminant ainsi le besoin de stratégies de test-temps conçues manuellement.

4.2 Perspectives d'avenir

Les résultats de cette étude montrent que l'entraînement RL à grande échelle constitue une voie solide pour atteindre l'état de l'art de l'IA dans des domaines de raisonnement tels que la programmation compétitive. À l'avenir, les grands modèles d'inférence devraient débloquer de nombreux nouveaux scénarios d'application dans une variété de domaines tels que la science, le codage et les mathématiques.

5. exemples

5.1 Exemples de solutions issues du concours IOI 2024

5.1.1 Le problème du Nil

o1-ioi a obtenu la note maximale pour le problème du Nil, voici l'exemple de code pour la solution :

#include "nile.h"

#include <bits/stdc++.h>

using namespace std;

// ... (代码省略,详见附录C.1)

5.1.2 Problème de message

o1-ioi a obtenu 79,64 pour le problème Message et voici l'exemple de code pour la solution :

#include "message.h"

#include <bits/stdc++.h>

using namespace std;

// ... (代码省略,详见附录C.2)

5.2 Exemples de solutions dans les tâches d'ingénierie logicielle

5.2.1 Jeu de données HackerRank Astra

o1 sur l'ensemble de données HackerRank Astra :

Figure 4 : Performances de o1 sur l'ensemble de données HackerRank Astra

5.2.2 SWE-bench Verified dataset (jeu de données vérifié)

o3 sur l'ensemble de données vérifiées SWE-bench :

Figure 5 : Performance de o3 sur l'ensemble de données vérifiées du SWE-bench

© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Postes connexes

Pas de commentaires...