MuseV+Muse Talk : Cadre complet de génération de vidéos humaines numériques - du portrait à la vidéo - de la pose à la vidéo - de la synchronisation labiale

Introduction générale

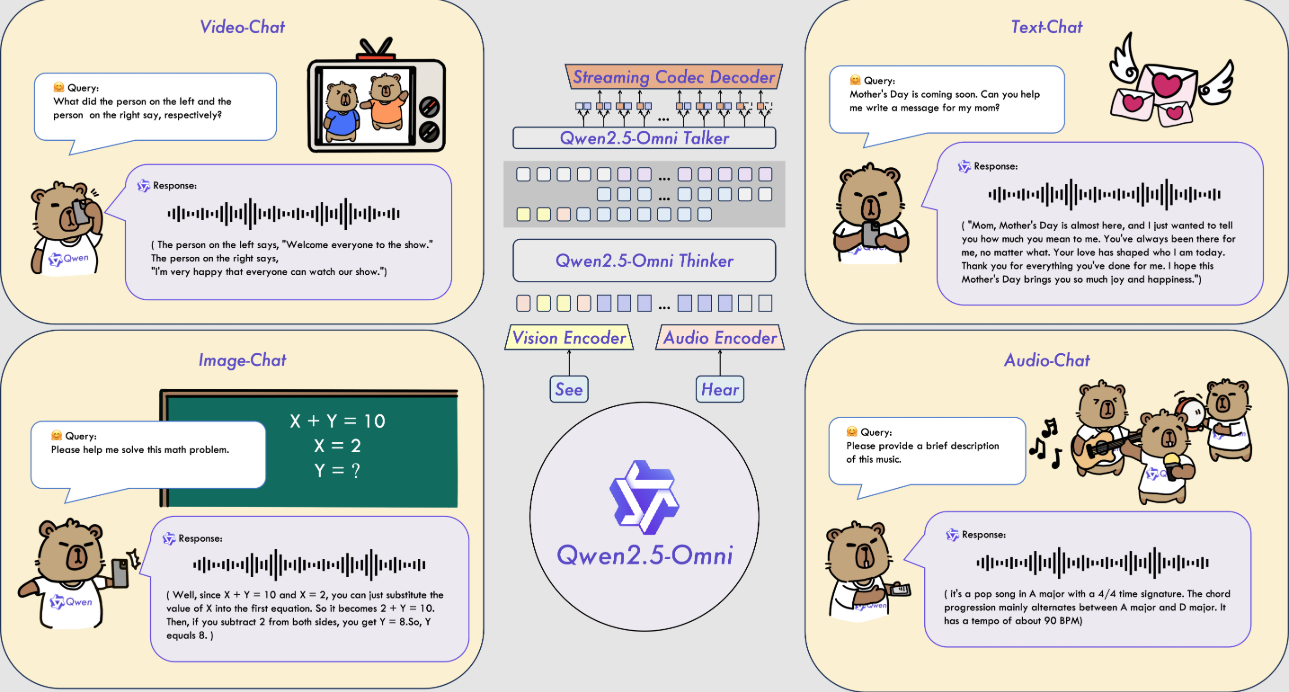

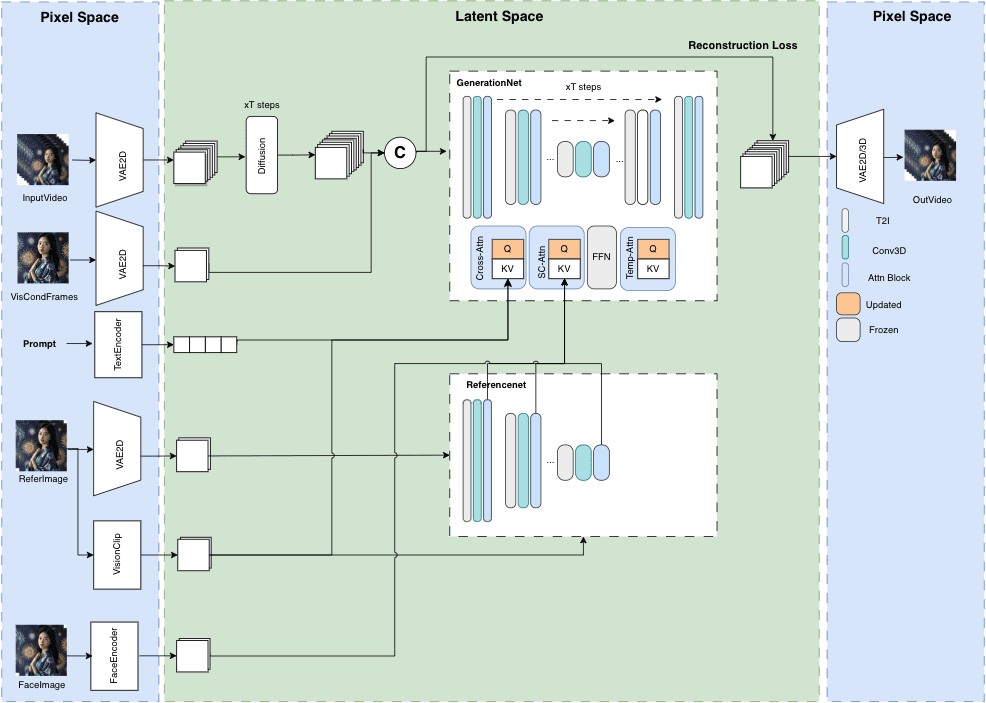

MuseV est un projet public sur GitHub visant à générer des vidéos d'avatars de longueur illimitée et de haute fidélité. Il est basé sur la technologie de diffusion et offre diverses fonctionnalités telles que Image2Video, Text2Image2Video, Video2Video et bien d'autres. Les détails de la structure du modèle, les cas d'utilisation, le guide de démarrage rapide, les scripts d'inférence et les remerciements sont fournis.

MuseV est un cadre de génération de vidéos d'humains virtuels basé sur un modèle de diffusion avec les caractéristiques suivantes :

Il prend en charge la génération de longueurs infinies à l'aide d'un nouveau schéma de débruitage parallèle conditionnel visuel sans le problème de l'accumulation d'erreurs, en particulier pour les scènes avec des positions de caméra fixes.

Un modèle pré-entraîné pour la génération de vidéos d'avatars, formé sur un ensemble de données de types de caractères, est fourni.

Prise en charge de la génération image-vidéo, texte-image-vidéo et vidéo-vidéo.

Compatible avec l'écosystème de génération graphique de Stable Diffusion, y compris base_model, lora, controlnet, et plus encore.

Prise en charge de plusieurs technologies d'images de référence, notamment IPAdapter, ReferenceOnly, ReferenceNet, IPAdapterFaceID.

Nous déploierons également le code de formation ultérieurement.

Liste des fonctions

Génération de vidéos de longueur illimitée

Images humaines virtuelles de haute fidélité

Prise en charge polyvalente : Image2Vidéo, Texte2Image2Vidéo, Vidéo2Vidéo

Structure claire du modèle et cas d'utilisation

Scripts de démarrage rapide et de raisonnement

Utiliser l'aide

Visitez les dépôts GitHub pour les mises à jour et les ressources téléchargeables.

Suivez le guide de démarrage rapide pour la configuration initiale du projet

Générer du contenu vidéo à l'aide des scripts d'inférence fournis

Méthode d'utilisation combinée :

Méthode 1 : Enregistrement vidéo en direct + Muse Talk

Méthode 2 : Photo + MuseV + Muse Talk

un produit fini

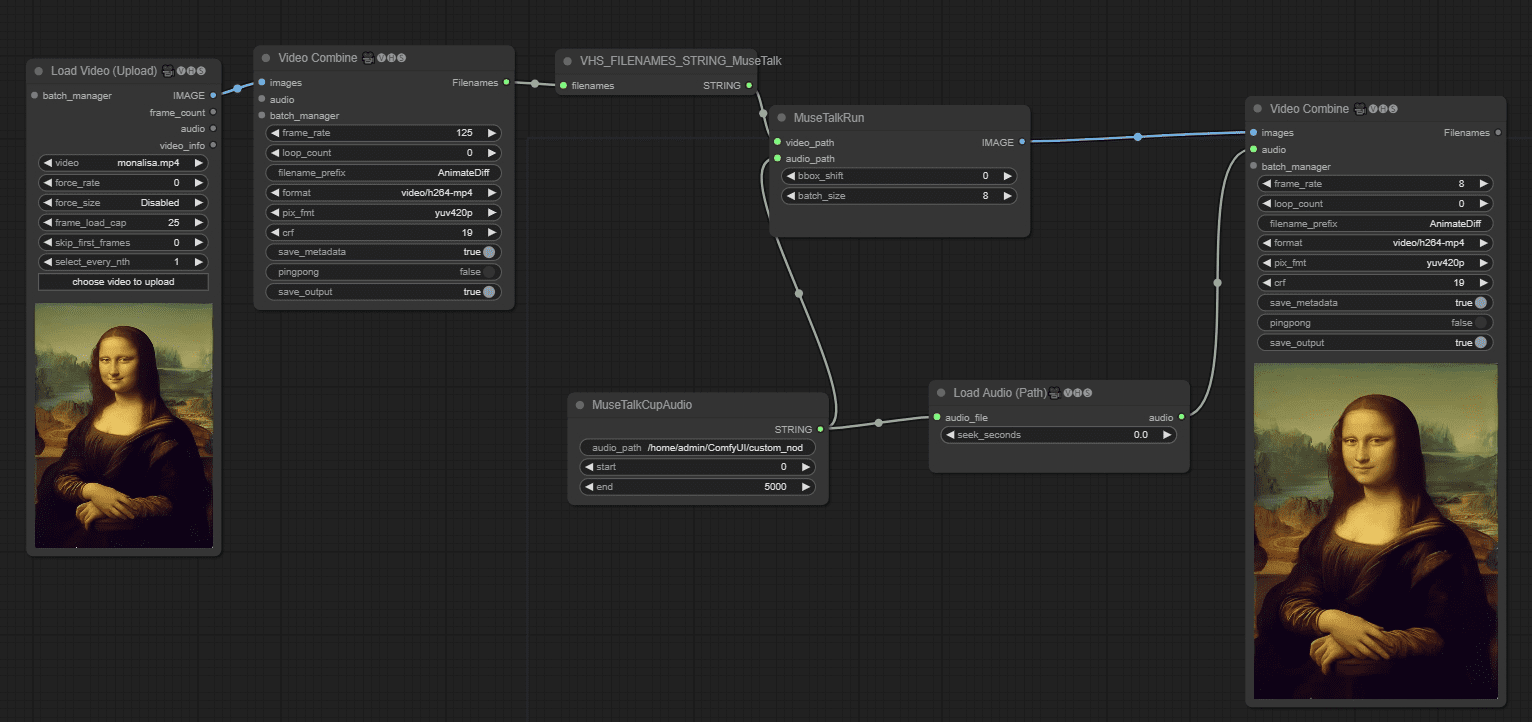

À partir d'une image fixe en boucle, faites parler le personnage d'anime, les lèvres du personnage de dessin animé sont absentes, ce qui le rend étrange à parler, la prochaine fois vous devriez changer l'image avec des "lèvres", de préférence une "vraie personne". 45 secondes de vidéo dans la version officielle. Attendez environ 15 minutes pour l'environnement de test.

Faire parler la vidéo dans les flux de travail de ComfyUI

Nous lançons MuseTalk MuseTalk est un modèle de synchronisation buccale en temps réel et de haute qualité (30fps+ sur NVIDIA Tesla V100). MuseTalk peut être appliqué à une vidéo d'entrée, telle que celle générée par MuseV, comme une solution complète d'avatar.

MuseV Online Experience / Windows One-Click Installation Package

Le modèle de synchronisation buccale du compagnon MuseV MuseTalk

Lien : https://pan.quark.cn/s/ed896ceda5c8

Code de l'extrait : JygA

© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Articles connexes

Pas de commentaires...