Model Context Provider CLI : outil en ligne de commande permettant d'utiliser les services MCP dans n'importe quel grand modèle, sans dépendre de Claude.

Introduction générale

Le Model Context Provider CLI (mcp-cli) est un outil de ligne de commande au niveau du protocole permettant d'interagir avec les serveurs de fournisseurs de contexte de modèle. L'outil permet aux utilisateurs d'envoyer des commandes, d'interroger des données et d'interagir avec une variété de ressources fournies par le serveur. mcp-cli prend en charge plusieurs fournisseurs et modèles, notamment OpenAI et Ollama, les modèles par défaut étant respectivement gpt-4o-mini et qwen2.5-coder. L'outil nécessite Python 3.8 ou une version plus récente, ainsi que les dépendances appropriées. appropriées. Vous pouvez utiliser l'outil en clonant le dépôt GitHub et en installant les dépendances nécessaires.

Liste des fonctions

- Prise en charge de la communication au niveau du protocole avec les serveurs de fourniture de contexte de modèle

- Des outils et des ressources dynamiques à explorer

- Prise en charge de plusieurs fournisseurs et modèles (OpenAI et Ollama)

- Fournit un mode interactif qui permet aux utilisateurs d'exécuter dynamiquement des commandes.

- Les commandes prises en charge sont les suivantes : ping, list-tools, list-resources, list-prompts, chat, clear, help, quit/exit.

- Les paramètres de ligne de commande pris en charge sont les suivants : --server, --config-file, --provider, --model

Utiliser l'aide

Processus d'installation

- Entrepôt de clonage :

git clone https://github.com/chrishayuk/mcp-cli

cd mcp-cli

- Installer les UV :

pip install uv

- Synchronisation des dépendances :

uv sync --reinstall

Utilisation

- Démarrer le client et interagir avec le serveur SQLite :

uv run main.py --server sqlite

- Exécuter le client avec le fournisseur et le modèle OpenAI par défaut :

uv run main.py --server sqlite

- En utilisant des configurations spécifiques et des Ollama Le fournisseur exécute le client :

uv run main.py --server sqlite --provider ollama --model llama3.2

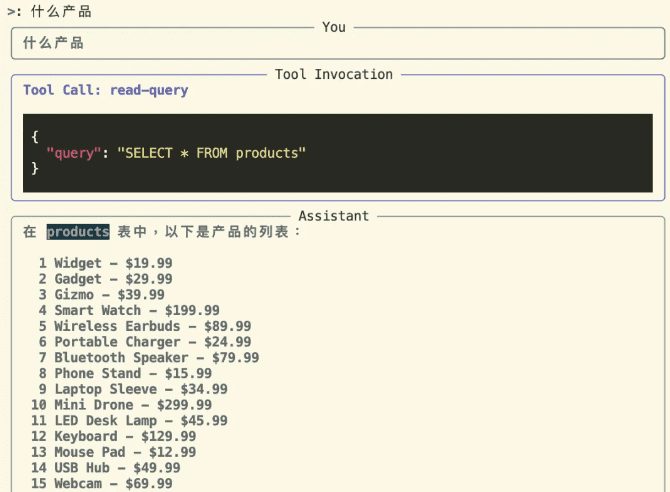

mode interactif

Entrez en mode interactif et interagissez avec le serveur :

uv run main.py --server sqlite

En mode interactif, vous pouvez utiliser l'outil et interagir avec le serveur. Le fournisseur et le modèle spécifiés au démarrage s'affichent comme suit :

Entering chat mode using provider 'ollama' and model 'llama3.2'...

Commandes prises en charge

pingVérification de la réponse du serveurlist-tools: Afficher les outils disponibleslist-resourcesRessources disponibles : Montrer les ressources disponibleslist-prompts: Afficher les conseils disponibleschatMode conversationnel : entrer dans le mode conversationnel interactifclear: Effacer l'écran du terminalhelpAffiche une liste des commandes prises en charge.quit/exitExit Client : Quitter le client

Utiliser les fournisseurs OpenAI

Si vous souhaitez utiliser un modèle OpenAI, vous devez définir le paramètre OPENAI_API_KEY qui se trouve dans le fichier .env ou en tant que variable d'environnement.

© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Articles connexes

Pas de commentaires...