LongWriter : Wisdom Spectrum a lancé un modèle puissant de génération de textes ultra-longs, permettant de générer plus de 10 000 mots dans une seule conversation.

Introduction générale

LongWriter est un puissant outil de génération de textes longs développé par le groupe de recherche sur l'exploration des données de l'université de Tsinghua (THUDM). Les modèles de base de LongWriter comprennent LongWriter-glm4-9b et LongWriter-llama3.1-8b, qui sont basés sur la formation GLM-4-9B et Meta-Llama-3.1-8B, respectivement. . Ces modèles sont performants dans la génération de textes longs et conviennent à divers scénarios d'application nécessitant la génération de textes volumineux, tels que la création de romans, la rédaction d'articles universitaires et la génération de rapports détaillés, etc. LongWriter n'est pas seulement open source, il fournit également un guide de déploiement et d'utilisation détaillé afin de permettre aux utilisateurs de démarrer rapidement.

Liste des fonctions

- Génération de textes longsLa nouvelle version du logiciel permet de générer des textes longs de plus de 10 000 mots pour un large éventail de scénarios d'application.

- Prise en charge de plusieurs modèlesLes deux modèles basés sur GLM-4-9B et Meta-Llama-3.1-8B sont fournis et les utilisateurs peuvent choisir en fonction de leurs besoins.

- Déploiement rapideLe logiciel de gestion de l'information : Il fournit des guides de déploiement détaillés et des exemples de code pour faciliter le déploiement et l'utilisation rapides du logiciel.

- source ouverteLe code et les modèles sont libres et peuvent être librement téléchargés et modifiés par les utilisateurs.

- Construction automatisée de donnéesLes outils AgentWrite pour la construction automatisée de données de sortie ultra-longues.

Utiliser l'aide

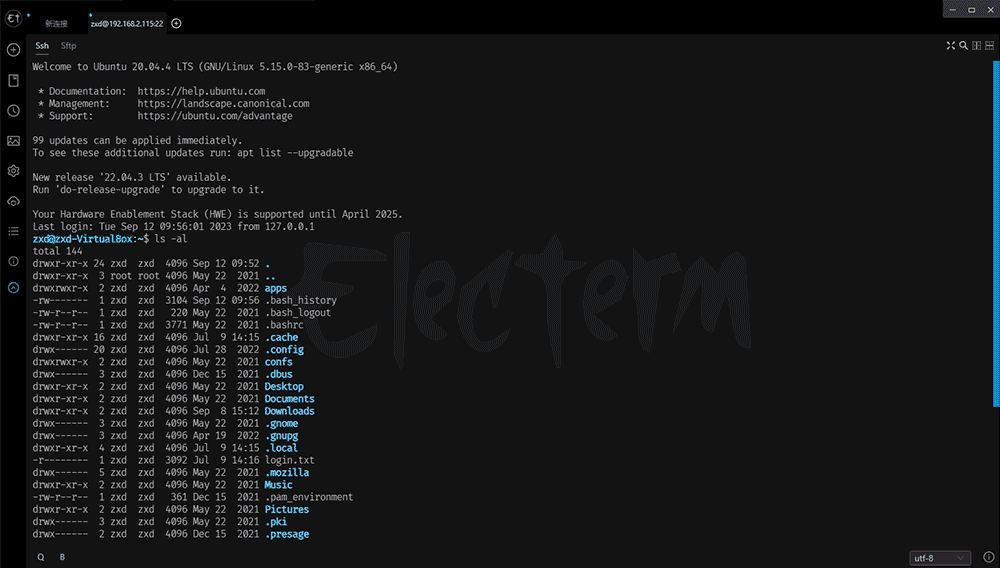

Installation et déploiement

- Préparation de l'environnementPython 3.8 ou plus : Assurez-vous que Python 3.8 ou plus est installé et installez les bibliothèques de dépendance nécessaires, par exemple transformers>=4.43.0.

- Télécharger les modèlesTéléchargez les modèles requis à partir de Hugging Face, tels que LongWriter-glm4-9b ou LongWriter-llama3.1-8b.

- Installation des dépendancesPour installer les paquets Python requis, exécutez la commande suivante :

pip install transformers torch

- Modèles de chargementLe code suivant permet de charger le modèle et d'effectuer l'inférence :

from transformers import AutoTokenizer, AutoModelForCausalLM

import torch

tokenizer = AutoTokenizer.from_pretrained("THUDM/LongWriter-glm4-9b", trust_remote_code=True)

model = AutoModelForCausalLM.from_pretrained("THUDM/LongWriter-glm4-9b", torch_dtype=torch.bfloat16, trust_remote_code=True, device_map="auto")

model = model.eval()

query = "Write a 10000-word China travel guide"

response, history = model.chat(tokenizer, query, history=[], max_new_tokens=32768, temperature=0.5)

print(response)

Utilisation de l'outil AgentWrite

- Configuration de la clé API: en

plan.pyrépondre en chantantwrite.pypour configurer votre clé API. - Construction des données opérationnellesLes commandes suivantes sont exécutées l'une après l'autre pour générer les données finales :

python plan.py

python write.py

Principales fonctions

- Génération de textes longsLe modèle génère des textes longs de plus de 10 000 mots sur la base des données saisies.

- Sélection du modèleLes modèles d'écriture sont les suivants : sélectionnez le modèle approprié (par exemple LongWriter-glm4-9b ou LongWriter-llama3.1-8b) en fonction de vos besoins spécifiques.

- paramétrageOptimiser la génération en ajustant les paramètres de génération (par exemple, la température, le nombre maximum de mots nouveaux, etc.)

Mode d'emploi détaillé

- Génération de texteLe modèle génère automatiquement un texte descriptif : entrez un thème ou un mot-guide dans la zone de saisie, cliquez sur le bouton Générer.

- formation au modèleTélécharger et utiliser un mélange de l'ensemble de données LongWriter-6k et d'autres données SFT pour entraîner le modèle conformément au code d'entraînement fourni.

- Exemple de déploiement: Référence

vllm_inference.pydans le fichier pour un déploiement rapide et une génération de texte ultra longue.

© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Articles connexes

Pas de commentaires...