LocalAI : solutions open source de déploiement de l'IA locale, prise en charge de plusieurs architectures de modèles, gestion unifiée des modèles et des API par l'interface WebUI.

Introduction générale

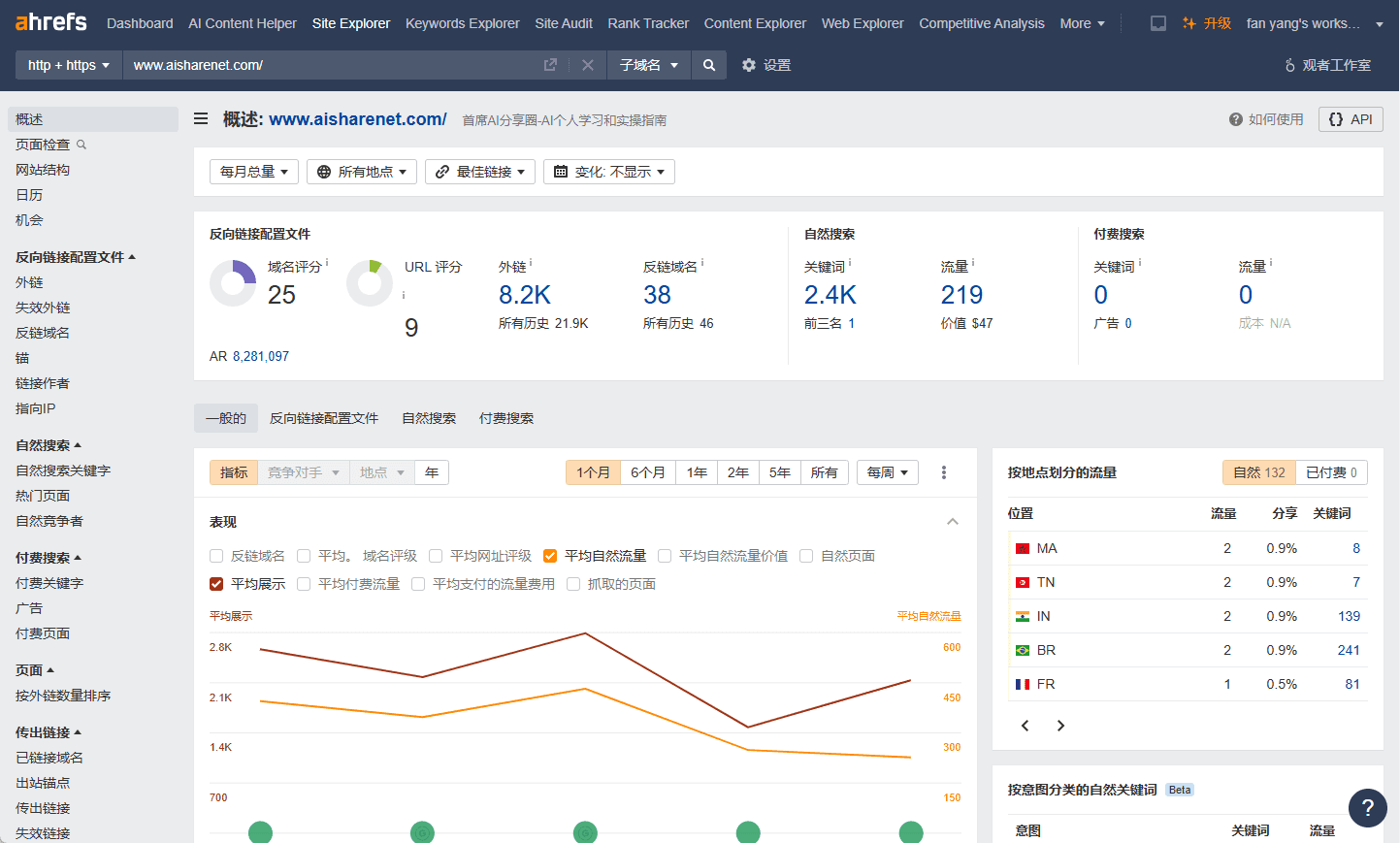

LocalAI est une alternative open source à l'IA locale qui vise à fournir des interfaces API compatibles avec OpenAI, Claude et d'autres. LocalAI a été créé et est maintenu par Ettore Di Giacinto, et prend en charge un large éventail d'architectures de modèles, y compris gguf, transformateurs, diffuseurs, et plus encore pour les déploiements locaux ou sur site.

Liste des fonctions

- Génération de texte : prend en charge la série de modèles GPT, capables de générer un contenu textuel de haute qualité.

- Génération audio : génère une voix naturelle et fluide grâce à la fonction texte-audio.

- Génération d'images : des images de haute qualité sont générées à l'aide d'un modèle de diffusion stable.

- Clonage de la parole : génère une parole similaire à la voix originale grâce à la technologie de clonage de la parole.

- Raisonnement distribué : prend en charge le raisonnement P2P pour améliorer l'efficacité du raisonnement sur les modèles.

- Téléchargement de modèles : téléchargez et exécutez des modèles directement à partir de plateformes telles que Huggingface.

- Interface utilisateur Web intégrée : fournit une interface utilisateur Web intégrée pour une utilisation conviviale.

- Génération d'intégration de bases de données vectorielles : Prise en charge de la génération d'intégration de bases de données vectorielles.

- Syntaxe contraignante : prise en charge de la génération de contenu textuel avec syntaxe contraignante.

- Vision API : fournit des fonctions de traitement et d'analyse d'images.

- API de réorganisation : permet de réorganiser et d'optimiser le contenu textuel.

Processus d'installation

- Utilisation de scripts d'installation: :

- Exécutez la commande suivante pour télécharger et installer LocalAI :

curl -s https://localai.io/install.sh | sh

- Exécutez la commande suivante pour télécharger et installer LocalAI :

- Utilisation de Docker: :

- S'il n'y a pas de GPU, lancez la commande suivante pour démarrer LocalAI :

docker run -ti --name local-ai -p 8080:8080 localai/localai:latest-aio-cpu - Si vous disposez d'un GPU Nvidia, exécutez la commande suivante :

docker run -ti --name local-ai -p 8080:8080 --gpus all localai/localai:latest-aio-gpu-nvidia-cuda-12

- S'il n'y a pas de GPU, lancez la commande suivante pour démarrer LocalAI :

Processus d'utilisation

- Démarrer LocalAI: :

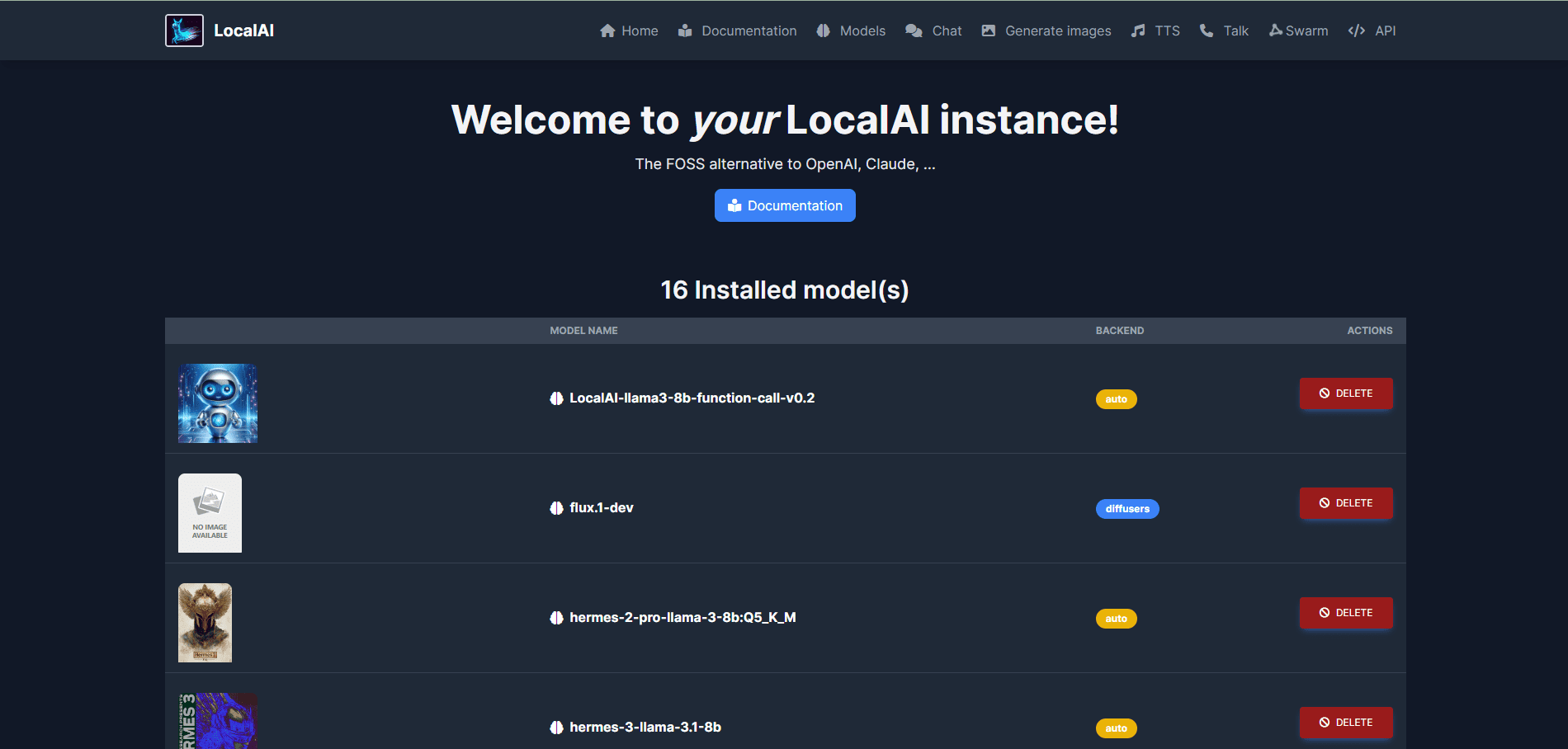

- Après avoir démarré LocalAI par le processus d'installation décrit ci-dessus, accédez à l'écran d'accueil de LocalAI.

http://localhost:8080Accédez à l'interface WebUI.

- Après avoir démarré LocalAI par le processus d'installation décrit ci-dessus, accédez à l'écran d'accueil de LocalAI.

- Modèles de chargement: :

- Dans l'interface WebUI, naviguez jusqu'à l'onglet Modèles et sélectionnez et chargez le modèle souhaité.

- Il est également possible de charger le modèle à l'aide de la ligne de commande, par exemple :

local-ai run llama-3.2-1b-instruct:q4_k_m

- Générer du contenu: :

- Dans l'interface WebUI, sélectionnez le module fonctionnel approprié (par exemple, génération de texte, génération d'images, etc.), entrez les paramètres requis et cliquez sur le bouton Générer.

- Par exemple, pour générer du texte, saisissez l'invite, sélectionnez le modèle et cliquez sur le bouton "Générer du texte".

- inférence distribuée: :

- Configurer plusieurs instances LocalAI pour réaliser une inférence P2P distribuée et améliorer l'efficacité de l'inférence.

- Reportez-vous au Guide de configuration de l'inférence distribuée dans la documentation officielle.

Fonctionnalités avancées

- Modèles personnalisés: :

- Les utilisateurs peuvent télécharger et charger des modèles personnalisés à partir de Huggingface ou du registre OCI pour répondre à des besoins spécifiques.

- Intégration de l'API: :

- LocalAI fournit une API REST compatible avec l'API OpenAI pour que les développeurs puissent facilement l'intégrer dans des applications existantes.

- Reportez-vous à la documentation officielle de l'API pour une utilisation détaillée de l'API.

© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Articles connexes

Pas de commentaires...