LLManager : un outil de gestion qui combine des approbations de processus automatisées et intelligentes avec des audits humains.

Introduction générale

LLManager est un outil open source de gestion intelligente des approbations basé sur la technologie LangChain. LangGraph Cadre développé pour automatiser le traitement des demandes d'approbation tout en optimisant la prise de décision en conjonction avec l'examen humain. Il tire des enseignements de l'historique des approbations grâce à la recherche sémantique, à l'apprentissage par échantillonnage et aux mécanismes de réflexion afin d'améliorer la précision des approbations. Les utilisateurs peuvent utiliser le Boîte de réception des agents En affichant et en répondant aux demandes, en prenant en charge des critères d'approbation et de rejet personnalisés et en s'adaptant à de multiples modèles linguistiques (par exemple, OpenAI, Anthropic), LLManager convient à l'approbation du budget de l'entreprise, à la gestion de projet et aux scénarios d'examen de la conformité, et le code est hébergé sur GitHub, ce qui permet aux développeurs d'étendre librement les fonctionnalités. L'outil met l'accent sur la collaboration entre l'IA et l'homme, en équilibrant l'efficacité et la fiabilité.

Liste des fonctions

- Approbations automatiséesLes recommandations d'approbation : Générer automatiquement des recommandations d'approbation basées sur des critères d'approbation et de rejet définis par l'utilisateur.

- Audit humainLe système de gestion de l'information de la Commission européenne (CEI) permet d'accepter, de modifier ou de rejeter manuellement les approbations générées par l'IA afin d'assurer une prise de décision précise.

- recherche sémantiqueLes résultats de l'étude sont les suivants : extraction de 10 échantillons sémantiquement similaires à partir de demandes historiques afin d'améliorer la pertinence contextuelle des approbations.

- l'apprentissage avec moins d'échantillonsOptimiser les capacités décisionnelles futures du modèle sur la base des données historiques d'approbation.

- Mécanismes de réflexionLe modèle d'approbation est un outil de gestion qui permet d'analyser les résultats des approbations modifiées et de générer des rapports de réflexion afin d'améliorer les performances du modèle.

- Personnalisation du modèleSupport pour les modèles tels que OpenAI, Anthropic, etc., avec support pour la fonction d'appel d'outil.

- Agent Inbox InteractiveLe système de gestion des demandes d'approbation : fournit une interface intuitive pour visualiser, répondre et gérer les demandes d'approbation.

- Création de repères dynamiquesLe système de gestion de l'information : Il ajuste dynamiquement les messages-guides en fonction des demandes afin de répondre aux différents scénarios d'approbation.

- Évaluation de bout en boutLes tests sont effectués pour vérifier la fiabilité et l'exactitude du flux de travail.

Utiliser l'aide

Processus d'installation

LLManager est basé sur les projets open source LangChain et LangGraph et doit être déployé localement. Voici les étapes détaillées de l'installation :

- Clonage de la base de code: :

Exécutez la commande suivante dans le terminal pour obtenir le code LLManager :git clone https://github.com/langchain-ai/llmanager.git cd llmanager - Installation des dépendances: :

Assurez-vous que Python 3.11 ou plus récent et Node.js (pour Yarn) sont installés sur votre système. Créez un environnement virtuel et installez les dépendances :python3 -m venv venv source venv/bin/activate yarn installLes dépendances par défaut incluent LangChain et le paquet d'intégration Anthropic/OpenAI. Des installations supplémentaires sont nécessaires si vous utilisez d'autres modèles (par exemple Google GenAI) :

yarn install @langchain/google-genai - Configuration des variables d'environnement: :

Copiez l'exemple de fichier d'environnement et complétez les informations nécessaires :cp .env.example .envcompilateur

.envajoutez la clé de l'API LangSmith et le fichier Anthropique Clé API (si vous utilisez le modèle anthropique) :LANGCHAIN_PROJECT="default" LANGCHAIN_API_KEY="lsv2_..." LANGCHAIN_TRACING_V2="true" LANGSMITH_TEST_TRACKING="true" ANTHROPIC_API_KEY="your_anthropic_key"LangSmith est utilisé pour le traçage et le débogage et il est recommandé de l'activer.

- Démarrer le serveur de développement: :

Exécutez la commande suivante pour démarrer le serveur LangGraph :yarn devLe serveur fonctionne par défaut sur le serveur

http://localhost:2024Dans les environnements de production, déployer sur un serveur en nuage et mettre à jour l'URL. Dans un environnement de production, déployer sur un serveur en nuage et mettre à jour l'URL.

Utilisation

Le cœur de LLManager est de gérer et de répondre aux demandes d'approbation par le biais de la boîte de réception des agents. Vous trouverez ci-dessous le déroulement détaillé des opérations :

- Réalisation d'une évaluation de bout en bout: :

- Exécutez la commande suivante pour générer un nouvel assistant d'approbation et exécuter 25 cas de test :

yarn test:single evals/e2e.int.test.ts - Le terminal émet l'UUID du nouvel assistant et enregistre cet ID pour la configuration de la boîte de réception de l'agent.

- Si vous devez réutiliser le même assistant, vous pouvez modifier le fichier

evals/e2e.int.test.tsSi vous utilisez un identifiant d'assistant fixe, utilisez l'identifiant d'assistant fixe.

- Exécutez la commande suivante pour générer un nouvel assistant d'approbation et exécuter 25 cas de test :

- Configuration des règles d'approbation: :

- existent

config.jsonDéfinir les critères d'approbation et de rejet dans la section exemple :{ "approvalCriteria": "请求需包含详细预算和时间表", "rejectionCriteria": "缺少必要文件或预算超标", "modelId": "anthropic/claude-3-7-sonnet-latest" } - Lorsqu'aucune règle n'est définie, LLManager apprend sur la base de données historiques, mais la définition de règles accélère l'adaptation du modèle.

modelIdadjuvantprovider/model_namecomme par exempleopenai/gpt-4opeut-êtreanthropic/claude-3-5-sonnet-latest.

- existent

- Utilisation de la boîte de réception des agents: :

- Allez sur dev.agentinbox.ai et cliquez sur "Add Inbox".

- Saisissez les informations suivantes :

- Assistant/Graph IDUUID : UUID généré par l'évaluation de bout en bout.

- URL de déploiement: :

http://localhost:2024(environnement de développement). - Nom: Personnalisez le nom, par ex.

LLManager.

- Actualisez la boîte de réception après la soumission pour voir les demandes en attente.

- Pour chaque demande, la boîte de réception de l'agent s'affiche :

- Recommandations d'approbation et rapports de motivation générés par l'IA.

- Options d'action : Accepter, Modifier (éditer les suggestions ou les instructions), ou Rejeter (indiquer les raisons).

- Les demandes modifiées ou acceptées sont automatiquement enregistrées dans la bibliothèque Less Sample Example afin d'optimiser les approbations ultérieures.

- Visualiser et optimiser l'historique des approbations: :

- Dans la boîte de réception de l'agent, cliquez sur Demandes traitées pour afficher les détails de l'approbation, les rapports d'inférence AI et les journaux de modification manuelle.

- Le système extrait les demandes similaires de l'historique en tant que modèles d'entrée contextuels par le biais d'une recherche sémantique.

- La demande modifiée déclenche le mécanisme de réflexion, qui génère un rapport de réflexion stocké dans le référentiel de réflexion et utilisé pour améliorer le modèle.

Fonction en vedette Fonctionnement

- recherche sémantiqueLorsqu'une nouvelle demande arrive, le système extrait de l'historique 10 demandes sémantiquement similaires (y compris le contenu de la demande, la réponse finale et la description) afin d'améliorer la précision de l'approbation.

- Mécanismes de réflexion: :

- Si le manuel ne modifie que la description (réponse correcte mais raisonnement incorrect), déclencher la fonction

explanation_reflectionpour analyser les erreurs de raisonnement et générer de nouvelles réflexions. - Si la réponse et la description sont toutes deux modifiées, déclencher

full_reflectionen analysant les erreurs globales et en produisant des réflexions. - Les rapports de réflexion sont déposés dans une banque de réflexion afin d'optimiser le raisonnement ultérieur.

- Si le manuel ne modifie que la description (réponse correcte mais raisonnement incorrect), déclencher la fonction

- Création de repères dynamiquesAjuste dynamiquement les invites en fonction du contenu de la demande et des données historiques pour garantir que les approbations sont adaptées à une variété de scénarios.

- Changement de modèle: en modifiant le

config.jsona fait mouchemodelIdPour ce faire, il faut passer à un modèle qui prend en charge les appels d'outils (par ex.openai/gpt-4o), vous devez vous assurer que le paquet d'intégration correspondant est installé.

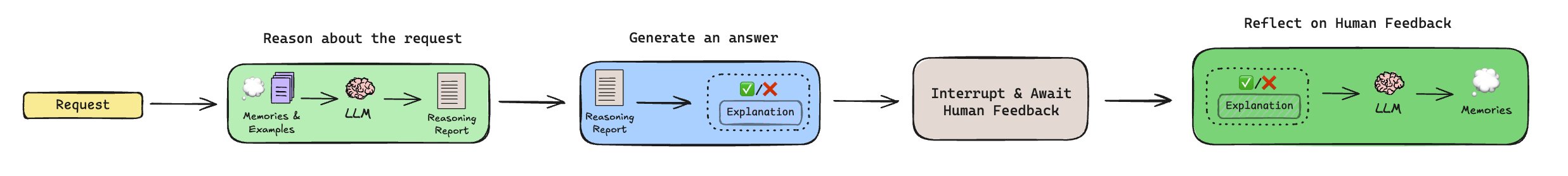

Le flux de travail expliqué

Le processus d'approbation de LLManager comprend les étapes suivantes :

- Raisonnement: :

- Extraire des réflexions historiques et des exemples de moindre importance (via la recherche sémantique).

- Génère un rapport de motivation qui analyse si la demande doit être acceptée, mais ne prend pas la décision finale.

- Générer une réponse: :

- Combiner le rapport de raisonnement et le contexte pour générer une recommandation d'approbation finale (approuver ou rejeter) et une description.

- Revue humaine: :

- Suspendre le flux de travail et attendre la révision manuelle via la boîte de réception de l'agent.

- Un humain peut accepter, modifier ou rejeter les suggestions, et les modifications sont déposées dans la bibliothèque des exemples de moindre importance.

- Réflexion: :

- Si la recommandation est modifiée, un mécanisme de réflexion est déclenché pour générer des recommandations d'amélioration.

- Les demandes non modifiées sautent cette étape.

mise en garde

- Assurez-vous que la clé API LangSmith est valide et que les environnements de développement et de production ont des réseaux stables.

- Les modèles non-OpenAI/Anthropic nécessitent l'installation de paquets d'intégration supplémentaires, voir la documentation LangChain.

- Les déploiements en production nécessitent le déplacement du serveur LangGraph vers le cloud et la mise à jour de l'URL de la boîte de réception de l'agent.

scénario d'application

- Approbation du budget de l'entreprise

LLManager automatise le traitement des demandes de budget des employés, en générant des recommandations basées sur des règles prédéfinies (par exemple, les plafonds budgétaires, les types de projets). L'équipe financière examine, modifie ou confirme les résultats via la boîte de réception de l'agent, réduisant ainsi les tâches répétitives. - Répartition des tâches du projet

Les chefs de projet utilisent LLManager pour approuver les demandes d'affectation des tâches. Le système analyse les priorités des tâches et les besoins en ressources pour générer des recommandations d'affectation. Le chef de projet examine manuellement la demande pour s'assurer que l'attribution des tâches est efficace et raisonnable. - Contrôle de conformité

LLManager vérifie la conformité réglementaire des documents soumis et signale les problèmes potentiels. L'équipe de conformité confirme ou ajuste les résultats par le biais de la boîte de réception, augmentant ainsi l'efficacité de l'examen. - Gestion des demandes des clients

Les équipes du service clientèle utilisent LLManager pour approuver les remboursements des clients ou les demandes de service. Le système génère des recommandations basées sur des données historiques, et l'équipe les examine manuellement pour s'assurer que les décisions sont justes et cohérentes.

QA

- Quels sont les modèles supportés par LLManager ?

Les modèles de support tels que OpenAI, Anthropic, etc., doivent prendre en charge la fonction d'appel d'outil. Les modèles qui ne sont pas des modèles par défaut nécessitent l'installation de paquets d'intégration LangChain, tels que@langchain/google-genai. - Comment réutiliser le même assistant ?

modificationsevals/e2e.int.test.tsSi vous utilisez un identifiant d'aide fixe ou si vous recherchez un identifiant existant avant d'effectuer une évaluation, évitez de générer un nouvel identifiant d'aide. - Comment est-il déployé dans un environnement de production ?

Déployez LangGraph sur un serveur cloud, mettez à jour l'URL de déploiement de l'Agent Inbox et utilisez LangSmith pour contrôler les performances du flux de travail. - Comment puis-je personnaliser mon flux de travail ?

Modifiez le sous-graphe de raisonnement (pour ajuster la logique de génération de l'invite) ou le sous-graphe de réflexion (pour contrôler les règles de génération de la réflexion) afin de l'adapter à des scénarios d'approbation spécifiques.

© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Articles connexes

Pas de commentaires...