LiveTalking : système numérique interactif en temps réel à source ouverte, permettant d'établir un dialogue audio et vidéo synchrone.

Introduction générale

LiveTalking est un système humain numérique interactif en temps réel à source ouverte, dédié à la construction d'une solution humaine numérique en direct de haute qualité. Le projet utilise le protocole open source Apache 2.0 et intègre un certain nombre de technologies de pointe, notamment le rendu ER-NeRF, le traitement des flux audio et vidéo en temps réel, la synchronisation labiale, etc. Le système prend en charge le rendu et l'interaction humaine numérique en temps réel et peut être utilisé pour la diffusion en direct, l'éducation en ligne, le service à la clientèle et de nombreux autres scénarios. Le projet a gagné plus de 4300 étoiles et 600 branches sur GitHub, montrant une forte influence de la communauté. LiveTalking accorde une attention particulière à la performance en temps réel et à l'expérience interactive, et fournit aux utilisateurs un cadre complet de développement humain numérique en intégrant la technologie AIGC. Le projet est continuellement mis à jour et maintenu, et est soutenu par une documentation complète, ce qui en fait un choix idéal pour la construction d'applications de personnes numériques.

Liste des fonctions

- Plusieurs modèles humains numériques sont pris en charge :ernerf,musetalk,wav2lip,Ultraléger-Numérique-Humain

- Réaliser un dialogue audio et vidéo simultané

- Prise en charge du clonage sonore

- Les partisans du numérique s'expriment et sont interrompus

- Prise en charge de l'épissage vidéo de l'ensemble du corps

- Prise en charge des flux push RTMP et WebRTC

- Prise en charge de la planification des vidéos : lecture de vidéos personnalisées lorsqu'il n'y a pas de prise de parole

- Prise en charge de la concurrence multiple

Utiliser l'aide

1. processus d'installation

- Exigences environnementales : Ubuntu 20.04, Python 3.10, Pytorch 1.12, CUDA 11.3

- Installation des dépendances : :

conda create -n nerfstream python=3.10

conda activate nerfstream

conda install pytorch==1.12.1 torchvision==0.13.1 cudatoolkit=11.3 -c pytorch

pip install -r requirements.txt

Si vous ne vous entraînez pas. ernerf les bibliothèques suivantes ne doivent pas être installées :

pip install "git+https://github.com/facebookresearch/pytorch3d.git"

pip install tensorflow-gpu==2.8.0

pip install --upgrade "protobuf<=3.20.1"

2. démarrage rapide

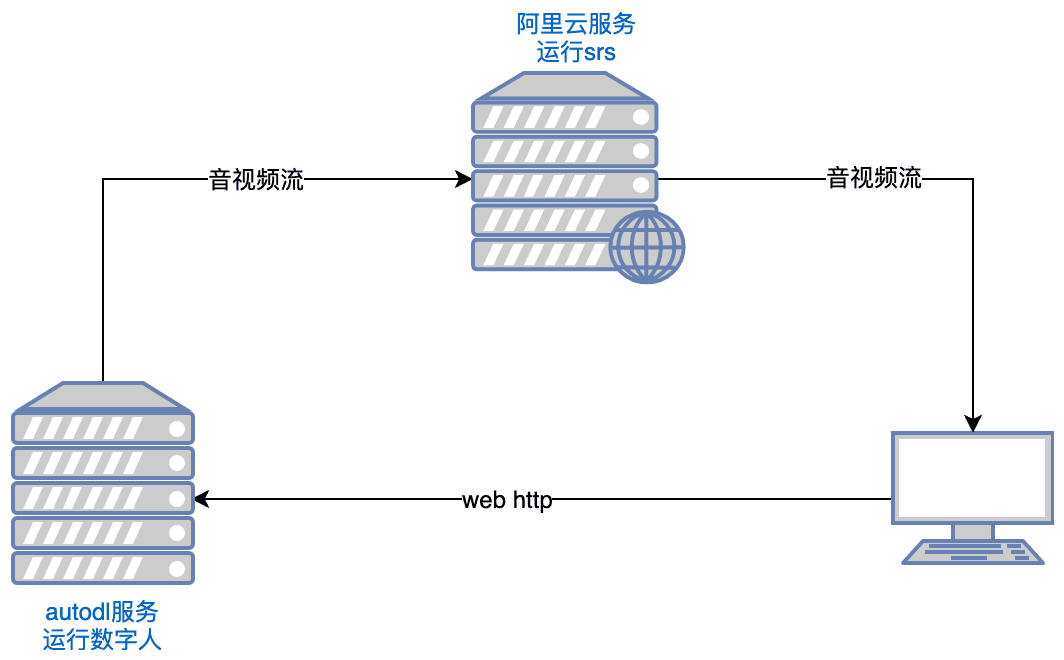

- Fonctionnement du SRS : :

export CANDIDATE='<服务器外网ip>'

docker run --rm --env CANDIDATE=$CANDIDATE -p 1935:1935 -p 8080:8080 -p 1985:1985 -p 8000:8000/udp registry.cn-hangzhou.aliyuncs.com/ossrs/srs:5 objs/srs -c conf/rtc.conf

Note : Le serveur doit ouvrir les ports tcp:8000,8010,1985 ; udp:8000

- Lancement de la personne numérique : :

python app.py

Si vous ne pouvez pas accéder à Huggingface, exécutez-le avant de l'exécuter :

export HF_ENDPOINT=https://hf-mirror.com

Ouvrir avec votre navigateur http://serverip:8010/rtcpushapi.htmlPour cela, il suffit de saisir un texte dans la zone de texte, de le soumettre et la personne numérique diffusera le passage.

Plus d'instructions d'utilisation

- Docker en cours d'exécution L'installation préalable n'est pas nécessaire, il suffit de l'exécuter :

docker run --gpus all -it --network=host --rm registry.cn-beijing.aliyuncs.com/codewithgpu2/lipku-metahuman-stream:vjo1Y6NJ3N

Le code se trouve dans le /root/metahuman-streampréalable git pull Retirez le dernier code, puis exécutez la commande comme aux étapes 2 et 3.

- Miroir : :

- image autodl :Tutoriel autodl

- miroirs ucloud :Tutoriel ucloud

- problèmes courants Pour l'installation de l'environnement Linux CUDA, vous pouvez vous référer à cet article :article de référence

3. les instructions de configuration

- Configuration du système

- Modifier le fichier config.yaml pour définir les paramètres de base

- Configuration des caméras et des périphériques audio

- Définition des paramètres et des trajectoires du modèle d'IA

- Configurer les paramètres de la diffusion push en direct

- Préparation d'un modèle humain numérique

- Prise en charge de l'importation de modèles 3D personnalisés

- Des modèles d'exemple préconstruits peuvent être utilisés

- Prise en charge de l'importation du modèle MetaHuman

Principales fonctions

- Dialogue synchronisé audio et vidéo en temps réel: :

- Select Digitizer Model : Sélectionnez le modèle de numériseur approprié (par exemple ernerf, musetalk, etc.) dans la page de configuration.

- Sélection de la méthode de transmission audio/vidéo : sélectionnez la méthode de transmission audio/vidéo appropriée (par exemple WebRTC, RTMP, etc.) en fonction des besoins.

- Démarrer un dialogue : démarrer la transmission audio/vidéo pour obtenir un dialogue synchrone audio/vidéo en temps réel.

- Changement de modèle humain numérique: :

- Entrer dans la page des paramètres : dans la page d'exécution du projet, cliquez sur le bouton Paramètres pour entrer dans la page des paramètres.

- Sélectionner un nouveau modèle : sélectionnez un nouveau modèle de Digimon dans la page Paramètres et enregistrez les paramètres.

- Redémarrer le projet : redémarre le projet pour appliquer la nouvelle configuration du modèle.

- Réglage des paramètres audio et vidéo: :

- Entrer dans la page de paramétrage : Dans la page de déroulement du projet, cliquez sur le bouton de paramétrage pour entrer dans la page de paramétrage.

- Paramètres de réglage : Réglez les paramètres audio et vidéo (tels que la résolution, la fréquence d'images, etc.) en fonction de vos besoins.

- Sauvegarder et appliquer : Sauvegarde les réglages et applique la nouvelle configuration des paramètres.

© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Articles connexes

Pas de commentaires...