Benchmarking multimodal de l'IA générative end-side entre appareils avec Nexa Compressed Inference

Résumé

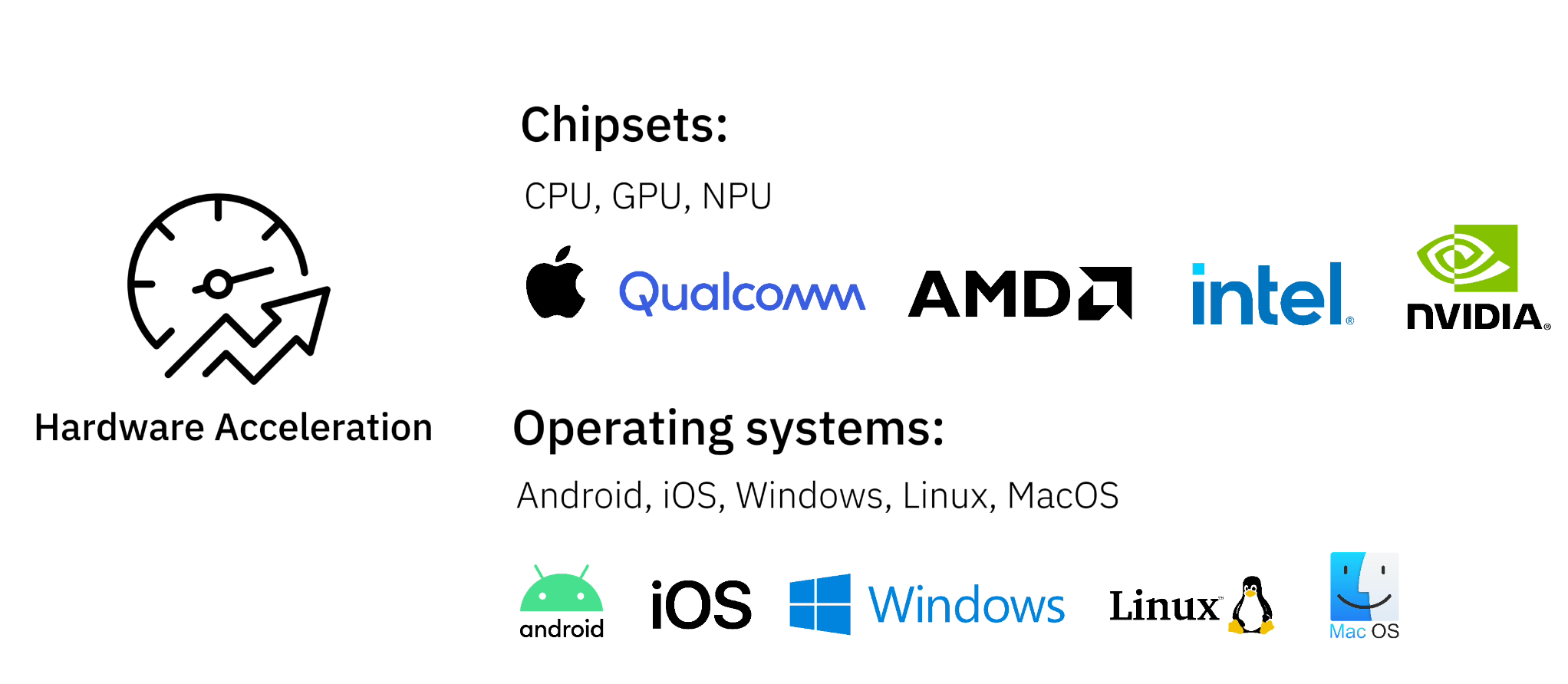

Nexa Le cadre d'inférence natif rend le déploiement de modèles d'IA génératifs sur l'appareil transparent et efficace. La technologie prend en charge un large éventail de jeux de puces, notamment AMD, Qualcomm, Intel, NVIDIA et les puces maison, et est compatible avec tous les principaux systèmes d'exploitation. Nous fournissons des données de référence pour les modèles d'IA générative sur une variété de tâches courantes, chacune testée au niveau de performance TOPS sur différents types d'appareils.

Points forts :

- capacité multimodale - soutienTexte, audio, vidéo et visuelsTâches génératives de type IA

- Large éventail de compatibilité matérielle - Exécution de modèles d'IA sur des PC, des ordinateurs portables, des appareils mobiles et des systèmes embarqués

- performance de pointe - Grâce à notre cadre d'inférence de pointe, NexaQuant, les modèles s'exécutent 2,5 fois plus vite et nécessitent 4 fois moins de stockage et de mémoire, tout en conservant une grande précision.

Pourquoi l'IA en bout de chaîne ?

Le déploiement de modèles d'IA directement sur l'appareil présente plusieurs avantages par rapport à l'utilisation d'API dans le nuage :

- Vie privée et sécurité - La conservation des données du côté de l'appareil garantit la confidentialité

- réduire les coûts - Pas besoin de payer pour un raisonnement coûteux basé sur l'informatique dématérialisée

- Vitesse et réaction - Inférence à faible latence sans dépendre du réseau

- capacité hors ligne - Les applications d'IA peuvent encore être utilisées dans les zones à faible connectivité

Avec la technologie Nexa edge inference, les développeurs peuvent exécuter efficacement des modèles génératifs d'IA sur une large gamme d'appareils avec une consommation minimale de ressources.

Nouvelles tendances dans les applications multimodales de l'IA

Nexa AI Soutien au déploiement en bout de chaîneL'IA multimodalepermettant aux applications de traiter et d'intégrer plusieurs types de données :

- Texte AI - Chatbots, résumés de documents, assistants de programmation

- L'IA de la voix à la voix - Traduction vocale en temps réel, assistant vocal IA

- Vision AI - Détection de cibles, description d'images, traitement OCR de documents

Pour ce faire, il est nécessaire d'utiliserNexaQuantNos modèles multimodaux permettent d'obtenir une compression et une accélération excellentes tout en maintenant des performances élevées.

Critères de performance des tâches d'IA générative sur plusieurs appareils

Nous fournissons des données d'étalonnage pour les modèles d'IA générative sur une variété de tâches courantes, chacune testée au niveau de performance TOPS sur différents types d'appareils. Si vous disposez d'un appareil et d'un cas d'utilisation spécifique, vous pouvez vous référer à des appareils aux performances similaires pour estimer la puissance de traitement :

Tâches d'IA générative couvertes :

- De voix à voix

- Texte à texte

- Du visuel au texte

Couvre le type d'équipement :

- Puces modernes pour ordinateurs portables - Optimisé pour le traitement natif de l'IA sur les ordinateurs de bureau et les ordinateurs portables

- puce mobile phare - Modèles d'IA fonctionnant sur smartphones et tablettes

- système embarqué (~4 TOPS) - Dispositifs à faible consommation d'énergie pour les applications informatiques de pointe

Analyse comparative de la synthèse vocale

Évaluation des capacités d'interaction vocale en temps réel à l'aide de modèles linguistiques - TraitementL'entrée audio génère une sortie audio

| Type d'équipement | Puces et dispositifs | Délai (TTFT) | vitesse de décodage | Mémoire de crête moyenne |

|---|---|---|---|---|

| Puces modernes pour ordinateurs portables (GPU) | Apple M3 Pro GPU | 0,67 secondes | 20,46 jetons/seconde | ~990MB |

| Puces modernes pour ordinateurs portables (iGPU) | iGPU AMD Ryzen AI 9 HX 370 (Radeon 890M) | 1,01 seconde | 19,28 jetons/seconde | ~990MB |

| Puces modernes pour ordinateurs portables (CPU) | Intel Core Ultra 7 268V | 1,89 secondes | 11,88 jetons/seconde | ~990MB |

| Puce mobile phare CPU | Qualcomm Snapdragon 8 Gen 3 (Samsung S24) | 1,45 secondes | 9,13 jetons/seconde | ~990MB |

| Système IoT embarqué CPU | Raspberry Pi 4 Model B | 6,9 secondes. | 4,5 jetons/seconde | ~990MB |

Analyse comparative de la synthèse vocale à l'aide de Moshi avec NexaQuant

Analyse comparative texte à texte

évaluationGénérer du texte à partir d'une entrée de textePerformance du modèle d'IA

| Type d'équipement | Puces et dispositifs | Délai initial (TTFT) | vitesse de décodage | Mémoire de crête moyenne |

|---|---|---|---|---|

| Puces modernes pour ordinateurs portables (GPU) | Apple M3 Pro GPU | 0,12 secondes | 49,01 jetons/seconde | ~2580MB |

| Puces modernes pour ordinateurs portables (iGPU) | iGPU AMD Ryzen AI 9 HX 370 (Radeon 890M) | 0,19 secondes | 30,54 jetons/seconde | ~2580MB |

| Puces modernes pour ordinateurs portables (CPU) | Intel Core Ultra 7 268V | 0,63 secondes | 14,35 jetons/seconde | ~2580MB |

| Puce mobile phare CPU | Qualcomm Snapdragon 8 Gen 3 (Samsung S24) | 0,27 secondes | 10,89 jetons/seconde | ~2580MB |

| Système IoT embarqué CPU | Raspberry Pi 4 Model B | 1,27 secondes | 5,31 jetons/seconde | ~2580MB |

Analyse comparative texte à texte utilisant llama-3.2 avec NexaQuant

Analyse comparative entre le visuel et le textuel

Évaluer l'IA Analyser les données visuellesLa capacité de générer des réponses, d'extraire des informations visuelles clés et de guider l'outil de manière dynamique.Entrée visuelle, sortie texte

| Type d'équipement | Puces et dispositifs | Délai initial (TTFT) | vitesse de décodage | Mémoire de crête moyenne |

|---|---|---|---|---|

| Puces modernes pour ordinateurs portables (GPU) | Apple M3 Pro GPU | 2,62 secondes | 86,77 jetons/seconde | ~1093MB |

| Puces modernes pour ordinateurs portables (iGPU) | iGPU AMD Ryzen AI 9 HX 370 (Radeon 890M) | 2,14 secondes | 83,41 jetons/seconde | ~1093MB |

| Puces modernes pour ordinateurs portables (CPU) | Intel Core Ultra 7 268V | 9,43 secondes | 45,65 jetons/seconde | ~1093MB |

| Puce mobile phare CPU | Qualcomm Snapdragon 8 Gen 3 (Samsung S24) | 7,26 secondes. | 27,66 jetons/seconde | ~1093MB |

| Système IoT embarqué CPU | Raspberry Pi 4 Model B | 22,32 secondes | 6,15 jetons/seconde | ~1093MB |

Analyse comparative entre le visuel et le texte à l'aide d'OmniVLM et de NexaQuant

© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Articles connexes

Pas de commentaires...