Hugging Face lance l'Agent Intelligence Body Rankings : Qui est le leader en matière d'appel d'outils ?

Le PDG de NVIDIA, Jen-Hsun Huang, a qualifié les intelligences artificielles de "main-d'œuvre numérique", et il n'est pas le seul dirigeant technologique à partager ce point de vue. Le PDG de Microsoft, Satya Nadella, pense également que la technologie des corps intelligents changera fondamentalement le mode de fonctionnement des entreprises.

La capacité de ces intelligences à interagir avec des outils externes et des API a considérablement élargi leurs scénarios d'application. Cependant, les intelligences IA sont loin d'être parfaites et l'évaluation de leurs performances dans des applications réelles est un défi en raison de la complexité des interactions potentielles.

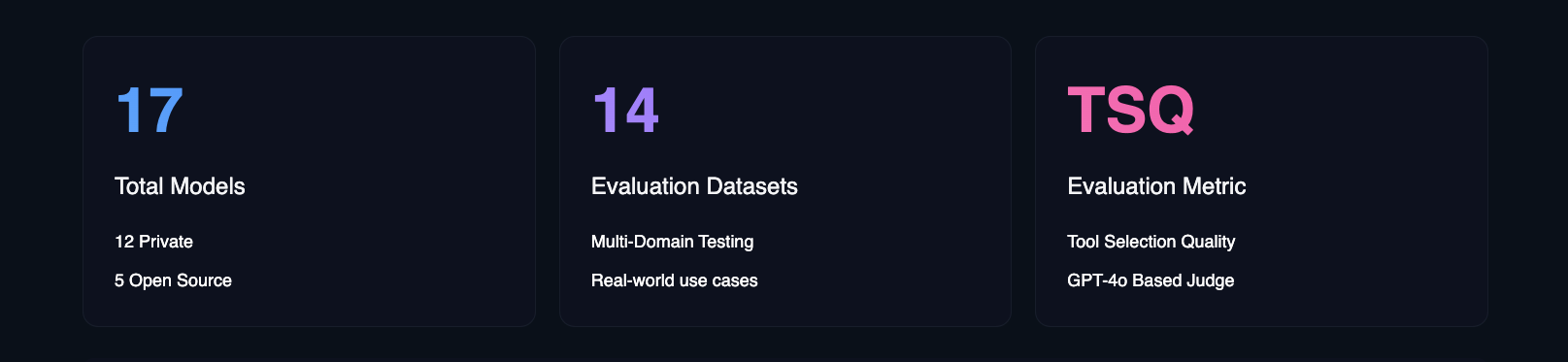

Pour relever ce défi, Hugging Face a introduit le classement du corps de l'intelligence de l'agent. En utilisant les mesures de qualité de sélection des outils (TSQ) de Galileo, le classement évalue les performances de différents grands modèles de langage (LLM) dans la gestion des interactions basées sur les outils, fournissant ainsi une référence claire pour les développeurs.

- Agent d'étreinte du visage Classement intelligent des corps

Hugging Face a construit ce classement pour répondre à la question centrale, "Quelle est la performance réelle des intelligences IA dans des environnements professionnels réels ?" Les références académiques sont importantes, mais elles se concentrent sur les capacités techniques, alors que Hugging Face s'intéresse davantage aux modèles qui sont réellement applicables à une variété de cas d'utilisation dans le monde réel.

Caractéristiques uniques du tableau de bord d'évaluation du corps intelligent de l'agent Hugging Face

Les cadres d'évaluation courants se concentrent généralement sur des domaines spécifiques. Par exemple, BFCL excelle dans les domaines académiques tels que les mathématiques, le divertissement et l'éducation ; τ-bench se concentre sur des scénarios spécifiques à l'industrie tels que le commerce de détail et les compagnies aériennes ; xLAM couvre 21 domaines de génération de données ; et ToolACE se concentre sur les interactions API à travers 390 domaines. Le classement de Hugging Face est unique en ce sens qu'il combine ces ensembles de données dans un cadre d'évaluation complet conçu pour couvrir un plus large éventail de domaines et de cas d'utilisation dans le monde réel.

En intégrant विविध benchmarks et scénarios de test, les classements de Hugging Face fournissent non seulement une évaluation des capacités techniques d'un modèle, mais s'attachent également à fournir des informations exploitables sur la manière dont le modèle gère les cas limites et les considérations de sécurité. Hugging Face fournit également des informations sur de multiples facteurs tels que la rentabilité, les directives de mise en œuvre et l'impact sur l'entreprise - autant d'éléments essentiels pour les organisations qui cherchent à déployer des intelligences IA. Avec ce classement, Hugging Face espère aider les équipes d'entreprise à identifier plus précisément les modèles d'intelligence artificielle qui répondent le mieux à leurs besoins spécifiques, en tenant compte des contraintes des applications du monde réel.

Compte tenu de la fréquence des nouvelles versions des grands modèles linguistiques (LLM), Hugging Face prévoit de mettre à jour les critères du classement tous les mois afin de s'assurer qu'ils restent en phase avec l'évolution rapide des technologies de modélisation.

Principales conclusions

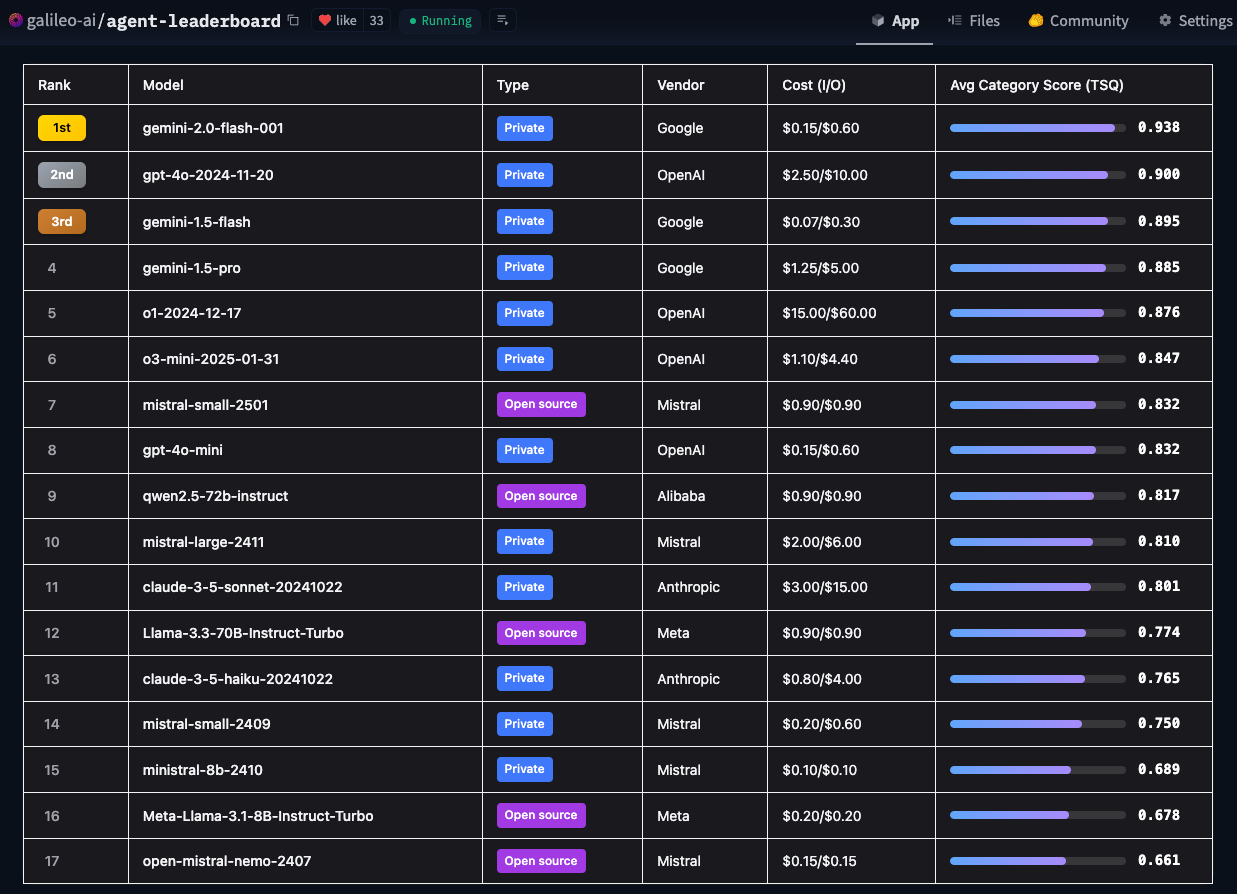

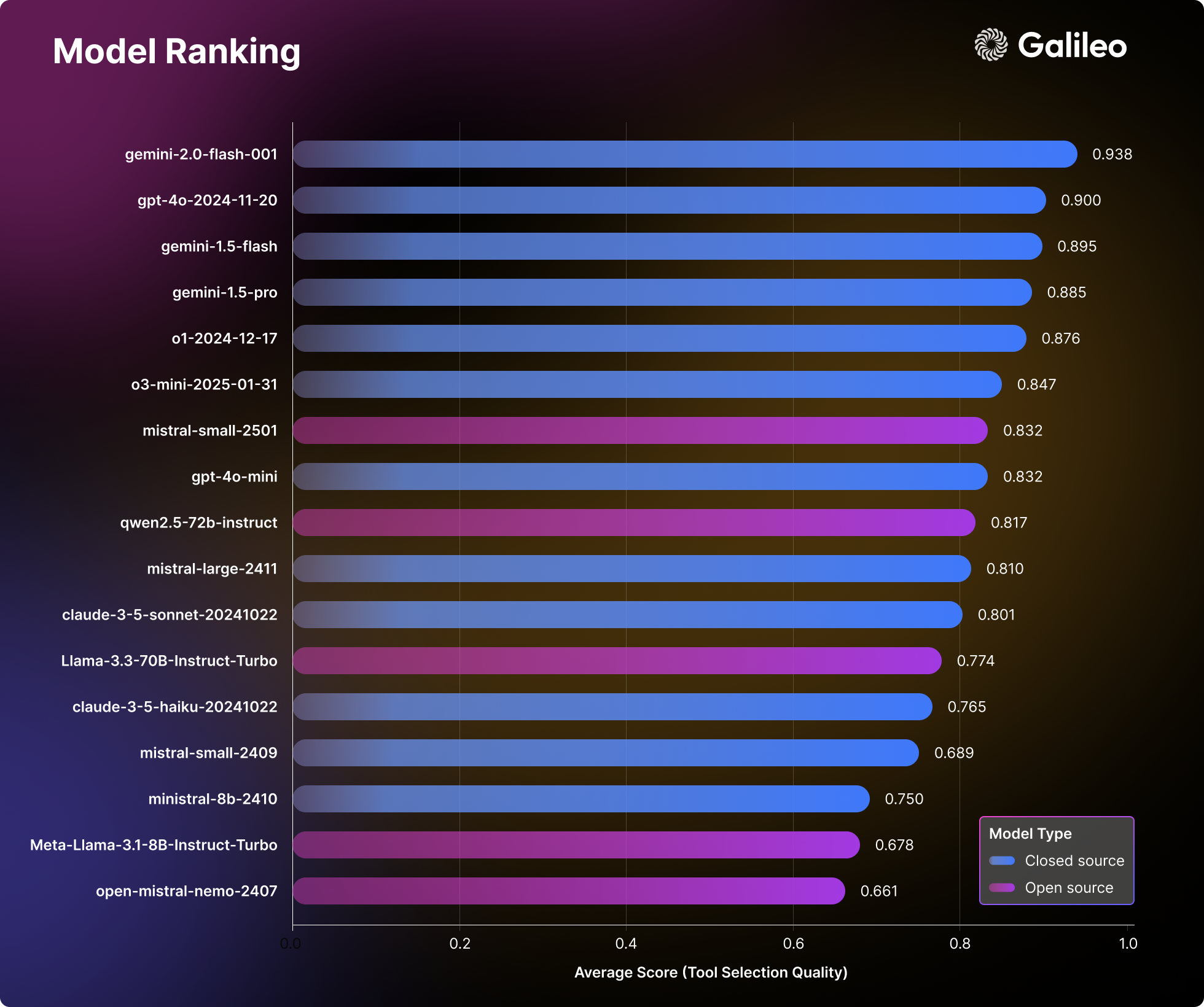

L'analyse approfondie par Hugging Face de 17 grands modèles de langage (LLM) révèle des schémas intéressants dans la manière dont les intelligences artificielles abordent les tâches du monde réel. Hugging Face a effectué des tests de stress complets sur des modèles privés et open source dans 14 points de référence différents, évaluant des dimensions allant de simples appels API à des interactions complexes entre plusieurs outils.

Classement de la modélisation en langues étrangères (LLM)

Les résultats de l'évaluation de Hugging Face remettent en question les perceptions traditionnelles de la performance des modèles et constituent une référence pratique précieuse pour les équipes qui développent des intelligences IA.

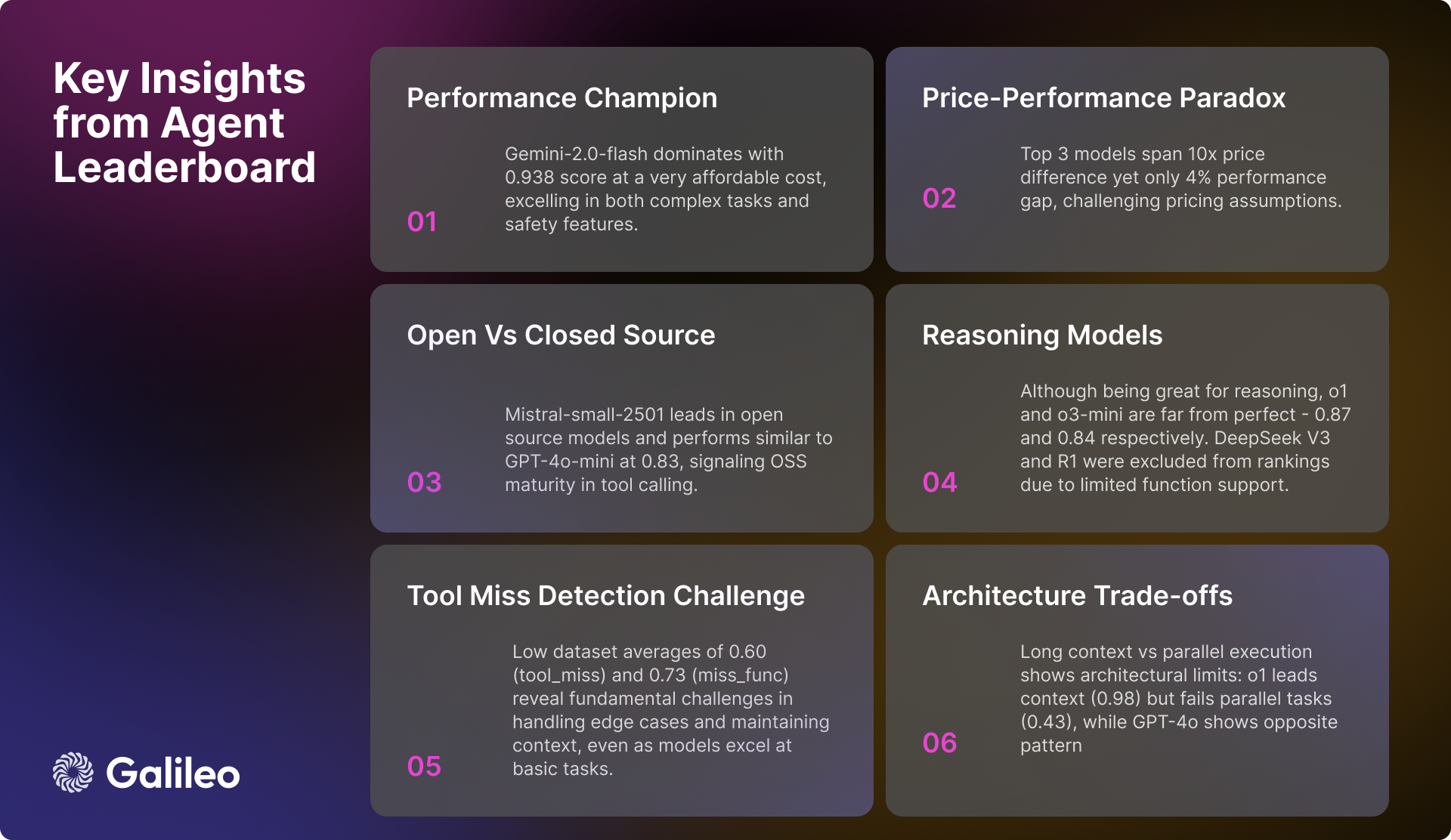

Principales conclusions du classement des organismes intelligents d'Agent

Complexité des appels d'outils

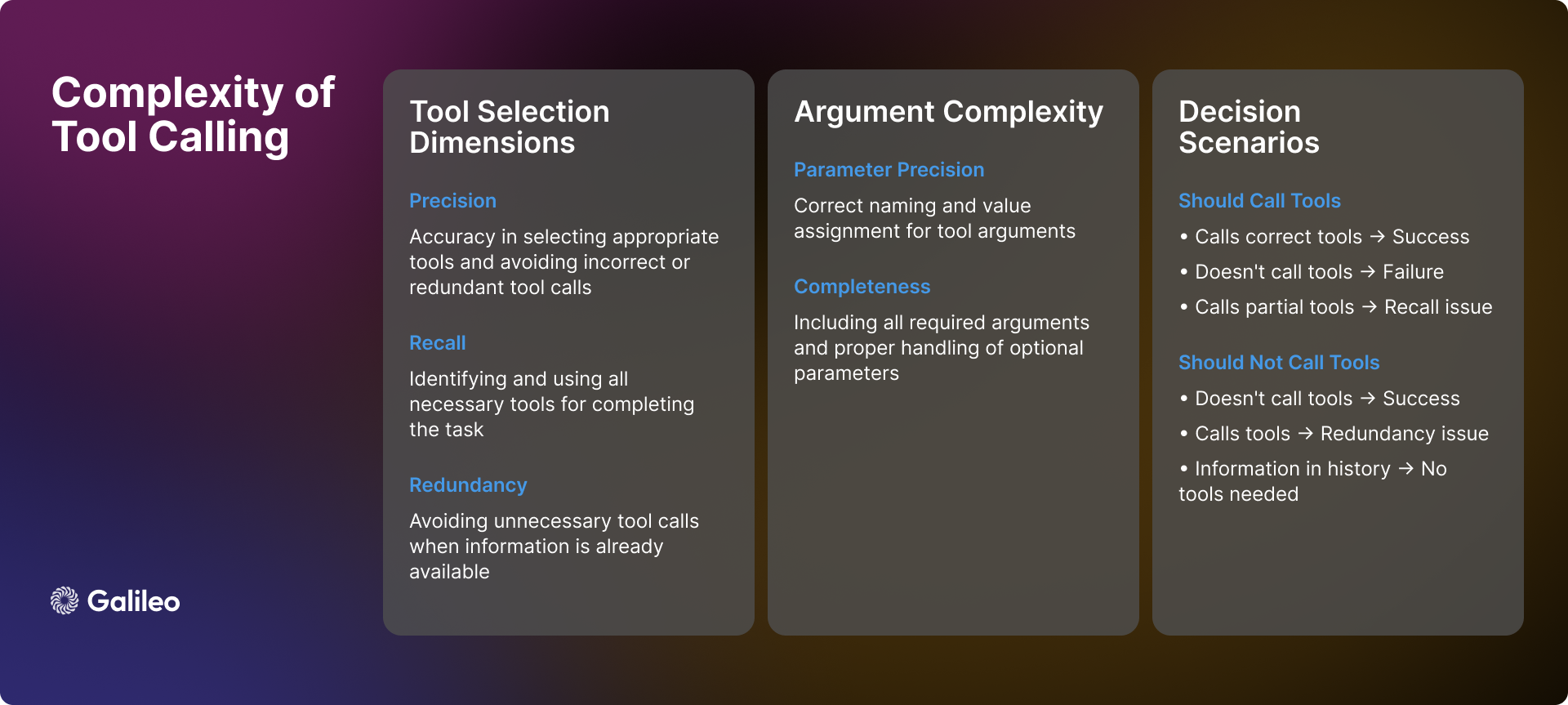

La complexité de l'invocation des outils va bien au-delà des simples appels d'API. Dans la pratique, les intelligences artificielles sont confrontées à de nombreux scénarios et défis complexes dans l'utilisation des outils, ce qui nécessite une prise de décision précise :

reconnaissance de scènes

Lorsqu'un organisme intelligent reçoit une requête d'un utilisateur, sa première tâche consiste à déterminer si l'invocation d'un outil est nécessaire. Parfois, les informations nécessaires existent déjà dans l'historique du dialogue, ce qui rend l'invocation de l'outil superflue. En outre, les outils disponibles peuvent ne pas être suffisants pour résoudre le problème de l'utilisateur ou ne pas être pertinents pour la tâche elle-même. Dans ces cas, les intelligences doivent être capables de reconnaître leurs limites et d'être honnêtes avec l'utilisateur, plutôt que d'imposer l'utilisation d'outils inappropriés.

Dynamique de sélection des outils

La sélection des outils n'est pas un simple problème binaire de type "oui" ou "non" ; elle fait intervenir la précision et le rappel. Idéalement, un organisme intelligent devrait être capable d'identifier avec précision tous les outils nécessaires tout en évitant de sélectionner des outils non pertinents. Cependant, la réalité est souvent plus complexe. Un organisme intelligent peut identifier correctement un outil nécessaire mais en omettre d'autres (rappel insuffisant), ou sélectionner à tort certains outils inutiles tout en choisissant les outils appropriés (précision insuffisante). Bien qu'aucun de ces scénarios ne soit optimal, ils représentent différents degrés de biais de sélection.

paramétrage

Même si un organisme intelligent sélectionne avec succès le bon outil, le traitement des paramètres peut encore poser de nouveaux défis. Les organismes intelligents doivent

- Fournissez tous les paramètres requis et assurez-vous qu'ils sont nommés correctement.

- Traitement correct des paramètres optionnels.

- S'assurer de l'exactitude des valeurs des paramètres.

- Formatez les paramètres en fonction de la spécification de l'outil.

la prise de décision séquentielle

Pour les tâches à plusieurs étapes, les intelligences doivent faire preuve de capacités de prise de décision plus avancées :

- Déterminer l'ordre optimal des appels d'outils.

- Gère les interdépendances entre les appels d'outils.

- Maintenir la cohérence contextuelle entre plusieurs opérations.

- Flexibilité pour répondre aux succès ou aux échecs locaux.

La complexité décrite ci-dessus démontre amplement que la qualité de la sélection des outils ne doit pas être considérée comme une simple mesure. Elle doit plutôt être considérée comme une évaluation complète de la capacité des intelligences à prendre des décisions complexes dans des scénarios de la vie réelle.

méthodologie

Le processus d'évaluation de Hugging Face suit une méthodologie systématique qui vise à fournir une évaluation complète et impartiale des intelligences de l'IA :

- Sélection du modèle : Hugging Face a soigneusement sélectionné un ensemble varié de modèles linguistiques de premier plan, qu'il s'agisse d'implémentations propriétaires ou de sources ouvertes. Cette stratégie de sélection vise à fournir une vue d'ensemble du paysage technologique actuel.

- Configuration de la carrosserie Smart : Hugging Face configure chaque modèle comme une intelligence avec des signaux standardisés et lui donne accès à un ensemble cohérent d'outils. Cette configuration standardisée garantit que les écarts de performance reflètent véritablement les capacités intrinsèques du modèle, plutôt que d'être influencés par des facteurs externes tels que l'ingénierie des signaux.

- Définition de l'indicateur : Hugging Face fait de la qualité de la sélection des outils (TSQ) la principale mesure d'évaluation, en se concentrant sur l'exactitude de la sélection des outils et l'efficacité de l'utilisation des paramètres. Les mesures TSQ sont conçues en tenant compte des exigences de performance du monde réel.

- Curation des ensembles de données : Hugging Face construit un ensemble de données équilibré et multi-domaines en prélevant stratégiquement des échantillons dans des ensembles de données de référence matures existants. L'ensemble de données teste de manière exhaustive les capacités des intelligences, depuis les appels de fonctions de base jusqu'aux interactions complexes à plusieurs tours, afin de garantir l'exhaustivité de l'évaluation.

- Système de notation : La note de performance finale est obtenue en calculant la moyenne des pondérations égales sur tous les ensembles de données. Cette approche garantit une évaluation équilibrée et évite qu'une seule capacité ne domine les résultats globaux de l'évaluation, reflétant ainsi plus objectivement les performances globales des intelligences.

Grâce à cette méthode d'évaluation structurée, Hugging Face vise à fournir des informations qui peuvent directement guider les décisions de déploiement dans le monde réel.

Comment Hugging Face mesure-t-il la performance des agents intelligents ?

Fonctionnement du cadre d'évaluation

Comme mentionné ci-dessus, l'évaluation de l'invocation d'outils nécessite des mesures fiables dans une variété de scénarios différents. Hugging Face a mis au point une mesure de la qualité de la sélection des outils pour évaluer les performances des intelligences en matière d'utilisation des outils, en examinant la précision de la sélection des outils et l'efficacité de l'utilisation des paramètres. Le cadre d'évaluation est conçu pour déterminer si les intelligences utilisent les outils de manière appropriée pour accomplir les tâches et pour identifier les situations où l'utilisation des outils est inutile.

Au cours du processus d'évaluation, Hugging Face a utilisé les modèles GPT-4o et ChainPoll pour évaluer les décisions de sélection des outils. Pour chaque interaction, Hugging Face recueille plusieurs jugements indépendants, le score final représentant la proportion d'évaluations positives. Chaque jugement comprend une explication détaillée afin d'assurer la transparence du processus d'évaluation.

L'exemple de code suivant montre comment utiliser les métriques TSQ pour évaluer les performances d'appel d'outil d'un grand modèle de langage (LLM) sur un ensemble de données :

import promptquality as pq

import pandas as pd

file_path = "path/to/your/dataset.parquet" # 替换为你的数据集文件路径

project_name = "agent-leaderboard-evaluation" # 替换为你的项目名称

run_name = "tool-selection-quality-run" # 替换为你的运行名称

model = "gpt-4o" # 你想要评估的模型名称

tools = [...] # 你的工具列表

llm_handler = pq.LLMHandler() # 初始化 LLMHandler

df = pd.read_parquet(file_path, engine="fastparquet")

chainpoll_tool_selection_scorer = pq.CustomizedChainPollScorer(

scorer_name=pq.CustomizedScorerName.tool_selection_quality,

model_alias=pq.Models.gpt_4o,

)

evaluate_handler = pq.GalileoPromptCallback(

project_name=project_name,

run_name=run_name,

scorers=[chainpoll_tool_selection_scorer],

)

llm = llm_handler.get_llm(model, temperature=0.0, max_tokens=4000)

system_msg ={

"role":"system",

"content":'Your job is to use the given tools to answer the query of human. If there is no relevant tool then reply with "I cannot answer the question with given tools". If tool is available but sufficient information is not available, then ask human to get the same. You can call as many tools as you want. Use multiple tools if needed. If the tools need to be called in a sequence then just call the first tool.',

}

outputs = []

for row in df.itertuples():

chain = llm.bind_tools(tools)

outputs.append(

chain.invoke(

[system_msg,*row.conversation],

config=dict(callbacks=[evaluate_handler])

)

)

evaluate_handler.finish()

Pourquoi Hugging Face a-t-il choisi d'utiliser le Large Language Model (LLM) pour l'évaluation des appels d'outils ?

La méthode d'évaluation basée sur le modèle linguistique étendu (LLM) permet une évaluation complète de divers scénarios complexes. Cette approche permet de vérifier efficacement si l'intelligentsia a traité correctement les situations dans lesquelles les informations contextuelles sont insuffisantes, afin de déterminer si l'utilisateur doit fournir davantage d'informations avant que l'outil puisse être utilisé. Dans les scénarios d'application multi-outils, la méthode permet de vérifier si l'organisme intelligent identifie tous les outils nécessaires et les invoque dans le bon ordre. Dans les longs dialogues contextuels, la méthode permet de s'assurer que l'organisme intelligent prend pleinement en compte les informations pertinentes recueillies plus tôt dans l'historique du dialogue. Même dans les cas où les outils sont manquants ou inapplicables, la méthode d'évaluation détermine si l'organisme intelligent évite correctement les invocations d'outils et donc les actions inappropriées.

Pour exceller dans les métriques TSQ, les intelligences artificielles doivent faire preuve de capacités sophistiquées, notamment : sélectionner le bon outil lorsque c'est nécessaire, fournir des paramètres précis, coordonner efficacement plusieurs outils et identifier les scénarios dans lesquels l'utilisation d'un outil est inutile. Par exemple, lorsque toutes les informations nécessaires existent déjà dans l'historique du dialogue, ou lorsqu'il n'y a pas d'outil approprié disponible, il est préférable d'éviter l'outil.

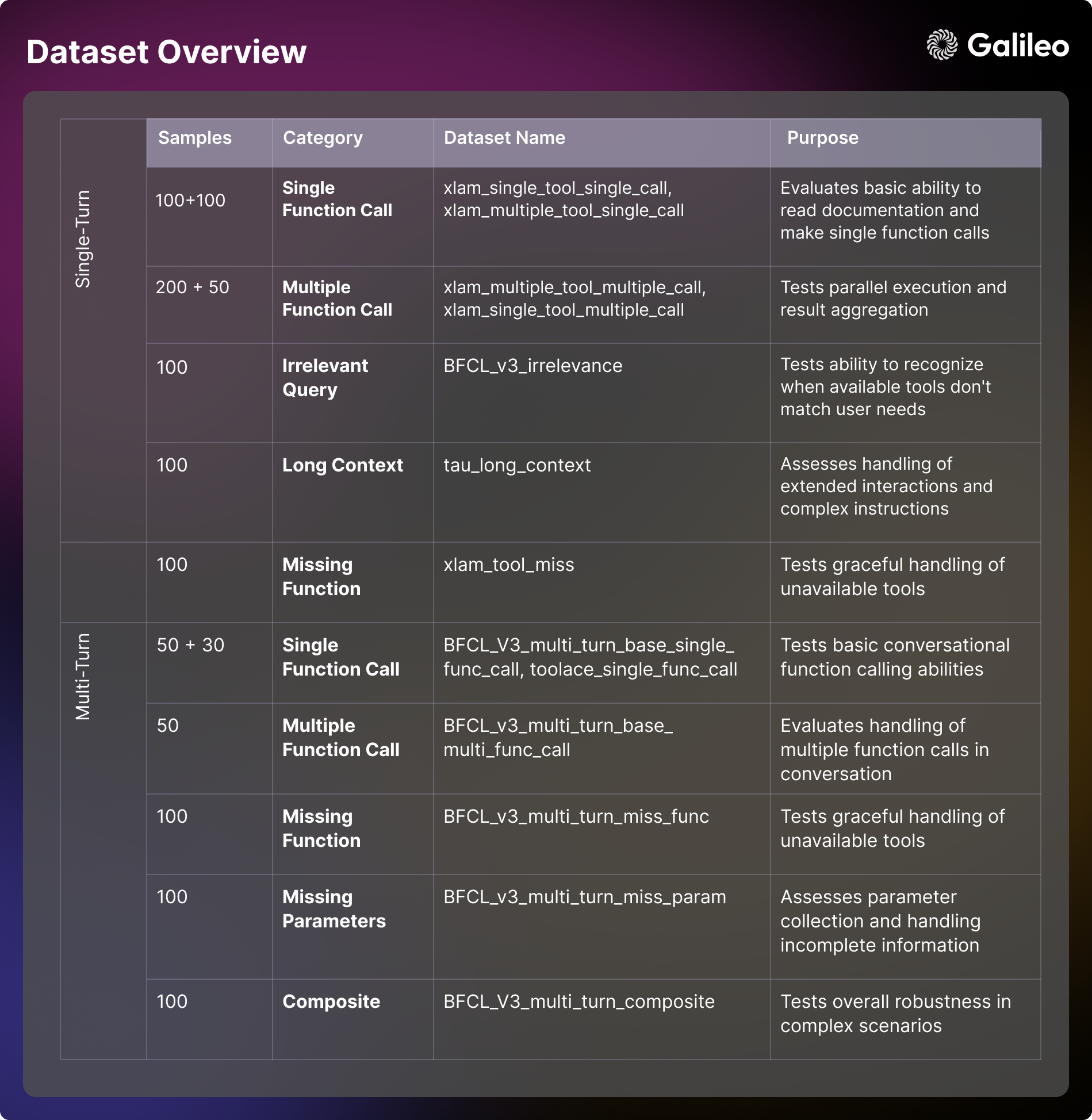

Évaluation de la composition du contenu de l'ensemble de données

Le cadre d'évaluation de Hugging Face utilise un ensemble de données de référence soigneusement sélectionnées, dérivées du BFCL (Berkeley Appel de fonction Leaderboard (Berkeley Function Call Leaderboard), τ-bench (Tau benchmark), Xlam et ToolACE. Chaque ensemble de données est conçu pour tester les capacités des intelligences dans un aspect spécifique. La compréhension de ces dimensions d'évaluation est cruciale pour l'évaluation des modèles et le développement d'applications pratiques.

capacité d'un seul tour

- Utilisation d'outils de base Scénario : il s'agit d'évaluer la capacité d'un organisme intelligent à comprendre la documentation relative aux outils, les paramètres de traitement et à effectuer des appels de fonction de base. Cette dimension se concentre sur l'examen des capacités de formatage des réponses et de traitement des erreurs des intelligences dans les interactions directes. Cette capacité est essentielle pour les tâches automatisées simples dans les applications du monde réel, telles que l'établissement de rappels ou l'obtention d'informations de base [xlam_single_tool_single_call].

- Sélection des outils Scénario : évalue la capacité du modèle à sélectionner le bon outil parmi plusieurs options. Cette dimension examine dans quelle mesure le modèle est capable de comprendre la documentation relative à l'outil et de prendre une décision raisonnée quant à l'adéquation de l'outil. Pour les scénarios d'application dans le monde réel où des intelligences polyvalentes sont construites, cette capacité est essentielle [xlam_multiple_tool_single_call].

- exécution en parallèle Scénario : examiner la capacité d'un modèle à programmer plusieurs outils pour qu'ils travaillent ensemble en même temps. Cette dimension est essentielle pour améliorer l'efficacité des applications réelles [xlam_multiple_tool_multiple_call].

- Réutilisation des outils Scénario : évaluer la capacité des intelligences à gérer efficacement les opérations par lots et les variations de paramètres. Cet aspect est particulièrement important pour les scénarios de traitement par lots dans les applications réelles [xlam_single_tool_multiple_call].

Gestion des erreurs et cas limites

- test de non-pertinence Scénario : capacité d'un modèle de test à identifier les limites des outils et à communiquer raisonnablement lorsque les outils disponibles ne répondent pas aux besoins de l'utilisateur. Cette capacité est la pierre angulaire de la sécurisation de l'expérience utilisateur et de la fiabilité du système [BFCL_v3_irrelevance].

- Manipulation des outils manquants Scénario : examinez l'élégance avec laquelle le modèle gère la situation où l'outil requis n'est pas disponible, y compris la capacité à informer l'utilisateur de ses limites et à lui proposer des alternatives [xlam_tool_miss, BFCL_v3_multi_turn_miss_func].

gestion du contexte (informatique)

- contexte long Scénario : évaluer la capacité d'un modèle à maintenir la cohérence contextuelle et à comprendre des instructions complexes dans des dialogues de longue durée. Cette capacité est essentielle pour gérer des flux de travail complexes et de longues interactions [tau_long_context, BFCL_v3_multi_turn_long_context].

interaction à plusieurs niveaux

- Dialogue de base Scénario : tester la capacité des intelligences à effectuer des appels de fonction conversationnels et à maintenir le contexte dans un dialogue à plusieurs tours. Cette capacité de base est essentielle pour développer des applications interactives [BFCL_v3_multi_turn_base_single_func_call, toolace_single_func_call].

- interaction complexe Scénario : combiner plusieurs défis pour tester de manière exhaustive la robustesse globale et la capacité de résolution de problèmes des intelligences dans des scénarios complexes [BFCL_v3_multi_turn_base_multi_func_call, BFCL_v3_multi_turn_composite].

gestion des paramètres

- paramètre manquant Scénario : Examinez comment le modèle gère les situations où les informations sont incomplètes et comment il interagit efficacement avec l'utilisateur pour collecter les paramètres nécessaires [BFCL_v3_multi_turn_miss_param].

Hugging Face a ouvert le jeu de données pour faciliter la recherche communautaire et le développement d'applications - Hugging Face Tableau de bord des agents Ensemble de données

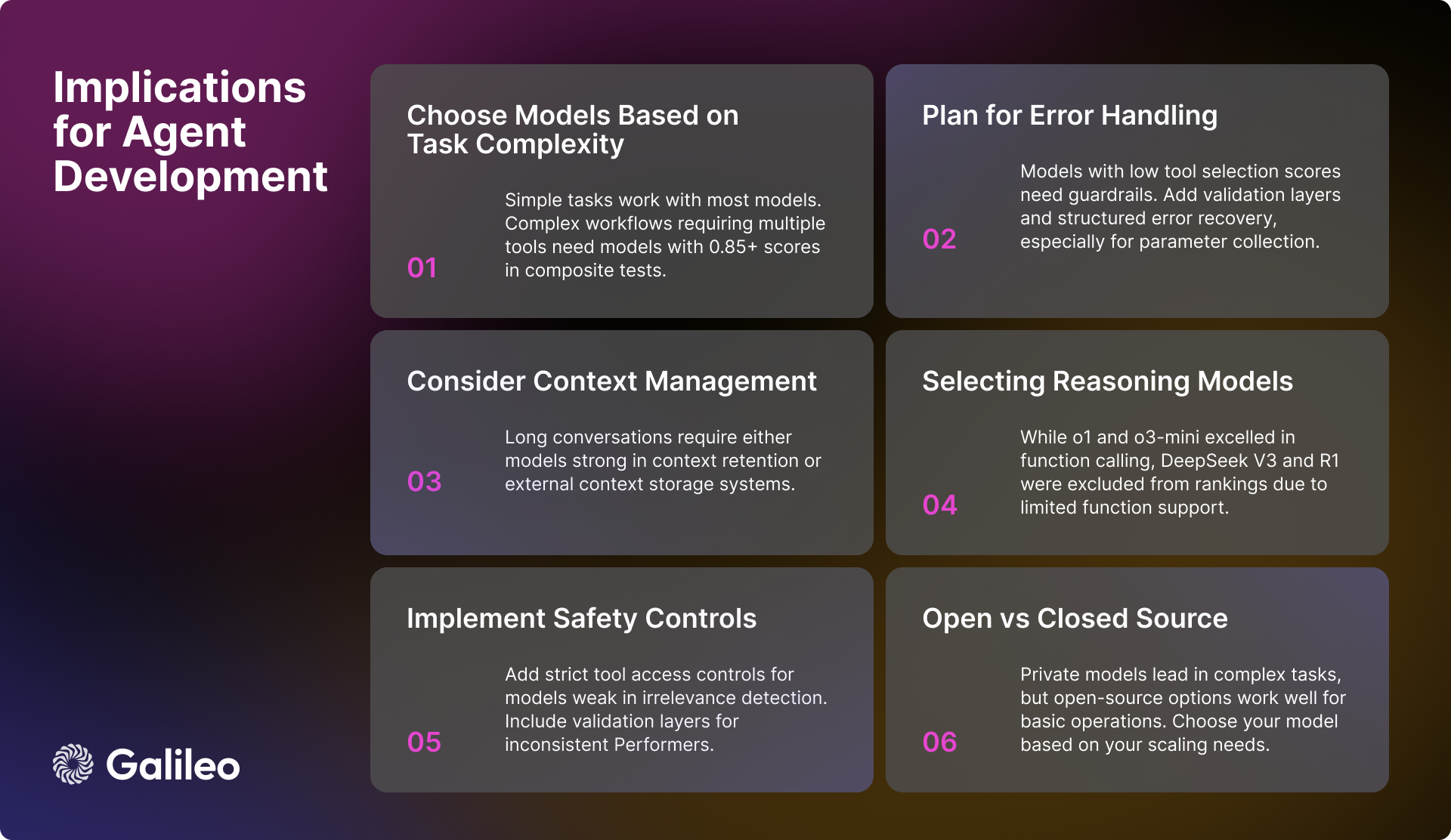

Implications pratiques pour les ingénieurs en IA

Les résultats de l'évaluation de Hugging Face fournissent de nombreuses informations précieuses pour les ingénieurs en intelligence artificielle lorsqu'ils développent des intelligences artificielles. Les facteurs clés suivants doivent être pris en compte lors de la construction d'un système corporel intelligent robuste et efficace :

Sélection et performance des modèles

Pour les applications qui doivent gérer des flux de travail complexes, il est essentiel de sélectionner des modèles très performants qui obtiennent un score supérieur à 0,85 pour la tâche composite. Bien que la plupart des modèles soient capables d'effectuer des tâches d'invocation d'outils de base, lorsqu'il s'agit d'opérations parallèles, il est plus important de se concentrer sur le score d'exécution du modèle pour une tâche spécifique plutôt que de s'appuyer uniquement sur des mesures de performance globales.

Gestion du contexte et des erreurs

Pour les modèles dont les performances sont médiocres dans les scénarios à contexte long, il est crucial de mettre en œuvre une stratégie efficace de résumé du contexte. Lorsque des modèles présentant des lacunes dans la détection de la non-pertinence ou le traitement des paramètres sont sélectionnés, des mécanismes robustes de traitement des erreurs doivent être mis en place. Pour les modèles qui nécessitent un soutien supplémentaire dans la collecte des paramètres, un flux de travail structuré qui guide l'utilisateur pour qu'il fournisse les informations nécessaires sur les paramètres peut être envisagé.

Sécurité et fiabilité

Afin de garantir la sécurité et la fiabilité du système, il est important de mettre en place un contrôle d'accès strict pour les outils, en particulier pour les modèles qui ne détectent pas bien les opérations non pertinentes. Pour les modèles dont la stabilité des performances est insuffisante, il convient d'envisager l'ajout de couches de vérification supplémentaires afin d'améliorer la fiabilité globale du système. Il est également essentiel de disposer d'un système de récupération des erreurs bien conçu, en particulier pour les modèles qui ont du mal à gérer les paramètres manquants.

Optimiser les performances du système

Lors de la conception de l'architecture du flux de travail du système, il convient de prendre dûment en considération les différences de capacité des différents modèles à gérer l'exécution parallèle et les scénarios à contexte long. Lors de la mise en œuvre d'une stratégie de traitement par lots, il est important d'évaluer la capacité de réutilisation des outils du modèle, car cela aura une incidence directe sur l'efficacité globale du système.

État actuel du développement des modèles d'IA

Bien que les modèles propriétaires restent actuellement en tête pour ce qui est de la capacité globale, les performances des modèles open source s'améliorent rapidement. Dans les tâches d'interaction avec des outils simples, tous les types de modèles deviennent plus sophistiqués. Toutefois, dans les interactions complexes à plusieurs tours et dans les scénarios à contexte long, les modèles sont encore confrontés à de nombreux défis.

La variabilité de la performance du modèle dans différentes dimensions souligne l'importance de sélectionner les modèles en fonction des exigences spécifiques du cas d'utilisation. Au lieu de se concentrer uniquement sur les mesures de performance génériques du modèle, les développeurs devraient évaluer en profondeur la performance réelle du modèle dans les scénarios d'application ciblés.

Hugging Face espère que cette liste d'agents intelligents constituera une référence précieuse pour les développeurs.

Aperçu des performances du modèle

modèle d'inférence

Un phénomène intéressant dans l'analyse de Hugging Face est la performance du modèle d'inférence. Bien que les o1 répondre en chantant o3-mini Bien qu'il ait obtenu de bons résultats dans l'intégration des capacités d'appel de fonction, avec des scores élevés de 0,876 et 0,847 respectivement, Hugging Face a rencontré quelques difficultés avec d'autres modèles d'inférence. En particulier.DeepSeek V3 répondre en chantant Deepseek R1 Les modèles, bien que présentant des performances admirables en termes de capacités générales впечатляющий, ont été exclus du classement Hugging Face en raison de leur prise en charge limitée des appels de fonction dans la version actuelle.

Il convient d'insister sur le fait qu'il DeepSeek V3 répondre en chantant Deepseek R1 L'exclusion des classements n'est pas un déni de l'excellence de ces modèles, mais plutôt une décision prudente prise en pleine connaissance des limites publiées des modèles. Dans le Deepseek V3 et Deepseek R1 Dans la discussion officielle de Hugging Face, les développeurs ont clairement indiqué que les versions actuelles de ces modèles ne prennent pas encore en charge les appels de fonction. Hugging Face a choisi d'attendre une future version avec prise en charge native des appels de fonction plutôt que d'essayer de trouver des solutions de contournement ou de présenter des mesures de performance potentiellement trompeuses.

Ce cas подчеркивает Les appels de fonction sont une fonctionnalité spécialisée que tous les modèles linguistiques performants n'ont pas par défaut. Même les modèles qui excellent dans le raisonnement peuvent ne pas prendre en charge nativement les appels de fonction structurés s'ils ne sont pas spécifiquement conçus et formés pour cela. Par conséquent, une évaluation approfondie du modèle pour votre cas d'utilisation spécifique vous permettra de faire le meilleur choix.

Performance de niveau élite (>= 0,9)

Gemini-2.0-flash Le modèle reste en tête du classement avec un excellent score moyen de 0,938. Il fait preuve d'une stabilité et d'une cohérence excellentes dans toutes les catégories d'évaluation, avec des forces particulières dans les scénarios composites (0,95) et la détection de la non-pertinence (0,98). Compte tenu de son coût par million jeton Prix de 0,15 $/0,6 $.Gemini-2.0-flash Un équilibre convaincant entre performance et rentabilité.

Suivi de près par GPT-4oLe modèle a obtenu un score élevé de 0,900 et a obtenu de bons résultats dans des tâches complexes telles que le traitement multi-outils (0,99) et l'exécution parallèle (0,98). Bien que GPT-4o Le prix est nettement plus élevé, à 2,5/10 dollars par million de jetons, mais ses performances supérieures sont encore оправдывает son coût plus élevé.

Bande haute performance (0,85 à 0,9)

Le segment haute performance se concentre sur un certain nombre de modèles forts. Flash Gemini-1.5 L'excellente note de 0,895 est maintenue, en particulier pour la détection de la non-corrélation (0,98) et la performance de la fonction unique (0,99). Gemini-1.5-pro Malgré le prix plus élevé de 1,25 $/5 $ par million de jetons, il a tout de même obtenu un score élevé de 0,885, démontrant des forces significatives dans les tâches combinées (0,93) et l'exécution d'un seul outil (0,99).

o1 Le modèle, malgré son prix plus élevé de 15/60 dollars par million de jetons, prouve encore sa position sur le marché avec un score de 0,876 et une puissance de traitement du contexte long à la pointe du secteur (0,98). Modèles émergents o3-mini Il est compétitif (0,847), excelle dans les appels de fonctions uniques (0,975) et la détection de la non-pertinence (0,97), et offre aux utilisateurs un choix équilibré avec un prix de 1,1 à 4,4 dollars par million de jetons.

Capacité de niveau moyen (0,8 à 0,85)

GPT-4o-mini maintient une performance efficace de 0,832, particulièrement bonne dans l'utilisation d'outils parallèles (0,99) et la sélection d'outils. Cependant, le modèle est relativement peu performant dans les scénarios à contexte long (0,51).

Dans le camp de la modélisation open source, lemistral-petit-2501 En tête avec un score de 0,832, le modèle montre des améliorations significatives à la fois dans le traitement des contextes longs (0,92) et dans les capacités de sélection des outils (0,99) par rapport à la version précédente. Qwen-72b Avec un score de 0,817, il suit de près, étant capable d'égaler le modèle privé dans la détection de la non-pertinence (0,99) et démontrant un fort traitement du contexte long (0,92). Mistral-large Il obtient de bons résultats en matière de sélection des outils (0,97), mais reste confronté à des difficultés d'intégration des tâches (0,76).

Claude-sonnet a obtenu un score de 0,801 et a excellé dans la détection instrumentale des délétions (0,92) et le traitement des fonctions uniques (0,955).

Modèle de la couche de base (<0,8)

Les modèles de base sont principalement constitués de modèles qui ont obtenu de bons résultats dans des domaines spécifiques, mais qui sont relativement peu performants en termes de scores globaux. Claude-haiku Avec une performance plus équilibrée (0,765) et un prix de 0,8/4 dollars par million de jetons, il fait preuve d'une grande rentabilité.

modèle open source Llama-70B présente un potentiel de 0,774, en particulier dans le scénario multi-outils (0,99). Tandis que Mistral-petit (0.750), Mistral-8b (0,689) et Mistral-nemo (0,661) et d'autres variantes à plus petite échelle du modèle, d'autre part, offrent aux utilisateurs des options efficaces dans les scénarios de tâches de base.

Ces ensembles de données sont essentiels pour construire un cadre permettant d'évaluer de manière exhaustive les capacités d'invocation des outils de modélisation linguistique.

Commentaires : L'agent Intelligent Body Ranking lancé par Hugging Face capture avec précision le problème central de l'application actuelle des modèles de langage : comment utiliser efficacement les outils. Pendant longtemps, l'attention de l'industrie s'est concentrée sur la capacité du modèle lui-même, mais la capacité d'invocation des outils est la clé pour que le modèle soit réellement mis en œuvre et résolve les problèmes réels. L'émergence de ce classement fournit sans aucun doute aux développeurs une référence précieuse pour les aider à choisir les modèles les plus appropriés pour des scénarios d'application spécifiques. De la méthodologie d'évaluation à la construction de l'ensemble des données et à l'analyse finale des performances, le rapport de Hugging Face démontre son professionnalisme rigoureux et méticuleux, et reflète également ses efforts actifs pour promouvoir la mise en œuvre des applications d'IA. Il est particulièrement louable que le classement ne se concentre pas uniquement sur la performance absolue des modèles, mais analyse également la performance des modèles dans différents scénarios, tels que le traitement de contextes longs et les invocations d'outils multiples, qui sont des considérations cruciales dans les applications du monde réel. En outre, Hugging Face a généreusement mis à disposition l'ensemble des données d'évaluation, ce qui favorisera sans aucun doute la recherche et le développement de la communauté dans le domaine des capacités d'invocation d'outils. Dans l'ensemble, il s'agit d'une initiative très opportune et précieuse.

© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Articles connexes

Pas de commentaires...