Gaze-LLE : Outil de prédiction de cible pour le regard d'une personne dans une vidéo

Introduction générale

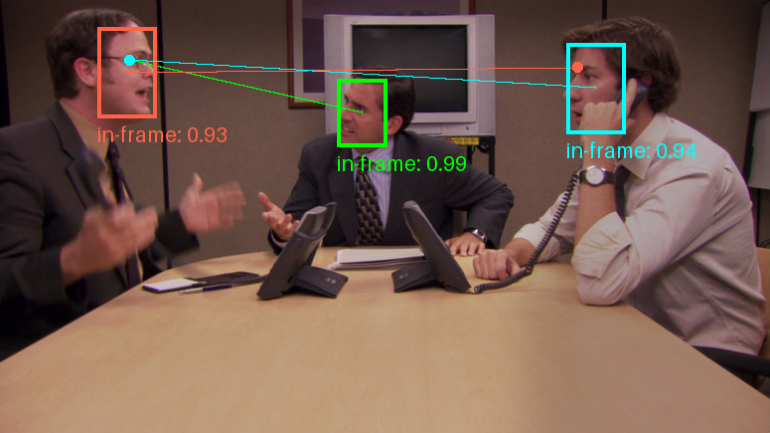

Gaze-LLE est un outil de prédiction de la cible du regard basé sur un codeur d'apprentissage à grande échelle. Développé par Fiona Ryan, Ajay Bati, Sangmin Lee, Daniel Bolya, Judy Hoffman et James M. Rehg, le projet vise à permettre une prédiction efficace de la cible du regard avec des modèles de base visuels pré-entraînés tels que DINOv2.L'architecture de Gaze-LLE est propre et simple, et ne fait que geler le codeur visuel pré-entraîné pour apprendre un décodeur de regard léger, ce qui réduit la quantité de paramètres de 1 à 2 ordres de grandeur par rapport aux modèles précédents. L'architecture de Gaze-LLE est propre et simple, et ne fige que le codeur visuel pré-entraîné pour apprendre un décodeur de regard léger, ce qui réduit la quantité de paramètres de 1 à 2 ordres de grandeur par rapport aux travaux précédents, et ne nécessite pas de modalités d'entrée supplémentaires telles que la profondeur et les informations sur la pose.

Liste des fonctions

- Se concentrer sur la prévision des objectifsLe projet de loi sur la protection de l'environnement a été adopté par le Parlement européen, le Conseil de l'Europe et la Commission européenne.

- Prédiction multiregardsIl permet de prédire le regard de plusieurs personnes sur une même image.

- Modèle de pré-entraînementLe système de gestion de l'information (SGI) : Il fournit une variété de modèles pré-entraînés pour prendre en charge différents réseaux dorsaux et données d'entraînement.

- Architecture légèreApprentissage de décodeurs de regard légers uniquement à partir de codeurs visuels pré-entraînés congelés.

- Pas de modes d'entrée supplémentairesLa profondeur et l'attitude ne nécessitent pas d'informations supplémentaires.

Utiliser l'aide

Processus d'installation

- Entrepôt de clonage :

git clone https://github.com/fkryan/gazelle.git

cd gazelle

- Créer un environnement virtuel et installer les dépendances :

conda env create -f environment.yml

conda activate gazelle

pip install -e .

- Facultatif : installer xformers pour accélérer les calculs d'attention (si le système le permet) :

pip3 install -U xformers --index-url https://download.pytorch.org/whl/cu118

Utilisation de modèles pré-entraînés

Gaze-LLE fournit une variété de modèles pré-entraînés que les utilisateurs peuvent télécharger et utiliser selon leurs besoins :

- gazelledinov2vitb14Modèle basé sur DINOv2 ViT-B avec des données d'entraînement provenant de GazeFollow.

- gazelledinov2vitl14Modèle basé sur DINOv2 ViT-L avec des données d'entraînement provenant de GazeFollow.

- gazelledinov2vitb14_inoutModèle basé sur DINOv2 ViT-B avec des données d'entraînement pour GazeFollow et VideoAttentionTarget.

- gazelleimportantvitl14_inoutModèle basé sur DINOv2 ViT-L avec des données d'entraînement pour GazeFollow et VideoAttentionTarget.

exemple d'utilisation

- Charger le modèle dans PyTorch Hub :

import torch

model, transform = torch.hub.load('fkryan/gazelle', 'gazelle_dinov2_vitb14')

- Consultez le cahier de démonstration dans Google Colab pour apprendre à détecter la cible du regard de chacun dans une image.

surveiller les prévisions

Gaze-LLE permet de prédire le regard de plusieurs personnes, c'est-à-dire qu'une seule image est codée une fois, puis les caractéristiques sont utilisées pour prédire les cibles du regard de plusieurs personnes dans l'image. Le modèle produit une carte thermique spatiale représentant la probabilité de l'emplacement de la cible du regard dans la scène avec des valeurs allant de [0,1], où 1 représente la probabilité la plus élevée de l'emplacement de la cible du regard.

© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Articles connexes

Pas de commentaires...