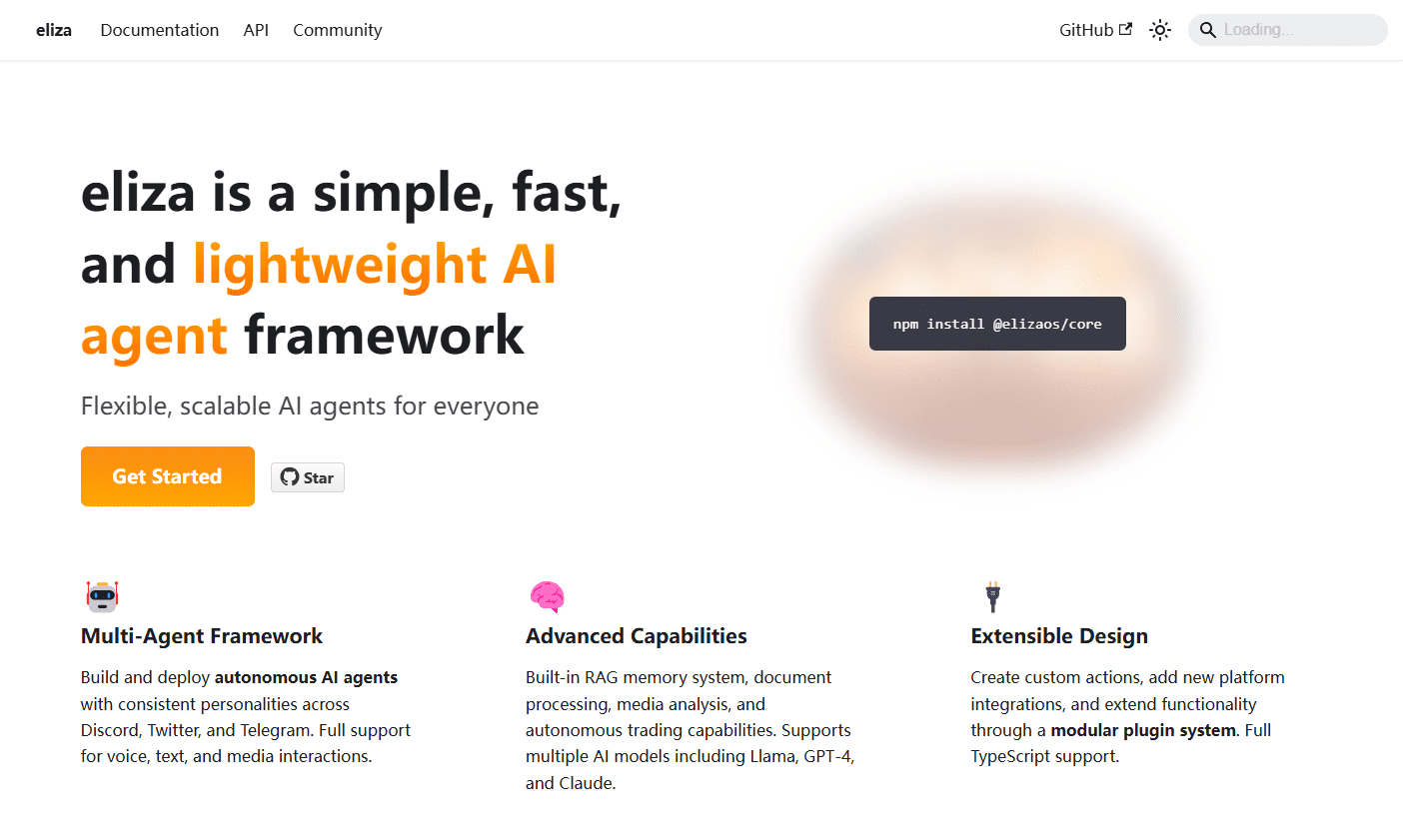

ElizaOS : Construire des multi-intelligences exécutées de manière autonome, un cadre de développement d'organismes intelligents d'IA entièrement fonctionnel et open source

Introduction générale

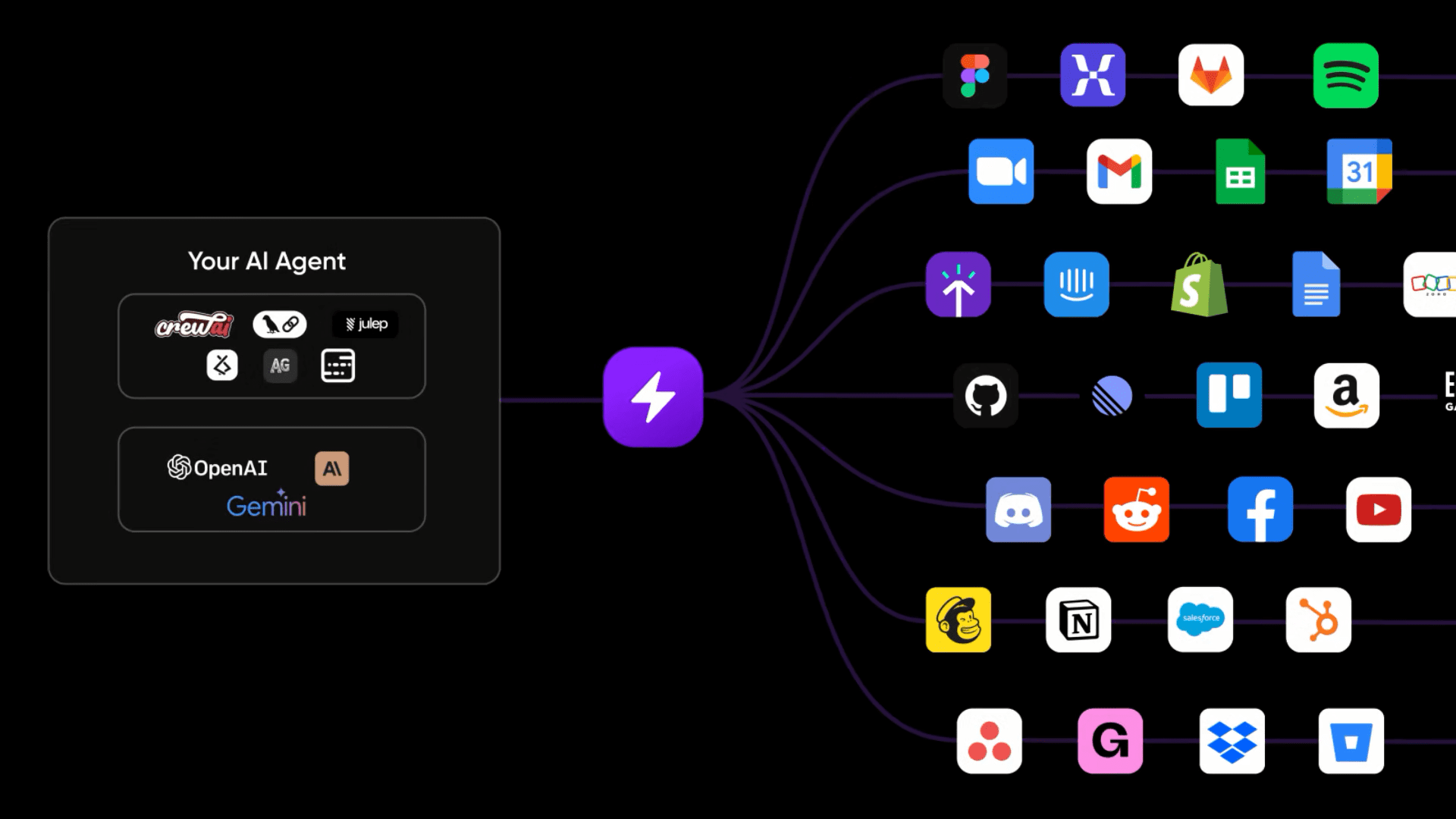

Eliza est un cadre de développement multi-agents de pointe qui vise à simplifier le processus de construction et de déploiement d'agents autonomes. Il prend en charge le déploiement de plusieurs intelligences avec différents paramètres de rôle, et peut réaliser la collaboration et l'interaction entre les intelligences. Le système intègre des interfaces Discord et Twitter complètes, prend en charge l'interaction vocale et est équipé de la génération augmentée basée sur la recherche (RAG).RAGEliza peut traiter des entrées multimodales, y compris des documents textuels, PDF, audio et vidéo, avec des capacités de compréhension du contenu et de génération de résumés. Le cadre utilise une conception modulaire, les développeurs peuvent personnaliser Action et Client pour étendre les limites de la capacité du corps intelligent. Il prend également en charge les grands modèles de langage open-source déployés localement (tels que Llama) et les API en nuage (telles que OpenAI, Anthropic). Claude), ce qui permet aux développeurs de choisir le modèle sous-jacent approprié en fonction de leurs besoins réels.

Un agent d'intelligence artificielle en tête de la liste mensuelle des tendances de Github

Prise en charge de plusieurs agents et de tous les modèles, mémoire intégrée, prise en charge du traitement de fichiers audio/vidéo/PDF arbitraires, intégration transparente avec des plateformes telles que Discord/Twitter.

Anciennement développeur Web3 DAO, maintenant c'est un Web3 Allin AI beat !

Liste des fonctions

- Soutien au déploiement d'intelligences sur plusieurs canaux de communication (Discord, Twitter, Telegram)

- Compatible avec les principaux modèles de langage large (Llama, Grok, OpenAI, Anthropic, etc.)

- Système de collaboration et d'interaction corporelle multi-intelligent

- Accès aux bases de connaissances basé sur la génération améliorée par la recherche (RAG)

- Système intelligent de mémoire à long terme du corps et de récupération des connaissances

- Cadre de capacités évolutives pour les organismes intelligents

- Sélection flexible du modèle (local ou en nuage)

- Expérience de déploiement prête à l'emploi

- Capacités de traitement des contenus multimodaux

- Système de mémoire de dialogue basé sur une base de données vectorielles

Utiliser l'aide

1) Exigences du système

Avant de commencer à utiliser Eliza, assurez-vous que votre système répond aux exigences suivantes.

- Python 2.7 ou supérieur

- Node.js 23 ou supérieur

- Gestionnaire de paquets pnpm

Note pour les utilisateurs de Windows : WSL 2 (Windows Subsystem for Linux 2) est nécessaire.

2. guide de démarrage rapide

La méthode d'installation du démarreur est recommandée :

git clone https://github.com/elizaos/eliza-starter.git

cd eliza-starter

cp .env.example .env

pnpm i && pnpm build && pnpm start

Après avoir démarré l'agent, vous serez invité à exécuter "pnpm start:client". Ouvrez un autre terminal, allez dans le même répertoire et exécutez la commande suivante :

pnpm start:client

3) Configuration de l'environnement

Vous devez configurer les paramètres importants suivants dans le fichier .env :

- Configuration relative à DISCORD (si vous utilisez la fonctionnalité Discord)

- Configuration relative à TWITTER (si vous utilisez la fonction Twitter)

- Clé API OpenAI (si vous utilisez les services OpenAI)

- Clés API pour d'autres services optionnels

4. configuration des rôles personnalisés

Les rôles peuvent être configurés de deux manières :

- modifications

packages/core/src/defaultCharacter.tspour modifier le rôle par défaut - Utilisez la commande pour charger un fichier de rôle personnalisé :

pnpm start --characters="path/to/your/character.json"

5. sélection du modèle

Eliza prend en charge un large éventail de modèles d'IA.

- Modèle de lama : installation

XAI_MODELLes variables d'environnement sontmeta-llama/Meta-Llama-3.1-70B-Instruct-Turbo - Modèle Grok : configuration

XAI_MODELLes variables d'environnement sontgrok-beta - Modèles OpenAI : configuration

XAI_MODELLes variables d'environnement sontgpt-4-minipeut-êtregpt-4o

6) Paramètres de raisonnement local

Si vous disposez d'un GPU NVIDIA, vous pouvez installer CUDA pour augmenter considérablement la vitesse de l'inférence locale :

pnpm install

npx --no node-llama-cpp source download --gpu cuda

Assurez-vous que la boîte à outils CUDA, y compris cuDNN et cuBLAS, est installée.

7. développement de plug-ins

Eliza prend en charge les extensions de plugins. Vous pouvez ajouter les composants suivants pour étendre les fonctionnalités :

- Ajout de nouvelles actions

- Création de nouveaux prestataires

- Développement de nouveaux évaluateurs

- Ajouter un nouveau service (Services)

- Création de nouveaux clients (Clients)

© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Articles connexes

Pas de commentaires...