dots.vlm1 - Petit livre rouge hi lab open source multimodal grand modèle

Qu'est-ce que dots.vlm1 ?

dots.vlm1 est le premier macromodèle multimodal mis à disposition par le Little Red Book hi lab. Basé sur le codeur visuel NaViT de 1,2 milliard de paramètres, entraîné à partir de zéro, et le codeur visuel NaViT de 1,2 milliard de paramètres, entraîné à partir de zéro. DeepSeek V3 avec de fortes capacités de perception visuelle et de raisonnement textuel. Le modèle est performant sur les tâches de compréhension visuelle et d'inférence, approchant le niveau des modèles SOTA à source fermée, et reste compétitif sur les tâches textuelles. Le codeur visuel de dots.vlm1, NaViT, est entraîné entièrement à partir de zéro, supporte nativement la résolution dynamique, et ajoute une supervision visuelle pure à la supervision textuelle pour améliorer les capacités perceptuelles. Les données d'entraînement introduisent une variété d'idées de données synthétiques pour couvrir divers types d'images et leurs descriptions afin d'améliorer la qualité des données.

Principales fonctions de dots.vlm1

- Forte compréhension visuelleLes images : reconnaissent et comprennent avec précision le contenu des images, y compris les diagrammes complexes, les tableaux, les documents, les graphiques, etc. et prennent en charge la résolution dynamique d'un large éventail de tâches visuelles.

- Génération de textes et raisonnement efficacesLe logiciel est basé sur DeepSeek V3 LLM. Il génère des descriptions textuelles de haute qualité et donne de bons résultats dans les tâches de raisonnement textuel telles que les mathématiques et le codage.

- Traitement multimodal des donnéesIl prend en charge le traitement des données avec un entrelacement graphique et textuel, et peut combiner des informations visuelles et textuelles pour un raisonnement intégré, ce qui convient aux scénarios d'application multimodaux.

- Adaptation et extension flexiblesL'adaptateur MLP relie l'encodeur visuel au modèle de langage, ce qui permet une adaptation et une extension flexibles à différentes tâches.

- Open Source et ouvertureLe programme de l'Union européenne pour l'éducation et la formation tout au long de la vie : fournir un code source ouvert complet et des modèles pour aider les développeurs dans leur recherche et le développement d'applications et pour promouvoir le développement de la technologie multimodale.

Adresse du projet pour dots.vlm1

- Dépôt GitHub: : https://github.com/rednote-hilab/dots.vlm1

- Bibliothèque de modèles de visages étreints: : https://huggingface.co/rednote-hilab/dots.vlm1.inst

- Démonstration de l'expérience en ligne: : https://huggingface.co/spaces/rednote-hilab/dots-vlm1-demo

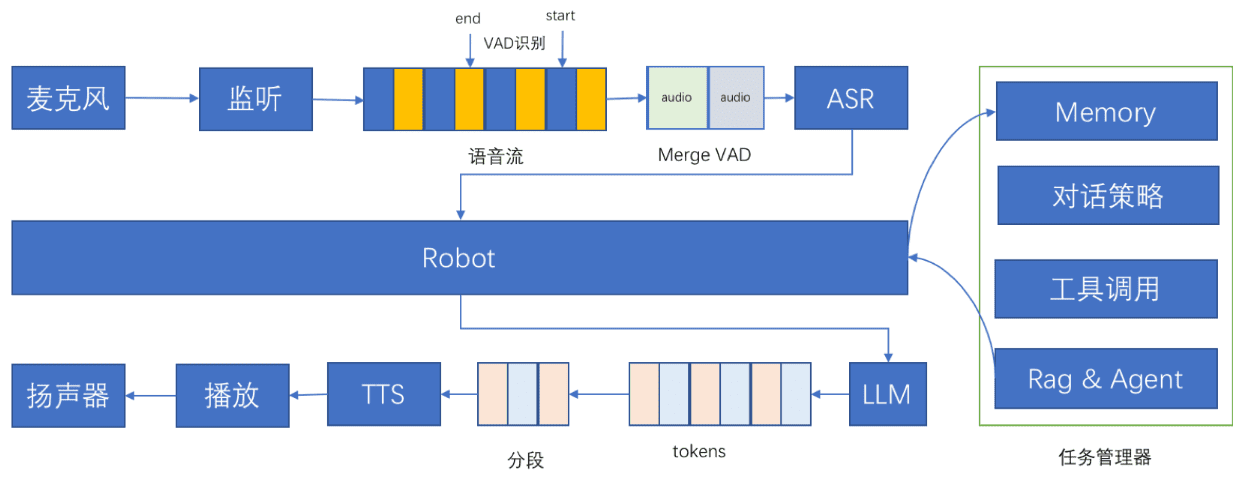

Principes techniques de dots.vlm1

- Encodeur visuel NaViTdots.vlm1 utilise NaViT, un codeur visuel de 1,2 milliard de paramètres formé à partir de zéro, et non pas affiné sur la base de modèles matures existants. Prise en charge native de la résolution dynamique, capable de gérer des images de différentes résolutions, et supervision purement visuelle ajoutée à la supervision textuelle pour améliorer la perception des images par le modèle.

- Formation aux données multimodalesLe modèle adopte diverses données d'entraînement multimodales, notamment des images ordinaires, des diagrammes complexes, des tableaux, des documents, des graphiques, etc., et les descriptions textuelles correspondantes (par exemple, Alt Text, Dense Caption, Grounding, etc.). ). Des idées de données synthétiques et des données entrelacées graphique-texte telles que des pages web et des PDF sont introduites pour améliorer la qualité des données par la réécriture et le nettoyage, et pour améliorer la capacité de compréhension multimodale du modèle.

- Fusion de modèles visuels et linguistiquesdots.vlm1 combine un encodeur visuel avec le DeepSeek V3 Large Language Model (LLM), connecté via un adaptateur MLP léger, pour permettre la fusion efficace des informations visuelles et linguistiques afin de soutenir le traitement des tâches multimodales.

- Processus de formation en trois phasesLa formation du modèle est divisée en trois étapes : préformation du codeur visuel, préformation du VLM et post-formation du VLM. La capacité de généralisation et la capacité de traitement des tâches multimodales du modèle sont améliorées en augmentant progressivement la résolution de l'image et en introduisant diverses données d'entraînement.

Principaux avantages de dots.vlm1

- Codeur visuel formé à partir de zéroLe codeur visuel NaViT a été formé entièrement à partir de zéro, avec une prise en charge native de la résolution dynamique et une supervision purement visuelle, ce qui permet de repousser la limite supérieure de la perception visuelle.

- Innovation en matière de données multimodalesLe projet : L'introduction d'une variété d'idées de données synthétiques pour couvrir divers types d'images et leurs descriptions, ainsi que la réécriture de données de pages web à l'aide d'un macromodèle multimodal, améliorent de manière significative la qualité des données d'apprentissage.

- Performance proche de SOTALa recherche sur la perception et le raisonnement visuels : des performances proches de celles des modèles SOTA à source fermée en matière de perception et de raisonnement visuels, établissant une nouvelle limite supérieure de performance pour les modèles de langage visuel à source ouverte.

- Des capacités de texte puissantesIl est performant dans les tâches de raisonnement textuel, avec quelques compétences en mathématiques et en codage, tout en restant compétitif dans les tâches de texte simple.

- Conception d'une architecture flexibleL'adaptateur MLP relie l'encodeur visuel au modèle de langage, ce qui permet une adaptation et une extension flexibles à différentes tâches.

Personnes auxquelles dots.vlm1 est destiné

- Chercheurs en intelligence artificielleVous êtes intéressé par la macromodélisation multimodale et vous souhaitez explorer son application et son amélioration dans le domaine de la vision et du traitement du langage.

- Développeurs et ingénieursLa nécessité d'intégrer dans le projet des fonctionnalités multimodales telles que la reconnaissance d'images, la génération de texte, le raisonnement visuel, etc.

- éducateurLe modèle peut être utilisé pour faciliter l'enseignement et aider les étudiants à mieux comprendre et analyser des diagrammes, des documents et d'autres contenus complexes.

- créateur de contenuLa nécessité de générer un contenu graphique de haute qualité, ou de faire des recommandations de contenu et des créations personnalisées.

- utilisateur professionnelDans les scénarios commerciaux où des données multimodales doivent être traitées, tels que le service client intelligent, la recommandation de contenu, l'analyse de données, etc.

© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Articles connexes

Pas de commentaires...