Deepseek R1 Enterprise Local Deployment Complete Manual (Manuel complet de déploiement local de Deepseek R1 Enterprise)

I. Introduction

Deepseek R1 est un modèle de langage large à usage général et à haute performance qui prend en charge le raisonnement complexe, le traitement multimodal et la génération de documents techniques. Ce manuel fournit un guide complet de déploiement local pour les équipes techniques, couvrant les configurations matérielles, les adaptations des puces nationales, les solutions de quantification, les solutions hétérogènes, les alternatives au cloud et les méthodes de déploiement pour le modèle 671B MoE complet.

II. configuration de base requise pour un déploiement local

1. tableau des paramètres du modèle et de la correspondance matérielle

| Paramètres du modèle (B) | Configuration requise pour Windows | Configuration requise pour Mac | Scénarios applicables |

|---|---|---|---|

| 1.5B | - RAM : 4GB- GPU : Graphique intégré/CPU moderne- Stockage : 5GB | - Mémoire : 8GB (M1/M2/M3) - Stockage : 5GB | Génération de texte simple, complétion de code de base |

| 7B | - RAM : 8-10GB- GPU : GTX 1680 (4-bit quantised)- Stockage : 8GB | - Mémoire : 16GB (M2 Pro/M3) - Stockage : 8GB | Quiz de complexité moyenne, débogage de code |

| 8B | - RAM : 16GB - GPU : RTX 4080 (16GB VRAM) - Stockage : 10GB | - Mémoire : 32GB (M3 Max) - Stockage : 10GB | Raisonnement de complexité moyenne, génération de documents |

| 14B | - RAM : 24GB- GPU : RTX 3090 (24GB VRAM) | - Mémoire : 32GB (M3 Max) - Stockage : 20GB | Raisonnement complexe, production de documentation technique |

| 32B | Déploiement en entreprise (nécessite plusieurs cartes en parallèle) | Non pris en charge pour l'instant | Calcul scientifique, traitement de données à grande échelle |

| 70B | Déploiement en entreprise (nécessite plusieurs cartes en parallèle) | Non pris en charge pour l'instant | Raisonnement à grande échelle, tâches ultra-complexes |

| 671B | Déploiement en entreprise (nécessite plusieurs cartes en parallèle) | Non pris en charge pour l'instant | Calculs de recherche à très grande échelle, calcul à haute performance |

2. l'analyse des besoins en puissance de calcul

| version du modèle | Paramètre (B) | précision des calculs | Taille du modèle | Exigences en matière de VRAM (Go) | Configuration de référence du GPU |

|---|---|---|---|---|---|

| Profondeur de l'eau-R1 | 671B | FP8 | ~1,342GB | ≥1,342GB | Configurations multi-GPU (par exemple NVIDIA A100 80GB * 16) |

| Vue profonde-R1-Distill-Llama-70B | 70B | BF16 | 43GB | ~32.7GB | Configurations multi-GPU (par exemple NVIDIA A100 80GB * 2) |

| Vue profonde-R1-Distill-Qwen-32B | 32B | BF16 | 20GB | ~14.9GB | Configurations multi-GPU (par exemple NVIDIA RTX 4090 * 4) |

| Vue profonde-R1-Distill-Qwen-14B | 14B | BF16 | 9GB | ~6.5GB | NVIDIA RTX 3080 10GB ou supérieur |

| DeepSeek-R1-Distill-Llama-8B | 8B | BF16 | 4.9GB | ~3.7GB | NVIDIA RTX 3070 8GB ou supérieur |

| Recherche approfondie-R1-Distill-Qwen-7B | 7B | BF16 | 4.7GB | ~3.3GB | NVIDIA RTX 3070 8GB ou supérieur |

| DeepSeek-R1-Distill-Qwen-1.5B | 1.5B | BF16 | 1.1GB | ~0.7GB | NVIDIA RTX 3060 12GB ou supérieur |

Notes supplémentaires :

- Exigences en matière de VRAMIl est recommandé de réserver 20%-30% de mémoire vidéo supplémentaire pour les déploiements réels afin de gérer les pics de demande lors du chargement et de l'utilisation du modèle.

- Configuration multi-GPUPour les modèles à grande échelle (par exemple 32B+), il est recommandé d'utiliser plusieurs GPU en parallèle pour améliorer l'efficacité et la stabilité des calculs.

- précision des calculsLe FP8 et le BF16 sont les principales précisions de calcul actuelles à haut rendement, qui peuvent garantir les performances du modèle tout en réduisant l'utilisation de la mémoire graphique.

- Scénarios applicablesLes modèles avec différentes échelles de paramètres sont adaptés à des tâches de complexité différente, et les utilisateurs peuvent choisir la version appropriée du modèle en fonction de leurs besoins réels.

- Déploiement en entreprisePour les modèles à très grande échelle tels que le 671B, il est recommandé de déployer une grappe de GPU de qualité professionnelle (par exemple, NVIDIA A100) pour répondre aux exigences de calcul à haute performance.

Programme national d'adaptation des puces et du matériel informatique

1. la dynamique de l'écopartenariat national

| sociétés | Contenu de l'adaptation | Analyse comparative des performances (par rapport à NVIDIA) |

|---|---|---|

| L'ascension de Huawei | Le Rise 910B supporte nativement toute la famille R1 et fournit une optimisation de l'inférence de bout en bout. | |

| Mu Xi GPU | La série MXN prend en charge l'inférence du modèle 70B BF16, ce qui augmente l'utilisation de la mémoire de 30%. | RTX 3090 équivalent |

| Sea Light DCU | Adaptation aux modèles V3/R1, performances par rapport à la NVIDIA A100 | Équivalent A100 (BF16) |

2) Configuration recommandée pour le matériel national

| paramètre du modèle | Programme recommandé | Scénarios applicables |

|---|---|---|

| 1.5B | Carte accélératrice Taichu T100 | Validation du prototype du développeur individuel |

| 14B | Cluster Kunlun Core K200 | Raisonnement sur les tâches complexes au niveau de l'entreprise |

| 32B | Wallchurch Computing Power Platform + Cluster Rise 910B | Calcul scientifique et traitement multimodal |

IV. solutions de déploiement dans le nuage

1. les fournisseurs nationaux de services d'informatique dématérialisée recommandés

| bâtiment à toit plat | Points forts | Scénarios applicables |

|---|---|---|

| Flux à base de silicium | API officiellement recommandée, faible latence, prise en charge de modèles multimodaux | Raisonnement à haute teneur en devises de classe entreprise |

| Nuage de Tencent | Déploiement en un clic + essai gratuit pour une durée limitée avec prise en charge de la privatisation des VPC | Les modèles à petite et moyenne échelle sont rapidement mis en service |

| PPIO Paio Cloud | 1/20e du prix d'OpenAI, 50 millions gratuits pour s'inscrire. jetons | Dégustation et test à faible coût |

2. canaux d'accès internationaux (nécessite un accès magique ou étranger à l'internet d'entreprise)

- NVIDIA NIM : Enterprise GPU Cluster Deployment (lien)

- Groq : raisonnement à très faible latence (lien)

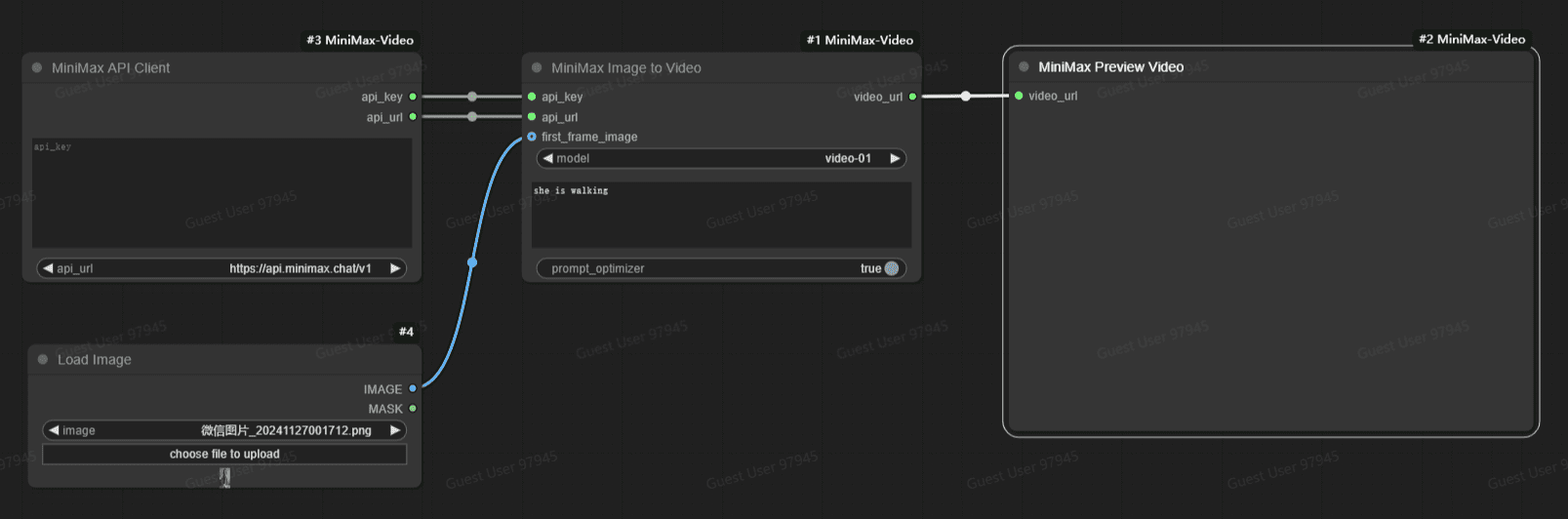

V. Ollama+Déploiement d'Unsloth

1. le programme de quantification et la sélection des modèles

| version quantifiée | taille du fichier | Exigences minimales en matière de RAM + VRM | Scénarios applicables |

|---|---|---|---|

| DeepSeek-R1-UD-IQ1_M | 158GB | ≥200GB | Matériel grand public (par exemple, Mac Studio) |

| DeepSeek-R1-Q4_K_M | 404 GB | ≥500GB | Serveurs/clouds à haute performance GPU |

Adresse de téléchargement :

- Bibliothèque de modèles HuggingFace

- Débarbouillettes Description officielle de l'IA

2) Recommandations pour la configuration du matériel

| Type de matériel | Configurations recommandées | Performances (génération de textes courts) |

|---|---|---|

| Matériel grand public | Mac Studio (192 Go de mémoire unifiée) | 10+ jetons/seconde |

| Serveurs haute performance | 4 RTX 4090 (96GB VRAM + 384GB RAM) | 7-8 jetons/seconde (raisonnement mixte) |

3. les étapes du déploiement (exemple Linux)

1) Installation des outils dépendants :

# 安装 llama.cpp(用于合并分片文件)

/bin/bash -c "$(curl -fsSL https://raw.githubusercontent.com/Homebrew/install/HEAD/install.sh)"

brew install llama.cpp

2) Télécharger et fusionner les éléments de modélisation :

llama-gguf-split --merge DeepSeek-R1-UD-IQ1_M-00001-of-00004.gguf DeepSeek-R1-UD-IQ1_S.gguf

3. installer Ollama :

curl -fsSL https://ollama.com/install.sh | sh

4. créer le fichier modèle :

FROM /path/to/DeepSeek-R1-UD-IQ1_M.gguf

PARAMETER num_gpu 28 # 每块 RTX 4090 加载 7 层(共 4 卡)

PARAMETER num_ctx 2048

PARAMETER temperature 0.6

TEMPLATE "<|end▁of▁thinking $|>{{{ .Prompt }}}<|end▁of▁thinking|>"

5. exécuter le modèle :

ollama create DeepSeek-R1-UD-IQ1_M -f DeepSeekQ1_Modelfile

4. l'optimisation des performances et les tests

- Faible utilisation du GPUMise à niveau de la mémoire à large bande passante (par exemple, DDR5 5600+).

- Espace d'échange étendu: :

sudo fallocate -l 100G /swapfile

sudo chmod 600 /swapfile

sudo mkswap /swapfile

sudo swapon /swapfile

Ordre de déploiement du sang 671B

- VLLM: :

vllm serve deepseek-ai/deepseek-r1-671b --tensor-parallel-size 2 --max-model-len 32768 --enforce-eager

- SGLang: :

python3 -m sglang.launch_server --model deepseek-ai/deepseek-r1-671b --trust-remote-code --tp 2

VI. notes et risques

1. alertes sur les coûts :

- Modèle 70BPour les utilisateurs de cartes graphiques : 3 cartes graphiques de 80G RAM ou plus (par exemple RTX A6000) sont nécessaires, ce qui n'est pas possible pour les utilisateurs d'une seule carte.

- Modèle 671BLes clusters 8xH100 sont requis pour les déploiements de centres de calcul uniquement.

2. les programmes alternatifs :

- Il est recommandé aux utilisateurs individuels d'utiliser des API basées sur le cloud (par exemple, Silicon Flow), qui ne nécessitent aucune maintenance et sont conformes.

3. la compatibilité du matériel national :

- Une version personnalisée du cadre est nécessaire (par exemple Rise CANN, MXMLLM).

VII. Annexe : Soutien technique et ressources

- L'ascension de HuaweiRise Cloud Services : Rise Cloud Services

- Mu Xi GPUL'expérience de l'API libre : L'expérience de l'API libre

- Blog de Lee Seok HanTutoriel de déploiement complet : Tutoriel de déploiement complet

VIII. programme GPUStack hétérogène

Projet Open Source GPUStack

https://github.com/gpustack/gpustack/

Outil de mesure des ressources de modélisation

- Analyseur GGUF(https://github.com/gpustack/gguf-parser-go) est utilisé pour calculer manuellement les besoins en mémoire vidéo.

GPUStack

Déploiement privé de la plate-forme complète DeepSeek

| Modèle | Contexte Taille | Exigences en matière de VRAM | GPU recommandés |

|---|---|---|---|

| R1-Distill-Qwen-1.5B (Q4_K_M) | 32K | 2.86 GiB | RTX 4060 8GB, MacBook Pro M4 Max 36G |

| R1-Distill-Qwen-1.5B (Q8_0) | 32K | 3.47 GiB | RTX 4060 8GB, MacBook Pro M4 Max 36G |

| r1-distill-qwen-1.5b (fp16) | 32K | 4,82 GiB | RTX 4060 8GB, MacBook Pro M4 Max 36G |

| R1-Distill-Qwen-7B (Q4_K_M) | 32K | 7,90 GiB | RTX 4070 12GB, MacBook Pro M4 Max 36G |

| R1-Distill-Qwen-7B (Q8_0) | 32K | 10,83 GiB | RTX 4080 16GB, MacBook Pro M4 Max 36G |

| R1-Distill-Qwen-7B (FP16) | 32K | 17.01 GiB | RTX 4090 24GB, MacBook Pro M4 Max 36G |

| R1-Distill-Llama-8B (Q4_K_M) | 32K | 10,64 GiB | RTX 4080 16GB, MacBook Pro M4 Max 36G |

| R1-Distill-Llama-8B (Q8_0) | 32K | 13.77 GiB | RTX 4080 16GB, MacBook Pro M4 Max 36G |

| R1-Distill-Llama-8B (FP16) | 32K | 20.32 GiB | RTX 4090 24GB, MacBook Pro M4 Max 36G |

| R1-Distill-Qwen-14B (Q4_K_M) | 32K | 16,80 GiB | RTX 4090 24GB, MacBook Pro M4 Max 36G |

| R1-Distill-Qwen-14B (Q8_0) | 32K | 22.69 GiB | RTX 4090 24GB, MacBook Pro M4 Max 36G |

| R1-Distill-Qwen-14B (FP16) | 32K | 34.91 GiB | RTX 4090 24GB x2, MacBook Pro M4 Max 48G |

| R1-Distill-Qwen-32B (Q4_K_M) | 32K | 28.92 GiB | RTX 4080 16GB x2, MacBook Pro M4 Max 48G |

| R1-Distill-Qwen-32B (Q8_0) | 32K | 42,50 GiB | RTX 4090 24GB x3, MacBook Pro M4 Max 64G |

| R1-Distill-Qwen-32B (FP16) | 32K | 70.43 GiB | RTX 4090 24GB x4, MacBook Pro M4 Max 128G |

| R1-Distill-Llama-70B (Q4_K_M) | 32K | 53.41 GiB | RTX 4090 24GB x5, A100 80GB x1, MacBook Pro M4 Max 128G |

| R1-Distill-Llama-70B (Q8_0) | 32K | 83.15 GiB | RTX 4090 24GB x5, MacBook Pro M4 Max 128G |

| R1-Distill-Llama-70B (FP16) | 32K | 143.83 GiB | A100 80GB x2, Mac Studio M2 Ultra 192G |

| R1-671B (UD-IQ1_S) | 32K | 225.27 GiB | A100 80GB x4, Mac Studio M2 Ultra 192G |

| R1-671B (UD-IQ1_M) | 32K | 251.99 GiB | A100 80GB x4, Mac Studio M2 Ultra 192G x2 |

| R1-671B (UD-IQ2_XXS) | 32K | 277.36 GiB | A100 80GB x5, Mac Studio M2 Ultra 192G x2 |

| R1-671B (UD-Q2_K_XL) | 32K | 305.71 GiB | A100 80GB x5, Mac Studio M2 Ultra 192G x2 |

| R1-671B (Q2_K_XS) | 32K | 300,73 GiB | A100 80GB x5, Mac Studio M2 Ultra 192G x2 |

| R1-671B (Q2_K/Q2_K_L) | 32K | 322,14 GiB | A100 80GB x6, Mac Studio M2 Ultra 192G x2 |

| R1-671B (Q3_K_M) | 32K | 392,06 GiB | A100 80GB x7 |

| R1-671B (Q4_K_M) | 32K | 471,33 GiB | A100 80GB x8 |

| R1-671B (Q5_K_M) | 32K | 537,31 GiB | A100 80GB x9 |

| R1-671B (Q6_K) | 32K | 607,42 GiB | A100 80GB x11 |

| R1-671B (Q8_0) | 32K | 758,54 GiB | A100 80GB x13 |

| R1-671B (FP8) | 32K | 805,2 GiB | H200 141GB x8 |

remarques finales

Deepseek R1 Le déploiement localisé nécessite des investissements en matériel et des seuils techniques extrêmement élevés, de sorte que les utilisateurs individuels doivent être prudents et que les entreprises doivent évaluer pleinement les besoins et les coûts. L'adaptation locale et les services en nuage permettent de réduire considérablement les risques et d'améliorer l'efficacité. La technologie n'a pas de limites, une planification rationnelle permet de réduire les coûts et d'accroître l'efficacité !

Calendrier mondial des canaux personnels d'entreprise

- Recherche de la tour secrète

- 360 Nano AI Search

- Flux à base de silicium

- Saut d'octet Moteur volcanique

- Baidu cloud Chifan, un site web de réalité virtuelle

- NVIDIA NIM

- Groq

- Feux d'artifice

- Chutes

- Github

- POE

- Curseur

- Monica

- lambda (lettre grecque Λλ)

- Cérébras

- Perplexité

- Alibaba Cloud 100 Refinements

Pour les environnements nécessitant un accès magique ou étranger à l'Internet d'entreprise

Calendrier de l'aide aux entreprises de puces

Tableau 1 : Fournisseurs de services en nuage prenant en charge DeepSeek-R1

| dates | Nom/site web | Publication d'informations pertinentes |

|---|---|---|

| 28 janvier | lit. ne pas connaître le dôme central du ciel | Une excellente combinaison de nuages hétérogènes |

| 28 janvier | PPIO Paio Cloud | DeepSeek-R1 est en ligne sur PPIO Paio Computing Cloud ! |

| 1er février | Mobilité à base de silicium x Huawei | Première version ! Silicon Mobility x Huawei Cloud lancent conjointement le service d'inférence DeepSeekR1 & V3 basé sur Rise Cloud ! |

| 2 février | Z stark (Cloud Axis Technology) | ZStack prend en charge DeepSeekV3/R1/JanusPro, plusieurs CPU/GPU maison pour un déploiement privé. |

| 3 février | Baidu Intelligent Cloud Chifan | Baidu Intelligent Cloud Chifan prend entièrement en charge les appels DeepSeek-R1/V3 à des prix très bas |

| 3 février | supercalculateur Internet | Supercomputing Internet lance la série de modèles DeepSeek pour fournir un support arithmétique de fusion superintelligent |

| 4 février | Huawei (Rise Community) | Les nouveaux modèles de la série DeepSeek sont officiellement lancés dans la communauté Rise ! |

| 4 février | Lu Chen x Huawei Rise | LU Chen x Huawei Rise, qui lancent ensemble l'API d'inférence de la série DeepSeekR1 et le service de mise en miroir dans le nuage basé sur la puissance arithmétique nationale. |

| 4 février | GreenCloud Technologies, Inc. | Gratuit pour une durée limitée, déploiement en un clic ! Keystone Wise Computing lance officiellement les modèles de la série DeepSeek-R1 |

| 4 février | Tennessee Intelligent Core (TIC), technologie informatique | Adaptation en un jour ! Le service modèle DeepseekR1 est officiellement lancé avec GiteeAi ! |

| 4 février | biologie moléculaire | Hommage à Deepseek : l'écologie Al de la Chine s'emballe grâce aux GPU nationaux |

| 4 février | Informations sur Hai Guang | DeepSeekV3 et R1, la formation termine l'adaptation de l'unité DCU de SeaLight et devient opérationnelle |

| 5 février | lit. lumière de douche | La version intégrale de DeepSeek-V3 est mise en service dans le cadre de la première expérience nationale Mu Xi GPU. |

| 5 février | Informations sur Hai Guang | Haidu Ang DcCU Chen Gong adapte les macromodèles multimodaux DeepSeek-Janus-pro |

| 5 février | Jingdong Yun (Pékin 2008-), le plus grand fournisseur de services en ligne de Chine | Déploiement en un clic ! Jingdong Cloud passe à la vitesse supérieure avec DeepSeek-R1/V3 |

| 5 février | (mesure) | DeepSeekR1 dans le mur ren plateforme arithmétique Ai domestique lancé, la gamme complète de modèles un-stop habiliter les développeurs. |

| 5 février | Unicom Cloud (China Unicom) | "Nezha dans la mer ! Connecter des étagères Cloud Modèles de la série DeepSeek-R1 ! |

| 5 février | Mobile Cloud (China Mobile) | Version complète, taille complète, fonctionnalité complète ! Mobile Cloud est entièrement opérationnel avec DeepSeek |

| 5 février | Ucotex (marque) | UXTECH adapte la gamme complète de modèles de DeepSeek sur la base d'une puce domestique. |

| 5 février | Acer, écrivain américain d'origine taïwanaise | Basé sur la carte d'accélération Taichu T100, 2 heures pour adapter les modèles de la série DeepSeek-R1, une expérience en un clic, un service API gratuit. |

| 5 février | Reed Yun Tian Fei (1931-), homme politique taïwanais, président de la République de Chine depuis 2008 | DeepEdge10 a terminé l'adaptation du modèle de la série DeepSeek-R1 |

| 6 février | SkyCloud (China Telecom) | Nouvelle percée dans l'écologie domestique d'Al ! "Hibiscus" + DeepSeek, la bombe royale ! |

| 6 février | Technologie Suwon | Original Technology parvient à un déploiement complet du service d'inférence de DeepSeek dans des centres de calcul intelligents à travers le pays |

| 6 février | Kunlun Core (Karakorum), chaîne de montagnes utilisée dans le Xinjiang | Domestic Alka Deepseek training inference full version adapted, excellent performance, one-click deployment and so on you ! |

| 7 février | Nuage d'ondes | Wave Cloud est le premier à lancer la solution tout-en-un 671BDeepSeek Big Model |

| 7 février | Supercalculateur de Pékin | Beijing Supercomputing xDeepSeek:Les deux moteurs s'embrasent, entraînant une tempête de 100 milliards d'innovations Al |

| 8 février | Chine E-Cloud | China eCloud lance DeepSeek-R1/V3, un modèle à volume complet qui ouvre un nouveau chapitre du déploiement privé. |

| 8 février | Kingsoft Cloud | Kingsoft Cloud supporte DeepSeek-R1/V3 |

| 8 février | Le grand dispositif de Shang Tang | Shangtang Big Device présente les modèles de la série DeepSeek avec une expérience limitée et des services améliorés ! |

Tableau 2 : Entreprises soutenant DeepSeek-R1

| dates | Nom/site web | Publication d'informations pertinentes |

|---|---|---|

| 30 janvier | 360 Nano AI Search | La recherche par nano-intelligence est lancée avec "DeepSeek-R1", un grand modèle à part entière. |

| 3 février | Secret Tower AI Search | L'IA Secret Tower accède à une version complète du modèle d'inférence DeepSeekR1 |

| 5 février | Assistant Xiaoyi (Huawei) | L'assistant Huawei Xiaoyi a accès à DeepSeek, après que Huawei Cloud a annoncé le lancement du service d'inférence DeepSeekR1/V3 basé sur le service Rise Cloud. |

| 5 février | Assistant d'écrivain (groupe de lecture) | Le premier dans l'industrie ! ReadWrite déploie DeepSeek, "Writer's Assistant" améliore trois fonctions créatives auxiliaires |

| 5 février | Wanxing Technology Co. | Wanxing Technology : Adaptation du grand modèle DeepSeek-R1 et lancement de plusieurs produits |

| 6 février | Aldo P. (1948-), homme d'affaires et homme politique de Hong Kong, premier ministre 2007-2010 | En adoptant DeepSeek comme grand modèle de raisonnement représentatif, NetEase a accéléré l'atterrissage de l'éducation à l'IA. |

| 6 février | école en nuage (informatique) | L'accès à l'apprentissage en nuage aux capacités d'IA du produit DeepSeek a été entièrement mis à jour. |

| 7 février | agrafe | L'assistant IA de Nail a accès à DeepSeek, un support pour la pensée profonde |

| 7 février | Ce qui vaut la peine d'être acheté | Un achat qui en vaut la peine : accès aux produits modèles de DeepSeek |

| 7 février | Flush (négociation d'actions) | Flush ask money 2.0 upgrade : injecter la sagesse de la "pensée lente", pour créer un assistant de prise de décision d'investissement plus rationnel |

| 8 février | Skyworks AI(Kunlun Wanwei) | Tiangong AI de Kunlun Wanwei lance officiellement DeepSeekR1+ Connected Search (recherche connectée) |

| 8 février | Le fantôme des étoiles | FlymeAIOS a terminé l'accès au grand modèle DeepSeek-R1 ! |

| 8 février | glorifier | Pride a accès à DeepSeek |

Tableau 3 : Résumé des entreprises qui soutiennent DeepSeek-R1

| Nom/site web | Publication d'informations pertinentes |

|---|---|

| DeepSeek | Publication de DeepSeek-R1, performances comparées à celles de la version o1 d'OpenAI |

| lit. ne pas connaître le dôme central du ciel | Infini-Al Heterogeneous Cloud est maintenant disponible sur DeepSeek-R1-Distill, une excellente combinaison de modèles maison et de cloud hétérogène. |

| PPIO Paio Cloud | DeepSeek-R1 est en ligne sur PPIO Paio Computing Cloud ! |

| Flux à base de silicium Huawei | Première version ! Silicon Mobility x Huawei Cloud lancent conjointement le service d'inférence DeepSeekR1&V3 basé sur Rise Cloud ! |

| Z stark (Cloud Axis Technology) | ZStack prend en charge DeepSeekV3/R1/JanusPro, plusieurs CPU/GPU maison pour un déploiement privé ! |

| Baidu Intelligent Cloud Chifan | Baidu Intelligent Cloud Chifan prend entièrement en charge les appels DeepSeek-R1/V3 à des prix très bas |

| supercalculateur Internet | Supercomputing Internet lance la série de modèles DeepSeek, qui fournit un support arithmétique de fusion superintelligent |

| Huawei (Rise Community) | Les nouveaux modèles de la série DeepSeek sont officiellement lancés dans la communauté Rise. |

| Lu Chen x Huawei Rise | LU Chen x Huawei Rise : lancement de la série DeepSeekR1 d'API d'inférence et de services de distribution en nuage basés sur la puissance arithmétique nationale |

| GreenCloud Technologies, Inc. | Gratuit pour une durée limitée, déploiement en un clic ! Cornerstone Computing lance la série de modèles DeepSeek-R1 ! |

| Jingdong Yun (Pékin 2008-), le plus grand fournisseur de services en ligne de Chine | Déploiement en un clic ! Jingdong Cloud passe à la vitesse supérieure avec DeepSeek-R1/V3 |

| Unicom Cloud (China Unicom) | "Ne Zha dans la mer ! Connecter les étagères Cloud Modèles de la série DeepSeek-R1 ! |

| Mobile Cloud (China Mobile) | Version complète, taille complète, fonctionnalité complète ! Le Mobile Cloud est entièrement opérationnel DeepSeek |

| Ucotex (marque) | L'UQD adapte toute la gamme des modèles DeepSeek sur la base d'une puce maison |

| SkyCloud (China Telecom) | Nouvelle percée dans l'écosystème domestique de l'IA ! "Hibernate + DeepSeek, la bombe royale ! |

| Chine numérique | Déploiement en 3 minutes du modèle d'IA haute performance DeepSeek, Digital China aide les entreprises dans leur transformation intelligente |

| Kaplan | Cape Cloud Enlightened Large Model Application and End-Side All-in-One Fully Accessed DeepSeek |

| Dôme nuage papillon or | L'accès complet de Kingdee au grand modèle DeepSeek permet aux entreprises d'accélérer l'application de l'IA ! |

| technologie parallèle | Serveur occupé ? Parallel Technologies vous aide à DeepSeek Freedom ! |

| Capital Online (CAPITAL) | La plateforme Cloud de Capital Online est en ligne avec la famille de modèles DeepSeek-R1 |

| Nuage d'ondes | Wave Cloud est le premier à lancer la solution tout-en-un DeepSeek Big Model 671B |

| Supercalculateur de Pékin | Beijing Supercomputing x DeepSeek : deux moteurs explosent, entraînant des centaines de milliards d'innovations en matière d'IA |

| Enablement Rhinoceros (Ziguang) | Ziguang : La plateforme Rhinoceros Enablement Platform permet le nanotubage et la mise en rayon des modèles DeepSeekV3/R1 |

| Chine E-Cloud | China eCloud lance les modèles de volumes complets DeepSeek-R1/V3 pour ouvrir un nouveau chapitre dans le déploiement privé. |

| Kingsoft Cloud | Kingsoft Cloud supporte DeepSeek-R1/V3 |

| Le grand dispositif de Shang Tang | Shangtang Big Device présente la série de modèles DeepSeek avec une expérience limitée et un service amélioré ! |

| 360 Nano AI Search | Nano AI Search lance "DeepSeek-R1", un grand modèle à sang plein |

| Secret Tower AI Search | minaret Accès de l'IA à une version complète du modèle d'inférence DeepSeek R1 |

| Assistant Xiaoyi (Huawei) | L'assistant Huawei Xiaoyi a accès à DeepSeek, après que Huawei Cloud a annoncé le lancement du service d'inférence DeepSeek R1/V3 basé sur le service Rise Cloud. |

| Assistant d'écrivain (groupe de lecture) | Le premier dans l'industrie ! ReadWrite déploie DeepSeek, "Writer's Assistant" améliore trois fonctions d'aide à la création |

| Wanxing Technology Co. | Wanxing Technology : Adaptation du grand modèle DeepSeek-R1 et lancement de plusieurs produits |

| Aldo P. (1948-), homme d'affaires et homme politique de Hong Kong, premier ministre 2007-2010 | En adoptant le grand modèle de raisonnement de DeepSeek, NetEaseYouDao accélère l'atterrissage de l'éducation à l'IA. |

| école en nuage (informatique) | L'accès à l'apprentissage en nuage aux capacités d'IA du produit DeepSeek a été entièrement mis à jour. |

| agrafe | L'assistant IA de Nail accède à DeepSeek, un support pour la pensée profonde |

| Ce qui vaut la peine d'être acheté | Un achat qui en vaut la peine : accès aux produits modèles de DeepSeek |

| Résumé des capacités d'IA liées à Flybook x DeepSeek (version publique) | |

| Flush (négociation d'actions) | Mise à jour de Flush Q&C 2.0 : Injecter la sagesse de la "pensée lente", créer un assistant de décision d'investissement plus rationnel |

| l'œuvre céleste AI (Kunlun Wanwei) | Tiangong AI, une filiale de Kunlun MSI, lance officiellement DeepSeek R1 + Networked Search. |

| Le fantôme des étoiles | Flyme AI OS a terminé l'accès au grand modèle DeepSeek-R1 ! |

| glorifier | Pride a accès à DeepSeek |

© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Articles connexes

Pas de commentaires...