DeepSeek met le feu à Ollama, votre déploiement local est-il sûr ? Méfiez-vous de l'arithmétique "volée" !

Ces dernières années, la technologie de modélisation des grands langages (LLM) a connu une croissance sans précédent et s'est progressivement imposée dans divers secteurs d'activité. Parallèlement, la demande de déploiement local de LLM augmente également. ollama, outil pratique de déploiement local de grands modèles, est bien connu pour sa facilité d'utilisation et sa capacité à DeepSeek et d'autres modèles avancés sont privilégiés par les développeurs et les passionnés de technologie.

Cependant, en recherchant la commodité technologique, les risques de sécurité sont souvent facilement négligés. Certains utilisateurs déploient localement des Ollama Après le service, le port de service Ollama peut être exposé à l'internet en raison d'une mauvaise configuration ou d'une faible sensibilisation à la sécurité, ce qui ouvre la voie à des risques de sécurité potentiels. Dans le présent document, nous analyserons ce risque de sécurité du début à la fin et proposerons des mesures préventives correspondantes.

1. la commodité et les risques potentiels pour la sécurité de l'Ollama

L'avènement d'Ollama a abaissé les barrières au déploiement local et à l'utilisation de grands modèles linguistiques, permettant aux utilisateurs d'exécuter facilement des modèles très performants tels que DeepSeek sur leurs PC ou leurs serveurs. Cette commodité a attiré un grand nombre d'utilisateurs, mais elle a également créé un problème qui ne peut être ignoré :Le service Ollama, dans sa configuration par défaut, peut être exposé à un risque d'accès non autorisé par l'Internet.

Plus précisément, si un utilisateur déploie le service Ollama sans effectuer les configurations de sécurité nécessaires, telles que la restriction des adresses d'écoute ou la mise en place de règles de pare-feu, le port 11434, sur lequel Ollama écoute par défaut, peut être ouvert au public. Cela signifie que n'importe quel utilisateur d'Internet peut accéder à votre service Ollama via le réseau etL'utilisation gratuite de vos ressources informatiques peut même entraîner des problèmes de sécurité plus graves.

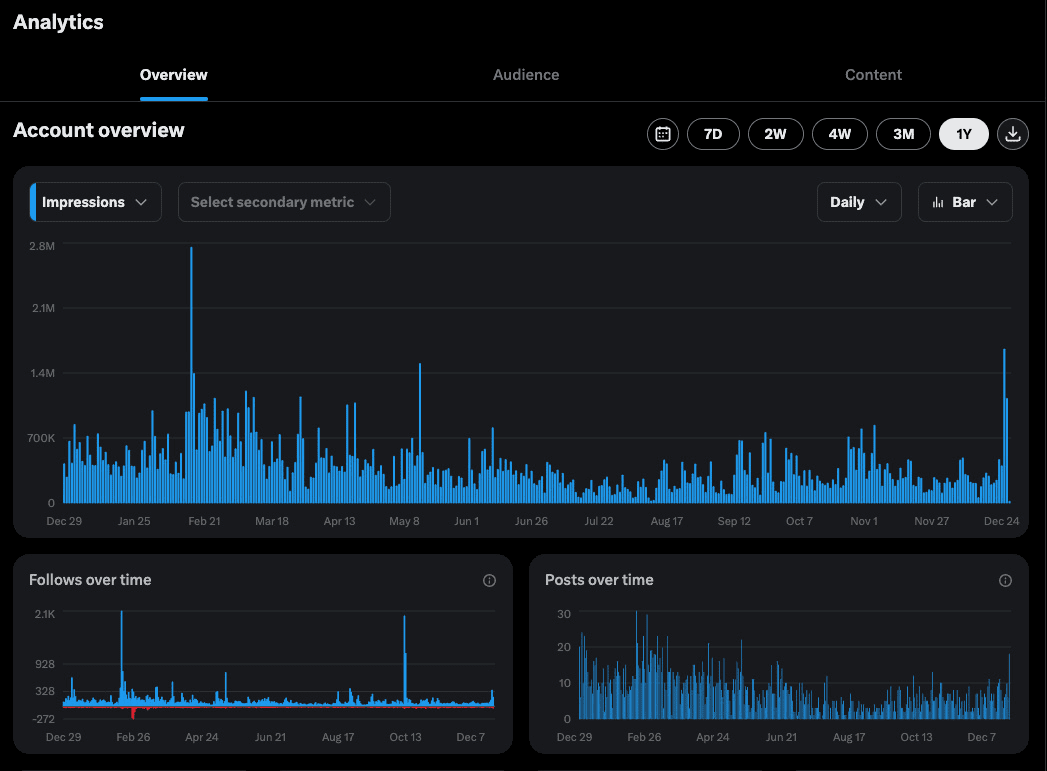

2) Comment découvrir les services exposés d'Ollama sur Internet ? -- Le moteur de recherche FOFA

Pour comprendre le degré d'exposition des services d'Ollama sur Internet et l'éventail des risques potentiels, nous avons besoin de l'aide d'un moteur de recherche du cyberespace.FOFA Il s'agit d'un outil puissant qui nous aide à retrouver et à localiser rapidement les services web exposés publiquement dans le monde entier.

En construisant soigneusement les instructions de recherche FOFA, nous pouvons trouver efficacement les hôtes qui exposent les ports de service Ollama à l'Internet. Par exemple, l'instruction de recherche FOFA suivante peut être utilisée pour trouver des cibles dont le port 11434 est ouvert et dont le code de statut est 200 :

port="11434" && status_code="200"

En effectuant la recherche ci-dessus, le FOFA dresse la liste des adresses IP cibles qualifiées qui sont susceptibles d'exécuter des services Ollama ouverts au public.

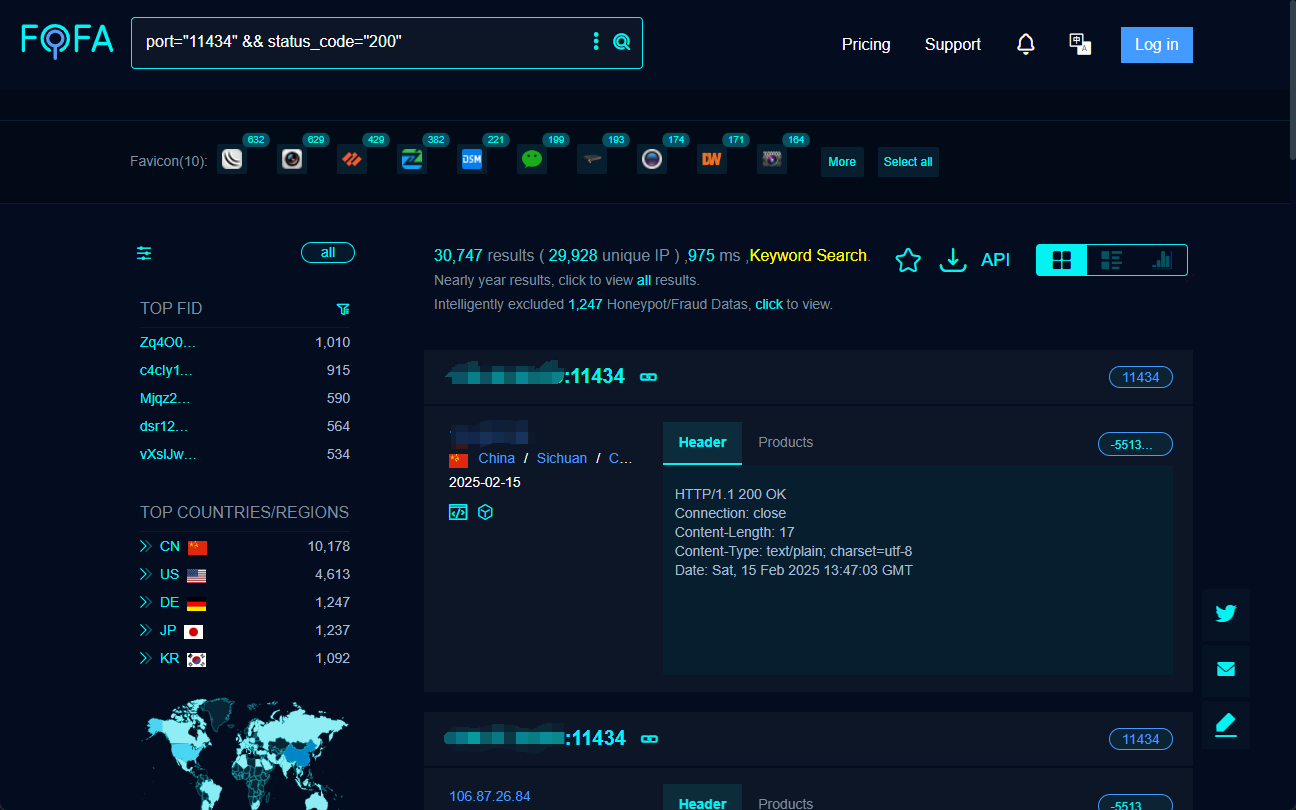

3. comment se connecter et "whore" le service ouvert Ollama ? -- ChatBox et Cherry Studio

Une fois que l'interface ouverte du service Ollama a été trouvée grâce à FOFA, l'étape suivante consiste à se connecter et à interagir avec elle à l'aide d'outils côté client.ChatBox répondre en chantant Cherry Studio sont deux logiciels clients d'IA couramment utilisés, qui permettent tous deux de se connecter au service Ollama à l'aide d'appels de modèles et de dialogues.

3.1 Utilisation de ChatBox pour se connecter au service Open Ollama

ChatBox Réputé pour sa simplicité et sa facilité d'utilisation, les étapes pour se connecter au service Open Ollama sont très simples :

- Télécharger et installer le client ChatBox.

- Configurez l'adresse de l'API : existent ChatBox définir l'adresse API en fonction de l'adresse IP et du port du serveur cible, par exemple

http://目标IP:11434/. - Sélectionnez le modèle et entamez le dialogue : Une fois la configuration terminée, vous pouvez sélectionner le modèle et entamer un dialogue avec le service à distance Ollama.

3.2 Connexion au service Open Ollama avec Cherry Studio

Cherry Studio Il est plus complet et prend en charge des fonctions avancées telles que la gestion de la base de connaissances, en plus des fonctions de dialogue. Les étapes de la connexion sont les suivantes :

- Télécharger et installer le client Cherry Studio.

- Configurer l'interface Ollama : existent Cherry Studio Dans "Settings" → "Model Services" → "Ollama", définissez l'adresse API comme suit

http://目标IP:11434. - Ajouter et valider le modèle : Ajoutez le modèle cible dans la page de gestion des modèles, par exemple "deepseek-r1:1.5b", et testez la connexion.

Grâce à des clients tels que ChatBox ou Cherry Studio, les utilisateurs peuvent facilement se connecter aux services d'Ollama exposés sur l'internet etUtilisation gratuite et non autorisée des ressources informatiques et des capacités de modélisation d'autrui.

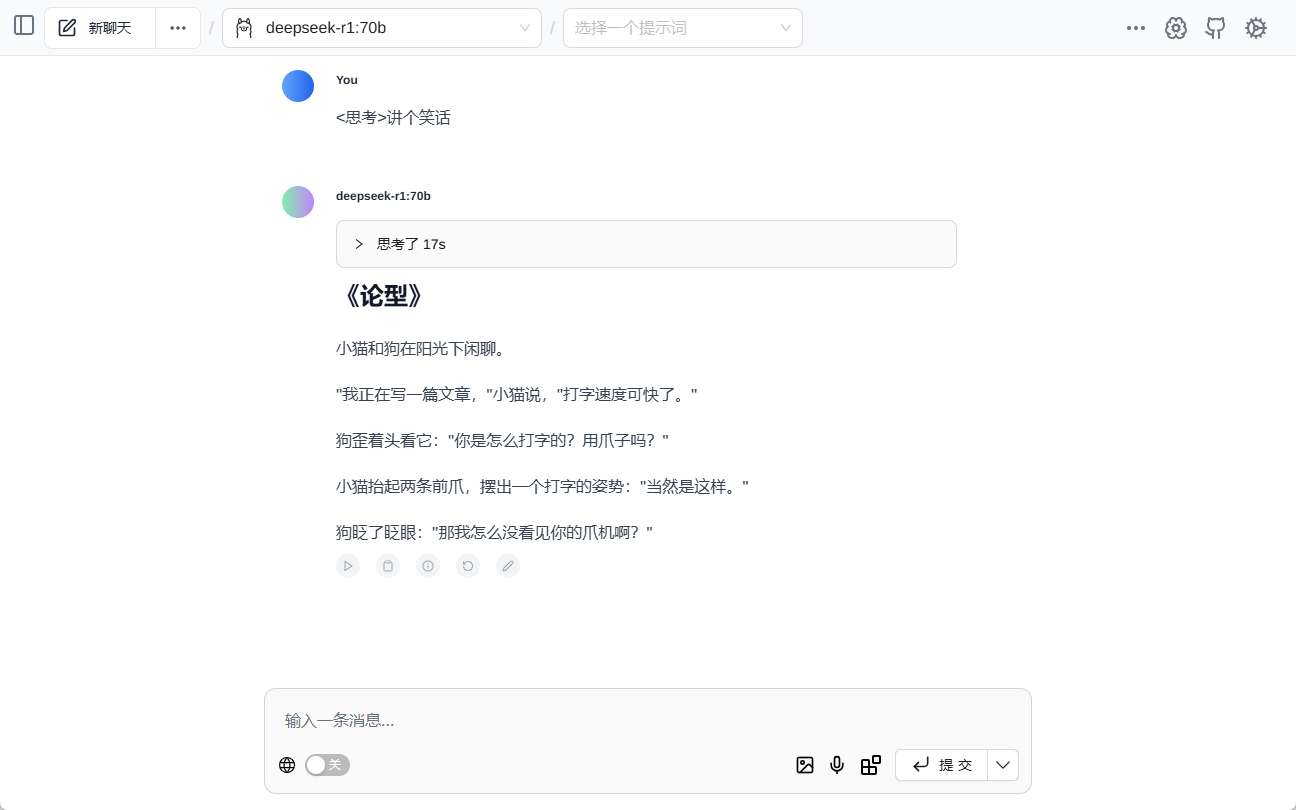

Après avoir obtenu une adresse aléatoire, essayez le plugin web qui supporte nativement la lecture des modèles Ollama. Page Assist Dialogue au milieu :

4. les risques de sécurité qui se cachent derrière le "free lunch" : vol d'électricité, fuite de données et pièges juridiques

Derrière l'apparente gratuité, se cachent de nombreux risques pour la sécurité et des problèmes juridiques potentiels :

- Vol arithmétique (mauvaise utilisation des ressources). Le risque le plus immédiat est que la puissance de calcul des GPU d'un fournisseur de services Ollama soit utilisée par d'autres sans compensation, ce qui entraîne un gaspillage de ressources et une dégradation des performances. Les attaquants peuvent utiliser des scripts automatisés pour scanner en masse et se connecter à des services Ollama ouverts, transformant ainsi leurs GPU en "ateliers d'entraînement" pour former des modèles malveillants.

- Violation de données. Si des données sensibles sont stockées ou traitées dans le service Ollama, il existe un risque de fuite de ces données dans un environnement de réseau ouvert. Les journaux de dialogue des utilisateurs, les données de formation, etc. pourraient être transmis sur des canaux non cryptés et faire l'objet d'une écoute malveillante ou d'un vol.

- Modèles en vente. Les fichiers de modèles non cryptés sont facilement téléchargés et copiés, et si de grands modèles d'industries à valeur commerciale sont utilisés dans les services d'Ollama, il y a un risque que les modèles soient volés et vendus, ce qui entraînerait des pertes financières importantes.

- Intrusion dans le système. Le service Ollama lui-même peut présenter une faille de sécurité qui, si elle est exploitée par un pirate, peut conduire à l'exécution d'un code à distance, ce qui permet à un attaquant de prendre le contrôle total du serveur d'une victime, en le transformant en un système d'information.se transformer enPartie d'un réseau de zombies utilisé pour lancer des cyberattaques à grande échelle.

- Risques juridiques. L'accès et l'utilisation non autorisés des services Ollama d'autres personnes, ou même l'utilisation malveillante de ces services, peuvent constituer une violation des lois et règlements en vigueur et entraîner une responsabilité juridique.

5) Les utilisateurs chinois sont-ils plus en sécurité ? -- L'IP dynamique n'est pas une barrière absolue

D'aucuns ont fait valoir que "les utilisateurs chinois sont relativement à l'abri de ce risque de "white whoring" en raison de la faiblesse de leurs droits de propriété intellectuelle indépendants". Ce point de vue est quelque peu partial.

Il est vrai qu'un pourcentage plus élevé d'utilisateurs chinois de l'Internet à haut débit utilise des adresses IP dynamiques par rapport aux pays occidentaux, ce qui réduit dans une certaine mesure le risque d'exposition. L'incertitude des IP dynamiques fait qu'il est difficile pour les attaquants de suivre et de localiser des utilisateurs spécifiques au fil du temps.

Mais cela ne signifie en aucun cas que les utilisateurs chinois peuvent dormir sur leurs deux oreilles. Premièrement, il existe encore un grand nombre de serveurs Ollama dans l'environnement Internet chinois, dont beaucoup avec des adresses IP fixes. Deuxièmement, même les adresses IP dynamiques peuvent rester inchangées pendant un certain temps, et il est toujours possible pour un attaquant de mener une attaque pendant la période où l'adresse IP n'a pas été changée. Plus important encore.La sécurité ne peut être laissée à la "chance" ou aux "barrières naturelles", mais doit reposer sur des mesures de sécurité proactives.

6) Lignes directrices sur la sécurité du service local d'Ollama : éviter de devenir un "Broiler" (bouc émissaire)

Afin de protéger les services Ollama déployés localement contre toute utilisation abusive, les utilisateurs doivent prendre des mesures de sécurité proactives et efficaces. Vous trouverez ci-dessous quelques conseils à l'intention des utilisateurs novices :

6.1 Restreindre les adresses d'écoute du service Ollama

Modifier l'adresse d'écoute du service Ollama par rapport à l'adresse par défaut 0.0.0.0 modifier pour 127.0.0.1Ce n'est pas grave.Force le service Ollama à n'écouter que les requêtes provenant de la machine locale et à refuser l'accès direct aux réseaux externes. Les étapes sont les suivantes :

- Trouver le fichier de configuration : Les fichiers de configuration d'Ollama sont généralement situés dans le répertoire

/etc/ollama/config.conf.. Ouvrez le fichier (ou créez-le s'il n'existe pas), trouvez ou ajoutez le champbind_addressÉlément de configuration. - Modifier l'adresse de liaison : commandant en chef (militaire)

bind_addressest fixé à la valeur de127.0.0.1et veiller à ce queportfixé à11434. Un exemple de configuration complète est présenté ci-dessous :bind_address = 127.0.0.1 port = 11434 - Sauvegardez et redémarrez le service : Après avoir enregistré le fichier de configuration, exécutez la commande

sudo systemctl restart ollamapour redémarrer le service Ollama afin que la configuration prenne effet.

6.2 Configuration des règles de pare-feu

En configurant des règles de pare-feu, vous pouvezContrôle précis de l'éventail des adresses IP et des ports autorisés à accéder au service Ollama. Par exemple, vous pouvez autoriser uniquement les adresses IP de votre réseau local à accéder au port 11434 et bloquer toutes les demandes d'accès provenant du réseau public. Les paragraphes suivants décrivent comment configurer le pare-feu dans les environnements Windows et Linux respectivement :

Étapes de la configuration de l'environnement Windows :

- Activez la sécurité avancée du pare-feu Windows Defender : Dans le "Panneau de configuration", recherchez "Système et sécurité", cliquez sur "Pare-feu Windows Defender", puis sélectionnez "Paramètres avancés". Paramètres avancés".

- Créez une nouvelle règle de réception : Dans "Inbound Rules", cliquez sur "New Rule...", sélectionnez le type de règle "Port" et cliquez sur "Next". Suivant".

- Spécifie le port et le protocole : Le protocole est sélectionné comme "TCP" et le port local spécifique est réglé sur

11434Cliquez sur "Suivant". - Sélectionner l'opération : Sélectionnez "Autoriser la connexion" et cliquez sur "Suivant".

- Configurer le champ d'application (facultatif) : Vous pouvez configurer les champs d'application des règles en fonction de vos besoins. En règle générale, conservez les paramètres par défaut et cliquez sur Suivant.

- Spécifiez le nom et la description : Attribuez un nom facilement reconnaissable à la règle (par exemple, "Ollama Service Port Restriction"), ajoutez une description (facultative) et cliquez sur "Finish" pour terminer la création de la règle.

Environnement Linux (pare-feu ufw par exemple) Étapes de configuration :

- Activer le pare-feu ufw : Si ufw n'est pas encore activé, exécutez la commande suivante dans le terminal

sudo ufw enablepour activer le pare-feu. - Autoriser l'accès au réseau local : réaliser

sudo ufw allow from 192.168.1.0/24 to any port 11434qui permet d'utiliser la commande192.168.1.0/24L'adresse IP du segment LAN accède au port 11434. Veuillez modifier la plage d'adresses IP en fonction du segment LAN actuel. - Interdire l'accès à d'autres personnes (facultatif) : Si la politique par défaut est d'autoriser tous les accès externes, vous pouvez exécuter la commande

sudo ufw deny 11434pour refuser l'accès au port 11434 aux adresses IP de toutes les autres sources. - Visualiser l'état du pare-feu : réaliser

sudo ufw status verbosepour vérifier l'état de la règle de pare-feu et confirmer que la configuration a pris effet.

6.3 Activation de l'authentification et du contrôle d'accès

Dans les cas où vous devez fournir des services Ollama à l'extérieur, veillez àActivation des mécanismes d'authentification. pour empêcher tout accès non autorisé. Voici quelques méthodes d'authentification courantes :

- Authentification de base HTTP : L'authentification de base HTTP peut être configurée via un serveur web tel qu'Apache ou Nginx. Cette méthode est simple et facile à utiliser, mais la sécurité est relativement faible, ce qui convient aux scénarios qui ne nécessitent pas une sécurité élevée. Après avoir configuré l'authentification de base, les utilisateurs doivent fournir un nom d'utilisateur et un mot de passe lorsqu'ils accèdent aux services Ollama.

- Clé API : Ajout d'un mécanisme de vérification de la clé API au front-end du service Ollama. Lorsqu'un client demande un service Ollama, il doit inclure une clé API prédéfinie dans l'en-tête de la requête ou dans les paramètres de la requête. Le serveur vérifie la validité de la clé et seules les demandes contenant la clé correcte sont traitées. Cette approche est plus sûre que l'authentification de base et est facile à intégrer dans les applications.

- Mécanismes d'authentification et d'autorisation plus avancés tels que OAuth 2.0 : Pour les scénarios présentant des exigences de sécurité plus élevées, des cadres d'authentification et d'autorisation plus complexes, tels que OAuth 2.0, peuvent être envisagés. OAuth 2.0 fournit un processus d'autorisation et d'authentification parfait, prend en charge plusieurs modes d'autorisation et permet un contrôle d'accès précis. Cependant, la configuration et l'intégration d'OAuth 2.0 sont relativement complexes et nécessitent un certain effort de développement.

Le choix de la méthode d'authentification doit être basé sur une combinaison de facteurs tels que les scénarios d'application, les exigences de sécurité et le coût de la mise en œuvre technique du service Ollama.

6.4 Utilisation d'un proxy inverse

En utilisant un serveur proxy inverse (tel que Nginx), vous pouvezAgit comme un frontal pour le service Ollama, cachant l'adresse IP et le port réels du service Ollama et fournissant des fonctions de sécurité supplémentaires.Par exemple :

- Masquer le serveur dorsal : Les utilisateurs externes ne peuvent voir que l'adresse IP du serveur proxy inverse et ne peuvent pas accéder directement au serveur réel où se trouve le service Ollama, ce qui améliore la sécurité.

- Équilibrage de la charge : Si le service Ollama est déployé sur plusieurs serveurs, le serveur mandataire inverse peut mettre en œuvre l'équilibrage de la charge pour distribuer les demandes des utilisateurs sur différents serveurs, améliorant ainsi la disponibilité et les performances du service.

- Cryptage SSL/TLS : Le serveur proxy inverse peut être configuré avec des certificats SSL/TLS pour permettre un accès crypté HTTPS et protéger la sécurité de la transmission des données.

- Pare-feu d'application Web (WAF) : Certains serveurs proxy inversés intègrent la fonctionnalité WAF pour détecter et se défendre contre les attaques web courantes telles que l'injection SQL, les attaques de scripts intersites (XSS), etc.

- Contrôle d'accès : Les serveurs proxy inversés peuvent être configurés avec des politiques de contrôle d'accès plus souples, telles que le contrôle d'accès basé sur l'adresse IP, l'identité de l'utilisateur, le contenu de la demande, etc.

7. conclusion : sensibilisation à la sécurité et responsabilité en action

La popularité des outils de big model déployés localement, tels qu'Ollama, a facilité l'innovation technologique et les applications, mais elle a également posé de nouveaux défis en matière de cybersécurité. Le service Ollama, présenté sur l'internet comme "libre d'utilisation", peut sembler séduisant, mais il comporte des risques cachés. Un tel comportement peut non seulement violer les lois et règlements et la cyberéthique, mais aussi constituer une menace pour votre propre sécurité et celle d'autrui.

Pour les déployeurs de services Ollama, la sensibilisation à la sécurité et l'adoption des mesures de sécurité nécessaires relèvent de la responsabilité de protéger leurs propres ressources informatiques et la sécurité des données, ainsi que de maintenir un environnement de réseau sain. Ne transformez pas vos serveurs en "broyeurs arithmétiques" et ne devenez pas complices de cyberattaques à cause d'une négligence momentanée.

Tout en profitant des dividendes de la technologie, chaque utilisateur de l'internet devrait toujours être vigilant, avoir une vision correcte de la sécurité des réseaux et travailler ensemble pour construire un écosystème d'applications d'IA sûr, digne de confiance et durable.

NOUVELLE ALERTE DE RISQUE : Veuillez vérifier et renforcer votre service Ollama immédiatement ! La sécurité n'est pas une mince affaire !

La popularité du modèle DeepSeek et de l'outil Ollama illustre sans aucun doute le développement de la technologie de l'IA. Cependant, la sécurité est toujours la pierre angulaire du progrès technologique. Avis aux utilisateurs d'OllamaExaminez immédiatement la configuration de votre déploiement local, évaluez les risques de sécurité potentiels et prenez les mesures de renforcement nécessaires. Il n'est pas trop tard pour réparer.

Pour ceux qui n'ont pas encore installé Ollama ou qui envisagent de déployer Ollama, assurez-vous également queReconnaître pleinement les risques de sécurité liés au déploiement local d'outils de big model, évaluer prudemment ses propres capacités techniques et son niveau de protection de la sécurité, et les utiliser de manière appropriée en vue d'assurer la sécurité. N'oubliez pas que la cybersécurité est l'affaire de tous et que la meilleure stratégie consiste à la prévenir avant qu'elle ne se produise.

© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Articles connexes

Pas de commentaires...