12 concepts clés à connaître sur l'utilisation de l'IA de navigation

Parcourir L'IA vous permet d'extraire et de surveiller les données de n'importe quelle page web en quelques minutes et sans code. Les robots que vous entraînez à exploiter les sites web comme le font les humains vous permettront d'extraire les données les plus précises avec le moins d'efforts possible. Ce guide présente quelques concepts clés pour vous aider à démarrer.

1) Robotique

Vous pouvez former unpersonne mécaniquepour automatiser une série d'étapes sur votre site web que vous devriez normalement effectuer manuellement.

Par exemple, un robot peut adopter tous les comportements suivants lors de l'exécution d'une tâche :

- ouvrir une page web

- toucher terre (typhon, etc.)

- cliquer sur un bouton

- remplir un formulaire

- Sélectionnez dans le menu déroulant

- Extraire des données structurées de pages web vers des feuilles de calcul

- Cliquez sur le bouton "Suivant" ou "Charger plus" pour obtenir plus de données.

- capturer une image affichée sur un écran d'ordinateur

- Contrôler les modifications visuelles ou de contenu apportées à des parties spécifiques d'une page web

Le robot possède des [paramètres d'entrée] dynamiques qui vous permettent d'ajuster l'URL de la page web alias [URL source] ou la saisie de texte à chaque exécution. Cela vous permet d'utiliser le même robot pour extraire ou surveiller des données sur un nombre illimité de pages d'un site ayant une présentation similaire.

La plupart des gens créent des robots qui ouvrent simplement une page web et en extraient des données. Les utilisateurs peuvent utiliser [batch run] sur des dizaines de milliers de pages similaires d'un site web pour extraire rapidement l'ensemble des données.

Les robots font également beaucoup de choses en arrière-plan que vous ne remarquez peut-être pas, comme résoudre les CAPTCHA, utiliser des adresses IP résidentielles géolocalisées, imiter le comportement humain pour éviter d'être détecté, s'adapter automatiquement aux modifications du site web et, essentiellement, s'auto-entretenir.

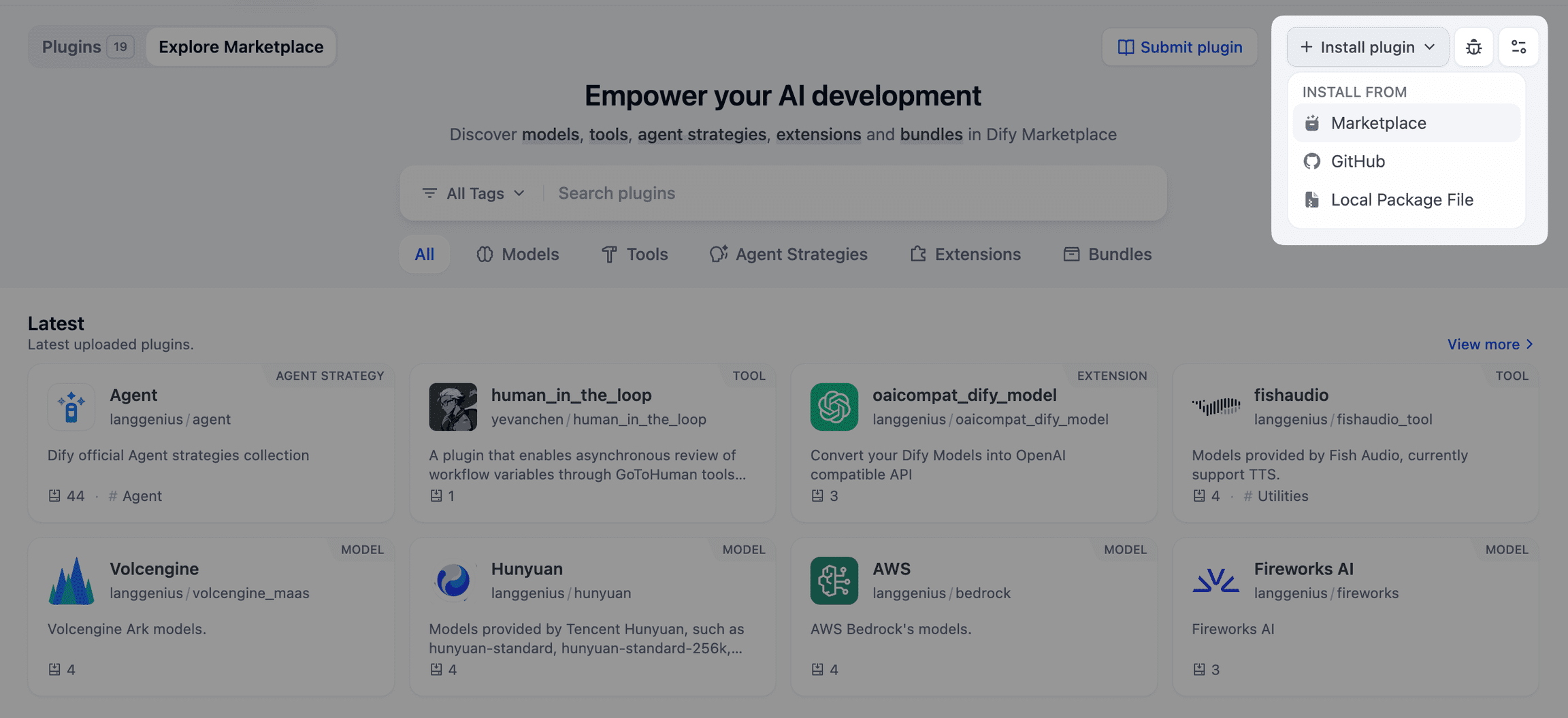

2) Robots préfabriqués et robots sur mesure

Les robots peuvent être créés en utilisant [Premade Robots], ou en utilisant l'enregistreur Browse AI et son interface click-to-extract. Chaque robot possède des [Paramètres d'entrée] (par exemple, l'adresse web) que vous pouvez ajuster à chaque fois que vous l'exécutez.

Des bots préconstruits s'appliquent aux cas d'utilisation les plus courants et de nouveaux bots sont mis en ligne chaque semaine. Il s'agit par exemple d'extraire des données des sites web des entreprises Yelp, TripAdvisor ou LinkedIn.

Plus de 901 utilisateurs de TP3T of Browse AI créent des bots qui sont des bots personnalisés formés pour des cas d'utilisation spécifiques. Par exemple, certains agents immobiliers surveillent les permis de construire délivrés par le gouvernement de leur comté (sur le site officiel du comté) et les connectent à un CRM de vente ou à une feuille de calcul qui envoie automatiquement des courriels à chaque constructeur qui obtient un permis de construire.

3) URL de la source

Chaque [bot personnalisé] dispose d'une URL source [paramètre d'entrée], qui pointe par défaut vers le lien sur lequel il a été formé. Vous pouvez extraire ou surveiller les données de n'importe quelle autre page de ce site ayant une présentation similaire en modifiant l'URL source.

Par exemple, si vous souhaitez [surveiller] les prix des produits Walmart, vous pouvez former un robot personnalisé sur une page de produit Walmart, puis ajuster l'URL source pour chaque surveillance afin de configurer ce robot pour qu'il surveille 100 pages de produits différentes.

4) Tâches

Chaque [bot] est formé pour effectuer une tâche spécifique. Chaque fois que vous exécutez ce robot, il effectue cette tâche et les détails de la tâche (y compris les données extraites) sont stockés sous cette tâche dans l'onglet Historique du robot.

Si vous mettez en place un robot de surveillance pour [surveiller] les modifications de pages web quotidiennement, il devra peut-être exécuter une tâche par jour, soit environ 30 tâches par mois.

Les nouvelles tâches peuvent être créées de différentes manières :

- Vous pouvez ouvrir un bot sur votre tableau de bord, accéder à son onglet Exécuter des tâches et exécuter une tâche.

- Dans l'onglet Exécuter des tâches, vous pouvez également sélectionner [Exécution par lots] pour exécuter jusqu'à 50 000 tâches à la fois en téléchargeant des fichiers CSV.

- Si vous configurez un moniteur, une nouvelle tâche de surveillance est automatiquement créée chaque fois que vous devez effectuer un contrôle de surveillance.

- Si vous intégrez Browse AI à un autre logiciel ou utilisez l'API, de nouvelles tâches peuvent être créées via l'API.

- Occasionnellement, le système crée des tâches pour s'assurer que le robot est en bonne santé ou pour l'optimiser afin de le rendre plus rapide ou plus fiable. Les tâches seront marquées comme "exécutées par le système".

5) Contrôle

L'une des caractéristiques les plus utiles de Browse AI est le système de surveillance intégré.

Chaque robot peut être configuré avec un nombre infini de moniteurs, chacun correspondant à une page du site web ou à une condition de recherche à surveiller.

Par exemple, vous pouvez utiliser un robot pour surveiller tous les produits sur un site de commerce électronique et recevoir des notifications lorsque les prix changent ou qu'un produit devient disponible.

Le moniteur peut détecter des changements et être configuré pour envoyer une notification par courrier électronique lorsqu'un changement est détecté ou pour envoyer automatiquement les données à un autre logiciel.

6) Paramètres d'entrée

Chaque robot est équipé de paramètres d'entrée qui peuvent être ajustés et contrôlés en fonction des exigences de la tâche, ce qui signifie que vous n'avez pas besoin de recréer des robots pour chaque page ou chaque terme de recherche sur votre site web.

Le paramètre d'entrée le plus courant est [URL source], qui est la page que le robot visite pour la première fois.

Lorsque vous personnalisez votre robot, si vous saisissez du texte, ce que vous saisissez deviendra un paramètre d'entrée qui pourra être ajusté ultérieurement.

7) Exécution par lots

La fonction d'exécution par lots est disponible dans l'onglet Exécuter des tâches du panneau de configuration du robot. Cette fonction vous permet de télécharger un fichier CSV contenant jusqu'à 50 000 ensembles différents de [paramètres d'entrée] et de créer instantanément une [tâche] pour chaque ensemble de paramètres. Les tâches seront mises en file d'attente pour être traitées et, une fois terminées, vous recevrez l'ensemble des données extraites.

Par exemple, vous pouvez télécharger un fichier CSV contenant des liens vers 50 000 pages d'entreprises sur LinkedIn et obtenir toutes les données extraites de ces pages.

8) Ramper en profondeur

Deep Crawl est un terme couramment utilisé qui fait référence à l'exploration d'une liste de liens à partir d'une page dans une catégorie particulière, puis à l'extraction des détails de chaque lien.

Cette approche vous permet de recueillir des données détaillées et approfondies sur des pages ou des sections de votre site web.

En savoir plus sur l'utilisation de Parcourir l'IA Effectuer une exploration en profondeur de [article connexe].

9) Applications intégrées

Souvent, vous aurez besoin de transférer les données capturées sur votre site Web vers d'autres logiciels que vous utilisez, tels que Google Forms ou CRM. Browse AI propose plus de 5 000 intégrations pour vous permettre d'importer facilement les données de n'importe quel site Web dans les outils que vous utilisez déjà.

10) Intégration de Google Forms avec Airtable

Il existe déjà des intégrations directes pour [Google Forms] et Airtable. Une fois configuré sur le robot, chaque fois que le robot effectue une tâche, les données extraites sont insérées directement dans votre feuille de calcul.

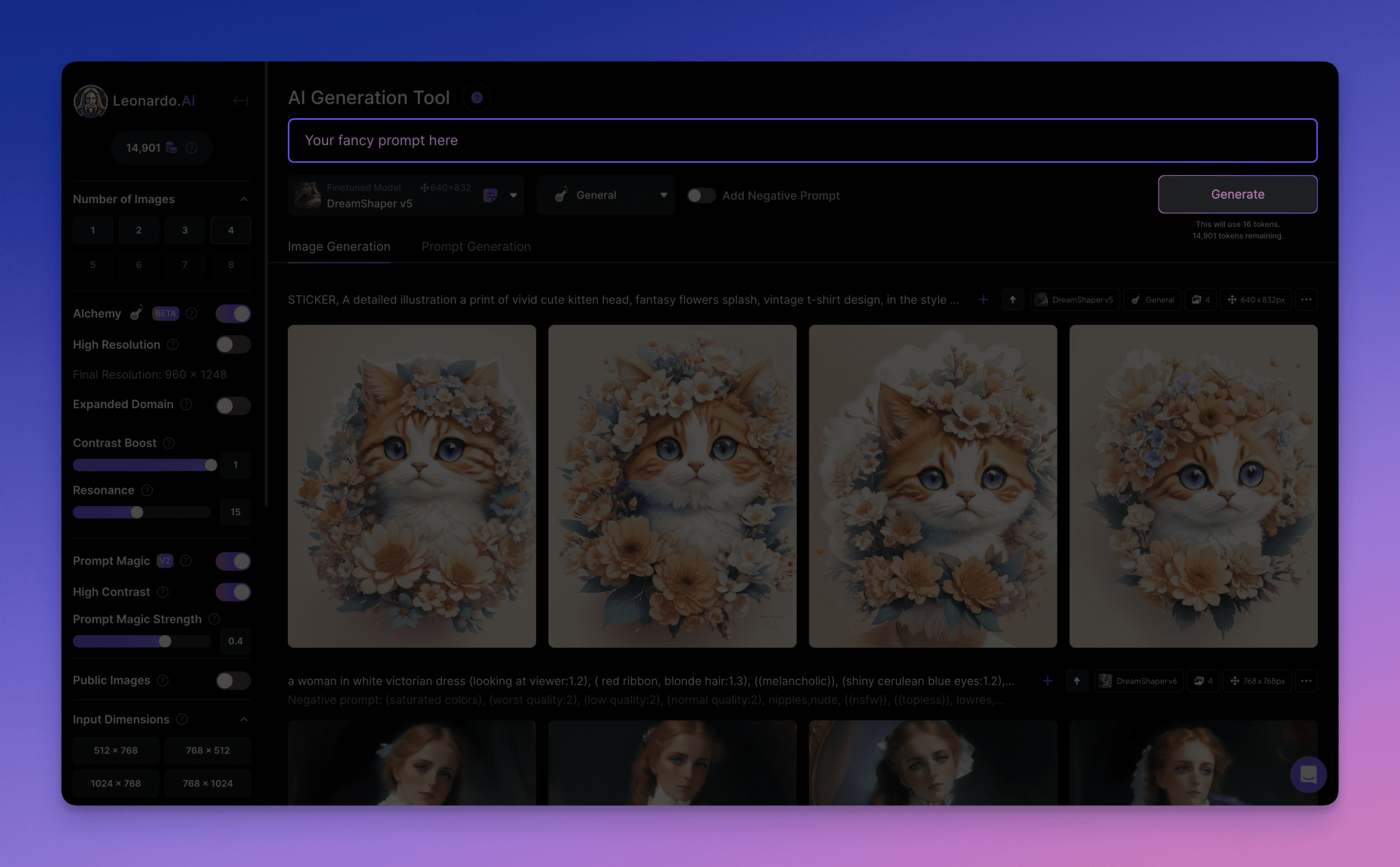

Parcourir le plugin Google Forms d'AI

Ce plugin offre des fonctionnalités supplémentaires pour Google Forms :

- Le robot peut être exécuté directement dans Google Forms en mettant en évidence l'ensemble des paramètres d'entrée et en cliquant sur le bouton.

- Suppression automatique des anciennes données de Google Forms.

- Supprimez automatiquement les doublons dans Google Sheets.

11) Intégration de connecteurs (Zapier, Make, Pabbly)

En quelques clics de logiciel d'intégration tiers, ces méthodes d'intégration natives vous permettront de connecter Browse AI à plus de 5 000 autres applications :

- [ZapierFacile à utiliser, mais coûteux lorsqu'il est utilisé en grande quantité.

- [FaireLe [...] coûte moins cher, mais est plus compliqué à utiliser.

- [Pabbly Connect] Souvent utilisé par les utilisateurs qui ont acheté un contrat à vie payé une seule fois pour économiser de l'argent.

12) API & Webhooks

Si vous avez des développeurs de logiciels dans votre équipe, assurez-vous de profiter des API et des webhooks, qui vous permettent de faire presque tout sur le panneau de contrôle (sauf créer de nouveaux bots) et d'avoir une interface programmatique avec les API et les webhooks disponibles publiquement.

Certaines startups ont conçu leur logiciel sur la base des API de Browse AI et ont externalisé toutes les opérations d'exploration de données, qui nécessitent une main-d'œuvre importante.

© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Articles connexes

Pas de commentaires...