Bonsai : un modèle de langage pondéré à trois valeurs adapté aux appareils périphériques

Introduction générale

Bonsai est un modèle de langue open source développé par deepgrove-ai avec une taille de paramètre de 500 millions, utilisant des poids ternaires. Il est basé sur l'architecture Llama et sur le modèle de la langue. Mistral Le classificateur est conçu avec une couche linéaire adaptée pour supporter des poids à trois valeurs. Le modèle a été entraîné principalement à l'aide des ensembles de données DCLM-Pro et Fineweb-Edu, qui totalisent moins de 5 milliards de jetons. Malgré la faible quantité de données d'entraînement, Bonsai fonctionne bien et est l'un des premiers modèles légers à triple valeur à atteindre des niveaux compétitifs. Les utilisateurs peuvent l'appeler via la bibliothèque Huggingface Transformers. Le code du projet est disponible publiquement sur GitHub pour les développeurs qui explorent des modèles d'IA efficaces.

Liste des fonctions

- Léger et efficaceLe modèle est petit, rapide et adapté aux appareils à faibles ressources.

- génération de langage naturelLes cours d'anglais pour adultes et les cours d'anglais pour adultes : Soutien à la production de textes fluides qui peuvent être utilisés pour le dialogue, les questions-réponses et d'autres tâches.

- accès libreLe code complet est disponible sur GitHub, ce qui permet aux utilisateurs de le télécharger, de le modifier et de l'optimiser.

- Compatible avec HuggingfaceLes fonctionnalités de l'application sont les suivantes : intégration transparente dans la bibliothèque Transformers pour un chargement et un déploiement faciles.

- excellente performanceLes performances sont comparables à celles de modèles comparables avec une faible quantité de données d'apprentissage.

Utiliser l'aide

Processus d'installation

Pour utiliser Bonsai, vous devez d'abord configurer l'environnement d'exécution. Voici les étapes détaillées :

- Vérification de l'environnement Python

Assurez-vous que Python 3.8 ou plus est installé sur votre ordinateur. Tapez dans le terminal :

python --version

Si vous ne l'avez pas, vous pouvez le télécharger sur le site web de Python.

- Installation de la bibliothèque des transformateurs

Bonsai s'appuie sur la bibliothèque Transformers de Huggingface. Exécutez-le dans un terminal :

pip install transformers

Après l'installation, utilisez le pip show transformers Confirmer la version.

- Télécharger les modèles de bonsaïs

Le modèle est hébergé sur Huggingface. Il est recommandé de les charger automatiquement via un code (voir ci-dessous), ou ils peuvent être téléchargés manuellement. - Installer les dépendances optionnelles

Si un réglage fin ou une accélération est nécessaire, installez le logicieltorchrépondre en chantantdatasets: :

pip install torch datasets

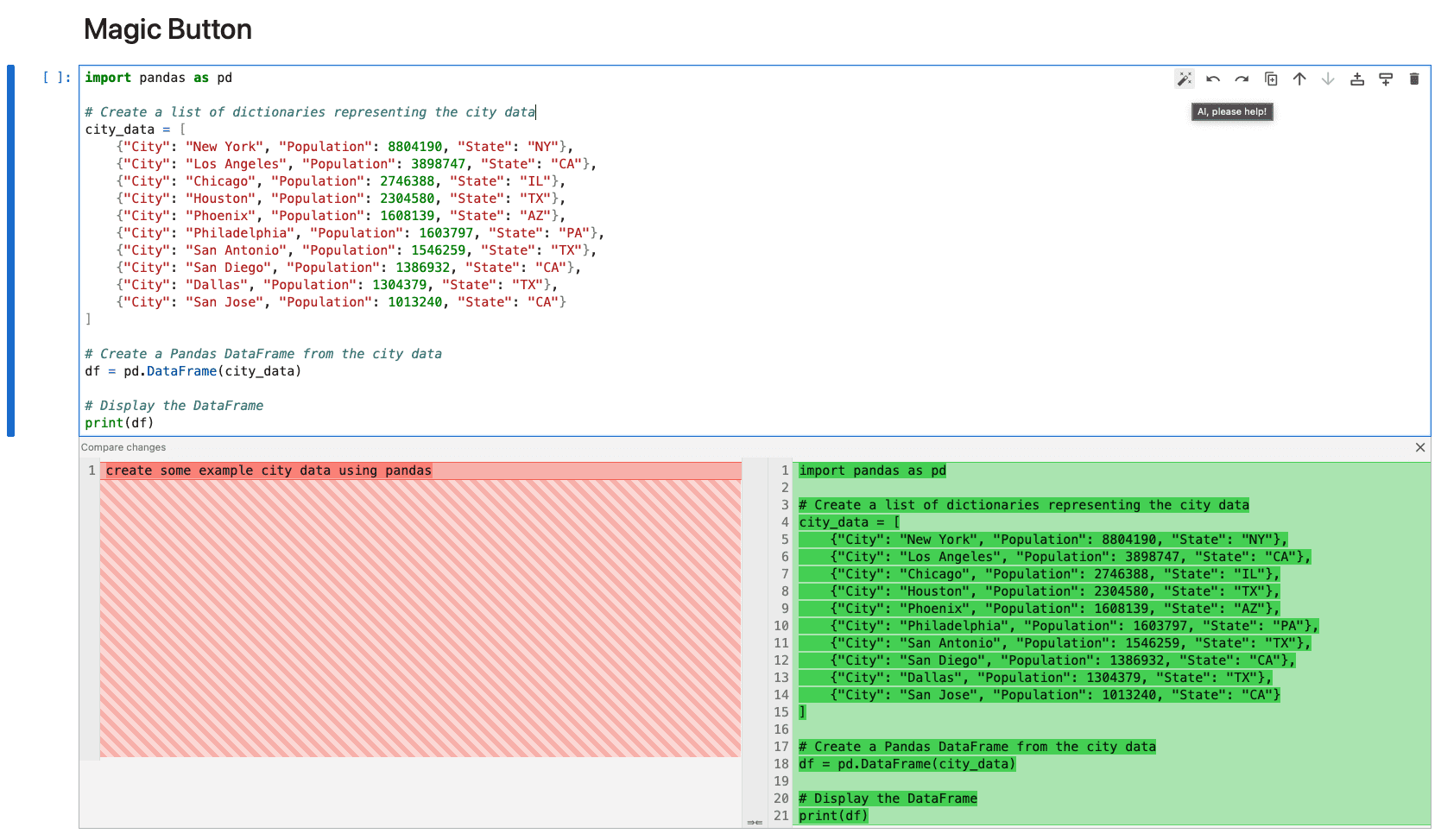

Comment l'utiliser

Bonsai est appelé à l'aide d'un script Python. Voici les étapes de base :

Modèles de chargement et séparateurs

Exécutez le code suivant en Python :

from transformers import AutoTokenizer, AutoModelForCausalLM

tokenizer = AutoTokenizer.from_pretrained("deepgrove/Bonsai", trust_remote_code=True)

model = AutoModelForCausalLM.from_pretrained("deepgrove/Bonsai", trust_remote_code=True)

Générer du texte

Saisissez du texte et générez des résultats :

text = "中国的首都是哪里?"

inputs = tokenizer(text, return_tensors="pt")

outputs = model.generate(**inputs, max_length=100)

result = tokenizer.decode(outputs[0], skip_special_tokens=True)

print(result)

Le résultat pourrait être "La capitale de la Chine est Pékin". .

Paramètres de réglage

Les paramètres de génération peuvent être modifiés, par exemple :

outputs = model.generate(**inputs, max_length=50, temperature=0.7)

max_length: Définit la longueur de la sortie.temperature: Contrôle le caractère aléatoire de la sortie, plus la valeur est petite, plus la sortie est stable.

Fonction en vedette Fonctionnement

fonctionnement efficace

La pondération à trois valeurs de Bonsai lui permet de fonctionner avec une précision de 16 bits. Il peut être accéléré automatiquement si un GPU est disponible :

import torch

print(torch.cuda.is_available()) # 返回 True 表示 GPU 可用

Le GPU augmentera considérablement les performances, mais le CPU fonctionnera parfaitement.

Évaluation des performances

Bonsai obtient de bons résultats dans plusieurs tests de référence. Voici les chiffres officiels :

| modélisation | ARC-c | ARC-e | HS. | OBQA | PiQA | Wino. | MMLU | score moyen |

|---|---|---|---|---|---|---|---|---|

| MobiLlama 0.5B | 26.62 | 46.68 | 51.66 | 30.00 | 71.65 | 54.50 | 28.61 | 44.25 |

| Qwen 2 0.5B | 28.84 | 50.29 | 49.12 | 33.00 | 69.26 | 56.99 | 31.78 | 45.61 |

| MobileLLM 600M | 29.01 | 56.65 | 55.35 | 34.00 | 71.65 | 59.75 | 31.40 | 48.13 |

| Qwen 2.5 0.5B | 32.25 | 58.29 | 52.18 | 35.40 | 69.91 | 56.12 | 33.40 | 48.22 |

| Bonsaï | 33.36 | 57.95 | 48.04 | 34.00 | 70.24 | 54.85 | 30.28 | 46.96 |

| Ces tests, qui incluent ARC, OBQA, MMLU, et d'autres, montrent que Bonsai se classe parmi les meilleurs modèles légers. |

Affiner le modèle

Bonsai n'est pas adapté aux tâches de génération générales. Il peut être affiné s'il doit être optimisé pour des utilisations spécifiques (par exemple, les quiz) :

- Préparer les données : utiliser un fichier texte ou

datasetsChargement de la bibliothèque. - Paramètres de configuration : avec

TrainingArgumentsLe cadre. - Modèles de formation :

from transformers import Trainer, TrainingArguments

training_args = TrainingArguments(

output_dir="./bonsai_finetuned",

num_train_epochs=3,

per_device_train_batch_size=4

)

trainer = Trainer(model=model, args=training_args, train_dataset=your_dataset)

trainer.train()

Pour plus de détails, voir Documentation sur le visage de l'étreinte.

mise en garde

- Limites de précision: Actuellement, seules les opérations de précision sur 16 bits sont prises en charge, et l'équipe est en train de développer la prise en charge de la précision mixte.

- Accord non commandéLe modèle par défaut n'est pas adapté à une utilisation directe dans des tâches de commandement complexes et doit être affiné.

- exigences en matière de matérielLes CPU normaux peuvent l'exécuter, les GPU ne sont pas nécessaires mais recommandés.

scénario d'application

- Aides pédagogiques

Les bonsaïs peuvent répondre à des questions de connaissances de base telles que "Quelle est la capitale de la France ? Bonsai peut répondre à des questions de connaissances de base telles que "Où se trouve la capitale de la France ? Les réponses sont générées rapidement après la saisie et sont adaptées à l'apprentissage. - Applications des dispositifs de périphérie

Le modèle est léger et peut être déployé sur des téléphones mobiles ou des appareils intégrés pour le traitement localisé des langues. - Études de modélisation

Les chercheurs peuvent l'utiliser pour tester le potentiel des techniques de pondération à trois valeurs et explorer la conception de modèles d'IA efficaces.

QA

- Quels sont les principaux atouts de Bonsai ?

Il utilise une technique de pondération à trois valeurs pour obtenir un poids léger et une efficacité élevée, avec moins de données d'apprentissage mais une performance élevée, adaptée aux scénarios à ressources limitées. - Besoin d'un GPU ?

Le CPU n'est pas nécessaire pour l'exécuter, mais le GPU l'accélère. - Peut-il être utilisé directement pour le dialogue ?

Le modèle par défaut ne nécessite pas de réglage et il est recommandé de l'affiner avant de l'utiliser pour une tâche spécifique.

© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Articles connexes

Pas de commentaires...