Bambo : un cadre léger et flexible pour les organismes intelligents, avec une configuration simple des rôles et des outils pour gérer de multiples charges de travail.

Introduction générale

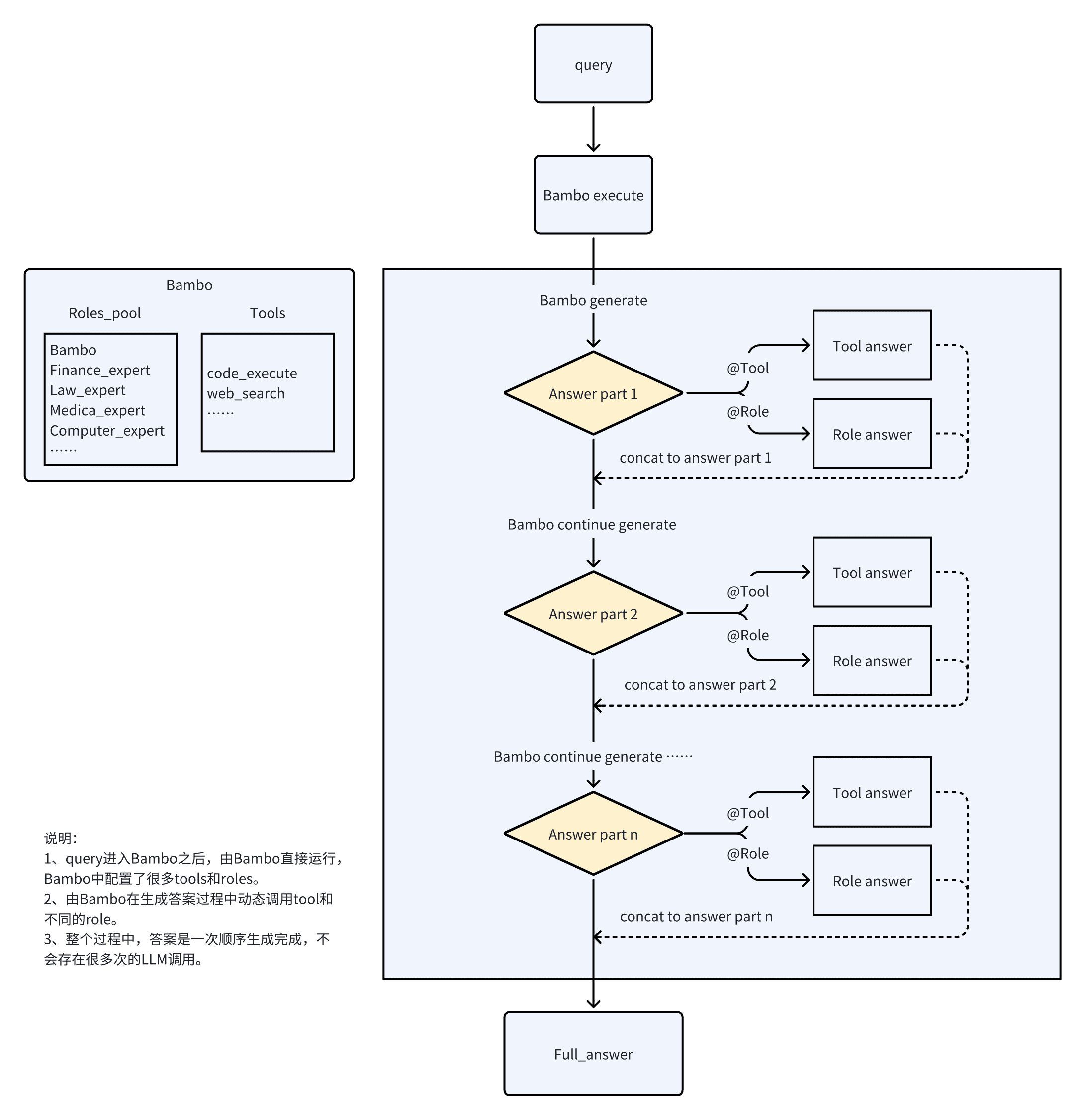

Bambo est un nouveau type de proxy qui est plus léger et plus flexible que les frameworks traditionnels et qui est capable de gérer un large éventail de tâches de charge. Bambo atteint une fonctionnalité de proxy efficace en définissant tous les outils dans le catalogue d'outils et en utilisant des fonctions personnalisées asynchrones. Les utilisateurs peuvent définir le modèle et les paramètres du client qu'ils doivent appeler dans le fichier llm_client.py, puis créer leurs propres scripts de test dans le dossier examples.Bambo a pour objectif de fournir une solution de proxy efficace et flexible pour une variété de scénarios d'application.

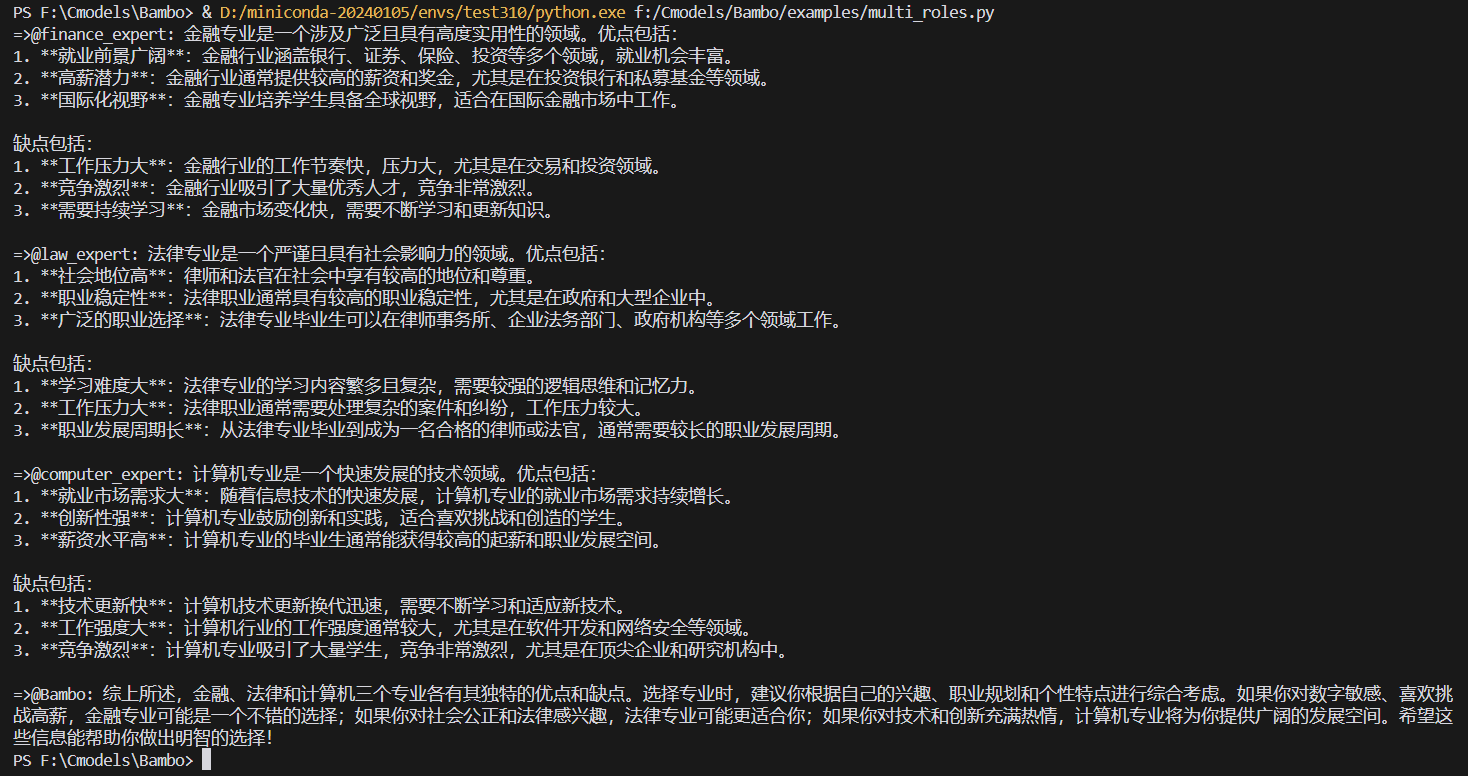

Cadre traditionnel de l'agent : chaque rôle est un agent indépendant, un "superviseur" est nécessaire pour coordonner le travail, le changement de rôle doit passer par un processus de transfert complexe, le nombre d'appels LLM est relativement élevé, ce qui se traduit par une vitesse de réponse et une fluidité médiocres.

Bambo résout ce problème par un jeu de rôle. Il n'y a pas de TTS dans l'effet, vous pouvez donc ajouter le code correspondant dans le script de test si nécessaire.

Liste des fonctions

- Cadre de proxy léger et flexible

- Manipuler une variété de charges

- Prise en charge des fonctions personnalisées asynchrones

- Définir et invoquer les paramètres requis du modèle et du client

- Création et exécution de scripts de test

- Prise en charge de scénarios à plusieurs caractères

- Fonctions d'exécution et d'analyse du code

Utiliser l'aide

Processus d'installation

- Entrepôt de clonage :

git clone https://github.com/LB-Young/Bambo.git cd Bambo - Installer la dépendance :

pip install -r requirements.txt - Installez PyTorch manuellement (si nécessaire) :

pip3 install torch torchvision torchaudio

Mise en place et configuration

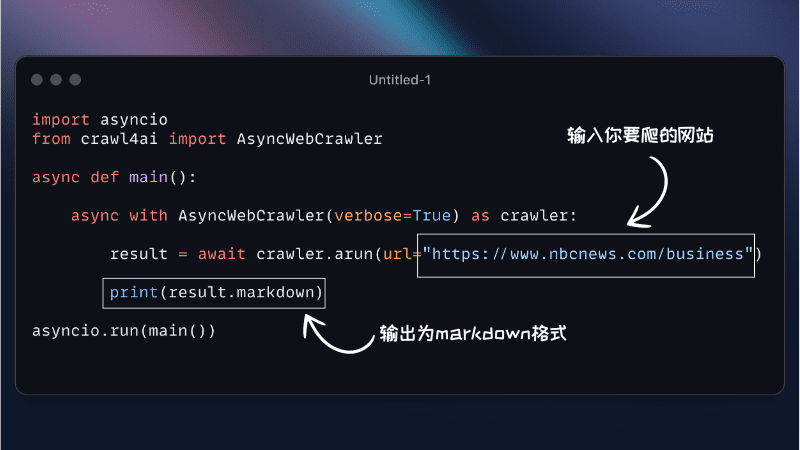

- Définissez tous les outils dans le catalogue d'outils et assurez-vous que les fonctions personnalisées sont asynchrones.

- Définissez les paramètres du modèle et du client pour les appels requis dans le fichier llm_client.py.

- Créez vos propres scripts de test dans le dossier des exemples, en définissant les rôles et les outils nécessaires.

- Initialiser l'objet Bambo et passer les paramètres requis :

from src.bambo import Bambo from src.llm_client import client, model from src.tools.code_execute import code_execute roles = { "finance_expert": "金融专家", "law_expert": "法律专家", "medical_expert": "医疗专家", "computer_expert": "计算机专家", } tools = {} bambo = Bambo(client=client, bambo_role=None, roles=roles, tools=tools, agents=None, model=model) query = "我是高考生,现在想要选专业,但是不知道选什么专业。请你介绍一下金融、法律和计算机三个专业分别有什么优点和缺点。" async for item in bambo.execute(query=query): print(item, end="", flush=True)

Utilisation de Bambo

- Lancez l'interface Bambo :

python examples/notebooklm.py - ou exécuter l'agent en arrière-plan :

nohup python examples/multi_roles.py &> multi_roles.log & - Le menu interactif vous guidera à travers les options suivantes :

- Création/mise à jour de l'ensemble de données d'entraînement

- Modèles de formation

- Agents d'exécution

- Exécuter un flux de travail complet

- annuler

configurer

Modifiez config.py pour le personnaliser :

- Sélection du modèle

- Entraînement des hyperparamètres

- Paramètres du proxy

- Modèles réactifs

- Filtrage des tâches

Bambo offre plusieurs façons de filtrer les tâches traitées :

- Étiquetage (automatique)

- Liste noire (manuelle)

© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Articles connexes

Pas de commentaires...