Archon : un cadre de développement pour la construction et l'optimisation autonomes d'intelligences IA

Introduction générale

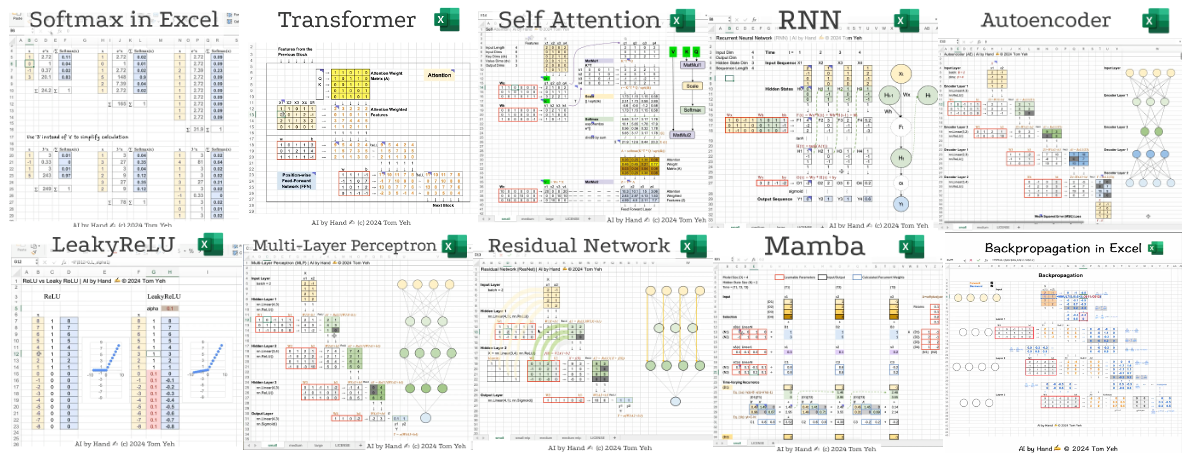

Archon est le premier projet "Agenteer" au monde créé par le développeur Cole Medin (nom d'utilisateur GitHub coleam00). Il s'agit d'un cadre open source axé sur la construction, l'optimisation et l'itération autonomes d'intelligences IA. Il s'agit d'un framework open source qui se concentre sur la construction autonome et l'itération d'intelligences IA. Archon, actuellement à la version V4, utilise une interface utilisateur Streamlit entièrement optimisée pour fournir une interface de gestion intuitive. Développé en Python, le projet intègre des technologies telles que Pydantic AI, LangGraph et Supabase pour évoluer de la simple génération d'intelligence à la collaboration complexe de flux de travail.Archon démontre les trois principes du développement moderne de l'IA : le raisonnement intelligent, l'intégration des connaissances et l'architecture extensible par la planification, les boucles de rétroaction et l'intégration des connaissances du domaine.

Archon est ce que j'aime appeler un "parasite" pour d'autres cadres de développement de l'intelligence. Archon peut construire et optimiser d'autres cadres de développement de l'intelligence, mais il est aussi une intelligence lui-même.

Liste des fonctions

- Génération automatique d'intelligencesLes codes de l'intelligence artificielle : Générer des codes de l'intelligence artificielle personnalisés en fonction des exigences de l'utilisateur.

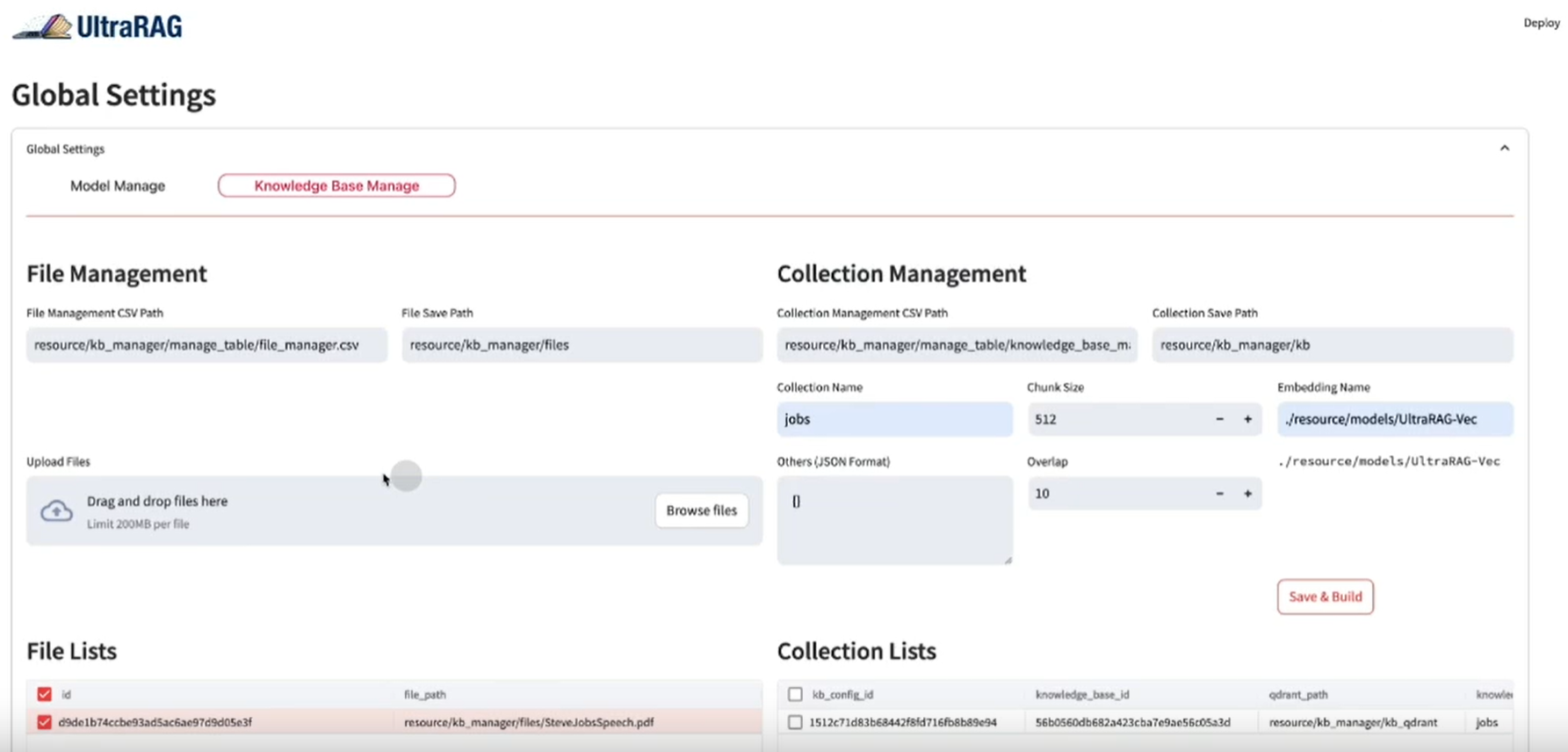

- Exploration et indexation de documentsLes services d'analyse de documents tels que Pydantic AI, la génération d'encastrements vectoriels et leur stockage dans une base de données.

- Soutien au système RAGLes techniques de génération par la recherche permettent de fournir des suggestions et des optimisations de code précises.

- Gestion de l'interface utilisateur StreamlitLes services d'aide à la décision : Configurer les variables d'environnement, les bases de données et les services de corps intelligents à l'aide d'une interface visuelle.

- collaboration multi-intelligence: Sur la base de LangGraph Permettre des flux de travail coordonnés pour le raisonnement, le codage et l'acheminement des tâches.

- Compatibilité locale et dans le nuageSupport des API OpenAI, Anthropic, OpenRouter ou natives Ollama Modèles.

- Déploiement conteneurisé Docker: Il s'agit du conteneur principal et de la MCP des conteneurs pour garantir que les environnements de production sont prêts à être utilisés dès leur sortie de l'emballage.

- Intégration MCPSupport pour l'intégration avec les IDE AI (par exemple Windsurf, Cursor) pour gérer les fichiers et les dépendances.

- Soutien communautaireFournir une plateforme de communication pour les utilisateurs par le biais du forum oTTomator Think Tank.

Utiliser l'aide

Archon est un framework open source riche en fonctionnalités conçu pour aider les utilisateurs à développer et gérer rapidement des intelligences IA. Voici un guide d'installation et d'utilisation détaillé pour vous permettre de démarrer facilement.

Processus d'installation

Archon V4 supporte deux méthodes d'installation : Docker (recommandé) et une installation locale en Python. Voici les étapes à suivre :

Méthode 1 : Installation de Docker (recommandée)

- Préparation de l'environnement

- Assurez-vous que Docker et Git sont installés.

- Obtenir un compte Supabase (pour les bases de données vectorielles).

- Préparez la clé API OpenAI/Anthropic/OpenRouter, ou exécutez Ollama localement.

- entrepôt de clones

S'exécute dans le terminal :git clone https://github.com/coleam00/archon.git cd archon

- Exécution de scripts Docker

Exécutez la commande suivante pour construire et démarrer le conteneur :python run_docker.py- Le script construit automatiquement deux conteneurs : le conteneur Archon principal (qui exécute l'interface utilisateur Streamlit et les services Graph) et le conteneur MCP (qui prend en charge l'intégration de l'IDE AI).

- s'il est présent

.envles variables d'environnement seront chargées automatiquement.

- interface d'accès

Ouvrez votre navigateur et visitezhttp://localhost:8501Pour ce faire, accédez à l'interface utilisateur Streamlit.

Méthode 2 : Installation locale de Python

- Préparation de l'environnement

- Assurez-vous que Python 3.11+ est installé.

- Obtenir le compte Supabase et la clé API.

- entrepôt de clones

git clone https://github.com/coleam00/archon.git cd archon - Création d'un environnement virtuel et installation des dépendances

python -m venv venv source venv/bin/activate # Windows: venv\Scripts\activate pip install -r requirements.txt - Lancer l'interface utilisateur Streamlit

streamlit run streamlit_ui.py - interface d'accès

Ouvrez votre navigateur et visitezhttp://localhost:8501.

Configuration des variables d'environnement

La première fois que vous exécutez Docker ou une installation locale, vous devez configurer des variables d'environnement. Créez une variable d'environnement .env avec des exemples de contenu :

OPENAI_API_KEY=your_openai_api_key

SUPABASE_URL=your_supabase_url

SUPABASE_SERVICE_KEY=your_supabase_service_key

PRIMARY_MODEL=gpt-4o-mini

REASONER_MODEL=o3-mini

Ces informations sont disponibles sur le tableau de bord de Supabase et auprès du fournisseur d'API.

Fonction Opération Déroulement

Une fois installé, Streamlit UI propose cinq modules fonctionnels principaux qui vous guident pas à pas dans l'installation et l'utilisation.

1. l'environnement

- procédure: :

- Allez dans l'onglet "Environnement".

- Saisissez la clé API (par exemple, OpenAI ou OpenRouter) et les paramètres du modèle (par exemple.

gpt-4o-mini). - Cliquez sur "Sauvegarder" et la configuration sera enregistrée dans le fichier

env_vars.json.

- prendre noteSi vous utilisez Ollama en local, vous devez vous assurer que le service s'exécute sur l'ordinateur de l'utilisateur.

localhost:11434Le streaming d'interface utilisateur n'est pris en charge que par OpenAI.

2) Paramètres de la base de données (Base de données)

- procédure: :

- Allez dans l'onglet "Base de données".

- Saisissez l'URL de Supabase et la clé de service.

- Cliquez sur "Initialiser la base de données", le système crée automatiquement la base de données.

site_pagesTableau. - Vérifiez l'état de la connexion pour confirmer le succès.

- structure du tableau: :

CREATE TABLE site_pages ( id UUID PRIMARY KEY DEFAULT uuid_generate_v4(), url TEXT, chunk_number INTEGER, title TEXT, summary TEXT, content TEXT, metadata JSONB, embedding VECTOR(1536) );

3. l'exploration et l'indexation de la documentation (Documentation)

- procédure: :

- Allez dans l'onglet "Documentation".

- Saisissez l'URL du document cible (par exemple, le document Pydantic AI).

- Cliquez sur "Start Crawling" et le système fragmente le document, génère un embed et le stocke dans Supabase.

- Vous pouvez visualiser la progression de l'indexation dans l'interface utilisateur lorsque vous avez terminé.

- utiliser: pour RAG Le système fournit la base de connaissances.

4) Service de l'organisme intelligent (service d'agent)

- procédure: :

- Allez dans l'onglet "Agent Service".

- Cliquez sur Démarrer le service pour exécuter le flux de travail LangGraph.

- Contrôler l'état du service à l'aide des journaux.

- FonctionnalitéLes tâches de l'intelligence : coordonner le raisonnement, le codage et l'acheminement des tâches pour garantir le bon fonctionnement de la logique de base de la génération des intelligences.

5. création d'un corps intelligent (Chat)

- procédure: :

- Allez dans l'onglet "Chat".

- Saisissez une exigence, telle que "Générer une intelligence qui analyse les fichiers JSON".

- Le système combine les connaissances récupérées par le système RAG pour générer des codes et les afficher.

- Copiez le code pour l'exécuter localement ou le déployer via un service.

- exemple typique: :

Entrée : "Générer un corps intelligent qui interroge la météo en temps réel".

Exemple de sortie :from pydantic_ai import Agent, OpenAIModel agent = Agent(OpenAIModel("gpt-4o-mini"), system_prompt="查询实时天气") result = agent.run("获取北京今天的天气") print(result.data)

Facultatif : Configuration MCP

- procédure: :

- Allez dans l'onglet "MCP".

- Configurer l'intégration avec un IDE d'IA tel que Cursor.

- Démarrez le conteneur MCP et connectez-vous au service Graph.

- utiliserSupport pour la création automatisée de fichiers et la gestion des dépendances dans l'IDE pour le code smartbody.

exemple d'utilisation

Supposons que vous souhaitiez développer une "Log Analysis Intelligence" :

- Dans Chat, tapez : "Generate a Pydantic AI intelligence that parses Nginx logs".

- Archon récupère la documentation pertinente et génère le code :

from pydantic_ai import Agent, OpenAIModel

agent = Agent(OpenAIModel("gpt-4o-mini"), system_prompt="解析Nginx日志")

result = agent.run("分析access.log并提取IP地址")

print(result.data)

- Enregistrez le code localement et veillez à configurer la clé API avant de l'exécuter.

mise en garde

- Compatibilité des modèles: Seule OpenAI prend en charge la sortie en continu de l'interface utilisateur Streamlit, les autres modèles (par exemple Ollama) ne prennent en charge que le non-streaming.

- exigences en matière de réseauLes réseaux : L'exploration de documents et l'appel d'API nécessitent un réseau stable.

- ajuster les composants pendant les essaisSi quelque chose ne va pas, vérifiez le journal de l'interface utilisateur ou la sortie du terminal.

Grâce à ces étapes, vous pouvez tirer pleinement parti de la capacité d'Archon à générer et à gérer rapidement des intelligences IA, à la fois pour l'apprentissage et pour le développement réel.

© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Articles connexes

Pas de commentaires...