Résultats de l'ARC-AGI-2 révélés : Waterloo pour tous Capacité de raisonnement du modèle d'IA

Il est essentiel de disposer de repères pour mesurer les progrès réalisés dans le domaine de l'intelligence artificielle à usage général (AGI). Des repères efficaces révèlent les capacités, et des repères excellents sont plus susceptibles d'inspirer les orientations de la recherche.La Fondation du prix ARC s'est engagée à fournir une plateforme pour le développement et la diffusion de l'AGI par le biais de ses ARC-AGI La série de critères de référence joue un tel rôle, en orientant les efforts de recherche vers une véritable intelligence polyvalente. Les derniers ARC-AGI-2 Les critères de référence et les résultats préliminaires des tests sont un signal d'alarme pour les questions actuelles de limites et d'efficacité des capacités de l'IA.

ARC-AGI-1 Depuis son lancement en 2019, il a joué un rôle unique dans le suivi des progrès de l'AGI, en aidant à identifier le moment où l'IA commence à dépasser la simple mémoire des formes. Par la suite ARC Prize 2024 Le concours a également attiré un grand nombre de chercheurs qui ont exploré de nouvelles idées pour l'adaptation au temps de test.

Cependant, la route vers l'AGI est encore longue. Les progrès actuels, tels que OpenAI (utilisé comme expression nominale) o3 Ces systèmes ne représentent peut-être qu'une avancée limitée dans le domaine de l'"intelligence fluide". Ces systèmes sont non seulement inefficaces, mais ils nécessitent également une supervision humaine importante. Il est clair qu'il faut davantage d'innovation à la source pour réaliser l'AGI.

Un nouveau défi : ARC-AGI-2, conçu pour révéler les faiblesses de l'IA

À cette fin, la Fondation du prix ARC vient de lancer l'initiative ARC-AGI-2 Critères de référence. Il a été conçu avec un objectif clair : être significativement plus difficile pour l'IA (en particulier les systèmes de raisonnement) tout en conservant une relative facilité d'utilisation pour les humains. Il ne s'agit pas d'une simple augmentation de la difficulté, mais d'un défi ciblé aux obstacles que les méthodes d'IA actuelles peinent à surmonter.

Philosophie de conception : se concentrer sur le fossé de l'intelligence Là où les gens sont faciles et l'IA est difficile

Contrairement à de nombreux autres critères d'évaluation de l'IA qui visent des capacités surhumaines, leARC-AGI Se concentrer sur les tâches qui sont relativement faciles pour les humains, mais extrêmement difficiles pour l'IA actuelle. Cette stratégie vise à révéler les lacunes dans les capacités qui ne peuvent pas être comblées par une simple "mise à l'échelle". Au cœur de l'intelligence générale se trouve la capacité de généraliser et d'appliquer efficacement des connaissances à partir d'une expérience limitée, ce qui constitue la faiblesse de l'IA actuelle.

ARC-AGI-2 : Difficulté croissante, confrontation directe avec les faiblesses du raisonnement de l'IA

ARC-AGI-2 existent ARC-AGI-1 La création de l'IA a considérablement accru les exigences en la matière, en mettant l'accent sur la combinaison d'une grande adaptabilité et d'une grande efficacité. En analysant les échecs de l'IA de pointe dans des tâches antérieures, l'équipe d'experts de la Commission européenne a pu constater que l'intelligence artificielle n'était pas toujours à la hauteur des attentes.ARC-AGI-2 Lancement de nouveaux défis qui testent la capacité à interpréter des symboles, à raisonner de manière combinatoire, à appliquer des règles contextuelles, etc. Ces tâches sont conçues pour forcer l'IA à aller au-delà de l'appariement superficiel de modèles et à atteindre des niveaux d'abstraction et de raisonnement plus profonds.

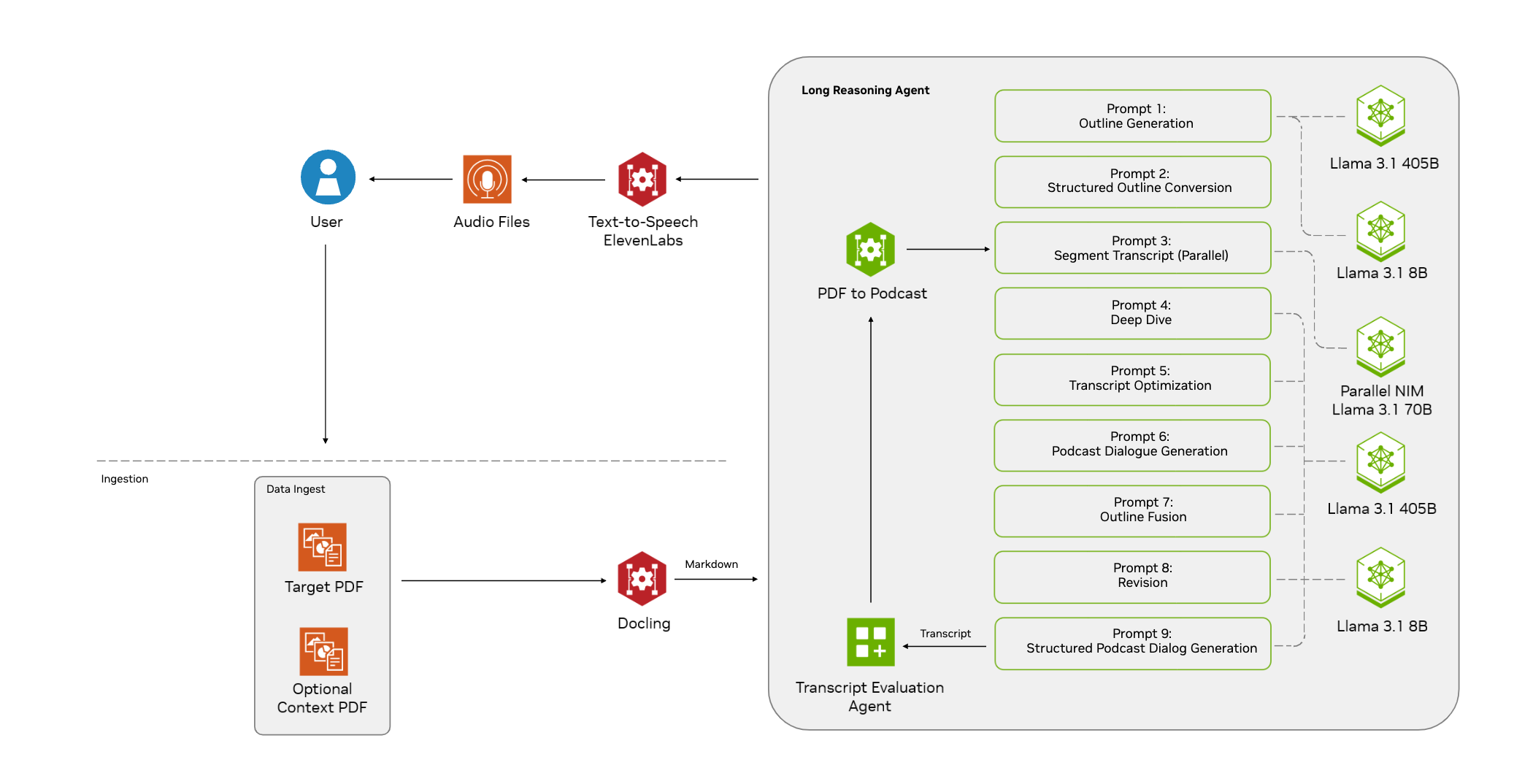

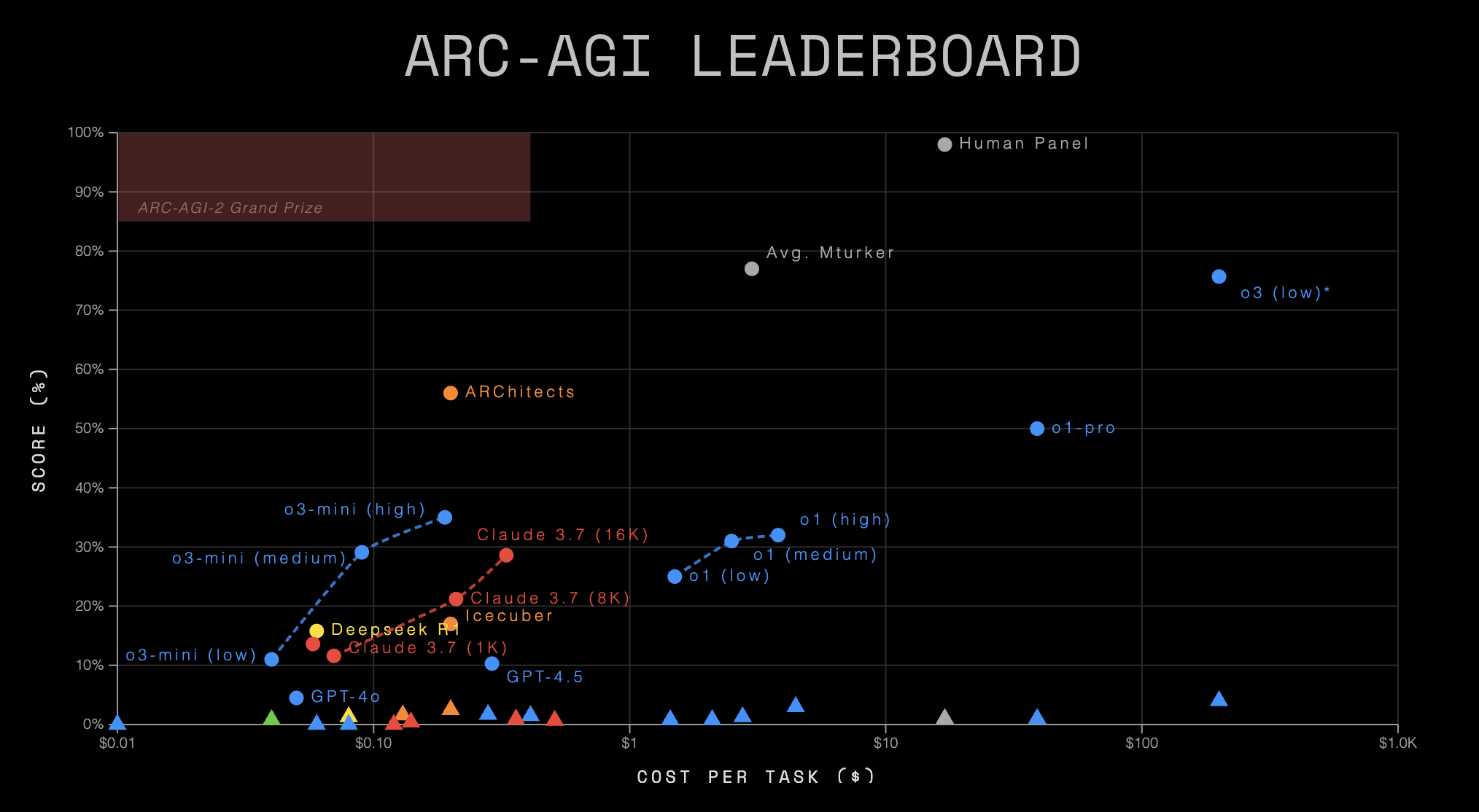

Bilan ARC-AGI-2 : un reflet sombre de la réalité

Dernière publication ARC-AGI Les données du classement dressent un tableau sombre des capacités actuelles de l'IA. Ces données confirment non seulement que ARC-AGI-2 et révèle plus profondément l'énorme fossé qui sépare l'IA de la puissance de raisonnement à usage général et de l'efficacité de l'IA.

Vue d'ensemble des données du classement

| Système d'IA | Organisation | Type de système | ARC-AGI-1 | ARC-AGI-2 | Coût/Tâche | Code / Papier |

|---|---|---|---|---|---|---|

| Panel humain | Humain | N/A | 98.0% | 100.0% | $17.00 | - |

| o3 (faible)* | OpenAI | CoT + Synthèse | 75.7% | 4.0% | $200.00 | 📄 |

| o1 (élevé) | OpenAI | CoT | 32.0% | 3.0% | $4.45 | 💻 |

| ARChitects | Prix ARC 2024 | Sur mesure | 56.0% | 2.5% | $0.200 | 📄💻 |

| o3-mini (moyen) | OpenAI | CoT | 29.1% | 1.7% | $0.280 | 💻 |

| Icecuber | Prix ARC 2024 | Sur mesure | 17.0% | 1.6% | $0.130 | 💻 |

| o3-mini (haut) | OpenAI | CoT | 35.0% | 1.5% | $0.410 | 💻 |

| Gémeaux 2.0 Flash | Google Société Internet | Base LLM | N/A | 1.3% | $0.004 | 💻 |

| o1 (moyen) | OpenAI | CoT | 31.0% | 1.3% | $2.76 | 💻 |

| Deepseek R1 | Deepseek | CoT | 15.8% | 1.3% | $0.080 | 💻 |

| Gemini-2.5-Pro-Exp-03-25 ** | Google Société Internet | CoT | 12.5% | 1.3% | N/A | 💻 |

| o1-pro | OpenAI | CoT + Synthèse | 50.0% | 1.0% | $39.00 | - |

| Claude 3.7 (8K) | Anthropique | CoT | 21.2% | 0.9% | $0.360 | 💻 |

| Gemini 1.5 Pro | Google Société Internet | Base LLM | N/A | 0.8% | $0.040 | 💻 |

| GPT-4.5 | OpenAI | Base LLM | 10.3% | 0.8% | $2.10 | 💻 |

| o1 (faible) | OpenAI | CoT | 25.0% | 0.8% | $1.44 | 💻 |

| Claude 3.7 (16K) | Anthropique | CoT | 28.6% | 0.7% | $0.510 | 💻 |

| Claude 3.7 (1K) | Anthropique | CoT | 11.6% | 0.4% | $0.140 | 💻 |

| Claude 3.7 | Anthropique | Base LLM | 13.6% | 0.0% | $0.120 | 💻 |

| GPT-4o | OpenAI | Base LLM | 4.5% | 0.0% | $0.080 | 💻 |

| GPT-4o-mini | OpenAI | Base LLM | N/A | 0.0% | $0.010 | 💻 |

| o3-mini (faible) | OpenAI | CoT | 11.0% | 0.0% | $0.060 | 💻 |

(Note : * indique des estimations préliminaires dans le tableau.* indique un modèle expérimental)

Insights : l'avertissement derrière les données

- Humains contre IA : un fossé insurmontable

Rien n'est plus frappant que le contraste saisissant entre les performances des humains et celles de l'IA. En effet, enARC-AGI-2Sur, l'équipe humaine a obtenu un score parfait de 100%, et le système d'IA le plus performant, leOpenAI(utilisé comme expression nominale)o3 (low)La note est de 4,0%. D'autres modèles bien connus, tels que leGemini 2.0 Flash,Deepseek R1etc., avec des scores avoisinant 1,3%. Il est encore plus alarmant de constater que des produits tels queClaude 3.7,GPT-4o,GPT-4o-miniCes grands modèles linguistiques de base (LLM de base), qui ont excellé dans d'autres domaines, ont été utilisés dans laARC-AGI-2Les scores du jeu sont passés directement à zéro. Cela révèle inexorablement que, bien qu'elle soit incroyablement capable d'accomplir des tâches spécifiques, l'IA reste fondamentalement inférieure à l'homme lorsqu'elle est confrontée à des problèmes nouveaux qui requièrent des capacités de raisonnement flexibles, abstraites et généralisées. - De l'AGI-1 à l'AGI-2 : l'effondrement des capacités de l'IA

Presque tous les systèmes d'IA qui ont participé au test, après avoir commencé par laARC-AGI-1transitionARC-AGI-2Les performances ont toutes chuté au bout d'un certain temps. Par exemple, leo3 (low)a chuté de 75,71 TP3T à 4,01 TP3T.o1-prod'environ 50% à 1,0%.ARChitectsde 56,01 TP3T à 2,51 TP3T. Ce phénomène général suggère fortement que lesARC-AGI-2Elle réussit à résoudre les "problèmes" des méthodologies d'IA actuelles, qu'elles soient basées sur CoT, Synthesis ou d'autres approches personnalisées, qui sont difficiles à traiter de manière efficace.ARC-AGI-2Le défi du raisonnement est représenté. - Type de système et efficacité : un coût élevé n'est pas synonyme d'intelligence élevée

Le classement révèle en outre le rôle des différents types de systèmes d'IA dans l'économie de la connaissance.ARC-AGI-2Différences de performances et graves problèmes d'efficacité sur le- CoT + Système de synthèse (

o3 (low),o1-pro) ont obtenu les scores d'IA relativement les plus élevés (4,0% et 1,0%), mais à un coût étonnamment élevé ($200 et $39 par tâche, respectivement). Cela suggère qu'un raisonnement complexe associé à des stratégies de recherche peut permettre d'"arracher" un peu de score, mais que cette méthode est extrêmement inefficace. - Système CoT pur Les résultats ont été mitigés, avec des scores généralement compris entre 1% et 3% et des coûts allant de quelques centimes à quelques dollars. Cela semble indiquer que le CoT seul n'est pas suffisant pour relever le défi.

- Base LLM (Large Language Model) (

GPT-4.5,Gemini 1.5 Pro,Claude 3.7,GPT-4o) a été une débâcle, avec des scores de 0% ou presque, ce qui est une forte réfutation de l'idée que "la taille fait tout", au moins dans le cas de laARC-AGICela est vrai pour l'aspect de l'intelligence fluide généralisée mesurée. - Systèmes personnalisés (

ARChitects,Icecuber) commeARC Prize 2024en obtenant des résultats comparables, voire légèrement meilleurs (2,5%, 1,6%) que d'autres systèmes d'IA à un coût très faible (~$0.1-$0.2 par tâche). Cela peut suggérer que des algorithmes ou des architectures légers et ciblés peuvent avoir plus de potentiel pour résoudre ce type de problèmes que de grands modèles à usage général, et souligne la valeur des concours ouverts et de l'innovation communautaire.

- CoT + Système de synthèse (

- Crise d'efficacité : l'intelligence ne peut pas se limiter à des scores

ARC PrizeL'inclusion du "coût/tâche" en tant que mesure clé dans les classements est significative. Les données montrent que même l'IA la plus performante (o3 (low)obtenir 4%), son coût par tâche ($200) est également plus de dix fois supérieur à celui des humains ($17 obtenir 100%). Alors que certains modèles à faible coût, tels queGemini 2.0 FlashLe contraste est saisissant avec l'IA, qui est soit très faible, soit coûteuse, soit les deux, même si son coût est très faible ($0,004) et qu'elle n'obtient qu'un score de 1,3%. L'intelligence ne consiste pas à obtenir la bonne réponse à tout prix ; l'efficacité est une propriété intrinsèque. Actuellement, l'IA estARC-AGI-2La courbe "coût-capacité" présentée ci-dessus révèle sans aucun doute une profonde "crise d'efficacité".

Composition de l'ensemble de données et détails du concours

ARC-AGI-2 Contient des ensembles de formation et d'évaluation calibrés, tels que pass@2 Mécanisme de notation. Les principaux changements comprennent une augmentation du nombre de tâches, la suppression des tâches vulnérables à la force brute, un étalonnage de la difficulté basé sur des tests humains et la conception de nouvelles tâches ciblées.

Lancement du concours ARC Prize 2025 : une récompense d'un million de dollars pour des idées nouvelles

Avec ce sombre bilan, laARC Prize 2025 Le concours s'est déroulé à Kaggle La plateforme est en ligne (26 mars - 3 novembre) avec un prix total de 1 million de dollars. L'environnement du concours limite l'utilisation de l'API et des ressources informatiques (~50 $/soumission) et impose aux gagnants de mettre leurs solutions en open source. Cela renforce encore le besoin d'efficacité et d'innovation.

Les principaux points du concours en 2025, par rapport à 2024, seront les suivantsJournal des modificationsNotamment : l'utilisation de ARC-AGI-2 un nouveau mécanisme de classement, des exigences renforcées en matière de sources ouvertes, le doublement des ressources informatiques et des mesures supplémentaires de lutte contre le surajustement.

Conclusion : un nouveau paradigme est nécessaire de toute urgence pour réaliser de véritables percées.

ARC-AGI-2 Les données du classement sont un miroir qui reflète clairement les limites de l'IA actuelle en termes de raisonnement généralisé et d'efficacité. Elles nous rappellent que la route vers l'AGI est loin d'être droite et qu'il ne suffira peut-être pas d'augmenter la taille des modèles ou les ressources informatiques pour franchir le gouffre qui se dresse devant nous. Les véritables percées peuvent nécessiter de nouvelles idées, des architectures différentes et peut-être même des innovateurs extérieurs aux grands laboratoires.ARC Prize 2025 C'est une telle plateforme qui appelle un nouveau paradigme.

© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Articles connexes

Pas de commentaires...