AnimeGamer : un outil open source pour générer des vidéos d'animation et des interactions entre personnages à l'aide de commandes linguistiques

Introduction générale

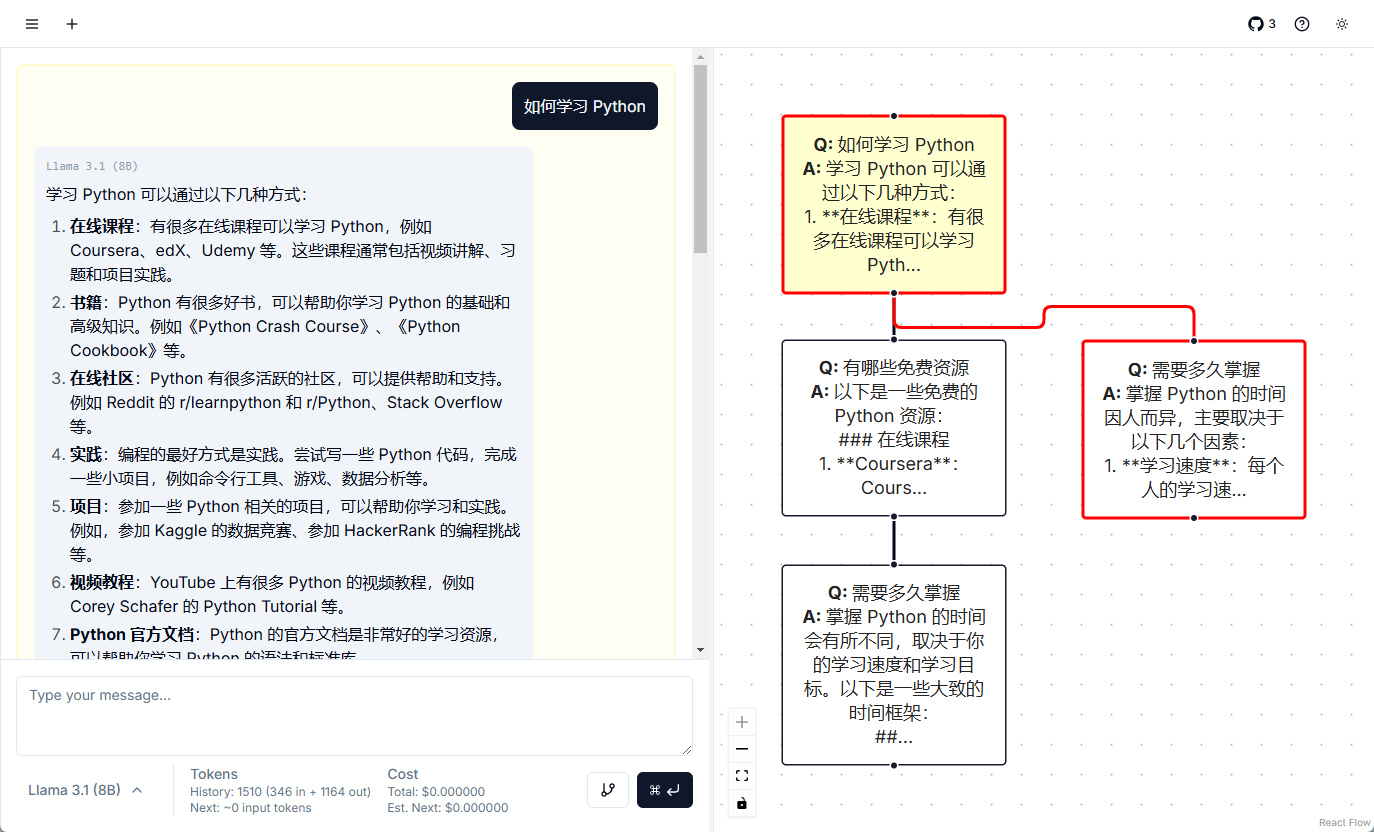

AnimeGamer est un outil open source du laboratoire ARC de Tencent. Les utilisateurs peuvent générer des vidéos d'anime à l'aide de commandes linguistiques simples, telles que "Sousuke roule dans une voiture violette", et faire interagir différents personnages d'anime, tels que Kiki de Magical Girl's Adventure et Pazu de Castle in the Sky. Il est basé sur le Multimodal Large Language Model (MLLM), qui crée automatiquement des segments animés cohérents tout en mettant à jour l'état du personnage, comme son endurance ou ses valeurs sociales. Le code et le modèle du projet sont gratuits et ouverts sur GitHub pour que les fans d'anime et les développeurs puissent les utiliser pour créer ou expérimenter.

Liste des fonctions

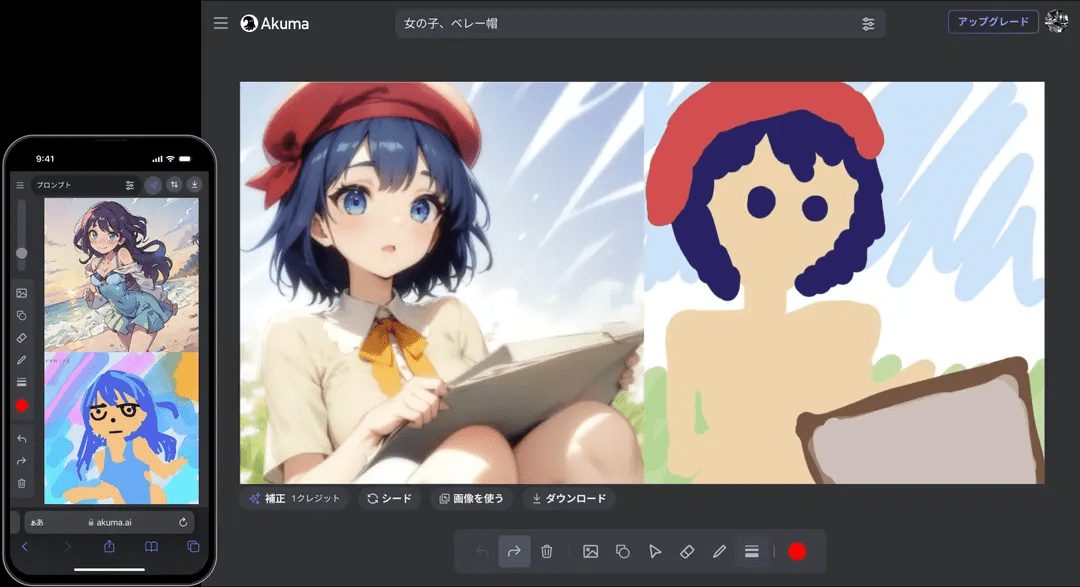

- Générer une vidéo d'animation : des commandes de langage d'entrée permettent de générer automatiquement des clips d'animation des mouvements des personnages et des scènes.

- Prise en charge de l'interaction des personnages : Permettez à différents personnages d'anime de se rencontrer et d'interagir pour créer de nouvelles histoires.

- Mise à jour du statut du personnage : enregistrement en temps réel des changements dans les valeurs du personnage telles que l'endurance, la sociabilité et le divertissement.

- Veiller à la cohérence du contenu : veiller à la cohérence des vidéos et des statuts en fonction des instructions historiques.

- Extensions open source : le code et les modèles complets sont fournis et les développeurs sont libres de les adapter.

Utiliser l'aide

AnimeGamer nécessite quelques bases de programmation, mais les étapes d'installation et d'utilisation ne sont pas difficiles. Voici des instructions détaillées pour vous aider à démarrer rapidement.

Processus d'installation

- Préparation de l'environnement

Vous aurez besoin d'un ordinateur équipé de Python, de préférence avec un GPU (au moins 24 Go de mémoire vidéo). Installez Git et Anaconda, puis tapez dans le terminal :

git clone https://github.com/TencentARC/AnimeGamer.git

cd AnimeGamer

Créer un environnement virtuel :

conda create -n animegamer python=3.10 -y

conda activate animegamer

- Installation des dépendances

Fonctionne dans un environnement virtuel :

pip install -r requirements.txt

Ceci installera les bibliothèques nécessaires telles que PyTorch.

- Télécharger les modèles

Télécharger les trois fichiers modèles sur./checkpointsDossier :

- Modèle AnimeGamer :Visage étreint.

- Modèle Mistral-7B :Visage étreint.

- Modèle 3D-VAE de CogvideoX : aller à

checkpointsdossier, exécuter :cd checkpoints wget https://cloud.tsinghua.edu.cn/f/fdba7608a49c463ba754/?dl=1 -O vae.zip unzip vae.zip

Assurez-vous que les modèles sont tous au bon endroit.

- test d'installation

Retournez dans le répertoire personnel et exécutez :

python inference_MLLM.py

L'absence d'erreur signifie que l'installation a réussi.

Comment utiliser les principales fonctionnalités

AnimeGamer génère des vidéos et des interactions avec les personnages à l'aide de commandes verbales. Voici comment cela fonctionne :

Générer des vidéos d'animation

- déplacer

- compilateur

./game_demodans un dossier tel queinstructions.txt. - Entrez une commande, par exemple "Sousuke roule dans une voiture violette dans la forêt".

- Exécutez MLLM pour générer une représentation :

python inference_MLLM.py --instruction "宗介在森林里开紫色车兜风"

- Décodage vers la vidéo :

python inference_Decoder.py

- La vidéo sera enregistrée dans le fichier

./outputsDossier.

- prendre note

Les instructions doivent être rédigées avec des personnages, des actions et des scènes clairs afin que la vidéo corresponde mieux aux attentes.

Interaction des personnages

- déplacer

- Entrez une commande interactive, telle que "Kiki apprend à Pazuzu à voler sur un balai".

- Suivez les étapes ci-dessus pour générer une vidéo interactive.

- spécificités

Permet de mélanger et d'interagir avec différents personnages d'anime pour créer des scènes uniques.

Mise à jour du statut des personnages

- déplacer

- Ajoutez une description d'état à la commande, par exemple "Sousuke est fatigué après avoir couru".

- être en mouvement

inference_MLLM.pyLe statut est mis à jour et devient./outputs/state.json.

- attirer l'attention sur qqch.

Le statut est automatiquement ajusté en fonction des instructions historiques afin de maintenir la cohérence.

Personnalisation et détails techniques

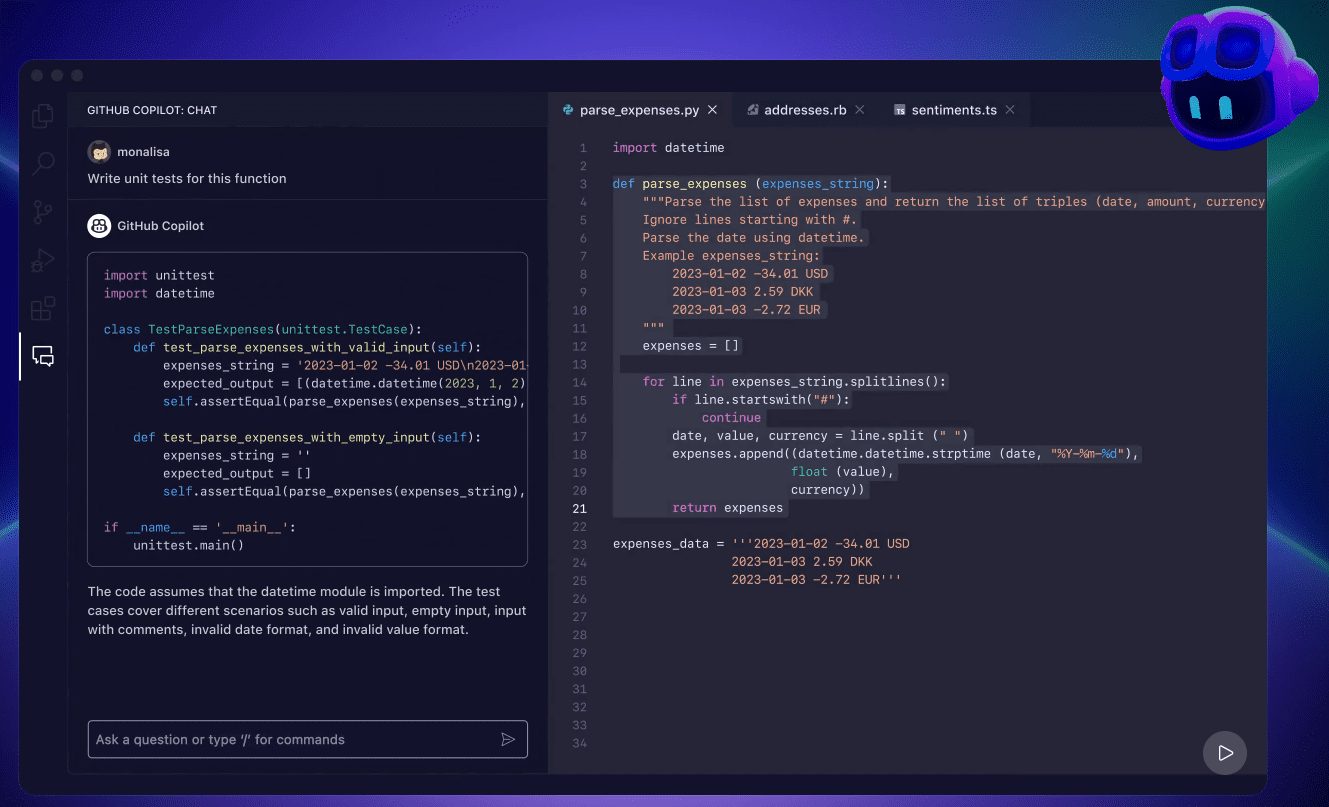

Vous souhaitez modifier une caractéristique ? Vous pouvez la modifier directement ./game_demo La technique d'AnimeGamer fonctionne en trois étapes :

- En traitant la représentation de l'action avec un encodeur, le décodeur de diffusion génère la vidéo.

- La MLLM prédit l'état suivant sur la base d'instructions historiques.

- Optimiser le décodeur pour améliorer la qualité vidéo.

Plus de détails sont disponibles dans le README.md de GitHub.

derniers développements

- 2 avril 2025 : publication des poids et papiers modèles pour The Witch's House et Goldfish Girl on the Cliff (arXiv).

- 1er avril 2025 : publication du code d'inférence.

- Projets futurs : lancement de démonstrations interactives Gradio et de codes de formation.

Problèmes courants résolus...

- Génération lente ? Confirmez que le GPU dispose de suffisamment de mémoire (24 Go) ou mettez à jour les pilotes.

- Le téléchargement du modèle a échoué ? Télécharger manuellement de Hugging Face.

- Signaler une erreur ? Vérifier la version de Python (3.10 requise) et les dépendances.

Avec ces étapes, vous serez en mesure de générer des vidéos d'anime et des interactions de personnages avec AnimeGamer.

scénario d'application

- création d'anime et de manga

Les fans d'anime peuvent l'utiliser pour créer des vidéos, par exemple en faisant interagir différents personnages, et les partager avec leurs amis. - Tests de jeu

Les développeurs peuvent l'utiliser pour créer rapidement des prototypes de contenu dynamique et tester des idées. - l'apprentissage en action

Les étudiants peuvent l'utiliser pour se familiariser avec la technologie multimodale et la génération de vidéos et acquérir une expérience pratique de l'IA.

QA

- Connaissances en programmation requises ?

Oui, des connaissances de base en Python sont nécessaires pour l'installation et le réglage, mais des commandes simples fonctionneront. - Quels sont les rôles soutenus ?

Prise en charge de Magical Girl's Home Companion et de Goldfish Hime on the Cliff dès à présent, avec une extension à venir. - Est-il disponible dans le commerce ?

Oui, mais en respectant le protocole Apache-2.0, voir GitHub pour plus de détails.

© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Articles connexes

Pas de commentaires...