Tableau de bord des agents : tableau de bord de l'évaluation des performances des agents d'IA

Introduction générale

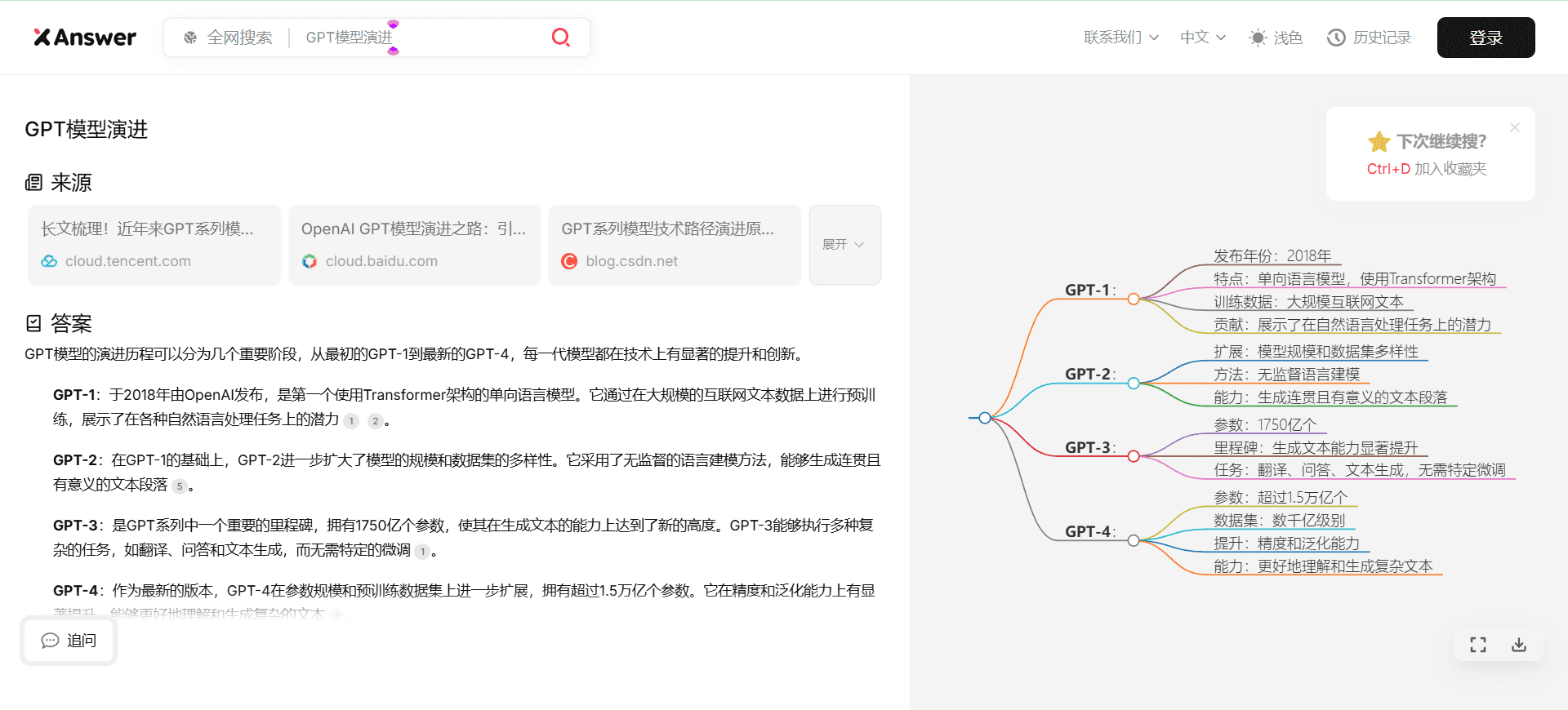

Agent Leaderboard est un outil en ligne axé sur l'évaluation des performances des agents d'IA lancé par Galileo AI sur la plateforme Hugging Face. Il teste 17 grands modèles de langage (LLM), couvrant des scénarios allant de simples appels d'API à des interactions complexes entre plusieurs outils, en combinant plusieurs ensembles de données faisant autorité (par exemple, BFCL, τ-bench, xLAM et ToolACE). Le site web vise à répondre à la question "Quelles sont les performances des agents d'IA dans des scénarios commerciaux réels ?" et à aider les développeurs et les entreprises à choisir le bon modèle pour leurs besoins. Le classement est mis à jour mensuellement et permet de visualiser les classements des modèles, les scores, les coûts et d'autres informations pour les équipes qui ont besoin de construire un système d'agent d'IA efficace. Les utilisateurs peuvent comparer visuellement les performances des modèles open source et privés. Consulter les rapports d'analyse :Hugging Face lance l'Agent Intelligence Body Rankings : Qui est le leader en matière d'appel d'outils ?

Liste des fonctions

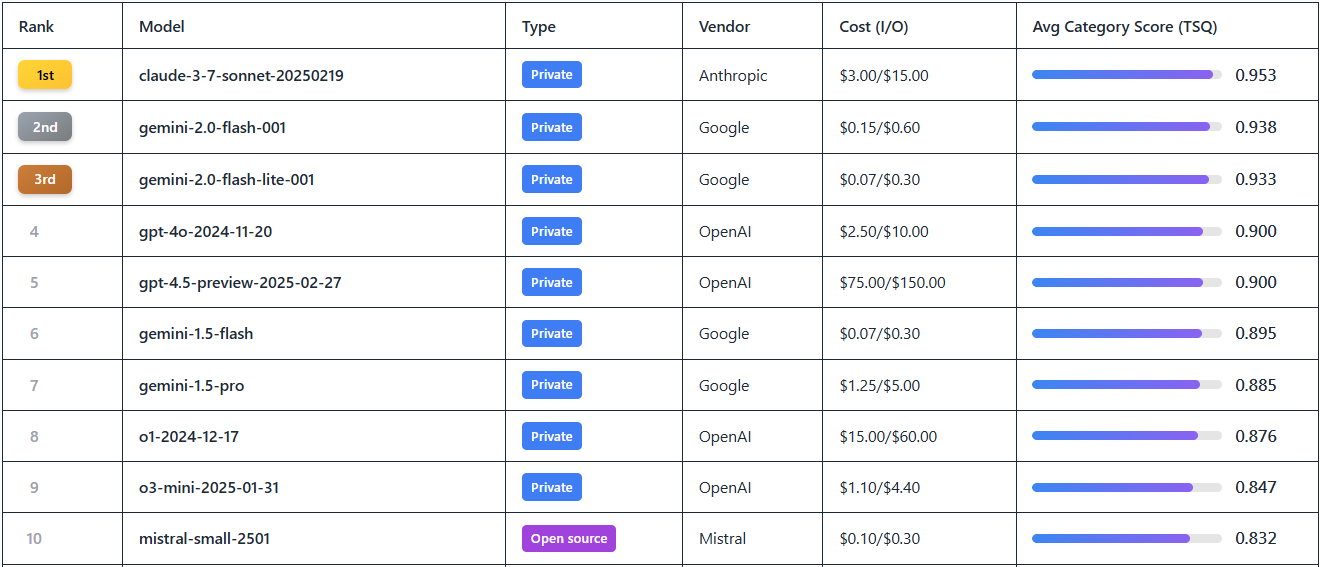

- Classement des performances des modèlesLe classement de 17 LLM de premier plan, tels que Gemini-2.0 Flash, GPT-4o, etc., est basé sur les scores de qualité de sélection des outils (Tool Selection Quality, TSQ).

- Données d'évaluation multidimensionnelleLe site Web de l'Agence européenne pour l'environnement (AEE) : Il fournit des résultats de tests multi-domaines couvrant plus de 390 scénarios tels que les mathématiques, le commerce de détail, l'aviation, les interactions API et bien d'autres encore.

- Coût et efficacité: : Démonstration par million pour chaque modèle jeton Coût (par exemple Gemini-2.0 Flash $0,15 vs GPT-4o $2,5) pour l'analyse prix/performance.

- Outils de filtrage et de visualisationLes modèles d'évaluation de la qualité de l'eau: : prise en charge du filtrage des modèles par fournisseur, statut open source/privé, score, etc. afin de localiser rapidement les informations requises.

- Accès libre aux ensembles de données: : Fournir des liens de téléchargement vers des ensembles de données de test pour que les développeurs puissent les étudier et les valider.

- Mécanisme de mise à jour dynamiqueLes données de performance sont mises à jour mensuellement afin de synchroniser les dernières versions des modèles et les données de performance.

Utiliser l'aide

Comment accéder et utiliser

Agent Leaderboard est un outil en ligne qui ne nécessite aucune installation et qui permet aux utilisateurs d'ouvrir simplement un navigateur, de visiter le site web de l'Agence. https://huggingface.co/spaces/galileo-ai/agent-leaderboard Prêt à l'emploi. Une fois la page chargée, vous êtes accueilli par un tableau de classement intuitif qui vous permet de parcourir toutes les données accessibles au public sans vous inscrire ni vous connecter. Pour un engagement plus approfondi (comme le téléchargement d'ensembles de données ou la formulation de suggestions), vous pouvez créer un compte Hugging Face.

flux de travail

- Parcourir les graphiques

- Lorsque vous ouvrez la page, la page d'accueil affiche par défaut les 17 premiers modèles de LLM.

- Les colonnes du tableau comprennent le rang, le modèle, le fournisseur, le score, le coût et le type (open source/privé). Score", "Coût" et "Type (Open Source/Privé)".

- Exemple : Le Gemini-2.0 Flash classé n°1 avec un score de 0,9+ et un coût de $0,15/million de tokens.

- Modèles de dépistage et de comparaison

- Cliquez sur les champs de filtrage en haut du tableau pour sélectionner le "fournisseur" (par exemple Google, OpenAI), le "type" (Open Source ou privé) ou la "fourchette de scores".

- Par exemple, en tapant "OpenAI", la page filtrera les modèles tels que GPT-4o, o1, et ainsi de suite, afin qu'il soit facile de comparer leurs performances.

- Pour connaître le rapport coût-efficacité, il suffit de trier par la colonne "Coût" pour trouver l'option la moins chère.

- Consulter les données d'évaluation détaillées

- En cliquant sur le nom d'un modèle (par exemple Gemini-1.5-Pro), vous obtiendrez un rapport de performance spécifique.

- Le rapport inclut les performances du modèle sur différents ensembles de données, par exemple le score du scénario de vente au détail dans τ-bench, le score d'interaction API dans ToolACE, etc.

- Les données sont présentées sous forme de graphiques afin de visualiser les forces et les faiblesses du modèle dans les tâches multi-outils ou les scénarios à long terme.

- Télécharger des jeux de données Open Source

- Au bas de la page, il y a un lien "Dataset", cliquez dessus pour aller à la page "Dataset".

https://huggingface.co/datasets/galileo-ai/agent-leaderboard. - Les utilisateurs peuvent télécharger des ensembles complets de données de test (par exemple, des banques de questions de mathématiques pour le BFCL, des données interdomaines pour le xLAM) à des fins d'analyse locale ou de développement secondaire.

- Si vous n'avez pas de compte, vous pouvez vous inscrire en cliquant sur "S'inscrire" dans le coin supérieur droit de la page.

- Au bas de la page, il y a un lien "Dataset", cliquez dessus pour aller à la page "Dataset".

- Obtenir des mises à jour

- Le classement sera mis à jour tous les mois. Suivez le blog officiel de Galileo AI (lien en bas de page) pour être informé des derniers ajouts de modèles.

- Par exemple, les demandes récentes d'utilisateurs dans la communauté pour adhérer à la Claude 3.7 Sonnet et Grok 3, des réponses officielles seront ajoutées dès que l'API sera disponible.

Fonctions vedettes

- Interprétation des scores de qualité de la sélection des outils (TSQ)

- Le TSQ est la principale mesure d'évaluation d'Agent Leaderboard qui mesure la précision du modèle dans l'utilisation de l'outil.

- Exemple d'opération : sélectionnez GPT-4o et voyez son score TSQ de 0,9, avec des lignes montrant qu'il est performant dans les tâches de collaboration multi-outils, mais qu'il est légèrement plus faible dans les scénarios à contexte long.

- Conseil d'utilisation : si votre projet implique des flux de travail complexes, choisissez un modèle dont le TSQ est supérieur à 0,85.

- Analyse des résultats des tests multi-domaines

- Cliquez sur "Détails de l'évaluation" pour voir comment le modèle s'est comporté dans 14 tests de référence.

- Exemple : Gemini-2.0 Flash a obtenu un score de 0,92 en BFCL (mathématiques et éducation) et de 0,89 en ToolACE (interaction API).

- Scénario d'utilisation : les équipes qui doivent traiter des données relatives à l'aviation peuvent se référer aux résultats du banc τ pour sélectionner des modèles spécialisés dans ce domaine.

- Prise de décision optimisée en fonction des coûts

- Voir le prix d'entrée/sortie par million de jetons dans la colonne "Coût" du tableau.

- Exemple : Filtre "Coût < $1" et le résultat montre Mistral-small-2501 ($0.5/million de tokens), qui convient aux projets avec un budget limité.

- Conseil : équilibrez les performances et les dépenses en combinant le score et le coût.

mise en garde

- Temps de mise à jour des donnéesLes données actuelles datent de février 2025. Il est recommandé de consulter régulièrement le site pour obtenir les classements les plus récents.

- Retour d'information de la communautéSi vous avez besoin d'un nouveau modèle (par exemple Grok 3), laissez un message sur la page Hugging Face et la réponse officielle sera basée sur la disponibilité de l'API.

- exigences techniquesLa page web est peu exigeante en termes de réseau, mais une connexion stable est nécessaire pour télécharger l'ensemble des données, c'est pourquoi il est recommandé d'utiliser un ordinateur de bureau.

Grâce à ces étapes, les utilisateurs peuvent rapidement commencer à utiliser Agent Leaderboard, un outil qui leur apporte une aide pratique, qu'ils soient à la recherche de modèles très performants ou qu'ils s'intéressent aux détails techniques des agents d'intelligence artificielle.

© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Articles connexes

Pas de commentaires...