2025 Perspectives de débarquement d'agents d'intelligence artificielle : une analyse des trois éléments que sont la planification, l'interaction et la mémoire

Les agents d'intelligence artificielle sont en train de devenir un changement de paradigme très attendu dans l'espace technologique de l'intelligence artificielle qui évolue rapidement. AI Share, une organisation leader dans l'évaluation des technologies de l'IA, a récemment fait une plongée en profondeur dans la tendance des agents d'IA et a référencé une série d'articles approfondis publiés par l'équipe de Langchain afin d'aider les lecteurs à mieux comprendre l'avenir des agents.

Cet article reprend les principales conclusions du rapport State of AI Agent publié par Langchain, qui a interrogé plus de 1 300 professionnels du secteur, notamment des développeurs, des chefs de produit et des dirigeants d'entreprise. Les résultats révèlent l'état actuel du développement des agents d'IA et les goulets d'étranglement en 2024 : Bien que 90% des entreprises planifient et appliquent activement des agents d'IA, les utilisateurs ne peuvent déployer des agents que dans des processus et des scénarios d'application spécifiques en raison des limites de leurs capacités actuelles. Les gens sont plus préoccupés par l'amélioration des capacités des agents et par l'observabilité et la fiabilité de leurs comportements, plutôt que par des facteurs tels que le coût et la latence. L'observabilité et la contrôlabilité du comportement des agents sont plus importantes que le coût et la latence.

En outre, cet article présente une analyse approfondie des éléments clés de l'agent d'intelligence artificielle tirée de la série "In the Loop" sur le site officiel de LangChain, en mettant l'accent sur les éléments suivants Planification, innovation interactive UI/UX et mémoire. Ces trois éléments fondamentaux. L'article analyse en profondeur cinq modèles d'interaction avec des produits natifs sur la base de grands modèles linguistiques (LLM) et fait l'analogie avec trois mécanismes de mémoire complexes des êtres humains, dans le but de fournir aux lecteurs des informations utiles pour comprendre la nature et les éléments clés des agents d'intelligence artificielle. Afin d'être plus proche de la pratique industrielle, cet article inclut également l'analyse des éléments clés dans la section des agents d'IA. Réflexion Des entretiens avec des fondateurs de l'IA et d'autres exemples de première main permettent d'anticiper les principales avancées que pourraient connaître les agents de l'IA en 2025.

Sur la base du cadre d'analyse ci-dessus, AI Share estime que les applications d'agents d'intelligence artificielle devraient connaître une croissance explosive en 2025 et évoluer progressivement vers un nouveau paradigme de collaboration entre l'homme et l'ordinateur. En ce qui concerne la capacité de planification des agents d'IA, les modèles émergents représentés par le modèle o3 montrent une forte capacité de réflexion et de raisonnement, ce qui indique que le développement de la technologie des modèles évolue rapidement du stade du raisonneur à celui de l'agent. Avec l'amélioration continue de la capacité de raisonnement, la question de savoir si l'agent d'IA peut réellement débarquer à grande échelle dépendra de l'innovation de l'interaction du produit et du mécanisme de mémoire, ce qui constituera également une opportunité importante pour les startups de se différencier et de faire une percée. Au niveau de l'interaction, l'industrie attend avec impatience une révolution de l'interaction homme-machine similaire au "moment GUI" de l'ère de l'IA ; au niveau de la mémoire, le contexte deviendra le mot-clé de l'atterrissage de l'agent, qu'il s'agisse de la personnalisation du contexte au niveau individuel ou de l'unification du contexte au niveau de l'entreprise. Le contexte (context) deviendra le mot-clé de l'atterrissage des agents, qu'il s'agisse de personnalisation au niveau individuel ou d'unification au niveau de l'entreprise.

01 État de l'agent d'intelligence artificielle : État actuel du développement de l'agent d'intelligence artificielle

Tendances de l'adoption des agents : toutes les entreprises planifient activement le déploiement d'agents

La concurrence dans le domaine des agents s'intensifie de jour en jour. Au cours de l'année écoulée, de nombreux frameworks d'agents populaires ont vu le jour. Par exemple, le framework ReAct combinant LLM pour le raisonnement et l'action, l'orchestration de tâches à l'aide du cadre multi-agents, et des méthodes telles que le LangGraph Il s'agit d'un cadre plus facile à gérer.

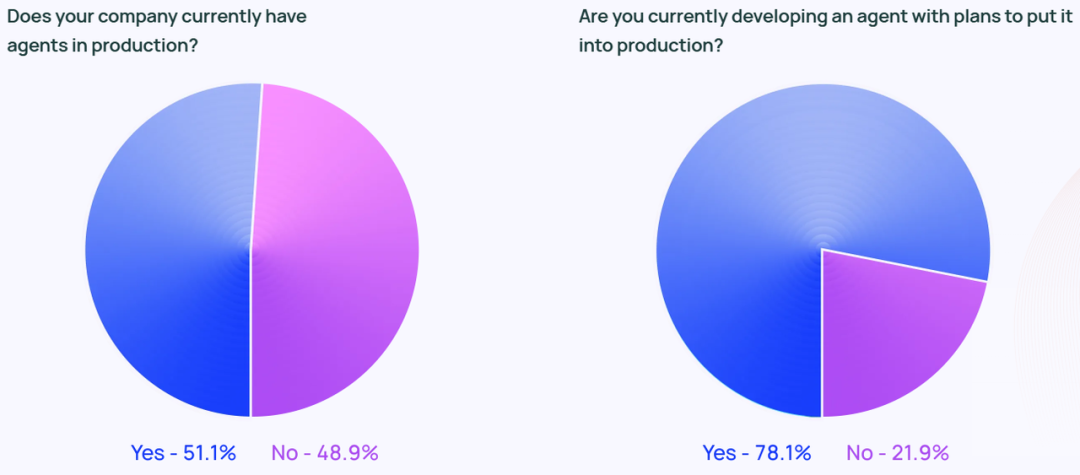

L'engouement pour les agents ne s'arrête pas aux médias sociaux. Selon l'étude, environ 51% des organisations interrogées utilisent déjà des agents dans leurs environnements de production. L'étude de Langchain ventile également les données par taille d'entreprise, montrant que les entreprises de taille moyenne de 100 à 2 000 employés sont les plus actives dans les déploiements d'agents en production, avec un nombre impressionnant de 63%.

En outre, 78% des personnes interrogées ont indiqué qu'elles prévoyaient de déployer des agents dans leurs environnements de production dans un avenir proche. Cela montre clairement que les agents d'IA suscitent un vif intérêt dans tous les secteurs d'activité, mais comment construire un véritable système d'agents d'IA ? prêt pour la production (pour une utilisation dans des environnements de production) reste un défi pour de nombreuses entreprises.

Bien que l'industrie technologique soit souvent considérée comme le précurseur de la technologie des agents, l'intérêt pour les agents croît rapidement dans toutes les industries. Parmi les répondants travaillant dans des entreprises non technologiques, 90% des organisations ont mis ou prévoient de mettre en place des agents dans leurs environnements de production, ce qui représente presque le même pourcentage que les entreprises technologiques (89%).

Cas d'utilisation de l'agent

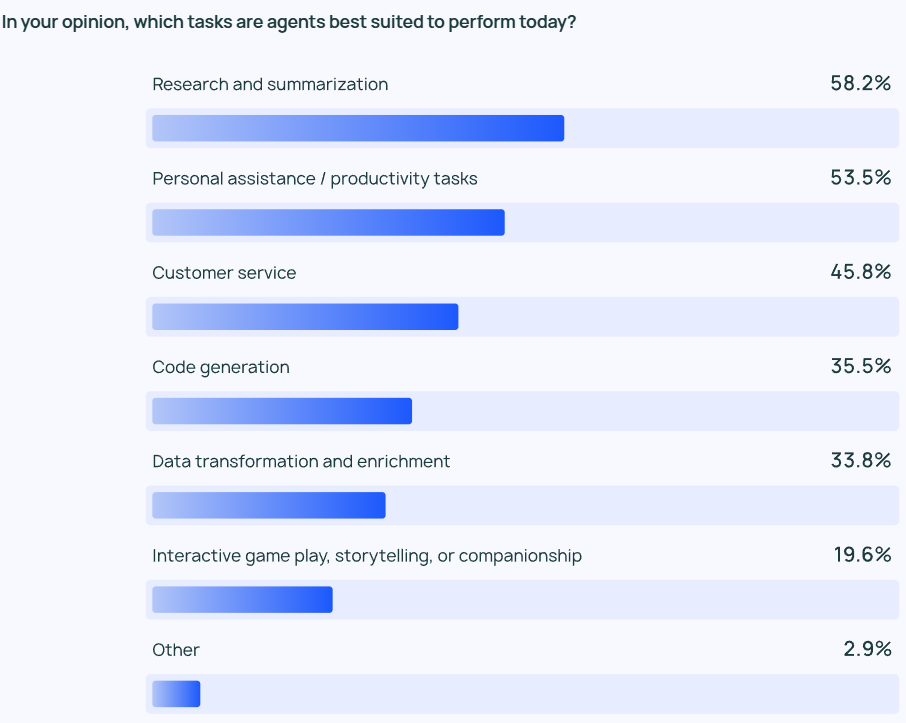

Les résultats de la recherche montrent que l'agent le plus courant est l'agent de liaison. cas d'utilisation (scénario d'application) y compris la recherche d'informations et la synthèse de contenu (58%), suivie par la rationalisation du flux de travail grâce à des agents personnalisés (53,5%).

Cela reflète le fait que les utilisateurs attendent des agents qu'ils les aident à accomplir des tâches qui prennent du temps et nécessitent beaucoup de travail. Les utilisateurs peuvent compter sur les agents d'intelligence artificielle pour extraire rapidement des informations clés et des perspectives à partir de grandes quantités d'informations, plutôt que d'avoir à passer au crible de grandes quantités de données et à procéder eux-mêmes à des examens de données ou à des analyses de recherche. De même, les agents d'intelligence artificielle peuvent aider à accomplir les tâches quotidiennes, augmentant ainsi la productivité personnelle et permettant aux utilisateurs de se concentrer sur des aspects plus importants de leur travail.

Ce ne sont pas seulement les utilisateurs individuels qui ont besoin de gains d'efficacité, mais aussi les organisations et les équipes. Le service à la clientèle (45,8%) est un autre domaine d'application majeur pour l'agent. Les agents aident les organisations à traiter les demandes des clients, à résoudre les problèmes et à réduire les délais de réponse aux clients au sein des équipes. Les quatrième et cinquième scénarios d'application les plus populaires concernent davantage le code de bas niveau et le traitement des données.

Surveillance : les applications d'agents doivent être observables et contrôlables.

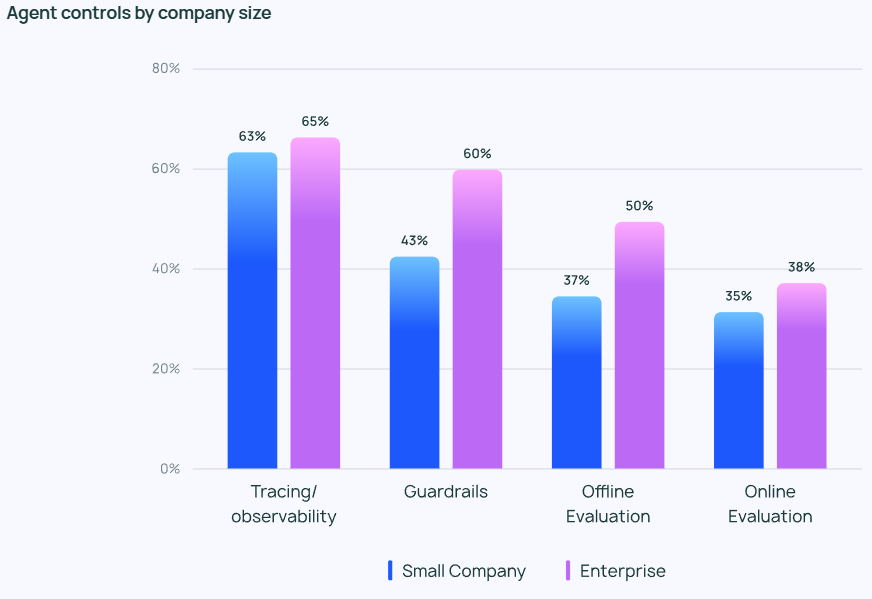

Les agents devenant de plus en plus puissants, il est essentiel de gérer et de surveiller efficacement leur comportement. Les outils de suivi et d'observabilité deviennent une option indispensable dans la pile technologique des agents d'une entreprise, car ils aident les développeurs à mieux comprendre le comportement et les performances des agents. De nombreuses entreprises utilisent également garde-corps pour éviter que le comportement de l'agent ne s'écarte de la trajectoire prédéfinie.

Lors du test des applications LLM, leÉvaluation hors ligne (39,8%) a été utilisé plus fréquemment que le Évaluation en ligne (32,5%), ce qui reflète les nombreux défis que pose encore le contrôle du LLM en temps réel. Dans les réponses au questionnaire ouvert de LangChain, de nombreuses entreprises ont indiqué qu'elles prendraient également des dispositions pour que des experts humains vérifient ou évaluent manuellement les résultats des réponses des agents, ce qui constituerait un niveau de sécurité supplémentaire.

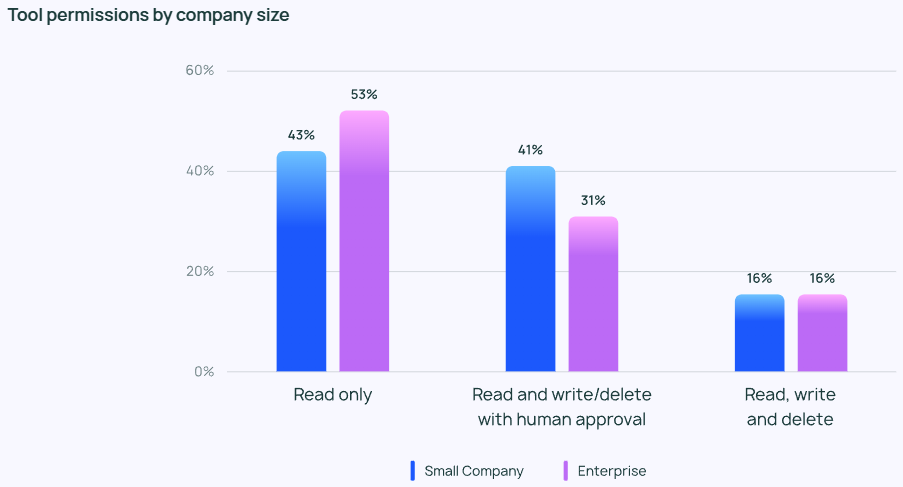

Malgré l'enthousiasme pour les agents, les gens sont généralement conservateurs en ce qui concerne le contrôle des privilèges des agents. Peu de personnes interrogées autorisent les agents à lire, écrire et supprimer librement. Au contraire, la plupart des équipes n'accordent aux agents que des autorisations de "lecture seule" ou exigent une approbation manuelle lorsque les agents effectuent des opérations plus risquées telles que l'écriture ou la suppression.

L'importance accordée aux contrôles des agents varie selon la taille de l'entreprise. Les grandes entreprises (plus de 2 000 employés) sont souvent plus prudentes et s'appuient fortement sur les autorisations de "lecture seule" pour minimiser les risques inutiles. Elles ont également tendance à placer garde-corps Combinée à des évaluations hors ligne, elle vise à éviter tout problème susceptible d'avoir un impact négatif sur le client.

Les petites entreprises et les start-ups (moins de 100 employés), quant à elles, sont plus intéressées par le suivi des agents pour avoir une idée de la façon dont leurs applications d'agents fonctionnent réellement (plutôt que par d'autres contrôles). L'étude de LangChain montre que les petites entreprises ont tendance à analyser les données pour comprendre les résultats, tandis que les grandes organisations se concentrent sur la mise en place d'un système de contrôle holistique.

Obstacles et défis à la mise en production de l'agent

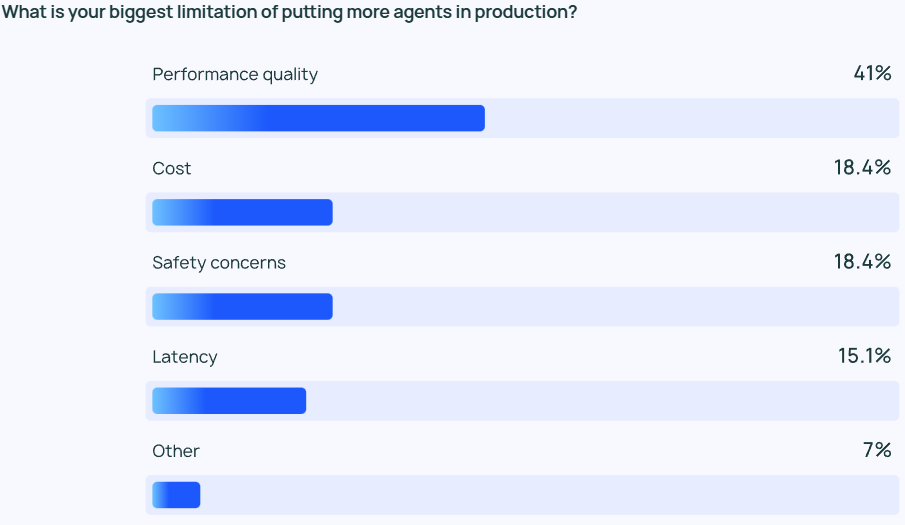

Veiller à ce que les résultats du programme d'éducation et de formation tout au long de la vie soient de haute qualité performance reste une tâche difficile. Les réponses des agents ne doivent pas seulement être très précises, elles doivent aussi être correctes sur le plan stylistique. Il s'agit d'une préoccupation majeure pour les développeurs d'agents, deux fois plus importante que d'autres facteurs tels que le coût et la sécurité.

L'agent LLM est essentiellement un modèle de sortie de contenu basé sur les probabilités, ce qui signifie que sa sortie est quelque peu imprévisible. Cette imprévisibilité augmente la probabilité d'erreur et rend difficile pour l'équipe de développement de s'assurer que l'agent fournit constamment des réponses précises et contextualisées.

Pour les petites entreprisesQualité des performances L'importance de cet aspect est particulièrement marquée, puisque 45,81 TP3T des petites entreprises en font leur première préoccupation, contre 22,41 TP3T pour le coût (la deuxième préoccupation la plus importante). Cette disparité souligne le fait que des performances fiables et de haute qualité sont essentielles pour permettre à une organisation de faire passer ses agents de la phase de développement à la phase de production.

La sécurité est également essentielle pour les grandes organisations qui doivent se conformer à des exigences strictes en matière de conformité et traiter les données des clients avec soin.

Outre les problèmes de qualité, les réponses au questionnaire ouvert de LangChain ont révélé que de nombreuses organisations hésitent encore à continuer à investir dans le développement et l'essai d'agents. Deux obstacles majeurs ont été fréquemment cités : premièrement, le développement d'un agent requiert une grande expertise et la nécessité de suivre les technologies de pointe ; deuxièmement, le coût en temps du développement et du déploiement d'un agent est élevé, mais il subsiste des incertitudes quant à sa capacité à fonctionner de manière fiable et à fournir les avantages escomptés.

Autres thèmes émergents

Lors de la séance de questions ouvertes, les personnes interrogées ont attribué une note élevée à l'agent d'intelligence artificielle en raison des capacités qu'il présente :

- Gérer des tâches en plusieurs étapes. L'agent d'intelligence artificielle est capable d'un raisonnement plus approfondi et d'une gestion du contexte, ce qui lui permet d'effectuer des tâches plus complexes.

- Automatisation des tâches répétitives. L'agent d'IA est toujours considéré comme un outil clé pour gérer les tâches automatisées, ce qui aide les utilisateurs à libérer leur temps pour se concentrer sur un travail plus créatif.

- Planification de la mission et collaboration. De meilleures capacités de planification des tâches garantissent que le bon agent travaille sur le bon problème au bon moment, ce qui est particulièrement important dans les systèmes multi-agents.

- Raisonnement de type humain. Contrairement aux LLM traditionnels, un agent d'IA peut retracer son processus de prise de décision, y compris l'examen et la révision des décisions antérieures sur la base de nouvelles informations.

En outre, les répondants ont identifié deux attentes clés pour l'avenir des agents d'intelligence artificielle :

- Ce que l'on peut attendre d'un agent d'intelligence artificielle open source. Les agents d'IA open source ont suscité beaucoup d'intérêt, beaucoup pensant que l'intelligence collective peut accélérer le rythme de l'innovation dans le domaine de la technologie des agents.

- Attentes pour des modèles plus puissants. Nombreux sont ceux qui attendent avec impatience le prochain bond en avant des agents d'IA alimentés par des modèles plus grands et plus puissants, lorsque les agents seront en mesure de gérer des tâches plus complexes avec plus d'efficacité et d'autonomie.

Au cours de la séance de questions-réponses, de nombreuses personnes interrogées ont également mentionné le plus grand défi que pose le développement d'un agent : la compréhension du comportement de l'agent. Certains ingénieurs ont déclaré qu'ils avaient du mal à comprendre le comportement d'un agent lorsqu'ils le présentaient à l'entreprise. partie prenante Ils rencontrent des difficultés pour expliquer les capacités et le comportement d'un agent d'intelligence artificielle. Bien que les plug-ins de visualisation puissent aider à expliquer le comportement de l'agent dans une certaine mesure, dans la plupart des cas, LLM reste une "boîte noire". Le fardeau supplémentaire de l'interprétabilité incombe toujours à l'équipe d'ingénierie.

02 Analyse des éléments essentiels d'un agent d'intelligence artificielle

Avant la publication du rapport State of AI Agent, l'équipe Langchain avait déjà exploré le domaine des agents en se basant sur le framework Langraph qu'elle a développé, et publié plusieurs articles sur l'analyse des composants clés des agents d'IA à travers le blog In the Loop. Dans cet article, nous compilerons le contenu principal de la série d'articles In the Loop et analyserons en profondeur les éléments clés de l'agent.

Afin de mieux comprendre les éléments essentiels d'un agent, nous devons tout d'abord mieux comprendre le concept d'agent. Système agentique Définition. Harrison Chase, fondateur de LangChain, donne la définition suivante d'un agent d'intelligence artificielle :

💡

L'agent AI est un système qui utilise le LLM pour contrôler les décisions relatives au flux de contrôle de l'application.

Un agent IA est un système qui utilise un LLM pour décider du flux de contrôle d'une application.

En ce qui concerne la manière dont l'agent est mis en œuvre, l'article présente le système de gestion de l'agent. Architecture cognitive Le concept. architecture cognitive C'est la façon dont l'agent pense et la façon dont le système orchestre le code ou les invites qui déterminent le LLM. La compréhension de l'architecture cognitive nous aide à mieux comprendre le fonctionnement de l'agent :

- Cognitif. L'agent utilise le LLM pour le raisonnement sémantique afin de déterminer comment coder ou inviter le LLM.

- Architecture. Les systèmes d'agents impliquent encore un grand nombre de pratiques d'ingénierie similaires aux architectures de systèmes traditionnels.

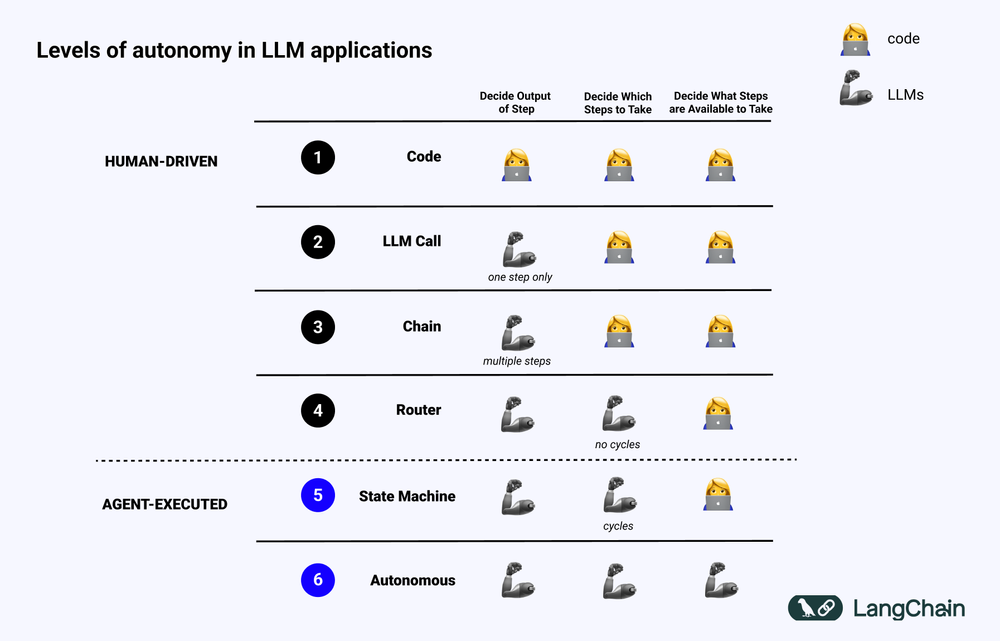

Le diagramme ci-dessous montre les différents niveaux de Architecture cognitive Exemple :

- Code logiciel normalisé (Code). Toute logique est Code dur les paramètres d'entrée et de sortie sont directement solidifiés dans le code source. Cette approche ne constitue pas une architecture cognitive en raison de l'absence d'un système d'information. cognitif Partie.

- Appel LLM. À l'exception d'une petite quantité de prétraitement de données, la plupart des fonctionnalités d'une application reposent sur un seul appel LLM. Un simple Chatbot entre généralement dans cette catégorie.

- Chaîne. Une série d'appels de LLM où Chain essaie de décomposer un problème complexe en étapes et d'appeler différents LLM pour les résoudre une par une. Le problème complexe RAG (Search Enhanced Generation) entrent dans cette catégorie : par exemple, le premier LLM est appelé pour effectuer une recherche et une requête, et le second LLM est appelé pour générer la réponse.

- Routeur. Dans ces trois systèmes, l'utilisateur connaît à l'avance toutes les étapes du programme. Cependant, dans l'architecture Router, le LLM peut décider de manière autonome des LLM à appeler et des étapes à suivre. Cela augmente le caractère aléatoire et imprévisible du système.

- Machine d'état. En combinant le LLM avec le routeur, l'imprévisibilité du système est encore renforcée. Comme cette combinaison crée une boucle, le système peut théoriquement invoquer le LLM un nombre infini de fois.

- Système agentique. On parle aussi souvent de "Agent autonome (Autonomous Agent)" Lors de l'utilisation d'une machine à états, les opérations que le système peut effectuer et les processus qui les suivent sont toujours limités. Lors de l'utilisation d'une machine à états, il existe encore des restrictions sur les opérations qui peuvent être effectuées par le système et sur le flux qui suit ces opérations. Cependant, lorsqu'on utilise un agent autonome, ces restrictions sont levées. Le LLM dispose d'une autonomie totale pour décider des étapes à suivre et de la manière de programmer les différents LLM, ce qui peut être réalisé par l'utilisation de différentes invites, outils ou codes.

En bref, plus un système "Agentic" Plus le LLM joue un rôle dans la détermination du comportement du système, plus le LLM joue un rôle important dans la détermination du comportement du système.

Éléments clés de l'agent : capacité de planification

La fiabilité des agents est un point sensible dans la pratique actuelle des applications. De nombreuses entreprises ont construit des agents basés sur le LLM, mais constatent que les capacités de planification et de raisonnement des agents sont insuffisantes. Que signifie donc la capacité de planification et de raisonnement d'un agent ?

Agent's Planification répondre en chantant Raisonnement La compétence, qui se réfère à la capacité du LLM à réfléchir et à prendre des décisions sur les actions à entreprendre. Cela implique à la fois le court terme et le long terme raisonnement . Le LLM doit évaluer toutes les informations disponibles et décider ensuite : Quelles mesures dois-je prendre pour atteindre mon objectif final ? Quelle est la première mesure la plus importante à prendre à l'heure actuelle ?

Dans la pratique, les développeurs utilisent généralement Appel de fonction pour permettre au MLD de sélectionner l'action à effectuer. Appel de fonction est une fonctionnalité ajoutée pour la première fois à l'API LLM en juin 2023 par OpenAI. Avec l'appel de fonction, les utilisateurs peuvent fournir des structures JSON pour différentes fonctions et faire correspondre LLM à une (ou plusieurs) de ces structures.

Pour mener à bien une tâche complexe, un système d'agents doit généralement effectuer une série d'opérations de manière séquentielle. Planification et raisonnement à long terme Un défi très complexe pour le LLM : premièrement, le LLM doit envisager une planification d'action à long terme et ensuite l'affiner pour les actions à court terme qui doivent être prises au moment présent ; deuxièmement, comme l'agent effectue de plus en plus d'opérations, les résultats des opérations seront continuellement renvoyés au LLM, ce qui entraîne une croissance continue de la fenêtre de contexte, ce qui peut conduire le LLM à être " distrait " et à réduire la performance. "et réduire les performances.

Le moyen le plus simple d'améliorer les capacités de planification est de s'assurer que les gestionnaires de l'espace local disposent de toutes les informations dont ils ont besoin pour raisonner et planifier de manière rationnelle. Bien que cela semble simple, la réalité est que les informations transmises au LLM sont souvent insuffisantes pour permettre au LLM de prendre des décisions judicieuses. L'ajout d'une étape de recherche ou l'optimisation de l'invite peut constituer une amélioration simple.

Pour aller plus loin, on peut envisager d'ajuster le paramètre architecture cognitive . Il existe deux types principaux d'architectures cognitives qui peuvent être utilisées pour améliorer la capacité de raisonnement de l'agent : Architecture cognitive générique répondre en chantant Architectures cognitives spécifiques à un domaine.

1. architecture cognitive générique

Architecture cognitive générique peut être appliquée à une variété de scénarios de tâches différents. Deux architectures génériques représentatives ont été proposées par des universitaires : "Architecture "Planifier et résoudre répondre en chantant Reflexion Architecture.

"Architecture "Planifier et résoudre Elle a été présentée pour la première fois dans l'article Plan-and-Solve Prompting : Improving Zero-Shot Chain-of-Thought Reasoning by Large Language Models. Dans cette architecture, un agent élabore d'abord un plan détaillé, puis exécute chaque étape du plan, pas à pas.

Reflexion Architecture a été présenté dans l'article Reflexion : Language Agents with Verbal Reinforcement Learning (Réflexion : agents linguistiques avec apprentissage par renforcement verbal). Dans cette architecture, un agent exécute une tâche et ajoute ensuite un message explicite à son message. "Réflexion". pour évaluer si leurs tâches sont exécutées correctement. Sans entrer dans les détails spécifiques de ces deux architectures, le lecteur intéressé est invité à se reporter aux deux documents originaux mentionnés ci-dessus.

Bien que les architectures "Plan and Solve" et Reflexion présentent un certain potentiel théorique d'amélioration, elles sont souvent trop générales pour être utiles dans l'utilisation des agents en production. (Note du traducteur : au moment de la rédaction de cet article, la famille de modèles o1 n'avait pas encore été publiée).

2. architecture cognitive spécifique à un domaine

Contrairement aux architectures cognitives génériques, de nombreux systèmes d'agents choisissent d'utiliser l'architecture de l'agent. Architectures cognitives spécifiques à un domaine . Cela se traduit généralement par une étape de catégorisation ou de planification spécifique au domaine, ainsi que par une étape de validation spécifique au domaine. Les idées de planification et de réflexion présentées dans les architectures cognitives génériques peuvent être empruntées et appliquées dans les architectures cognitives spécifiques à un domaine, mais elles doivent généralement être adaptées et optimisées d'une manière plus spécifique au domaine.

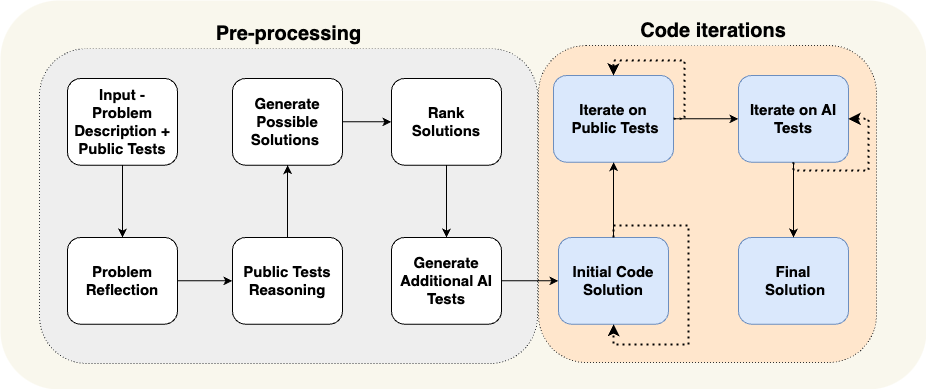

Un article d'AlphaCodium fournit un excellent exemple d'architecture cognitive spécifique à un domaine. L'équipe d'AlphaCodium y est parvenue en utilisant ce qu'elle appelle l'architecture cognitive spécifique à un domaine. "Ingénierie des flux". (essentiellement une autre façon de décrire les architectures cognitives), atteignant des performances de pointe à l'époque.

Comme le montre la figure ci-dessus, les processus de l'agent AlphaCodium sont conçus pour être très pertinents par rapport au problème de programmation qu'ils tentent de résoudre. Ils informent l'agent en détail sur les tâches qui doivent être effectuées par étapes : d'abord proposer un cas de test, puis proposer une solution, puis itérer sur d'autres cas de test, et ainsi de suite. Cette architecture cognitive est très spécifique à un domaine, elle n'est pas générique et il est difficile de la généraliser directement à d'autres domaines.

Étude de cas : La vision de Laskin, fondateur de Reflection AI, sur l'avenir des agents

Dans l'interview de Sequoia Capital avec Misha Laskin, fondateur de Reflection AI, Misha Laskin partage sa vision de l'avenir de l'agent : en combinant Capacité de recherche pour l'apprentissage par renforcement (RL) En conjonction avec LLM, Reflection AI se concentre sur la construction de modèles d'agents aux performances supérieures. Misha Laskin et son cofondateur Ioannis Antonoglou (responsable d'AlphaGo, AlphaZero, Gemini RLHF) se concentrent sur l'entraînement de modèles d'agents spécialement conçus pour le LLM. Flux de travail agentique Modélisation de la conception. Les idées principales issues des entretiens sont présentées ci-dessous :

- La profondeur est le principal ingrédient manquant à un agent d'IA. Si les modèles linguistiques actuels excellent en termes d'étendue des connaissances, ils n'ont pas la profondeur nécessaire pour accomplir de manière fiable des tâches complexes. Misha Laskin affirme que la résolution du "problème de la profondeur" est essentielle à la création d'agents d'intelligence artificielle réellement capables. Dans ce contexte, le terme "capacité" désigne l'aptitude d'un agent à planifier et à exécuter des tâches complexes en plusieurs étapes.

- La combinaison de l'apprentissage et de la recherche est la clé d'une performance surhumaine. S'appuyant sur le succès d'AlphaGo, Misha Laskin a souligné que l'idée la plus profonde de l'IA est la combinaison efficace de **Learn** (s'appuyant sur le LLM) et **Search** (trouver le chemin optimal). Cette approche est essentielle pour créer des agents qui surpassent les humains dans des tâches complexes.

- La modélisation de la post-formation et des récompenses pose de grands défis. Contrairement aux jeux dotés de mécanismes de récompense explicites, les tâches du monde réel ne comportent généralement pas de signaux de récompense explicites. Comment développer des modèle de récompense Le principal défi consiste à créer un agent d'intelligence artificielle fiable.

- Les agents universels sont peut-être plus proches qu'on ne le pense. Misha Laskin prédit que nous ne sommes plus qu'à trois ans de la réalisation de l'objectif de l'Union européenne. "L'AGI numérique (Intelligence Artificielle Générale Numérique)". Ce calendrier accéléré souligne l'urgence de développer rapidement les capacités des agents tout en traitant simultanément les questions de sécurité et de fiabilité. Ce calendrier accéléré souligne l'urgence de développer rapidement les capacités de l'agent tout en abordant les questions de sécurité et de fiabilité.

- Le chemin vers les agents universels passe par une méthode. Reflection AI se concentre sur l'extension des limites fonctionnelles de l'agent, en commençant par des environnements spécifiques tels que les navigateurs, les éditeurs de code et les systèmes d'exploitation informatiques. L'objectif ultime est de développer Agents universels Cela leur permet d'effectuer des tâches dans une variété de domaines différents et n'est pas limité à des tâches spécifiques.

UI/UX Interaction Innovation

L'interaction homme-machine (IHM) deviendra un axe de recherche clé dans le domaine de l'IA au cours des prochaines années. Les systèmes d'agents sont très différents des systèmes informatiques traditionnels, et de nouvelles caractéristiques telles que la latence, le manque de fiabilité et les interfaces en langage naturel posent de nouveaux défis. Par conséquent, un nouveau type de UI/UX (interface utilisateur/expérience utilisateur) Des paradigmes vont émerger. Bien que les systèmes d'agents en soient encore aux premiers stades de leur développement, un certain nombre de paradigmes UX émergent. Chacun d'entre eux sera examiné ci-dessous.

1) Interaction conversationnelle (Chat UI)

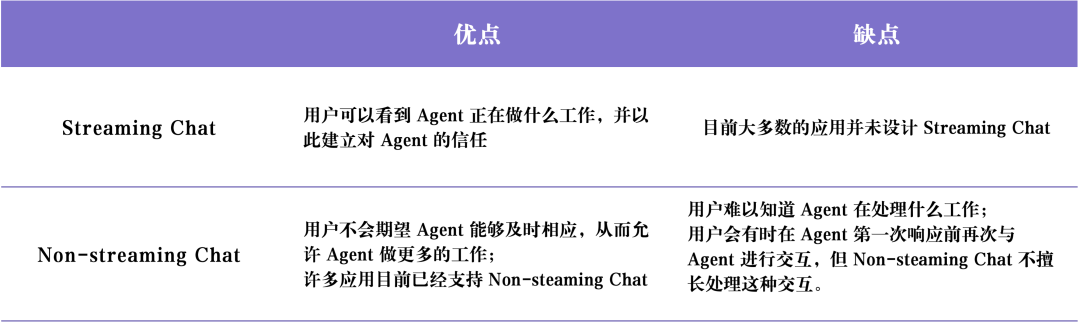

Interaction conversationnelle (Chat UI) Il en existe généralement deux types principaux : Chat en streaming répondre en chantant Chat sans streaming .

Chat en streaming est le paradigme UX le plus courant aujourd'hui. Il s'agit essentiellement d'un chatbot, qui reprend le processus de pensée et le comportement de l'agent et le fait passer par un format de dialogue semblable à celui d'un humain. Flux à l'utilisateur. ChatGPT Il s'agit d'un représentant typique du chat en continu. Ce mode d'interaction semble simple, mais il est très efficace pour les raisons suivantes : premièrement, les utilisateurs peuvent utiliser le langage naturel pour dialoguer directement avec les MFR, et il n'y a pratiquement pas de barrières de communication entre les utilisateurs et les MFR ; deuxièmement, les MFR mettent généralement du temps à terminer leurs tâches, et le traitement en continu permet aux ménages de connaître la progression de l'exécution des tâches en arrière-plan en temps réel ; troisièmement, les MFR peuvent parfois faire des erreurs, et l'interface de chat fournit un moyen convivial pour les utilisateurs de corriger et de guider naturellement les MFR, qui ont pris l'habitude d'avoir des conversations de suivi et des discussions en ligne. Troisièmement, les MFR peuvent parfois faire des erreurs, et l'interface de chat offre aux utilisateurs un moyen convivial de corriger et de guider naturellement les MFR, qui ont pris l'habitude d'avoir des conversations de suivi et des itérations pendant le processus de chat afin de clarifier progressivement les exigences et de résoudre les problèmes.

Cependant.Chat en streaming Il existe également certaines limites. Premièrement, le chat en continu est encore une expérience utilisateur relativement nouvelle, et il n'est pas encore communément adopté par nos plateformes de chat courantes (par exemple, iMessage, Facebook Messenger, Slack, etc.) ; deuxièmement, l'expérience utilisateur du chat en continu est un peu insuffisante pour les tâches avec une longue durée d'exécution, et les utilisateurs peuvent avoir besoin de rester dans l'interface de chat pendant une longue période en attendant que l'agent termine la tâche ; troisièmement, le chat en continu doit généralement être déclenché par des utilisateurs humains, ce qui signifie qu'une grande quantité d'implication humaine (Human-in-the-tray) est encore nécessaire pendant l'exécution des tâches. Troisièmement, les chats en continu sont généralement déclenchés par des utilisateurs humains, ce qui signifie qu'il y a encore beaucoup d'implication humaine dans le processus d'exécution de l'agent.

Chat sans streaming La principale différence avec le chat en continu est que les réponses de l'agent sont renvoyées par lots. Le LLM fonctionne silencieusement en arrière-plan, de sorte que l'utilisateur n'a pas à attendre impatiemment une réponse immédiate de l'agent. Cela signifie que le chat sans flux peut être plus facile à intégrer dans les flux de travail existants. Les utilisateurs ont l'habitude d'envoyer des SMS à leurs amis, alors pourquoi ne pas "envoyer des SMS" à l'IA ? Le chat sans flux rendra l'interaction avec des systèmes d'agents plus complexes plus naturelle et plus facile. Les systèmes d'agents complexes étant souvent longs à exécuter, les utilisateurs peuvent être frustrés s'ils attendent une réponse immédiate de l'agent. Le chat sans flux élimine en partie l'attente d'une réponse immédiate, ce qui facilite l'exécution de tâches plus complexes.

Le tableau suivant résume Chat en streaming répondre en chantant Chat sans streaming Les avantages et les inconvénients de la

2. l'environnement de fond (UX ambiant)

Les utilisateurs peuvent envoyer des messages à l'IA, comme nous l'avons vu précédemment. Chat UI (Chat Interface) Mais si l'agent fonctionne silencieusement en arrière-plan, comment interagir avec lui ? Mais comment interagir avec un agent s'il fonctionne silencieusement en arrière-plan ?

Afin de réaliser le plein potentiel du système d'agents, nous devons modifier le paradigme de l'IHM pour qu'il permette à l'IA de s'intégrer dans le système d'information de l'entreprise. Environnement backend (Ambient UX) s'exécutant en arrière-plan. Lorsque les tâches sont traitées en arrière-plan, les utilisateurs peuvent généralement tolérer des délais d'exécution plus longs (parce qu'ils réduisent leur besoin d'utiliser l'interface utilisateur). latence attentes). Cela permet à l'agent de disposer de plus de temps pour effectuer davantage de tâches et, d'une manière générale, de raisonner avec plus de soin et d'efficacité que dans l'interface utilisateur en mode conversationnel.

En outre, en Environnement backend (Ambient UX) L'utilisation d'un agent dans une interface de dialogue en ligne permet d'étendre les capacités des utilisateurs humains eux-mêmes. Les interfaces de dialogue en ligne limitent généralement les utilisateurs à une seule tâche à la fois. Toutefois, si l'agent fonctionne en arrière-plan, il est possible de prendre en charge plusieurs agents travaillant sur plusieurs tâches en même temps.

Pour qu'un agent fonctionne de manière fiable en arrière-plan, il faut que les utilisateurs lui fassent confiance. Comment établir cette confiance ? Une idée simple : montrer à l'utilisateur ce que fait exactement l'agent. En montrant toutes les étapes que l'agent exécute en temps réel, l'utilisateur peut observer ce qui se passe. Même si ces étapes ne sont pas aussi immédiates que la diffusion d'une réponse, elles doivent permettre à l'utilisateur de cliquer dessus à tout moment et de voir la progression de l'exécution de l'agent. En outre, il est important de permettre à l'utilisateur non seulement de voir ce que fait l'agent, mais aussi de corriger les erreurs de l'agent. Par exemple, si l'utilisateur découvre que l'agent a pris une mauvaise décision à l'étape 4 (sur 10), il a la possibilité de revenir à l'étape 4 et de corriger le comportement de l'agent d'une manière ou d'une autre.

Cette approche combine le modèle d'interaction utilisateur-agent De "In-the-loop" à "On-the-loop". . "En boucle". Le modèle exige que le système soit en mesure de montrer à l'utilisateur toutes les étapes intermédiaires réalisées par l'agent, ce qui permet à l'utilisateur d'interrompre le flux de travail pendant l'exécution d'une tâche, de fournir un retour d'information, puis de permettre à l'agent de poursuivre l'exécution des tâches suivantes en fonction du retour d'information de l'utilisateur.

Ingénieur logiciel en IA Devin est représentatif de la mise en œuvre d'applications de type UX. La durée d'exécution d'un Devin est généralement longue, mais l'utilisateur peut clairement voir toutes les étapes exécutées par l'agent, revenir à l'état de développement à un moment précis et donner des instructions correctives à partir de cet état. Le fait qu'un agent fonctionne en arrière-plan ne signifie pas qu'il doive exécuter des tâches de manière totalement autonome. Il peut arriver qu'un agent ne sache pas quoi faire ensuite, ou qu'il ne soit pas sûr de savoir comment répondre à la question d'un utilisateur. Dans ce cas, l'agent doit attirer de manière proactive l'attention de l'utilisateur humain et lui demander de l'aide.

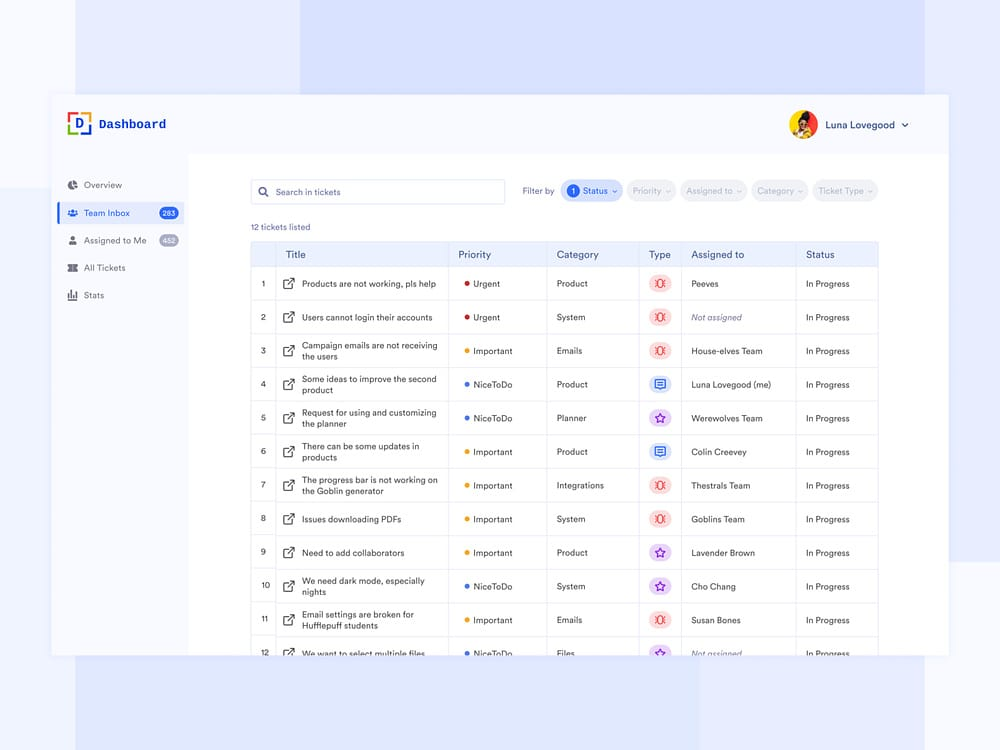

Email Assistant Agent Oui UX ambiant (environnement de fond) Un autre cas d'utilisation de LangChain. Le fondateur de LangChain, Harrison Chase, est en train de construire un agent assistant de messagerie. Alors que l'agent peut répondre automatiquement à des courriels simples, dans certains cas, il demande à Harrison de s'engager manuellement dans des tâches qui ne se prêtent pas à l'automatisation, telles que : examiner des rapports de bogues complexes de LangChain, l'examen de rapports d'erreurs LangChain complexes, la décision d'assister ou non à une réunion, etc. Dans ces cas-là, l'agent Assistant électronique a besoin d'un moyen efficace pour communiquer à Harrison qu'il a besoin d'une assistance humaine pour continuer à accomplir la tâche. Notez qu'au lieu de demander directement des réponses à Harrison, l'agent lui demande son avis sur certaines tâches, puis l'agent peut utiliser ce retour d'information pour rédiger un courriel de qualité ou programmer une invitation à une réunion sur le calendrier.

Lorsque l'agent a besoin d'une assistance humaine, il envoie une question sur Slack à Harrison, qui peut y répondre dans le tableau de bord, une interaction qui s'intègre de manière transparente au flux de travail quotidien de Harrison. Ce type d'interaction s'intègre parfaitement au flux de travail quotidien de Harrison. L'interface du tableau de bord montre clairement toutes les tâches pour lesquelles l'assistant a besoin d'une aide humaine, la priorité de la demande et d'autres données pertinentes.

3. l'interface utilisateur de la feuille de calcul

Tableur UX Il s'agit d'une interaction très intuitive et conviviale, particulièrement adaptée aux travaux de traitement par lots. Dans l'interface du tableur, chaque tableau, voire chaque colonne, peut être traité comme un agent distinct pour la recherche et le traitement de tâches spécifiques. Cette capacité de traitement par lots permet aux utilisateurs d'étendre facilement leur interaction avec plusieurs agents.

Tableur UX Il y a aussi d'autres avantages. Le format feuille de calcul est une interface utilisateur avec laquelle la plupart des utilisateurs sont familiers, il est donc facile de l'intégrer dans les flux de travail existants. Ce type d'UX est idéal pour les scénarios d'enrichissement des données où chaque colonne de la feuille de calcul peut représenter un attribut de données différent qui doit être développé.

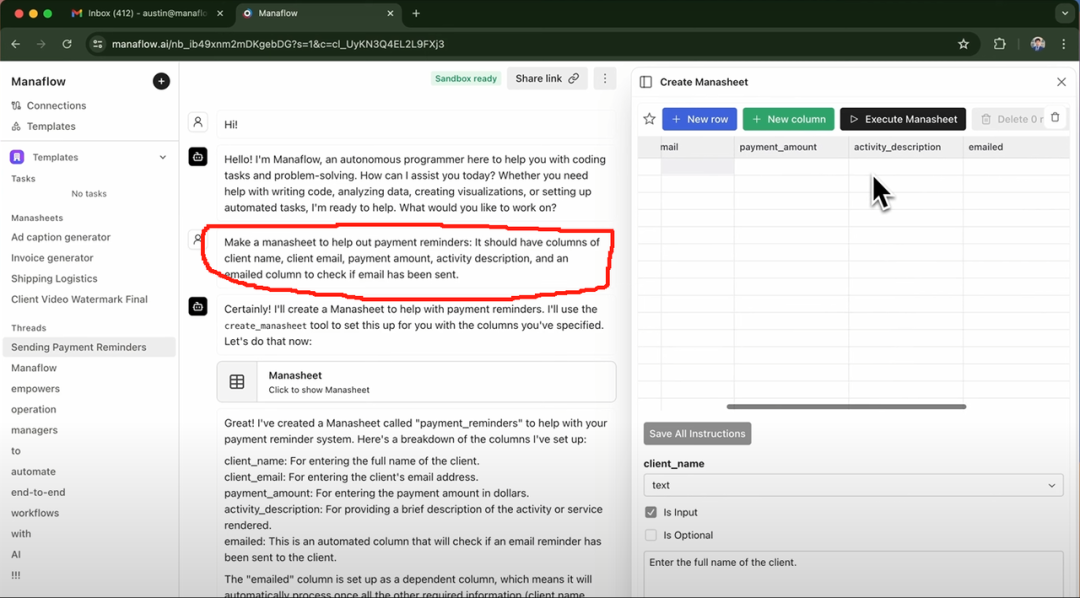

Exa AI, Clay AI, Manaflow et d'autres ont utilisé l'outil Tableur UX Voici un exemple de Manaflow. Voici un exemple de Manaflow Tableur UX Comment il s'applique aux flux de travail des agents.

Étude de cas : Comment Manaflow utilise des feuilles de calcul pour les interactions avec les agents

Manaflow a été inspiré par Minion AI, l'entreprise pour laquelle travaillait son fondateur, Lawrence. Le produit phare de Minion AI est l'agent Web. L'agent Web peut contrôler les systèmes d'information locaux de l'entreprise. Google Chrome et permet aux utilisateurs d'interagir avec diverses applications web par l'intermédiaire de l'agent web, comme la réservation de vols en ligne, l'envoi de courriels, la réservation de lavages de voitures, etc. Inspiré par Minion AI, Manaflow a choisi de laisser l'agent manipuler directement des outils tels que des feuilles de calcul. L'équipe de Manaflow pense que les agents ne sont pas doués pour travailler directement avec des interfaces humaines, et que ce qu'ils savent faire, c'est Codage Manaflow est le premier du genre au monde. Manaflow permet à l'agent d'appeler des scripts Python, des interfaces de base de données et des interfaces API directement à partir de l'interface utilisateur, puis d'effectuer des opérations directement sur la base de données, notamment la lecture de données, la planification, l'envoi de courriels, etc.

Le flux de travail de Manaflow est le suivant : la principale interface interactive de Manaflow est une feuille de calcul (Manasheet). Chaque colonne de la feuille de calcul représente une étape du flux de travail, et chaque ligne correspond à un agent IA qui exécute une tâche spécifique. Chaque flux de travail de la feuille de calcul est programmable en langage naturel (ce qui permet aux utilisateurs non techniques de décrire les tâches et les étapes en langage naturel). Chaque feuille de calcul possède un graphe de dépendance interne qui détermine l'ordre d'exécution de chaque colonne. Ces ordres d'exécution sont attribués aux agents de chaque ligne, qui exécutent des tâches en parallèle, en gérant des processus tels que la transformation de données, les appels API, la récupération de contenu et la messagerie :

Les feuilles de calcul peuvent être générées de différentes manières, la plus courante étant d'entrer une commande en langage naturel comme celle qui figure dans l'encadré rouge ci-dessus. Par exemple, si vous souhaitez envoyer à vos clients des courriers électroniques contenant des informations sur les prix, vous pouvez saisir une invite dans l'interface de chat et l'agent générera automatiquement une feuille de calcul. La feuille de calcul vous indique le nom du client, son adresse électronique, son secteur d'activité et si le courrier électronique a été envoyé ou non, entre autres informations clés. Les utilisateurs peuvent simplement cliquer sur le bouton "Exécuter la feuille de calcul" pour effectuer des tâches d'envoi d'e-mails en masse.

4. l'interface utilisateur générative

"L'interface utilisateur générative". Il existe deux principales mises en œuvre différentes.

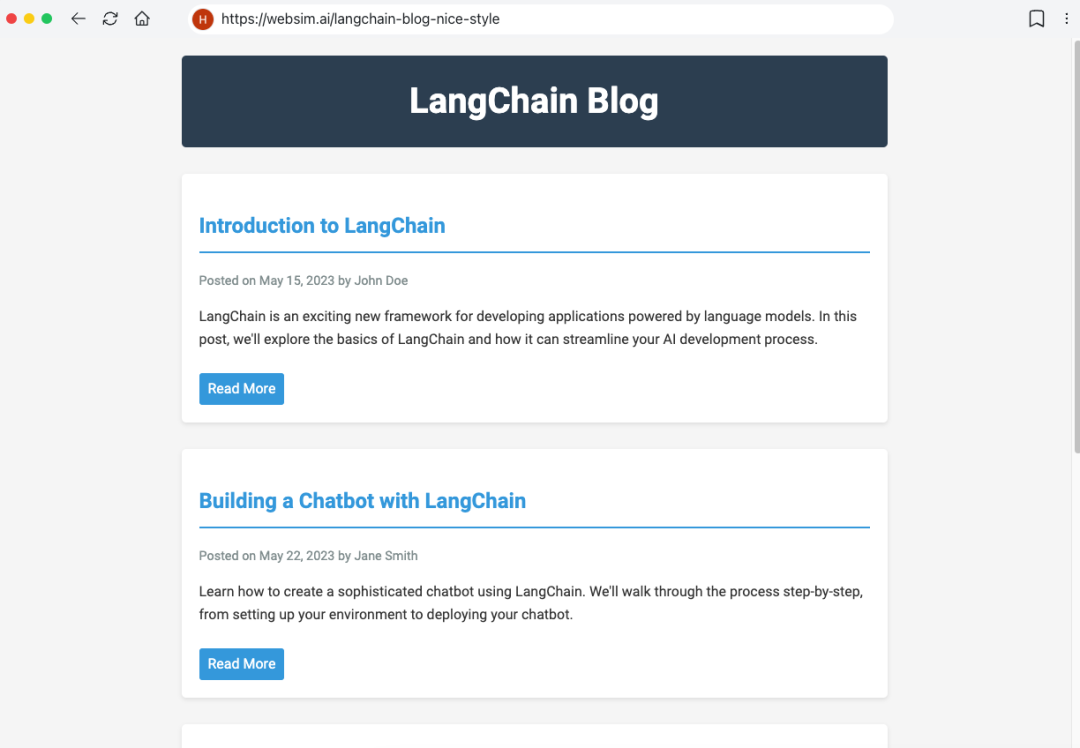

La première méthode consiste à faire en sorte que le modèle génère de manière autonome les données nécessaires à l'évaluation de la qualité de l'eau. Composants de l'interface utilisateur . Ceci est similaire à Websim et d'autres produits. En arrière-plan, l'agent écrit principalement le code HTML brut, ce qui lui donne un contrôle total sur l'affichage de l'interface utilisateur. Toutefois, l'inconvénient de cette approche est que la qualité de l'application Web résultante est très incertaine et que l'expérience de l'utilisateur peut être variable.

Une autre approche, plus contraignante, consiste à prédéfinir un ensemble de composants d'interface utilisateur couramment utilisés, puis à les faire passer par la fonction Appels d'outils pour effectuer un rendu dynamique des composants de l'interface utilisateur. Par exemple, si LLM appelle l'API météo, il déclenchera le rendu du composant d'interface utilisateur de la carte météo. Étant donné que les composants d'interface utilisateur rendus sont prédéfinis (et que l'utilisateur a plus de choix), l'interface utilisateur résultante sera plus soignée, mais sa flexibilité sera quelque peu limitée.

Étude de cas : produit d'IA personnelle dot

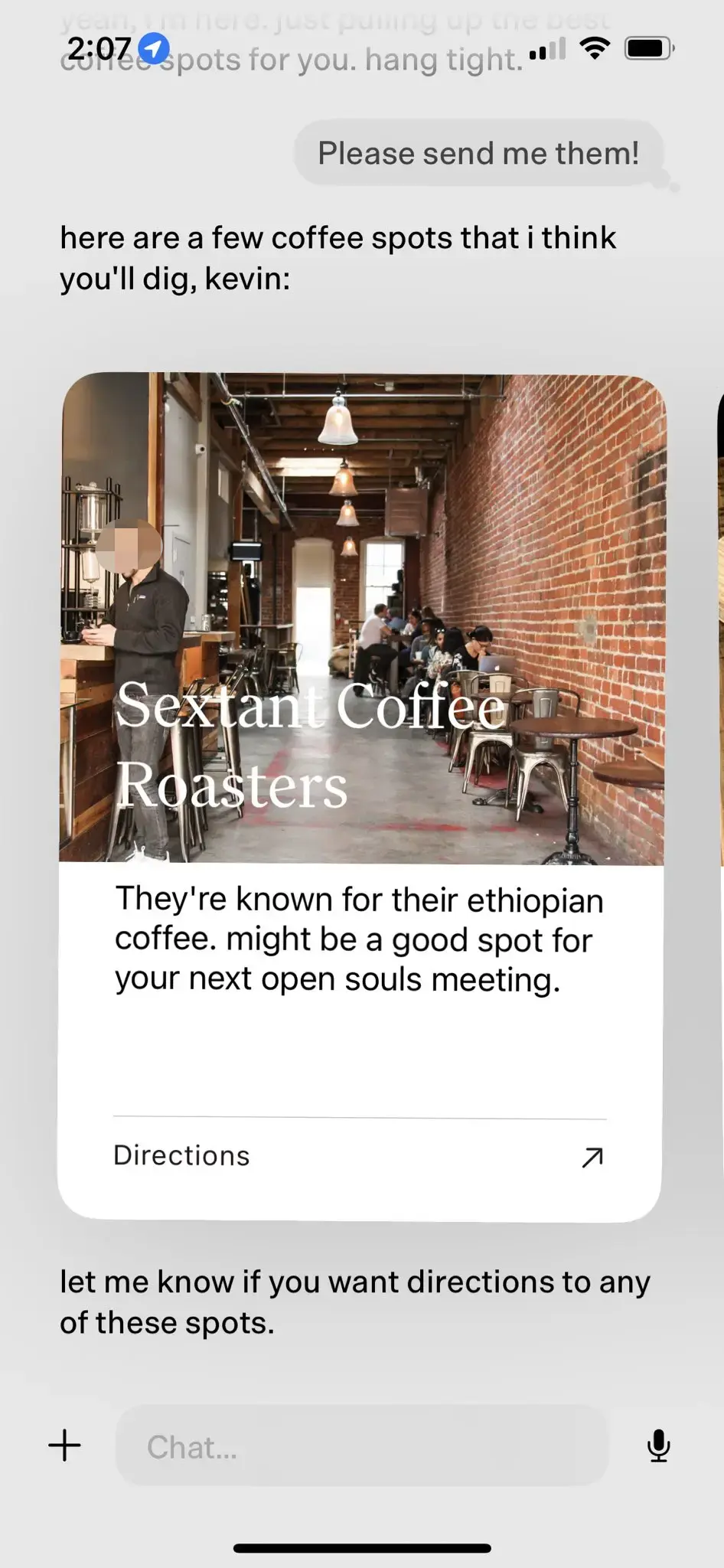

Produits d'IA personnels dot Oui L'interface utilisateur générative Le meilleur exemple en est le suivant : dot a été qualifié de "meilleur produit d'IA personnelle" en 2024. dot a été salué comme le "meilleur produit d'IA personnelle" en 2024.

point Oui Nouveau Ordinateur Le produit phare de l'entreprise. L'objectif de dot est de devenir un compagnon numérique à long terme pour les utilisateurs, et pas seulement un outil efficace de gestion des tâches. Comme le dit Jason Yuan, cofondateur de New Computer, le scénario d'application de dot est le suivant : "lorsque vous ne savez pas où aller, quoi faire ou quoi dire, vous vous tournez vers dot". Voici quelques cas d'utilisation typiques de dot :

- Jason Yuan, fondateur de New Computer, demande souvent à dot de lui recommander des bars tard dans la nuit dans l'espoir de "s'enivrer". Après des mois de conversations dans les bars, Jason Yuan a un jour posé une question similaire à dot, et dot a commencé à dire à Jason qu'il "ne pouvait pas continuer comme ça".

- Mark Wilson, journaliste à Fast Company, a également passé quelques mois avec dot. À un moment donné, il a partagé avec dot un "O" manuscrit qu'il avait écrit lors d'un cours de calligraphie. À sa grande surprise, dot a immédiatement fait apparaître une photo du "O" manuscrit de Mark Wilson quelques semaines plus tôt et l'a félicité pour ses "progrès considérables" en calligraphie.

- Au fur et à mesure que les utilisateurs utilisent dot pendant des périodes de plus en plus longues, dot est en mesure d'acquérir une compréhension plus approfondie de leurs intérêts et de leurs préférences. Par exemple, lorsque dot apprend qu'un utilisateur aime se rendre dans des cafés, il lui propose activement des cafés de qualité situés à proximité, lui explique les raisons de la recommandation et lui demande s'il a besoin de naviguer à la fin.

Dans le cas de la recommandation du café ci-dessus, dot réalise l'effet d'interaction naturelle entre l'homme et l'ordinateur sur la base de LLM-native grâce à des composants d'interface utilisateur prédéfinis.

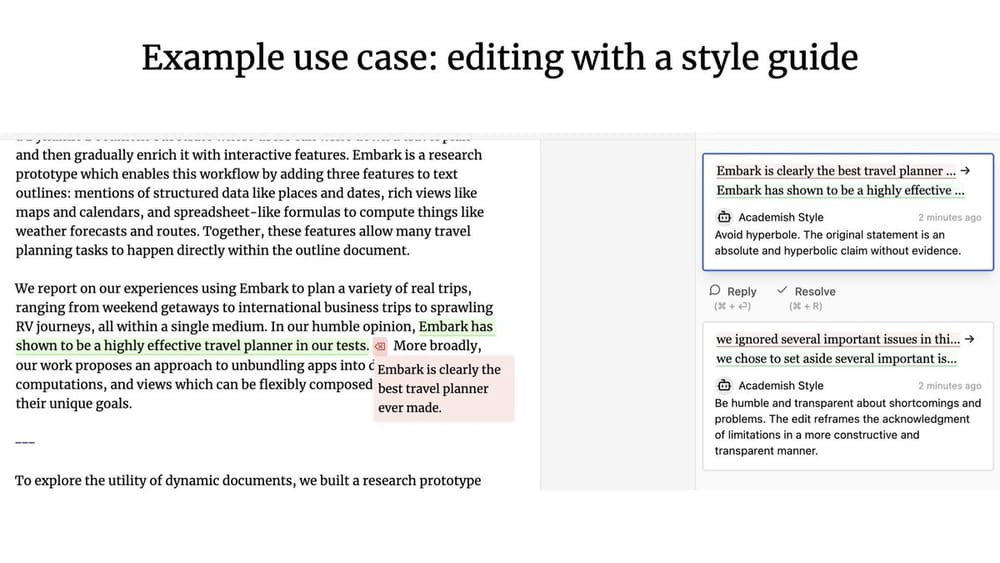

5. l'UX collaborative

Quels types de modèles d'interaction homme-machine apparaissent lorsqu'un agent et un utilisateur humain travaillent ensemble ? À l'instar de Google Docs, plusieurs utilisateurs peuvent collaborer en temps réel pour rédiger ou modifier le même document. Que se passe-t-il si l'un des collaborateurs est un agent ?

Geoffrey Litt avec Ink & Switch Projet de patchwork Il s'agit d'une relation homme-machine. UX collaboratif Un bon représentant du projet Patchwork. (Note du traducteur : la récente mise à jour du produit Canvas d'OpenAI pourrait avoir été inspirée par le projet Patchwork).

UX collaboratif Contrairement à ce qui a été dit précédemment, les UX ambiant (environnement de fond) Quelle est la différence ? Nuno, l'ingénieur fondateur de LangChain, souligne que la principale différence entre les deux est la disponibilité de l'information. Concurrence : :

- existent UX collaboratif Dans ce cas, l'utilisateur humain et le LLM doivent généralement travailler simultanément et utiliser le produit du travail de l'autre comme intrant.

- existent UX ambiant (environnement de fond) Dans ce cas, le LLM fonctionne en permanence en arrière-plan, tandis que l'utilisateur peut se concentrer sur d'autres tâches sans avoir à surveiller l'état de l'agent en temps réel.

Mémoire

Mémoire Il est essentiel d'améliorer l'expérience utilisateur de l'agent. Imaginez que votre collègue ne se souvienne jamais de ce que vous lui avez dit et qu'il vous demande sans cesse de répéter la même chose, ce serait une expérience de collaboration épouvantable. Il est courant de s'attendre à ce que les systèmes LLM soient intrinsèquement capables de se souvenir, probablement parce que les LLM sont d'une certaine manière très proches de la cognition humaine. Cependant, les LLM n'ont pas intrinsèquement de capacités de mémorisation.

Agent's Mémoire La conception doit être adaptée aux besoins spécifiques du produit lui-même. Les différents paradigmes UX fournissent également différentes méthodes de collecte d'informations et de mise à jour du retour d'information. Les mécanismes de mémoire des produits agents nous permettent d'observer différents types de modèles de mémoire de haut niveau qui imitent, dans une certaine mesure, les types de mémoire humaine.

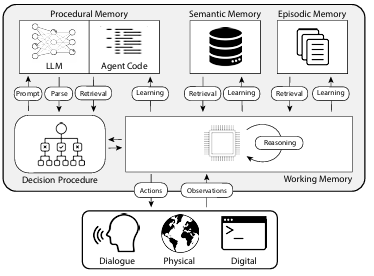

L'article "CoALA : Cognitive Architectures for Language Agents" établit une correspondance entre les types de mémoire humaine et les mécanismes de mémoire des agents, classés comme indiqué dans la figure ci-dessous :

1. la mémoire procédurale

Mémoire procédurale C'est une façon de parler de Comment effectuer les tâches de la mémoire à long terme, semblable à l'ensemble des instructions du cerveau humain.

- Mémoire procédurale humaine. Par exemple, rappelez-vous comment faire du vélo.

- La mémoire procédurale de l'agent. Le document CoALA décrit la mémoire procédurale comme une combinaison de poids LLM et de code d'agent qui détermine fondamentalement la façon dont l'agent travaille.

En pratique, l'équipe Langchain n'a pas trouvé de systèmes d'agents qui mettent automatiquement à jour leurs LLM ou réécrivent leur code. Cependant, certains systèmes d'agents ont la capacité de mettre à jour dynamiquement leurs Invite du système Les arguments en faveur de.

2. la mémoire sémantique

Mémoire sémantique Il s'agit d'une réserve de connaissances à long terme permettant de stocker des connaissances factuelles.

- La mémoire sémantique chez l'homme. Il s'agit de divers éléments d'information, tels que des faits, des concepts et des relations entre eux, appris à l'école.

- Mémoire sémantique pour les agents. Le document CoALA décrit la mémoire sémantique comme un dépôt de connaissances factuelles.

Dans la pratique, la mémoire sémantique d'un agent est généralement obtenue en utilisant le LLM pour extraire des informations du dialogue de l'agent ou du processus d'interaction. La manière exacte dont les informations sont stockées dépend généralement de l'application spécifique. Lors des dialogues suivants, le système récupère ces informations stockées et les insère dans la mémoire sémantique de l'agent. Invite du système pour influencer la réponse de l'agent.

3. la mémoire épisodique

Mémoire épisodique Utilisé pour se souvenir d'événements passés spécifiques.

- Mémoire situationnelle chez l'homme. La mémoire situationnelle est utilisée lorsqu'une personne se souvient d'événements spécifiques (ou "épisodes") vécus dans le passé.

- Mémoire situationnelle pour l'agent. Le document CoALA définit la mémoire situationnelle comme une séquence qui stocke les actions passées d'un agent.

La mémoire de scénario est principalement utilisée pour s'assurer que l'agent fonctionne comme prévu. Dans la pratique, la mémoire situationnelle est généralement mise à jour par l'intermédiaire de la fonction Promesse de quelques coups de feu pour y parvenir. Si, dans la phase initiale, le système est passé par le système Promesse de quelques coups de feu Si l'agent reçoit l'instruction d'effectuer l'opération correctement, il peut directement réutiliser cette méthode d'opération lorsqu'il sera confronté à des problèmes similaires à l'avenir. Au contraire, s'il n'y a pas de méthode efficace pour guider l'agent à opérer correctement, ou si l'agent a besoin d'essayer constamment de nouvelles méthodes d'opération, alors l'agent ne peut pas utiliser cette méthode. Mémoire sémantique deviendra encore plus importante.Mémoire épisodique Le rôle dans ces scénarios est relativement limité.

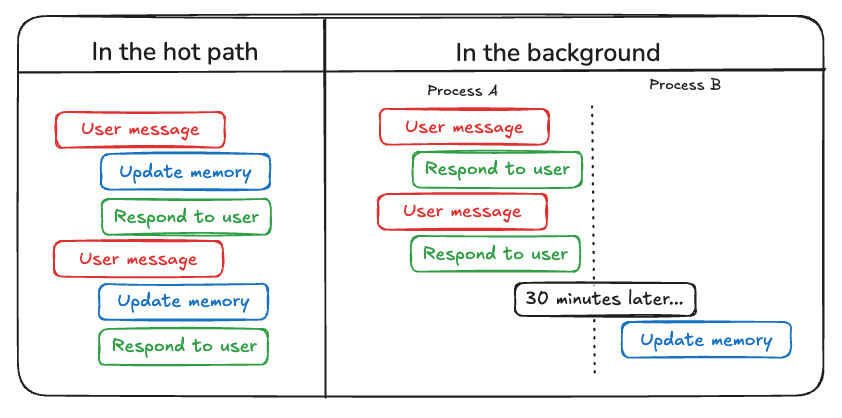

Outre les types de mémoires qui doivent être mises à jour dans Agent, les développeurs doivent tenir compte des éléments suivants Comment mettre à jour la mémoire de l'agent . Il existe actuellement deux méthodes principales pour mettre à jour la mémoire des agents :

La première méthode est "dans la voie du succès (mise à jour de la voie du succès)". . Dans ce modèle, le système d'agents mémorise les informations factuelles pertinentes en temps réel avant de générer une réponse (généralement obtenue par le biais d'un appel d'outil). ChatGPT utilise actuellement cette approche pour mettre à jour sa mémoire.

La deuxième méthode est "en arrière-plan (mise à jour de l'arrière-plan)" . Dans ce mode, un processus d'arrière-plan s'exécute de manière asynchrone à la fin de la session et met à jour la mémoire de l'agent en arrière-plan.

"dans la voie du succès (mise à jour de la voie du succès)". L'inconvénient de cette méthode est qu'avant qu'une réponse ne soit renvoyée, une certaine quantité de latence . En outre, il doit intégrer logique de la mémoire avec logique de l'agent Intégration étroite.

"en arrière-plan (mise à jour de l'arrière-plan)" évite efficacement le problème susmentionné, n'augmente pas le temps de latence de la réponse et la méthode logique de la mémoire peuvent rester relativement indépendants. Cependant, les "en arrière-plan (mise à jour de l'arrière-plan)" Elle présente également des inconvénients : la mémoire n'est pas mise à jour immédiatement et une logique supplémentaire est nécessaire pour déterminer quand lancer le processus de mise à jour en arrière-plan.

Une autre approche de la mise à jour des mémoires implique le retour d'informations de la part de l'utilisateur, qui est similaire à l'approche de la mise à jour des mémoires. Mémoire épisodique particulièrement pertinente. Par exemple, si un utilisateur attribue une note élevée à une interaction avec un agent (Rétroaction positive), l'agent peut enregistrer ce retour d'information pour y faire appel dans des scénarios similaires à l'avenir.

Sur la base de la compilation ci-dessus, AI Share estime que le développement simultané et les progrès continus des trois éléments clés, à savoir la capacité de planification, l'innovation en matière d'interaction et le mécanisme de mémoire, donneront lieu à des applications plus pratiques des agents d'intelligence artificielle en 2025 et nous mèneront vers une nouvelle ère de travail collaboratif homme-machine.

© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Articles connexes

Pas de commentaires...

![ICLR 惊现[10,10,10,10]满分论文,ControlNet作者新作——IC-Light V2适配Flux](https://aisharenet.com/wp-content/uploads/2024/12/8989dba3bb6d866.png)