2024 Rapport d'évaluation comparative des grands modèles chinois (SuperCLUE)

contextes

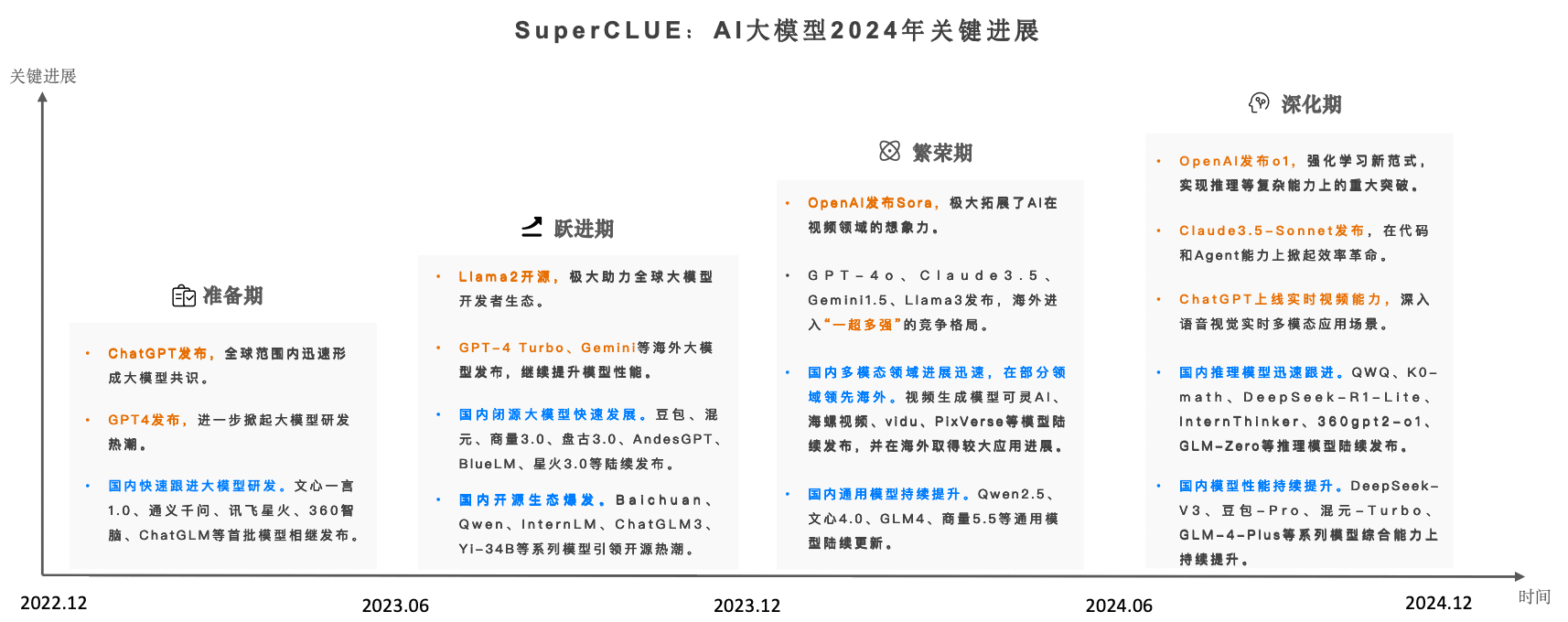

Depuis 2023, les grands modèles d'IA ont créé la plus grande vague d'IA jamais enregistrée à l'échelle mondiale. À l'aube de l'année 2024, la dynamique concurrentielle du grand modèle mondial s'intensifie et se renforce.Avec la sortie du Sora, du GPT-4o et du o1, les grands modèles nationaux ont connu une course-poursuite mouvementée en 2024.

L'outil de référence pour l'évaluation des grands modèles chinois, SuperCLUE, qui suit en permanence et en temps réel les tendances de développement et l'effet global des grands modèles en Chine et à l'étranger, est officiellement publié.Rapport annuel 2024 sur l'analyse comparative des grands modèles chinois.

Le rapport complet comprend 89 pages, cet article ne présente que le contenu essentiel du rapport, l'adresse du rapport complet est en ligne (téléchargeable) :

www.cluebenchmarks.com/superclue_2024

Adresse du tableau de bord SuperCLUE :

www.superclueai.com

Éléments clés du rapport

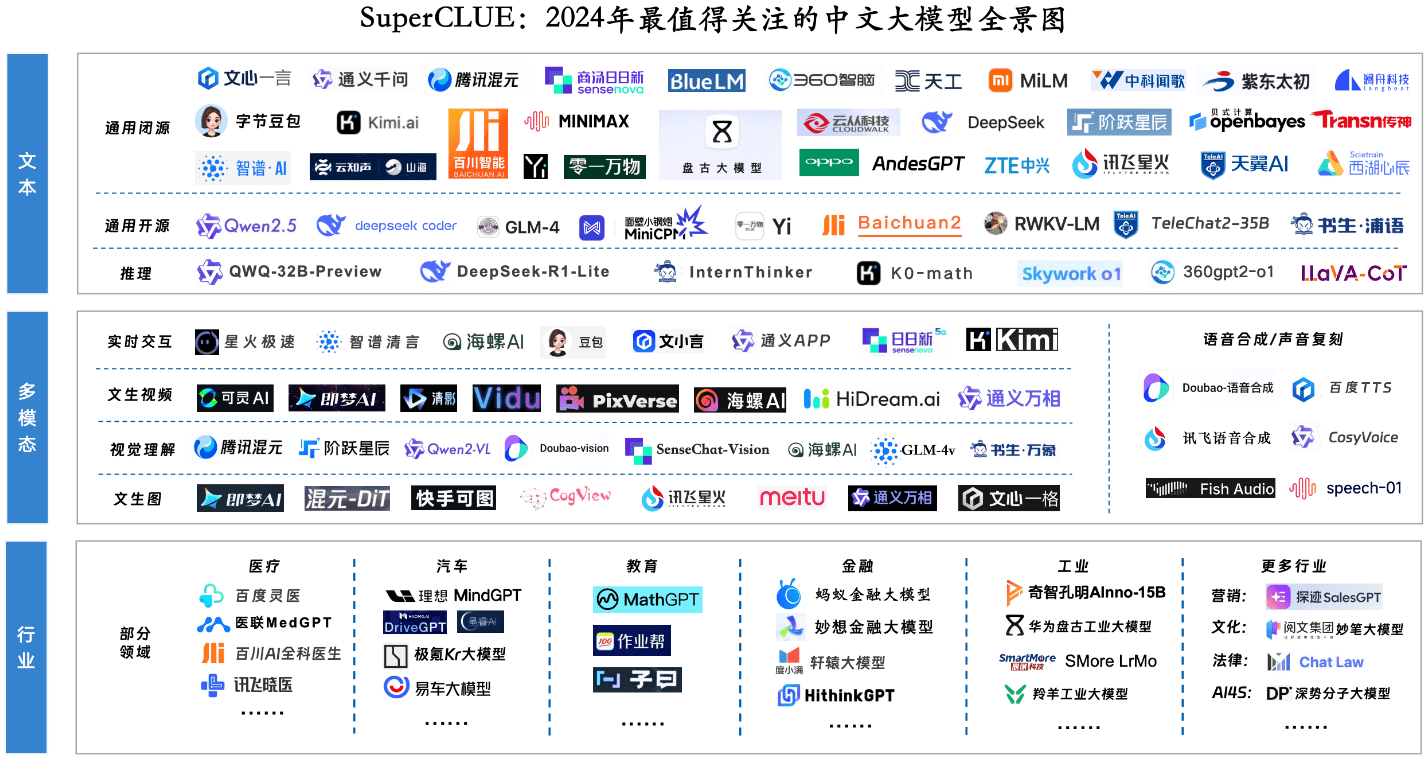

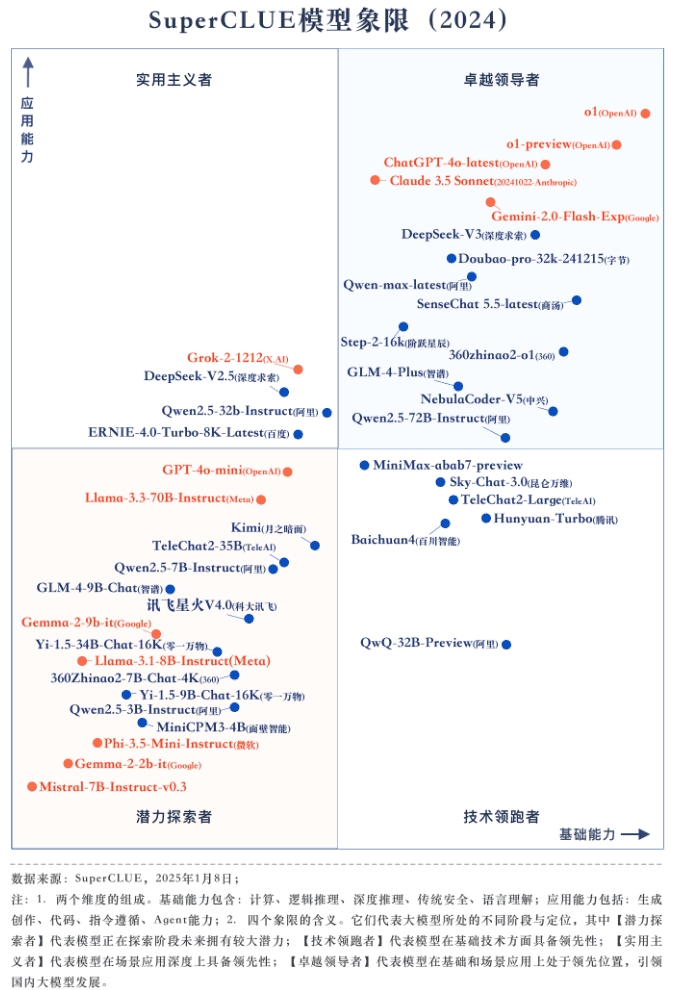

Composante clé 1 : Panorama des grands modèles les plus remarquables pour 2024

Composante clé 2 : classement général annuel et quadrant de modélisation

Introduction à l'évaluation

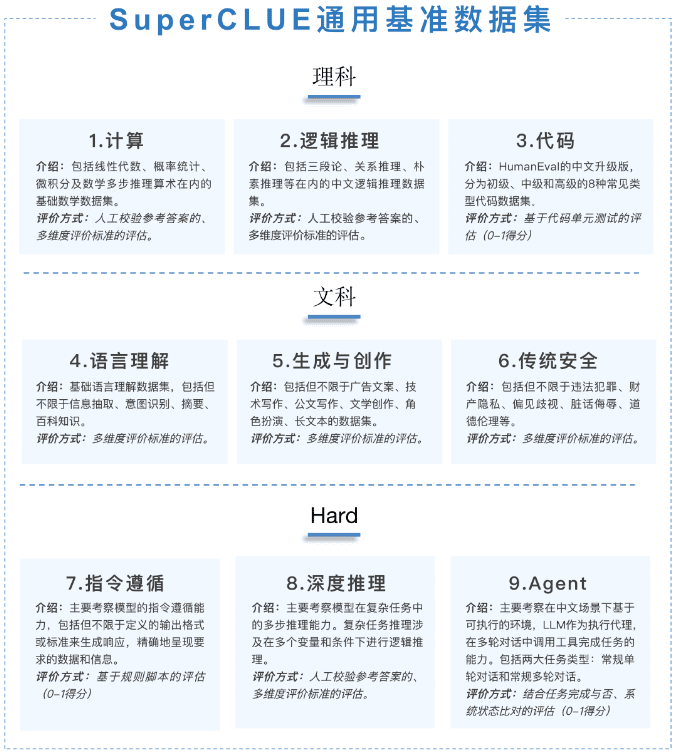

Ce rapport annuel se concentre sur l'évaluation des compétences générales (ECG), qui comprend trois dimensions : les sciences, les arts et le dur.Les questions sont toutes nouvelles et originalesavec un total de 1 325 questions à réponse courte à plusieurs tours.

Les [tâches scientifiques] sont divisées en ensembles d'évaluation de l'informatique, du raisonnement logique et du code ; les [tâches artistiques] sont divisées en ensembles d'évaluation de la compréhension du langage, de la création générative et de la sécurité ; et les [tâches difficiles] sont divisées en ensembles d'évaluation du suivi des instructions, du raisonnement profond et de l'agent.

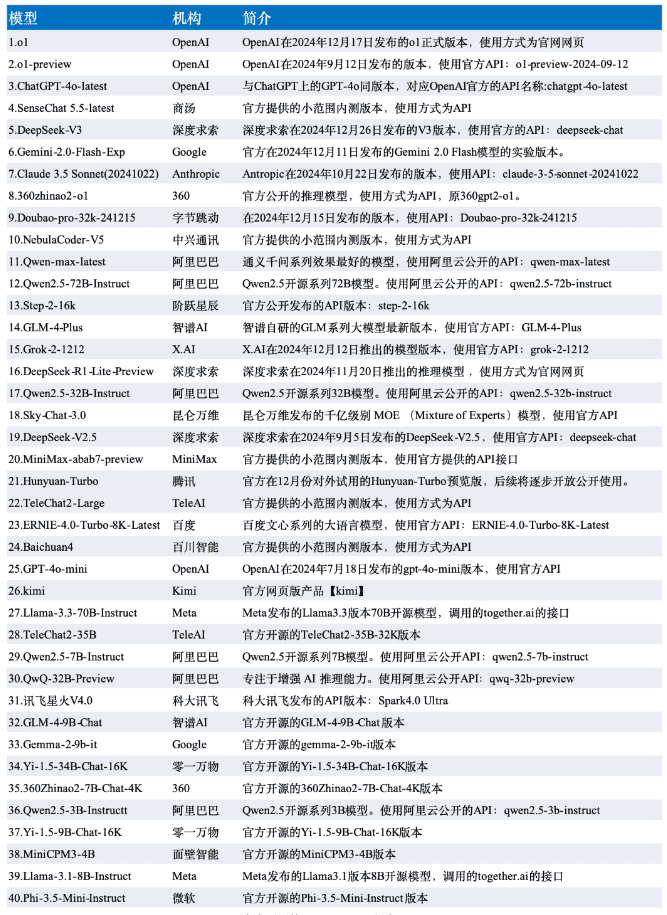

Les données de cette évaluation sont tirées des résultats de l'évaluation SuperCLUE-December, et le modèle est sélectionné parmi les 42 grands modèles représentatifs nationaux et internationaux de la version de décembre.

tableau de classement

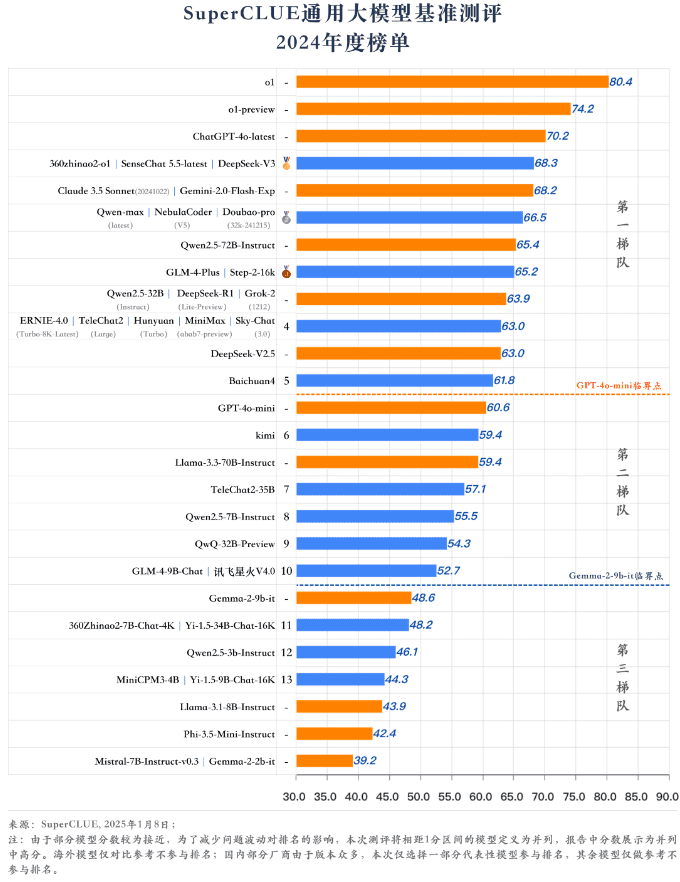

Modèle annuel quadrant

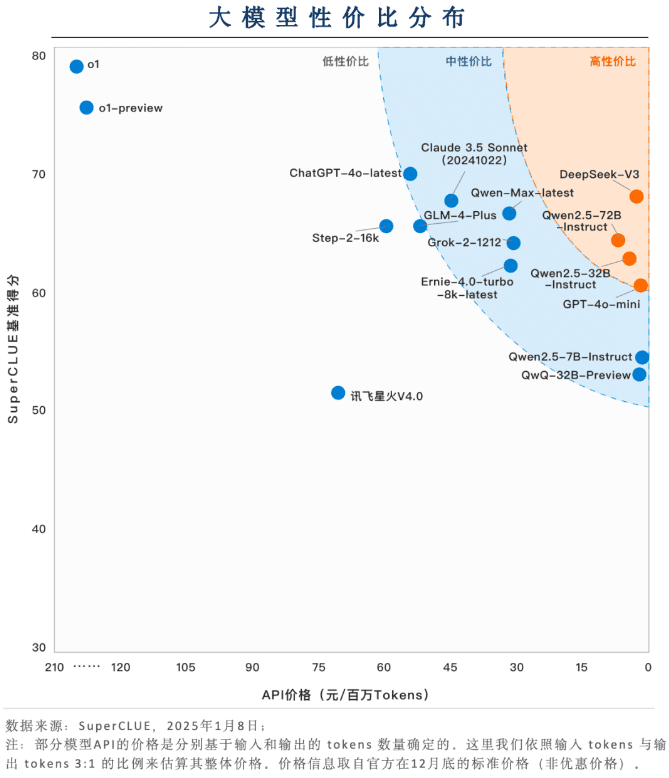

Élément clé 3 : Distribution des zones de valeur ajoutée

Les grands modèles nationaux ont un grand avantage en termes de rapport prix/performance (prix + efficacité).

Les grands modèles nationaux tels que DeepSeek-V3, Qwen2.5-72B-Instruct et Qwen2.5-32B-Instruct font preuve d'une grande compétitivité en termes de rapport prix/performance. Sur la base d'un niveau de capacité relativement élevé, il est possible de maintenir un coût d'application très bas, et l'application de l'atterrissage présente une facilité d'utilisation.

La plupart des modèles ont un rapport qualité-prix moyen.

La plupart des modèles restent à un prix élevé afin de maintenir un haut niveau de capacité. Par exemple, le GLM-4-Plus, le Qwen-Max-dernier, le Claude 3.5 Sonnet et le Grok-2-1212 sont tous proposés à un prix supérieur à 30 dollars par million de jetons.

o1 et d'autres modèles d'inférence ont une plus grande marge d'optimisation en termes de rapport prix/performance

Bien que o1 et o1-preview présentent un niveau élevé de capacité, ils sont plusieurs fois plus chers que les autres modèles en termes de prix. La réduction du coût pourrait devenir une condition préalable à l'utilisation généralisée des modèles d'inférence.

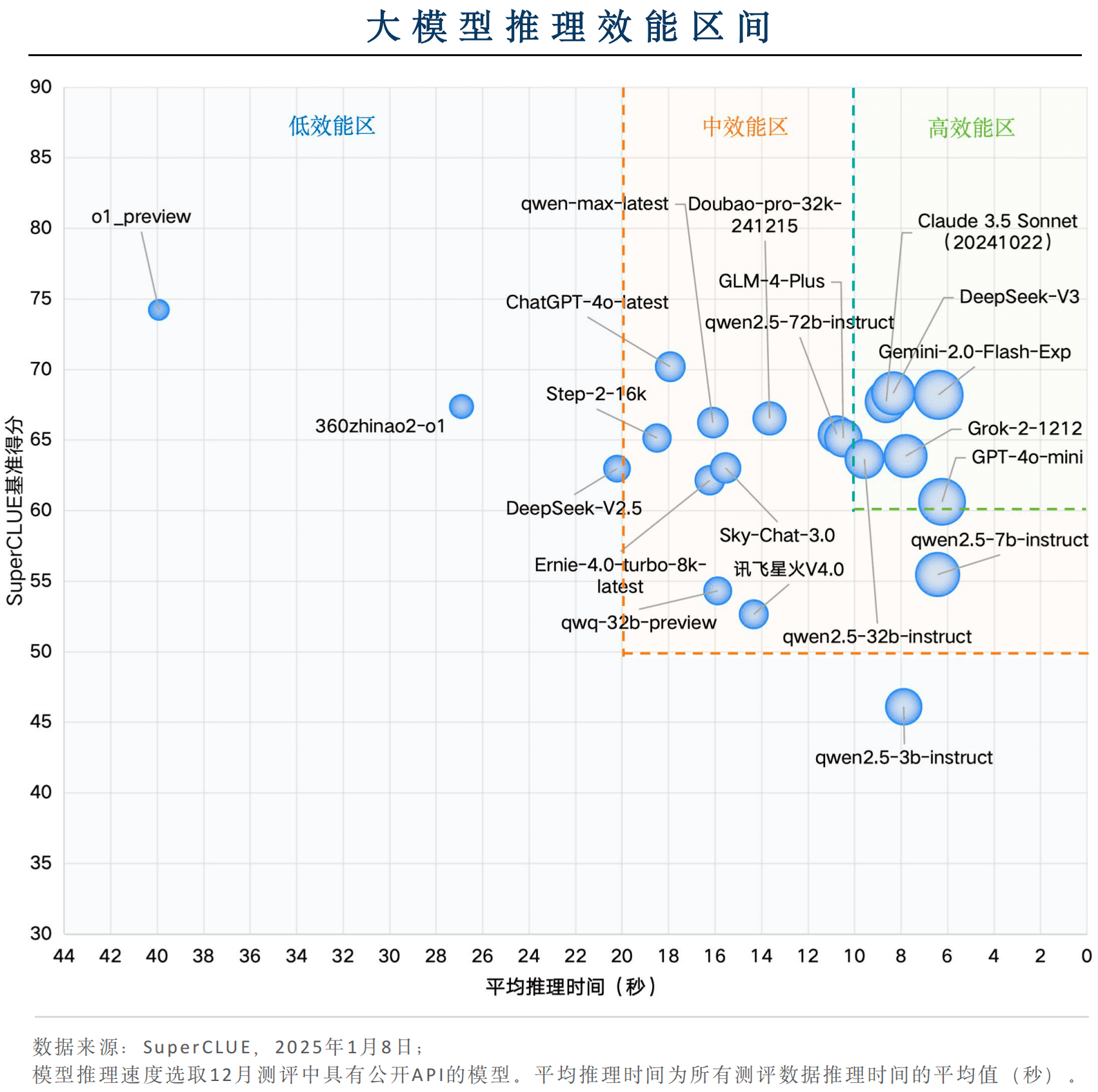

Composante clé 4 : raisonnement sur la distribution des intervalles d'efficacité

Certains modèles nationaux sont compétitifs en termes d'efficacité globale

Parmi les modèles nationaux, DeepSeek-V3 et Qwen2.5-32B-Instruct ont d'excellentes vitesses d'inférence, avec un temps d'inférence moyen de moins de 10 secondes par question, et en même temps, les scores de référence sont supérieurs à 60, ce qui est conforme à la "zone de haute performance" et montre une très grande efficacité de l'application.

Gemini-2.0-Flash-Exp, leader mondial de la performance des applications Big Model

Les modèles d'outre-mer Gemini-2.0-Flash-Exp, Claude 3.5 Sonnet (20241022), Grok-2-1212 et GPT-4o-mini se qualifient pour la "zone de haute performance", Gemini-2.0-Flash-Exp étant le plus performant en termes d'efficacité combinée pour ce qui est du temps d'inférence et du score de référence. GPT-4o-mini est le plus performant en termes de vitesse d'inférence.

modèle d'inférenceIl y a beaucoup de place pour l'optimisation en termes de performance.

Bien que le modèle d'inférence représenté par o1-preview obtienne de bons résultats, le temps d'inférence moyen par question est d'environ 40 secondes, et la performance globale se situe dans la "zone de faible performance". Afin de disposer d'un large éventail de scénarios d'application, le modèle d'inférence doit se concentrer sur l'amélioration de sa vitesse d'inférence.

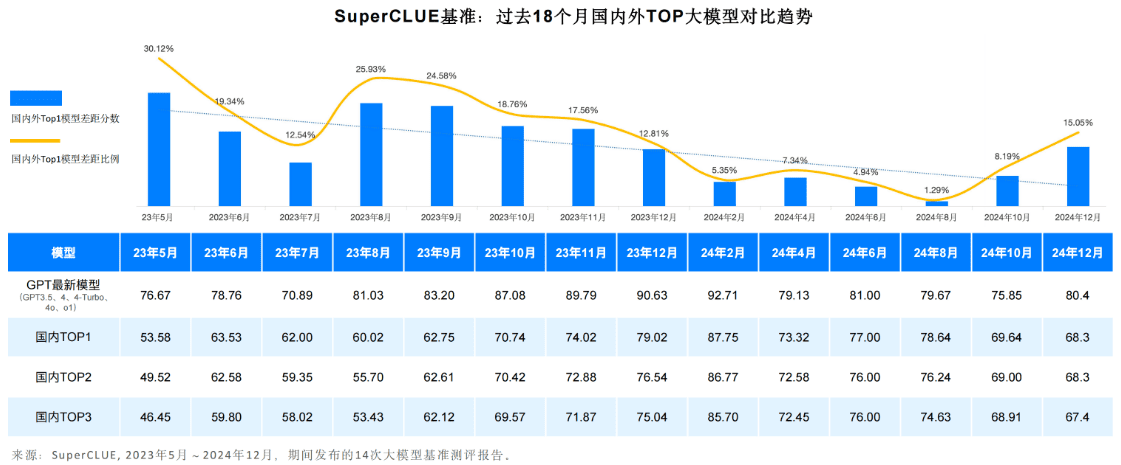

Composant clé 5 : Lacunes et tendances nationales et internationales en matière de modélisation à grande échelle, 2024

La tendance générale est que l'écart entre les capacités génériques des grands modèles nationaux et étrangers de premier rang dans le domaine chinois se creuse.

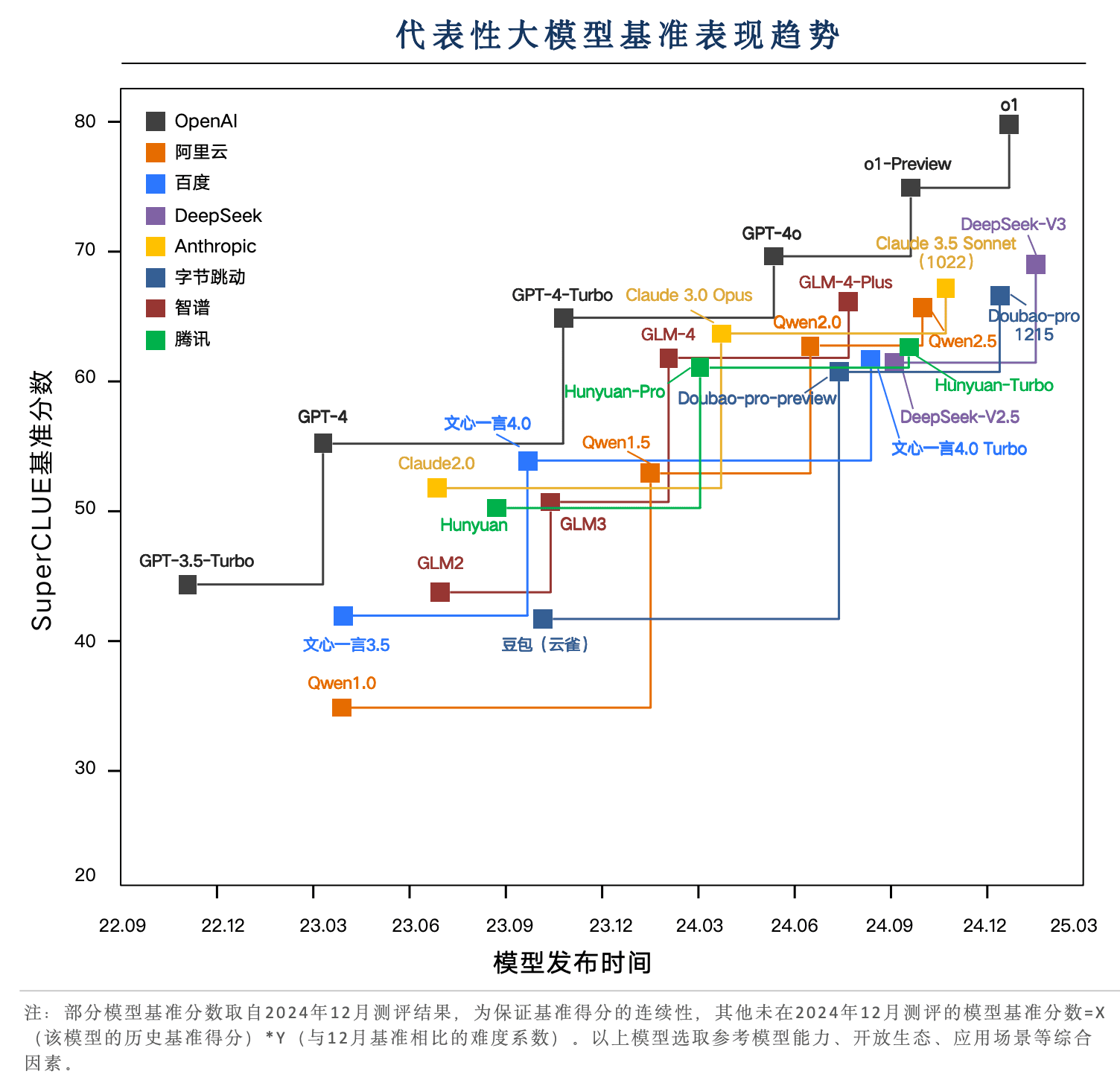

De mai 2023 à aujourd'hui, les capacités des grands modèles nationaux et étrangers n'ont cessé d'évoluer. Parmi eux, les meilleurs modèles d'outre-mer représentés par la série de modèles GPT ont connu de multiples itérations depuis le GPT3 . 5, GPT4, GPT4 - Turbo, GPT4o, o1 de multiples versions de mises à niveau itératives.

Le modèle national a également connu un cycle d'itération de 1 8 mois, réduisant l'écart de 0,121 TP3T en mai 2 0 2 3 à 1,291 TP3T en août 2024. mais avec la sortie de l'o1, l'écart s'est à nouveau creusé pour atteindre 15,051 TP3T.

Les modèles nationaux représentés par DeepSeek-V3 sont extrêmement proches de GPT-4o-latest

Au cours des deux dernières années, les modèles représentatifs nationaux ont été itérés en plusieurs versions, DeepSeek-V3, Doubao-pro, GLM-4-Plus, et Qwen2.5 ont été proches de GPT-4o dans les tâches chinoises, parmi lesquelles DeepSeek-V3 a obtenu de bons résultats, dépassant les performances de Claude 3.5 Sonnet lors de l'évaluation de décembre.

o1 Modèles de raisonnement basés sur le nouveau paradigme de l'apprentissage par renforcement, dépassant les 80 points pour creuser l'écart entre les meilleurs modèles nationaux et étrangers.

Lors de l'évaluation SuperCLUE en décembre, les principaux grands modèles nationaux et étrangers ont obtenu des scores de référence SuperCLUE concentrés entre 60 et 70 points. o1 et o1-preview, basés sur le nouveau paradigme du modèle d'inférence de l'apprentissage par renforcement, sont devenus une technologie importante représentative du dépassement du goulot d'étranglement des 70 points, en particulier la version formelle o1 de la percée de la marque des 80 points, montrant ainsi un large avantage de premier plan.

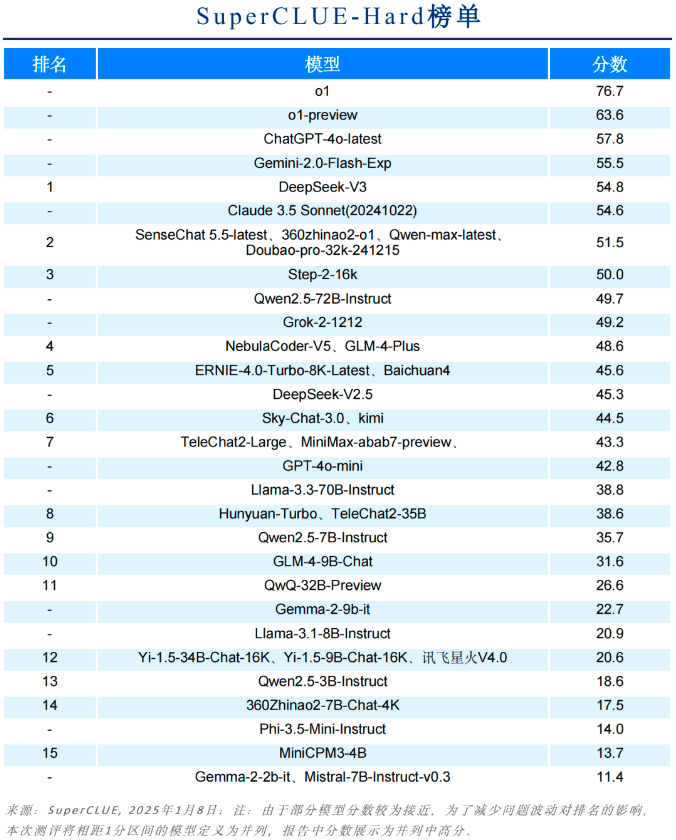

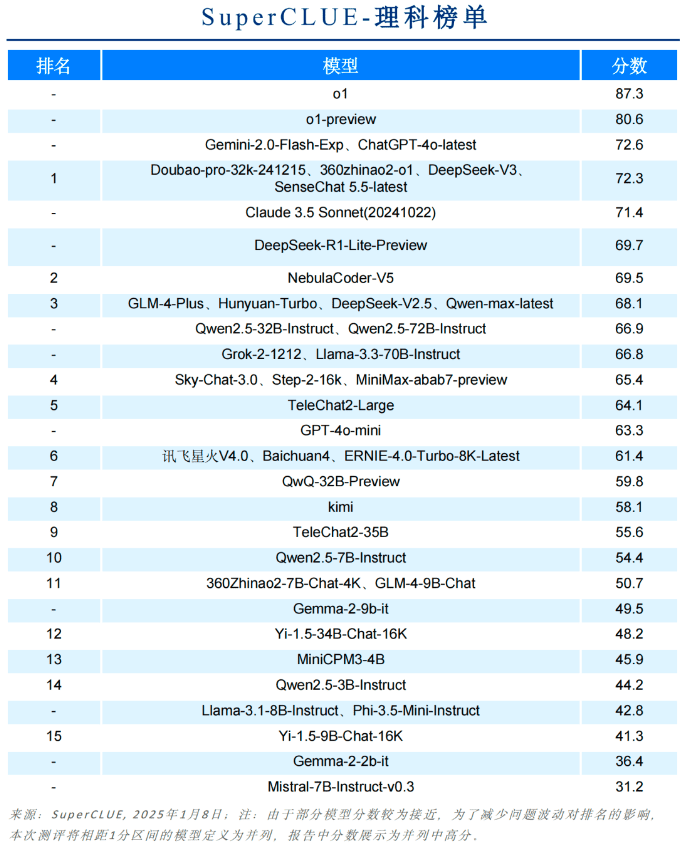

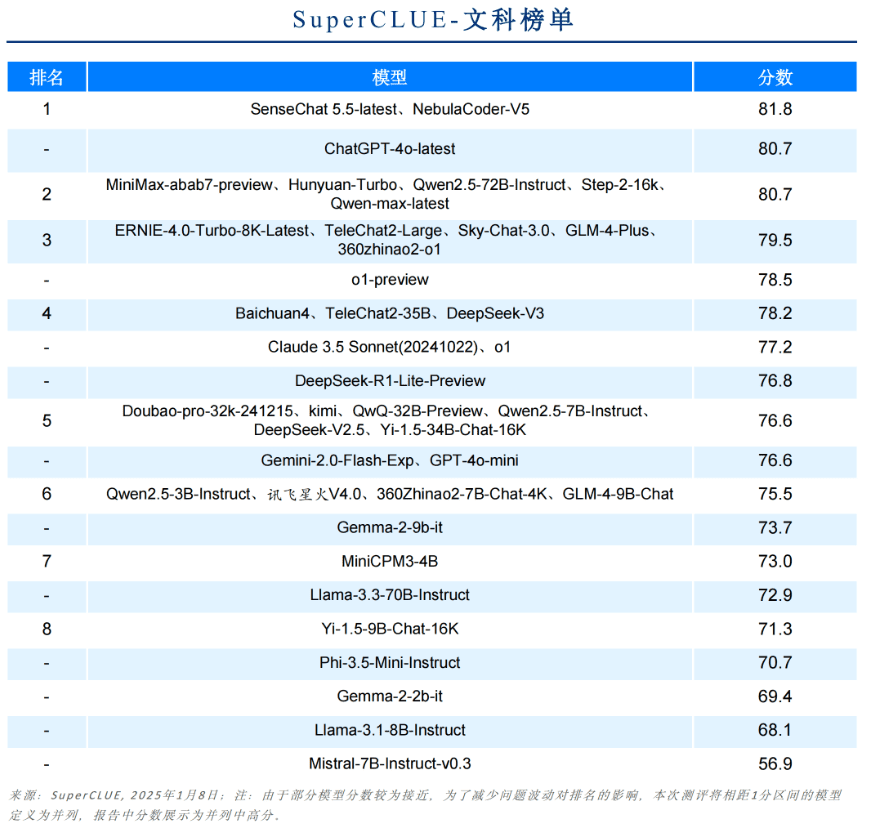

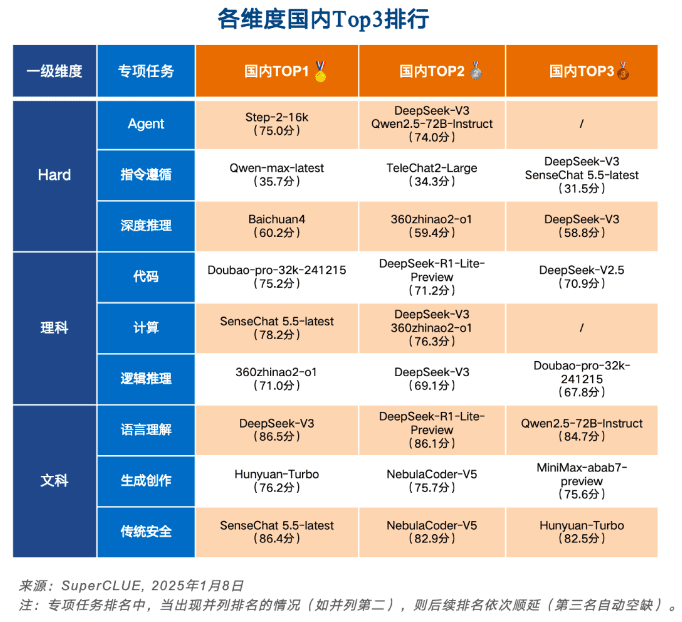

Élément clé 6 : Autres listes de sous-dimensions

Liste dure

Liste des sujets scientifiques

Liste des arts libéraux

Les trois premiers en Chine pour chaque dimension

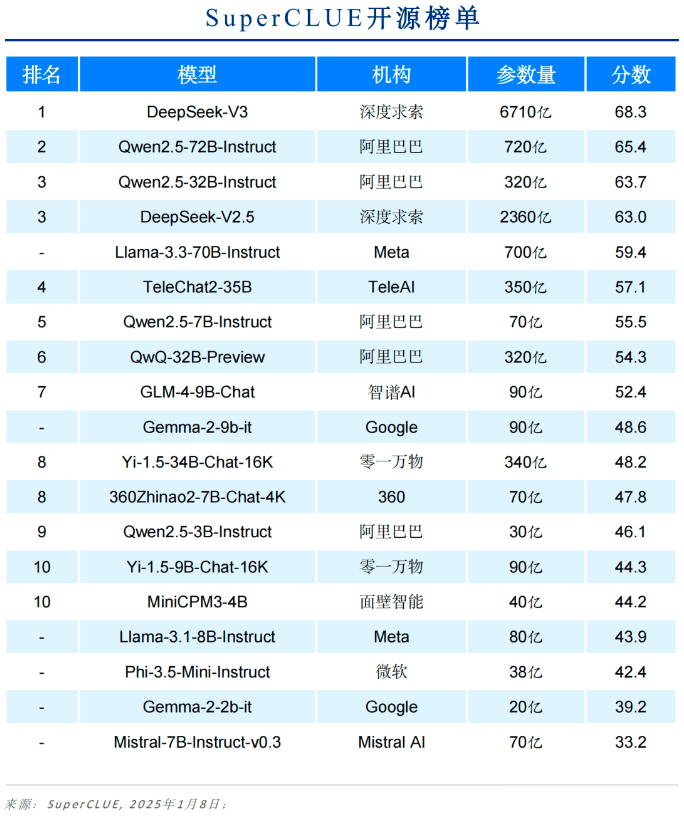

Liste des modèles Open Source

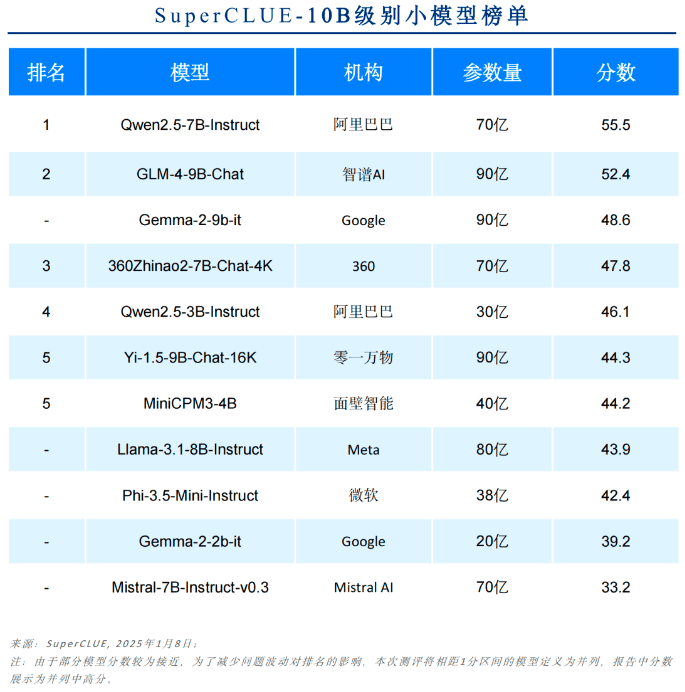

Liste des modèles jusqu'à 10B

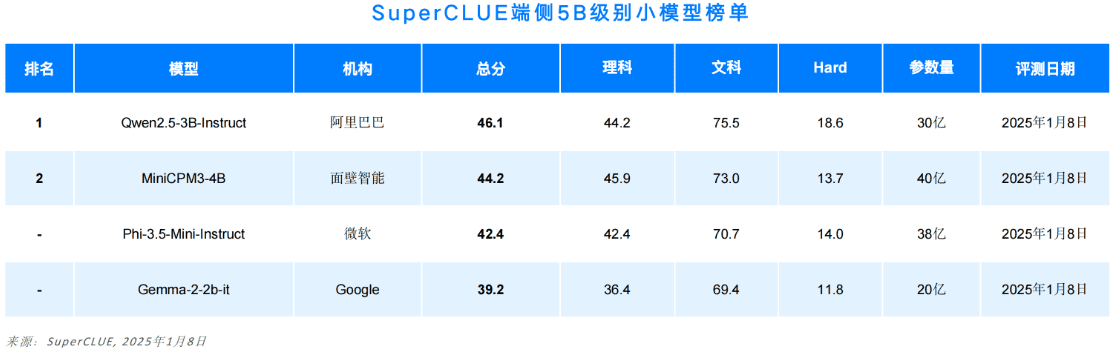

Liste des modèles d'extrémité jusqu'à 5B

Liste des notes secondaires à grain fin

Pour des raisons d'espace, ce document ne présente qu'une partie du rapport. Le contenu complet comprend la méthodologie d'évaluation, les exemples d'évaluation, les listes de sous-tâches, la multimodalité, les applications et l'introduction aux repères d'inférence.

© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Articles connexes

Pas de commentaires...