Google Veröffentlichungen Zwillinge 2.0 Neue Modelle der Flash-Serie, darunter Zwilling 2.0 Flash, undFlash-Lite im Gesang antworten Pro Drei neue Modelle, die Entwicklern schnellere, kostengünstigere und leistungsfähigere generative KI-Lösungen bieten sollen. Zwilling 2.0 Flash Jetzt vollständig verfügbar mit höherer Ratenbegrenzung und verbesserter Leistung;Flash-Lite die kostengünstigere Option ist; und Pro Versionen sind für die Codierung und komplexe Aufgaben optimiert. Die neuen Modellreihen unterstützen alle Millionen von Token Kontextfenster und bietet leistungsstarke Funktionen wie die Verwendung nativer Tools und multimodale Eingaben, die Entwicklern helfen, leistungsfähigere KI-Anwendungen zu erstellen. Darüber hinaus ist die Gemini 2.0 Flash Series deutlich preisgünstiger und bietet praktische Entwicklungstools und kostenlose Tiers, die Entwicklern den Einstieg erleichtern und eine schnelle Skalierung ihrer Anwendungen ermöglichen.

Gemini 2.0 Serie bietet Entwicklern mehr Optionen

Google hat heute spannende Updates angekündigt, die Gemini 2.0 für mehr Entwickler verfügbar machen und in die Produktion überführen sollen. Die folgenden Modelle sollen nun verfügbar sein über Google AI Studio und Vertex AI in Zwillings-API Bereitgestellt in:

- Zwilling 2.0 Flash Jetzt in vollem Umfang verfügbar mit höheren Ratenobergrenzen, verbesserter Leistung und vereinfachter Preisgestaltung.

- Gemini 2.0 Flash-Lite Dabei handelt es sich um eine neue Variante und das bisher kostengünstigste Modell von Google, das jetzt in der öffentlichen Vorschau zu sehen ist.

- Gemini 2.0 Pro, ein experimentelles Update von Googles bisher bestem Modell für Kodierung und komplexe Hinweise, ist jetzt verfügbar.

Zusätzlich zu dem kürzlich veröffentlichten Gemini 2.0 Flash Thinking Experimental, einer Flash-Variante mit Argumentation vor der Antwort, ermöglichen diese neuen Versionen die Anwendung der Funktionalität von Gemini 2.0 auf eine breitere Palette von Anwendungsfällen und Anwendungsszenarien.

Merkmale des Modells

Gemini 2.0 Flash bietet umfassende Funktionen, darunter die Verwendung nativer Tools, ein Kontextfenster mit 1 Million Token und multimodale Eingaben. Derzeit wird die Textausgabe unterstützt, während die allgemeine Verfügbarkeit von Bild- und Audioausgabefunktionen und einer multimodalen Live-API für die kommenden Monate geplant ist.Gemini 2.0 Flash-Lite ist kostenoptimiert für Anwendungsfälle mit umfangreicher Textausgabe.

Leistung des Modells

Das Modell Gemini 2.0 erzielt in einer Reihe von Benchmarks deutliche Leistungssteigerungen gegenüber Gemini 1.5.

Ähnlich wie bei den Vorgängermodellen wird bei Gemini 2.0 Flash standardmäßig ein sauberer Stil verwendet, was die Nutzung erleichtert und die Kosten reduziert. Darüber hinaus kann es aufgefordert werden, aufwändigere Stile zu verwenden, um bessere Ergebnisse in chatorientierten Anwendungsfällen zu erzielen.

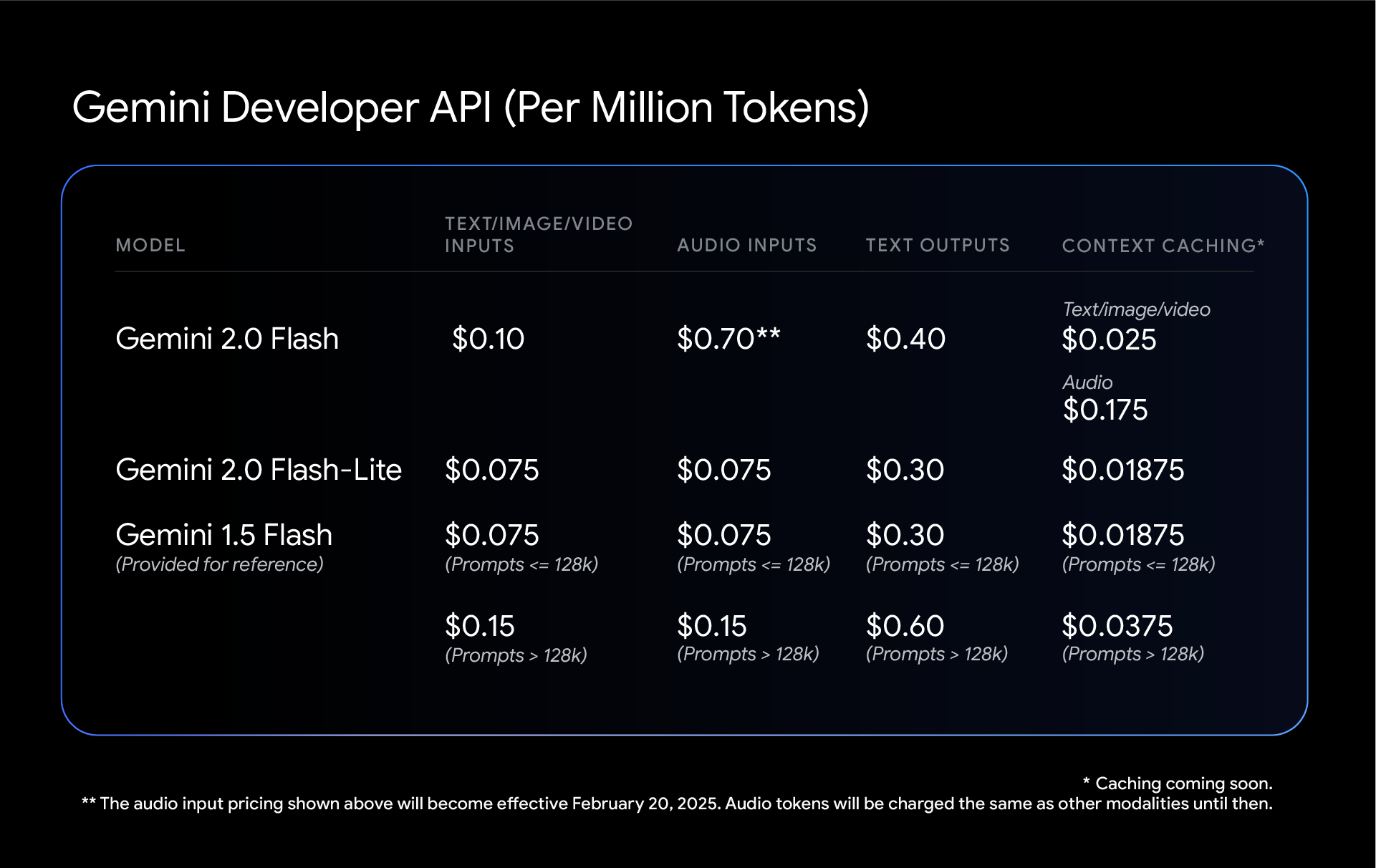

Zwillinge Preisgestaltung

Mit Gemini 2.0 Flash und 2.0 Flash-Lite senkt Google weiter die Kosten. Beide Modelle haben einen einzigen Preis pro Eingabetyp, wodurch die Unterscheidung zwischen kurzen und langen Kontextanfragen, die Gemini 1.5 Flash machte, wegfällt. Das bedeutet, dass sowohl 2.0 Flash als auch Flash-Lite zwar Leistungsverbesserungen bieten, aber bei gemischten Kontext-Workloads kostengünstiger sein können als Gemini 1.5 Flash.

Anmerkung: Beim Gemini-Modell entspricht ein Tonkes etwa 4 Zeichen. 100 Lemmata entsprechen etwa 60-80 englischen Wörtern.