Allgemeine Einführung

Together AI ist eine Plattform, die sich auf generative KI-Modelle konzentriert und eine breite Palette von Dienstleistungen vom Modelltraining über die Feinabstimmung bis hin zur Inferenz anbietet. Benutzer können die hocheffiziente Inferenz-Engine und die GPU-Cluster von Together AI nutzen, um eine Vielzahl von Open-Source-Modellen schnell einzusetzen und auszuführen. Die Plattform unterstützt mehrere Modellarchitekturen, um unterschiedliche Anforderungen von KI-Anwendungen zu erfüllen.

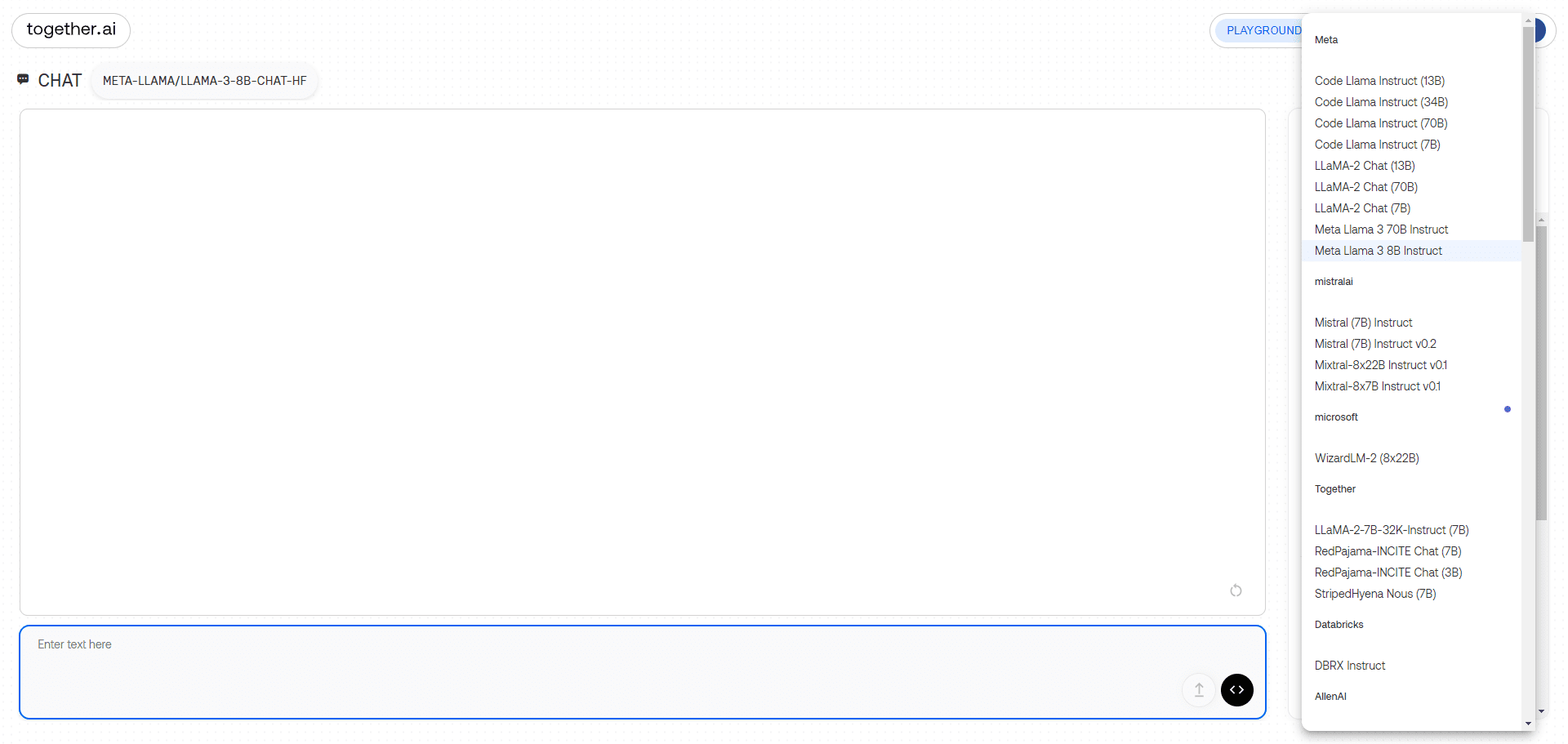

Große Modell-Chat-Demo-Schnittstelle

Funktionsliste

- Inferenz-APIUnterstützt das Reasoning auf mehr als 100 Open-Source-Modellen und bietet sowohl serverlose als auch dedizierte Instanzmodelle.

- FeinabstimmungsfunktionErmöglicht den Nutzern die Feinabstimmung generativer KI-Modelle unter Verwendung ihrer eigenen Daten, wobei das Eigentum an den Daten erhalten bleibt.

- GPU-ClusterBietet hochmoderne Cluster mit 16 bis 1000+ GPUs zur Unterstützung des Modelltrainings in großem Maßstab.

- Benutzerdefinierte ModellschulungTrainieren Sie hochmoderne Modelle von Grund auf und unterstützen Sie mehrere Modellarchitekturen.

- multimodales ModellUnterstützt Bilderkennung, Bildinferenz, Bilderzeugung und mehr.

- Effiziente InferenzmaschineIntegration der neuesten Inferenztechnologien wie FlashAttention-3 und Flash-Decoding zur Bereitstellung schneller und präziser Inferenzdienste.

Hilfe verwenden

Installation und Nutzung

- Registrieren & Anmelden::

- Besuchen Sie die Website von Together AI (https://www.together.ai/) und klicken Sie auf die Schaltfläche "Start Building", um sich zu registrieren.

- Sobald die Registrierung abgeschlossen ist, melden Sie sich bei Ihrem Konto an und gehen Sie zum Benutzer-Kontrollzentrum.

- Dienst auswählen::

- Wählen Sie im Bedienfeld das zu verwendende Servicemodul aus, z. B. die Inferenz-API, die Feinabstimmungsfunktion oder den GPU-Cluster.

- Wählen Sie je nach Bedarf den serverlosen oder den dedizierten Instanzmodus.

- Verwendung der Inferenz-API::

- Wählen Sie das Open-Source-Modell aus, das Sie ausführen möchten, z. B. Llama-3, RedPajama, usw.

- Integrieren Sie das Modell über die von Together AI bereitgestellte API-Schnittstelle in Ihre Anwendung.

- Erstellen Sie Ihre eigene RAG-Anwendung mit den eingebetteten Endpunkten von Together AI.

- Feinabstimmungsfunktion::

- Laden Sie Ihren Datensatz hoch und wählen Sie die Modelle aus, die einer Feinabstimmung unterzogen werden müssen.

- Konfigurieren Sie die Feinabstimmungsparameter, um den Feinabstimmungsprozess zu starten.

- Sobald die Feinabstimmung abgeschlossen ist, laden Sie das feinabgestimmte Modell herunter und stellen es bereit.

- GPU-Cluster-Nutzung::

- Wählen Sie die gewünschte GPU-Clustergröße aus und konfigurieren Sie die Hardwareparameter.

- Laden Sie Trainingsdaten und Modellcode hoch, um mit dem Training zu beginnen.

- Nach Abschluss des Trainings wird das trainierte Modell zur Inferenz oder weiteren Feinabstimmung heruntergeladen.

- Benutzerdefinierte Modellschulung::

- Wählen Sie das Modul Custom Model Training, um die Modellarchitektur und die Trainingsparameter zu konfigurieren.

- Laden Sie den Datensatz hoch und starten Sie den Trainingsprozess.

- Sobald das Training abgeschlossen ist, wird das Modell heruntergeladen, um es einzusetzen und Schlussfolgerungen zu ziehen.

Arbeitsablauf

- Zugriff auf das BedienfeldNach dem Einloggen gehen Sie zum Bedienfeld und wählen das gewünschte Servicemodul aus.

- KonfigurationsparameterKonfigurieren Sie die Inferenz-, Feinabstimmungs- oder Trainingsparameter nach Bedarf.

- Daten hochladenUpload des gewünschten Datensatzes oder Modellcodes.

- Beginn der MissionInitiieren Sie Denk-, Feinabstimmungs- oder Trainingsaufgaben und überwachen Sie den Fortschritt der Aufgaben in Echtzeit.

- Ergebnisse herunterladenNach Abschluss der Aufgabe werden die Modell- oder Inferenzergebnisse zur Anwendungsintegration heruntergeladen.

allgemeine Probleme

- Wie wählt man das richtige Modell?

- Wählen Sie das geeignete Open-Source-Modell je nach Anwendungsszenario, z. B. Texterstellung, Bilderkennung usw.

- Was ist, wenn ich bei der Feinabstimmung auf einen Fehler stoße?

- Überprüfen Sie das Datensatzformat und die Parameterkonfigurationen und ziehen Sie die offizielle Dokumentation für Anpassungen zu Rate.

- Schlechte Leistung bei der Nutzung von GPU-Clustern?

- Vergewissern Sie sich, dass die Hardwarekonfiguration den Anforderungen entspricht, und passen Sie die Trainingsparameter an, um die Effizienz zu verbessern.

brauchbares Modell

| Serverlose Endpunkte | Autor | Typ | Preisgestaltung (pro 1M) Token) | |

|---|---|---|---|---|

| Meta Llama 3.2 11B Vision Instruct Turbo | ||||

| Meta | Chat | $0.18 | ||

| Meta Llama 3.2 90B Vision Instruct Turbo | ||||

| Meta | Chat | $1.20 | ||

| Qwen2.5 7B Instruct Turbo | ||||

| Qwen | Chat | $0.30 | ||

| Qwen2.5 72B Instruct Turbo | ||||

| Qwen | Chat | $1.20 | ||

| FLUX.1 [schnell] | ||||

| Schwarzwald-Labore | Bild | Siehe Preise | ||

| FLUX 1.1 [pro] | ||||

| Schwarzwald-Labore | Bild | Siehe Preise | ||

| FLUX.1 [pro] | ||||

| Schwarzwald-Labore | Bild | Siehe Preise | ||

| FLUX.1 [schnell] Kostenlos | ||||

| Schwarzwald-Labore | Bild | Siehe Preise | ||

| Meta Llama 3.2 3B Instruct Turbo | ||||

| Meta | Chat | $0.06 | ||

| Meta Llama Vision Free | ||||

| Meta | Chat | Kostenlos | ||

| Meta Llama Guard 3 11B Vision Turbo | ||||

| Meta | Moderation | $0.18 | ||

| Meta Llama 3.1 8B Instruct Turbo | ||||

| Meta | Chat | $0.18 | ||

| Mixtral-8x22B Anleitung v0.1 | ||||

| mistralai | Chat | $1.20 | ||

| Stabile Diffusion XL 1.0 | ||||

| Stabilität AI | Bild | Siehe Preise | ||

| Meta Llama 3.1 70B Instruct Turbo | ||||

| Meta | Chat | $0.88 | ||

| Meta Llama 3.1 405B Instruct Turbo | ||||

| Meta | Chat | $3.50 | ||

| Gryphe MythoMax L2 Lite (13B) | ||||

| Gryphe | Chat | $0.10 | ||

| Salesforce Llama Rang V1 (8B) | ||||

| Vertriebsmitarbeiter | neu bewerten | $0.10 | ||

| Meta Llama-Wächter 3 8B | ||||

| Meta | Moderation | $0.20 | ||

| Meta Llama 3 70B Instruct Turbo | ||||

| Meta | Chat | $0.88 | ||

| Meta Llama 3 70B Instruct Lite | ||||

| Meta | Chat | $0.54 | ||

| Meta Llama 3 8B Instruct Lite | ||||

| Meta | Chat | $0.10 | ||

| Meta Llama 3 8B Instruct Turbo | ||||

| Meta | Chat | $0.18 | ||

| Meta Llama 3 70B Anleitung Referenz | ||||

| Meta | Chat | $0.90 | ||

| Meta Llama 3 8B Anleitungsreferenz | ||||

| Meta | Chat | $0.20 | ||

| Qwen 2 Unterweisung (72B) | ||||

| Qwen | Chat | $0.90 | ||

| Gemma-2 Instruct (27B) | ||||

| Google Internet-Unternehmen | Chat | $0.80 | ||

| Gemma-2 Unterweisung (9B) | ||||

| Chat | $0.30 | |||

| Mistral (7B) Anweisung v0.3 | ||||

| mistralai | Chat | $0.20 | ||

| Qwen 1.5 Chat (110B) | ||||

| Qwen | Chat | $1.80 | ||

| Meta Llama-Wächter 2 8B | ||||

| Meta | Moderation | $0.20 | ||

| WizardLM-2 (8x22B) | ||||

| microsoft | Chat | $1.20 | ||

| DBRX-Anweisung | ||||

| Datenbausteine | Chat | $1.20 | ||

| DeepSeek LLM-Chat (67B) | ||||

| DeepSeek | Chat | $0.90 | ||

| Gemma Instruct (2B) | ||||

| Google Internet-Unternehmen | Chat | $0.10 | ||

| Mistral (7B) Anleitung v0.2 | ||||

| mistralai | Chat | $0.20 | ||

| Mixtral-8x7B Instruct v0.1 | ||||

| mistralai | Chat | $0.60 | ||

| Mixtral-8x7B v0.1 | ||||

| mistralai | Sprache | $0.60 | ||

| Qwen 1.5 Chat (72B) | ||||

| Qwen | Chat | $0.90 | ||

| Lama-Wächter (7B) | ||||

| Meta | Moderation | $0.20 | ||

| Nous Hermes 2 - Mixtral 8x7B-DPO | ||||

| NousResearch | Chat | $0.60 | ||

| Mistral (7B) Anweisung | ||||

| mistralai | Chat | $0.20 | ||

| Mistral (7B) | ||||

| mistralai | Sprache | $0.20 | ||

| LLaMA-2 Chat (13B) | ||||

| Meta | Chat | $0.22 | ||

| LLaMA-2 Chat (7B) | ||||

| Meta | Chat | $0.20 | ||

| LLaMA-2 (70B) | ||||

| Meta | Sprache | $0.90 | ||

| Code Llama Instruct (34B) | ||||

| Meta | Chat | $0.78 | ||

| Upstage SOLAR Instruct v1 (11B) | ||||

| upstage | Chat | $0.30 | ||

| M2-BERT-Abruf-32k | ||||

| Gemeinsam | einbetten. | $0.01 | ||

| M2-BERT-Abruf-8k | ||||

| Gemeinsam | einbetten. | $0.01 | ||

| M2-BERT-Wiederherstellung-2K | ||||

| Gemeinsam | einbetten. | $0.01 | ||

| UAE-Groß-V1 | ||||

| WoIsAI | einbetten. | $0.02 | ||

| BAAI-Bge-Groß-1p5 | ||||

| BAAI | einbetten. | $0.02 | ||

| BAAI-Bge-Basis-1p5 | ||||

| BAAI | einbetten. | $0.01 | ||

| MythoMax-L2 (13B) | ||||

| Gryphe | Chat | $0.30 |

Anwendungsbeispiel

Beispiele für Modellüberlegungen

importieren os

importieren Anfragen

url = "https://api.together.xyz/v1/chat/completions"

Nutzlast = {

"Modell": "mistralai/Mixtral-8x7B-Instruct-v0.1",

"max_tokens": 512,

"Temperatur": 0.7,

"top_p": 0.7,

"top_k": 50,

"wiederholung_strafen": 1

}

headers = {

"akzeptieren": "application/json",

"Inhaltstyp": "application/json",

"Autorisierung": "Überbringer TOGETHER_API_KEY"

}

response = requests.post(url, json=payload, headers=headers)

drucken(Antwort.Text)

Beispiel für die Feinabstimmung des Modells

importieren os

importieren Anfragen

url = "https://api.together.xyz/v1/fine-tune"

Nutzlast = {

"Modell": "zusammencomputer/llama-2-70b-chat",

"Daten": "pfad/zu/ihren/daten",

"Epochen": 3,

"batch_size": 8

}

headers = {

"akzeptieren": "application/json",

"Inhaltstyp": "application/json",

"Autorisierung": "Überbringer TOGETHER_API_KEY"

}

response = requests.post(url, json=payload, headers=headers)

drucken(Antwort.Text)