Wisdom Spectrum unterstützt 128K-Kontext/4K-Ausgangslänge großes Modell GLM-4-Flash volles Volumen frei offen!

Seit dem 27. August stellt Wisdom Spectrum die GLM-4-Flash API der Öffentlichkeit kostenlos zur Verfügung. In einem 3-tägigen Englisch-Chinesischen Übersetzungstest vergleicht GLM-4-Flash das GLM-4-9b von Silicon Flow und das OpenRouter: Einheitliche Schnittstelle für die Integration mehrerer LLMs, freie Schnittstelle für große Modelle Es ist nicht weniger effektiv oder schneller als die vielen kostenlosen Modell-APIs, die vom RIP angeboten werden.

GLM-4-9b hat zuvor eine kostenlose API auf der SILICONFLOW (Silicon Flow): Beschleunigung der AGI für die Menschheit, Integration einer kostenlosen Schnittstelle für große Modelle GLM-4-Flash und GLM-4-9b unterscheiden sich in Bezug auf die Modellgröße, die Anzahl der Parameter, die Anwendungsszenarien usw. Außerdem sind beide kostenlose APIs und bieten beide kostenlose Dienste an - wie sollten wir uns entscheiden?

Man kann sagen, dass das Modell GLM-4-Flash sowohl in Bezug auf die "Geschwindigkeit" als auch auf die "Leistung" einen großen Vorteil hat.

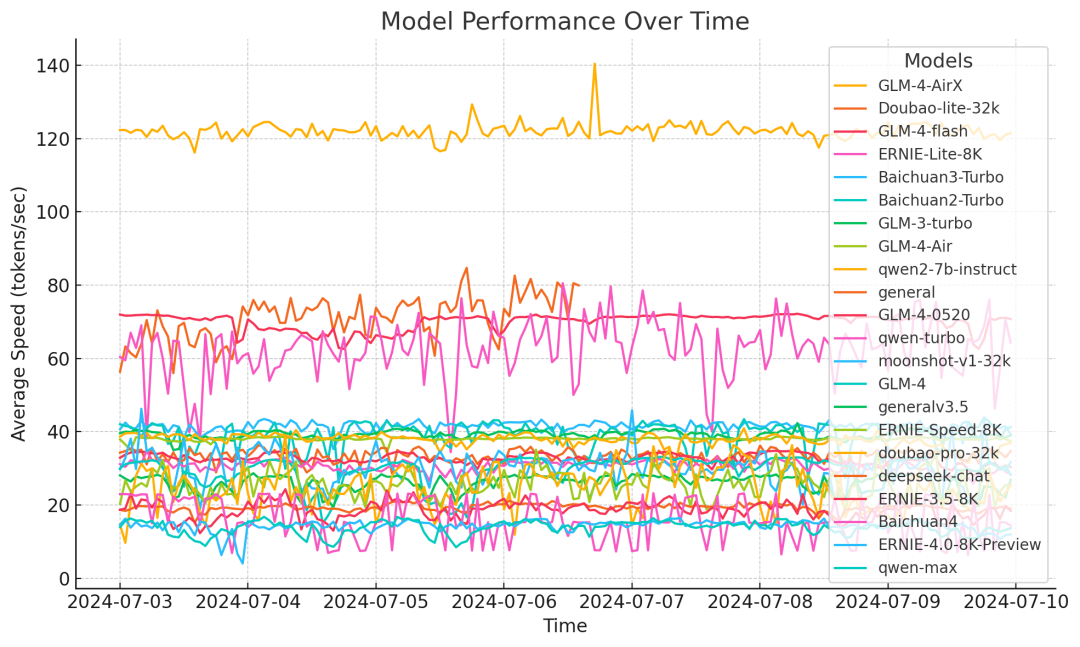

Um die Inferenzgeschwindigkeit des Modells zu verbessern, wendet GLM-4-Flash eine Reihe von Optimierungsmaßnahmen an, wie z. B. adaptive Gewichtsquantisierung, mehrere parallele Verarbeitungstechniken, Stapelverarbeitungsstrategie und spekulatives Sampling. Nach den Testergebnissen von Drittanbietern liegt die Inferenzgeschwindigkeit von GLM-4-Flash in einem einwöchigen Testzyklus stabil bei 72,14 Token/s, was deutlich besser ist als bei anderen Modellen.

In Bezug auf die Leistung verwendet GLM-4-Flash bis zu 10T hochwertige mehrsprachige Daten in der Pre-Trainingsphase des Modells, was das Modell in die Lage versetzt, auf Dialoge mit mehreren Runden, Websuchen, Tool-Aufrufe und lange Texte (mit Unterstützung für Kontextlängen von bis zu 128K) zu schließen.Ausgabe 4K Länge), usw. Es werden 26 Sprachen unterstützt, darunter Chinesisch, Englisch, Japanisch, Koreanisch und Deutsch.

Auf der Grundlage der völlig freien und offenen GLM-4-Flash-API bieten wir gleichzeitig Funktionen zur Feinabstimmung des Modells an, um den Bedürfnissen verschiedener Nutzer gerecht zu werden und das Modell besser auf spezifische Anwendungsszenarien anwenden zu können. Willkommen zur Nutzung!

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...