Intelligent Agentic Retrieval Enhanced Generation: ein Überblick über die Agentic RAG-Technologie

Abstracts

Große Sprachmodelle (Large Language Models, LLMs) wie GPT-4 von OpenAI, PaLM von Google und LLaMA von Meta haben die Künstliche Intelligenz (KI) grundlegend verändert, indem sie eine menschenähnliche Texterzeugung und ein natürliches Sprachverständnis ermöglichen. Ihre Abhängigkeit von statischen Trainingsdaten schränkt jedoch ihre Fähigkeit ein, auf dynamische Echtzeit-Anfragen zu reagieren, was zu veralteten oder ungenauen Ergebnissen führt. Retrieval Augmented Generation (RAG) hat sich als eine Lösung zur Erweiterung von LLMs durch die Integration von Echtzeit-Datenabfragen herauskristallisiert, um kontextuell relevante und zeitnahe Antworten zu liefern. Trotz der vielversprechenden Möglichkeiten von RAG sind herkömmliche RAG-Systeme in Bezug auf statische Arbeitsabläufe und mangelnde Flexibilität begrenzt, die für mehrstufige Schlussfolgerungen und komplexes Aufgabenmanagement erforderlich sind.

Agentic Retrieval Augmented Generation (Agentic RAG) überwindet diese Einschränkungen, indem es autonome KI-Agenten in den RAG-Prozess einbindet. Diese Agenten nutzen agenturische Entwurfsmuster - Reflexion, Planung, Werkzeugnutzung und Multi-Agenten-Kollaboration - zur dynamischen Verwaltung von Retrieval-Strategien, zur iterativen Verfeinerung des kontextuellen Verständnisses und zur Anpassung von Arbeitsabläufen an die Anforderungen komplexer Aufgaben. Durch diese Integration bietet das Agentic RAG-System eine unübertroffene Flexibilität, Skalierbarkeit und Kontextwahrnehmung für eine Vielzahl von Anwendungen.

Diese Übersichtsarbeit befasst sich umfassend mit Agentic RAG, beginnend mit den zugrunde liegenden Prinzipien und der Entwicklung des RAG-Paradigmas. Er beschreibt die Kategorisierung von agentenbasierten RAG-Architekturen, hebt ihre wichtigsten Anwendungen in Branchen wie dem Gesundheits-, Finanz- und Bildungswesen hervor und erforscht praktische Implementierungsstrategien. Darüber hinaus werden die Herausforderungen bei der Skalierung dieser Systeme, der Sicherstellung einer ethischen Entscheidungsfindung und der Optimierung der Leistung realer Anwendungen erörtert, während gleichzeitig detaillierte Einblicke in Frameworks und Tools für die Implementierung von Agentic RAG gegeben werden.

Schlüsselwörter. Große Sprachmodelle (LLMs) - Künstliche Intelligenz (KI) - Verstehen natürlicher Sprache - Retrieval Augmented Generation (RAG) - Agenten-RAG - Autonome KI-Agenten - Reflexion - Planung - Werkzeugnutzung - Multi-Agenten-Kollaboration - Agenten-Muster - Kontextuelles Verständnis - Dynamische Anpassung - Skalierbarkeit - Echtzeit-Datenabfrage - Agenten-RAG-Klassifikation - Anwendungen im Gesundheitswesen - Anwendungen im Finanzwesen - Anwendungen im Bildungswesen - Ethische KI-Entscheidungsfindung - Leistungsoptimierung - Mehrstufiges Reasoning

1 Einleitung

Große Sprachmodelle (Large Language Models, LLMs) [1, 2] [3] wie GPT-4 von OpenAI, PaLM von Google und LLaMA von Meta haben die Künstliche Intelligenz (KI) durch die Generierung von menschenähnlichem Text und die Durchführung komplexer Aufgaben zur Verarbeitung natürlicher Sprache grundlegend verändert. Diese Modelle haben die Innovation im Bereich des Dialogs vorangetrieben [4], einschließlich Gesprächsagenten, automatischer Inhaltserstellung und Echtzeitübersetzung. Jüngste Fortschritte haben ihre Fähigkeiten auf multimodale Aufgaben wie Text-zu-Bild- und Text-zu-Video-Generierung [5] ausgeweitet und ermöglichen die Erstellung und Bearbeitung von Videos und Bildern auf der Grundlage detaillierter Eingabeaufforderungen [6], was das Spektrum der potenziellen Anwendungen für generative KI erweitert.

Trotz dieser Fortschritte stoßen LLMs immer noch auf erhebliche Einschränkungen, da sie auf statische Daten vor dem Training angewiesen sind. Diese Abhängigkeit führt in der Regel zu veralteten Informationen, Phantomantworten [7] und der Unfähigkeit, sich an dynamische Szenarien der realen Welt anzupassen. Diese Herausforderungen unterstreichen den Bedarf an Systemen, die Echtzeitdaten integrieren und Antworten dynamisch verfeinern können, um kontextuelle Relevanz und Genauigkeit zu erhalten.

Retrieval Augmented Generation (RAG) [8, 9] hat sich als vielversprechende Lösung für diese Herausforderungen herauskristallisiert: RAG verbessert die Relevanz und Aktualität von Antworten durch die Kombination der generativen Fähigkeiten von LLMs mit externen Retrieval-Mechanismen [10]. Diese Systeme rufen Echtzeit-Informationen aus Quellen wie Wissensdatenbanken [11], APIs oder dem Internet ab und überbrücken so effektiv die Lücke zwischen statischen Trainingsdaten und dynamischen Anwendungsanforderungen. Herkömmliche RAG-Workflows sind jedoch immer noch durch ihr lineares und statisches Design eingeschränkt, was ihre Fähigkeit einschränkt, komplexe mehrstufige Schlussfolgerungen zu ziehen, tiefes kontextuelles Verständnis zu integrieren und Antworten iterativ zu verfeinern.

Die Entwicklung von Agenten [12] hat die Fähigkeiten von KI-Systemen weiter verbessert. Moderne Agenten, einschließlich LLM-basierter und mobiler Agenten [13], sind intelligente Einheiten, die in der Lage sind, wahrzunehmen, zu argumentieren und Aufgaben autonom auszuführen. Diese Agenten nutzen agentenbasierte Arbeitsablaufmuster wie Reflexion [14], Planung [15], Verwendung von Werkzeugen und Zusammenarbeit zwischen mehreren Agenten [16], wodurch sie in der Lage sind, dynamische Arbeitsabläufe zu verwalten und komplexe Probleme zu lösen.

Die Konvergenz von RAG und agentenbasierter Intelligenz hat zu Agentic Retrieval Augmented Generation (Agentic RAG) [17] geführt, einem Paradigma, das Agenten in den RAG-Prozess integriert. Agentic RAG implementiert dynamische Retrieval-Strategien, kontextuelles Verständnis und iterative Verfeinerung [18] und ermöglicht so eine adaptive und effiziente Informationsverarbeitung. Im Gegensatz zum traditionellen RAG setzt Agentic RAG autonome Agenten ein, um die Suche zu orchestrieren, relevante Informationen zu filtern und Antworten zu verfeinern, und zeichnet sich in Szenarien aus, die Genauigkeit und Anpassungsfähigkeit erfordern.

Diese Übersicht untersucht die zugrundeliegenden Prinzipien, die Klassifizierung und die Anwendungen von Agentic RAG. Sie bietet einen umfassenden Überblick über RAG-Paradigmen wie Simple RAG, Modular RAG und Graph RAG [19] und deren Weiterentwicklung zu Agentic RAG Systemen. Zu den wichtigsten Beiträgen gehören eine detaillierte Klassifizierung von Agentic RAG Frameworks, Anwendungen in Bereichen wie Gesundheitswesen [20, 21], Finanzen und Bildung [22] sowie Einblicke in Implementierungsstrategien, Benchmarking und ethische Überlegungen.

Der Beitrag ist wie folgt gegliedert: In Abschnitt 2 werden die RAG und ihre Entwicklung vorgestellt, wobei die Grenzen der traditionellen Ansätze hervorgehoben werden. Abschnitt 3 beschreibt die Prinzipien der agentenbasierten Intelligenz und agentenbasierte Modelle. Abschnitt 4 bietet eine Klassifizierung von agentenbasierten RAG-Systemen, einschließlich Einzelagenten-, Multiagenten- und graphbasierten Systemen. In Abschnitt 5 werden Anwendungen von Agentic RAG untersucht, während in Abschnitt 6 Implementierungswerkzeuge und Frameworks erörtert werden. Abschnitt 7 konzentriert sich auf Benchmarks und Datensätze, und Abschnitt 8 schließt mit einem Ausblick auf zukünftige Entwicklungen von Agentic RAG Systemen.

2 Grundlage für die Generierung von Retrieval-Erweiterungen

2.1 Überblick über die Retrieval Augmented Generation (RAG)

Retrieval-augmented generation (RAG) stellt einen großen Fortschritt auf dem Gebiet der künstlichen Intelligenz dar, indem es die generative Kraft großer Sprachmodelle (LLMs) mit Echtzeit-Datenabfrage kombiniert. Während LLMs außergewöhnliche Fähigkeiten in der Verarbeitung natürlicher Sprache bewiesen haben, führt ihre Abhängigkeit von statischen Vortrainingsdaten oft zu veralteten oder unvollständigen Antworten. RAG behebt diese Einschränkung, indem es relevante Informationen aus externen Quellen dynamisch abruft und in den generativen Prozess einbezieht, was die Generierung von kontextuell genauen und reaktionsfähigen Ergebnissen in einer zeitnahen Weise ermöglicht.

2.2 Kernbestandteile der RAG

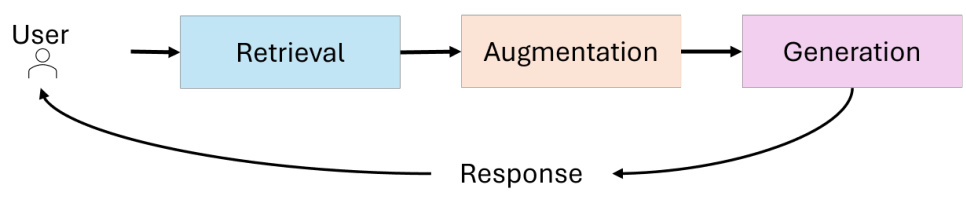

Die Architektur des RAG-Systems setzt sich aus drei Hauptkomponenten zusammen (siehe Abbildung 1):

- abrufen (Daten)Abfrage von externen Datenquellen wie Wissensdatenbanken, APIs oder Vektordatenbanken. Fortgeschrittene Retriever nutzen die dichte Vektorsuche und auf Transformer basierende Modelle, um die Retrievalgenauigkeit und semantische Relevanz zu verbessern.

- verstärken.Verarbeitung der abgerufenen Daten, um die für den Abfragekontext wichtigsten Informationen zu extrahieren und zusammenzufassen.

- Erzeugung vonKombinieren Sie die abgerufenen Informationen mit dem vorher trainierten Wissen über das LLM, um kohärente, kontextgerechte Antworten zu generieren.

Abbildung 1: Kernkomponenten von RAG

2.3 Entwicklung des RAG-Paradigmas

Das Gebiet der Retrieval Augmented Generation (RAG) hat erhebliche Fortschritte gemacht, um der zunehmenden Komplexität realer Anwendungen gerecht zu werden, bei denen kontextbezogene Genauigkeit, Skalierbarkeit und mehrstufige Schlussfolgerungen entscheidend sind. Ausgehend von einer einfachen stichwortbasierten Suche hat sie sich zu komplexen, modularen und adaptiven Systemen entwickelt, die in der Lage sind, verschiedene Datenquellen und autonome Entscheidungsprozesse zu integrieren. Diese Entwicklung verdeutlicht den wachsenden Bedarf an RAG-Systemen, die komplexe Abfragen effizient und effektiv bearbeiten können.

In diesem Abschnitt wird die Entwicklung des RAG-Paradigmas untersucht, wobei die wichtigsten Entwicklungsstufen - Simple RAG, Advanced RAG, Modular RAG, Graph RAG und Agent-Based RAG - sowie deren definierende Merkmale, Stärken und Grenzen beschrieben werden. Durch das Verständnis der Entwicklung dieser Paradigmen kann der Leser die Fortschritte bei der Suche und den generativen Fähigkeiten sowie deren Anwendungen in verschiedenen Bereichen nachvollziehen.

2.3.1 Einfache RAG

Die einfache RAG [23] stellt die Basisimplementierung der Retrieval-gestützten Generierung dar. Abbildung 2 zeigt einfache RAGs für einfache Retrieval-Lese-Workflows mit Schwerpunkt auf schlagwortbasiertem Retrieval und statischen Datenbeständen. Diese Systeme stützen sich auf einfache schlagwortbasierte Retrievaltechniken wie TF-IDF und BM25, um Dokumente aus statischen Datenbeständen zu finden. Die abgerufenen Dokumente werden dann verwendet, um die Erstellung von Sprachmodellen zu verbessern.

Abbildung 2: Ein Überblick über die Naive RAG.

Simple RAG zeichnet sich durch seine Einfachheit und leichte Implementierung aus und eignet sich für Aufgaben, die faktenbasierte Abfragen mit minimaler kontextueller Komplexität beinhalten. Es hat jedoch mehrere Einschränkungen:

- Mangelndes Bewusstsein für ZusammenhängeAbgerufene Dokumente erfassen oft nicht die semantischen Nuancen einer Anfrage, weil sie sich auf lexikalische Übereinstimmung und nicht auf semantisches Verständnis verlassen.

- Fragmentierung der AusgabeDas Fehlen einer fortgeschrittenen Vorverarbeitung oder einer kontextuellen Integration führt oft zu inkohärenten oder zu allgemeinen Antworten.

- Problem der SkalierbarkeitSchlüsselwortbasierte Suchtechniken sind bei großen Datenbeständen meist nicht sehr leistungsfähig und können die wichtigsten Informationen nicht identifizieren.

Trotz dieser Einschränkungen bietet das einfache RAG-System einen entscheidenden Konzeptnachweis für die Kombination von Abruf und Generierung und legt damit den Grundstein für komplexere Paradigmen.

2.3.2 Erweiterte RAG

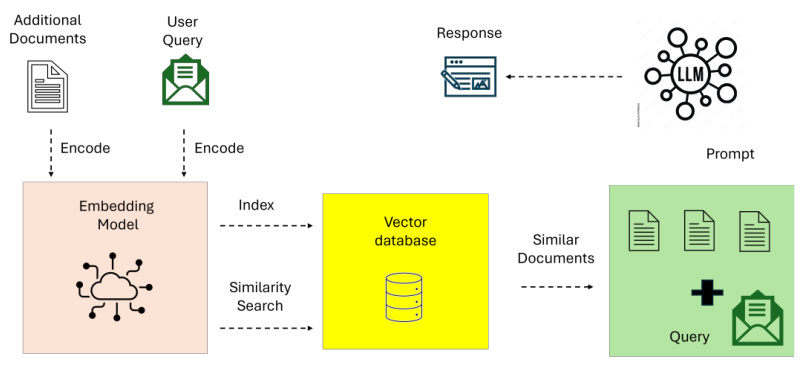

Fortgeschrittene RAG-Systeme [23] bauen auf den Beschränkungen der einfachen RAG auf, indem sie semantisches Verständnis und verbesserte Suchtechniken integrieren. Abbildung 3 verdeutlicht die semantische Erweiterung und den iterativen, kontextbewussten Prozess der erweiterten RAG beim Retrieval. Diese Systeme nutzen dichte Retrievalmodelle wie Dense Paragraph Retrieval (DPR) und neuronale Ranking-Algorithmen, um die Retrievalgenauigkeit zu verbessern.

Abbildung 3: Überblick über die erweiterte RAG

Zu den wichtigsten Merkmalen des Advanced RAG gehören:

- Dichte VektorsucheAbfragen und Dokumente werden in einem hochrangigen Vektorraum dargestellt, was zu einer besseren semantischen Übereinstimmung zwischen Benutzerabfragen und abgerufenen Dokumenten führt.

- Kontext neu ordnenNeuronales Modell: Das neuronale Modell ordnet die abgerufenen Dokumente neu, um die kontextuell relevantesten Informationen zu priorisieren.

- Iterative SucheAdvanced RAG führt einen Multi-Hop-Retrieval-Mechanismus ein, der es ermöglicht, komplexe Abfragen über mehrere Dokumente hinweg zu beantworten.

Dank dieser Fortschritte eignen sich fortgeschrittene RAG für Anwendungen, die eine hohe Präzision und ein differenziertes Verständnis erfordern, wie z. B. die Synthese von Forschungsergebnissen und personalisierte Empfehlungen. Allerdings gibt es nach wie vor Probleme mit dem Rechenaufwand und der begrenzten Skalierbarkeit, insbesondere bei großen Datensätzen oder mehrstufigen Abfragen.

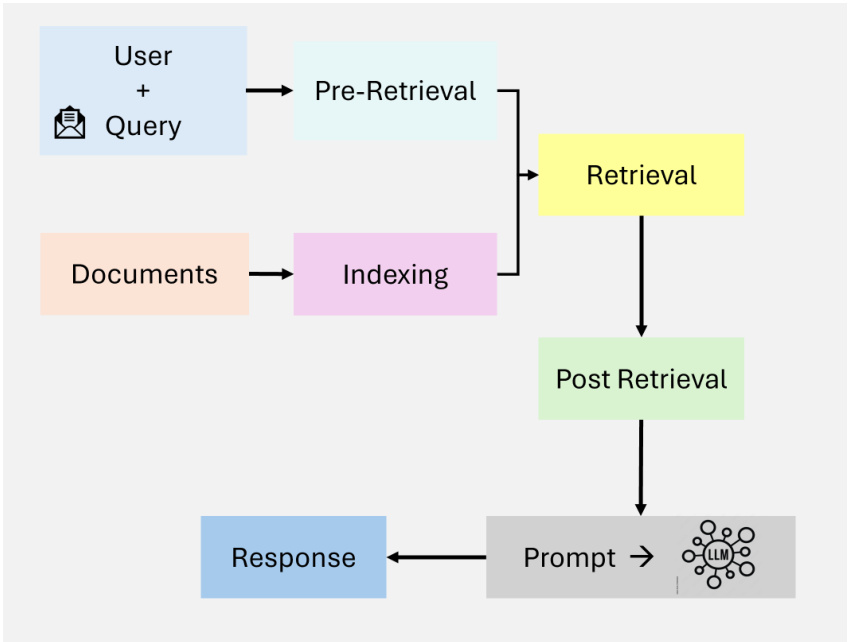

2.3.3 Modulare RAG

Modulare RAGs [23] stellen die jüngste Entwicklung des RAG-Paradigmas dar, wobei der Schwerpunkt auf Flexibilität und Anpassbarkeit liegt. Diese Systeme zerlegen die Retrieval- und Generierungsprozesse in separate, wiederverwendbare Komponenten, um eine domänenspezifische Optimierung und Anpassbarkeit der Aufgaben zu ermöglichen. Abbildung 4 veranschaulicht die modulare Architektur und zeigt hybride Abfragestrategien, zusammensetzbare Prozesse und die Integration externer Werkzeuge.

Zu den wichtigsten Innovationen des modularen RAG gehören:

- hybride SuchstrategieKombination von Sparse-Retrieval-Methoden (z.B. Sparse Encoder - BM25) und Dense-Retrieval-Techniken (z.B. DPR - Dense Paragraph Retrieval) zur Maximierung der Genauigkeit für verschiedene Abfragetypen.

- WerkzeugintegrationIntegration externer APIs, Datenbanken oder Berechnungswerkzeuge zur Bewältigung spezifischer Aufgaben, wie Echtzeit-Datenanalyse oder bereichsspezifische Berechnungen.

- Zusammensetzbare ProzesseDer modulare RAG ermöglicht den Austausch, die Erweiterung oder die Neukonfiguration von Retrievern, Generatoren und anderen Komponenten, die unabhängig voneinander ein hohes Maß an Anpassung an spezifische Anwendungsfälle ermöglichen.

Ein modulares RAG-System, das für die Finanzanalyse entwickelt wurde, könnte zum Beispiel Echtzeit-Aktienkurse über eine API abrufen, historische Trends mit Hilfe einer intensiven Suche analysieren und mit Hilfe eines angepassten Sprachmodells verwertbare Erkenntnisse über Investitionen generieren. Durch diese Modularität und Anpassbarkeit eignet sich modulares RAG gut für komplexe, bereichsübergreifende Aufgaben und bietet sowohl Skalierbarkeit als auch Genauigkeit.

Abbildung 4: Übersicht über das Modulare RAG

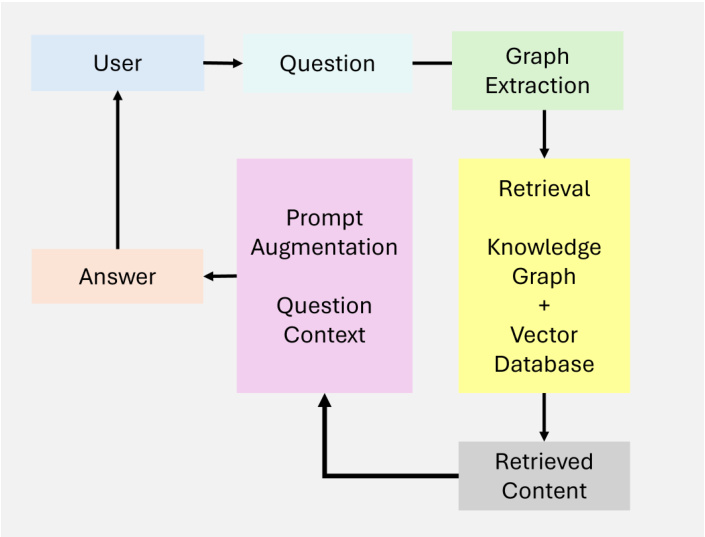

2.3.4 Abbildung RAG

Graph RAG [19] erweitert die traditionellen Systeme zur Generierung von Retrieval-Erweiterungen durch die Integration graphbasierter Datenstrukturen, wie in Abbildung 5 dargestellt. Diese Systeme nutzen Beziehungen und Hierarchien in Graphdaten, um Multi-Hop-Reasoning und kontextuelle Erweiterungen zu verbessern. Durch die Integration von graphbasiertem Retrieval sind Graph-RAGs in der Lage, reichhaltigere und genauere Ergebnisse zu generieren, insbesondere für Aufgaben, die ein relationales Verständnis erfordern.

Die Abbildung RAG zeichnet sich durch ihre Fähigkeit aus,:

- KnotenkonnektivitätErfassen von und Schlussfolgerungen über Beziehungen zwischen Entitäten.

- Hierarchisches WissensmanagementHandhabung strukturierter und unstrukturierter Daten durch Graphenhierarchien.

- kontextabhängig: Hinzufügen eines relationalen Verständnisses durch die Verwendung von Graphenpfaden.

Das RAG-Diagramm weist jedoch einige Einschränkungen auf:

- Begrenzte SkalierbarkeitAbhängigkeit von der Graphenstruktur kann die Skalierbarkeit einschränken, insbesondere bei einer großen Anzahl von Datenquellen.

- Abhängigkeit von den DatenQualitativ hochwertige Graphdaten sind für eine aussagekräftige Ausgabe unabdingbar, was die Anwendung auf unstrukturierte oder schlecht annotierte Datensätze beschränkt.

- Komplexität der IntegrationDie Integration von Graphdaten in unstrukturierte Retrievalsysteme erhöht die Komplexität von Design und Implementierung.

Graph RAG eignet sich gut für Anwendungen in Bereichen wie der medizinischen Diagnostik und der juristischen Forschung, in denen die Schlussfolgerung über strukturierte Beziehungen entscheidend ist.

Abbildung 5: Überblick über die Grafik RAG

2.3.5 Stellvertretende RAG

Agentenbasierte RAG stellen einen Paradigmenwechsel dar, indem sie autonome Agenten einführen, die in der Lage sind, dynamische Entscheidungen zu treffen und Arbeitsabläufe zu optimieren. Im Gegensatz zu statischen Systemen verwenden agentenbasierte RAGs iterative Verfeinerungs- und adaptive Abrufstrategien, um komplexe Echtzeit- und Multidomänen-Abfragen zu bewältigen. Dieses Paradigma nutzt die Modularität des Abruf- und Generierungsprozesses und führt gleichzeitig agentenbasierte Autonomie ein.

Zu den wichtigsten Merkmalen der agentenbasierten RAG gehören:

- SelbstbestimmungsrechtAgenten bewerten und verwalten selbständig Abfragestrategien auf der Grundlage der Komplexität der Anfrage.

- Iterative VerfeinerungIntegration von Feedback-Schleifen zur Verbesserung der Abrufgenauigkeit und der Relevanz der Antworten.

- Optimierung des ArbeitsablaufsDynamische Planung von Aufgaben, um Echtzeitanwendungen effizienter zu machen.

Trotz dieser Fortschritte stehen agentenbasierte RAGs vor einer Reihe von Herausforderungen:

- Komplexität der KoordinierungDie Verwaltung von Interaktionen zwischen Agenten erfordert komplexe Koordinationsmechanismen.

- rechnerischer AufwandDer Einsatz mehrerer Agenten erhöht den Ressourcenbedarf für komplexe Arbeitsabläufe.

- SkalierbarkeitsbeschränkungenSkalierbarkeit: Obwohl das System skalierbar ist, kann es aufgrund seiner Dynamik bei hohen Abfragevolumina zu Problemen kommen.

Agentenbasierte RAGs haben sich in Bereichen wie Kundensupport, Finanzanalyse und adaptive Lernplattformen bewährt, wo dynamische Anpassungsfähigkeit und kontextbezogene Genauigkeit entscheidend sind.

2.4 Herausforderungen und Grenzen der traditionellen RAG-Systeme

Herkömmliche Retrieval Augmented Generation (RAG)-Systeme haben die Fähigkeiten großer Sprachmodelle (LLMs) durch die Integration von Echtzeit-Datenabfragen erheblich erweitert. Allerdings stehen diese Systeme immer noch vor einer Reihe von Herausforderungen, die ihre Effektivität in komplexen realen Anwendungen behindern. Die bemerkenswertesten Einschränkungen betreffen die Kontextintegration, mehrstufige Schlussfolgerungen sowie Skalierbarkeits- und Latenzprobleme.

2.4.1 Kontextbezogene Integration

Selbst wenn RAG-Systeme erfolgreich relevante Informationen abrufen, haben sie oft Schwierigkeiten, die Informationen nahtlos in die generierte Antwort zu integrieren. Die statische Natur des Abrufprozesses und die begrenzte Kontextwahrnehmung führen zu fragmentierten, inkonsistenten oder zu generischen Ergebnissen.

BEISPIEL: Eine Abfrage wie "Jüngste Fortschritte in der Alzheimer-Forschung und ihre Auswirkungen auf eine frühzeitige Behandlung" kann relevante wissenschaftliche Arbeiten und medizinische Leitlinien liefern. Herkömmliche RAG-Systeme sind jedoch oft nicht in der Lage, diese Erkenntnisse in kohärente Erklärungen zusammenzufassen, die neue Behandlungen mit spezifischen Patientenszenarien verbinden. Ähnlich verhält es sich mit einer Anfrage wie "Welches sind die besten nachhaltigen Praktiken für die kleinbäuerliche Landwirtschaft in Trockengebieten?": Ein konventionelles System findet möglicherweise Artikel über allgemeine landwirtschaftliche Methoden, lässt aber wichtige nachhaltige Praktiken für trockene Gebiete aus.

Tabelle 1. Vergleichende Analyse der RAG-Paradigmen

| Paradigma | Wesentliche Merkmale | Stärken |

|---|---|---|

| Naive RAG | - Schlüsselwort-basiert Abruf (z.B. TF-IDF. BM25) | - Einfach und leicht zu implementieren - Geeignet für faktenbasierte Abfragen |

| Erweiterte RAG | - Dichte Suchmodelle (z. B. DPR) - Neuronales Ranking und Re-Ranking - Multi-hop Retrieval | - Hochpräzises Abrufen - Verbesserte kontextbezogene Relevanz |

| Modularer RAG | - Hybrides Retrieval (sparse und dense) - Tool- und API-Integration - Kompatible, bereichsspezifische Pipelines | - Hohe Flexibilität und Anpassbarkeit - Geeignet für verschiedene Anwendungen - Skalierbar |

| Grafik RAG | - Integration graphenbasierter Strukturen - Multi-hop reasoning - Kontextanreicherung über Knoten | - Relationale Schlussfolgerungsmöglichkeiten - Mildert Halluzinationen - Ideal für strukturierte Datenaufgaben |

| Agentische RAG | - Autonome Agenten - Dynamische Entscheidungsfindung - Iterative Verfeinerung und Arbeitsablauf Optimierung | - Anpassungsfähig an Änderungen in Echtzeit - Skalierbar für Aufgaben in mehreren Bereichen - Hohe Genauigkeit |

2.4.2 Mehrstufige Argumentation

Viele reale Anfragen erfordern eine iterative oder mehrstufige Argumentation, d. h. das Abrufen und Zusammenführen von Informationen aus mehreren Schritten. Herkömmliche RAG-Systeme sind oft schlecht darauf vorbereitet, die Abfrage auf der Grundlage von Zwischenergebnissen oder Nutzerfeedback zu verfeinern, was zu unvollständigen oder unzusammenhängenden Antworten führt.

Beispiel: eine komplexe Frage wie "Welche Lehren aus der europäischen Politik im Bereich der erneuerbaren Energien können auf die Entwicklungsländer übertragen werden, und wie sehen die potenziellen wirtschaftlichen Auswirkungen aus?" Mehrere Informationen müssen miteinander in Einklang gebracht werden, einschließlich politischer Daten, Kontextualisierung für Entwicklungsregionen und wirtschaftlicher Analysen. Herkömmliche RAG-Systeme sind oft nicht in der Lage, diese unterschiedlichen Elemente zu einer kohärenten Antwort zu verbinden.

2.4.3 Skalierbarkeit und Latenzprobleme

Da die Zahl der externen Datenquellen zunimmt, wird die Abfrage und Einordnung großer Datenmengen immer rechenintensiver. Dies führt zu erheblichen Latenzzeiten, die die Fähigkeit des Systems, bei Echtzeitanwendungen zeitnahe Antworten zu geben, beeinträchtigen.

Beispiel: In zeitkritischen Umgebungen wie der Finanzanalyse oder dem Echtzeit-Kundensupport können Verzögerungen bei der Abfrage mehrerer Datenbanken oder der Arbeit mit großen Dokumentensätzen den Gesamtnutzen des Systems schmälern. Beispielsweise können Verzögerungen beim Abrufen von Markttrends im Hochfrequenzhandel zu verpassten Chancen führen.

2.5 Agentenbasierte RAG: ein Paradigmenwechsel

Herkömmliche RAG-Systeme mit ihren statischen Arbeitsabläufen und ihrer begrenzten Anpassungsfähigkeit sind oft nicht in der Lage, dynamische, mehrstufige Schlussfolgerungen zu ziehen und komplexe Aufgaben in der realen Welt zu bewältigen. Durch die Integration autonomer Agenten, die in der Lage sind, dynamische Entscheidungen zu treffen, iterative Schlussfolgerungen zu ziehen und adaptive Suchstrategien anzuwenden, überwinden agentenbasierte RAGs ihre inhärenten Beschränkungen und behalten gleichzeitig die Modularität früherer Paradigmen bei. Diese Entwicklung ermöglicht die Lösung komplexerer, bereichsübergreifender Aufgaben mit verbesserter Präzision und kontextbezogenem Verständnis und positioniert agentenbasierte RAGs als Grundlage für die nächste Generation von KI-Anwendungen. Insbesondere reduzieren agentenbasierte RAG-Systeme die Latenzzeit durch optimierte Arbeitsabläufe und verfeinern inkrementell die Ergebnisse, wodurch Herausforderungen angegangen werden, die lange Zeit die Skalierbarkeit und Effektivität traditioneller RAGs behindert haben.

3 Grundprinzipien und Kontext der Agentenintelligenz

Agentenintelligenz bildet die Grundlage agentenbasierter Retrieval Augmented Generation (RAG)-Systeme und ermöglicht es ihnen, über die statische und reaktive Natur herkömmlicher RAG hinauszugehen. Durch die Integration von autonomen Agenten, die in der Lage sind, dynamische Entscheidungen zu treffen, iterative Schlussfolgerungen zu ziehen und kollaborative Arbeitsabläufe durchzuführen, weisen agentenbasierte RAG-Systeme eine größere Anpassungsfähigkeit und Genauigkeit auf. In diesem Abschnitt werden die Grundprinzipien der Agentenintelligenz untersucht.

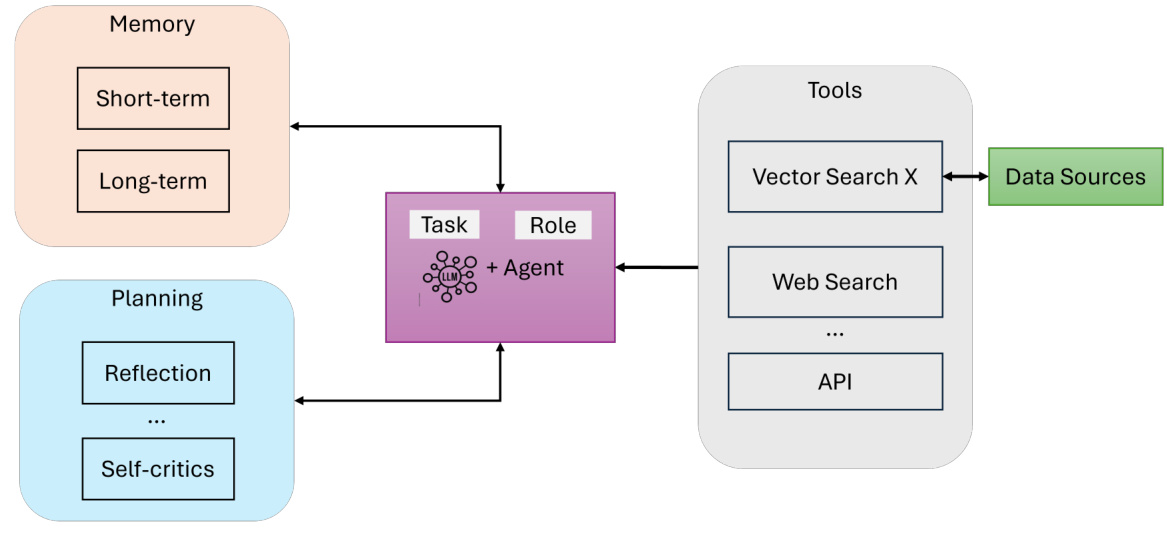

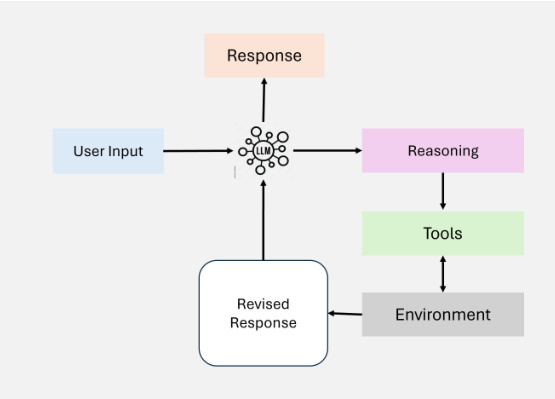

Bestandteile eines KI-Agenten. Ein KI-Agent besteht im Wesentlichen aus (siehe Abbildung 6):

- LLM (mit definierten Rollen und Aufgaben)Die primäre Argumentationsmaschine und Dialogschnittstelle des Agenten. Er interpretiert Benutzeranfragen, erzeugt Antworten und sorgt für Kohärenz.

- Gedächtnis (kurz- und langfristig)Erfassen von Kontext und relevanten Daten während einer Interaktion. Das Kurzzeitgedächtnis [25] erfasst den unmittelbaren Dialogzustand, während das Langzeitgedächtnis [25] das gesammelte Wissen und die Erfahrung des Agenten speichert.

- Planung (Reflexion und Selbstkritik)Die Steuerung des iterativen Denkprozesses des Agenten durch Reflexion, Query Routing oder Selbstkritik [26] gewährleistet, dass komplexe Aufgaben effektiv zerlegt werden [15].

- Werkzeuge (Vektorsuche, Websuche, APIs, usw.)Erweiterung der Fähigkeit von Agenten, über die Texterstellung hinaus auf externe Ressourcen, Echtzeitdaten oder spezialisierte Datenverarbeitung zuzugreifen.

Abbildung 6: Ein Überblick über KI-Agenten

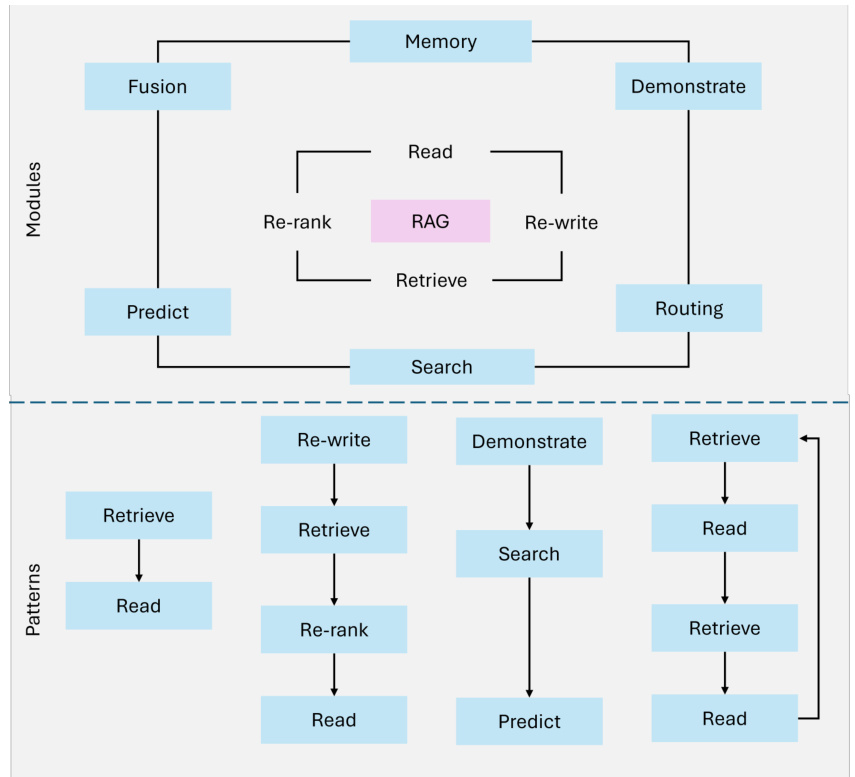

3.1 Proxy-Modell

Agentenmuster [27, 28] bieten strukturierte Möglichkeiten, das Verhalten von Agenten in agentenbasierten Retrieval Augmented Generation (RAG)-Systemen zu steuern. Diese Muster ermöglichen es den Agenten, sich dynamisch anzupassen, zu planen und zusammenzuarbeiten, um sicherzustellen, dass das System komplexe Aufgaben der realen Welt präzise und skalierbar bewältigen kann. Vier Schlüsselmuster bilden die Grundlage des Agenten-Workflows:

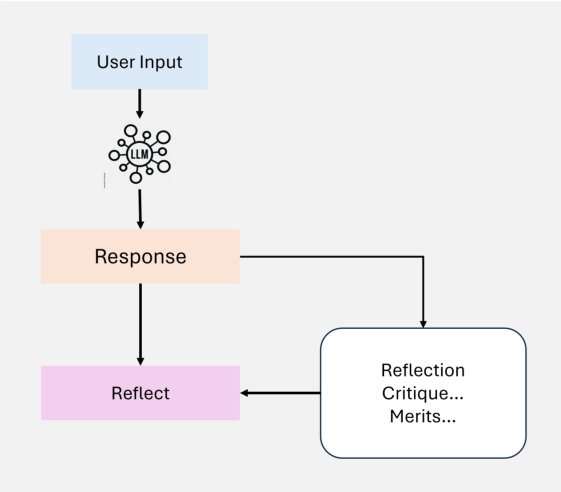

3.1.1 Reflexion

Reflexion ist ein grundlegendes Entwurfsmuster des Agenten-Workflows, das es dem Agenten ermöglicht, seine Ergebnisse iterativ zu bewerten und zu verbessern. Durch die Integration eines Selbstfeedback-Mechanismus kann der Agent Fehler, Inkonsistenzen und verbesserungswürdige Bereiche erkennen und beheben und so die Leistung von Aufgaben wie Codegenerierung, Texterstellung und Fragen und Antworten verbessern (siehe Abbildung 7). In der Praxis bedeutet Reflexion, dass der Agent aufgefordert wird, seine Ergebnisse in Bezug auf Korrektheit, Stil und Effizienz zu kritisieren, und dass dieses Feedback in die nachfolgenden Iterationen einfließt. Externe Tools, wie Unit-Tests oder Websuchen, können diesen Prozess weiter verbessern, indem sie die Ergebnisse validieren und Lücken aufzeigen.

Abbildung 7: Ein Überblick über Agentic Self- Reflexion

In Multi-Agenten-Systemen kann die Reflexion verschiedene Rollen einnehmen, z. B. wenn ein Agent den Output generiert, während ein anderer Agent ihn kritisiert, was eine kollaborative Verbesserung ermöglicht. In der juristischen Forschung können Agenten beispielsweise Antworten iterativ verfeinern, um Genauigkeit und Vollständigkeit zu gewährleisten, indem sie abgerufenes Fallrecht neu bewerten. Reflexion hat in Studien wie Self-Refine [29], Reflexion [30] und CRITIC [26] erhebliche Leistungssteigerungen gezeigt.

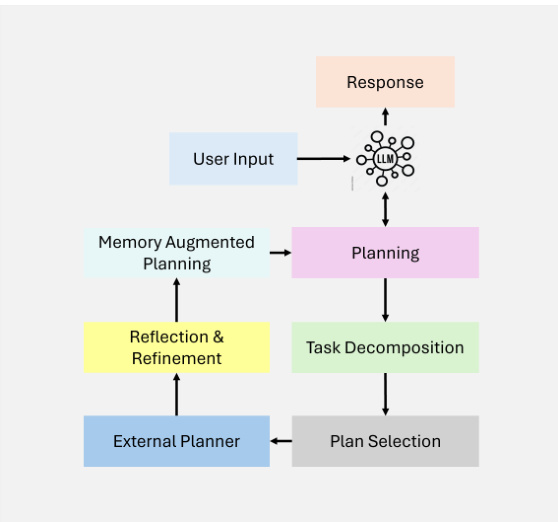

3.1.2 Planung

Planung [15] ist ein zentrales Entwurfsmuster für Agenten-Workflows, das es den Agenten ermöglicht, komplexe Aufgaben autonom in kleinere, besser zu bewältigende Teilaufgaben zu zerlegen. Diese Fähigkeit ist entscheidend für Multi-Hop-Reasoning und iterative Problemlösungen in dynamischen und unsicheren Szenarien (wie in Abbildung 8 dargestellt).

Abbildung 8: Ein Überblick über die agentenbasierte Planung

Durch den Einsatz von Planung können Agenten dynamisch die Abfolge von Schritten festlegen, die zur Erreichung größerer Ziele erforderlich sind. Diese Anpassungsfähigkeit ermöglicht es den Agenten, Aufgaben zu bewältigen, die nicht im Voraus festgelegt werden können, und gewährleistet Flexibilität bei der Entscheidungsfindung. Obwohl die Planung leistungsfähig ist, kann sie zu weniger vorhersehbaren Ergebnissen führen als deterministische Arbeitsabläufe wie die Reflexion. Die Planung eignet sich besonders für Aufgaben, die eine dynamische Anpassung erfordern und bei denen vordefinierte Arbeitsabläufe nicht ausreichen. Mit zunehmender Reife der Technologie wird ihr Potenzial zur Entwicklung innovativer Anwendungen in verschiedenen Bereichen weiter zunehmen.

3.1.3 Einsatz von Werkzeugen

Die Nutzung von Werkzeugen ermöglicht es Agenten, ihre Fähigkeiten zu erweitern, indem sie mit externen Werkzeugen, APIs oder Rechenressourcen interagieren, wie in Abbildung 9 dargestellt. Dieses Modell ermöglicht es dem Agenten, Informationen zu sammeln, Berechnungen durchzuführen und Daten zu manipulieren, die über sein vortrainiertes Wissen hinausgehen. Durch die dynamische Integration von Tools in den Arbeitsablauf können sich Agenten an komplexe Aufgaben anpassen und genauere und kontextbezogene Ergebnisse liefern.

Abbildung 9: Überblick über die Verwendung von Werkzeugen

Moderne Agenten-Workflows integrieren die Nutzung von Werkzeugen in eine Vielzahl von Anwendungen, einschließlich Informationsbeschaffung, rechnerische Schlussfolgerungen und Schnittstellen zu externen Systemen. Die Umsetzung dieses Modells hat sich mit der Entwicklung der GPT-4-Funktionsaufrufe und der Systeme, die den Zugriff auf zahlreiche Werkzeuge verwalten können, erheblich weiterentwickelt. Diese Entwicklungen haben komplexe Agenten-Workflows erleichtert, bei denen die Agenten die für eine bestimmte Aufgabe am besten geeigneten Werkzeuge selbständig auswählen und ausführen können.

Obwohl der Einsatz von Werkzeugen die Arbeitsabläufe von Agenten erheblich verbessert hat, gibt es nach wie vor Probleme bei der Optimierung der Auswahl von Werkzeugen, insbesondere wenn eine große Anzahl von Optionen verfügbar ist. Zur Lösung dieses Problems wurden Techniken vorgeschlagen, die sich an der Retrieval-gestützten Generierung (RAG) orientieren, z. B. die heuristische Auswahl.

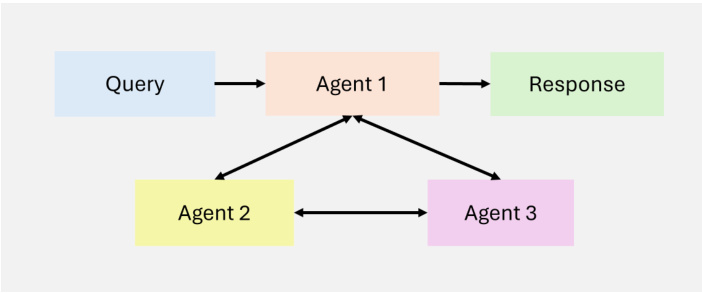

3.1.4 Multi-Agent

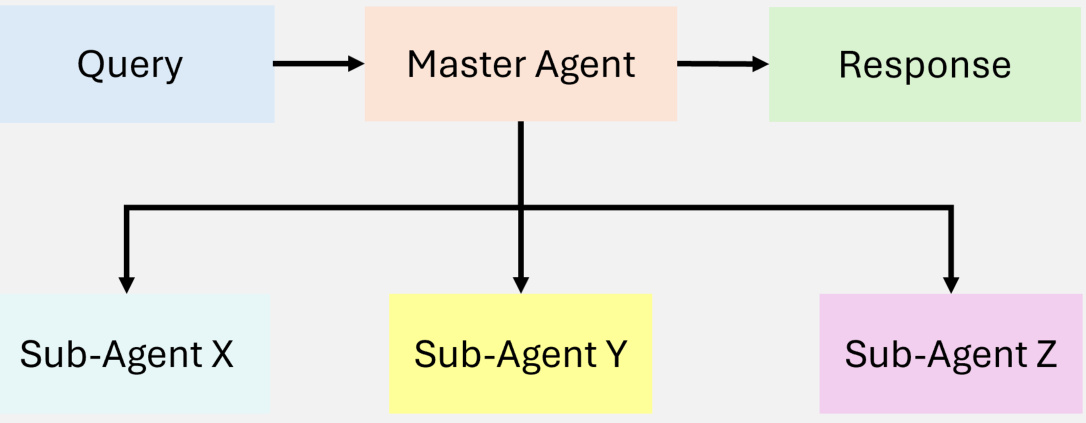

Die Zusammenarbeit mehrerer Agenten [16] ist ein zentrales Entwurfsmuster in Agenten-Workflows, das eine Aufgabenspezialisierung und Parallelverarbeitung ermöglicht. Agenten kommunizieren miteinander und tauschen Zwischenergebnisse aus, um sicherzustellen, dass der gesamte Arbeitsablauf effizient und kohärent bleibt. Durch die Zuweisung von Teilaufgaben an spezialisierte Agenten verbessert dieses Muster die Skalierbarkeit und Anpassungsfähigkeit komplexer Arbeitsabläufe. Multi-Agenten-Systeme ermöglichen es den Entwicklern, komplexe Aufgaben in kleinere, besser handhabbare Teilaufgaben aufzuteilen, die verschiedenen Agenten zugewiesen werden. Dieser Ansatz verbessert nicht nur die Aufgabenleistung, sondern bietet auch einen leistungsfähigen Rahmen für die Verwaltung komplexer Interaktionen. Jeder Agent verfügt über einen eigenen Speicher und einen eigenen Arbeitsablauf, der den Einsatz von Werkzeugen, Reflexion oder Planung umfassen kann, was eine dynamische und gemeinschaftliche Problemlösung ermöglicht (siehe Abbildung 10).

Abbildung 10: Ein Überblick über MultiAgent

Die Zusammenarbeit von Multi-Agenten bietet zwar ein großes Potenzial, ist aber ein weitaus weniger vorhersehbares Entwurfsparadigma als ausgereiftere Arbeitsabläufe wie Reflexion und Werkzeugnutzung. Dennoch bieten aufkommende Frameworks wie AutoGen, Crew AI und LangGraph neue Möglichkeiten zur Implementierung effektiver Multi-Agenten-Lösungen.

Diese Muster sind der Grundstein für den Erfolg von agentenbasierten RAG-Systemen, die es ihnen ermöglichen, Abruf- und Generierungsworkflows dynamisch anzupassen, um den Anforderungen unterschiedlicher, dynamischer Umgebungen gerecht zu werden. Durch die Nutzung dieser Muster können Agenten iterative, kontextabhängige Aufgaben bewältigen, die über die Möglichkeiten traditioneller RAG-Systeme hinausgehen.

4 Klassifizierung von agentenbasierten RAG-Systemen

Agentenbasierte Retrieval Augmented Generation (RAG)-Systeme lassen sich aufgrund ihrer Komplexität und ihrer Gestaltungsprinzipien in verschiedene Architekturen einteilen. Dazu gehören Ein-Agenten-Architekturen, Multi-Agenten-Systeme und hierarchische Agenten-Architekturen. Jeder Rahmen zielt darauf ab, spezifische Herausforderungen zu bewältigen und die Leistung in verschiedenen Anwendungen zu optimieren. In diesem Abschnitt wird eine detaillierte Kategorisierung dieser Architekturen vorgenommen, wobei ihre Merkmale, Vorteile und Grenzen hervorgehoben werden.

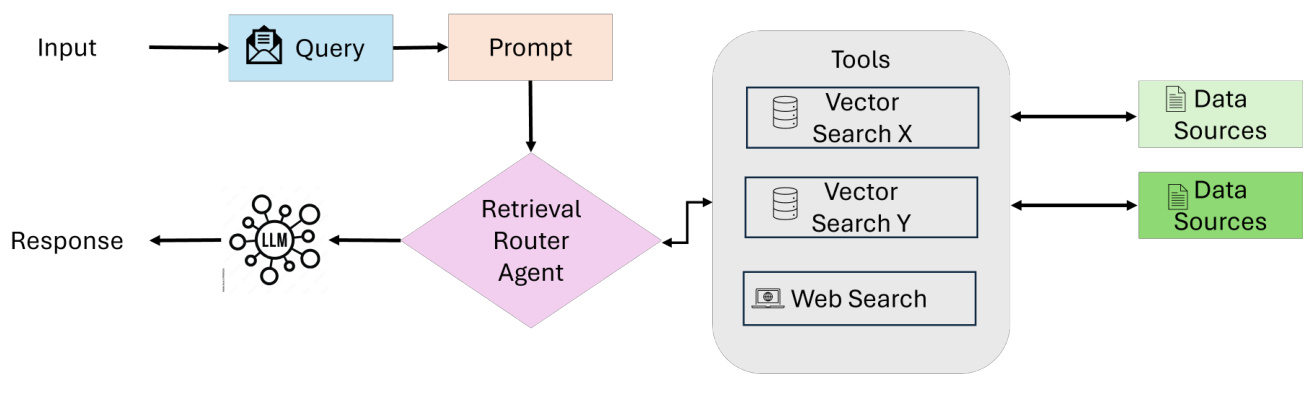

4.1 Alleinvertretungsberechtigter Proxy RAG: Router

Auf Einzelagenten basierende RAGs [31] fungieren als zentralisiertes Entscheidungssystem, bei dem ein Agent die Abfrage, das Routing und die Informationsintegration verwaltet (wie in Abbildung 11 dargestellt). Diese Architektur vereinfacht das System, indem sie diese Aufgaben in einem einzigen, einheitlichen Agenten zusammenfasst, wodurch sie sich besonders für Umgebungen mit einer begrenzten Anzahl von Tools oder Datenquellen eignet.

Arbeitsablauf

- Einreichung und Auswertung von AnfragenDer Prozess beginnt, wenn der Nutzer eine Anfrage stellt. Ein koordinierender Agent (oder Master-Retrieval-Agent) nimmt die Anfrage entgegen und analysiert sie, um die am besten geeignete Informationsquelle zu ermitteln.

- Auswahl der WissensquellenJe nach Art der Anfrage wählt der koordinierende Agent aus einer Vielzahl von Suchoptionen aus:

- Strukturierte DatenbankFür Abfragen, die den Zugriff auf tabellarische Daten erfordern, kann das System eine Text-to-SQL-Engine verwenden, die mit Datenbanken wie PostgreSQL oder MySQL interagiert.

- semantische SucheBei unstrukturierten Informationen verwendet es vektorbasiertes Retrieval, um relevante Dokumente (z. B. PDFs, Bücher, Organisationsunterlagen) abzurufen.

- Suche im InternetFür Echtzeit- oder umfassende kontextbezogene Informationen nutzt das System Web-Suchwerkzeuge, um auf die neuesten Online-Daten zuzugreifen.

- EmpfehlungssystemBei personalisierten oder kontextbezogenen Abfragen verwendet das System eine Empfehlungsmaschine, um maßgeschneiderte Vorschläge zu unterbreiten.

- Datenintegration und LLM-SyntheseSobald relevante Daten aus einer ausgewählten Quelle abgerufen wurden, werden sie an das Large Language Model (LLM) weitergeleitet, das die gesammelten Informationen zusammenführt und Erkenntnisse aus mehreren Quellen in eine kohärente und kontextbezogene Antwort integriert.

- Erzeugung von OutputSchließlich generiert das System eine umfassende, nutzerorientierte Antwort auf die ursprüngliche Anfrage. Die Antwort wird in einem umsetzbaren, prägnanten Format präsentiert und enthält optional Referenzen oder Zitate zu den verwendeten Quellen.

Hauptmerkmale und Vorteile

- Zentralisierte EinfachheitEin einziger Agent erledigt alle Abruf- und Weiterleitungsaufgaben, wodurch die Architektur einfach zu entwerfen, zu implementieren und zu warten ist.

- Effizienz und RessourcenoptimierungMit weniger Agenten und einer einfacheren Koordinierung benötigt das System weniger Rechenressourcen und kann Abfragen schneller bearbeiten.

- dynamisches RoutingDer Agent wertet jede Anfrage in Echtzeit aus und wählt die am besten geeignete Wissensquelle aus (z. B. strukturierte Datenbanken, semantische Suche, Websuche).

- Werkzeugübergreifende VielseitigkeitUnterstützung für mehrere Datenquellen und externe APIs, so dass sowohl strukturierte als auch unstrukturierte Arbeitsabläufe unterstützt werden.

- Geeignet für einfache SystemeFür Anwendungen mit klar definierten Aufgaben oder begrenzten Integrationsanforderungen (z. B. Dateiabruf, SQL-basierte Workflows).

Abbildung 11: Ein Überblick über die RAGs für Einzelakteure

Anwendungsfälle: Kundensupport

auf etw. aufmerksam machen: Können Sie mir den Lieferstatus meiner Bestellung mitteilen?

Systemprozesse (Ein-Bearbeiter-Workflow)::

- Einreichung und Auswertung von Anfragen::

- Der Nutzer stellt eine Anfrage, die vom Koordinationsagenten entgegengenommen wird.

- Koordinierung mit Agenten, um Anfragen zu analysieren und die am besten geeigneten Informationsquellen zu ermitteln.

- Auswahl der Wissensquellen::

- Abruf von Tracking-Details aus der Auftragsverwaltungsdatenbank.

- Erhalten Sie Echtzeit-Updates von der API des Kurierdienstes.

- Optional kann eine Websuche durchgeführt werden, um lokale Bedingungen zu ermitteln, die sich auf die Zustellung auswirken, z. B. Wetterbedingungen oder logistische Verzögerungen.

- Datenintegration und LLM-Synthese::

- Weitergabe relevanter Daten an den LLM, der die Informationen zu einer kohärenten Antwort zusammenfasst.

- Erzeugung von Output::

- Das System generiert eine umsetzbare und prägnante Antwort, die eine Echtzeitverfolgung von Aktualisierungen und möglichen Alternativen ermöglicht.

reaktionsschnell::

Integrierte AntwortIhr Paket befindet sich derzeit auf dem Transportweg und wird voraussichtlich morgen Abend ankommen. Die Echtzeitverfolgung von UPS zeigt, dass es sich in einem regionalen Verteilerzentrum befindet.

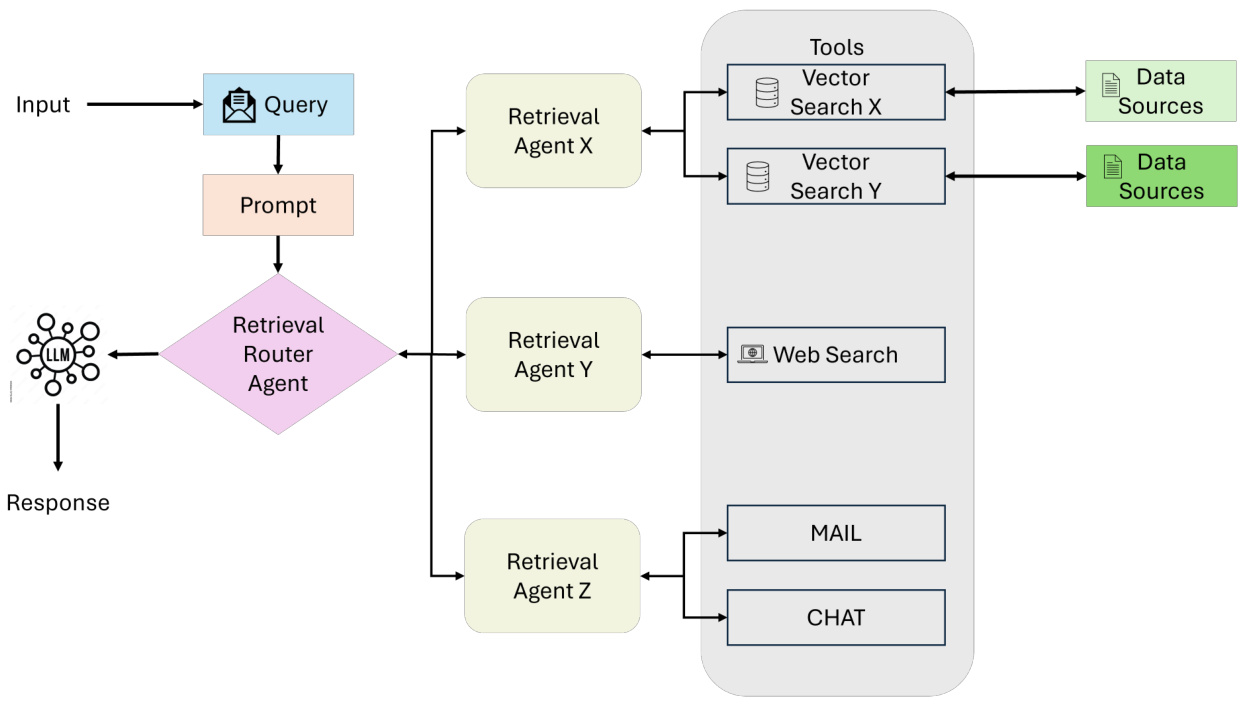

4.2 Multi-Agenten-RAG-System

Multi-Agenten-RAG [31] stellt eine modulare und skalierbare Weiterentwicklung der Einzel-Agenten-Architektur dar, die darauf abzielt, komplexe Prozesse und verschiedene Abfragetypen durch den Einsatz mehrerer spezialisierter Agenten (wie in Abbildung 12 dargestellt) zu bewältigen. Im Gegensatz zu einem einzelnen Agenten, der alle Aufgaben - Reasoning, Retrieval und Antwortgenerierung - bewältigt, weist das System die Verantwortlichkeiten mehreren Agenten zu, die jeweils für eine bestimmte Rolle oder Datenquelle optimiert sind.

Arbeitsablauf

- Anfrage EinreichungDer Prozess beginnt mit einer Benutzeranfrage, die von einem koordinierenden Agenten oder einem Master-Retrieval-Agenten entgegengenommen wird. Dieser Agent fungiert als zentraler Koordinator und delegiert die Anfrage an einen spezialisierten Retrieval-Agenten entsprechend den Anforderungen der Anfrage.

Abbildung 12: Ein Überblick über Multi-Agenten-Agenten-RAG-Systeme

- Spezialisierte SuchagentenAbfragen werden mehreren Retrieval Agents zugewiesen, die sich jeweils auf eine bestimmte Art von Datenquelle oder Aufgabe konzentrieren. Beispiel:

- Agent 1Bearbeitung strukturierter Abfragen, z. B. im Zusammenspiel mit SQL-basierten Datenbanken wie PostgreSQL oder MySQL.

- Agent 2Verwaltung semantischer Suchen zum Abrufen unstrukturierter Daten aus Quellen wie PDFs, Büchern oder internen Aufzeichnungen.

- Agent 3Schwerpunkt: Abruf von öffentlichen Informationen in Echtzeit aus Websuchen oder APIs.

- Agent 4Empfehlungssysteme: Spezialisiert auf Empfehlungssysteme, die auf der Grundlage des Nutzerverhaltens oder -profils kontextrelevante Vorschläge machen.

- Werkzeugzugang und DatenabrufJeder Agent leitet die Abfrage an das entsprechende Tool oder die entsprechende Datenquelle innerhalb seines Bereichs weiter, zum Beispiel:

- Vektorsuche: für semantische Relevanz.

- Text zu SQLFür strukturierte Daten.

- Suche im InternetFür öffentliche Informationen in Echtzeit.

- APIFür den Zugriff auf externe Dienste oder proprietäre Systeme.

Der Abrufprozess wird parallel ausgeführt, was eine effiziente Verarbeitung verschiedener Abfragetypen ermöglicht.

- Datenintegration und LLM-SyntheseSobald die Abfrage abgeschlossen ist, werden alle Daten des Agenten an das Large Language Model (LLM) weitergeleitet, das die abgerufenen Informationen zu einer kohärenten und kontextrelevanten Antwort zusammenfasst, die Erkenntnisse aus verschiedenen Quellen nahtlos integriert.

- Erzeugung von OutputDas System generiert eine umfassende Antwort, die dem Benutzer in einem übersichtlichen Format zurückgegeben wird.

Hauptmerkmale und Vorteile

- ModularisierungJeder Agent arbeitet unabhängig, so dass Agenten je nach Systemanforderungen nahtlos hinzugefügt oder entfernt werden können.

- SkalierbarkeitParallele Verarbeitung mehrerer Agenten ermöglicht es dem System, hohe Abfragevolumina effizient zu bewältigen.

- Spezialisierung der AufgabenJeder Agent ist für eine bestimmte Art von Abfrage oder Datenquelle optimiert, was die Genauigkeit und die Relevanz der Abfrage verbessert.

- EffizienzDurch die Zuweisung von Aufgaben an spezielle Agenten minimiert das System Engpässe und verbessert die Leistung komplexer Arbeitsabläufe.

- VielseitigkeitFür Anwendungen in verschiedenen Bereichen, einschließlich Forschung, Analyse, Entscheidungsfindung und Kundensupport.

Herausforderung

- Komplexität der KoordinierungDie Verwaltung der Kommunikation zwischen Agenten und die Delegation von Aufgaben erfordert komplexe Koordinationsmechanismen.

- rechnerischer AufwandParallele Verarbeitung mehrerer Agenten kann den Ressourcenverbrauch erhöhen.

- DatenintegrationDie Integration von Ergebnissen aus verschiedenen Quellen in eine kohärente Antwort ist nicht einfach und erfordert fortgeschrittene LLM-Fähigkeiten.

Anwendungsfall: Multidisziplinärer Forschungsassistent

auf etw. aufmerksam machenWas sind die wirtschaftlichen und ökologischen Auswirkungen der Einführung erneuerbarer Energien in Europa?

Systemprozesse (Multi-Agenten-Workflow)::

- Agent 1Abrufen von statistischen Daten aus einer Wirtschaftsdatenbank mittels SQL-Abfragen.

- Agent 2Suche nach relevanten akademischen Arbeiten mit Hilfe semantischer Suchwerkzeuge.

- Agent 3Suchen Sie im Internet nach den neuesten Nachrichten und politischen Updates zu erneuerbaren Energien.

- Agent 4: Konsultieren Sie das Empfehlungssystem, um relevante Inhalte vorzuschlagen, z. B. Berichte oder Expertenkommentare.

reaktionsschnell::

Integrierte AntwortDie Einführung erneuerbarer Energien in Europa hat laut dem EU-Politikbericht in den letzten zehn Jahren zu einer Reduzierung der Treibhausgasemissionen um 20% geführt. Auf wirtschaftlicher Ebene wurden durch Investitionen in erneuerbare Energien rund 1,2 Millionen Arbeitsplätze geschaffen, wobei der Solar- und der Windsektor ein erhebliches Wachstum verzeichneten. Jüngste akademische Forschungen haben auch mögliche Kompromisse in Bezug auf die Netzstabilität und die Kosten für die Energiespeicherung aufgezeigt.

4.3 Hierarchisches agentenbasiertes RAG-System

Das hierarchische agentenbasierte RAG-System [17] verwendet einen strukturierten, mehrstufigen Ansatz zur Informationsbeschaffung und -verarbeitung, der die Effizienz und die strategische Entscheidungsfindung verbessert (siehe Abbildung 13). Die Agenten sind in einer hierarchischen Struktur organisiert, wobei Agenten der höheren Ebene die Agenten der unteren Ebene überwachen und anleiten. Diese Struktur ermöglicht eine mehrstufige Entscheidungsfindung und gewährleistet, dass die Anfragen von den am besten geeigneten Ressourcen bearbeitet werden.

Abbildung 13: Eine Illustration der Hierarchischen Agentischen RAG

Arbeitsablauf

- Quittung der AnfrageDer Benutzer stellt eine Anfrage, die vom Top-Level-Agenten entgegengenommen wird, der für die erste Bewertung und Inbetriebnahme zuständig ist.

- strategische EntscheidungsfindungTop-Level-Agent: Der Top-Level-Agent bewertet die Komplexität der Abfrage und entscheidet, welche untergeordneten Agenten oder Datenquellen priorisiert werden sollen. Je nach Bereich der Abfrage können bestimmte Datenbanken, APIs oder Suchwerkzeuge als zuverlässiger oder relevanter angesehen werden.

- Delegation an einen UntergebenenTop-Level-Agenten weisen Aufgaben an untergeordnete Agenten zu, die sich auf bestimmte Retrieval-Methoden spezialisiert haben (z. B. SQL-Datenbanken, Websuchen oder proprietäre Systeme). Diese Agenten führen die ihnen zugewiesenen Aufgaben selbständig aus.

- Polymerisation und SyntheseAgenten auf höherer Ebene sammeln und integrieren Ergebnisse von untergeordneten Agenten und fassen Informationen zu kohärenten Antworten zusammen.

- Zustellung der AntwortDie endgültige, zusammengefasste Antwort wird an den Benutzer zurückgesendet, um sicherzustellen, dass die Antwort sowohl umfassend als auch kontextbezogen ist.

Hauptmerkmale und Vorteile

- Strategische PrioritätensetzungTop-Level-Agenten können Datenquellen oder Aufgaben auf der Grundlage der Komplexität der Abfrage, der Zuverlässigkeit oder des Kontexts priorisieren.

- SkalierbarkeitDie Zuweisung von Aufgaben an mehrere Agentenebenen ermöglicht die Bearbeitung hochkomplexer oder vielschichtiger Anfragen.

- Verbesserte Entscheidungsfähigkeit:: Hochrangige Beamte üben eine strategische Aufsicht aus, um die allgemeine Genauigkeit und Konsistenz der Reaktion zu verbessern.

Herausforderung

- Komplexität der KoordinierungDie Aufrechterhaltung einer robusten Kommunikation zwischen den Agenten über mehrere Ebenen hinweg kann den Koordinationsaufwand erhöhen.

- Zuweisung von RessourcenEs ist nicht einfach, Aufgaben effizient auf die verschiedenen Ebenen zu verteilen und gleichzeitig Engpässe zu vermeiden.

Anwendungsfall: Finanzanalysesystem

auf etw. aufmerksam machenWelche Investitionsmöglichkeiten für erneuerbare Energien gibt es angesichts der aktuellen Markttrends?

Systemprozesse (Hierarchischer Agenten-Workflow)::

- Bearbeiter an der Spitze der HierarchieBewertung der Komplexität von Abfragen und Bevorzugung von zuverlässigen Finanzdatenbanken und Wirtschaftsindikatoren gegenüber weniger validierten Datenquellen.

- Agenten der mittleren EbeneAbrufen von Echtzeit-Marktdaten (z. B. Aktienkurse, Branchenleistung) aus proprietären APIs und strukturierten SQL-Datenbanken.

- Low-Level-AgentenRecherchieren Sie im Internet nach aktuellen Verlautbarungen und politischen Maßnahmen, und konsultieren Sie Empfehlungssysteme, um Expertenmeinungen und Nachrichtenanalysen zu verfolgen.

- Polymerisation und SyntheseProxy-Aggregationsergebnisse auf höchster Ebene, die quantitative Daten mit politischen Erkenntnissen verbinden.

reaktionsschnell::

Integrierte AntwortAuf der Grundlage aktueller Marktdaten sind die Anteile an erneuerbaren Energien im vergangenen Quartal um 15% gestiegen, was vor allem auf die unterstützende Politik der Regierungen und das große Interesse der Anleger zurückzuführen ist. Analysten sind der Ansicht, dass die Sektoren Wind- und Solarenergie wahrscheinlich weiter an Dynamik gewinnen werden, während aufstrebende Technologien wie grüner Wasserstoff ein moderates Risiko aufweisen, aber hohe Renditen bieten können."

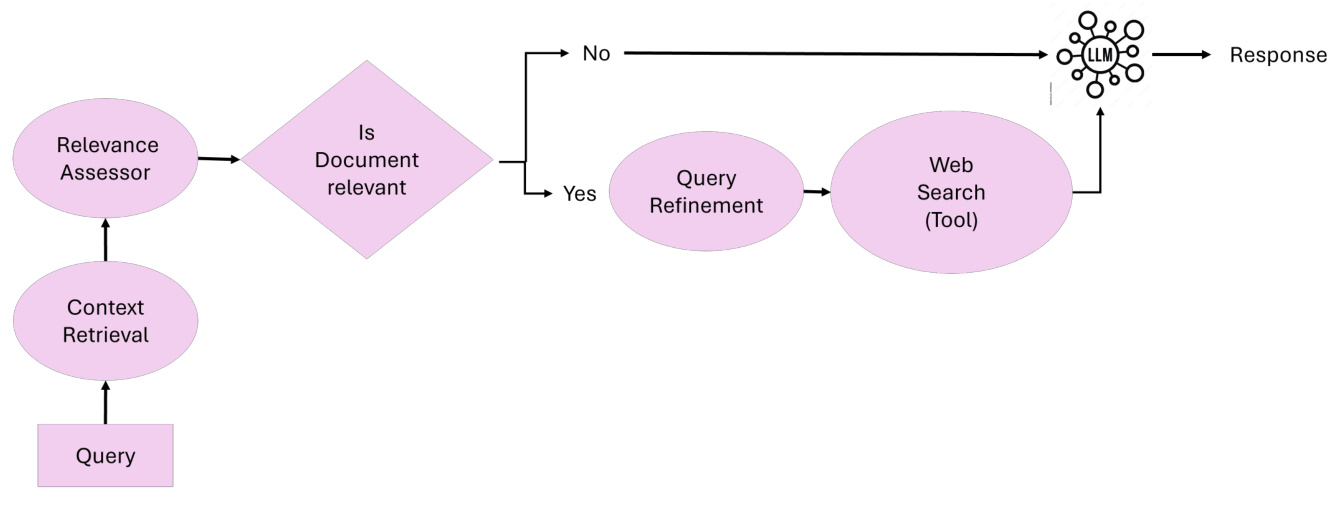

4.4 Stellvertretende RAG-Korrekturen

Corrective RAG [32] [33] führt die Fähigkeit zur Selbstkorrektur von Retrieval-Ergebnissen ein, wodurch die Dokumentennutzung und die Qualität der Antwortgenerierung verbessert werden (wie in Abbildung 14 gezeigt). Durch die Einbettung intelligenter Agenten in den Arbeitsablauf gewährleistet Corrective RAG [32] [33] eine iterative Verfeinerung der kontextbezogenen Dokumente und Antworten, um Fehler zu minimieren und die Relevanz zu maximieren.

Abbildung 14: Überblick über die agenturischen Korrekturmaßnahmen RAG

Korrektur des Kerngedankens der RAGDas Kernprinzip von Corrective RAG liegt in seiner Fähigkeit, die abgerufenen Dokumente dynamisch zu bewerten, Korrekturen vorzunehmen und die Abfrage zu verfeinern, um die Qualität der generierten Antwort zu verbessern. Corrective RAG passt seine Methodik wie folgt an:

- Bewertung der DokumentenrelevanzAbgerufene Dokumente werden von einem Relevanzbewertungsagenten bewertet. Dokumente unterhalb der Relevanzschwelle lösen einen Korrekturschritt aus.

- Verfeinerung und Erweiterung der AnfrageAbfragen werden durch einen Abfrageverfeinerungsagenten verfeinert, der semantisches Verständnis nutzt, um die Abfrage für bessere Ergebnisse zu optimieren.

- Dynamischer Abruf aus externen QuellenWenn der Kontext nicht ausreicht, führt der externe Wissensabruf-Agent eine Websuche durch oder greift auf alternative Datenquellen zu, um die abgerufenen Dokumente zu ergänzen.

- AntwortsyntheseAlle validierten und verfeinerten Informationen werden an den Agenten für die Antwortsynthese zur endgültigen Generierung der Antwort weitergeleitet.

ArbeitsablaufDas RAG-Korrektursystem basiert auf fünf Schlüsselkomponenten:

- kontextbezogener SuchagentVector: Verantwortlich für den Abruf des ersten Kontextdokuments aus der Vektordatenbank.

- Agent für RelevanzbewertungBewertung der Relevanz der abgerufenen Dokumente und Kennzeichnung irrelevanter oder zweideutiger Dokumente für Korrekturmaßnahmen.

- AnfrageveredlerRewriting von Abfragen zur Verbesserung der Abfrageeffizienz und Nutzung des semantischen Verständnisses zur Optimierung der Ergebnisse.

- Externer Agent für die WissensbeschaffungInternetrecherchen durchführen oder auf alternative Datenquellen zugreifen, wenn die kontextbezogene Dokumentation nicht ausreichend ist.

- Antwort-Synthese-MittelIntegrieren Sie alle validierten Informationen in eine kohärente und genaue Antwort.

Hauptmerkmale und Vorteile:

- Iterative KorrekturGewährleistung einer hohen Antwortgenauigkeit durch dynamisches Erkennen und Korrigieren irrelevanter oder zweideutiger Suchergebnisse.

- Dynamische AnpassungIntegration von Echtzeit-Web-Suche und Abfrageverfeinerung zur Verbesserung der Abfragegenauigkeit.

- Proxy ModularJeder Agent führt spezielle Aufgaben aus, um einen effizienten und skalierbaren Betrieb zu gewährleisten.

- Tatsächliche GarantienRAG-Korrektur: Die Korrektur der RAG minimiert das Risiko von Halluzinationen oder Fehlinformationen, indem alle abgerufenen und generierten Inhalte validiert werden.

Anwendungsfall: Wissenschaftlicher Mitarbeiter

auf etw. aufmerksam machenWas sind die neuesten Erkenntnisse aus der generativen KI-Forschung?

Systemprozesse (Korrektur der RAG-Workflows)::

- Anfrage EinreichungBenutzer stellen Abfragen an das System.

- kontextbezogene Suche::

- kontextbezogener SuchagentRufen Sie erste Dokumente aus der Datenbank veröffentlichter Artikel über generative KI ab.

- Die abgerufenen Dokumente werden zur Auswertung an den nächsten Schritt weitergeleitet.

- Bewertung der Relevanz:

- Agent für RelevanzbewertungBewerten Sie die Übereinstimmung zwischen dem Dokument und der Abfrage.

- Einstufung der Dokumente als relevant, zweideutig oder irrelevant. Irrelevante Dokumente werden für Korrekturmaßnahmen gekennzeichnet.

- Abhilfemaßnahmen (falls erforderlich):

- AnfrageveredlerUmschreiben von Abfragen zur Verbesserung der Spezifität.

- Externer Agent für die WissensbeschaffungFühren Sie Internetrecherchen durch, um zusätzliche Dokumente und Berichte aus externen Quellen zu erhalten.

- Antwort-Synthese.

- Antwort-Synthese-MittelIntegrieren Sie validierte Dokumente in umfassende und detaillierte Zusammenfassungen.

Antwort.

Integrierte AntwortAktuelle Ergebnisse der generativen KI-Forschung umfassen Diffusionsmodelle, Verstärkungslernen bei Text-zu-Video-Aufgaben und Fortschritte bei Optimierungstechniken für das Training von Modellen in großem Maßstab. Weitere Einzelheiten finden Sie in der auf der NeurIPS 2024 und der AAAI 2025 vorgestellten Forschung."

4.5 Adaptive agentenbasierte RAG

Adaptive Retrieval Augmented Generation (Adaptive RAG) [34] verbessert die Flexibilität und Effizienz von Large Language Models (LLMs), indem es die Strategie der Anfrageverarbeitung dynamisch an die Komplexität der eingehenden Anfrage anpasst. Im Gegensatz zu statischen Retrieval-Workflows setzt Adaptive RAG [35] Klassifikatoren ein, um die Komplexität der Anfrage zu analysieren und den am besten geeigneten Ansatz zu bestimmen, der von einstufigem Retrieval bis zu mehrstufigem Reasoning reicht oder sogar das Retrieval bei einfachen Anfragen ganz umgeht, wie in Abbildung 15 gezeigt.

Abbildung 15: Ein Überblick über die Adaptive Agentic RAG

Die Kernidee der adaptiven RAG Das Kernprinzip der adaptiven RAG liegt in ihrer Fähigkeit, die Suchstrategie dynamisch an die Komplexität der Anfrage anzupassen. Die adaptive RAG passt ihre Methode wie folgt an:

- einfache AbfrageBei Sachfragen, die eine zusätzliche Abfrage erfordern (z. B. "Wie hoch ist der Siedepunkt von Wasser?"), generiert das System die Antworten direkt aus dem vorhandenen Wissen. :: Bei Sachfragen, die eine zusätzliche Suche erfordern (z. B. "Wie hoch ist der Siedepunkt von Wasser?"), generiert das System die Antworten direkt unter Verwendung des bereits vorhandenen Wissens.

- einfache Abfrage:: Bei mäßig komplexen Aufgaben, die nur wenig Kontext erfordern (z. B. "Wie ist der Stand meiner letzten Stromrechnung?") führt das System eine einstufige Suche durch, um die relevanten Details zu erhalten.

- komplexe Abfrage:: Bei mehrstufigen Abfragen, die eine iterative Argumentation erfordern (z. B. "Wie hat sich die Bevölkerung der Stadt X in den letzten zehn Jahren verändert, und welche Faktoren haben dazu beigetragen?") verwendet das System eine mehrstufige Suche, bei der Zwischenergebnisse schrittweise verfeinert werden, um umfassende Antworten zu erhalten.

ArbeitsablaufDas adaptive RAG-System besteht aus drei Hauptkomponenten:

- Rolle des Klassifizierers.

- Ein kleineres Sprachmodell analysiert die Abfragen, um ihre Komplexität vorherzusagen.

- Der Klassifikator wird mit automatisch gekennzeichneten Datensätzen trainiert, die aus früheren Modellergebnissen und Abfragemustern abgeleitet werden.

- Dynamische Strategieauswahl.

- Bei einfachen Abfragen vermeidet das System unnötige Suchvorgänge und generiert die Antworten direkt mit LLM.

- Für einfache Abfragen wird ein einstufiger Suchprozess verwendet, um den relevanten Kontext zu erhalten.

- Bei komplexen Abfragen wird ein mehrstufiger Abruf aktiviert, um eine iterative Verfeinerung und eine verbesserte Argumentation zu gewährleisten.

- LLM-Integration.

- LLM integriert die abgerufenen Informationen in eine kohärente Antwort.

- Die iterative Interaktion zwischen LLM und Klassifikatoren ermöglicht die Verfeinerung komplexer Abfragen.

Hauptmerkmale und Vorteile.

- Dynamische Anpassung:: Anpassung der Abfragestrategien an die Komplexität der Abfrage zur Optimierung der Berechnungseffizienz und der Antwortgenauigkeit.

- Ressourceneffizienz:: Minimierung des unnötigen Aufwands für einfache Abfragen bei gleichzeitiger Gewährleistung einer gründlichen Verarbeitung komplexer Abfragen.

- Verbesserte GenauigkeitIterative Verfeinerung: Iterative Verfeinerung stellt sicher, dass komplexe Abfragen mit hoher Genauigkeit gelöst werden.

- GeschicklichkeitKann erweitert werden, um zusätzliche Pfade zu integrieren, z. B. domänenspezifische Tools oder externe APIs.

Anwendungsfälle. Assistentin der Kundenbetreuung

Tipp. Warum ist mein Paket verspätet und welche Möglichkeiten habe ich?

Systemprozesse (Adaptiver RAG-Workflow).

- Anfrage Kategorie.

- Der Klassifikator analysiert die Anfrage und stellt fest, dass es sich um eine komplexe Anfrage handelt, die eine mehrstufige Argumentation erfordert.

- Dynamische Strategieauswahl.

- Das System aktiviert einen mehrstufigen Abrufprozess, der auf der Klassifizierung der Komplexität beruht.

- Suche in mehreren Schritten.

- Abrufen von Tracking-Details aus der Auftragsdatenbank.

- Erhalten Sie Statusaktualisierungen in Echtzeit von der Courier-API.

- Führen Sie eine Internetrecherche durch, um nach externen Faktoren wie Wetterbedingungen oder lokalen Störungen zu suchen.

- Antwort-Synthese.

- LLM integriert alle abgerufenen Informationen in eine umfassende und umsetzbare Antwort.

Antwort.

Integrierte AntwortIhr Paket hat sich aufgrund der schlechten Wetterbedingungen in Ihrer Region verzögert. Es befindet sich derzeit im örtlichen Verteilzentrum und wird voraussichtlich innerhalb von 2 Tagen eintreffen. Alternativ können Sie es auch dort abholen."

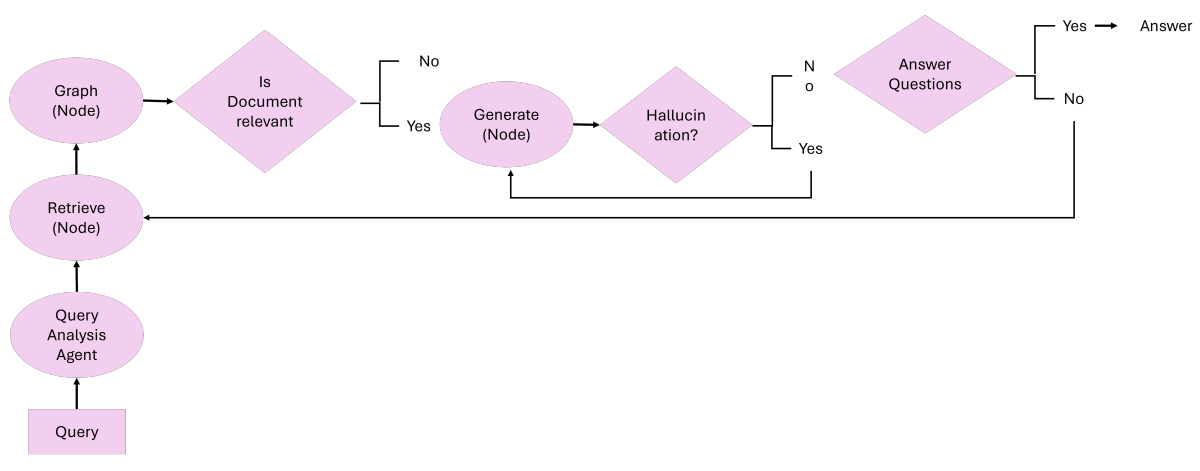

4.6 Graphenbasierte agentenbasierte RAGs

4.6.1 Agent-G: Ein agentenbasierter Rahmen für Graphen-RAGs

Agent-G [8] stellt eine innovative agentenbasierte Architektur vor, die Graphen-Wissensdatenbanken mit der Suche nach unstrukturierten Dokumenten kombiniert. Durch die Kombination von strukturierten und unstrukturierten Datenquellen verbessert dieses Framework die Schlussfolgerungen und die Abrufgenauigkeit von Retrieval Augmented Generation (RAG) Systemen. Es verwendet modulare Retriever-Bibliotheken, dynamische Agenteninteraktionen und Rückkopplungsschleifen, um eine qualitativ hochwertige Ausgabe zu gewährleisten (siehe Abbildung 16).

Abbildung 16: Ein Überblick über Agent-G: Agentisches Framework für Graph RAG

Die Kernidee von Agent-G Das Kernprinzip von Agent-G liegt in der Fähigkeit, Suchaufgaben dynamisch an spezialisierte Agenten zu vergeben, die Graph-Wissensbasen und Textdateien nutzen. Agent-G passt seine Suchstrategien wie folgt an:

- grafische WissensbasisStrukturierte Daten verwenden, um Beziehungen, Hierarchien und Verbindungen zu extrahieren (z. B. Zuordnung von Krankheiten zu Symptomen im medizinischen Bereich).

- unstrukturiertes Dokument:: Herkömmliche Textsuchsysteme liefern kontextbezogene Informationen, um die Graphdaten zu ergänzen.

- Modul Kritik:: Bewertung der Relevanz und Qualität der abgerufenen Informationen, um die Übereinstimmung mit der Anfrage sicherzustellen.

- Rückkopplungsschleife:: Verfeinerung des Abrufs und der Synthese durch iterative Validierung und erneute Abfrage.

ArbeitsablaufDas : Agent-G-System besteht aus vier Hauptkomponenten:

- Retriever-Bibliothek.

- Eine Reihe von modularen Agenten ist auf das Abrufen von graphbasierten oder unstrukturierten Daten spezialisiert.

- Der Agent wählt dynamisch relevante Quellen auf der Grundlage der Anforderungen der Abfrage aus.

- Modul "Kritik".

- Validieren Sie die Relevanz und Qualität der abgerufenen Daten.

- Markieren Sie Ergebnisse mit niedrigem Konfidenzniveau zum erneuten Abrufen oder Verfeinern.

- Dynamische Agenteninteraktion.

- Aufgabenspezifische Agenten arbeiten zusammen, um verschiedene Arten von Daten zu integrieren.

- Gewährleistung einer koordinierten Abfrage und Synthese zwischen Bild- und Textquellen.

- LLM-Integration.

- Synthese der validierten Daten zu einer kohärenten Antwort.

- Das iterative Feedback des Kritikmoduls gewährleistet die Übereinstimmung mit der Anfrageabsicht.

Hauptmerkmale und Vorteile.

- verbesserte ArgumentationKombinieren Sie strukturierte Beziehungen in einem Diagramm mit kontextuellen Informationen aus unstrukturierten Dokumenten.

- Dynamische Anpassung:: Dynamische Anpassung von Suchstrategien an die Anforderungen von Anfragen.

- Verbesserte GenauigkeitDas Modul "Critique" verringert das Risiko, dass irrelevante oder minderwertige Daten in der Antwort enthalten sind.

- Skalierbare Modularität:: Unterstützung für das Hinzufügen neuer Agenten, die spezielle Aufgaben für eine bessere Skalierbarkeit ausführen.

Anwendungsfälle: Medizinische Diagnostik

Tipp. Was sind die häufigsten Symptome von Typ-2-Diabetes und wie hängen sie mit Herzerkrankungen zusammen?

System-Prozesse (Agent-G Workflow).

- Entgegennahme und Verteilung von Abfragen:: Das System erhält Anfragen und erkennt die Notwendigkeit, sowohl graph-strukturierte als auch unstrukturierte Daten zu verwenden, um die Frage vollständig zu beantworten.

- Chart Finder.

- Extrahieren des Zusammenhangs zwischen Typ-2-Diabetes und Herzerkrankungen aus dem Medical Knowledge Graph.

- Identifizieren Sie gemeinsame Risikofaktoren wie Fettleibigkeit und Bluthochdruck, indem Sie grafische Hierarchien und Beziehungen untersuchen.

- Document Retriever.

- Suchen Sie in der medizinischen Fachliteratur nach Beschreibungen von Typ-2-Diabetes-Symptomen (z. B. vermehrter Durst, häufiges Wasserlassen, Müdigkeit).

- Fügen Sie kontextbezogene Informationen hinzu, um grafikbasierte Erkenntnisse zu ergänzen.

- Modul "Kritik".

- Bewerten Sie die Relevanz und Qualität der abgerufenen Diagramm- und Dokumentdaten.

- Markieren Sie Ergebnisse mit niedrigem Vertrauen zur Verfeinerung oder erneuten Abfrage.

- AntwortsyntheseLLM integriert Validierungsdaten aus dem Graph Retriever und dem Document Retriever in eine kohärente Antwort und gewährleistet so die Übereinstimmung mit der Anfrageabsicht.

Antwort.

Integrierte AntwortZu den Symptomen des Typ-2-Diabetes gehören vermehrter Durst, häufiges Wasserlassen und Müdigkeit. Studien haben einen 50%-Zusammenhang zwischen Diabetes und Herzkrankheiten gezeigt, vor allem durch gemeinsame Risikofaktoren wie Fettleibigkeit und Bluthochdruck."

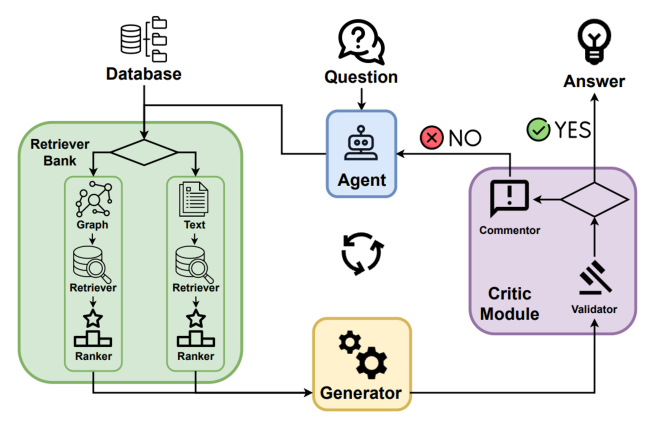

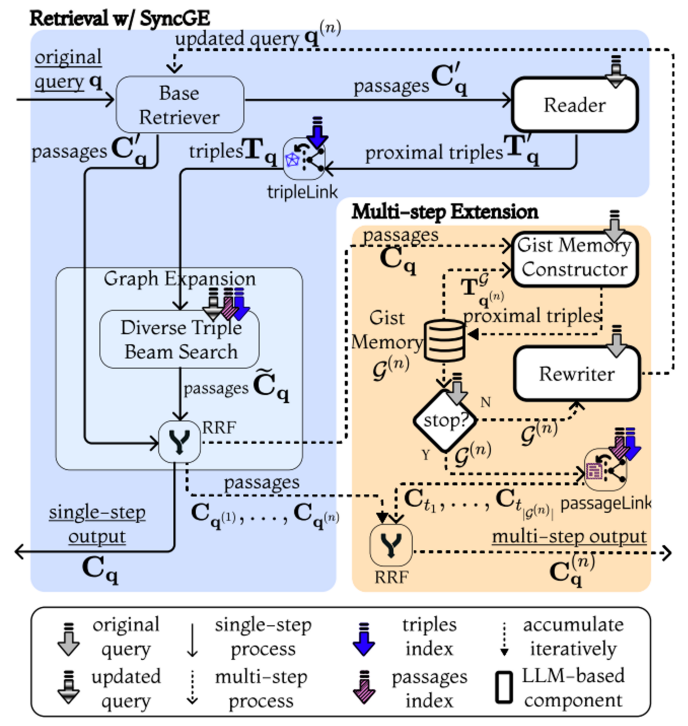

4.6.2 GeAR: Graph Augmentation Agent for Retrieval Augmentation Generation

GeAR [36] stellt einen agentenbasierten Rahmen vor, der herkömmliche Retrieval Augmented Generation (RAG)-Systeme durch die Integration graphbasierter Retrieval-Mechanismen erweitert. Durch die Verwendung von Graphenerweiterungstechniken und einer agentenbasierten Architektur geht GeAR auf die Herausforderungen in Multi-Hop-Retrieval-Szenarien ein und verbessert die Fähigkeit des Systems, komplexe Abfragen zu bearbeiten, wie in Abbildung 17 dargestellt.

Abbildung 17: Ein Überblick über GeAR: Graph-Enhanced Agent for Retrieval-Augmented Generation[36]

- grafische ErweiterungVerbessert herkömmliche Baseline Retriever (z. B. BM25), indem es den Retrievalprozess um graphenstrukturierte Daten erweitert, so dass das System komplexe Beziehungen und Abhängigkeiten zwischen Entitäten erfassen kann.

- VertretungsregelungIntegriert eine agentenbasierte Architektur, die Graphenerweiterungen nutzt, um Suchaufgaben effizienter zu verwalten und dynamische und autonome Entscheidungen während des Suchvorgangs zu ermöglichen.

ArbeitsablaufDas GeAR-System arbeitet mit den folgenden Komponenten:

- Abbildung Erweiterungsmodul.

- Durch die Integration von graphenbasierten Daten in den Suchprozess kann das System Beziehungen zwischen Entitäten während des Suchvorgangs berücksichtigen.

- Verbesserung der Fähigkeit der Basissuchmaschine, Multi-Hop-Anfragen zu bearbeiten, indem der Suchraum um verbundene Entitäten erweitert wird.

- Agentenbasiertes Retrieval.

- Zur Verwaltung des Suchprozesses wird ein Agentenrahmen verwendet, der es den Agenten ermöglicht, Suchstrategien je nach Komplexität der Anfrage dynamisch auszuwählen und zu kombinieren.

- Agenten können autonom über einen Suchpfad entscheiden, indem sie Graphenerweiterungen nutzen, um die Relevanz und Genauigkeit der abgerufenen Informationen zu verbessern.

- LLM-Integration.

- Die Kombination der abgerufenen Informationen mit den Vorteilen von Graphenerweiterungen mit den Möglichkeiten von Large Language Modelling (LLM), um kohärente und kontextbezogene Antworten zu generieren.

- Diese Integration gewährleistet, dass der Generierungsprozess sowohl von unstrukturierten Dokumenten als auch von strukturierten Graphdaten inspiriert wird.

Hauptmerkmale und Vorteile.

- Verbesserte Multi-Hop-Suche:: Die Graphenerweiterungen von GeAR ermöglichen es dem System, komplexe Abfragen zu bearbeiten, die Schlussfolgerungen über mehrere miteinander verbundene Informationen erfordern.

- Entscheidungsfindung durch BevollmächtigteDer Proxy-Rahmen ermöglicht eine dynamische und autonome Auswahl von Abrufstrategien, wodurch Effizienz und Relevanz verbessert werden.

- Verbesserte Genauigkeit:: Durch die Integration von strukturierten Graphdaten verbessert GeAR die Genauigkeit der abgerufenen Informationen, um genauere und kontextgerechte Antworten zu generieren.

- SkalierbarkeitDer modulare Charakter des Agentenrahmens ermöglicht die Integration zusätzlicher Suchstrategien und Datenquellen nach Bedarf.

Anwendungsfall: Multi-hop Quiz

Tipp. Wer hat J.K. Rowlings Mentorin beeinflusst?

System-Prozesse (GeAR-Workflow).

- Bearbeiter an der Spitze der HierarchieBewertung des Multi-Hop-Charakters der Anfrage und Bestimmung der Notwendigkeit, Graphenerweiterung und Dokumentenabfrage zu kombinieren, um die Frage zu beantworten.

- Abbildung Erweiterungsmodul.

- Identifizieren Sie J.K. Rowlings Mentor als Schlüsselperson in der Abfrage.

- Rückverfolgung der literarischen Einflüsse von Mentoren durch Untersuchung der Daten aus der Struktur der Literary Relationship Map.

- Agentenbasiertes Retrieval.

- Ein Agent wählt selbstständig einen graphenerweiterten Suchpfad, um relevante Informationen über die Auswirkungen des Mentors zu sammeln.

- Integrieren Sie zusätzlichen Kontext für unstrukturierte Details über Mentoren und ihre Einflüsse, indem Sie textuelle Datenquellen abfragen.

- AntwortsyntheseLLM: Verwenden Sie LLM, um Erkenntnisse aus dem Graphen und dem Dokumentenabrufprozess zu kombinieren, um eine Antwort zu generieren, die die komplexen Beziehungen in der Anfrage genau wiedergibt.

Antwort.

Integrierte AntwortJ.K. Rowlings Mentorin, [Name der Mentorin], wurde stark von [Name des Autors] beeinflusst, der für sein [berühmtes Werk oder Genre] bekannt ist. Diese Verbindung verdeutlicht die kaskadenartigen Beziehungen in der Literaturgeschichte, wo einflussreiche Ideen oft über mehrere Generationen von Schriftstellern weitergegeben werden."

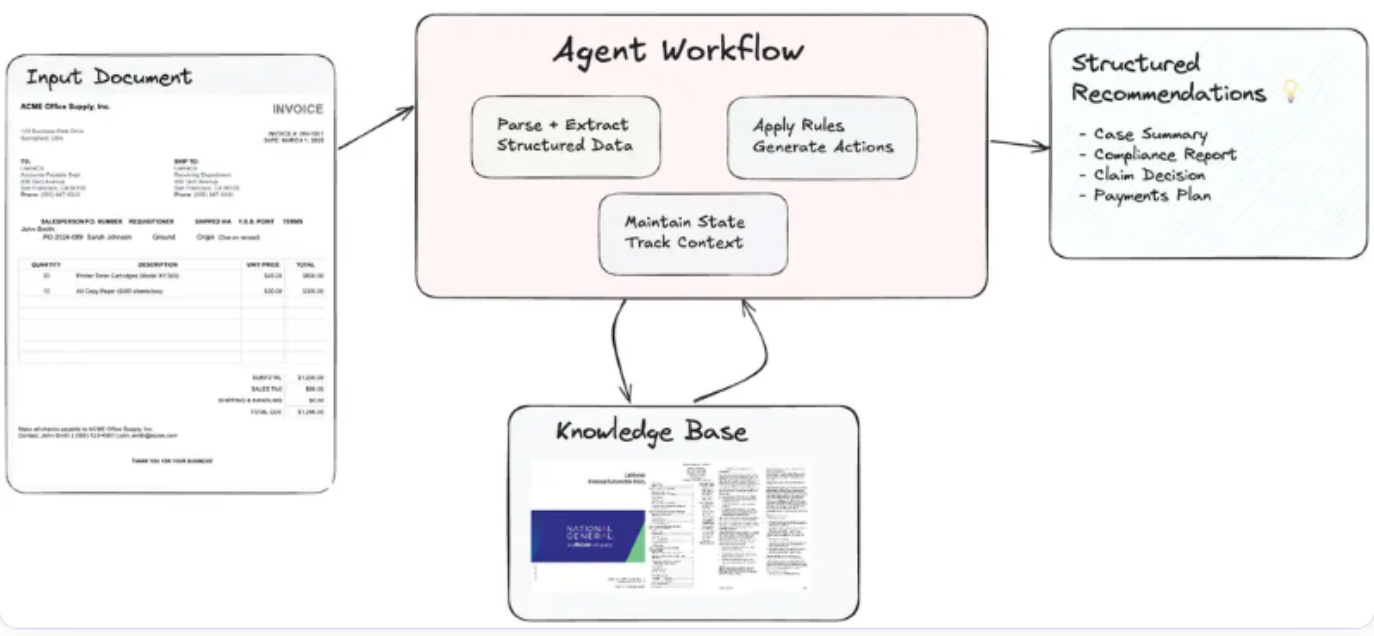

4.7 Agentenbasierte Dokumenten-Workflows in agentenbasierten RAGs

Agentische Dokumenten-Workflows (ADW)[37] erweitert das traditionelle Retrieval Augmented Generation (RAG)-Paradigma durch die Automatisierung von End-to-End-Wissensarbeit. Diese Workflows orchestrieren komplexe dokumentenzentrierte Prozesse, die Dokumenten-Parsing, Retrieval, Reasoning und strukturierte Ausgabe mit intelligenten Agenten integrieren (siehe Abbildung 18).ADW-Systeme adressieren die Einschränkungen von Intelligent Document Processing (IDP) und RAG, indem sie den Status beibehalten, mehrstufige Workflows orchestrieren und domänenspezifische Logik auf Dokumente anwenden.

Arbeitsablauf

- Parsing von Dokumenten und Strukturierung von Informationen::

- Verwenden Sie Tools auf Unternehmensebene (z. B. LlamaParse) zum Parsen von Dokumenten, um relevante Datenfelder wie Rechnungsnummern, Daten, Lieferanteninformationen, Einträge und Zahlungsbedingungen zu extrahieren.

- Organisieren Sie strukturierte Daten für die Weiterverarbeitung.

- Prozessübergreifende Statuspflege::

- Das System behält den Zustand des jeweiligen Dokumentenkontextes bei und sorgt so für Konsistenz und Relevanz in mehrstufigen Arbeitsabläufen.

- Verfolgen Sie den Weg der Dokumente durch die verschiedenen Phasen der Bearbeitung.

- Wissensabfrage::

- Abrufen relevanter Referenzen aus externen Wissensdatenbanken (z. B. LlamaCloud) oder Vektorindizes.

- Abrufen von bereichsspezifischen Anleitungen in Echtzeit für eine bessere Entscheidungsfindung.

- Agentenbasierte Terminplanung::

- Intelligente Agenten wenden Geschäftsregeln an, führen Multi-Hop-Reasoning durch und generieren umsetzbare Empfehlungen.

- Orchestrierung von Komponenten wie Parsern, Retrievern und externen APIs für eine nahtlose Integration.

- Erzeugung umsetzbarer Ergebnisse::

- Die Ergebnisse werden in einem strukturierten Format präsentiert, das auf spezifische Anwendungsfälle zugeschnitten ist.

- Zusammenfassen von Empfehlungen und gewonnenen Erkenntnissen in prägnanten, umsetzbaren Berichten.

Abbildung 18: Ein Überblick über Agentic Document Workflows (ADW) [37]

Anwendungsfall: Workflow für die Rechnungszahlung

auf etw. aufmerksam machenGenerieren Sie einen Zahlungsavis-Bericht auf der Grundlage der eingereichten Rechnungen und der Bedingungen des jeweiligen Lieferantenvertrags.

Systemprozesse (ADW-Workflow)::

- Parsing von Rechnungen, um wichtige Details wie Rechnungsnummer, Datum, Lieferanteninformationen, Einträge und Zahlungsbedingungen zu extrahieren.

- Rufen Sie die entsprechenden Lieferantenverträge ab, um die Zahlungsbedingungen zu überprüfen und eventuelle Rabatte oder Compliance-Anforderungen zu ermitteln.

- Erstellen Sie einen Bericht mit Zahlungsempfehlungen, der den ursprünglich fälligen Betrag, mögliche Nachlässe für vorzeitige Zahlungen, eine Analyse der Auswirkungen auf das Budget und strategische Zahlungsmaßnahmen enthält.

reaktionsschnellKonsolidierte Antwort: "Die Rechnung INV-2025-045 in Höhe von $15.000,00 wurde bearbeitet. Wenn die Zahlung bis zum 2025-04-10 erfolgt, ist ein Frühzahlerrabatt von 2% möglich, wodurch sich der fällige Betrag auf $14.700,00 reduziert. Da die Zwischensumme $10.000,00 übersteigt, wurde ein Großbestellerrabatt von 5% gewährt. Es wird empfohlen, die vorzeitige Zahlung zu genehmigen, um 21 TP3T einzusparen und die rechtzeitige Zuweisung der Mittel für die kommenden Projektphasen zu gewährleisten."

Hauptmerkmale und Vorteile

- ZustandserhaltungVerfolgung des Dokumentenkontextes und der Arbeitsablaufphasen, um die Konsistenz der Prozesse zu gewährleisten.

- mehrstufige ProgrammierungHandhabung komplexer Arbeitsabläufe mit mehreren Komponenten und externen Tools.

- Bereichsspezifische IntelligenzAnwendung maßgeschneiderter Geschäftsregeln und Richtlinien für eine genaue Beratung.

- SkalierbarkeitUnterstützt die Verarbeitung umfangreicher Dokumente mit modularer und dynamischer Agentenintegration.

- Steigerung der ProduktivitätAutomatisierung sich wiederholender Aufgaben bei gleichzeitiger Verbesserung der menschlichen Kompetenz bei der Entscheidungsfindung.

4.8 Vergleichende Analyse von agentenbasierten RAG-Rahmenwerken

Tabelle 2 enthält eine umfassende vergleichende Analyse der drei Architekturen: traditionelle RAG, agentenbasierte RAG und agentenbasierter Dokumenten-Workflow (ADW). Die Analyse hebt ihre jeweiligen Stärken, Schwächen und Best-Fit-Szenarien hervor und liefert wertvolle Erkenntnisse für die Anwendung in verschiedenen Anwendungsfällen.

Tabelle 2: Vergleichende Analyse: traditionelle RAG vs. agentenbasierte RAG vs. agentenbasierter Dokumenten-Workflow (ADW)

| Charakterisierung | Traditionelle RAG | Proxy RAG | Agentenbasierter Dokumenten-Workflow (ADW) |

|---|---|---|---|

| Nachzählung (z.B. Wahlergebnisse) | Isolierte Abruf- und Erzeugungsaufgaben | Multi-Agenten-Kollaboration und Argumentation | Dokumentenzentrierte End-to-End-Workflows |

| Pflege des Kontexts | Zwänge | Realisierung durch Speichermodule | Pflege des Status in einem mehrstufigen Workflow |

| Dynamische Anpassung | minimal | Ihr (Ehrentitel) | Maßgeschneidert für den Dokumenten-Workflow |

| Organisation des Arbeitsablaufs | Hiatus | Orchestrierung von Multi-Agenten-Aufgaben | Integrierte mehrstufige Dokumentenverarbeitung |

| Verwendung von externen Tools/APIs | Grundlegende Integration (z. B. Suchwerkzeuge) | Erweiterung durch Werkzeuge (z. B. APIs und Wissensdatenbanken) | Tiefe Integration mit Geschäftsregeln und bereichsspezifischen Tools |

| Skalierbarkeit | Begrenzt auf kleine Datensätze oder Abfragen | Skalierbares Multiagentensystem | Skalierbare multidisziplinäre Unternehmens-Workflows |

| komplexe Inferenz | Einfach (z. B. einfaches Quiz) | Mehrschrittige Argumentation mit Agenten | Strukturierte Argumentation über Dokumente hinweg |

| wichtige Anwendung | Q&A-System, Wissensabfrage | Multidisziplinäre Kenntnisse und Argumentation | Vertragsprüfung, Rechnungsbearbeitung, Schadensanalyse |

| Schneidkante | Einfache, schnelle Einrichtung | Hohe Genauigkeit, kollaborative Argumentation | End-to-End-Automatisierung, domänenspezifische Intelligenz |

| Herausforderung | Unzureichendes kontextuelles Verständnis | Komplexität der Koordinierung | Ressourcenaufwand, Feldstandardisierung |

Die vergleichende Analyse zeigt die Entwicklung von der traditionellen RAG über die agentenbasierte RAG bis hin zum agentenbasierten Dokumenten-Workflow (ADW). Während traditionelles RAG die Vorteile der Einfachheit und des leichten Einsatzes für grundlegende Aufgaben bietet, führt agentenbasiertes RAG erweiterte Argumentationsfähigkeiten und Skalierbarkeit durch Multi-Agenten-Kollaboration ein.ADW baut auf diesen Fortschritten auf, indem es robuste, dokumentenzentrierte Workflows bietet, die eine durchgehende Automatisierung und Integration mit domänenspezifischen Prozessen erleichtern. Das Verständnis der Stärken und Grenzen der einzelnen Frameworks ist entscheidend für die Auswahl der Architektur, die am besten zu den spezifischen Anwendungsbedürfnissen und betrieblichen Anforderungen passt.

5 Anwendung der stellvertretenden RAG

Agentenbasierte Retrieval Augmented Generation (RAG)-Systeme haben in einer Vielzahl von Bereichen ein transformatives Potenzial. Durch die Kombination von Echtzeit-Datenabfrage, generativen Fähigkeiten und autonomer Entscheidungsfindung bewältigen diese Systeme komplexe, dynamische und multimodale Herausforderungen. In diesem Abschnitt werden die wichtigsten Anwendungen von agentenbasierten RAG-Systemen untersucht und es wird erläutert, wie diese Systeme Bereiche wie Kundensupport, Gesundheitswesen, Finanzwesen, Bildung, juristische Arbeitsabläufe und die Kreativwirtschaft beeinflussen.

5.1 Kundenbetreuung und virtuelle Assistenten

Agentenbasierte RAG-Systeme revolutionieren den Kundensupport, indem sie eine kontextabhängige Lösung von Anfragen in Echtzeit ermöglichen. Traditionelle Chatbots und virtuelle Assistenten stützen sich oft auf statische Wissensdatenbanken, was zu generischen oder veralteten Antworten führt. Im Gegensatz dazu rufen agentenbasierte RAG-Systeme dynamisch die relevantesten Informationen ab, passen sich dem Kontext des Benutzers an und generieren personalisierte Antworten.

Anwendungsfall: Verbesserung des Anzeigenverkaufs auf Twitch [38]

Twitch nutzt zum Beispiel einen agenturähnlichen Workflow mit RAG auf Amazon Bedrock, um den Anzeigenverkauf zu optimieren. Das System ruft dynamisch Daten von Werbetreibenden, historische Kampagnenleistung und Publikumsstatistiken ab, um detaillierte Anzeigenvorschläge zu generieren, was die betriebliche Effizienz erheblich verbessert.

Wichtigste Vorteile:

- Verbesserung der Qualität der AntwortenPersonalisierte und kontextbezogene Antworten erhöhen das Engagement der Nutzer.

- Operative EffizienzReduzierung der Arbeitsbelastung manueller Supportmitarbeiter durch Automatisierung komplexer Abfragen.

- Anpassungsfähigkeit in EchtzeitDynamische Integration sich entwickelnder Daten, wie z. B. Echtzeit-Serviceausfälle oder Preisaktualisierungen.

5.2 Medizinische Behandlung und personalisierte Medizin

Im Gesundheitswesen ist die Kombination von patientenspezifischen Daten mit den neuesten medizinischen Forschungsergebnissen entscheidend, um fundierte Entscheidungen zu treffen. Agentenbasierte RAG-Systeme ermöglichen dies, indem sie in Echtzeit klinische Leitlinien, medizinische Fachliteratur und Patientengeschichten abrufen, um den Arzt bei der Diagnose und Behandlungsplanung zu unterstützen.

Anwendungsfälle: Zusammenfassung von Patientenfällen [39]

Agentenbasierte RAG-Systeme wurden bereits zur Erstellung von Zusammenfassungen von Patientenfällen eingesetzt. Durch die Integration elektronischer Gesundheitsakten (EHR) und aktueller medizinischer Fachliteratur erstellt das System beispielsweise umfassende Zusammenfassungen für Kliniker, damit diese schnellere und fundiertere Entscheidungen treffen können.

Wichtigste Vorteile:

- Personalisierte PflegeEmpfehlungen an die Bedürfnisse der einzelnen Patienten anpassen.

- ZeiteffizienzRationalisieren Sie das Auffinden relevanter Studien und sparen Sie wertvolle Zeit für Gesundheitsdienstleister.

- GenauigkeitEmpfehlungen müssen auf den neuesten Erkenntnissen und patientenspezifischen Parametern beruhen.

5.3 Rechtliche und vertragliche Analyse

Agentenbasierte RAG-Systeme definieren die Art und Weise, wie juristische Arbeitsabläufe ausgeführt werden, neu und bieten Werkzeuge für eine schnelle Dokumentenanalyse und Entscheidungsfindung.

Anwendungsfälle: Vertragsprüfung [40]

Ein RAG-System im Stil eines Rechtsagenten analysiert Verträge, extrahiert Schlüsselklauseln und identifiziert potenzielle Risiken. Durch die Kombination von semantischen Suchfunktionen und juristischer Wissenszuordnung automatisiert es den mühsamen Prozess der Vertragsprüfung, gewährleistet die Einhaltung der Vorschriften und mindert das Risiko.

Wichtigste Vorteile:

- RisikoermittlungAutomatisch: Kennzeichnet Klauseln, die von den Standardklauseln abweichen.

- EffizienzVerringerung des Zeitaufwands für die Vertragsprüfung.

- SkalierbarkeitBearbeitung einer großen Anzahl von Verträgen zur gleichen Zeit.

5.4 Finanz- und Risikoanalyse

Agentengestützte RAG-Systeme verändern die Finanzbranche, indem sie in Echtzeit Erkenntnisse für Anlageentscheidungen, Marktanalysen und Risikomanagement liefern. Diese Systeme integrieren Echtzeit-Datenströme, historische Trends und Prognosemodelle, um umsetzbare Ergebnisse zu erzielen.

Anwendungsfälle: Bearbeitung von Kfz-Versicherungsansprüchen [41]

In der Kfz-Versicherung automatisiert die agentenbasierte RAG die Schadenbearbeitung. Indem sie zum Beispiel Versicherungsdetails abruft und mit Unfalldaten kombiniert, erstellt sie Schadensmeldungen und stellt dabei die Einhaltung der gesetzlichen Vorschriften sicher.

Wichtigste Vorteile:

- Echtzeit-AnalyseBietet Einblicke auf der Grundlage von Echtzeit-Marktdaten.

- RisikominderungIdentifizieren Sie potenzielle Risiken mithilfe von prädiktiven Analysen und mehrstufigen Schlussfolgerungen.

- Verbesserte EntscheidungsfähigkeitKombinieren Sie historische und Echtzeitdaten, um eine umfassende Strategie zu entwickeln.

5.5 Bildung

Bildung ist ein weiterer Bereich, in dem agentenbasierte RAG-Systeme erhebliche Fortschritte gemacht haben. Diese Systeme ermöglichen adaptives Lernen, indem sie Erklärungen, Lernmaterialien und Feedback generieren, die sich an den Fortschritt und die Präferenzen des Lernenden anpassen.

Anwendungsfälle: Erstellung von Forschungspapieren [42]

Im Hochschulbereich wurde die agentenbasierte RAG zur Unterstützung von Forschern eingesetzt, indem wichtige Erkenntnisse aus verschiedenen Quellen zusammengefasst wurden. Forscher, die zum Beispiel die Frage "Was sind die neuesten Fortschritte im Quantencomputing? eine prägnante Zusammenfassung mit Verweisen erhalten und so die Qualität und Effizienz ihrer Arbeit verbessern.

Wichtigste Vorteile: