Kleines Modell, große Leistung: QwQ-32B mit 1/20-Parametern im Kampf gegen den vollblütigen DeepSeek-R1

In letzter Zeit gab es beeindruckende Fortschritte im Bereich der künstlichen Intelligenz, insbesondere bei der Verbesserung der Argumentationsfähigkeit von Large Language Models (LLMs). Dabei wird das Verstärkungslernen (Reinforcement Learning, RL) zu einer Schlüsseltechnologie, um den Leistungsengpass traditioneller Modelle zu überwinden. Viele Studien haben bestätigt, dass RL die Schlussfolgerungsfähigkeit von Modellen erheblich verbessern kann. Das Modell DeepSeek R1 beispielsweise erreichte durch die Integration von Kaltstartdaten und mehrstufigem Training ein tiefes Denken und komplexe Schlussfolgerungen und war zu diesem Zeitpunkt führend.

Vor diesem Hintergrund hat AliCloud das Modell QwQ-32B auf den Markt gebracht, das erneut die Aufmerksamkeit der Branche auf sich gezogen hat. Dieses Modell mit 32 Milliarden Parametern ist in seiner Leistung vergleichbar mit dem DeepSeek-R1 Modell, das eine hohe Anzahl von 671 Milliarden Parametern (37 Milliarden aktivierte Parameter) aufweist. Die herausragende Leistung von QwQ-32B ist ein deutlicher Beweis für die Wirksamkeit des Verstärkungslernens bei der Verbesserung der Intelligenz leistungsfähiger Basismodelle, die auf der Grundlage eines umfangreichen Weltwissens trainiert wurden.

Darüber hinaus hat Aliyun auch agentenbezogene Fähigkeiten in das Denkmodell des QwQ-32B integriert, die ihn nicht nur in die Lage versetzen, kritisch zu denken, sondern auch Werkzeuge zu nutzen und den Denkprozess auf der Grundlage von Umgebungsrückmeldungen anzupassen. Diese technologischen Fortschritte zeigen das transformative Potenzial der RL-Technologie und ebnen den Weg zur allgemeinen künstlichen Intelligenz (AGI).

Derzeit ist QwQ-32B auf den Plattformen Hugging Face und ModelScope unter dem Apache-2.0-Open-Source-Protokoll veröffentlicht, und Benutzer können über die Qwen-Schmätzer Erfahrung.

Einführung

QwQ ist das Inferenzmodell der "Qwen"-Modellfamilie. Im Vergleich zu herkömmlichen Modellen zur Feinabstimmung von Instruktionen verfügen QwQ-Modelle über stärkere Denk- und Schlussfolgerungsfähigkeiten und zeigen erhebliche Leistungssteigerungen bei nachgelagerten Aufgaben, insbesondere beim Lösen komplexer Rätsel. qwQ-32B, ein Inferenzmodell mittlerer Größe, hat eine Leistung ist vergleichbar mit fortgeschrittenen Inferenzmodellen wie DeepSeek-R1 und o1-mini.

Eigenschaften des Modells.

- Typologie: Kausale Sprachmodelle

- AusbildungsphasePre- und Post-Training, einschließlich überwachtem Finetuning und Reinforcement Learning.

- bauenTransformers-Struktur mit RoPE-Positionskodierung, SwiGLU-Aktivierungsfunktion, RMSNorm-Normalisierung und Aufmerksamkeits-QKV-Vorspannung Aufmerksamkeitsmechanismus-Vorspannung

- Parameterskala32,5 Milliarden Dollar (32,5B)

- Parametergrößen der nicht eingebetteten Schicht31 Milliarden Dollar (31.0B)

- Stockwerk: 64

- Leiter der Aufmerksamkeit (GQA): 40 auf der Abfrageseite und 8 auf der Schlüssel/Wert-Seite.

- Länge des KontextsVoll 131.072 Token

zur Kenntnis nehmenFür ein optimales Erlebnis sollten Sie sich auf die Leitlinien für die Verwendung Das QwQ-Modell wird später eingesetzt.

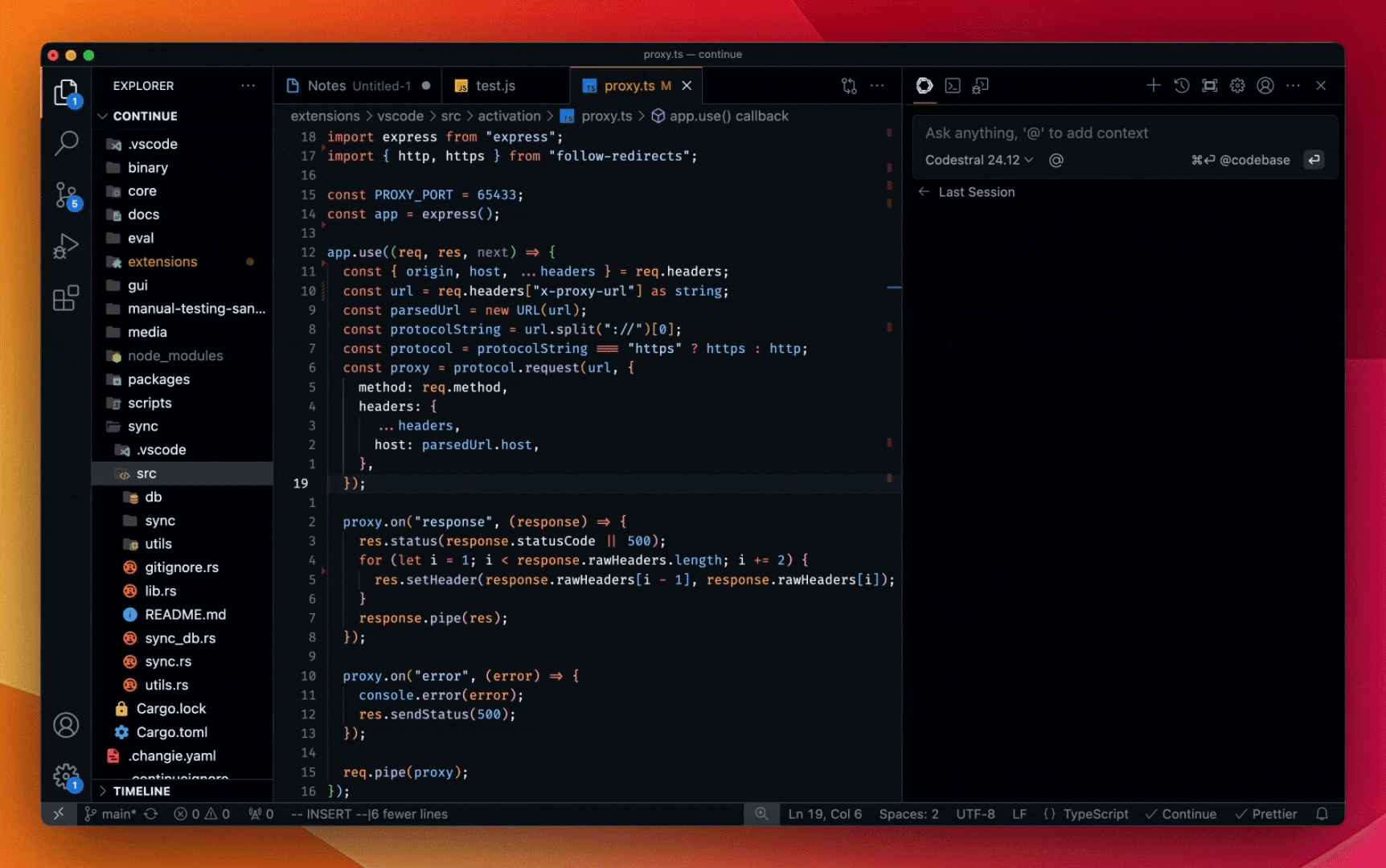

Die Benutzer können die Demo Machen Sie eine Erfahrung, oder gehen Sie durch die QwenChat Um auf das QwQ-Modell zuzugreifen, müssen Sie Thinking (QwQ) öffnen.

Ausführlichere Informationen finden Sie unter GitHub-Repositorien zu offizielles Dokument.

Leistung

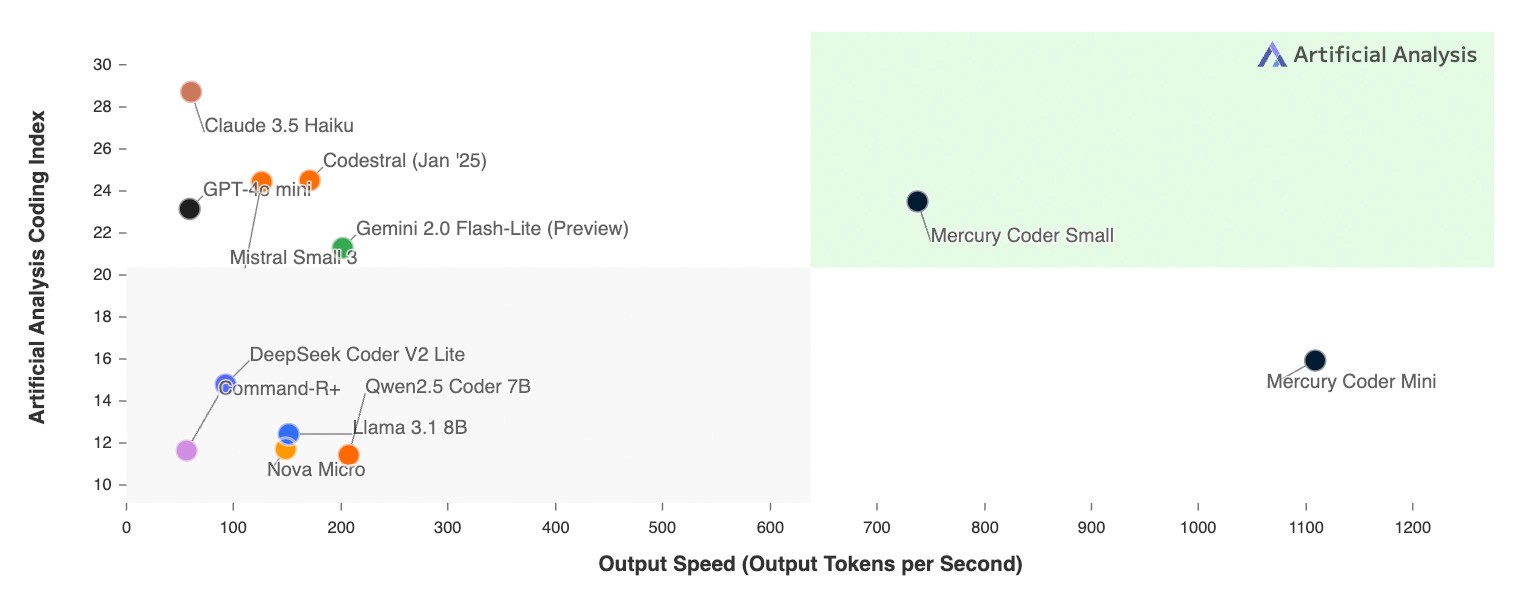

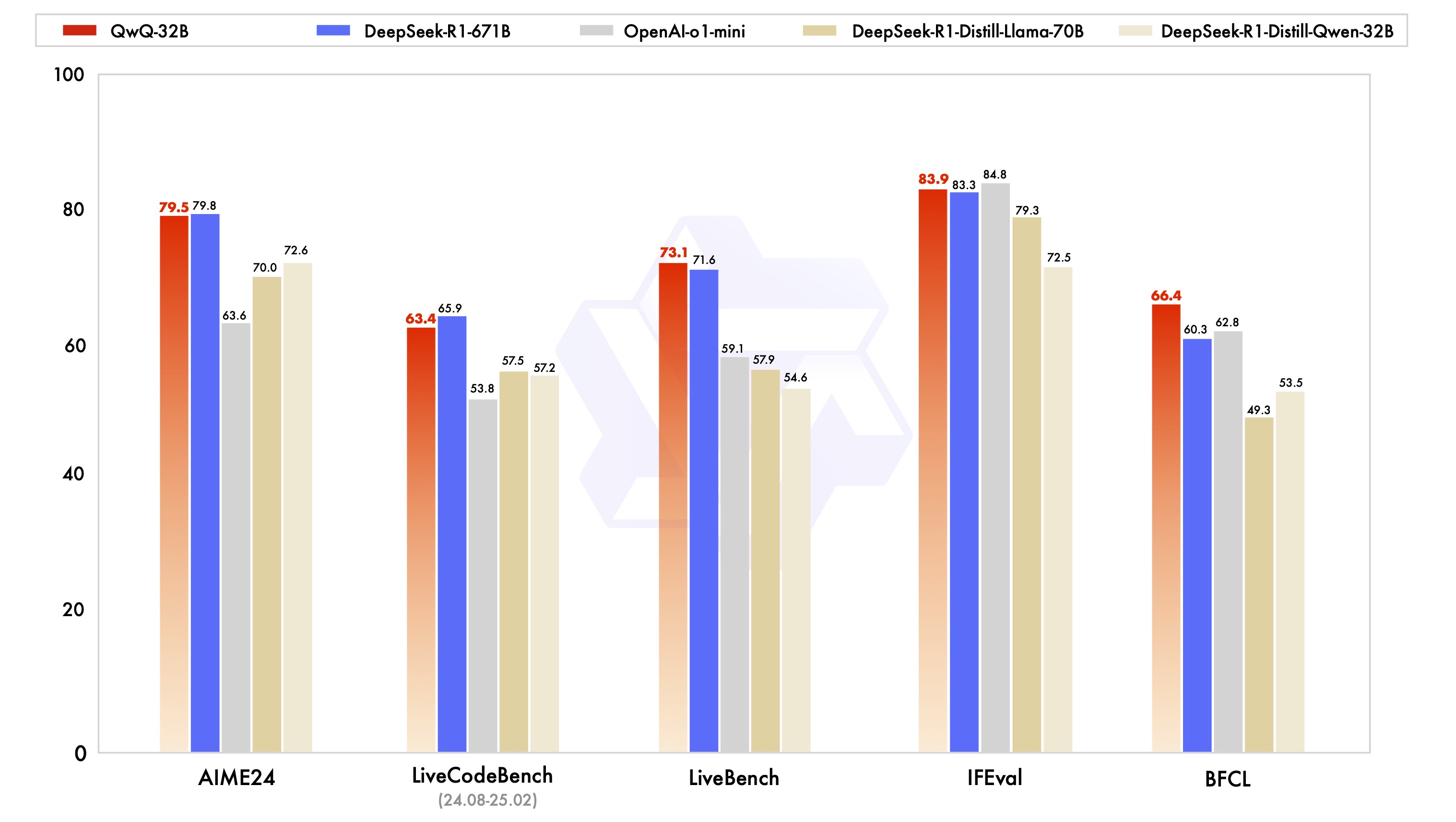

Das Modell QwQ-32B wurde in einer Reihe von Benchmark-Tests bewertet, die einen umfassenden Einblick in seine Fähigkeiten beim mathematischen Denken, beim Schreiben von Code und beim Lösen allgemeiner Probleme geben sollen. Die nachstehende Tabelle zeigt die Leistung von QwQ-32B im Vergleich zu anderen führenden Modellen wie DeepSeek-R1-Distilled-Qwen-32B, DeepSeek-R1-Distilled-Llama-70B, o1-mini und dem ursprünglichen DeepSeek-R1.

Die Ergebnisse zeigen, dass QwQ-32B in mehreren wichtigen Benchmarks ähnlich gut oder sogar besser abschneidet als die Spitzenmodelle. Besonders bemerkenswert ist, dass QwQ-32B immer noch wettbewerbsfähig gegenüber DeepSeek-R1 ist, das eine viel höhere Anzahl von Parametern hat als QwQ-32B, was ein weiterer Beweis für das große Potenzial von Reinforcement Learning zur Verbesserung der Modellleistung ist.

Reinforcement Learning

Die herausragende Leistung des QwQ-32B ist zu einem großen Teil auf die ihm zugrunde liegende Reinforcement Learning (RL)-Technologie zurückzuführen. Einfach ausgedrückt, ist Reinforcement Learning eine Methode, die ein Modell dazu anleitet, durch Belohnungs- oder Bestrafungsmechanismen zu lernen, in einer bestimmten Umgebung optimale Entscheidungen zu treffen. Im Gegensatz zum traditionellen überwachten Lernen stützt sich das Reinforcement Learning nicht auf große Mengen an markierten Daten, sondern interagiert mit der Umgebung und lernt durch Versuch und Irrtum, um schließlich die für die Erfüllung der Aufgabe erforderlichen Strategien zu beherrschen.

Während des Trainings von QwQ-32B implementierte das Aliyun-Forschungsteam eine auf Ergebnisbelohnung basierende Verstärkungslernmethode, die von einem Kaltstart-Kontrollpunkt ausging. In der Anfangsphase konzentrierten sie sich auf die RL-Erweiterung für Mathematik- und Code-Aufgaben. Anstatt sich auf traditionelle Belohnungsmodelle zu verlassen, verwendete das Team einen Accuracy Verifier für die Mathematikfragen, um die Korrektheit der endgültigen Antworten sicherzustellen, und einen Code Execution Server, um zu bewerten, ob der generierte Code die vordefinierten Testfälle erfolgreich bestanden hat.

Mit fortschreitendem Training verbesserte sich die Leistung des Modells sowohl im mathematischen als auch im Code-Bereich kontinuierlich. Nach der ersten Phase fügte das Forschungsteam eine RL-Trainingsphase für generische Fähigkeiten hinzu. In dieser Trainingsphase wurden Belohnungssignale aus dem generischen Belohnungsmodell und eine Reihe von regelbasierten Validatoren verwendet. Die experimentellen Ergebnisse zeigen, dass eine kleine Anzahl von RL-Trainingsschritten die allgemeinen Fähigkeiten des Modells in Bezug auf die Befolgung von Anweisungen, die Anpassung an menschliche Präferenzen und die Leistung des Agenten effektiv verbessern kann, ohne dass es zu einer signifikanten Leistungsverschlechterung in den mathematischen und kodierenden Fähigkeiten kommt.

Hier ist ein Artikel darüber, warum Qwen-2.5-3B ein ausgezeichnetes logisches Denkvermögen hat:Wie werden große Modelle "schlauer"? Die Stanford University enthüllt den Schlüssel zur Selbstverbesserung: vier kognitive Verhaltensweisen

Leitlinien für die Verwendung

Die folgenden Einstellungen werden für eine optimale Leistung empfohlen:

- Modelle dazu zwingen, über den Output nachzudenken:: Sicherstellen, dass die Modelle mit

<think>\num zu vermeiden, dass leere think-Inhalte erzeugt werden, was die Qualität der Ausgabe beeinträchtigen kann. Wenn Sie dieapply_chat_templateund einrichtenadd_generation_prompt=TrueDies wird automatisch umgesetzt. Beachten Sie jedoch, dass dies dazu führen kann, dass die Antwort am Anfang der<think>Kennzeichnung, was normal ist. - Parameter der Probenahme:

- ausnutzen

Temperature=0.6im Gesang antwortenTopP=0.95Anstelle von Greedy Decoding, um endlose Wiederholungen zu vermeiden. - ausnutzen

TopKZwischen 20 und 40 zum Herausfiltern seltener Token erscheinen, wobei die Vielfalt des erzeugten Outputs erhalten bleibt.

- ausnutzen

- Standardisierte AusgabeformateBeim Benchmarking empfiehlt es sich, die Eingabeaufforderung zu verwenden, um die Modellausgabe zu standardisieren.

- mathematisches ProblemIn der Aufforderung fügen Sie hinzu: "Bitte begründen Sie Schritt für Schritt und setzen Sie Ihre endgültige Antwort in die Boxen. "(Bitte begründen Sie Schritt für Schritt und geben Sie Ihre endgültige Antwort innerhalb der Boxen an.

- Multiple-Choice-FrageFügen Sie die folgende JSON-Struktur in die Eingabeaufforderung ein, um die Antwort zu standardisieren: "Bitte zeigen Sie Ihre Wahl im Feld

answerFeld nur mit dem Auswahlbuchstaben, z.B..\"answer\": \"C\". "(Bitte fügen Sie den folgenden Text in dieanswerDas Feld zeigt Ihre Auswahl an und enthält nur den Auswahlbuchstaben, z. B.\"answer\": \"C\").

- Behandlung langer EingabenFür Eingänge mit mehr als 32.768 Token, aktivieren Sie YaRN Techniken, um die Fähigkeit des Modells zu verbessern, lange Sequenzinformationen effektiv zu erfassen.

Bei unterstützten Frameworks kann Folgendes zur config.json Datei, um YaRN zu aktivieren:

{

...,

"rope_scaling": {

"factor": 4.0,

"original_max_position_embeddings": 32768,

"type": "yarn"

}

}

Für die Bereitstellung wird vLLM empfohlen. Wenn Sie mit vLLM nicht vertraut sind, lesen Sie bitte die offizielles Dokument um die Verwendung zu ermitteln. Derzeit unterstützt vLLM nur statische YARNs, was bedeutet, dass der Skalierungsfaktor konstant bleibt, wenn sich die Eingabelänge ändert.Dies kann die Leistung des Modells beeinträchtigen, wenn es um kürzere Texte geht. Es wird daher empfohlen, lange Kontexte nur dann hinzuzufügen, wenn sie verarbeitet werden müssen rope_scaling Konfiguration.

So verwenden Sie QwQ-32B (QwQ-32B verwenden)

Das folgende kurze Beispiel zeigt, wie das Modell QwQ-32B über Hugging Face Transformers und die AliCloud DashScope API verwendet werden kann.

über Hugging Face Transformers.

from transformers import AutoModelForCausalLM, AutoTokenizer

model_name = "Qwen/QwQ-32B"

model = AutoModelForCausalLM.from_pretrained(

model_name,

torch_dtype="auto",

device_map="auto"

)

tokenizer = AutoTokenizer.from_pretrained(model_name)

prompt = "How many r's are in the word \"strawberry\""

messages = [

{"role": "user", "content": prompt}

]

text = tokenizer.apply_chat_template(

messages,

tokenize=False,

add_generation_prompt=True

)

model_inputs = tokenizer([text], return_tensors="pt").to(model.device)

generated_ids = model.generate(

**model_inputs,

max_new_tokens=32768

)

generated_ids = [

output_ids[len(input_ids):] for input_ids, output_ids in zip(model_inputs.input_ids, generated_ids)

]

response = tokenizer.batch_decode(generated_ids, skip_special_tokens=True)[0]

print(response)

Über AliCloud DashScope API.

from openai import OpenAI

import os

# Initialize OpenAI client

client = OpenAI(

# If the environment variable is not configured, replace with your API Key: api_key="sk-xxx"

# How to get an API Key:https://help.aliyun.com/zh/model-studio/developer-reference/get-api-key

api_key=os.getenv("DASHSCOPE_API_KEY"),

base_url="https://dashscope.aliyuncs.com/compatible-mode/v1"

)

reasoning_content = ""

content = ""

is_answering = False

completion = client.chat.completions.create(

model="qwq-32b",

messages=[

{"role": "user", "content": "Which is larger, 9.9 or 9.11?"}

],

stream=True,

# Uncomment the following line to return token usage in the last chunk

# stream_options={

# "include_usage": True

# }

)

print("\n" + "=" * 20 + "reasoning content" + "=" * 20 + "\n")

for chunk in completion:

# If chunk.choices is empty, print usage

if not chunk.choices:

print("\nUsage:")

print(chunk.usage)

else:

delta = chunk.choices[0].delta

# Print reasoning content

if hasattr(delta, 'reasoning_content') and delta.reasoning_content is not None:

print(delta.reasoning_content, end='', flush=True)

reasoning_content += delta.reasoning_content

else:

if delta.content != "" and is_answering is False:

print("\n" + "=" * 20 + "content" + "=" * 20 + "\n")

is_answering = True

# Print content

print(delta.content, end='', flush=True)

content += delta.content

Künftige Arbeit

Die Veröffentlichung von QwQ-32B ist ein erster, aber entscheidender Schritt zur Erweiterung des Reinforcement Learning (RL) für verbesserte Argumentation mit der Qwen-Modellfamilie. Durch diese Erkundung hat Aliyun nicht nur das enorme Potenzial für erweiterte Anwendungen des Reinforcement Learning gesehen, sondern auch das ungenutzte Potenzial innerhalb der vortrainierten Sprachmodelle erkannt.

Aliyun ist zuversichtlich, was die Entwicklung der nächsten Generation von "Thousand Questions"-Modellen angeht. Sie glauben, dass durch die Kombination eines robusteren Basismodells mit Verstärkungslerntechniken, die durch skalierte Rechenressourcen unterstützt werden, das ultimative Ziel der allgemeinen künstlichen Intelligenz (AGI) beschleunigt werden kann. Darüber hinaus erforscht AliCloud aktiv eine tiefere Verschmelzung von Agenten mit RL, um weitreichendere Argumentationsfähigkeiten zu ermöglichen, und setzt sich dafür ein, mehr Intelligenz durch Skalierung am Punkt der Inferenz zu erschließen.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...