Die Zukunft ist da: Ein detaillierter Blick auf die Ära des "Modells als Produkt".

In den letzten Jahren hat es eine nicht enden wollende Diskussion über die nächste Stufe der KI-Entwicklung gegeben: Agentisierung? Stärkere logische Fähigkeiten? Oder echte multimodale Verschmelzung? Alle möglichen Spekulationen sind aufgetaucht und signalisieren einen neuen Wandel im Bereich der KI.

Ich denke, es ist jetzt an der Zeit, ein klares Urteil zu fällen:Die Ära des "Modells als Produkt" ist angebrochen. Dies ist nicht nur ein Trend, sondern ein tiefer Einblick in die aktuelle KI-Entwicklungslandschaft.

Ob es sich nun um die neuesten Erkenntnisse der akademischen Forschung oder um die tatsächliche Entwicklung des kommerziellen Marktes handelt, alle Zeichen weisen eindeutig in diese Richtung.

- Bei der Skalierung allgemeiner Modelle kommt es zu Engpässen: Das "größer ist besser"-Entwicklungsmodell des generischen Großmodells stößt allmählich an seine Grenzen. Dies ist nicht nur eine technische Herausforderung, sondern auch eine Kostenüberlegung. Wie die Diskussion in der Branche nach dem GPT-4 gezeigt hat, ist das Verhältnis zwischen der Steigerung der Modellkapazität und dem rechnerischen Kostenanstieg nicht einfach linear, sondern eine sich ausweitende Schere. Die Modellleistung mag nur linear wachsen, aber die Kosten für die Ausbildung und den Betrieb dieser Giganten steigen exponentiell an. Selbst Unternehmen mit so viel Technologie und Ressourcen wie OpenAI, ganz zu schweigen von anderen Anbietern, haben Mühe, ein Geschäftsmodell zu finden, das ihre enormen Investitionen decken kann. Dies deutet darauf hin, dass die Zeiten, in denen man sich ausschließlich auf die Erweiterung der Modellparametergrößen verlassen konnte, um die KI-Fähigkeiten unendlich zu verbessern, vorbei sein könnten. Wir müssen effizientere, kostenwirksamere und nachhaltigere Wege zur KI-Entwicklung finden.

- Die Orientierungsschulung hat sich zu einer neuen Kraft entwickelt, deren Ergebnisse die Erwartungen weit übertreffen: In krassem Gegensatz zu der ins Stocken geratenen Entwicklung von generischen Modellen, ist die"Meinungsbildende Ausbildung". Ansatz zeigt ein erstaunliches Potenzial. Bei diesem Trainingsparadigma liegt der Schwerpunkt auf der Feinabstimmung und dem Training von Modellen für bestimmte Aufgaben und Anwendungsszenarien. Die Konvergenz von Reinforcement Learning und Reasoning-Techniken hat dem gezielten Training neuen Schwung verliehen. Anstatt einfach "die Daten zu lernen", sehen wir, dass die Modelle tatsächlich beginnen, "die Aufgabe zu lernen". Dies ist ein qualitativer Sprung, der einen Wandel in der Art und Weise markiert, wie KI betrachtet wird. Ob es sich um die verblüffende Leistung kleiner Modelle in der Mathematik, die Entwicklung von Code-Modellen von Code-Generatoren zu autonomen Managern von Code-Basen oder die Claude Fälle, in denen komplexe Spiele mit fast keinem Informationsinput gespielt werden, sind ein Beweis für die Leistungsfähigkeit des Orientierungstrainings. Dieser Weg der "kleinen, aber feinen" und "spezialisierten, aber starken" Modellentwicklung könnte zum Hauptbestandteil künftiger KI-Anwendungen werden.

- Die Kosten für die Modellinferenz sinken drastisch: Auch die Kosten für die Argumentation, die einst als "Hindernis" für die Einführung von KI galten, haben sich stark verringert. Dank DeepSeek Durch die bahnbrechenden Fortschritte bei der Modelloptimierung und der Beschleunigung von Schlussfolgerungen durch Unternehmen wie KI ist die Schwelle für den Einsatz und die Anwendung von KI-Modellen drastisch gesenkt worden. Die neuesten Forschungsergebnisse von DeepSeek zeigen, dass die vorhandene GPU-Rechenleistung theoretisch Milliarden von Menschen auf der ganzen Welt beherbergen kann, die jeweils modernste Modelle verwenden, um 10.000 KI-Modelle pro Tag zu verarbeiten. Token Die Bedürfnisse der Dies bedeutet, dass die Arithmetik nicht länger ein Schlüsselfaktor ist, der die Popularität der KI einschränkt, und die Ära der groß angelegten Anwendung von KI beschleunigt sich. Für Modellanbieter reicht das "Pay-per-Use"-Geschäftsmodell des Token-Verkaufs allein eindeutig nicht aus, um den Wert von KI-Modellen voll auszuschöpfen. Sie müssen sich auf das höhere Ende der Wertschöpfungskette konzentrieren und beispielsweise vertikalere und spezialisierte Modelldienstleistungen und -lösungen anbieten.

All diese Anzeichen deuten darauf hin, dass sich der Schwerpunkt der Entwicklung der KI-Industrie von einem "allgemeinen Modell" zu einem neuen Paradigma des "Modells als Produkt" verschiebt. Dies ist nicht nur eine Anpassung des technischen Weges, sondern auch eine tiefgreifende Veränderung des Geschäftsmodells und des industriellen Musters. Die traditionelle "Apps sind König"-Philosophie muss möglicherweise neu überdacht werden. Lange Zeit haben sich Investoren und Unternehmer auf die KI-Anwendungsebene konzentriert, weil sie glaubten, dass die Anwendungsinnovation der Schlüssel zur KI-Kommerzialisierung ist. In der Ära des "Modells als Produkt" könnte die Anwendungsebene jedoch die erste sein, die automatisiert und unterbrochen wird. Der Schwerpunkt des künftigen Wettbewerbs wird auf den Modellen selbst liegen, und wer über fortschrittlichere, effizientere und professionellere Modelle verfügt, wird sich im KI-Wettbewerb an die Spitze setzen können.

Die Form der zukünftigen Modelle: Spezialisierung, Vertikalisierung, Serviceleistungen

In den letzten Wochen sind zwei repräsentative Produkte aus dem "Modell-als-Produkt"-Paradigma hervorgegangen: DeepResearch von OpenAI und Anthropisch Der Claude 3.7 Sonnet: Beide Produkte spiegeln die Trends der neuen Modellgeneration wider und sind ein Vorbote dessen, wie die Modelle der Zukunft aussehen könnten.

Die DeepResearch von OpenAI, die seit ihrer Veröffentlichung viel Aufmerksamkeit erregt hat, wurde von vielen Fehlinterpretationen begleitet. Viele haben es einfach als eine "Shell"-Anwendung von GPT-4 oder als ein auf GPT-4 basierendes Werkzeug zur Verbesserung der Suche interpretiert. Doch das ist weit von der Wahrheit entfernt. OpenAI trainiert ein völlig neues Modell speziell für Recherche- und Informationsbeschaffungsaufgaben. DeepResearch ist kein "Workflow", der sich auf externe Suchmaschinen oder Tool-Aufrufe stützt, sondern eine echte "Modell der Forschungssprache".Es verfügt über durchgängig autonome Such-, Browsing-, Informationsintegrations- und Berichterstellungsfunktionen, ohne dass ein externer Eingriff erforderlich ist. DeepResearch verfügt über durchgängig autonome Such-, Browsing-, Informationsintegrations- und Berichterstellungsfunktionen, ohne dass ein externer Eingriff erforderlich ist. Jeder, der DeepResearch benutzt hat, kann den Unterschied zu herkömmlichen LLMs oder Chatbots deutlich spüren. Die von DeepResearch generierten Berichte sind klar strukturiert, stringent argumentiert und zuverlässig nachvollziehbar und spiegeln eine Professionalität und Tiefe wider, die weit über die herkömmlicher Suchwerkzeuge und LLMs hinausgeht.

Im Gegensatz dazu sind andere Produkte auf dem Markt, die behaupten, "Deep Search" zu sein, wie z. B. Perplexität und die entsprechenden Funktionen von Google verblassen im Vergleich dazu. Wie Hanchung Lee hervorhebt, basieren diese Produkte im Wesentlichen immer noch auf einem generischen Modell mit einigen einfachen Feinabstimmungen und Funktionsüberlagerungen, und es fehlt ihnen eine tiefgreifende Optimierung und ein systematisches Design für die Suchaufgabe. Das Aufkommen von DeepResearch markiert die erste Landung des Konzepts "Modell als Produkt" und zeigt uns auch die Entwicklungsrichtung spezialisierter und vertikalisierter Modelle.

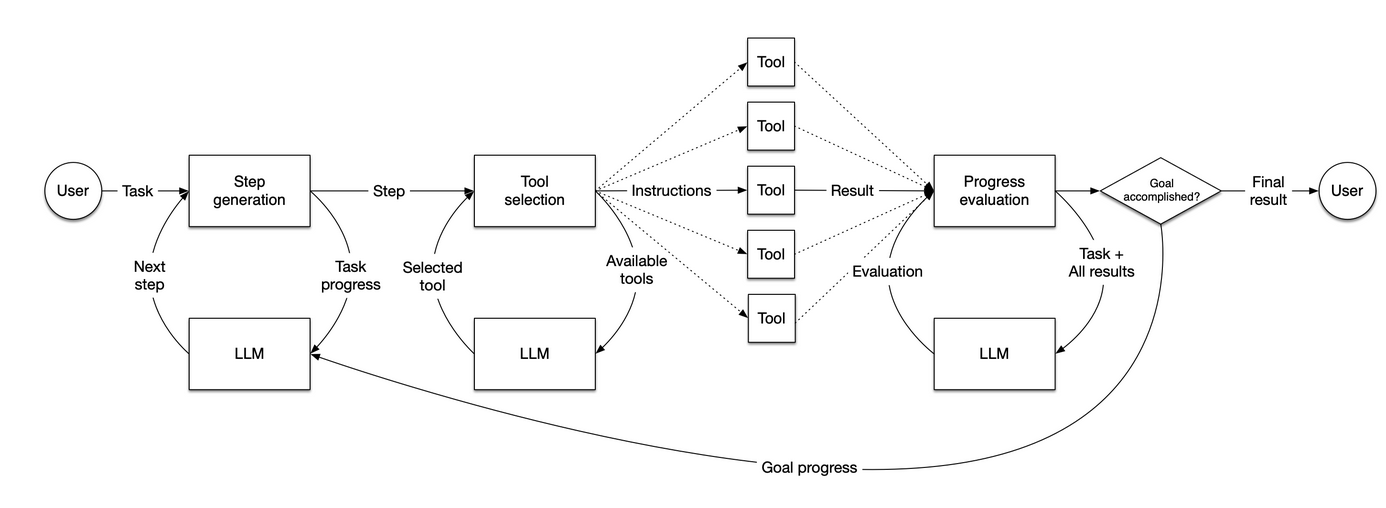

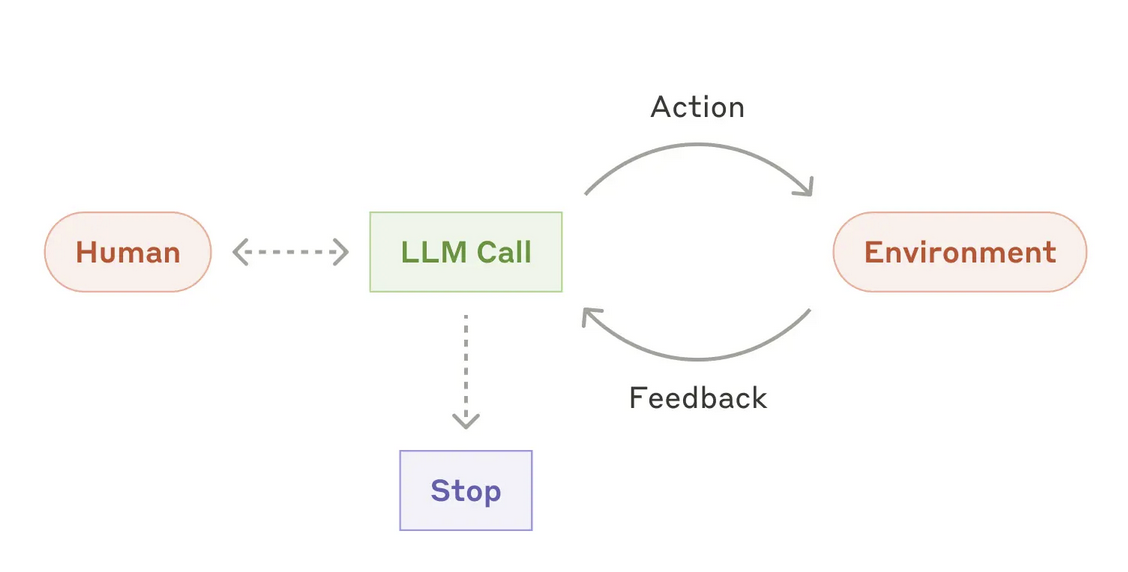

Anthropic verfolgt ebenfalls aktiv eine "Modell als Produkt"-Strategie und hat Einblicke in Agentenmodelle gewährt. Sie haben im Dezember letzten Jahres einen Artikel veröffentlichtForschungsberichtAnthropic hat das Agentenmodell neu definiert. Anthropic argumentiert, dass ein echtes Agentenmodell Folgendes haben sollte "Autonomie".der in der Lage ist, die Zielaufgabe eigenständig zu erledigen, und nicht nur als Glied im Arbeitsablauf. Ähnlich wie DeepResearch legt Anthropic Wert darauf, dass Agentenmodelle "Intern" Vervollständigen Sie den gesamten Prozess der Aufgabenausführung, einschließlich der dynamischen Planung des Aufgabenflusses, der autonomen Auswahl und des Aufrufs von Tools usw., anstatt sich auf vordefinierte Codepfade und externe Orchestrierung zu verlassen.

Es gibt heute eine große Anzahl von Agent-Startups auf dem Markt, aber die meisten der von ihnen entwickelten "Agenten" stecken noch in der "Arbeitsablauf" Ebene. Bei diesen "Agenten" handelt es sich im Wesentlichen um eine Reihe vordefinierter Codeflüsse, die LLMs und verschiedene Werkzeuge miteinander verbinden, um Aufgaben in einer festgelegten Anzahl von Schritten auszuführen. Dieser "Pseudo-Agenten"-Ansatz mag zwar in bestimmten Branchen von gewissem Wert sein, ist aber noch weit entfernt vom "echten Agenten"-Ansatz, wie er von Anthropic und OpenAI definiert wird. Wirklich autonome Systeme müssen auf der Modellebene umgestaltet und innoviert werden, um einen qualitativen Sprung nach vorn zu machen.

Die Veröffentlichung von Anthropic Claude 3.7 ist ein weiterer Beweis für den Trend "Modell als Produkt". Claude 3.7 ist ein Modell, das tiefgreifend für komplexe Codeszenarien optimiert wurde. Claude 3.7 zeigt eine hervorragende Leistung bei der Codegenerierung, dem Codeverständnis und der Codebearbeitung. Besonders erwähnenswert ist, dass selbst ein Modell wie Devin Ein solcher hochkomplexer und intelligenter "KI-Programmierer"-Workflow, der auf Claude 3.7 basiert, konnte auch bei den SWE-Benchmarks deutliche Verbesserungen erzielen. Dies deutet darauf hin, dass die Leistungsfähigkeit des Modells selbst der Schlüssel zum Aufbau großartiger Anwendungen ist. Anstatt viel Aufwand in die Entwicklung komplexer Arbeitsabläufe und externer Tools zu stecken, sollten die Ressourcen in die Entwicklung und Optimierung des Modells selbst investiert werden.

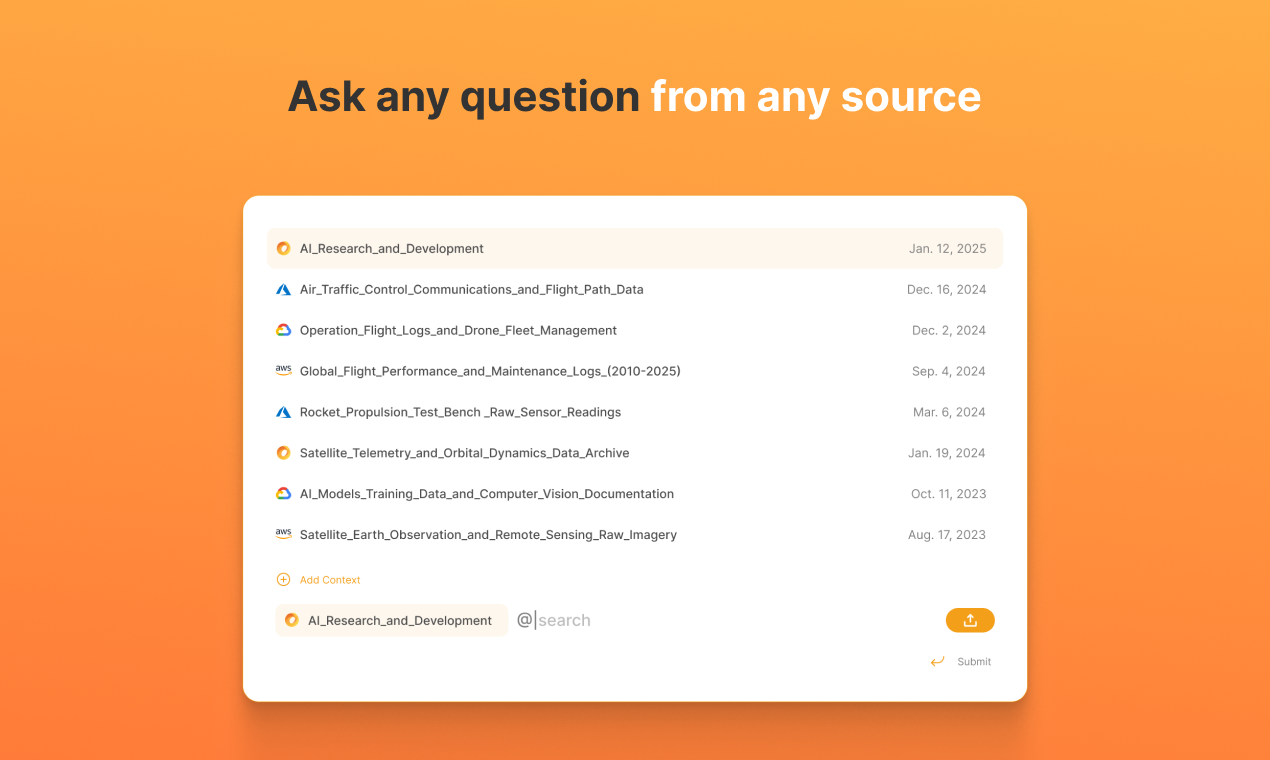

Das Pleias-Team bei RAG Die Erforschung des Bereichs der Retrieval-Augmented Generation (RAG) spiegelt auch die Idee des "Modells als Produkt" wider. Herkömmliche RAG-Systeme bestehen in der Regel aus mehreren unabhängigen und gekoppelten Arbeitsabläufen, wie z. B. Datenrouting, Text-Chunking, Neuordnung von Ergebnissen, Abfrageverständnis, Abfrageerweiterung, Kontextfusion, Suchoptimierung usw. Das Fehlen einer organischen Integration zwischen diesen Verbindungen führt zu einer hohen Anfälligkeit und hohen Wartungs- und Optimierungskosten. Das Fehlen einer organischen Integration zwischen diesen Verbindungen führt zu einer hohen Systemanfälligkeit und hohen Wartungs- und Optimierungskosten. Das Pleias-Team versucht, die neuesten Ausbildungstechniken zu nutzen, um die verschiedenen Aspekte des RAG-Systems zu integrieren. "Modellierung"Die RAG verfügt über zwei Kernmodelle: eines für die Datenvorverarbeitung und den Aufbau der Wissensbasis und das andere für die Informationsbeschaffung, die Generierung von Inhalten und die Berichtsausgabe. Diese beiden Modelle arbeiten miteinander zusammen, um die gesamten Prozessaufgaben der RAG zu erfüllen. Diese Lösung, die eine neue Modellarchitektur, eine verfeinerte Pipeline für synthetische Daten und eine maßgeschneiderte Belohnungsfunktion für das Verstärkungslernen erfordert, stellt eine echte technologische Innovation und einen Durchbruch in der Forschung dar. Durch die "Modellierung" des RAG-Systems kann die Systemarchitektur stark vereinfacht werden, die Systemleistung und -stabilität kann verbessert werden, die Bereitstellungs- und Wartungskosten können gesenkt werden und die RAG-Technologie kann in größerem Umfang eingesetzt werden.

Kurz gesagt, das Kernkonzept von "Modell als Produkt" besteht darin, dass "Komplexität verdrängen". Komplexe Probleme, die ursprünglich auf der Anwendungsebene gelöst werden müssen, werden im Vorfeld auf der Modellebene durch Modelltraining verarbeitet und verdaut. Das Modell lernt und passt sich in der Trainingsphase im Voraus an verschiedene komplexe Szenarien und Extremsituationen an, wodurch der Einsatz und die Anwendung des Modells einfacher und effizienter werden. In Zukunft wird sich der Kernwert von KI-Produkten eher im Modell selbst widerspiegeln als in ausgefallenen Funktionen und komplexen Workflows auf der Anwendungsebene. Modelltrainer werden die dominierenden Akteure bei der Wertschöpfung und -erfassung sein. Anthropic Claude hat sich zum Ziel gesetzt, die derzeitigen Workflow-basierten "Pseudo-Agenten"-Systeme, wie z. B. das von LlamaIndex bereitgestellte Agenten-Framework, zu stören und zu ersetzen. Sie wollen intelligentere, autonomere und einfacher zu bedienende KI-Anwendungen mit leistungsfähigeren Modellen ermöglichen.

wird durch eine fortschrittlichere Modellierungsarchitektur (siehe unten) ersetzt:

Überleben in der Ära des "Modells als Produkt": ein eigenes Modell entwickeln oder vom Modell geschluckt werden?

Auch hier ist die strategische Platzierung der großen KI-Labors keine "verdeckte Operation", sondern klar und offen. Auch wenn ihre Strategien in mancher Hinsicht weniger transparent erscheinen mögen, sind ihre Kernabsichten klar: Sie werden von der Modellebene ausgehen und nach oben zur Anwendungsebene vordringen, um End-to-End-KI-Produkte und -Dienstleistungen zu entwickeln und die Wertschöpfungskette zu dominieren. Die geschäftlichen Auswirkungen dieses Trends sind weitreichend. Naveen Rao, VP von Gen AI bei Databricks, trifft den Nagel auf den Kopf:

In den nächsten 2-3 Jahren werden alle Anbieter von Closed-Source-KI-Modellen nach und nach aufhören, API-Schnittstellen direkt zu verkaufen. Nur Open-Source-Modelle werden weiterhin Dienste über APIs anbieten. Das Ziel der Anbieter von Closed-Source-Modellen ist es, einzigartig wettbewerbsfähige, nicht-generische KI-Funktionen zu entwickeln, und um diese Funktionen bereitzustellen, müssen sie die ultimative Benutzererfahrung und Anwendungsschnittstelle schaffen. Das KI-Produkt der Zukunft wird nicht mehr nur das Modell selbst sein, sondern eine vollständige Anwendung, die das Modell, die Anwendungsschnittstelle und spezifische Funktionen integriert.

Das bedeutet, dass die Flitterwochen der "Arbeitsteilung" zwischen Modellanbietern und App-Entwicklern vorbei sind. Anwendungsentwickler, insbesondere "Wrapper"-Unternehmen, die sich bei der Erstellung von Anwendungen auf Modell-APIs von Drittanbietern stützen, stehen vor nie dagewesenen Herausforderungen, wenn es um ihr Überleben geht. In Zukunft könnte sich die Wettbewerbslandschaft der KI-Branche in die folgenden Richtungen entwickeln:

- Modellanbieter entwickeln ihre eigenen Anwendungen, um Marktanteile zu gewinnen: Claude Code und DeepSearch haben signalisiert, dass die Modellanbieter ihre Anwendungsbereiche aktiv erweitern. DeepSearch hat keine offene API-Schnittstelle, sondern ist in den Premium-Abonnementdienst von OpenAI als Kernfunktion integriert, die den Wert des Dienstes steigert. Claude Code ist ein leichtgewichtiges Endpunkt-Integrationswerkzeug, das es Entwicklern ermöglicht, Claude 3.7-Modelle direkt in einem Code-Editor zu verwenden. Diese Schritte deuten darauf hin, dass die Modellanbieter den Aufbau ihrer eigenen Anwendungsökosysteme beschleunigen, um Dienste direkt für die Nutzer bereitzustellen und Marktanteile zu erobern. Es ist erwähnenswert, dass einige Anwendungs-Wrapper, wie z.B. Cursor, Leistungseinbußen und Benutzerabwanderung erfahren haben, wenn sie mit dem Claude 3.7 Modell verbunden wurden. Dies ist ein weiterer Beleg dafür, dass das Modell das Produkt ist: Ein echter KI-Agent ist darauf bedacht, die eigenen Fähigkeiten des Modells zu maximieren, anstatt sich an bestehende Arbeitsabläufe anzupassen.

- Application Wrapper Transformation, Fokus auf Model Self-Research: Angesichts des "Niedergangs" der Modellanbieter haben einige Head Application Wrapper begonnen, sich aktiv um eine Umgestaltung zu bemühen und versuchen, ihre eigenen Modellschulungskapazitäten aufzubauen. Trotz ihres späten Starts und ihrer relativen Schwäche bei der Modellschulung legen diese Unternehmen aktiv den Grundstein dafür. Cursor zum Beispiel betont den Wert seiner kleinen Modelle zur automatischen Codevervollständigung; WindSurf hat ein hauseigenes, kostengünstiges Code-Modell, Codium; Perplexity verlässt sich seit langem auf einen hauseigenen Klassifikator für das Traffic-Routing und hat damit begonnen, seine eigene Variante von DeepSeek für die Suchverbesserung zu trainieren. Diese Schritte zeigen, dass die Anwendungsentwickler erkannt haben, dass es schwierig ist, sich allein auf das Modell des "API-Aufrufs" zu verlassen, um im künftigen Wettbewerb Fuß zu fassen, und dass sie bestimmte Fähigkeiten zur Selbstentwicklung des Modells beherrschen müssen, um wettbewerbsfähig zu bleiben.

- Wie geht es weiter mit kleinen Verpackern? UI-Innovation könnte der Schlüssel zum Durchbruch sein: Für die große Zahl kleiner und mittlerer Anwendungsumsetzer wird der Spielraum zum Überleben in Zukunft noch enger werden. Wenn große Modelllabore ihre API-Dienste auf breiter Front einschränken, könnten diese kleinen Wrapper gezwungen sein, sich an neutralere Drittanbieter von Argumentationsdiensten zu wenden. Mit der Konvergenz der Modellfunktionen können Innovationen im Bereich der Benutzeroberfläche (UI) und der Benutzererfahrung der Schlüssel zum Durchbruch für kleine Verpackungsunternehmen werden. Der Wert der Benutzeroberfläche wurde im Bereich der KI lange Zeit stark unterschätzt. Da die generischen Modelle immer leistungsfähiger werden und die Modellbereitstellung und die Anwendungsprozesse zunehmend rationalisiert werden, ist dieEine exzellente Benutzeroberfläche wird der Schlüsselfaktor sein, um die Wettbewerbsfähigkeit des Produkts zu verbessern und Nutzer anzuziehen. Insbesondere in Anwendungsszenarien wie RAG ist die Modellfähigkeit möglicherweise nicht mehr der entscheidende Faktor, und Benutzerfreundlichkeit, Interaktivität und Benutzererfahrung werden immer wichtiger.

Kurz gesagt, für die meisten Anwendungsentwickler ist die Zukunft ein "Entweder-Oder"-Dilemma: Entweder werden Sie zum Modellausbilder (Training) oder Sie werden vom Modellbesitzer verschluckt (Being Trained On). Gegenwärtig ist die gesamte Arbeit dieser Application Wrapper in gewisser Weise zu einer "kostenlosen Marktforschung" und "kostenlosen Datenkennzeichnung" für große Modelllabors geworden. Das liegt daran, dass alle Daten zur Nutzerinteraktion und alle Rückmeldungen letztlich an die Modellanbieter fließen, damit diese ihre Modelle verbessern, ihre Produkte optimieren und ihre Marktposition weiter stärken können.

Die künftige Entwicklung von Application Wrappers hängt auch weitgehend von den Einstellungen und Wahrnehmungen der Anleger ab. Besorgniserregend ist, dass das derzeitige Investitionsklima etwas "voreingenommen" gegenüber dem Bereich der Modellausbildung zu sein scheint. Viele Investoren klammern sich noch immer an das traditionelle Konzept "Anwendung ist König" und erkennen nicht den Wert und das Potenzial der Modellschulung. Diese "Fehlanpassung" der Investitionen kann die gesunde Entwicklung der KI-Technologie behindern und sogar dazu führen, dass die westliche KI-Industrie im künftigen Wettbewerb zurückfällt. Infolgedessen müssen einige Anwendungsentwickler ihre Bemühungen im Bereich der Modellschulung möglicherweise "verstecken", um von den Investoren nicht falsch interpretiert zu werden. Die Miniaturen von Cursor und Codium beispielsweise wurden bisher nicht ausreichend bekannt gemacht und beworben. Diese Investitionsorientierung, die sich auf Anwendungen und nicht auf Modelle konzentriert, muss die Branche zum Nachdenken und zur Wachsamkeit anregen.

Das unterschätzte Reinforcement Learning: Der Schlüssel zum zukünftigen Wettbewerb der KI

Im Bereich der KI-Investitionen gibt es derzeit eine Vielzahl von "Reinforcement Learning wurde nicht eingepreist." Das Phänomen. Hinter diesem Phänomen steht die kognitive Voreingenommenheit der Investorengemeinschaft gegenüber dem Entwicklungstrend der KI-Technologie und ihre Vernachlässigung der strategischen Bedeutung der Reinforcement-Learning-Technologie.

Die Investitionsentscheidungen von VCs im Bereich KI beruhen in der Regel auf mehreren Annahmen:

- Die Anwendungsschicht ist die Wertetasche, die Modellschicht ist nur die Infrastruktur: Die Investoren sind im Allgemeinen der Meinung, dass sich der tatsächliche Wert der KI in der Anwendungsebene widerspiegelt und dass die Anwendungsinnovation der Schlüssel ist, um den bestehenden Markt zu stören. Die Modellebene ist nur eine Infrastruktur, die API-Schnittstellen bereitstellt, und hat keine zentrale Wettbewerbsfähigkeit.

- Die Preise für Modell-APIs werden weiter sinken, und die Anwendungsentwickler werden weiterhin davon profitieren: Die Anleger gehen davon aus, dass die Modellanbieter die Preise für API-Aufrufe weiter senken werden, um Marktanteile zu gewinnen und damit die Rentabilität der Anwendungs-Wrapper zu steigern.

- Die Closed-Source-Modell-API ist für alle Anwendungen ausreichend: Die Investoren sind der Meinung, dass Anwendungen, die auf APIs mit geschlossenem Quellcode basieren, den Anforderungen einer Vielzahl von Szenarien gerecht werden können, selbst in sensiblen Branchen mit hohen Anforderungen an Datensicherheit und Autonomie.

- Die Modellschulung ist eine große Investition, ein langer Zyklus, ein hohes Risiko, daher ist es besser, API direkt zu kaufen: Investoren glauben im Allgemeinen, dass der Aufbau von Modellschulungskapazitäten eine "undankbare" Investition ist. Die Modellschulung erfordert enorme Kapitalmengen, lange Zyklen und hohe technische Schwellenwerte, und das Risiko ist viel höher als der direkte Erwerb von Modell-APIs und die schnelle Entwicklung von Anwendungen.

Im Zeitalter des "Modells als Produkt" werden diese Annahmen jedoch zunehmend unhaltbar. Ich befürchte, dass die Investorengemeinschaft, wenn sie weiterhin an diesen überholten Vorstellungen festhält, strategische Chancen für die KI-Entwicklung verpassen und sogar zu einer Fehlallokation von Marktressourcen führen könnte. Der derzeitige KI-Investitionsboom könnte sich zu einem "riskanten Glücksspiel" entwickeln, zu einem "Marktversagen, das die neuesten technologischen Entwicklungen (insbesondere das Reinforcement Learning) nicht richtig einschätzen kann".

Risikokapitalfonds (VC-Fonds), die nach Investitionen in ein Portfolio von Unternehmen suchen sollen "Unkorreliert"Das Ziel von VCs besteht nicht darin, den S&P500-Index zu schlagen. Das Ziel eines VCs ist es nicht, den S&P500-Index zu schlagen, sondern ein diversifiziertes Portfolio aufzubauen, das das Gesamtrisiko reduziert und sicherstellt, dass sich einige Investitionen auch in Abwärtsphasen auszahlen. Modelltraining, das dem Profil des "nicht korrelierten" Investierens entspricht. Vor dem Hintergrund der Rezessionsrisiken in den großen westlichen Volkswirtschaften ist der Bereich der KI-Modellschulung, der ein enormes Innovations- und Wachstumspotenzial birgt, nur schwach mit den makroökonomischen Zyklen korreliert. Allerdings haben die Modellbildungsunternehmen im Allgemeinen mit Finanzierungsschwierigkeiten zu kämpfen, was der wesentlichen Logik des Risikokapitals zuwiderläuft. Prime Intellect ist eines der wenigen westlichen Start-ups für die Ausbildung von KI-Modellen, die das Potenzial haben, sich zu einem hochmodernen KI-Labor zu entwickeln. Trotz ihrer technologischen Durchbrüche, darunter die Ausbildung des ersten dezentralen LLM, ist ihr Finanzierungsumfang mit dem eines gewöhnlichen "Shell"-App-Unternehmens vergleichbar. Dieses Phänomen des "schlechten Geldes, das das gute Geld verdrängt", regt zum Nachdenken an.

Mit Ausnahme einiger weniger großer Labors ist das derzeitige Ökosystem für das Training von KI-Modellen noch sehr fragil und marginal. Weltweit gibt es nur eine Handvoll innovativer Unternehmen, die sich auf die Modellausbildung konzentrieren. Prime Intellect, Moondream, Arcee, Nous, Pleias, Jina, das HuggingFace Pre-Trainingsteam (das sehr klein ist) und andere machen fast den gesamten Open-Source-KI-Modell-Trainingsbereich aus. Zusammen mit einer Handvoll akademischer Einrichtungen wie Allen AI, EleutherAI usw. bauen und pflegen sie die Eckpfeiler der aktuellen Open-Source-KI-Trainingsinfrastruktur. In Europa habe ich erfahren, dass es 7-8 LLM-Projekte gibt, die planen, Modelle auf der Grundlage des Common Corpus-Korpus und der vom Pleias-Team entwickelten Pre-Trainingstools zu trainieren. Die florierende Open-Source-Gemeinschaft hat einen Teil dazu beigetragen, den Mangel an kommerziellen Investitionen auszugleichen, aber sie hat sich auch bemüht, die Herausforderungen, denen sich das Ökosystem der Modellausbildung gegenübersieht, an der Wurzel zu packen.

Auch OpenAI scheint sich der Bedeutung von "Vertical RL" sehr bewusst zu sein. Kürzlich gab es Berichte, dass OpenAI-Führungskräfte ihre Unzufriedenheit mit der Startup-Szene im Silicon Valley geäußert haben, die "wenig auf RL und viel auf Anwendungen" ausgerichtet ist. Vermutlich kam diese Botschaft von Sam Altman selbst und wird sich vielleicht im nächsten YC Startup Camp widerspiegeln. Dies signalisiert einen möglichen Wechsel in der Kooperationsstrategie von OpenAI. Künftig wird OpenAI vielleicht nicht mehr nur API-Kunden, sondern "Co-Contractors" auswählen, die an den frühen Ausbildungsphasen der Modelle beteiligt sind. Das Modelltraining, das vom Hintergrund in den Vordergrund rückt, wird ein zentraler Aspekt des KI-Wettbewerbs werden.

Die Ära des "Modells als Produkt" bedeutet einen Paradigmenwechsel in der KI-Innovation. Die Zeit der Einzelkämpfer ist vorbei, offene Zusammenarbeit und kollaborative Innovation werden zum Mainstream. Die Bereiche Suche und Code sind die ersten, in denen das "Modell als Produkt" zum Einsatz kommt, was zum großen Teil an der relativen Reife der Anwendungsszenarien in diesen beiden Bereichen, der eindeutigen Marktnachfrage und dem klaren Technologiepfad liegt, der es leicht macht, die "niedrig hängenden Früchte" zu pflücken. Wie Cursor Solche innovativen Produkte können in wenigen Monaten auf den Markt gebracht werden. Hochwertige KI-Anwendungsszenarien für die Zukunft, wie z. B. die intelligente Verbesserung regelbasierter Systeme, befinden sich jedoch noch in einem frühen Stadium der Erforschung, mit enormen technischen Herausforderungen und unsicherer Marktnachfrage, was es schwierig macht, kurz-, mittel- und langfristig Durchbrüche zu erzielen. Dies sind Bereiche, die kleine Teams mit interdisziplinärem Hintergrund und einem hohen Maß an Konzentration für langfristige und tiefgreifende FuE-Investitionen erfordern. Diese "kleinen und feinen" Innovationsteams könnten sich in Zukunft zu einer wichtigen Kraft in der KI-Branche entwickeln und von großen Technologieunternehmen übernommen werden, um ihren Wert zu realisieren, nachdem sie ihre frühe Technologieakkumulation abgeschlossen haben. Ein ähnliches Modell der Zusammenarbeit könnte sich im Bereich der Benutzeroberflächen (UI) entwickeln. Einige Unternehmen, die sich auf UI-Innovationen konzentrieren, könnten differenzierte und wettbewerbsfähige KI-Produkte entwickeln, indem sie strategische Partnerschaften mit großen Modelllabors eingehen, um exklusiven API-Zugang zu speziellen Closed-Source-Modellen zu erhalten.

Die strategische Ausrichtung von DeepSeek ist zweifellos zukunftsorientierter und ehrgeiziger im Sinne des Trends "Modell ist Produkt". Das Ziel von DeepSeek ist nicht nur "Modell als Produkt", sondern "Modell als gemeinsame Infrastrukturschicht". Ähnlich wie bei OpenAI und Anthropic hat der DeepSeek-Gründer Wenfeng Lien seine Vision für DeepSeek öffentlich dargelegt:

Wir glauben, dass die derzeitige Phase Eine Explosion der technologischen Innovation, nicht eine Explosion der AnwendungenDer erste Schritt besteht darin, sicherzustellen, dass Sie die richtige Mischung aus KI und KI-Anwendungen haben. Erst wenn ein komplettes KI-vor- und -nachgelagertes Industrie-Ökosystem etabliert ist, muss DeepSeek die Anwendung nicht selbst durchführen. Natürlich kann DeepSeek bei Bedarf auch Anwendungen erstellen, aber das ist nicht vorrangig. Die Kernstrategie von DeepSeek bestand schon immer darin, an technologischen Innovationen festzuhalten und eine leistungsstarke gemeinsame KI-Infrastrukturplattform aufzubauen.

In der Ära des "Modells als Produkt" ist die Beschränkung auf die Anwendungsschicht nichts anderes als "Setzen Sie die Generäle der letzten Kriegsgeneration ein, um die nächste Kriegsgeneration zu befehligen".Besorgniserregend ist, dass die westliche KI-Industrie noch immer in der alten Mentalität "Anwendung ist König" verhaftet zu sein scheint. Besorgniserregend ist, dass die westliche KI-Industrie immer noch in der alten Denkweise "Anwendung ist König" verhaftet zu sein scheint und nicht ausreichend auf die neuen Trends in der KI-Entwicklung vorbereitet ist. Vielleicht haben viele Menschen noch nicht bemerkt, dass der "Krieg" im Bereich der KI leise in eine neue Phase eingetreten ist. Wer das neue Paradigma des "Modells als Produkt" als Erster umsetzt, wird im künftigen KI-Wettbewerb einen Vorsprung haben.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...