Original: DieDense X Retrieval: Welche Abrufgranularität sollten wir verwenden?Die

Hinweis: Diese Methode eignet sich für eine kleine Anzahl von Modellen, wie z. B. die OPENAI-Serie, die Claude-Serie, Mixtral, Yi, qwen und so weiter.

Abstracts

In offenen Aufgaben der natürlichen Sprachverarbeitung (NLP) ist die dichte Suche zu einer wichtigen Methode geworden, um relevantes Kontext- oder Weltwissen zu erlangen. Wenn wir gelernte Dense Retriever zum Abrufen von Korpora zur Inferenzzeit verwenden, ist eine oft übersehene Designentscheidung die Retrievaleinheit, d.h. die Granularität, mit der das Korpus indiziert wird, z.B. Dokumente, Absätze oder Sätze. Wir haben festgestellt, dass die Wahl der Abfrageeinheit die Abfrageleistung sowie die Leistung nachgelagerter Aufgaben erheblich beeinflusst. Im Gegensatz zum traditionellen Ansatz, der Absätze oder Sätze verwendet, führen wir eine neue Retrieval-Einheit, Propositionen, für intensives Retrieval ein. Propositionen werden als atomare Ausdrücke im Text definiert, von denen jeder einen eindeutigen Sachverhalt kapselt und in einem prägnanten, in sich geschlossenen natürlichsprachlichen Format präsentiert wird. Wir vergleichen empirisch verschiedene Retrieval-Granularitäten. Unsere Ergebnisse zeigen, dass das propositionsbasierte Retrieval die traditionellen absatz- oder satzbasierten Ansätze beim dichten Retrieval deutlich übertrifft. Darüber hinaus verbessert die Suche nach Propositionen die Leistung nachgelagerter Frage-Antwort-Aufgaben, da der gefundene Text kompaktere, für die Frage relevante Informationen enthält, wodurch der Bedarf an langen Eingabe-Tokens reduziert und die Aufnahme irrelevanter Informationen minimiert wird.

1 Einleitung

Dense Retriever sind eine Klasse von Techniken, die für den Zugriff auf externe Informationsquellen für wissensintensive Aufgaben verwendet werden. Bevor wir einen gelernten Dense Retriever zum Abrufen von Informationen aus einem Korpus verwenden können, müssen wir eine wichtige Design-Entscheidung treffen, nämlich die Abrufeinheit - d.h. die Granularität, mit der wir den abgerufenen Korpus in unserer Argumentation segmentieren und indizieren. In der Praxis ist die Wahl der Retrieval-Einheiten, z. B. Dokumente, Abschnitte von Absätzen oder Sätzen fester Länge usw., in der Regel dadurch vorgegeben, wie das Dense Retrieval-Modell instanziiert oder trainiert wurde.

In diesem Beitrag gehen wir einer Forschungsfrage nach, die bei dichten Retrievals vernachlässigt wurde: Mit welcher Retrieval-Granularität sollten wir den Retrieval-Korpus segmentieren und indizieren? Wir stellen fest, dass die Wahl der geeigneten Retrieval-Granularität zum Zeitpunkt des Reasonings eine einfache, aber effektive Strategie zur Verbesserung der Leistung von Dense Retrievern sowohl für Retrieval- als auch für nachgelagerte Aufgaben sein kann.

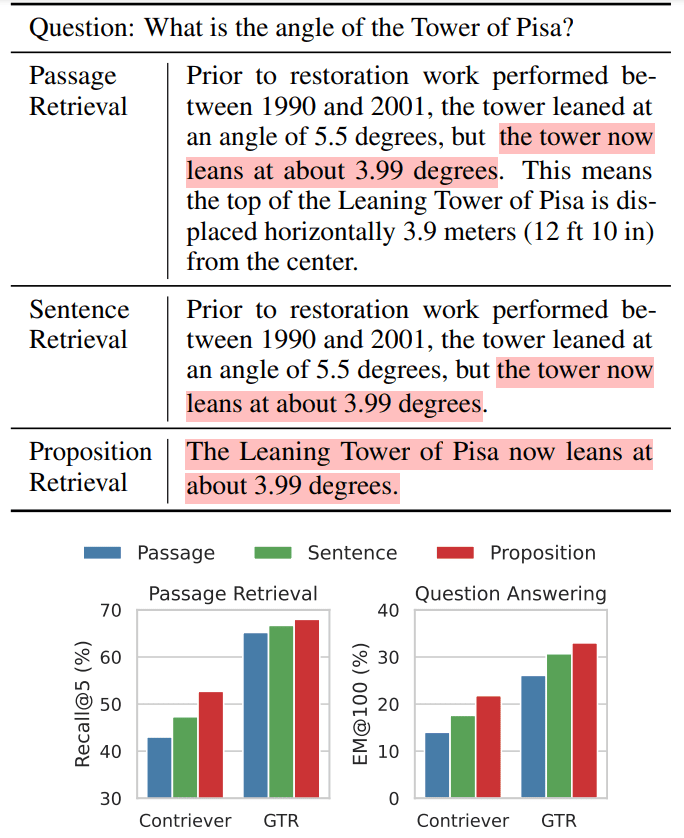

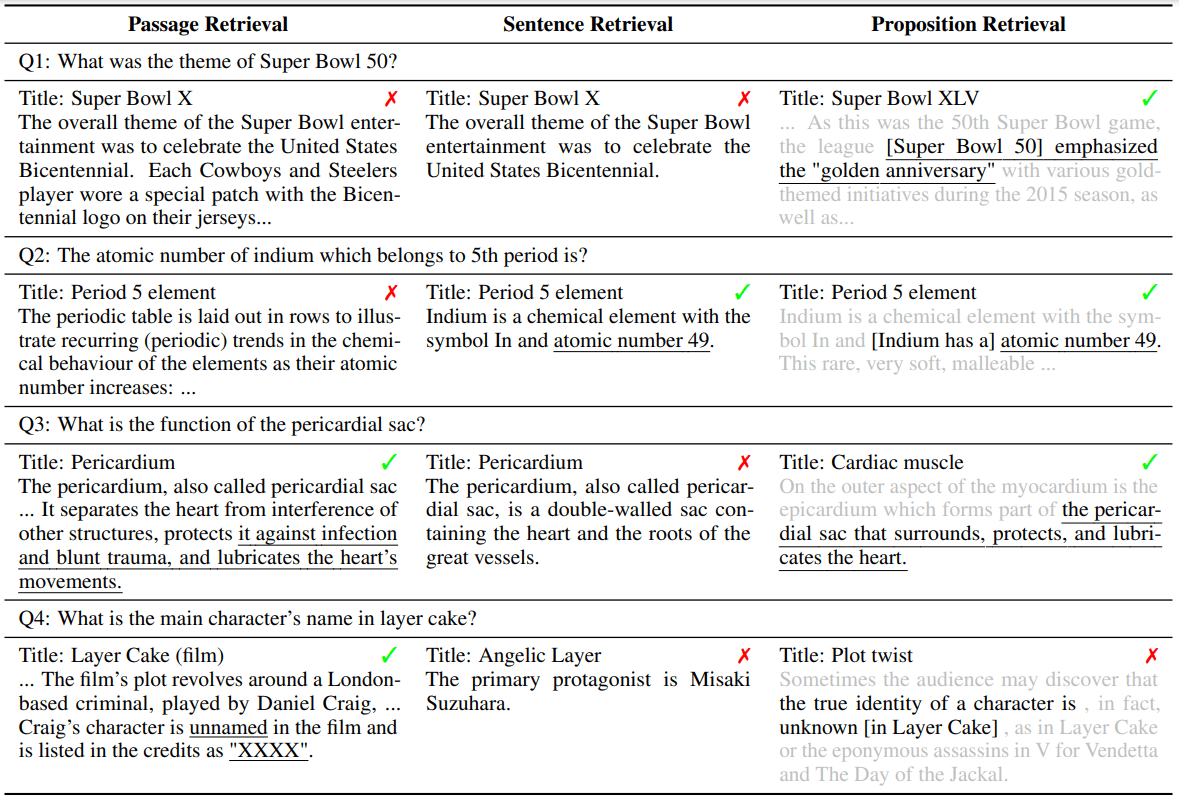

Wir veranschaulichen unsere Intuition anhand eines Beispiels einer offenen Frage und Antwort (QA) (Tabelle 1).

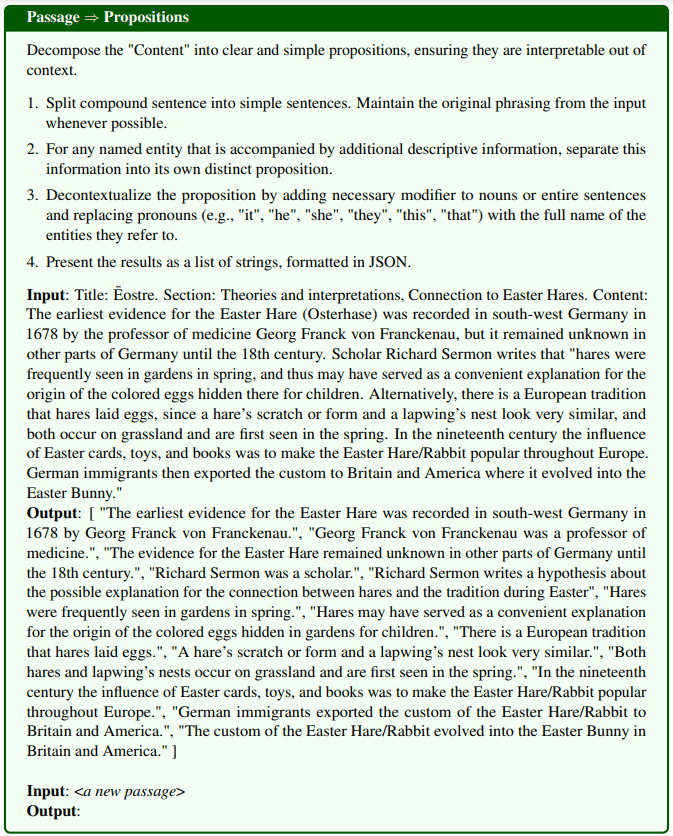

Tabelle 1 Abbildung 1: Beispiele für drei Suchgranularitäten für Wikipedia-Text bei intensiver Suche

Oben: Zeigt, dass Wikipedia-Text in drei verschiedene Sucheinheiten unterteilt werden kann, wenn eine dichte Suchmethode verwendet wird.

UNTEN: Wir haben festgestellt, dass das Abrufen über Propositionen (Propositionen) sowohl bei Aufgaben zum Abrufen von Absätzen als auch bei nachgelagerten Aufgaben zu offenen Fragen und Antworten (QA) die beste Abrufleistung erbrachte. Als Backbone-Retriever wurden beispielsweise Contriever (Izacard et al., 2022) oder GTR (Ni et al., 2022) verwendet. Hervorgehobene Abschnitte kennzeichnen Abschnitte, die Antworten auf Fragen enthalten.

Dieses Beispiel zeigt, wie dasselbe Modell Text auf drei verschiedenen Ebenen der Granularität abruft. Theoretisch können Passagen, die eine gröbere Granularität aufweisen, mehr relevante Informationen für die Frage liefern. Allerdings enthalten Absätze oft zusätzliche Details, die die Aufmerksamkeit des Retrievers und des Sprachmodells der nachgelagerten Aufgabe ablenken können (z. B. die Erholungszeit und die horizontale Verschiebung im Beispiel in Tabelle 1). Die Indizierung auf Satzebene hingegen bietet zwar einen detaillierteren Ansatz, geht aber nicht vollständig auf dieses Problem ein. Das liegt daran, dass Sätze nach wie vor komplex und zusammengesetzt sein können und in der Regel nicht in sich geschlossen sind, da ihnen die notwendigen Kontextinformationen fehlen, um die Relevanz von Abfragen und Dokumenten zu beurteilen.

Um diese Unzulänglichkeiten herkömmlicher Retrievaleinheiten (z. B. Absätze oder Sätze) zu beheben, schlagen wir die Verwendung von Propositionen als neuartige Retrievaleinheit für die intensive Suche vor. Propositionen sind definiert als atomare Ausdrücke in einem Text, von denen jeder eine eindeutige Tatsache enthält und in einem prägnanten, in sich geschlossenen natürlichsprachlichen Format dargestellt wird. Ein Beispiel für einen Satz ist in Tabelle 1 dargestellt. Der Satz beschreibt Informationen über den aktuellen Neigungswinkel des schiefen Turms von Pisa in einer in sich geschlossenen Weise und beantwortet genau das, was in der Frage abgefragt wird. Eine genauere Definition und Beschreibung finden Sie in Abschnitt II.

Um die Effektivität der Verwendung von Propositionen als Retrieval-Einheiten für dichte Retriever-Inferenz zu validieren, haben wir zunächst einen englischsprachigen Wikipedia-Dump verarbeitet und indiziert, der alle Dokumente in Propositionen aufteilt, was wir als FACTOIDWIKI bezeichnen. Anschließend haben wir Experimente mit fünf verschiedenen QS-Datensätzen durchgeführt und die Leistung der sechs Dual-Encoder-Retriever empirisch verglichen, wenn die Wikipedia nach Absätzen, Sätzen und unseren vorgeschlagenen Propositionen indiziert ist Leistung der sechs Dual-Encoder-Retriever bei Indizierung nach Absatz, Satz und Proposition. Unsere Bewertung ist zweifach: Wir untersuchen sowohl die Retrievalleistung als auch die Auswirkungen auf nachgelagerte QS-Aufgaben. Unsere Ergebnisse deuten darauf hin, dass das propositionsbasierte Retrieval satz- und absatzbasierte Ansätze in Bezug auf die Generalisierung übertrifft, wie in Abschnitt V erläutert. Dies deutet darauf hin, dass Propositionen als kompakte und inhaltsreiche Kontexte fungieren, die es dichten Retrievern ermöglichen, auf präzise Informationen zuzugreifen und dabei den richtigen Kontext zu wahren. Die Verbesserung des durchschnittlichen Recalls @20 für passagenbasiertes Retrieval beträgt +10,1 gegenüber dem unbeaufsichtigten dichten Retriever und +2,2 gegenüber dem überwachten Retriever. Darüber hinaus beobachten wir einen klaren Vorteil in der nachgelagerten QS-Leistung, wenn wir propositionsbasiertes Retrieval verwenden, wie in Abschnitt VI beschrieben. Angesichts der typischerweise begrenzten Länge von Eingabe-Token in einem Sprachmodell bieten Propositionen von Natur aus eine höhere Dichte an fragestellungsrelevanten Informationen.

Der wichtigste Beitrag unseres Papiers ist:

- Wir schlagen vor, bei der Indizierung eines Suchkorpus Propositionen als Retrieval-Einheiten zu verwenden, um die intensive Retrieval-Leistung zu verbessern.

- Wir stellen FACTOIDWIKI vor, einen verarbeiteten englischen Wikipedia-Dump, in dem jede Seite in mehrere Granularitäten unterteilt ist: 100-Wort-Absätze, Sätze und Propositionen.

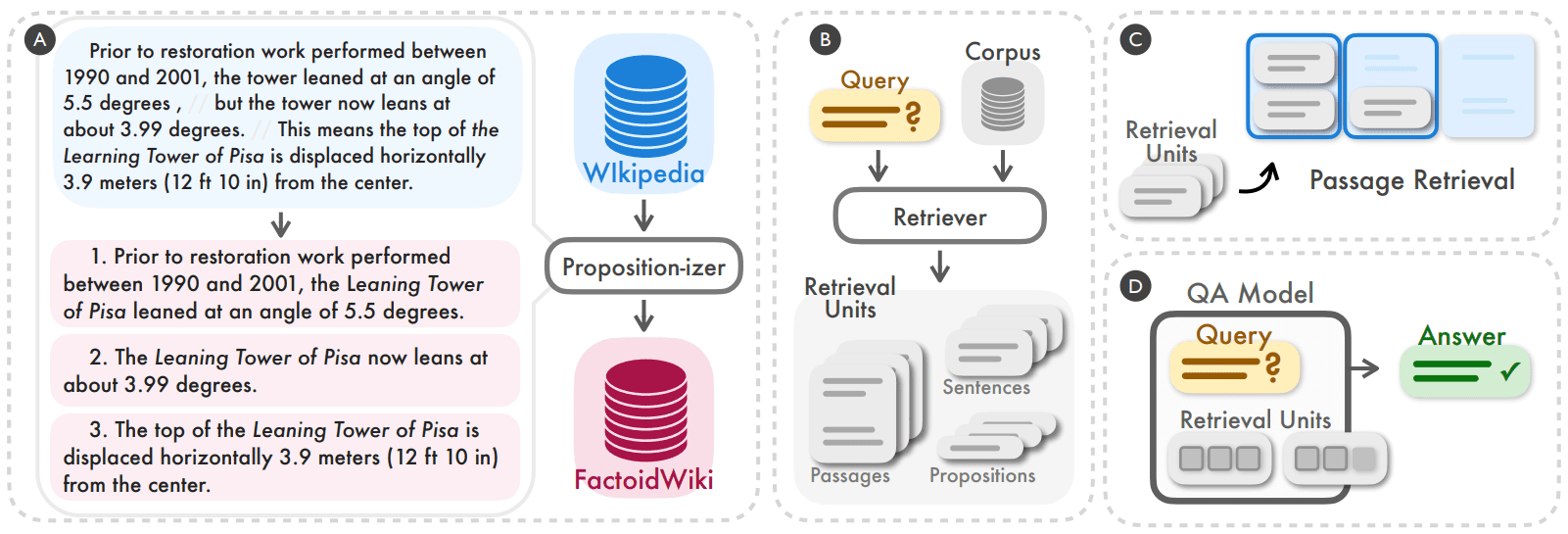

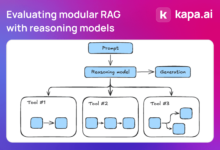

Abbildung 2: Wir haben herausgefunden, dass die Segmentierung und Indizierung des Retrieval-Korpus auf Propositionsebene eine einfache und effektive Strategie sein kann, um die Generalisierungsleistung von Dense Retrievern bei Schlussfolgerungen zu verbessern (A, B). Wir vergleichen empirisch die Leistung des dichten Retrievers bei Retrieval- und nachgelagerten Frage-und-Antwort-Aufgaben (QA), wenn er auf der Ebene von 100 Wörtern, Sätzen oder Propositionen arbeitet (C, D).

2 Propositionen als Sucheinheiten

Das Ziel unserer Studie ist es, empirisch zu verstehen, wie die Granularität eines Retrieval-Korpus die Leistung eines dichten Retrieval-Modells beeinflusst. Zusätzlich zu den üblicherweise verwendeten Retrieval-Einheiten, wie z.B. 100-Wort-Absätze oder -Sätze, schlagen wir die Verwendung von Propositionen als eine alternative Retrieval-Einheit vor. Dabei stellen Propositionen atomare Bedeutungsausdrücke in einem Text dar und werden durch die folgenden drei Prinzipien definiert.

- Jeder Satz sollte einem eindeutigen Bedeutungsfragment des Textes entsprechen, und die Kombination aller Sätze stellt die Semantik des gesamten Textes dar.

- Der Satz sollte minimal sein, d.h. er kann nicht weiter in einzelne Sätze aufgeteilt werden.

- Die Sätze sollten kontextbezogen und in sich geschlossen sein. Sätze sollten den gesamten notwendigen Kontext aus dem Text enthalten (z. B. Ko-Referenz), um ihre Bedeutung zu erklären.

Die Verwendung von Propositionen als Retrieval-Einheiten wurde durch eine Reihe neuerer Arbeiten inspiriert, die erfolgreich die Semantik von Texten auf propositionaler Ebene darstellen und bewerten. Wir demonstrieren den Begriff der Propositionen und wie ein Absatz in seine Menge von Propositionen unterteilt werden kann anhand des Beispiels auf der linken Seite von Abbildung 2. Der Absatz enthält drei Sätze, von denen jeder einer einzigen Tatsache über den Schiefen Turm von Pisa entspricht: dem Winkel vor der Restaurierung, dem aktuellen Winkel und der horizontalen Verschiebung. In jedem Satz ist der notwendige Kontext aus dem Text enthalten, so dass die Bedeutung des Satzes unabhängig vom Originaltext interpretiert werden kann, z. B. wird der Verweis auf den Turm im ersten Satz als sein voller Name, der Schiefe Turm von Pisa, analysiert. Wir gehen davon aus, dass jeder Satz einen kontextualisierten, atomaren Sachverhalt genau beschreibt, so dass wir davon ausgehen, dass sich Sätze als Retrieval-Einheiten für Information Retrieval Probleme eignen werden.

3 FACTOIDWIKI: Indexierung und Suche auf Vorschlagsebene in Wikipedia

Wir haben die Verwendung von 100-Wort-Absätzen, Sätzen und Propositionen als Retrieval-Einheiten in Wikipedia empirisch verglichen. Wikipedia ist eine häufig genutzte Quelle für die Suche in wissensintensiven NLP-Aufgaben. Um faire Vergleiche auf verschiedenen Granularitäten zu ermöglichen, haben wir 2021-10-13 englische Wikipedia-Dumps verarbeitet, wie sie von Bohnet et al. (2022) verwendet wurden. Wir haben jeden Dokumententext in drei verschiedene Granularitäten unterteilt: Absätze mit 100 Wörtern, Sätze und Propositionen. Wir verwenden dieselbe Granularität in derAnhang Aenthält detaillierte Informationen über den Korpus der Absatz- und Satzsegmentierung.

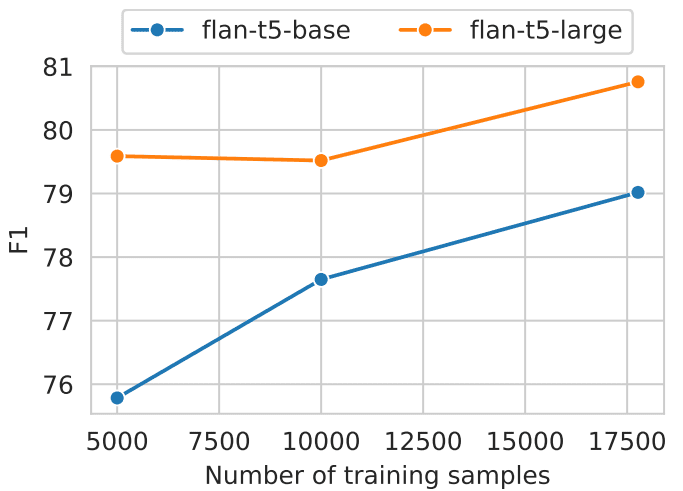

Die paraphrasierte Passage ist propositional:Um Wikipedia-Seiten in Propositionen aufzuteilen, haben wir ein Modell zur Texterzeugung entwickelt, das wir Propositionizer nennen. Der Propositionizer nimmt einen Absatz als Eingabe und generiert eine Liste von Propositionen innerhalb des Absatzes. In Anlehnung an den Ansatz von Chen et al. (2023b) trainieren wir den Propositionizer in einem zweistufigen Destillationsprozess. Zunächst verwenden wir die Instruktionsaufforderung GPT-4, die Definitionen von Propositionen und ein Demonstrationsbeispiel enthält. Einzelheiten zu den Prompts sind in Abbildung 8 dargestellt. Wir beginnen mit einer Menge von 42k Passagen und verwenden GPT-4, um eine Startmenge von Passagen-Propositions-Paaren zu erzeugen. Als Nächstes verwenden wir die Startmenge zur Feinabstimmung des FlanT5-großen Modells.

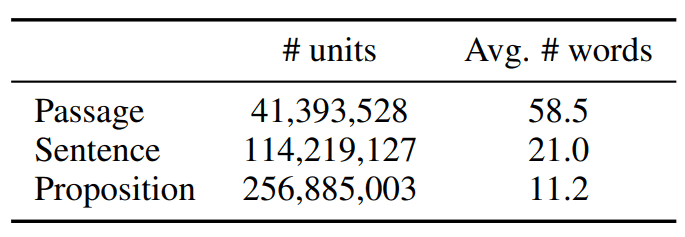

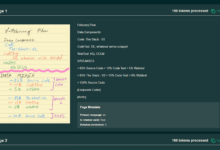

Wir bezeichnen das verarbeitete Korpus als FACTOIDWIKI. Die Statistiken von FACTOIDWIKI sind in Tabelle 1 dargestellt.

Tabelle 1: Statistische Daten zu Texteinheiten im englischen Wikipedia-Dump am 13. Oktober 2021

4 Versuchsaufbau

Um die Auswirkungen der drei gewählten Abfrageeinheiten zu bewerten, haben wir Experimente mit fünf verschiedenen QS-Datensätzen auf FACTOIDWIKI durchgeführt. Für jeden Datensatz haben wir die Abfrage von Absätzen und die nachgelagerte QS-Leistung bewertet, wenn der Dense Retriever Wikipedia mit unterschiedlicher Granularität indiziert.

4.1 Offene QA-Datensätze

Wir führen unsere Evaluierung auf fünf verschiedenen Open-Domain-QA-Datensätzen durch, die Wikipedia als Retrievalquelle nutzen: Natural Questions (NQ) (Kwiatkowski et al., 2019), TriviaQA (TQA) (Joshi et al., 2017), Web Questions ( WebQ) (Berant et al., 2013), SQuAD (Rajpurkar et al., 2016) und Entity Questions (EQ) (Sciavolino et al., 2021).

4.2 Modelle der dichten Suche

Wir vergleichen die Leistung der folgenden sechs überwachten oder unbeaufsichtigten Dense-Retriever-Modelle. Dabei beziehen sich überwachte Modelle auf Modelle, die während des Trainingszeitraums unter Verwendung der

Manuell etikettierte Abfrage-Absatz-Paare als überwachte Modelle und vice versa.

- SimCSE ist ein BERT-basierter Encoder, der auf zufällig ausgewählten, unmarkierten Sätzen aus Wikipedia trainiert wird.

- Befürworter Contriever wird durch den Vergleich von Kontrastpaaren trainiert, die aus Dokumentenpaaren aus unmarkierten Wikipedia- und Web-Crawling-Daten gebildet werden.

- DPR ist ein BERT-Basismodell mit zwei Encodern, das mit fünf offenen QS-Datensätzen feinabgestimmt wurde, darunter die vier Datensätze in unserer Bewertung (NQ, TQA, WebQ und SQuAD).

- ANCE Es wurden die gleichen Einstellungen wie bei der DPR verwendet und das Modell wurde mit der ANCE-Methode (Approximate Nearest Neighbour Negative Contrast Estimation) trainiert, einer auf harter Negativität basierenden Trainingsmethode.

- TAS-B ist ein BERT-Basismodell mit zwei Encodern, das aus einem Lehrermodell mit Cross-Attention-Training extrahiert und mit MS MARCO feinabgestimmt wurde.

- GTR ist ein T5-basierter Kodierer, der auf unmarkierten Online-Forum-QA-Datenpaaren vortrainiert und auf MS MARCO und Natural Question feinabgestimmt wurde.

4.3 Bewertung von Absatzrecherchen

Wir bewerten die Leistung des Retrievals auf Absatzebene, wenn wir den Korpus auf Absatz-, Satz- oder Propositionsebene indizieren. Für das Retrieval auf Satz- und Propositionsebene folgen wir dem von Lee et al. (2021b) vorgestellten Aufbau, bei dem der Score für einen Absatz auf dem maximalen Ähnlichkeits-Score zwischen der Abfrage und allen Sätzen oder Propositionen im Absatz basiert. In der Praxis rufen wir zunächst etwas mehr Texteinheiten ab, ordnen jede Einheit einem Quellabsatz zu und geben die besten k eindeutigen Absätze zurück. Als Bewertungsmaßstab verwenden wir den Recall @k, der definiert ist als der Prozentsatz der Fragen, die in den ersten k abgerufenen Passagen die richtige Antwort finden.

4.4 Nachgeschaltete QS-Bewertung

Um die Auswirkungen der Verwendung verschiedener Abfrageeinheiten auf nachgelagerte Open-Domain-QS-Aufgaben zu verstehen, evaluieren wir die Verwendung des Abfragemodells in einer Abfrage-nach-Lese-Einstellung. In der "Retrieve-then-read"-Einstellung ruft das Retrieval-Modell zunächst k Texteinheiten für eine gegebene Anfrage ab. Diese k abgerufenen Texteinheiten werden dann zusammen mit der Anfrage als Input für das Lesemodell verwendet, um die endgültige Antwort zu erhalten. In der Regel wird die Wahl von k durch die Beschränkung der maximalen Eingabelänge oder das Rechenbudget des Lesemodells begrenzt, das mit der Anzahl der Eingabewörter skaliert.

Daher verwenden wir eine Evaluierungsmethode, bei der die maximale Anzahl der abgerufenen Wörter auf l = 100 oder 500 begrenzt ist, d. h. nur die ersten l Wörter aus einem Absatz, Satz oder einer Proposition werden in das Lesemodell eingegeben. Wir bewerten den Prozentsatz der Fragen, bei denen die vorhergesagte Antwort genau mit der wahren Antwort übereinstimmt (EM). Wir bezeichnen unsere Metrik als EM@l. Für unsere Bewertung verwenden wir T5-large size UnifiedQA-v2 als Lesemodell.

5 Ergebnisse: Absatzsuche

In diesem Abschnitt berichten und diskutieren wir über die Leistung der Retrievalaufgabe. Unsere Ergebnisse zeigen, dass, obwohl keines der Modelle auf Daten auf Satzebene trainiert wurde, alle Retrievalmodelle eine vergleichbare oder bessere Leistung als das absatz- oder satzbasierte Retrieval zeigen, wenn der Korpus auf Satzebene indiziert ist.

5.1 Leistung der Absatzsuche

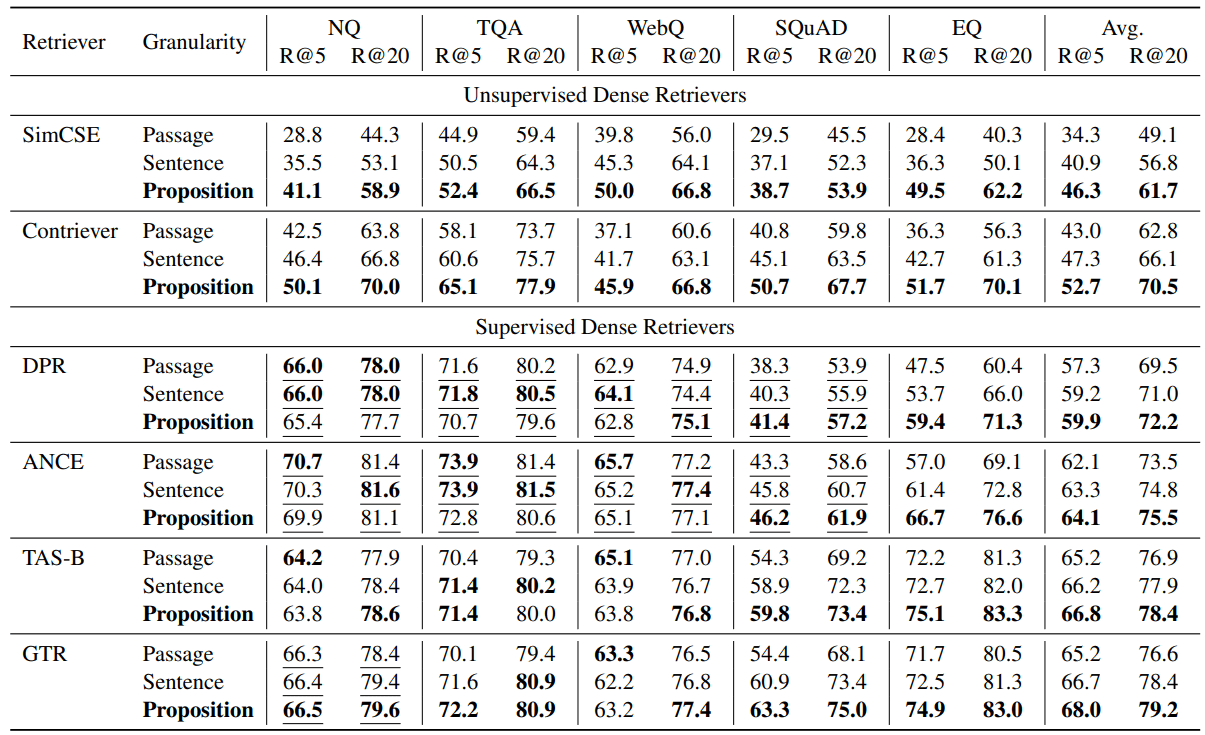

Unsere Evaluierungsergebnisse sind in Tabelle 2 aufgeführt. Wir stellen fest, dass das propositionsbasierte Retrieval das satz- oder absatzbasierte Retrieval bei den meisten Aufgaben sowohl für unbeaufsichtigte als auch für überwachte Retriever übertrifft.

Bei allen getesteten intensiven Retrievern übertraf das propositionsbasierte Retrieval das satz- und absatzbasierte Retrieval im Durchschnitt der fünf Datensätze durchweg. Für die unüberwachten Retriever, d.h. SimCSE und Contriever, sehen wir eine durchschnittliche Recall@5-Verbesserung von +12,0 und +9,3 über die fünf Datensätze (eine relative Verbesserung von 35,01 TP3T und 22,51 TP3T).

Bei den überwachten Retrievern zeigt das Retrieval auf Satzebene immer noch einen durchschnittlichen Vorteil, aber die Verbesserung ist geringer. Wir vermuten, dass dies auf die Tatsache zurückzuführen ist, dass diese Retriever auf Abfrage-Paragraphen-Paaren trainiert werden. Für DPR und ANCE, die auf NQ, TQA, WebQ und SQuAD trainiert wurden, stellen wir beispielsweise fest, dass das propositions- und satzbasierte Retrieval auf allen drei Datensätzen außer SQuAD etwas schlechter ist als das absatzbasierte Retrieval. Wie in Tabelle 2 gezeigt, ist die Leistung aller überwachten Retriever auf NQ, TQA und WebQ auf den drei Retrieval-Granularitäten vergleichbar.

Bei Datensätzen, die das Retriever-Modell während des Trainings nicht gesehen hatte, konnten wir jedoch einen klaren Vorteil für das propositionsbasierte Retrieval feststellen. Zum Beispiel bei SQuAD oder EntityQuestions beobachten wir, dass das propositionsbasierte Retrieval die beiden anderen Granularitäten deutlich übertrifft. Wir sehen eine relative Verbesserung des Recall@5 für 17-25% bei relativ schwachen Retrievern wie DPR und EntityQuestions für ANCE. Darüber hinaus verbessert sich der Recall@5 für propositionsbasiertes Retrieval auf SQuAD am stärksten auf TAS-B und GTR, mit einer relativen Verbesserung von 10-16%.

Tabelle 2: Leistung beim Abrufen von Absätzen (Recall @k = 5, 20) in fünf verschiedenen offenen Q&A-Datensätzen, wenn der vortrainierte Dense Retriever mit drei verschiedenen Granularitäten im Abrufkorpus arbeitet. Die Unterstreichungen zeigen an, dass die Trainingssegmentierung des Zieldatensatzes in den Trainingsdaten des Dense Retrievers enthalten ist.

5.2 Propositionsbasierte Suche ⇒ bessere aufgabenübergreifende Generalisierung

Unsere Ergebnisse zeigen, dass die Vorteile des propositionsbasierten Abrufs bei der aufgabenübergreifenden Generalisierung am deutlichsten sind. Wir stellen fest, dass propositionsbasiertes Retrieval bei der aufgabenübergreifenden Generalisierung von SQuAD und EntityQuestions mehr Leistungsgewinne bringt.

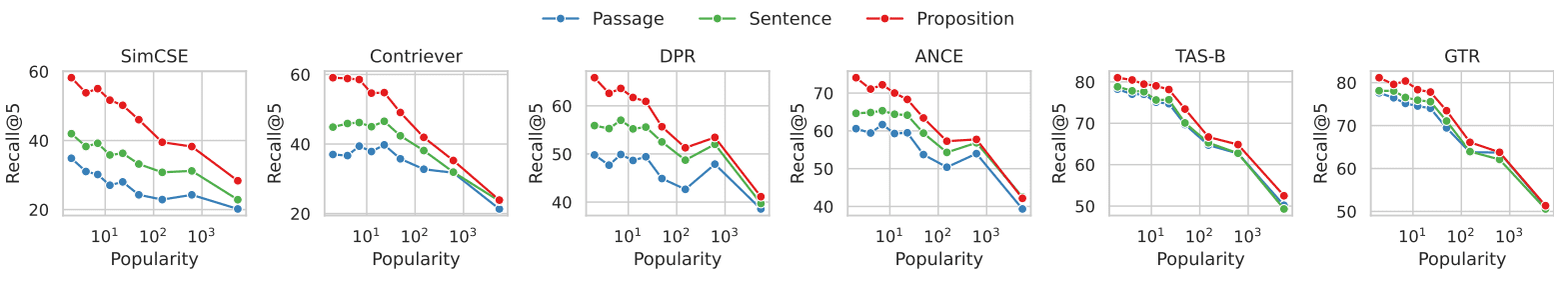

Um die Quellen der Verbesserung besser zu verstehen, haben wir zusätzliche Analysen zu EntityQuestions durchgeführt. Da EntityQuestions Fragen enthalten, die auf Long-Tail-Entity-Attribute abzielen, haben wir untersucht, wie sich die Popularität der Ziel-Entity in der Frage auf die Suchleistung auswirkt, d. h. wie oft die Entity in Wikipedia vorkommt, und zwar auf drei verschiedenen Granularitätsebenen. Wir schätzen die Popularität jeder Entität anhand der folgenden Methode. Ausgehend von der Oberflächenform einer Entität verwenden wir BM25, um die ersten 1000 relevanten Passagen aus Wikipedia abzurufen. Wir verwenden die Anzahl der Vorkommen der Entität in den ersten 1000 Absätzen als Schätzwert für ihre Popularität. Von den 20.000 Testanfragen in EntityQuestion haben etwa 251 TP3T der Zielentitäten Popularitätswerte kleiner oder gleich 3.

Abbildung 3 zeigt die Beziehung zwischen der Leistung des Absatzabrufs und der Popularität der Zielentitäten in jedem Problem. Bei allen sechs dichten Retrievern ist zu beobachten, dass das propositionsbasierte Retrieval einen größeren Vorteil gegenüber dem absatzbasierten Retrieval aufweist, wenn es um Probleme mit weniger häufigen Entitäten geht. Der Leistungsunterschied verringert sich mit zunehmender Popularität der Entitäten. Unsere Ergebnisse deuten darauf hin, dass die Leistungsverbesserung des propositionsbasierten Retrievals hauptsächlich auf Anfragen zurückzuführen ist, die auf Long-Tail-Informationen abzielen. Dies deckt sich mit unserer Beobachtung, dass propositionsbasiertes Retrieval die aufgabenübergreifende Generalisierungsleistung von Dense Retrievern verbessert.

Abbildung 3: Abruf von Dokumenten im Vergleich zur Popularität der Zielentität jeder Frage im EntityQuestions-Datensatz

Im EntityQuestions-Datensatz wurde die Popularität jeder Frage (d. h. kleinere Werte zeigen an, dass die Entität weniger häufig vorkommt, und umgekehrt) anhand der Häufigkeit des Auftretens der Entität in den ersten 1.000 von BM25 abgerufenen Passagen geschätzt.

Bei Anfragen, die weniger häufig vorkommende Entitäten enthalten, zeigt sich, dass die Suche nach Propositionen im Vergleich zur Suche nach Entitäten größere Vorteile bietet.

6 Ergebnis: QA im offenen Feld

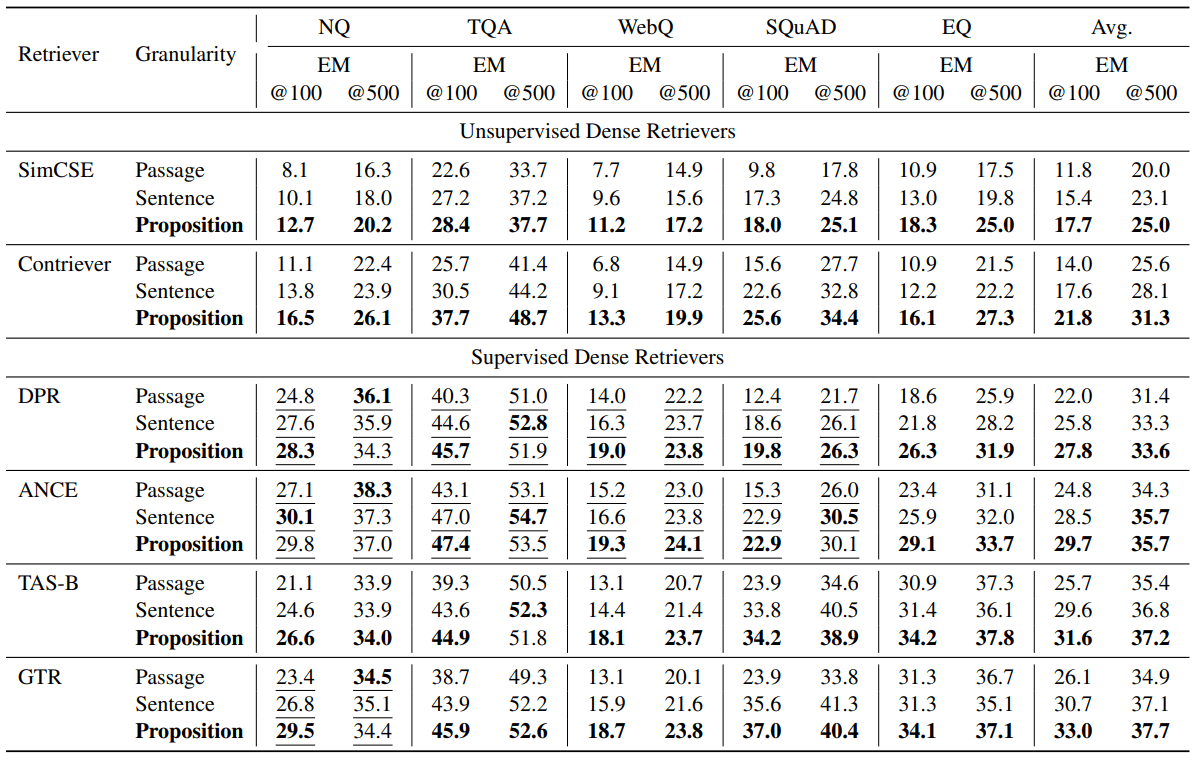

In diesem Abschnitt untersuchen wir, wie sich die Auswahl der Abrufgranularität auf nachgelagerte Open-Domain-QS-Aufgaben auswirkt. Wir zeigen den starken Einfluss von propositionsbasiertem Retrieval auf die nachgelagerte QS-Leistung in einer Retrieve-then-read-Umgebung, in der die Anzahl der Retrieval-Token, die in das QS-Modell des Lesers eingegeben werden, auf l = 100 oder 500 Wörter begrenzt ist. Wir stellen fest, dass die QS-Leistung bei der durchschnittlichen EM@l-Metrik über alle Retriever hinweg höher ist, wenn Propositionen als Retrievaleinheiten verwendet werden.

6.1 QA-Leistung

Tabelle 3 zeigt die Bewertungsergebnisse. Bei den verschiedenen Retrievern beobachten wir eine höhere QS-Leistung bei der durchschnittlichen EM@l-Metrik, wenn Propositionen als Retrievaleinheiten verwendet werden. Die unüberwachten Retriever SimCSE und Contriever verbesserten ihre EM@100-Werte um +5,9 bzw. +7,8 (relative Verbesserungen für 50% und 55%). Die überwachten Retriever DPR, ANCE, TAS-B und GTR verbesserten sich beim EM@100 um +5,8, +4,9, +5,9 bzw. +6,9 (relative Verbesserungen für 26%, 19%, 22% und 26%). Ähnlich wie bei der Evaluierung des Absatzabrufs haben wir festgestellt, dass der vorschlagsbasierte Abruf in Bezug auf die nachgelagerte QS-Leistung vorteilhafter ist, insbesondere wenn der Abrufer nicht auf dem Zieldatensatz trainiert ist. In anderen Fällen ist die vorschlagsbasierte Suche immer noch vorteilhaft, allerdings mit geringeren durchschnittlichen Gewinnspannen.

Tabelle 3: Open-Domain-Quiz-Performance (EM = exact match) in der Post-Retrieval-Lese-Einstellung, bei der die Anzahl der abgerufenen Wörter, die an das Leser-Quiz-Modell weitergegeben wurden, auf l = 100 oder 500 begrenzt war. Wir verwendeten UnifiedQA V2 (Khashabi et al., 2022) als Lesemodell. Die ersten l Wörter aus den verbundenen Top-Retrieval-Texteinheiten wurden als Eingabe an das Lesemodell übergeben. Die Unterstreichungen zeigen an, dass die Trainingssegmentierung des Zieldatensatzes in die Trainingsdaten des Dense Retrievers aufgenommen wurde. In den meisten Fällen zeigt sich, dass die Verwendung kleinerer Retrievaleinheiten zu einer besseren Q&A-Leistung führt.

6.2 These ⇒ höhere Dichte an fragestellungsrelevanter Information

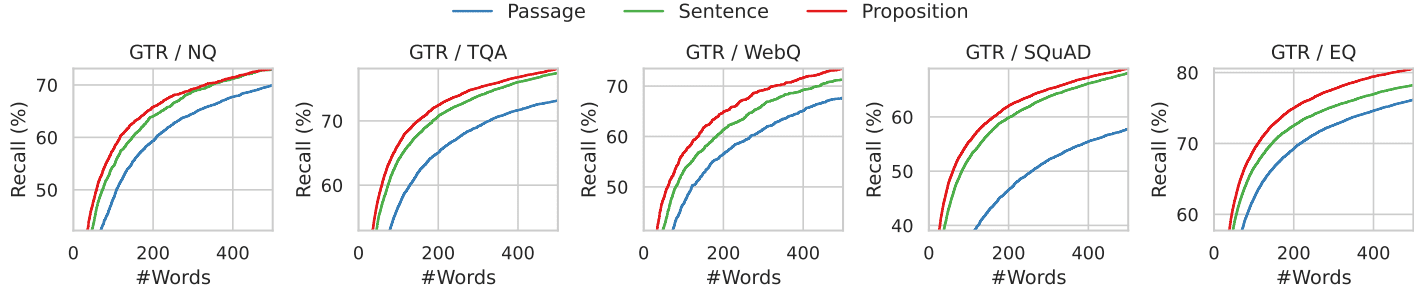

Intuitiv besteht der Vorteil von Sätzen gegenüber Sätzen oder Absätzen als Abfrageeinheiten darin, dass die abgerufenen Sätze eine höhere Dichte an für die Anfrage relevanten Informationen aufweisen. Bei der Verwendung feinkörnigerer Retrieval-Einheiten ist es wahrscheinlicher, dass die richtige Antwort auf eine Anfrage in den Top-L-Suchbegriffen eines Suchenden auftaucht.

Wir veranschaulichen dieses Phänomen anhand der in Abbildung 4 dargestellten Analyse. Hier untersuchen wir die Position der richtigen Antwort in den ersten l abgerufenen Wörtern. Konkret berechnen wir die Wiederauffindbarkeit der goldenen Antwort in den ersten l Wörtern, die vom GTR-Retriever abgerufen werden, wenn die Wikipedia mit drei verschiedenen Granularitäten indiziert wird.

Wir zeigen die Ergebnisse in den Abbildungen 4 und 7, wobei l von 0 bis 500 reicht und alle fünf Datensätze abdeckt. Bei einem festen Budget an abgerufenen Wörtern hat das propositionale Retrieval eine höhere Erfolgsrate als Satz- und Absatzretrieval-Methoden im Bereich der ersten 100-200 Wörter, was etwa 10 Propositionen, 5 Sätzen oder 2 Absätzen entspricht. Mit zunehmender Wortzahl konvergiert die Trefferquote der drei Granularitätsebenen, da alle für die Frage relevanten Informationen im abgerufenen Text enthalten sind.

Abbildung 4: Rückgewinnung der Goldstandard-Antwort, wenn der abgerufene Text auf die ersten k Wörter für den GTR-Retriever beschränkt ist. Feinkörnigere Abfragen haben eine höhere Wiedererkennung über alle Wortzahlbereiche hinweg.

6.3 Fallstudien zu Fehlern

Um die Fehlerquellen bei jeder Abrufgranularität zu verstehen, werden in Tabelle 4 vier typische Fehlerbeispiele vorgestellt und diskutiert. In jedem Beispiel werden die vom GTR-Retriever auf den drei Granularitäten abgerufenen Probleme und die entsprechenden Top-1-Texteinheiten gezeigt.

Beim Retrieval auf Kanalebene stellt die Mehrdeutigkeit von Entitäten oder deren Referenzen eine Herausforderung für dichte Sucher dar, was die Ergebnisse von (Min et al., 2020) widerspiegelt. In Beispiel Q1 beispielsweise wird in der Frage nach "Super Bowl 50" gefragt, aber der gefundene Artikel und Satz verweisen auf "Super Bowl 5". In Beispiel Q2 gelingt es der Absatzsuche nicht, den Abschnitt zu finden, der auf die richtige "Atomzahl" verweist. Stattdessen bezog sich der erste gefundene Artikel auf die "Ordnungszahl" in einem anderen Kontext, der nichts mit der Frage zu tun hat. Die Satz-für-Satz-Suche kann ähnliche Probleme wie die Absatz-für-Absatz-Suche haben, wie in Beispiel Q1, und eine weitere Herausforderung für die Satz-Suche ist der fehlende Kontext. In Beispiel Q3 schlägt die satzbasierte Suche fehl, weil der richtige Satz im gefundenen Artikel "es" verwendet, um sich auf den Herzbeutel zu beziehen.

Das propositionsbasierte Retrieval löst das obige Problem, indem es sicherstellt, dass jede Retrievaleinheit nur eine Tatsache mit dem erforderlichen Kontext in der Proposition enthält. Das propositionsbasierte Retrieval steht jedoch vor der Herausforderung des Multi-Hop-Reasonings, das weitreichende Textanalysen erfordert. In Beispiel Q4 beschreiben die abgerufenen Passagen die Namen der Schauspieler bzw. die Rollen, die sie spielen. Keiner der Sätze enthielt sowohl Fragen als auch Antworten.

Tabelle 4: Beispiele für Fälle, in denen die erstplatzierte Texteinheit, die bei jeder Suchgranularität abgerufen wird, nicht die richtige Antwort liefert. Der unterstrichene Text ist die richtige Antwort. Der graue Text ist der Kontext des Vorschlags, er dient jedoch nur zur Veranschaulichung und wird dem Retriever und dem nachgeschalteten Q&A-Modell nicht zur Verfügung gestellt.

7 Verwandte Arbeiten

Neuere Arbeiten zu dichten Retrievern verwenden in der Regel eine duale Encoder-Architektur. Bei dualen Kodierern wird jede Anfrage und jedes Dokument separat als niedrigdimensionaler Merkmalsvektor kodiert, und die Korrelation zwischen ihnen wird durch eine nichtparametrische Ähnlichkeitsfunktion zwischen den eingebetteten Vektoren gemessen. Aufgrund der begrenzten Aussagekraft der Ähnlichkeitsfunktion haben Dual-Encoder-Modelle in der Regel eine schlechte Generalisierungsfähigkeit für neue Aufgaben, insbesondere wenn nur wenige Trainingsdaten vorliegen. Aus diesem Grund wurden in früheren Studien Techniken wie Datenerweiterung, kontinuierliches Pre-Training, aufgabenorientiertes Training, hybrides Sparse-Dense-Retrieval oder hybrides Strategie-Retrieval eingesetzt, um die aufgabenübergreifende Generalisierungsleistung von Dense Retrievern zu verbessern.

Unsere Arbeit ist zum Teil durch Anklänge an das Multi-Vektor-Retrieval motiviert, z. B. ColBERT, DensePhrase (Lee et al., 2021a,b), ME-BERT, MVR, bei dem das Retrieval-Modell lernt, kandidierende Retrieval-Einheiten in mehrere Vektoren zu kodieren, um die Repräsentativität des Modells zu erhöhen und die Granularität des Retrievals zu verbessern. Unsere Arbeit konzentriert sich auf Einstellungen, bei denen das dichte Retriever-Modell oder seine Parameter nicht aktualisiert werden. Wir zeigen, dass die Partitionierung des Retrieval-Korpus in feinere Propositionen eine einfache und orthogonale Strategie sein kann, um die Generalisierungsfähigkeit des Dual-Encoder-Dense Retriever während der Inferenz zu verbessern.

Die Idee, Propositionen als textuelle Repräsentationseinheiten zu verwenden, lässt sich auf den Pyramidenansatz bei der automatischen Digest-Bewertung zurückführen (Nenkova und Passonneau, 2004), bei dem modellgenerierte Digests anhand jeder Proposition bewertet werden. Die Extraktion von Propositionen aus Texten ist eine seit langem bestehende Aufgabe in der NLP, wobei sich frühe Formulierungen auf strukturierte Repräsentationen von Propositionen konzentrierten, z.B. offene Informationsextraktion, semantische Rollenmarkierung. Neuere Studien haben erfolgreich Propositionen in natürlicher Sprache extrahiert, indem sie große Sprachmodelle mit weniger Hinweisen oder eine Feinabstimmung kleinerer Modelle verwendeten.

Retrieval-then-reading, oder allgemeiner - Retrieval-enhanced generation, ist in letzter Zeit zu einem beliebten Paradigma für Open-Domain Q&A geworden. Während frühe Arbeiten den Downstream-Lesern bis zu 100 abgefragte Passagen zur Verfügung stellten, ist die Menge des zulässigen Kontexts erheblich reduziert (z.B. die ersten 10), wenn neuere große Sprachmodelle verwendet werden, da diese eine begrenzte Länge des Kontextfensters haben und nicht in der Lage sind, lange Kontexte zu verarbeiten. In jüngster Zeit wurde versucht, die Qualität der Lesekontexte durch Filterung oder Komprimierung der abgerufenen Dokumente zu verbessern. Unsere Arbeit geht dieses Problem effektiv an, indem sie eine neue Abfrageeinheit, den Satz, verwendet, der nicht nur die Kontextlänge reduziert, sondern auch eine höhere Informationsdichte bietet.

8 Schlussfolgerung

Wir schlagen vor, Propositionen als Retrieval-Einheiten zur Indizierung von Korpora zu verwenden, um die Leistung des dichten Retrievals während der Inferenz zu verbessern. In unseren Experimenten mit fünf Open-Domain-QS-Datensätzen und sechs verschiedenen intensiven Retrievern stellen wir fest, dass das propositionsbasierte Retrieval das absatz- oder satzbasierte Retrieval sowohl in Bezug auf die Genauigkeit des Absatzretrievals als auch auf die nachgelagerte QS-Leistung bei festen Retrieval-Wortbudgets übertrifft. Wir stellen FACTOIDWIKI vor, eine indexierte Version der englischen Wikipedia, in der der Text von 6 Millionen Seiten in 250 Millionen Propositionen unterteilt ist. Wir hoffen, dass FACTOIDWIKI und unsere Ergebnisse die zukünftige Forschung im Bereich Information Retrieval erleichtern werden.

Einschränkungen

Unsere aktuelle Studie über die Granularität von Abfragekorpora hat die folgenden Einschränkungen. (1) Retrieval-Korpus - Unsere Studie konzentriert sich nur auf Wikipedia als Retrieval-Korpus, da die meisten Open-Domain-QA-Datensätze Wikipedia als Retrieval-Korpus verwenden. (2) Evaluierte Arten von Dense Retrievern - In der aktuellen Version dieses Papiers evaluieren wir nur sechs populäre Dense Retriever, von denen die meisten eine Dual-Encoder- oder Double-Encoder-Architektur verwenden. In zukünftigen Versionen werden wir die Ergebnisse für eine breitere Palette von Dense Retrievern einbeziehen und diskutieren. (3) Sprache - Unsere aktuelle Studie ist auf die englische Wikipedia beschränkt. Wir überlassen die Untersuchung anderer Sprachen der zukünftigen Arbeit.

A Abruf der Korpusverarbeitung

Der in dieser Studie verwendete englische Wikipedia-Dump wurde von Bohnet et al. im Jahr 2022 veröffentlicht und wurde für die Verwendung ausgewählt, weil er gefiltert wurde, um Diagramme, Tabellen und Listen zu entfernen und in Absatzform organisiert wurde. Der Dump datiert zurück auf den 13. Oktober 2021. Für diese Studie haben wir Wikipedia in drei Sucheinheiten unterteilt: Absatzblöcke mit 100 Wörtern, Sätze und Propositionen. Wir haben eine Greedy-Methode verwendet, um Absätze in 100-Wort-Absatzblöcke zu unterteilen. Wir segmentieren nur am Ende von Sätzen, um sicherzustellen, dass jeder Absatzblock vollständige Sätze enthält. Bei der Verarbeitung der Absätze fügen wir einen Satz nach dem anderen hinzu. Wenn durch die Aufnahme des nächsten Satzes der Absatzblock 100 Wörter überschreiten würde, beginnen wir einen neuen Absatzblock mit diesem Satz. Wenn der letzte Absatzblock jedoch weniger als 50 Wörter umfasst, fügen wir ihn mit dem vorherigen zusammen, um zu kleine Fragmente zu vermeiden. Außerdem unterteilen wir jeden Absatz in Sätze, indem wir das weit verbreitete Python-Modell SpaCy en_core_web_lg verwenden. Darüber hinaus zerlegt unser Propositionizer-Modell jeden Absatz in Propositionen. Insgesamt haben wir 6 Millionen Seiten in 41,39 Millionen Absätze, 11,42 Millionen Sätze und 257 Millionen Propositionen zerlegt. Im Durchschnitt enthält ein Absatz 6,3 Propositionen und ein Satz 2,3 Propositionen.

B Ausbildung der Antragsteller

Wir haben GPT-4 verwendet, um eine Liste von Propositionen aus einer gegebenen Passage zu generieren, wie in Abbildung 8 dargestellt. Nach der Filterung wurden insgesamt 42.857 Paare für die Feinabstimmung des Flan-T5-Large-Modells verwendet. Wir nannten das Modell Propositionizer. Wir verwendeten den AdamW-Optimierer mit einer Stapelgröße von 64, einer Lernrate von 1e-4 und einem Gewichtsabfall von 1e-4 und trainierten 3 Zyklen lang. Um die Leistung der von den verschiedenen Modellen generierten Vorschläge zu vergleichen, haben wir ein Entwicklungsset und eine Bewertungsmetrik erstellt. Der Entwicklungssatz enthält zusätzliche 1000 Probenpaare, die von GPT-4 mit der gleichen Methode wie der Trainingssatz gesammelt wurden. Wir bewerten die Qualität der vorhergesagten Aussagen anhand der F1-Scores der beiden Sätze von Aussagen. In Anlehnung an die F1-Scores der beiden Sätze von Markern in BertScore entwerfen wir F1-Scores für die beiden Sätze von Vorschlägen. Sei P = {p1, ... , pn} bezeichne die Menge der markierten Sätze, ˆP = {ˆp1, ... , ˆpm} die Menge der vorhergesagten Sätze. Wir verwenden sim(pi, ˆpj), um die Ähnlichkeit zwischen zwei Sätzen darzustellen. Theoretisch kann jede beliebige textuelle Ähnlichkeitsmetrik verwendet werden. Wir haben uns für BertScore als sim-Funktion entschieden, weil wir wollen, dass unsere Metrik die semantischen Unterschiede zwischen den Sätzen widerspiegelt. Wir definieren:

Recall = 1 / |P| ∑(max(sim(pi, ˆpj)) für ˆpj in ˆP) Precision = 1 / |ˆP| ∑(max(sim(pi, ˆpj)) für pi in P) F1 = 2 * Precision * Recall / (Precision + Recall)

Hier eine grafische Erklärung des F1-Scores: Recall steht für den Prozentsatz der Sätze in der markierten Menge, die den Sätzen in der generierten Menge ähnlich sind, Precision steht für den Prozentsatz der Sätze in der generierten Menge, die den Sätzen in der markierten Menge ähnlich sind, und F1 ist der abgeglichene Durchschnitt von Recall und Precision. F1 ist 1, wenn die beiden Sätze identisch sind, und 0, wenn zwei Sätze semantisch unterschiedlich sind.

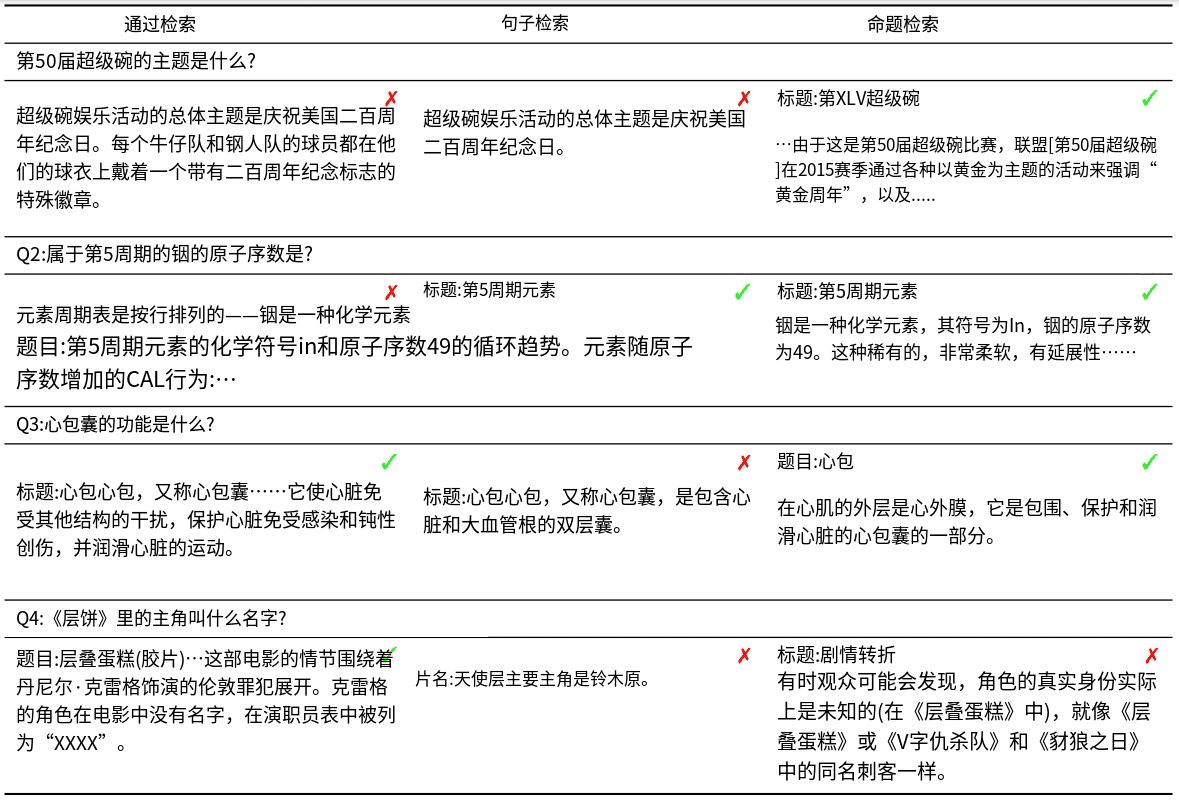

Wir haben eine vergleichende Analyse der einfachen und großen Flan-T5-Modelle durchgeführt, die mit unterschiedlichen Datenmengen trainiert wurden (siehe Abb. 5). Die Ergebnisse der Studie zeigen, dass größere Modelle in Verbindung mit großen Mengen von Trainingsdaten bessere Ergebnisse liefern. Der propositionale Analysator erreichte einen F1-Wert von 0,822. Nach einer manuellen Überprüfung der generierten Propositionen befanden wir diese für zufriedenstellend.

Abb. 5: Leistung der propositionalen Dekomposition für Modelle unterschiedlicher Größe und Anzahl von Trainingsdaten.

C Offline-Index

Wir kodierten die abgerufenen Einheiten als Einbettungen mit den Paketen pyserini und faiss. Wir haben jede Texteinheit mit mehreren GPUs kodiert, die in 1 Million Einheiten mit einer Stapelgröße von 64 gruppiert wurden. Nach der Vorverarbeitung der Einbettungen führten wir alle Experimente mit exakter Suche mit innerem Produkt (faiss.IndexFlatIP) durch.Der reine Index von FACTOIDWIKI ist etwa 768 GB groß. Um den Speicherbedarf zu reduzieren, wird die Einbettung in 8 Slices aufgeteilt. Jedes Slice führt eine ungefähre Suche nach dem nächsten Nachbarn durch, bevor alle Ergebnisse aggregiert werden. Obwohl die Anzahl der Propositionen sechsmal so groß ist wie die Anzahl der Passagen, können mit effizienten Indizierungstechniken sublineare Suchzeiten im Verhältnis zur Gesamtzahl der Vektoren erreicht werden. Darüber hinaus wird durch die Nutzung der GPU-Parallelität und der verteilten Indizierung die Online-Suchzeit erheblich reduziert. Mit einer geeigneten Implementierung können wir also die propositionale Suche zu einer praktischen und effizienten Option machen.

D Retriever-Modell

Wir haben die Pakete transformers und sentence-transformers für die Modellimplementierung verwendet. Wir verwendeten die folgenden auf HuggingFace veröffentlichten Checkpoints: SimCSE (princeton-nlp/unsup-simcse-bert-base-uncased), Contriever (facebook/contriever), DPR (facebook/dpr- ctx_encoder-multiset-base, facebook/dpr-question_encoder-multiset-base), ANCE (castorini/ance-dpr-context-multi, castorini/ance-dpr- question-multi,), TAS-B (sentence-transformers/msmarco-distilbert-base-tas-b) und GTR (sentence-transformers/gtr-t5-base).

E Zusätzliche Ergebnisse

In Abschnitt 5.2 zeigen wir die Vorteile des propositionsbasierten Retrievals gegenüber dem satzbasierten Retrieval, insbesondere in EQs, in denen die Population der Entitäten abnimmt. Wir verwenden die Anzahl der Vorkommen in den ersten 1000 von BM25 abgerufenen Absätzen als Proxy für die Prävalenz, anstatt die Anzahl der Hyperlinks zu Entitäten zu verwenden, wie in Sciavolino et al. (2021). Infolgedessen zeigt der Trend des Graphen Leistung vs. Popularität (Abbildung 6) einige Unterschiede zwischen unseren Ergebnissen und denen von Sciavolino et al. (2021). Zum Beispiel sind einige Entitäten mehrdeutig (z. B. 1992, eine Fernsehserie). In diesem Fall ist die Anzahl der Vorkommen der Oberflächenform der Entität groß. Gleichzeitig sind Fragen, die sich auf unscharfe Entitäten beziehen, schwer zu beantworten, was zu einem geringen Erinnerungswert führt. In Abschnitt 6.2 wird die Wiederauffindbarkeit von Antworten im abgerufenen Text in Abhängigkeit von der Kontextlänge diskutiert. Wir zeigen außerdem den Leistungstrend der sechs dichten Retriever, wie in Abb. 7 dargestellt. Die Ergebnisse zeigen, dass die Wiederauffindbarkeit von Propositionen durchweg besser ist als die von Sätzen und Absätzen. Unsere Ergebnisse lassen den Schluss zu, dass die Dichte an fragestellungsrelevanten Einheiten in Propositionen im Vergleich zu Sätzen und Absätzen größer ist.

Abbildung 8: Hinweise zur Generierung von Propositionen aus Artikeln mit GPT-4.

Zerlegen Sie den "Inhalt" in klare und einfache Aussagen und stellen Sie sicher, dass diese interpretierbar sind

des Kontextes.

1. zusammengesetzte Sätze in einfache Sätze zerlegen. die ursprüngliche Formulierung der Eingabe beibehalten

wann immer möglich.

(2) Für jede benannte Einheit, die von zusätzlichen beschreibenden Informationen begleitet wird, sind diese

Informationen zu einer eigenen Aussage zu machen.

3) Dekontextualisierung der Aussage durch Hinzufügen der erforderlichen Modifikatoren zu Substantiven oder ganzen Sätzen

und das Ersetzen von Pronomen (z. B. "es", "er", "sie", "sie", "dies", "das") durch den vollständigen Namen des

Einheiten, auf die sie sich beziehen.

4. die Ergebnisse als Liste von Strings, formatiert in JSON, darstellen.Eingabe. Titel: Eostre. Abschnitt: Theorien und Interpretationen, Verbindung zu Osterhasen. Inhalt: ¯

Der früheste Nachweis für den Osterhasen wurde in Südwestdeutschland im Jahr

1678 durch den Medizinprofessor Georg Franck von Franckenau, blieb aber in Deutschland unbekannt.

Der Gelehrte Richard Sermon schreibt, dass "Hasen bis ins 18.

häufig im Frühling in den Gärten zu sehen ist und somit als bequeme Erklärung für die

Alternativ dazu gibt es in Europa die Tradition der "schwarzen Eier", die weltweit am weitesten verbreitet sind und in den Vereinigten Staaten am häufigsten vorkommen.

dass Hasen Eier gelegt haben, da der Kratzer oder die Form eines Hasen und das Nest eines Kiebitzes sehr ähnlich aussehen, und

Beide kommen auf Grünland vor und sind erstmals im Frühjahr zu sehen. Im neunzehnten Jahrhundert wurde der Einfluss der

von Osterkarten, Spielzeug und Büchern sollte den Osterhasen in ganz Europa populär machen.

Deutsche Einwanderer exportierten den Brauch dann nach Großbritannien und Amerika, wo er sich zum

Osterhase".

Ausgabe. [Die frühesten Belege für den Osterhasen wurden im Südwesten Deutschlands im

1678 von Georg Franck von Franckenau", "Georg Franck von Franckenau war ein Professor der

Medizin.", "Der Beweis für den Osterhasen blieb in anderen Teilen Deutschlands unbekannt

bis zum 18. Jahrhundert", "Richard Sermon war ein Gelehrter", "Richard Sermon schreibt eine Hypothese

über die mögliche Erklärung für die Verbindung zwischen Hasen und der Tradition zu Ostern".

"Hasen wurden im Frühjahr häufig in Gärten gesehen", "Hasen dienten möglicherweise als praktische

Erklärung für den Ursprung der bunten Eier, die in Gärten für Kinder versteckt werden", "Es gibt eine

europäischen Tradition, dass Hasen Eier legen", "Ein Hasenscharren oder eine Hasenform und ein Kiebitznest sehen sehr

ähnlich", "Sowohl Hasen- als auch Kiebitznester kommen auf Grünland vor und sind erstmals im Frühjahr zu sehen.", "Sowohl Hasen- als auch Kiebitznester kommen auf Grünland vor und sind erstmals im Frühjahr zu sehen.".

"Im neunzehnten Jahrhundert hatten Osterkarten, Spielzeug und Bücher den Einfluss, das Osterfest zu einer

Hase/Kaninchen in ganz Europa beliebt", "Deutsche Einwanderer exportierten den Brauch des

Osterhasen nach Großbritannien und Amerika", "Der Brauch des Osterhasen entwickelte sich zu

der Osterhase in Großbritannien und Amerika."] Eingabe. <a new passage>

Ausgabe.

Zerlegen Sie "Inhalte" in klare und einfache Ideen, um sicherzustellen, dass sie auch außerhalb ihres ursprünglichen Kontextes Sinn ergeben.

1. zusammengesetzte Sätze in einfache Sätze umwandeln und, wenn möglich, die ursprüngliche Formulierung beibehalten.

(2) Für bestimmte Entitäten mit zusätzlichen beschreibenden Informationen werden diese Informationen in separaten Assertions aufgeführt.

3. aus dem Kontext gerissene Behauptungen durch Hinzufügen der erforderlichen Modifikatoren zu Substantiven oder ganzen Sätzen oder durch Ersetzen von Pronomen (z. B. "es", "er", "sie", "sie", "dies", "das") durch den vollständigen Namen der Einheit, auf die sie sich beziehen.

4. die Ergebnisse als eine Liste von Strings darstellen und das JSON-Format verwenden.Eingabe:Titel: Eostre. Kapitel: Theorien und Erklärungen, mit Verbindungen zum Osterhasen. Inhalt: Die frühesten Belege für den Osterhasen wurden von Georg Franck von Franckenau im Jahr 1678 in Südwestdeutschland aufgezeichnet, aber im übrigen Deutschland war er bis ins 18. Der Gelehrte Richard Sermon schreibt, dass "Hasen im Frühling oft in den Gärten zu sehen waren, so dass sie als bequeme Erklärung für die Herkunft der bunten Eier, die die Kinder in ihren Gärten fanden, herangezogen worden sein könnten. Außerdem gibt es in Europa die Tradition, dass Hasen Eier legen, weil ihre Kratzspuren oder Formen den Nestern von Weizenvögeln ähneln und sie auf Wiesen zu finden sind und im Frühjahr zuerst entdeckt werden. Im 19. Jahrhundert wurde der Osterhase durch den Einfluss von Osterkarten, Spielzeug und Büchern in ganz Europa populär. Der Brauch wurde dann von deutschen Einwanderern nach England und in die Vereinigten Staaten gebracht, wo er sich zum Osterhasen, wie wir ihn heute kennen, entwickelte.

Ausgabe:[Die frühesten Belege für den Osterhasen wurden 1678 von Georg Franck von Franckenau in Südwestdeutschland gefunden." Georg Franck von Franckenau war ein Professor der Medizin. Erst im 18. Jahrhundert erfuhr man auch in anderen Teilen Deutschlands von diesem Nachweis der Osterhasenassoziation." , "Richard Sermon war ein Gelehrter." Richard Sermon stellte eine Hypothese über mögliche Erklärungen für die traditionelle Assoziation des Hasen mit Ostern auf.", "Hasen sind im Frühling oft in Gärten anzutreffen.", "Hasen sind möglicherweise einfache Tiere, die in der Natur vorkommen. , "Hasen könnten eine einfache Erklärung dafür sein, warum Kinder bunte Eier in ihren Gärten finden." , "In Europa gibt es eine traditionelle Ansicht, dass Hasen Eier legen." , "Der Hasenbau ist dem Nest des Weizenvogels sehr ähnlich. Beide sind auf Wiesen zu finden und die ersten, die man im Frühjahr findet. Im 19. Jahrhundert wurde der Osterhase in Europa durch die Beliebtheit von Osterkarten, Spielzeug und Büchern weithin bekannt. Deutsche Einwanderer brachten den Brauch des Osterhasen nach England und in die Vereinigten Staaten. , "In England und den Vereinigten Staaten entwickelte sich der Brauch des Osterhasen allmählich zu dem Osterhasen, den wir heute kennen." ] Eingabe:

Ausgabe: