VideoGrain: Text-Eingabeaufforderungen für die lokale Bearbeitung von Videos Open-Source-Projekt

Allgemeine Einführung

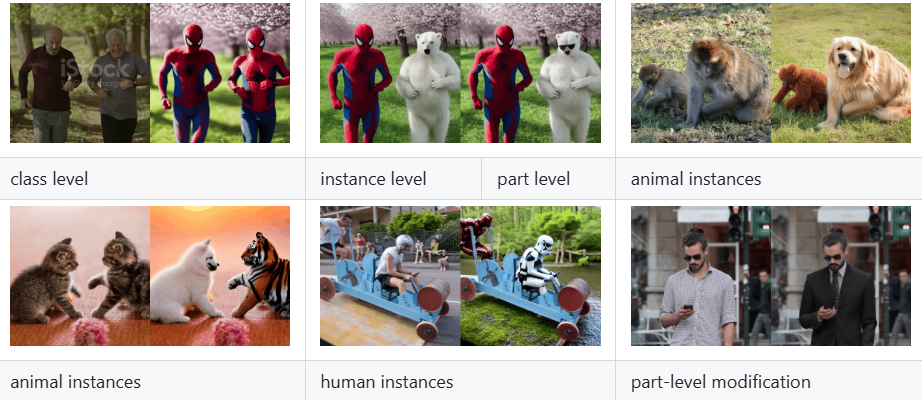

VideoGrain ist ein Open-Source-Projekt, das sich auf Multi-Grain-Videobearbeitung konzentriert, vom xAI-Team entwickelt und auf GitHub gehostet wird. Dieses Projekt stammt aus dem Papier "VideoGrain: Modulating Space-Time Attention for Multi-Grained Video Editing", das für die ICLR 2025 Konferenz ausgewählt wurde. Es ermöglicht eine feinkörnige Bearbeitung von Videoinhalten auf Kategorie-, Instanz- und lokaler Ebene, indem es den raum-zeitlichen Aufmerksamkeitsmechanismus im Diffusionsmodell moduliert. Im Vergleich zu herkömmlichen Methoden löst VideoGrain das Problem der semantischen Ausrichtung von Text- und Regionskontrolle sowie das Problem der Feature-Kopplung und kann ohne zusätzliches Training eine qualitativ hochwertige Bearbeitung durchführen. Das Projekt stellt Entwicklern, Forschern und Videobearbeitungs-Enthusiasten einen vollständigen Code, eine Installationsanleitung und vortrainierte Modelle zur Verfügung und hat bereits die Aufmerksamkeit der akademischen und Open-Source-Gemeinschaft auf sich gezogen.

Funktionsliste

- Videobearbeitung mit MehrfachgranularitätUnterstützung für die präzise Änderung von Kategorien (z. B. Ersetzen von "Mensch" durch "Roboter"), Instanzen (z. B. bestimmte Objekte) und lokalen Details (z. B. Handbewegungen) in einem Video.

- Keine Möglichkeit zur Sample-BearbeitungEs ist nicht nötig, für ein bestimmtes Video erneut zu üben, geben Sie einfach die Textanweisungen ein, um die Bearbeitung abzuschließen.

- räumlich-zeitliche Modulation der AufmerksamkeitVerbesserung der Bearbeitungsgenauigkeit und der Videoqualität durch Verbesserung der Cross-Attention (Text-zu-Region) und Self-Attention (Trennung von Merkmalen innerhalb der Region).

- Offener Quellcode und ModellierungVollständiger Implementierungscode und vortrainierte Modelle werden zur einfachen Reproduktion und Erweiterung durch die Benutzer bereitgestellt.

- diffusionsoffenes ModellBasierend auf Frameworks wie Diffusoren und FateZero zur einfachen Integration in bestehende Videoerstellungsprozesse.

- Unterstützung mehrerer DokumenteEs kann Videos, Bilder und andere von Benutzern hochgeladene Inhalte verarbeiten und die bearbeiteten Videoergebnisse ausgeben.

Hilfe verwenden

VideoGrain erfordert einige Programmierkenntnisse und Hardware-Unterstützung, aber seine Installations- und Betriebsverfahren sind im GitHub-Repository ausführlich beschrieben. Nachfolgend finden Sie eine detaillierte Installations- und Nutzungsanleitung, die den Benutzern einen schnellen Einstieg ermöglicht.

Einbauverfahren

- Erstellen einer Conda-Umgebung

Erstellen Sie eine eigenständige Python 3.10-Umgebung und aktivieren Sie sie, indem Sie den folgenden Befehl in das Terminal eingeben:

conda create -n videograin python=3.10

conda activate videograin

Vergewissern Sie sich, dass Conda installiert ist. Falls nicht, laden Sie es von der Anaconda-Website herunter.

- Installation von PyTorch und verwandten Abhängigkeiten

VideoGrain stützt sich auf PyTorch und dessen CUDA-Unterstützung, GPU-Beschleunigung wird empfohlen. Führen Sie den folgenden Befehl aus, um es zu installieren:

conda install pytorch==2.3.1 torchvision==0.18.1 torchaudio==2.3.1 pytorch-cuda=12.1 -c pytorch -c nvidia

pip install --pre -U xformers==0.0.27

xformers können auf Speicherplatz und Geschwindigkeit optimiert werden; wenn sie nicht benötigt werden, können sie übersprungen werden.

- Installieren zusätzlicher Abhängigkeiten

Führen Sie den folgenden Befehl im Stammverzeichnis des Repository aus, um alle abhängigen Bibliotheken zu installieren:

pip install -r requirements.txt

Vergewissern Sie sich, dass das Internet offen ist, da für das Herunterladen einiger Pakete ein wissenschaftlicher Internetzugang erforderlich sein kann.

- Herunterladen des vortrainierten Modells

VideoGrain erfordert Modellgewichte wie Stable Diffusion 1.5 und ControlNet. Führen Sie das im Repository bereitgestellte Skript aus:

bash download_all.sh

Dadurch wird das Basismodell automatisch in das angegebene Verzeichnis heruntergeladen. Für manuelle Downloads besuchen Sie die Links Hugging Face oder Google Drive (siehe README für Details).

- Vorbereitung von ControlNet-Präprozessorgewichten

Laden Sie Annotator-Gewichte (z. B. DW-Pose, depth_midas usw.) herunter (ca. 4 GB) und verwenden Sie den folgenden Befehl:

gdown https://drive.google.com/file/d/1dzdvLnXWeMFR3CE2Ew0Bs06vyFSvnGXA/view?usp=drive_link

tar -zxvf videograin_data.tar.gz

Entpacken Sie die Dateien und legen Sie sie im Verzeichnis ./annotator/ckpts Katalog.

Verwendung

Nach Abschluss der Installation kann VideoGrain zur Videobearbeitung über die Kommandozeile gestartet werden. Im Folgenden wird der Ablauf der Hauptfunktionen beschrieben:

1. multigranularer Videoschnitt

- Vorbereiten der Eingabedatei

Legen Sie die zu bearbeitende Videodatei in das Projektverzeichnis (z. B../input_video.mp4). Unterstützt gängige Formate wie MP4, AVI. - Vorbereiten von Text-Warnungen

Geben Sie im Skript z. B. Bearbeitungsanweisungen an:

prompt = "将视频中的汽车替换为保时捷"

Unterstützung der Ersetzung von Kategorien (z. B. "Auto" in "Porsche"), der Änderung von Instanzen (z. B. "Bestimmte Figur" in "Iron Man ") und lokale Anpassungen (z. B. "Handbewegung" in "Handwelle").

- Führen Sie den Befehl edit aus

Geben Sie ihn in das Terminal ein:

python edit_video.py --input ./input_video.mp4 --prompt "将视频中的汽车替换为保时捷" --output ./output_video.mp4

Nach der Bearbeitung wird das Ergebnis gespeichert unter ./output_video.mp4.

2. null Probenbearbeitung

- Direkte Bearbeitung ohne Schulung

Die Hauptstärke von VideoGrain ist die Null-Proben-Fähigkeit. Die Benutzer müssen nur Videos und Hinweise zur Verfügung stellen, es ist kein Vortraining erforderlich. Beispiel:

python edit_video.py --input ./sample_video.mp4 --prompt "将狗替换为猫" --output ./edited_video.mp4

- Anpassungsparameter

passabel--strengthDer Parameter steuert die Bearbeitungsintensität (0,0-1,0, Standardwert 0,8):

python edit_video.py --input . /sample_video.mp4 --prompt "Ersetze Hund durch Katze" --strength 0.6

3. zeitliche Modulation der Aufmerksamkeit

- Verbesserte Text-zu-Bereich-Kontrolle

VideoGrain optimiert automatisch die Cross-Attention, um sicherzustellen, dass Aufforderungen nur den Zielbereich betreffen. Wenn die Aufforderung beispielsweise lautet: "Ändere die Kleidung der Figur auf Rot", werden fremde Hintergründe nicht beeinflusst. - Erhöhte Merkmalstrennung

Der Mechanismus der Selbstbeachtung verbessert die Detailkonsistenz innerhalb der Regionen und verringert die Interferenzen zwischen den Regionen. Die Benutzer müssen keine manuellen Anpassungen vornehmen; sie werden zur Laufzeit automatisch wirksam.

Vorsichtsmaßnahmen bei der Handhabung

- Hardware-Voraussetzung

NVIDIA-GPUs (z. B. A100 oder RTX 3090) mit mindestens 12 GB Videospeicher werden empfohlen, da die CPU langsamer laufen kann. - Vorschläge für Stichwortwörter

Die Aufforderungen müssen spezifisch und klar sein, z. B. "Ersetze das Zeichen auf der linken Seite durch einen Roboter" ist besser als das vage "Bearbeite das Zeichen". - Fehlersuche und Protokollierung

Wenn etwas schief geht, prüfen Sie die./logsVerzeichnis oder durch Hinzufügen der Protokolldatei nach dem Befehl--verboseDetaillierte Ausgabe anzeigen.

Ausgewählte Funktionen

- Multigranularitätsbearbeitung in Aktion

Angenommen, der Benutzer möchte in einem Video "Fahrrad" durch "Motorrad" ersetzen. Geben Sie einfach den Videopfad und das Stichwort ein, und VideoGrain erkennt alle Fahrräder und ersetzt sie durch Motorräder, wobei Aktion und Hintergrund konsistent bleiben. - Open-Source-Erweiterungen

Vom Benutzer änderbaredit_video.pyModellparameter im Diffusor-Framework zu ändern oder neue Funktionen auf der Grundlage des Diffusor-Frameworks hinzuzufügen, z. B. Unterstützung für höhere Auflösungen oder mehr Bearbeitungsarten. - Unterstützung der Gemeinschaft

GitHub-Repositories bieten Issue Boards, in denen Benutzer Probleme einreichen oder sehen können, was andere getan haben.

Mit den oben genannten Schritten können Benutzer schnell mit VideoGrain beginnen und Videobearbeitungsaufgaben erledigen, die von einfachen Ersetzungen bis zu komplexen lokalen Anpassungen reichen.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...