Allgemeine Einführung

Infinity ist ein bahnbrechendes System zur Erzeugung hochauflösender Bilder, das vom FoundationVision-Team entwickelt wurde. Das Kernmerkmal von Infinity ist die Verwendung eines unbegrenzten Vokabulars von Disambiguatoren und Klassifikatoren, die zusammen mit dem Autokorrelationsmechanismus auf Bit-Ebene in der Lage sind, realistische Bilder in höchster Qualität zu erzeugen. Das Projekt ist vollständig quelloffen und bietet eine Auswahl an Modellgrößen von 2B bis 20B Parameterskalen und unterstützt die Bilderzeugung bei Auflösungen von bis zu 1024x1024. Als Spitzenforschungsprojekt treibt Infinity nicht nur den technologischen Fortschritt auf dem Gebiet der Computer Vision voran, sondern bietet auch neue Lösungen für Bilderzeugungsaufgaben.

Tritt dem Discord-Kanal bei, um das Infinity-Bilderzeugungsmodell zu erleben!

Funktionsliste

- 2B parametrisches Modell unterstützt hochwertige Bilderzeugung bis zu einer Auflösung von 1024x1024

- Bietet ein visuelles Lexikon mit unbegrenztem Wortschatz zur Unterstützung der Extraktion feinerer Bildmerkmale

- Implementierung eines Selbstkorrekturmechanismus auf Bit-Ebene zur Verbesserung der Qualität und Genauigkeit der erzeugten Bilder

- Unterstützt die flexible Auswahl mehrerer Modellgrößen (125M, 1B, 2B, 20B Parameter)

- Bereitstellung einer interaktiven Schnittstelle, die den Benutzern die Durchführung von Experimenten zur Bilderzeugung erleichtert

- Integriert in einen vollständigen Ausbildungs- und Bewertungsrahmen

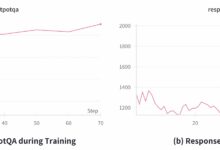

- Unterstützt die multidimensionale Bewertung der Modellleistung (GenEval, DPG, HPSv2.1 und andere Metriken)

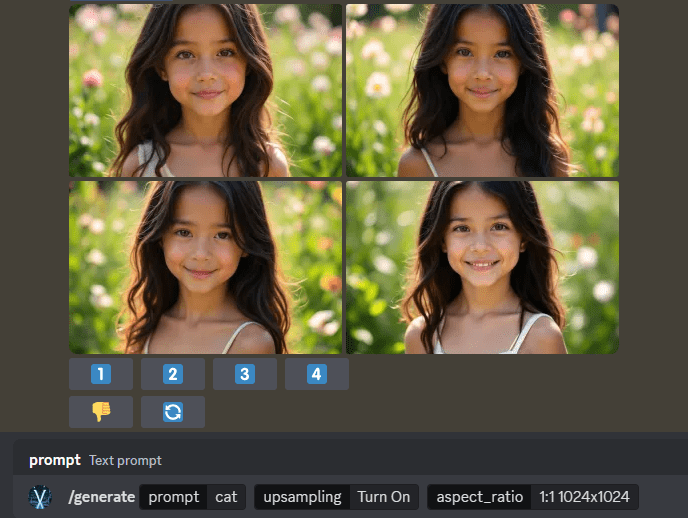

- Bietet eine Online-Demoplattform, auf der die Benutzer die Bilderzeugung direkt erleben können

Hilfe verwenden

1. ökologische Konfiguration

1.1 Grundlegende Anforderungen:

- Python-Umgebung

- PyTorch >= 2.5.1 (erfordert FlexAttention-Unterstützung)

- Installieren Sie andere Abhängigkeiten über pip:

pip3 install -r anforderungen.txt

2. die Verwendung von Modellen

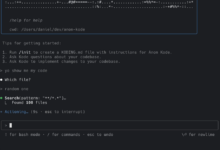

2.1 Schnellstart:

- Laden Sie das vortrainierte Modell von HuggingFace herunter: infinity_2b_reg.pth

- Visual Segmenter herunterladen: infinity_vae_d32_reg.pth

- Interaktive Bilderzeugung mit interactive_infer.ipynb

2.2 Konfiguration der Ausbildung:

# Starten des Trainings mit einem einzigen Befehl

bash skripte/train.sh

# Trainingsbefehle für verschiedene Modellgrößen

# 125M Modell (256x256 Auflösung)

torchrun --nproc_pro_node=8 train.py --model=layer12c4 --pn 0.06M

# 2B-Modell (Auflösung 1024x1024)

torchrun --nproc_per_node=8 train.py --model=2bc8 --pn 1M

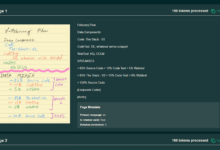

2.3 Datenaufbereitung:

- Die Trainingsdaten müssen im JSONL-Format aufbereitet werden

- Jedes Datenelement enthält: Bildpfad, lange und kurze Textbeschreibung, Bildseitenverhältnis und andere Informationen

- Beispieldatensätze werden vom Projekt als Referenz zur Verfügung gestellt

2.4 Bewertung des Modells:

- Unterstützung für mehrere Bewertungsindikatoren:

- ImageReward: Bewertung der menschlichen Präferenzen für generierte Bilder

- HPS v2.1: Bewertungsmetriken basierend auf 798K manuellen Rankings

- GenEval: Auswertung von Text-Bild-Abgleich

- FID: Bewertung der Qualität und Vielfalt der erzeugten Bilder

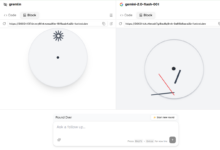

2.5 Online-Präsentation:

- Besuchen Sie die offizielle Demo-Plattform: https://opensource.bytedance.com/gmpt/t2i/invite

- Geben Sie eine Textbeschreibung ein, um ein entsprechendes hochwertiges Bild zu generieren

- Unterstützt die Einstellung von mehreren Bildauflösungen und Generierungsparametern

3. erweiterte Funktionen

3.1 Selbstkorrekturmechanismen auf Bitebene:

- Automatische Erkennung und Korrektur von Fehlern im Erzeugungsprozess

- Verbesserung der Qualität und Genauigkeit der erzeugten Bilder

3.2 Erweiterungen des Modells:

- Unterstützt flexible Skalierung der Modellgrößen

- Es sind mehrere Modelle mit Parametern von 125M bis 20B erhältlich.

- Anpassung an unterschiedliche Hardware-Umgebungen und Anwendungsanforderungen

4. vorsichtsmaßnahmen

- Sicherstellen, dass die Hardware-Ressourcen den Modellanforderungen entsprechen

- Groß angelegte Modelle erfordern ausreichend GPU-Speicher

- Empfohlen für die Ausbildung mit HPC-Geräten

- Regelmäßige Kontrolle der Back-up-Ausbildung

- Beachten Sie die Einhaltung des MIT-Open-Source-Protokolls