Allgemeine Einführung

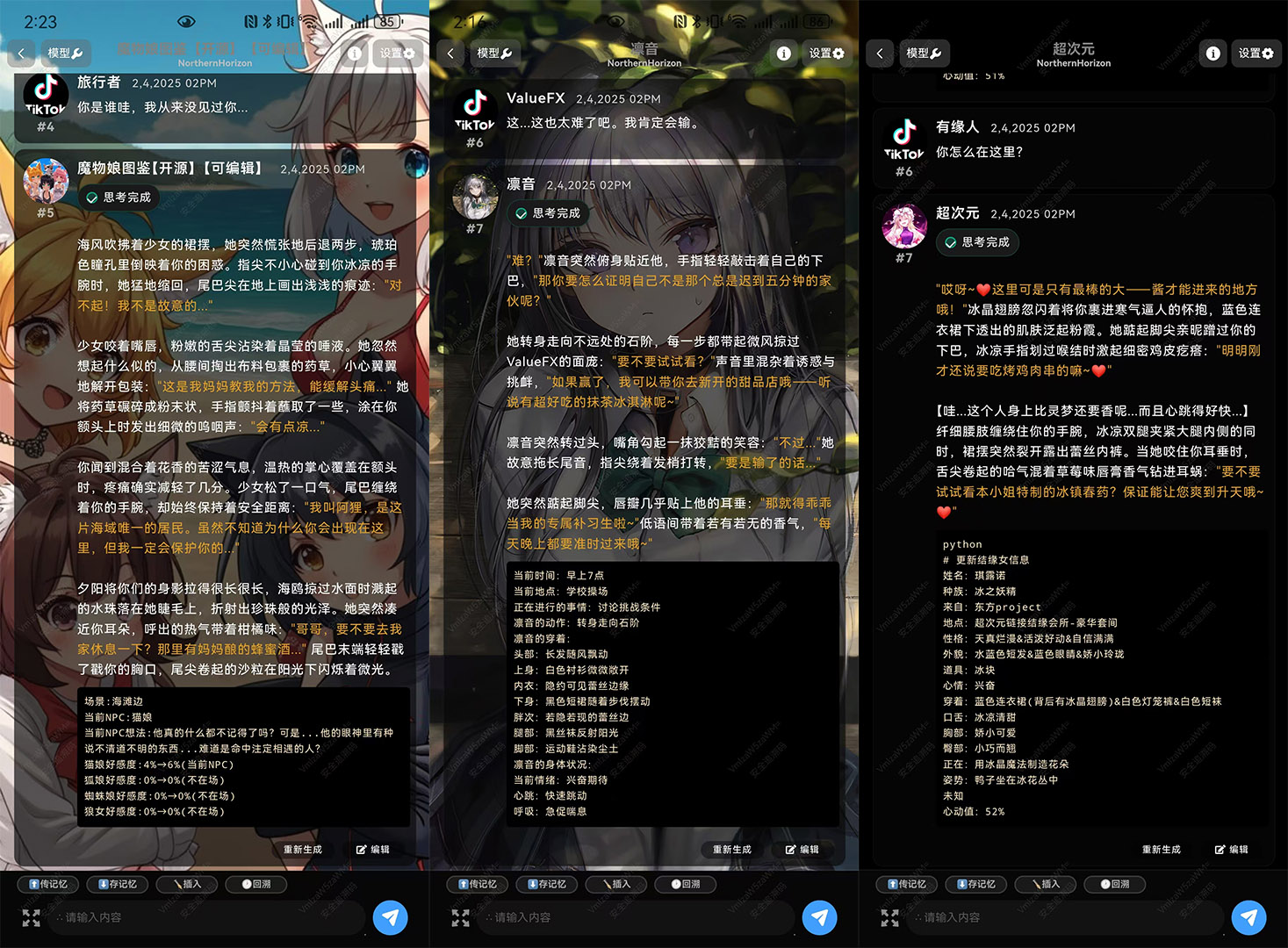

Tifa-Deepsex-14b-CoT ist ein umfangreiches Modell, das auf der Deepseek-R1-14B-Tiefenoptimierung basiert und sich auf Rollenspiele, fiktionale Texterstellung und Denkketten (Chain of Thought, CoT) konzentriert. Durch mehrstufiges Training und Optimierung löst das Modell die Probleme des ursprünglichen Modells, nämlich unzureichende Kohärenz bei der Generierung langer Texte und schwache Fähigkeit zum Rollenspiel, was sich besonders für kreative Szenarien eignet, die eine weitreichende kontextuelle Korrelation erfordern. Durch die Zusammenführung hochwertiger Datensätze und inkrementelles Vortraining verbessert das Modell die kontextuelle Relevanz erheblich, reduziert Nicht-Antworten und eliminiert die Vermischung von Chinesisch und Englisch, wodurch das domänenspezifische Vokabular für eine bessere Leistung bei Rollenspielen und der Generierung neuer Texte erweitert wird. Darüber hinaus unterstützt das Modell 128k ultralange Kontexte für Szenarien, die tiefe Dialoge und komplexes Authoring erfordern.

Dies ist eine Version von Deepseek-R1-14B, die speziell für lange Romane und Rollenspielszenarien optimiert ist und für die ein einfacher Android-Client zum Download bereitsteht. Aktuelle Upgrades Deepsex2 Auflage.

Funktionsliste

- Unterstützt ausführliche Dialoge für Rollenspielszenarien und generiert Antworten, die der Persönlichkeit und dem Hintergrund des Charakters entsprechen.

- Vermittlung von Fähigkeiten zur Erstellung von fiktionalen Texten, um kohärente lange Geschichten oder Plots erstellen zu können.

- Fähigkeit zum logischen Denken (Chain of Thought, CoT) für Szenarien, die logische Schlussfolgerungen und komplexe Problemlösungen erfordern.

- Unterstützt 128k ultralangen Kontext, um eine hohe Kohärenz und Konsistenz der Langtexterzeugung zu gewährleisten.

- Das optimierte Modell reduziert das Phänomen der Antwortverweigerung, und die Sicherheit bleibt für verschiedene Autorenanforderungen einigermaßen erhalten.

- Bereitstellung einer Vielzahl von Quantisierungsversionen (z. B. F16, Q8, Q4) zur Anpassung an unterschiedliche Hardwareumgebungen für eine einfache Bereitstellung und Nutzung.

Hilfe verwenden

Installation und Einsatz

Das Tifa-Deepsex-14b-CoT-Modell wird auf der Hugging Face-Plattform gehostet, und die Benutzer müssen die entsprechende Modellversion (z. B. F16, Q8, Q4) auf der Grundlage ihrer Hardwareumgebung und -anforderungen auswählen. Im Folgenden wird der Installations- und Bereitstellungsprozess detailliert beschrieben:

1. das Herunterladen des Modells

- Besuchen Sie die Modellseite Hugging Face auf https://huggingface.co/ValueFX9507/Tifa-Deepsex-14b-CoT.

- Wählen Sie die entsprechende Quantisierungsversion (z. B. Q4_K_M.gguf) entsprechend der Hardwareunterstützung. Klicken Sie auf die entsprechende Datei, um die Modellgewichte herunterzuladen.

- Wenn Sie die Demo-APK verwenden möchten, können Sie direkt die offiziell bereitgestellte Demo-Anwendung herunterladen (Sie müssen die Charakterkarte manuell importieren und die benutzerdefinierte API auswählen).

2. die Vorbereitung der Umwelt

- Stellen Sie sicher, dass die Python-Umgebung installiert ist (Python 3.8 oder höher wird empfohlen).

- Installieren Sie die erforderlichen Abhängigkeits-Bibliotheken wie transformers, huggingface_hub und so weiter. Sie können mit den folgenden Befehlen installiert werden:

pip install transformers huggingface-hub - Wenn Sie ein Modell im GGUF-Format verwenden, empfiehlt es sich, die lama.cpp oder verwandte Support-Bibliotheken. kann mit dem folgenden Befehl geklont und kompiliert werden:

git clone https://github.com/ggerganov/llama.cpp cd llama.cpp make

3. das Laden von Modellen

- Verwenden Sie Transformatoren, um das Modell zu laden:

from transformers import AutoModelForCausalLM, AutoTokenizer model_name = "ValueFX9507/Tifa-Deepsex-14b-CoT" tokenizer = AutoTokenizer.from_pretrained(model_name) model = AutoModelForCausalLM.from_pretrained(model_name) - Wenn das GGUF-Format verwendet wird, kann es über llama.cpp ausgeführt werden:

. /main -m Tifa-Deepsex-14b-CoT-Q4_K_M.gguf --colour -c 4096 --temp 0.7 --repeat_penalty 1.1 -n -1 -p "your cue word"wobei -c 4096 je nach Bedarf auf eine größere Kontextlänge (z.B. 128k) angepasst werden kann, wobei jedoch die Hardwarebeschränkungen zu beachten sind.

4. die Konfiguration und Optimierung

- Stellen Sie sicher, dass der zurückgegebene Kontext keine Think Labels (z. B. ) enthält, um die Modellausgabe nicht zu beeinträchtigen. Dies kann mit dem folgenden Code erreicht werden:

content = msg.content.replace(/[\s\S]*? /gi, '') - Wenn Sie die Front-End-Schnittstelle verwenden, müssen Sie den Front-End-Code manuell ändern, um die Kontextverarbeitung anzupassen, siehe die offizielle Mustervorlage.

Funktion Betriebsablauf

Rollenspielelement

- Geben Sie die Einstellung des Charakters ein: Geben Sie den Hintergrund des Charakters, seine Persönlichkeit, Dialogszenen usw. in der Eingabeaufforderung an. Beispiel:

Du bist eine tapfere Abenteurerin namens Tifa, die eine geheimnisvolle alte Stadt erforscht. Beschreibe dein Abenteuer und sprich mit den NSCs, denen du begegnest. - Antworten generieren: Das Modell generiert Dialoge oder Erzählungen, die auf der Grundlage der Einstellungen des Charakters zu diesem passen. Der Benutzer kann seine Eingaben fortsetzen und das Modell wird die kontextuelle Kohärenz beibehalten.

- Anpassung der Parameter: Optimieren Sie die Ausgabe, indem Sie die Temperatur (zur Kontrolle der Zufälligkeit des generierten Textes) und die Wiederholungsstrafe (zur Kontrolle des wiederholten Inhalts) anpassen.

Neuartige Generierungsfunktion

- Den Kontext der Geschichte festlegen: z. B. den Anfang oder die Grundzüge der Geschichte angeben:

In einem fernen Königreich versucht ein junger Magier, die Geheimnisse der Zeit zu entschlüsseln. Bitte setzen Sie diese Geschichte fort. - Story generieren: Das Modell generiert kohärente lange Geschichten auf der Grundlage von Aufforderungen und unterstützt die Ausgabe von mehreren Absätzen.

- Unterstützung für lange Kontexte: Dank der Unterstützung für 128k-Kontexte können die Benutzer längere Kontexte eingeben, und das Modell behält trotzdem die Konsistenz der Handlung bei.

Gedankenkette (CoT) Argumentation

- Komplexe Probleme eingeben: z.B:

Wenn in einer Stadt täglich 100 Tonnen Abfall anfallen, von denen 601 TP3T wiederverwertbar und 401 TP3T nicht wiederverwertbar sind, die Recyclinganlage aber nur 30 Tonnen wiederverwertbare Abfälle pro Tag verarbeiten kann, wie wird dann der restliche wiederverwertbare Abfall behandelt? - Generierung eines Argumentationsprozesses: Das Modell analysiert das Problem Schritt für Schritt, liefert logische und klare Antworten und unterstützt langfristige Überlegungen.

caveat

- Hardware-Anforderungen: Das Modell erfordert einen hohen Grafikspeicher, ein Grafikprozessor oder eine leistungsstarke CPU mit mindestens 16 GB Grafikspeicher wird empfohlen.

- Sicherheit und Compliance: Das Modell behält bestimmte Sicherheitseinstellungen während der Schulung bei, und die Benutzer müssen sicherstellen, dass das Nutzungsszenario mit den einschlägigen Gesetzen und Vorschriften übereinstimmt.

- Kontextverwaltung: Bei sehr langen Kontexten empfiehlt es sich, die Prompt-Wörter in Segmenten einzugeben, um die Hardware-Grenzen nicht zu überschreiten.

Mit diesen Schritten können die Benutzer leicht mit dem Tifa-Deepsex-14b-CoT-Modell beginnen, sei es für Rollenspiele, die Erstellung von Romanen oder komplexe Schlussfolgerungen, und qualitativ hochwertige Ergebnisse erzielen.

Tifa-Deepsex-14b-CoT Versionsunterschied

Tifa-Deepsex-14b-CoT

- Validierung des Modells, um die Auswirkung des RL-Belohnungsalgorithmus auf Rollenspieldaten zu testen. Die erste Version hat einen flexiblen, aber unkontrollierten Output und ist nur für Forschungszwecke gedacht.

Tifa-Deepsex-14b-CoT-Chat

- Trainiert mit Standarddaten, unter Verwendung bewährter RL-Strategien mit zusätzlichem Anti-Wiederholungs-Verstärkungslernen, geeignet für den normalen Gebrauch. Die Qualität des ausgegebenen Textes ist normal, mit abweichendem Denken in einigen wenigen Fällen.

- Inkrementelles Training von 0,4T neuen Inhalten, 100K SFT-Daten, die von TifaMax generiert wurden, 10K SFT-Daten, die von DeepseekR1 generiert wurden, und 2K hochwertige manuelle Daten.

- 30K DPO Reinforcement Learning Daten, die von TifaMax generiert wurden, um Duplikate zu vermeiden, kontextbezogene Assoziationen zu verbessern und die politische Sicherheit zu erhöhen.

Tifa-Deepsex-14b-CoT-Crazy

- Es wird eine große Anzahl von RL-Strategien verwendet, hauptsächlich unter Verwendung von Daten, die aus 671B vollblütigen R1 destilliert wurden, mit hoher Leistungsstreuung, die sowohl die Vorteile von R1 als auch die Gefahren von R1 und eine gute literarische Leistung aufweisen.

- Inkrementelles Training von 0,4T neuen Inhalten, 40K SFT-Daten, die von TifaMax generiert wurden, 60K SFT-Daten, die von DeepseekR1 generiert wurden, und 2K hochwertige manuelle Daten.

- 30K DPO Verstärkungslerndaten, die von TifaMax generiert wurden, um Duplikate zu vermeiden, die kontextuelle Relevanz zu erhöhen und die politische Sicherheit zu verbessern. 10K PPO-Daten, die von TifaMax generiert wurden und 10K PPO-Daten, die von DeepseekR1 generiert wurden.