Schnelllesen

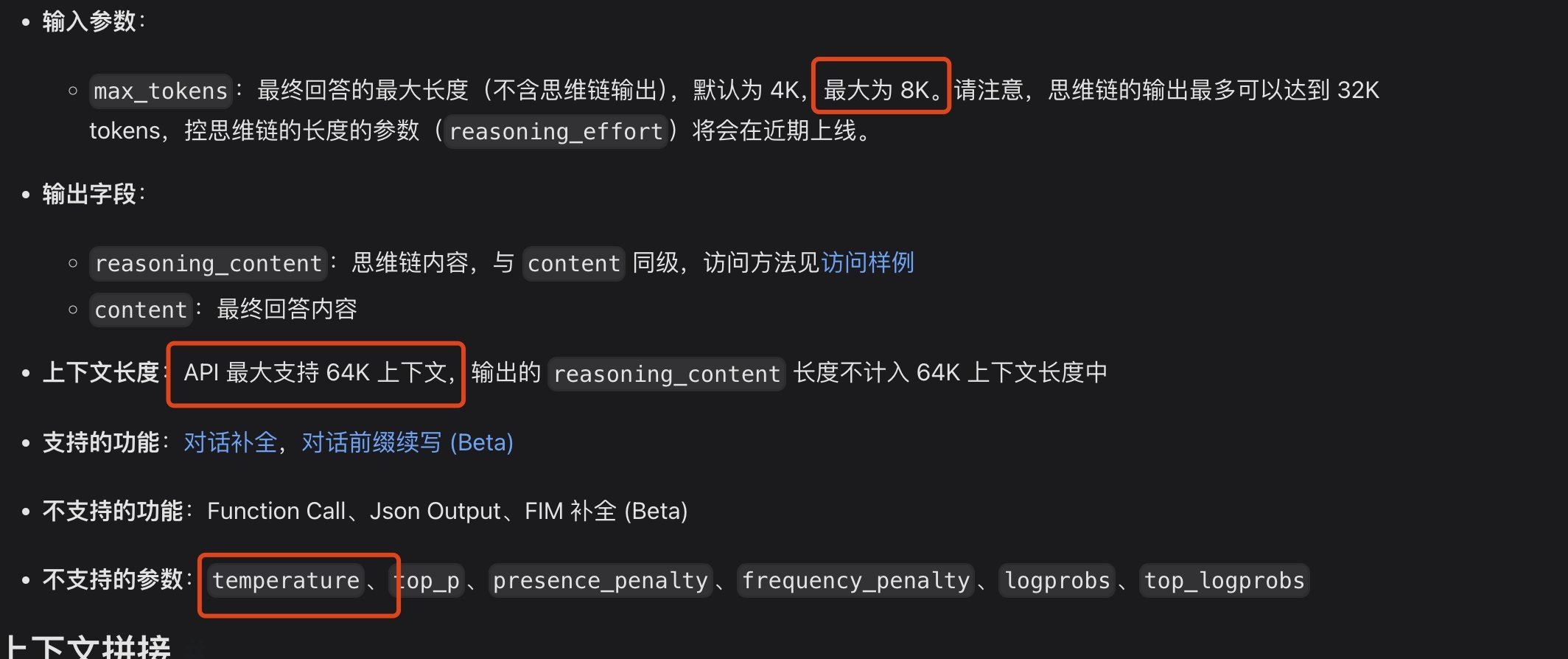

Erfahrung:DeepSeek Offizielle Website: chat.deepseek.com Chatte mit DeepSeek-R1 und schalte die Schaltfläche "Deep Thinking" ein. Besuchen Sie API kompatibel mit OpenAI-Format .

Zusammenfassung:Kontextlänge: 128K, $2,19/pro Million Output-Token (Poundland in der Welt der großen Modelle), gleichwertige Leistung wie OpenAI-o1, alle Open-Source-Modelle frei destilliert und kommerziell genutzt, einfallsreiche Front-End-Funktionen zum Schreiben

Basismodell: Sowohl DeepSeek-R1-Zero als auch DeepSeek-R1 werden auf der Grundlage von DeepSeek-V3-Base trainiert, und DeepSeek-R1 wird durch eine kleine Menge langer CoT-Daten erweitert, was die Ausgabe strukturierter und einfacher macht.

Destillationsmodelle (allgemeine Verbesserung der bestehenden Open-Source-Miniaturen-Funktionen): Die Zerlegung von DeepSeek-R1 in mehrere kleinere Modelle, die ( Ollama (zum Herunterladen verfügbar)

Qwen2.5-Math-1.5B, Qwen2.5-Math-7B, Qwen2.5-14B, Qwen2.5-32B, Llama-3.1-8B, Llama-3.3-70B-Instruct

Problem, dass die Kontextlänge der API bei der Programmierung möglicherweise nicht ausreicht

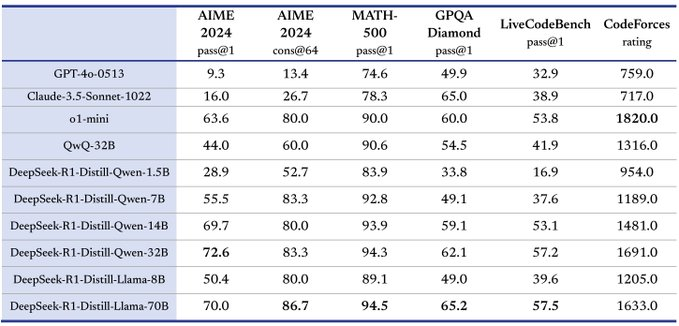

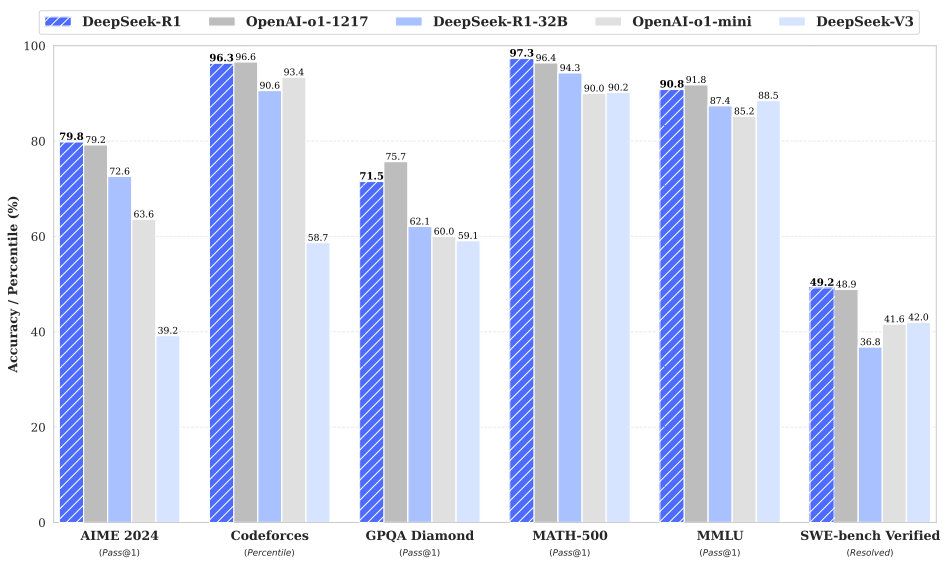

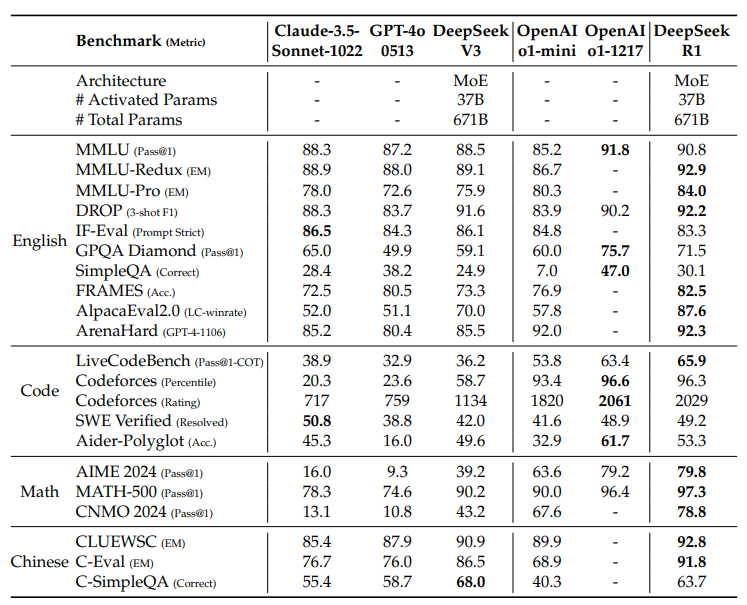

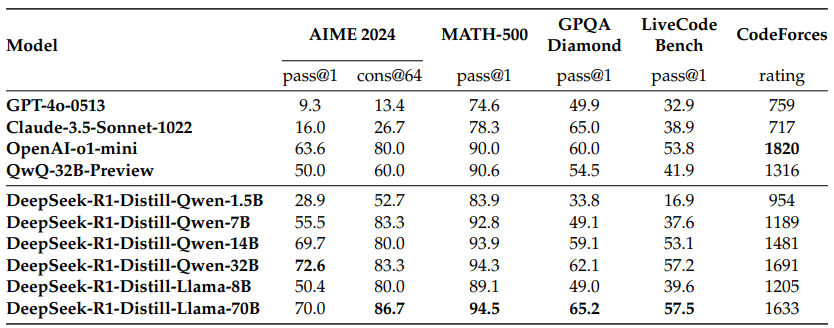

Benchmark-Bewertung

-

Starke Argumentationsfähigkeit:

-

Gute Leistung bei mathematischen Problemen, vergleichbar mit der Leistung von OpenAI-01-1217. Erzielt eine überraschend hohe Punktzahl (97,3%) beim MATH-500-Benchmark.

-

Starke Leistung bei Codieralgorithmus-Aufgaben wie Codeforces und LiveCodeBench.

-

Demonstration starker Fähigkeiten bei Aufgaben, die komplexes Denken erfordern, wie z. B. FRAMES.

-

-

Starke Allzweckfähigkeiten:

-

Ausgezeichnete Leistung bei wissensbasierten Benchmarks wie MMLU, MMLU-Pro und GPQA Diamond.

-

Außerdem zeichnete er sich durch schriftliche Arbeiten, die Beantwortung offener Fragen und eine Vielzahl anderer Aufgaben aus.

-

Hervorragende Gewinnraten bei der Längenkontrolle in Benchmarks wie AlpacaEval 2.0 und ArenaHard, was beweist, dass es intelligent mit nicht prüfungsorientierten Abfragen umgeht.

-

Fähigkeit, prägnante Zusammenfassungen zu erstellen und Längenfehler zu vermeiden.

-

-

Gute Lesbarkeit:Mit Kaltstartdaten und einem speziellen Design im Trainingsprozess ist die Ausgabe von DeepSeek-R1 einfacher zu lesen, da das richtige Format und die richtige Struktur verwendet werden.

-

Mehrsprachigkeit:Obwohl es derzeit hauptsächlich für Chinesisch und Englisch optimiert ist, zeigt es eine gewisse Fähigkeit, Abfragen in mehreren Sprachen zu bearbeiten.

-

Fähigkeit, Anweisungen zu befolgen:Beim IF-Eval-Benchmark hat es gut abgeschnitten und gezeigt, dass es Anweisungen gut verstehen und befolgen kann.

-

Selbstentwicklungsfähigkeit:Durch Verstärkungslernen können Modelle selbstständig lernen und ihre Denkfähigkeiten verbessern und sind in der Lage, komplexe Probleme zu bewältigen, indem sie ihre Denkzeit erhöhen.

-

Ausgezeichnetes Destillationspotenzial:DeepSeek-R1 kann als Lehrermodell verwendet werden, um die Inferenzleistung in kleinere Modelle zu destillieren, und die destillierten Modelle haben eine ausgezeichnete Leistung, z. B. DeepSeek-R1-Distill-Qwen-32B, das die anderen Modelle bei mehreren Benchmarks deutlich übertrifft.

Über lokale Programmierungsmöglichkeiten

Wenn Sie der Meinung sind, dass v3 gut genug für die Programmierung ist, welches ist das alternative Destillationsmodell für den Desktop? Welches Destillationsmodell ist mit DeepSeek V3 vergleichbar? Nach der LiveCodeBench-Bewertung erreicht DeepSeek V3 42,2 Punkte und das Destillationsmodell Qwen 14B 53,1 Punkte, das eine vergleichbare Leistung und eine relativ große Desktop-Klasse hat, so dass die Verwendung von 14B auf dem Desktop empfohlen wird.

DeepSeek-R1: Motivierendes LLM-Reasoning durch Reinforcement Learning.

Geschrieben von DeepSeek-AI

Original: https://github.com/deepseek-ai/DeepSeek-R1/blob/main/DeepSeek_R1.pdf

Abstracts

Wir stellen unsere Inferenzmodelle der ersten Generation vor, DeepSeek-R1-Zero und DeepSeek-R1. DeepSeek-R1-Zero, ein Modell, das durch großangelegtes Reinforcement Learning (RL) ohne einen anfänglichen überwachten Feinabstimmungsschritt (SFT) trainiert wurde, demonstriert eine überlegene Inferenz. Mit RL zeigt DeepSeek-R1-Zero auf natürliche Weise viele leistungsstarke und interessante Inferenz-Verhaltensweisen. Allerdings stößt es auch auf einige Herausforderungen wie schlechte Lesbarkeit und Sprachmischung. Um diese Probleme anzugehen und die Inferenzleistung weiter zu verbessern, führen wir DeepSeek-R1 ein, das mehrstufiges Training und Kaltstartdaten vor RL kombiniert. DeepSeek-R1 erreicht eine mit OpenAI-01-1217 vergleichbare Leistung bei Inferenzaufgaben. Um die Forschungsgemeinschaft zu unterstützen, stellen wir DeepSeek-R1-Zero, DeepSeek-R1 und sechs dichte Modelle (1.5B, 7B, 8B, 14B, 32B, 70B) basierend auf Qwen und Llama Verfeinerungen als Open Source zur Verfügung.

Abb. 1 | Benchmark-Leistung von DeepSeek-R1.

Verzeichnis (auf der Festplatte des Computers)

1 Einleitung

1.1 Beiträge

1.2 Zusammenfassung der Bewertungsergebnisse

2 Methodik

2.1 Überblick

2.2 DeepSeek-R1-Zero: Verstärkungslernen auf der Grundlage grundlegender Modelle

2.2.1 Erweiterter Lernalgorithmus

2.2.2 Modellierung der Anreize

2.2.3 Schulungsvorlagen

2.2.4 Leistung von DeepSeek-R1-Zero, selbst-evolutionäre Prozesse und Momente der Offenbarung

2.3 DeepSeek-R1: Reinforcement Learning mit einem Kaltstart

2.3.1 Kaltstart

2.3.2 Begründungsorientiertes Verstärkungslernen

2.3.3 Ablehnung der Probenahme und Überwachung der Feinabstimmung

2.3.4 Reinforcement Learning für alle Szenarien

2.4 Destillation: Erweiterung kleiner Modelle um die Fähigkeit zur Schlussfolgerung

3 Experimente

3.1 DeepSeek-R1-Bewertung

3.2 Bewertung der Destillationsmodellierung

4 Diskussion

4.1 Destillation vs. intensives Lernen

4.2 Fehlgeschlagene Versuche

5 Schlussfolgerungen, Einschränkungen und künftige Arbeiten

1. einleitung

In den letzten Jahren haben sich groß angelegte Sprachmodelle (LLMs) rasant weiterentwickelt (Anthropic, 2024; Google, 2024; OpenAI, 2024a) und schließen allmählich die Lücke zur allgemeinen künstlichen Intelligenz (AGI).

In letzter Zeit hat sich das Post-Training zu einem wichtigen Teil des gesamten Trainingsprozesses entwickelt. Es hat sich gezeigt, dass es die Genauigkeit von Schlussfolgerungsaufgaben verbessert, mit gesellschaftlichen Werten übereinstimmt und sich an Benutzerpräferenzen anpasst, während es im Vergleich zum Pre-Training relativ wenig Rechenressourcen benötigt. Die Modellfamilie o1 von OpenAI (OpenAI, 2024b) ermöglicht erstmals eine Skalierung der Argumentation durch Erhöhung der Länge der Gedankenkette. Dieser Ansatz hat zu bedeutenden Fortschritten bei einer Vielzahl von Denkaufgaben geführt, z. B. bei mathematischen, kodierenden und wissenschaftlichen Denkaufgaben. Die Herausforderung einer effektiven Skalierung der Testzeit bleibt jedoch eine offene Frage für die Forschungsgemeinschaft. In einigen früheren Arbeiten wurden verschiedene Ansätze untersucht, darunter prozessbasierte Belohnungsmodelle (Lightman et al., 2023; Uesato et al., 2022; Wang et al., 2023), Reinforcement Learning (Kumar et al., 2024) und Suchalgorithmen wie Monte-Carlo-Baumsuche und Bündelsuche (Feng et al., 2024; Trinh et al., 2024). 2024; Trinh et al.). Keine dieser Methoden war jedoch in der Lage, eine verallgemeinerte Inferenzleistung zu erreichen, die mit der o1-Modellfamilie von OpenAI vergleichbar ist.

In diesem Beitrag unternehmen wir den ersten Schritt zur Verbesserung der Argumentationsfähigkeiten von Sprachmodellen durch reines Reinforcement Learning (RL). Unser Ziel ist es, das Potenzial von LLM zu erforschen, um Argumentationsfähigkeiten ohne überwachte Daten zu entwickeln, wobei wir uns auf die Selbstevolution durch einen reinen RL-Prozess konzentrieren. Konkret verwenden wir DeepSeek-V3-Base als Basismodell und GRPO (Shao et al., 2024) als RL-Framework, um die Leistung des Modells bei der Argumentation zu verbessern. Während des Trainingsprozesses entwickelt DeepSeek-R1-Zero auf natürliche Weise viele leistungsstarke und interessante Inferenzverhaltensweisen. Nach Tausenden von RL-Schritten zeigt DeepSeek-R1-Zero eine hervorragende Leistung bei Inferenz-Benchmarks. Zum Beispiel AIME 2024的pass@1得分从15.6%提高到71.0% und durch Mehrheitsabstimmung wird die Punktzahl weiter auf 86,7% verbessert und erreicht damit das Leistungsniveau von OpenAI-01-0912.

Allerdings stößt DeepSeek-R1-Zero auf Herausforderungen wie schlechte Lesbarkeit und Sprachmischung. Um diese Probleme anzugehen und die Inferenzleistung weiter zu verbessern, führen wir DeepSeek-R1 ein, das eine kleine Menge an Kaltstartdaten mit einem mehrstufigen Trainingsprozess kombiniert. Wir sammeln zunächst Tausende von Cold-Start-Daten, um das DeepSeek-V3-Base-Modell zu optimieren. Wenn sich der RL-Prozess der Konvergenz nähert, erzeugen wir neue SFT-Daten durch Ablehnung von RL-Kontrollpunkten, kombinieren sie mit überwachten Daten aus DeepSeek-V3 in den Bereichen Schreiben, Faktenquiz und Selbstwahrnehmung und trainieren dann das DeepSeek V3-Basismodell. Nach der Feinabstimmung mit den neuen Daten durchläuft dieser Checkpoint einen weiteren RL-Prozess, der die Hinweise aus allen Szenarien berücksichtigt. Nach diesen Schritten erhalten wir einen Kontrollpunkt namens DeepSeek-R1, der in seiner Leistung mit OpenAI-01-1217 vergleichbar ist.

Wir haben außerdem die Destillation von DeepSeek-R1 auf kleinere dichte Modelle untersucht. Unter Verwendung von Qwen 2.5-32B (Qwen, 2024b) als Basismodell übertrifft die Destillation direkt von DeepSeek-R1 die Anwendung von RL darauf, was darauf hindeutet, dass die im größeren Basismodell gefundenen Inferenzmuster für die Verbesserung der Inferenz entscheidend sind. Wir stellen die Qwen- und Llama-Modellfamilie (Dubey et al., 2024) für die Destillation als Open Source zur Verfügung. Bemerkenswert ist, dass unser destilliertes 14B-Modell das hochmoderne Open-Source-Modell QwQ-32B-Preview (Qwen, 2024a) erheblich übertrifft und die destillierten 32B- und 70B-Modelle einen neuen Rekord für Schlussfolgerungsbenchmarks in dichten Modellen aufstellen.

1.1 Beiträge

Post-Training: Verstärkungslernen im großen Maßstab auf der Grundlage von Basismodellen

- Wir wenden Reinforcement Learning (RL) direkt auf das zugrundeliegende Modell an, ohne auf Supervised Fine-Tuning (SFT) als vorbereitenden Schritt zurückzugreifen. Dieser Ansatz ermöglicht es dem Modell, die Chain of Thought (CoT) zur Lösung komplexer Probleme zu erforschen, was zur Entwicklung von DeepSeek-R1-Zero führt. DeepSeek-R1-Zero demonstriert die Fähigkeit, die CoT selbst zu validieren, zu reflektieren und zu erweitern, was einen wichtigen Meilenstein für die Forschungsgemeinschaft darstellt. Dies ist ein wichtiger Meilenstein für die Forschungsgemeinschaft. Insbesondere ist dies die erste öffentliche Studie, die bestätigt, dass die Argumentationsfähigkeit von LLM durch reine RL motiviert werden kann, ohne dass SFT erforderlich ist.

- Wir beschreiben den Prozess, der zur Entwicklung von DeepSeek-R1 verwendet wurde. Der Prozess besteht aus zwei RL-Phasen, die darauf abzielen, verbesserte Argumentationsmuster zu entdecken und sie mit menschlichen Präferenzen abzugleichen, und zwei SFT-Phasen, die als Grundlage für die Argumentations- und Nicht-Reasoning-Fähigkeiten des Modells dienen. Wir glauben, dass dieser Prozess der Industrie durch die Entwicklung besserer Modelle zugute kommen wird.

Destillation: Kleine Modelle können mächtig sein

- Wir zeigen, dass Inferenzmuster aus großen Modellen in kleinere Modelle destilliert werden können, um eine bessere Leistung im Vergleich zu Inferenzmustern zu erzielen, die mittels RL auf kleinen Modellen entdeckt wurden. Das quelloffene DeepSeek-R1 und seine API werden der Forschungsgemeinschaft bei der Destillation besserer kleiner Modelle in der Zukunft von Nutzen sein.

- Anhand der von DeepSeek-R1 generierten Inferenzdaten haben wir mehrere dichte Modelle, die in der Forschungsgemeinschaft weit verbreitet sind, feinabgestimmt. Die Evaluierungsergebnisse zeigen, dass die destillierten kleinen dichten Modelle in Benchmarks gut abschneiden.DeepSeek-R1-Distill-Qwen-7B erreicht eine Punktzahl von 55,51 TP3T auf AIME 2024 und übertrifft damit QwQ-32B-Preview.Darüber hinaus erreicht DeepSeek-R1-Distill-Qwen-32B 72.6% auf AIME 2024, 94.3% auf MATH-500 und 57.2% auf LiveCodeBench. Diese Ergebnisse sind deutlich besser als frühere Open-Source-Modelle und vergleichbar mit o1-mini. Wir haben die Destillationsprüfpunkte 1.5B, 7B, 8B, 14B, 32B und 70B, die auf den Serien Qwen2.5 und Llama3 basieren, für die Community freigegeben.

1.2 Zusammenfassung der Bewertungsergebnisse

- Inferenzaufgaben:(1) DeepSeek-R1 erreichte bei AIME 2024 eine pass@1-Punktzahl von 79,81 TP3T und übertraf damit OpenAI-o1-1217 leicht. Bei MATH-500 erreichte es eine beeindruckende Punktzahl von 97,31 TP3T, die mit der Leistung von OpenAI-o1-1217 vergleichbar und deutlich besser als andere Modelle. (2) Bei kodierungsbezogenen Aufgaben zeigte DeepSeek-R1 Expertenniveau in der Codewettbewerbsaufgabe, da es eine 2.029 Elo-Bewertung bei Codeforces erreichte und damit den menschlichen Teilnehmer mit 96,31 TP3T übertraf. Bei ingenieurwissenschaftlichen Aufgaben schnitt DeepSeek-R1 etwas besser ab als DeepSeek-V3, der Entwicklern bei der Arbeit in der realen Welt hilft.

- **** Wissen: Bei Benchmarks wie MMLU, MMLU-Pro und GPQA Diamond erzielt DeepSeek-R1 exzellente Ergebnisse, die deutlich über denen von DeepSeek-V3 liegen: 90,8% bei MMLU, 84,0% bei MMLU-Pro und GPQA Diamond erzielt 71,5%. Obwohl seine Leistung bei diesen Benchmarks etwas geringer ist als die von OpenAI-01-1217, übertrifft DeepSeek-R1 die anderen Closed-Source-Modelle und zeigt damit seinen Wettbewerbsvorteil bei Bildungsaufgaben. Beim Fakten-Benchmark SimpleQA übertrifft DeepSeek-R1 DeepSeek-V3, was seine Fähigkeit zur Bearbeitung faktenbasierter Abfragen unter Beweis stellt. Ein ähnlicher Trend ist bei OpenAI-o1 über 4o für diesen Benchmark zu beobachten.

- Sonstiges: DeepSeek-R1 schnitt auch bei einer Vielzahl von Aufgaben gut ab, darunter kreatives Schreiben, Beantworten allgemeiner Fragen, Bearbeiten, Zusammenfassen und mehr. Er erreichte eine Längenkontroll-Gewinnrate von 87,61 TP3T auf AlpacaEval 2.0 und 92,31 TP3T auf ArenaHard, was seine starke Fähigkeit zur intelligenten Verarbeitung von nicht prüfungsorientierten Anfragen beweist. Darüber hinaus schneidet DeepSeek-R1 bei Aufgaben, die ein langes Kontextverständnis erfordern, gut ab und übertrifft DeepSeek-V3 im Long Context Benchmark Test deutlich.

2. die Methodik

2.1 Überblick

Frühere Arbeiten haben sich stark auf große Mengen an überwachten Daten gestützt, um die Modellleistung zu verbessern. In dieser Studie zeigen wir, dass die Inferenz durch großangelegtes Reinforcement Learning (RL) signifikant verbessert werden kann, auch ohne die Verwendung von überwachtem Fine-Tuning (SFT) als Kaltstart. Darüber hinaus kann die Leistung durch die Einbeziehung einer kleinen Menge von Kaltstartdaten weiter verbessert werden. In den folgenden Abschnitten stellen wir (1) DeepSeek-R1-Zero vor, das RL direkt auf das Basismodell ohne SFT-Daten anwendet, und (2) DeepSeek-R1, das RL ausgehend von Checkpoints anwendet, die mit Tausenden von langen Chain of Thoughts (CoT)-Beispielen feinabgestimmt wurden. und (3) die Destillation der Inferenzfähigkeiten von DeepSeek-R1 in kleine dichte Modelle.

2.2 DeepSeek-R1-Zero: Verstärkungslernen auf der Grundlage grundlegender Modelle

Verstärkungslernen hat sich bei Inferenzaufgaben als sehr effektiv erwiesen, wie in unseren früheren Arbeiten gezeigt wurde (Shao et al., 2024; Wang et al., 2023). Allerdings sind diese Aufgaben stark auf überwachte Daten angewiesen, deren Erhebung zeitaufwändig ist. In diesem Abschnitt untersuchen wir das Potenzial von LLM zur Entwicklung von Denkfähigkeiten ohne überwachte Daten und konzentrieren uns auf die Selbstentwicklung durch einen reinen Verstärkungslernprozess. Wir beginnen mit einem kurzen Überblick über unseren Reinforcement-Learning-Algorithmus und stellen dann einige spannende Ergebnisse vor, von denen wir hoffen, dass sie der Community wertvolle Erkenntnisse liefern.

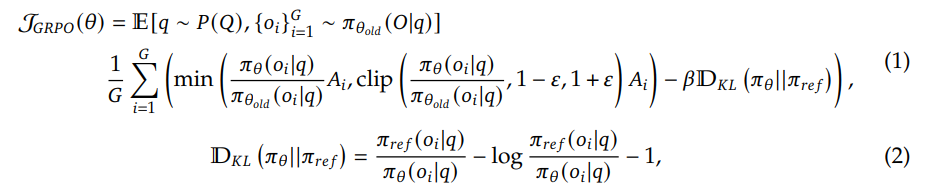

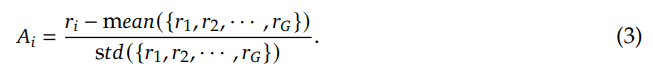

Gruppenrelative Strategieoptimierung Um die Trainingskosten von RL einzusparen, verwenden wir die gruppenrelative Strategieoptimierung (GRPO) (Shao et al., 2024), die das kritische Modell, das in der Regel die gleiche Größe wie das Strategiemodell hat, aufgibt und stattdessen die Basislinie aus den Gruppenergebnissen schätzt. Genauer gesagt, nimmt GRPO für jedes Problem q eine Stichprobe von Outputs {o1, o2,..., oG} aus der alten Strategie πθold und optimiert dann das Strategiemodell πθ durch Maximierung des folgenden Ziels:

wobei ɛ und β Hyperparameter sind und Ai die Dominanz ist, unter Verwendung der Belohnungen, die den Ausgängen innerhalb jeder Gruppe {r1,r2, . . . , rG} für die Berechnung:

Die Belohnung ist die Quelle des Trainingssignals, das die Optimierungsrichtung von RL bestimmt. Um DeepSeek-R1-Zero zu trainieren, verwenden wir ein regelbasiertes Belohnungssystem, das aus den folgenden zwei Haupttypen von Belohnungen besteht:

- Genauigkeitsbelohnungen: Genauigkeitsbelohnungsmodelle bewerten, ob eine Antwort richtig ist. Bei Mathematikaufgaben mit deterministischen Ergebnissen muss das Modell beispielsweise die endgültige Antwort in einem bestimmten Format (z. B. in einem Kasten) bereitstellen, damit eine regelbasierte Korrektheitsprüfung zuverlässig durchgeführt werden kann. In ähnlicher Weise kann der Compiler bei LeetCode-Problemen verwendet werden, um Rückmeldungen auf der Grundlage vordefinierter Testfälle zu erzeugen.

- Format-Belohnung: Zusätzlich zum Modell für die Genauigkeits-Belohnung haben wir ein Modell für die Format-Belohnung verwendet, das das Modell zwingt, den Denkprozess zwischen den Markierungen '' und '' zu platzieren.

Wir haben bei der Entwicklung von DeepSeek-R1-Zero keine neuronalen Ergebnis- oder Prozessbelohnungsmodelle verwendet, weil wir festgestellt haben, dass neuronale Belohnungsmodelle während des groß angelegten Verstärkungslernens unter Belohnungshacking leiden können und dass das Neutrainieren des Belohnungsmodells zusätzliche Trainingsressourcen erfordert, was den gesamten Trainingsprozess verkomplizieren kann.

Um DeepSeek-R1-Zero zu trainieren, haben wir zunächst eine einfache Vorlage entworfen, die das Basismodell anweist, die von uns angegebenen Anweisungen zu befolgen. Wie in Tabelle 1 dargestellt, verlangt diese Vorlage, dass DeepSeek-R1-Zero zuerst den Argumentationsprozess und dann die endgültige Antwort generiert. Wir haben die Einschränkungen absichtlich auf dieses strukturelle Format beschränkt, um jegliche inhaltsspezifischen Verzerrungen zu vermeiden, wie z. B. die Erzwingung von reflektierendem Denken oder die Förderung spezifischer Problemlösungsstrategien, um sicherzustellen, dass wir die natürliche Progression des Modells durch den Prozess des verstärkten Lernens (Reinforcement Learning, RL) genau beobachten können.

Ein Dialog zwischen dem Benutzer und dem Assistenten. Der Benutzer stellt eine Frage und der Assistent löst die Frage.

Der Assistent denkt zunächst über den Denkprozess in seinem Kopf nach und gibt dann dem Benutzer die Antwort.

Der Denkprozess und die Antwort werden in die Tags und eingeschlossen, d.h.:

Hier ist der Argumentationsprozess </think

Hier ist die Antwort .

Benutzer:auf etw. aufmerksam machen. Assistentin:

Tabelle 1 | Vorlagen für DeepSeek-R1-Zero. Während des Trainings werden dieauf etw. aufmerksam machenwird durch ein spezifisches Argumentationsproblem ersetzt.

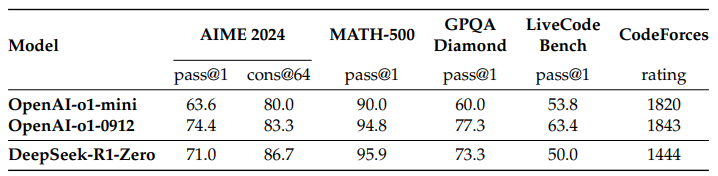

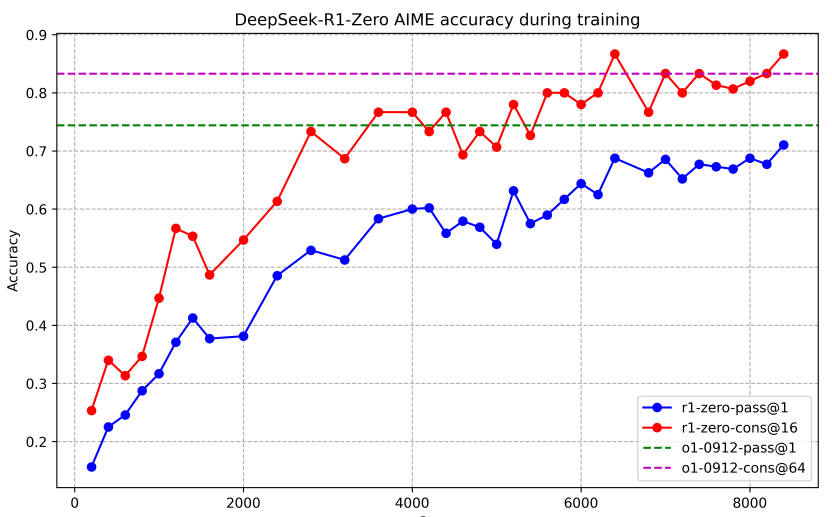

Leistung von DeepSeek-R1-Zero Abbildung 2 zeigt den Leistungsverlauf von DeepSeek-R1-Zero auf dem AIME 2024 Benchmark während des Reinforcement Learning (RL) Trainings. Wie gezeigt, zeigt die Leistung von DeepSeek-R1-Zero eine stetige und konsistente Verbesserung während des RL-Trainings. Insbesondere der durchschnittliche pass@1-Score des AIME 2024 zeigt ein signifikantes Wachstum und springt von anfänglichen 15,61 TP3T auf beeindruckende 71,01 TP3T und erreicht damit ein Leistungsniveau, das mit OpenAI-01-0912 vergleichbar ist. Diese signifikante Verbesserung unterstreicht die Wirksamkeit unseres RL-Algorithmus bei der Optimierung der Modellleistung.

Tabelle 2 zeigt eine vergleichende Analyse von DeepSeek-R1-Zero und dem Modell o1-0912 von OpenAI bei verschiedenen inferenzbezogenen Benchmarks. Die Ergebnisse zeigen, dass RL die

Tabelle 2 | Vergleich von DeepSeek-R1-Zero und OpenAI o1 Modellen bei inferenzbezogenen Benchmarks.

Abb. 2 | AIME Genauigkeit von DeepSeek-R1-Zero während des Trainings. Für jedes Problem wurden 16 Antworten abgetastet und die durchschnittliche Gesamtgenauigkeit berechnet, um eine stabile Auswertung zu gewährleisten.

DeepSeek-R1-Zero erzielt leistungsstarke Inferenzen ohne überwachte Feinabstimmung der Daten. Dies ist eine bemerkenswerte Leistung, da sie die Fähigkeit des Modells unterstreicht, allein durch RL effektiv zu lernen und zu generalisieren. Darüber hinaus kann die Leistung von DeepSeek-R1-Zero durch Anwendung von Mehrheitsentscheidungen weiter verbessert werden. Beispielsweise verbessert sich die Leistung von DeepSeek-R1-Zero bei Verwendung von Mehrheitsentscheidungen im AIME-Benchmark von 71,01 TP3T auf 86,71 TP3T und übertrifft damit die Leistung von OpenAI-01-0912.DeepSeek-R1-Zero erreicht eine derart konkurrenzfähige Leistung mit und ohne Mehrheitsentscheidungen, was Dies unterstreicht seine starken grundlegenden Fähigkeiten und sein Potenzial für die weitere Entwicklung bei logischen Aufgaben.

DeepSeek-R1-Zero's Self-Evolutionary Process DeepSeek-R1-Zero's self-evolutionary process ist eine faszinierende Demonstration, wie RL Modelle dazu bringen kann, ihre Argumentation autonom zu verbessern. Indem wir RL direkt vom Basismodell aus starten, können wir den Fortschritt des Modells genau beobachten, ohne eine überwachte Feinabstimmungsphase durchlaufen zu müssen. Dieser Ansatz bietet einen klaren Überblick darüber, wie sich das Modell im Laufe der Zeit entwickelt, insbesondere im Hinblick auf seine Fähigkeit, komplexe Argumentationsaufgaben zu bewältigen.

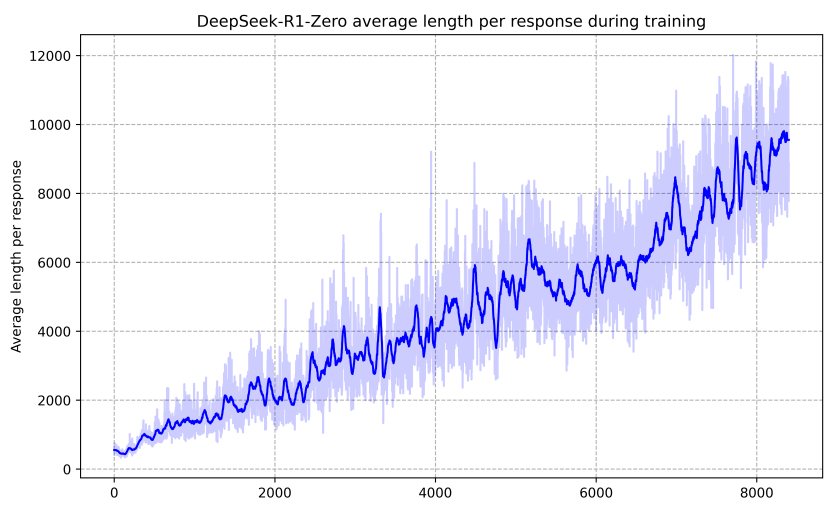

Wie in Abbildung 3 dargestellt, verbessert sich die Denkzeit von DeepSeek-R1-Zero während des gesamten Trainingsprozesses kontinuierlich. DeepSeek-R1-Zero gewinnt auf natürliche Weise die Fähigkeit, immer komplexere Denkaufgaben zu lösen, indem es erweiterte Testzeitberechnungen einsetzt. Diese Berechnungen reichen von der Generierung hunderter bis tausender Inferenz-Token, was dem Modell erlaubt, seine Denkprozesse in größerer Tiefe zu erforschen und zu verfeinern.

Einer der auffälligsten Aspekte dieser Selbstevolution ist das Auftreten komplexer Verhaltensweisen mit zunehmender Rechenleistung während der Tests. Reflexion - d. h. das Modell überprüft und bewertet seine vorherigen Schritte neu - sowie die Erkundung alternativer Problemlösungsansätze treten spontan auf. Diese Verhaltensweisen sind nicht explizit programmiert, sondern ergeben sich aus der Interaktion des Modells mit der Verstärkungslernumgebung. Diese spontane Entwicklung verbessert die Denkfähigkeiten von DeepSeek-R1-Zero erheblich und ermöglicht es ihm, anspruchsvollere Aufgaben mit größerer Effizienz und Genauigkeit zu bewältigen.

Abb. 3 | Durchschnittliche Antwortlänge von DeepSeek-R1-Zero auf der RL-Prozess-Trainingsmenge.DeepSeek-R1-Zero lernt auf natürliche Weise, Inferenzaufgaben zu lösen, indem es mehr Denkzeit benötigt.

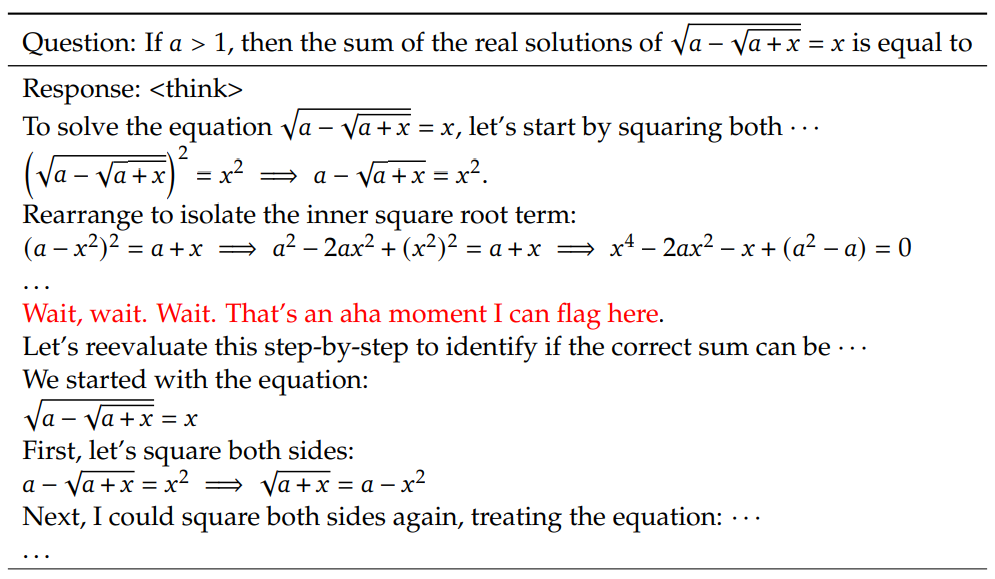

Epiphanie-Momente in DeepSeek-R1-Zero Ein besonders interessantes Phänomen, das während des Trainings von DeepSeek-R1-Zero beobachtet wurde, ist das Auftreten von "Epiphanie-Momenten". Wie in Tabelle 3 dargestellt, treten diese Momente in der Zwischenversion des Modells auf. In diesem Stadium lernt DeepSeek-R1-Zero, dem Problem mehr Denkzeit zu widmen, indem es seinen ursprünglichen Ansatz neu bewertet. Dieses Verhalten ist nicht nur ein Beweis für die wachsenden Inferenzfähigkeiten des Modells, sondern auch ein faszinierendes Beispiel dafür, wie Verstärkungslernen zu unerwarteten und komplexen Ergebnissen führen kann.

Tabelle 3 | Ein interessanter "Erleuchtungsmoment" in der Zwischenversion von DeepSeek-R1-Zero. Das Modell lernt, in einem anthropomorphen Tonfall umzudenken. Dies war auch unser eigener Aha-Moment, der uns die Macht und Schönheit des Verstärkungslernens vor Augen führte.

Dieser Moment war eine "Offenbarung" nicht nur für das Modell, sondern auch für die Forscher, die sein Verhalten beobachteten. Er unterstreicht die Macht und Schönheit des Verstärkungslernens: Anstatt einem Modell explizit beizubringen, wie es ein Problem zu lösen hat, geben wir ihm einfach die richtigen Anreize, und es entwickelt selbstständig fortgeschrittene Problemlösungsstrategien. Der "Moment der Erleuchtung" ist ein deutlicher Hinweis auf das Potenzial von RL, neue Ebenen der Intelligenz in KI-Systemen zu erschließen und den Weg für autonomere und adaptive Modelle in der Zukunft zu ebnen.

Nachteile von DeepSeek-R1-Zero Obwohl DeepSeek-R1-Zero über starke logische Fähigkeiten verfügt und eigenständig unerwartete und leistungsstarke logische Verhaltensweisen entwickelt, gibt es auch einige Probleme. Zum Beispiel kämpft DeepSeek-R1-Zero mit schlechter Lesbarkeit und Sprachmischung. Um den Schlussfolgerungsprozess besser lesbar zu machen und ihn mit der offenen Gemeinschaft zu teilen, haben wir DeepSeek-R1 erforscht, einen Ansatz, der RL mit menschenfreundlichen Kaltstartdaten nutzt.

2.3 DeepSeek-R1: Reinforcement Learning mit einem Kaltstart

Inspiriert von den vielversprechenden Ergebnissen von DeepSeek-R1-Zero stellen sich zwei Fragen: 1) Kann die Inferenzleistung weiter verbessert oder die Konvergenz beschleunigt werden, indem eine kleine Menge hochwertiger Daten als Kaltstart verwendet wird? und 2) Wie können wir ein benutzerfreundliches Modell trainieren, das nicht nur klare und kohärente Chains of Thought (CoTs) erzeugt, sondern auch starke Generalisierungsfähigkeiten aufweist? Um diese Fragen zu beantworten, haben wir einen Prozess für das Training von DeepSeek-R1 entwickelt. Der Prozess besteht aus vier Phasen, die im Folgenden beschrieben werden.

Im Gegensatz zu DeepSeek-R1-Zero haben wir für DeepSeek-R1 eine kleine Menge langer CoT-Daten zur Feinabstimmung des Modells als anfänglicher RL-Teilnehmer erstellt und gesammelt, um eine frühe instabile Kaltstartphase zu verhindern, wenn das RL-Training mit dem Basismodell beginnt. Um solche Daten zu sammeln, untersuchten wir mehrere Ansätze: die Verwendung von Prompts mit wenigen Beispielen und langen CoTs, die direkte Aufforderung an das Modell, detaillierte Antworten mit Reflexion und Validierung zu generieren, die Sammlung von DeepSeek-R1-Zero-Ausgaben in einem lesbaren Format und die Nachbearbeitung der Ergebnisse durch menschliche Annotatoren.

In dieser Arbeit haben wir Tausende von Kaltstartdaten gesammelt, um DeepSeek-V3-Base als Ausgangspunkt für RL fein abzustimmen. Zu den Vorteilen von Kaltstartdaten gegenüber DeepSeek-R1-Zero gehören:

- Lesbarkeit: Eine wesentliche Einschränkung von DeepSeek-R1-Zero ist, dass der Inhalt oft nicht lesbar ist. In den Antworten können mehrere Sprachen gemischt sein, oder es fehlt die Formatierung, um die Antworten des Benutzers hervorzuheben. Stattdessen haben wir bei der Erstellung von Kaltstartdaten für DeepSeek-R1 ein lesbares Schema entwickelt, das eine Zusammenfassung am Ende jeder Antwort enthält und Antworten herausfiltert, die nicht leicht lesbar sind. Hier definieren wir das Ausgabeformat als | special_token | | special_token |

, wobei der reasoning process der CoT der Abfrage ist und die Zusammenfassung dazu dient, die Ergebnisse der Argumentation zusammenzufassen. - Potenzial: Durch die Verwendung eines menschlichen Vorgängers zur Erstellung eines Modells für Kaltstartdaten beobachten wir eine bessere Leistung gegenüber DeepSeek-R1-Zero. Wir argumentieren, dass iteratives Training ein besserer Weg ist, um über Modelle nachzudenken.

Nach der Feinabstimmung von DeepSeek-V3-Base anhand von Kaltstartdaten wendeten wir denselben groß angelegten Trainingsprozess für das Verstärkungslernen an wie bei DeepSeek-R1-Zero. Der Schwerpunkt dieser Phase lag auf der Verbesserung der Inferenzfähigkeiten des Modells, insbesondere bei Aufgaben, die Inferenzen erfordern, wie z. B. Codierung, mathematisches, wissenschaftliches und logisches Denken mit expliziten Fragen. Während des Trainingsprozesses stellten wir fest, dass das CoT häufig Sprachmischungen aufweist, insbesondere wenn die RL-Hinweise mehrere Sprachen umfassen. Um das Problem der Sprachmischung zu entschärfen, führten wir während des RL-Trainings eine Belohnung für sprachliche Konsistenz ein, die als Anteil der Wörter in der Zielsprache im CoT berechnet wurde. Obwohl Ablationsexperimente zeigen, dass diese Anpassung zu einer leichten Verschlechterung der Modellleistung führt, entspricht diese Belohnung den menschlichen Präferenzen und macht sie verständlicher. Schließlich kombinieren wir die Belohnungen für Genauigkeit und sprachliche Konsistenz in der Schlussfolgerungsaufgabe, indem wir sie direkt addieren, um die endgültige Belohnung zu bilden. Anschließend wird das fein abgestimmte Modell mit Reinforcement Learning (RL) trainiert, bis es bei der Inferenzaufgabe konvergiert.

Wenn die schlussfolgernde RL konvergiert, verwenden wir die erzeugten Kontrollpunkte, um SFT-Daten (supervised fine-tuning) für die nachfolgenden Runden zu sammeln. Im Gegensatz zu den anfänglichen Kaltstartdaten, die sich in erster Linie auf das schlussfolgernde Denken konzentrieren, werden in dieser Phase Daten aus anderen Domänen einbezogen, um die Fähigkeiten des Modells beim Schreiben, bei Rollenspielen und anderen allgemeinen Aufgaben zu verbessern. Im Einzelnen haben wir Daten generiert und das Modell wie unten beschrieben feinabgestimmt.

Schlussfolgerungsdaten Wir kuratierten Schlussfolgerungshinweise und generierten Schlussfolgerungstrajektorien, indem wir aus den oben beschriebenen RL-trainierten Kontrollpunkten ein Rejection Sampling durchführten. In der vorangegangenen Phase haben wir nur Daten einbezogen, die mit regelbasierten Belohnungen bewertet werden konnten. In dieser Phase erweitern wir jedoch den Datensatz, indem wir mehr Daten kombinieren, von denen einige generative Belohnungsmodelle verwenden, indem wir echte Beschriftungen und Modellvorhersagen zur Beurteilung in DeepSeek-V3 einspeisen. Da die Modellausgabe manchmal verwirrend und schwer zu lesen ist, haben wir außerdem Gedankenketten mit gemischter Sprache, langen Absätzen und Code-Blöcken herausgefiltert. Für jeden Hinweis haben wir mehrere Antworten erfasst und nur die richtige Antwort gespeichert. Insgesamt sammelten wir etwa 600.000 Trainingsbeispiele für die Argumentation.

Nicht-vernünftige Daten Für nicht-vernünftige Daten, wie z. B. Schreiben, Faktenquiz, Selbsterkenntnis und Übersetzung, verwenden wir den DeepSeek-V3-Prozess und greifen auf Teile des SFT-Datensatzes von DeepSeek-V3 zurück. Bei bestimmten Aufgaben, bei denen es sich nicht um Denkaufgaben handelt, rufen wir DeepSeek-V3 auf, um potenzielle Gedankenketten zu generieren, indem wir vor der Beantwortung einer Frage nachfragen. Für einfache Abfragen (z. B. "Hallo") stellen wir jedoch keine CoTs in den Antworten zur Verfügung. Schließlich sammeln wir insgesamt etwa 200.000 Trainingsbeispiele, die nicht mit Inferenz verbunden sind.

Wir haben DeepSeek-V3-Base für zwei Perioden mit dem oben genannten kuratierten Datensatz von etwa 800.000 Proben feinabgestimmt.

Um das Modell weiter an die menschlichen Präferenzen anzupassen, haben wir eine zweite Phase des Verstärkungslernens implementiert, die darauf abzielt, die Nützlichkeit und Harmlosigkeit des Modells zu erhöhen und gleichzeitig seine Argumentationsfähigkeit kontinuierlich zu verbessern. Konkret trainieren wir das Modell mit einer Kombination aus Belohnungssignalen und verschiedenen Cue-Verteilungen. Für Inferenzdaten halten wir uns an den in DeepSeek-R1-Zero beschriebenen Ansatz, der regelbasierte Belohnungen verwendet, um den Lernprozess in den Bereichen des mathematischen, kodierenden und logischen Denkens zu steuern. Bei allgemeinen Daten verlassen wir uns auf Belohnungsmodelle, um menschliche Präferenzen in komplexen und detaillierten Szenarien zu erfassen. Wir bauen auf dem DeepSeek-V3-Verfahren auf und verwenden ähnliche Präferenzpaare und Trainings-Cue-Verteilungen. Um hilfreich zu sein, konzentrieren wir uns ausschließlich auf die abschließende Zusammenfassung und stellen sicher, dass die Bewertung die Nützlichkeit und Relevanz der Antwort für den Nutzer hervorhebt, während wir gleichzeitig die Beeinträchtigung des zugrundeliegenden Argumentationsprozesses minimieren. Um die Unbedenklichkeit zu gewährleisten, bewerten wir die gesamte Antwort des Modells, einschließlich des Argumentationsprozesses und der Zusammenfassung, um potenzielle Risiken, Verzerrungen oder schädliche Inhalte, die während des Generierungsprozesses entstanden sein könnten, zu identifizieren und zu entschärfen. Die Integration von Belohnungssignalen und verschiedenen Datenverteilungen ermöglicht es uns, ein Modell zu trainieren, das hervorragende Schlussfolgerungen zieht und sowohl die Nützlichkeit als auch die Unbedenklichkeit priorisiert.

2.4 Destillation: Erweiterung kleiner Modelle um die Fähigkeit zur Schlussfolgerung

Um kleine Modelle mit Inferenzfähigkeiten wie DeepSeek-R1 effizienter zu machen, haben wir Open-Source-Modelle wie Qwen (Qwen, 2024b) und Llama (AI@Meta, 2024) unter Verwendung der 800.000 von DeepSeek-R1 gesammelten Stichproben direkt feinabgestimmt (wie in Abschnitt 2.3.3 beschrieben). Unsere Ergebnisse deuten darauf hin, dass diese einfache Destillationsmethode die Inferenz von kleinen Modellen erheblich verbessern kann. Die hier verwendeten Basismodelle sind Qwen2.5-Math-1.5B, Qwen2.5-Math-7B, Qwen2.5-14B, Qwen2.5-32B, Llama-3.1-8B und Llama-3.3-70B-Instruct. Wir haben uns für Llama-3.3 entschieden, weil es eine etwas bessere Schlussfolgerungsfähigkeit hat als Llama-3.1.

Für das Destillationsmodell verwenden wir nur die SFT und lassen die RL-Phase außer Acht, obwohl die Zusammenführung von RL die Modellleistung erheblich verbessern kann. Unser Hauptziel ist es hier, die Wirksamkeit der Destillationstechnik zu demonstrieren, und die Erforschung der RL-Phase der breiteren Forschungsgemeinschaft zu überlassen.

3 Experimente

Benchmarking Wir haben die Ergebnisse in MMLU (Hendrycks et al., 2020), MMLU-Redux (Gema et al., 2024), MMLU-Pro (Wang et al., 2024), C-Eval (Huang et al., 2023), und CMMLU (Li et al., 2023), IFEval (Zhou et al., 2023), FRAMES (Krishna et al., 2024), GPQA Diamond (OpenAI Diamond) (Rein et al., 2023), und IFEval (Zhou et al., 2023), FRAMES (Krishna et al., 2024), GPQA Diamond (Rein et al., 2023), SimpleQA (OpenAI, 2024c), C-SimpleQA (He et al., 2024), SWE- Bench Verified (OpenAI, 2024d), Aider¹ , LiveCodeBench (Jain et al., 2024) (2024-08 - 2025-01), Codeforces², Chinese National High School Mathematics Olympiad (CNHSMOA) School Mathematics Olympiad (CNMO 2024)³, und American Invitational Mathematics Examination 2024 (AIME 2024) (MAA, 2024). Zusätzlich zu den Standard-Benchmark-Tests verwenden wir LLM als Jury, um die Leistung unserer Modelle bei offenen generativen Aufgaben zu bewerten. Konkret folgen wir den ursprünglichen Konfigurationen von AlpacaEval 2.0 (Dubois et al., 2024) und Arena-Hard (Li et al., 2024), die GPT-4-Turbo-1106 als Jury für paarweise Vergleiche verwenden. Wir stellen hier nur die endgültigen Zusammenfassungen zur Bewertung bereit, um Längenverzerrungen zu vermeiden. Für Destillationsmodelle berichten wir über repräsentative Ergebnisse auf AIME 2024, MATH-500, GPQA Diamond, Codeforces und LiveCodeBench.

Tipps zur Bewertung In Anlehnung an die Einrichtung in DeepSeek-V3 werden Standard-Benchmarks wie MMLU, DROP, GPQA Diamond und SimpleQA mit Prompts aus dem Simple-Evals-Framework bewertet. Für MMLU-Redux verwenden wir das Zero-Eval-Prompt-Format (Lin, 2024) in der Null-Stichproben-Einstellung. Für MMLU-Pro, C-Eval und CLUE-WSC haben wir die Prompts leicht an die Null-Stichproben-Einstellung angepasst, da die Original-Prompts unterabgetastet waren. CoT in wenigen Stichproben kann die Leistung von DeepSeek-R1 beeinträchtigen. Die anderen Datensätze folgen dem Original-Evaluierungsprotokoll mit Standardhinweisen, die von ihren Erstellern bereitgestellt wurden. Für Code- und Mathematik-Benchmarking deckt der HumanEval-Mul-Datensatz acht wichtige Programmiersprachen ab (Python, Java, C++, C#, JavaScript, TypeScript, PHP und Bash). Die Leistung des Modells auf LiveCodeBench wird im CoT-Format bewertet, wobei die Daten zwischen August 2024 und Januar 2025 gesammelt wurden. Der Codeforces-Datensatz wurde anhand von Fragen aus 10 Div.2-Wettbewerben sowie von Experten erstellten Testfällen ausgewertet, und anschließend wurden die erwarteten Bewertungen und Prozentsätze der Wettbewerber berechnet. Die Ergebnisse der SWE-Bench-Validierung wurden mithilfe eines agentenlosen Frameworks ermittelt (Xia et al., 2024). AIDER-bezogene Benchmarks wurden unter Verwendung des "diff"-Formats gemessen, und die DeepSeek-R1-Ausgabe wurde auf 32 768 Token pro Benchmark begrenzt.

Basislinie (in der geodätischen Vermessung) Wir führten umfassende Evaluierungen gegen mehrere leistungsstarke Baselines durch, darunter DeepSeek-V3, Claude-Sonnet-3.5-1022, GPT-40-0513, OpenAI-01-mini und OpenAI-01-1217. Aufgrund des schwierigen Zugangs zur OpenAI-01-1217-API in Festlandchina geben wir ihre Leistung auf der Grundlage offizieller Berichte an. Für das Destillationsmodell haben wir auch das Open-Source-Modell QwQ-32B-Preview (Qwen, 2024a) verglichen.

Einstellungen generieren Für alle unsere Modelle wird die maximale Generierungslänge auf 32.768 Token festgelegt. Für Benchmarks, die Stichproben erfordern, verwenden wir eine Temperatur von 0,6, einen Top-p-Wert von 0,95 und generieren 64 Antworten für jede Anfrage, um pass@1 zu schätzen.

3.1 DeepSeek-R1-Bewertung

Bei bildungsorientierten Wissensbenchmarks wie MMLU, MMLU-Pro und GPQA Diamond zeigt DeepSeek-R1 eine bessere Leistung als DeepSeek-V3. Diese Verbesserung ist vor allem auf die höhere Genauigkeit bei MINT-Problemen zurückzuführen, bei denen durch großangelegtes Reinforcement Learning (RL) erhebliche Gewinne erzielt werden. Darüber hinaus schneidet DeepSeek-R1 bei FRAMES, einer langen kontextabhängigen QA-Aufgabe, gut ab, was seine starken Fähigkeiten bei der Dokumentenanalyse unter Beweis stellt. Dies unterstreicht das Potenzial von Inferenzmodellen bei KI-gesteuerten Such- und Datenanalyseaufgaben. Beim faktenbasierten Benchmark SimpleQA übertrifft DeepSeek-R1 DeepSeek-V3 und zeigt damit seine Fähigkeit, faktenbasierte Abfragen zu bearbeiten. Ein ähnlicher Trend wurde beobachtet, als OpenAI-01 GPT-40 in diesem Benchmark übertraf. Allerdings schneidet DeepSeek-R1 beim chinesischen SimpleQA-Benchmark nicht so gut ab wie DeepSeek-V3, was vor allem auf seine Tendenz zurückzuführen ist, die Beantwortung bestimmter Abfragen nach einer sicheren RL zu verweigern. Ohne eine sichere RL kann DeepSeek-R1 eine Genauigkeit von mehr als 70% erreichen.

Tabelle 4 | Vergleich zwischen DeepSeek-R1 und anderen repräsentativen Modellen.

DeepSeek-R1 erzielte auch beeindruckende Ergebnisse beim IF-Eval, einem Benchmark-Test, mit dem die Fähigkeit eines Modells zur Befolgung von Formatanweisungen bewertet wird. Diese Verbesserungen könnten mit den Daten zur Befolgung von Anweisungen zusammenhängen, die in den letzten Phasen der überwachten Feinabstimmung (SFT) und des RL-Trainings enthalten sind. Darüber hinaus wurde eine überlegene Leistung bei AlpacaEval2.0 und ArenaHard beobachtet, was zeigt, dass DeepSeek-R1 bei Schreibaufgaben und der Beantwortung offener Fragen im Vorteil ist. Die deutlich bessere Leistung von DeepSeek-R1 gegenüber DeepSeek-V3 unterstreicht die Vorteile der Generalisierung von Large-Scale-RL, die nicht nur die Inferenz, sondern auch die Leistung über mehrere Domänen hinweg verbessert. Darüber hinaus generiert DeepSeek-R1 prägnante Zusammenfassungen, und der Durchschnitt auf ArenaHard Token von 689 und einen Durchschnitt von 2.218 Zeichen bei AlpacaEval 2.0. Dies zeigt, dass DeepSeek-R1 die Einführung von Längenverzerrungen während der GPT-basierten Bewertung vermeidet, was seine Robustheit über mehrere Aufgaben hinweg weiter festigt.

Bei mathematischen Aufgaben ist die Leistung von DeepSeek-R1 mit der von OpenAI-01-1217 vergleichbar und übertrifft die anderen Modelle deutlich. Ein ähnlicher Trend ist bei Codieralgorithmus-Aufgaben wie LiveCodeBench und Codeforces zu beobachten, bei denen inferenzzentrierte Modelle diese Benchmarks dominieren. Bei ingenieurwissenschaftlich orientierten Codierungsaufgaben übertrifft OpenAI-01-1217 DeepSeek-R1 bei Aider, erreicht aber eine vergleichbare Leistung bei SWE Verified. Wir glauben, dass die Leistung von DeepSeek-R1 für ingenieurwissenschaftliche Aufgaben in der nächsten Version verbessert werden wird, da die Menge an relevanten RL-Trainingsdaten zu diesem Zeitpunkt noch sehr begrenzt ist.

3.2 Bewertung der Destillationsmodellierung

Tabelle 5 | Vergleich des DeepSeek-R1-Destillationsmodells mit anderen Modellen, die mit dem Inferenzkorrelations-Benchmarktest vergleichbar sind.

Wie in Tabelle 5 gezeigt, ermöglicht die einfache Destillation der Ausgabe von DeepSeek-R1 dem effizienten DeepSeek-R1-7B (d. h. DeepSeek-R1-Distill-Qwen-7B, im Folgenden mit diesem Namen bezeichnet), Nicht-Inferenzmodelle wie GPT-40-0513 in jeder Hinsicht zu übertreffen. DeepSeek-R1-14B übertrifft QwQ-32B-Preview in allen Bewertungsmetriken, während DeepSeek-R1-32B und DeepSeek-R1-70B o1-mini in den meisten Benchmarks deutlich übertreffen. Diese Ergebnisse zeigen das große Potenzial von Distill. Darüber hinaus stellen wir fest, dass die Anwendung von RL auf diese Destillationsmodelle zu erheblichen weiteren Verbesserungen führt. Wir glauben, dass es sich lohnt, dies weiter zu untersuchen, und präsentieren daher hier nur Ergebnisse für das einfache SFT-Destillationsmodell.

4. die Diskussion

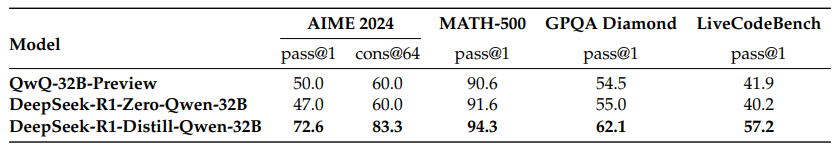

4.1 Destillation vs. intensives Lernen

Tabelle 6 | Vergleich zwischen dem Destillationsmodell und dem RL-Modell beim Benchmark der Inferenzkorrelation.

In Abschnitt 3.2 haben wir gesehen, dass kleine Modelle durch die Destillation von DeepSeek-R1 beeindruckende Ergebnisse erzielen können. Es bleibt jedoch eine Frage offen: Können Modelle mit der in dieser Arbeit diskutierten groß angelegten RL (ohne Destillation) trainiert werden, um eine vergleichbare Leistung zu erzielen?

Um diese Frage zu beantworten, haben wir ein umfangreiches RL-Training von Qwen-32B-Base unter Verwendung von Mathematik-, Code- und STEM-Daten für mehr als 10.000 Schritte durchgeführt, was zu DeepSeek-R1-Zero-Qwen-32B führte. Die experimentellen Ergebnisse (siehe Abb. 6) zeigen, dass das 32B-Basismodell nach dem umfangreichen RL-Training eine Leistung erreicht, die mit der des QwQ-32B-Preview auf einem vergleichbaren Niveau. DeepSeek-R1-Distill-Qwen-32B, das aus DeepSeek-R1 destilliert wird, übertrifft jedoch DeepSeek-R1-Zero-Qwen-32B in allen Benchmarks deutlich. Daraus lassen sich zwei Schlussfolgerungen ziehen: Erstens führt die Destillation des leistungsfähigeren Modells in ein kleineres Modell zu hervorragenden Ergebnissen während kleinere Modelle, die sich auf die in dieser Arbeit erwähnten groß angelegten RLs stützen, enorme Rechenleistung benötigen und möglicherweise nicht einmal die Leistung der Destillation erreichen. Zweitens ist die Destillationsstrategie zwar sowohl kosteneffektiv als auch effizient, aber leistungsfähigere zugrundeliegende Modelle und Verstärkungslernen in größerem Maßstab können dennoch erforderlich sein, um die Grenzen der Intelligenz zu überschreiten.

4.2 Fehlgeschlagene Versuche

Während der frühen Entwicklungsphasen von DeepSeek-R1 sind wir auch auf einige Misserfolge und Rückschläge gestoßen. Wir teilen hier unsere Misserfolge mit, um Einblicke zu gewähren. Das bedeutet jedoch nicht, dass diese Methoden nicht in der Lage sind, effektive Inferenzmodelle zu entwickeln.

Prozess-Belohnungs-Modellierung (PRM) PRM ist eine sinnvolle Methode, um Modelle dazu anzuleiten, bessere Methoden zur Lösung von Denkaufgaben anzuwenden (Lightman et al., 2023; Uesato et al., 2022; Wang et al., 2023). In der Praxis gibt es jedoch drei Hauptbeschränkungen von PRM, die seinen letztendlichen Erfolg behindern können. Erstens ist es schwierig, feinkörnige Schritte in der allgemeinen Argumentation explizit zu definieren. Zweitens ist die Feststellung, ob der aktuelle Zwischenschritt korrekt ist, eine schwierige Aufgabe. Die automatische Annotation mit Hilfe von Modellen führt möglicherweise nicht zu befriedigenden Ergebnissen, und die manuelle Annotation ist der Skalierung nicht förderlich. Drittens führt die Einführung von modellbasiertem PRM unweigerlich zu Reward Hacking (Gao et al., 2022), und die Umschulung des Reward-Modells erfordert zusätzliche Trainingsressourcen, was den gesamten Trainingsprozess verkomplizieren kann. Zusammenfassend lässt sich sagen, dass PRM zwar eine gute Fähigkeit aufweist, modellgenerierte Top-N-Antworten neu zu ordnen oder bei der geführten Suche zu helfen (Snell et al., 2024), seine Vorteile jedoch begrenzt sind, wenn man sie mit dem zusätzlichen Rechenaufwand vergleicht, der durch das groß angelegte Verstärkungslernen in unseren Experimenten entsteht.

Monte-Carlo-Baumsuche (MCTS) Inspiriert von AlphaGo (Silver et al., 2017b) und AlphaZero (Silver et al., 2017a) untersuchten wir die Verwendung der Monte-Carlo-Baumsuche (MCTS), um die Skalierbarkeit der Berechnungen zur Testzeit zu verbessern. Bei diesem Ansatz wird die Antwort in kleinere Teile zerlegt, damit das Modell den Lösungsraum systematisch erkunden kann. Um dies zu erleichtern, fordern wir das Modell auf, mehrere Labels zu generieren, die den für die Suche erforderlichen spezifischen Inferenzschritten entsprechen. Für das Training verwenden wir zunächst die gesammelten Hinweise, um Antworten durch ein MCTS zu finden, das von einem vortrainierten Wertmodell geleitet wird. Anschließend verwenden wir die generierten Frage-Antwort-Paare, um das Akteursmodell und das Wertemodell zu trainieren und so den Prozess iterativ zu verbessern.

Allerdings stößt dieser Ansatz bei der Skalierung des Trainings auf mehrere Herausforderungen. Erstens: Im Gegensatz zum Schachspiel, bei dem der Suchraum relativ klar definiert ist, ist der Suchraum bei der Tokengenerierung exponentiell größer. Um dieses Problem zu lösen, setzen wir eine maximale Expansionsgrenze für jeden Knoten, aber dies kann dazu führen, dass das Modell in ein lokales Optimum fällt. Zweitens wirkt sich das Wertmodell direkt auf die Qualität der Generierung aus, da es jeden Schritt des Suchprozesses steuert. Das Training eines feinkörnigen Wertmodells ist von Natur aus schwierig, was eine iterative Verbesserung des Modells erschwert. Während der zentrale Erfolg von AlphaGo auf dem Training von Wertmodellen beruht, um seine Leistung inkrementell zu verbessern, ist dieses Prinzip aufgrund der Komplexität der Markergenerierung in unserer Umgebung schwer zu reproduzieren.

Zusammenfassend lässt sich sagen, dass MCTS zwar die Leistung während der Inferenz verbessern kann, wenn es mit vortrainierten Wertmodellen gepaart wird, die iterative Verbesserung der Modellleistung während der Selbstsuche jedoch eine schwierige Herausforderung bleibt.

5. schlussfolgerungen, einschränkungen und zukünftige arbeiten

DeepSeek-R1-Zero stellt einen reinen RL-Ansatz dar, der sich nicht auf Kaltstartdaten stützt und eine starke Leistung bei einer Vielzahl von Aufgaben erzielt. DeepSeek-R1 ist sogar noch leistungsfähiger, da es Kaltstartdaten und iterative RL-Feinabstimmung nutzt. Letztendlich erreicht DeepSeek-R1 eine mit OpenAI-01-1217 vergleichbare Leistung in einer Vielzahl von Aufgaben.

Wir haben weiter untersucht, wie wir die Argumentationskraft in kleine dichte Modelle destillieren können. Wir haben DeepSeek-R1 als Lehrermodell verwendet, um 800K Daten zu generieren und mehrere kleine dichte Modelle feinabzustimmen. Die Ergebnisse sind vielversprechend: DeepSeek-R1-Distill-Qwen-1.5B übertrifft GPT-40 und Claude-3.5-Sonnet im Mathe-Benchmarking-Test mit einer AIME-Punktzahl von 28.91 TP3T und einer MATH-Punktzahl von 83.91 TP3T.Die anderen dichten Modelle erzielen ebenfalls beeindruckende Ergebnisse, die deutlich besser sind als die andere Modelle zur Feinabstimmung von Anweisungen, die auf denselben zugrunde liegenden Prüfpunkten basieren.

Für die Zukunft planen wir, DeepSeek-R1 in den folgenden Bereichen zu untersuchen:

- Allgemeine Fähigkeiten: Derzeit ist DeepSeek-R1 bei Aufgaben wie Funktionsaufrufen, Dialogen mit mehreren Runden, komplexen Rollenspielen und JSON-Ausgaben weniger leistungsfähig als DeepSeek-V3. In Zukunft wollen wir untersuchen, wie lange CoTs genutzt werden können, um Aufgaben in diesen Bereichen zu erweitern.

- Sprachmischung: DeepSeek-R1 ist derzeit für Chinesisch und Englisch optimiert, was zu Sprachmischungsproblemen bei der Verarbeitung von Abfragen in anderen Sprachen führen kann. Zum Beispiel kann DeepSeek-R1 auf Englisch argumentieren und antworten, auch wenn die Anfrage in einer anderen Sprache als Englisch oder Chinesisch gestellt wird. Wir beabsichtigen, diese Einschränkung in einem zukünftigen Update zu beheben.

- Hinweis-Engineering: Bei der Bewertung von DeepSeek-R1 haben wir festgestellt, dass das Programm empfindlich auf Hinweise reagiert. Hinweise mit weniger Stichproben verschlechtern durchweg seine Leistung. Daher empfehlen wir, dass die Benutzer das Problem direkt beschreiben und das Ausgabeformat mit der Einstellung "Zero-Sample" angeben, um beste Ergebnisse zu erzielen.

- Software-Engineering-Aufgaben: Large-Scale-RL wurde aufgrund der langen Auswertungszeit, die die Effizienz des RL-Prozesses beeinträchtigt, noch nicht in großem Umfang auf Software-Engineering-Benchmarks angewandt, weshalb DeepSeek-R1 noch keine große Leistungssteigerung gegenüber DeepSeek-V3 gezeigt hat. Zukünftige Versionen werden dieses Problem angehen, indem sie Rejection Sampling auf Software-Engineering-Daten implementieren oder asynchrone Auswertungen in den RL-Prozess einbinden, um die Effizienz zu verbessern.