Stichworte: h100-Preisspitzen, subventionierte abgeleitete Preise, Exportkontrollen, MLAs

Die DeepSeek-Erzählung erobert die Welt im Sturm

DeepSeek Die Welt im Sturm erobern. Seit einer Woche ist DeepSeek das einzige Thema, über das jeder auf der Welt sprechen möchte. Derzeit hat DeepSeek täglich weit mehr Besucher als Claude, Perplexity oder sogar Gemini.

Aber für diejenigen, die das Thema aufmerksam verfolgen, sind dies nicht gerade "neue" Nachrichten. Wir sprechen nun schon seit Monaten über DeepSeek (jeder Link ist ein Beispiel). Das Unternehmen ist nicht neu, aber der Hype ist es, und SemiAnalysis hat lange argumentiert, dass DeepSeek sehr talentiert ist und dass die breite US-Öffentlichkeit sich nicht dafür interessiert. Als die Welt endlich aufmerksam wurde, geschah dies in einem rasenden Hype, der nicht der Realität entsprach.

Wir möchten betonen, dass sich diese Aussage im Vergleich zum letzten Monat geändert hat, als die Skalierungsgesetze gebrochen wurden und wir das Missverständnis ausgeräumt haben, dass sich die Algorithmen jetzt zu schnell verbessern, was in gewisser Weise auch schlecht für Nvidia und GPUs ist.

Hintergrund: 11. Dezember 2024 Skalierungsgesetze - O1 Pro-Architektur, Infrastruktur für Inferenztraining, Orion und Claude 3.5 Opus "Ausfälle"

Jetzt heißt es, dass DeepSeek so effizient ist, dass wir keine weiteren Berechnungen mehr brauchen, und dass es jetzt aufgrund der Modelländerungen bei allem eine enorme Überkapazität gibt. Während das Jevons-Paradoxon ebenfalls überbewertet wird, ist Jevons näher an der Realität, und diese Modelle haben eine Nachfrage ausgelöst, die sich spürbar auf die Preise des H100 und H200 ausgewirkt hat.

DeepSeek und Überflieger

High-Flyer ist ein chinesischer Hedgefonds, der schon früh KI in seinen Handelsalgorithmen eingesetzt hat. Das Unternehmen hat das Potenzial der KI außerhalb des Finanzbereichs und die wichtigen Erkenntnisse der Skalierung früh erkannt. Infolgedessen haben sie ihr GPU-Angebot erhöht. Nachdem sie mit Modellen experimentiert hatten, die Cluster mit Tausenden von Grafikprozessoren verwendeten, investierte High Flyer im Jahr 2021 * vor den Exportbeschränkungen in 10.000 A100-GPUs. * Das hat sich ausgezahlt. Als High-Flyer immer besser wurde, erkannte man, dass es an der Zeit war, "DeepSeek" im Mai 2023 auszugliedern, mit dem Ziel, weitere KI-Fähigkeiten in einer gezielteren Weise zu verfolgen. High-Flyer finanzierte das Unternehmen selbst, da das Interesse an KI zu dieser Zeit bei externen Investoren gering war, wobei das Fehlen eines Geschäftsmodells die Hauptsorge war. High-Flyer und DeepSeek teilen sich heute häufig Ressourcen, sowohl personelle als auch rechnerische.

DeepSeek hat sich inzwischen zu einem ernsthaften, gemeinschaftlichen Unternehmen entwickelt, das weit entfernt ist von dem "Nebenerwerb", als den es viele in den Medien bezeichnen. Wir glauben, dass die GPU-Investitionen über 500 Millionen Dollar betragen, selbst wenn man die Exportkontrollen berücksichtigt.

-

Quelle: SemiAnalysis, Lennart Heim.

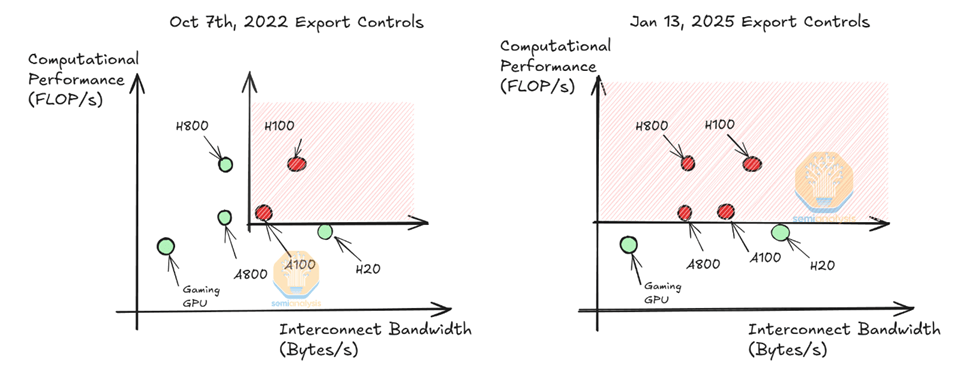

GPU-Situation

Wir glauben, dass sie etwa 50.000 brauchen könnten. Hopper GPUDies ist nicht dasselbe wie die 50.000 H100, die einige Leute behaupten. Nvidia stellt verschiedene Modelle der H100 her, um verschiedene Vorschriften zu erfüllen (H800, H20), und derzeit ist nur die H20 für Modellanbieter in China verfügbar. Beachten Sie, dass der H800 die gleiche Rechenleistung wie der H100 hat, jedoch mit einer geringeren Netzwerkbandbreite.

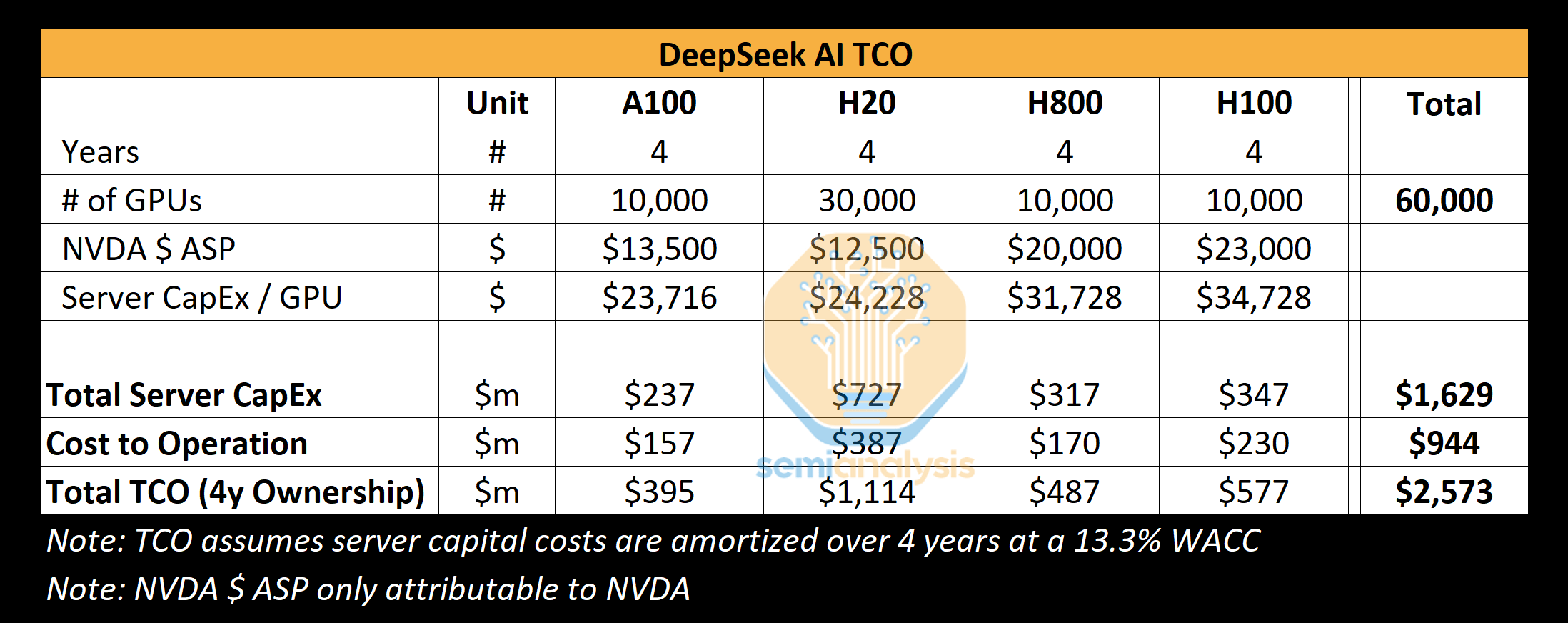

Wir denken, dass DeepSeek etwa 10.000 H800 und etwa 10.000 H100 gebrauchen könnte. Außerdem haben sie mehr H20 bestellt, und Nvidia hat in den letzten 9 Monaten mehr als 1 Million China-spezifische GPUs produziert. Diese GPUs werden von High-Flyer und DeepSeek gemeinsam genutzt und sind in gewisser Weise geografisch verteilt. Sie werden für den Handel, die Inferenz und das Training verwendet. Sie werden für den Handel, die Inferenz, die Ausbildung und die Forschung eingesetzt. Eine genauere und detaillierte Analyse finden Sie in unserem Beschleunigermodell.

-

Quelle: SemiAnalysis

Unsere Analyse zeigt, dass sich die gesamten Serverinvestitionen von DeepSeek auf etwa 1,6 Milliarden Dollar belaufen, wobei die mit dem Betrieb solcher Cluster verbundenen Kosten bis zu 944 Millionen Dollar betragen. In ähnlicher Weise verfügen alle KI-Labore und Hyperscaler über mehr GPUs für eine Vielzahl von Aufgaben, einschließlich Forschung und Training, als sie für einen einzigen Trainingslauf bereitstellen, da die Bündelung von Ressourcen eine Herausforderung darstellt. x.AI ist ein einzigartiges KI-Labor, das alle seine GPUs an einem Standort hat.

DeepSeek hat sich auf die Suche nach Talenten aus China spezialisiert, unabhängig von ihrer Vorbildung, wobei der Schwerpunkt auf Kompetenz und Neugier liegt. Das Unternehmen veranstaltet regelmäßig Rekrutierungsveranstaltungen an Spitzenuniversitäten wie Peking und Zhejiang, wo viele seiner Mitarbeiter ihren Abschluss gemacht haben. Die Stellen sind nicht unbedingt vordefiniert, und den Personalverantwortlichen wird Flexibilität eingeräumt. In den Stellenanzeigen wird sogar mit dem Zugang zu mehr als 10 000 GPUs ohne Nutzungsbeschränkung geprahlt. Das Unternehmen ist äußerst wettbewerbsfähig und bietet vielversprechenden Kandidaten angeblich Gehälter von mehr als 1,3 Millionen US-Dollar, was deutlich höher ist als die Gehälter großer chinesischer Technologieunternehmen und KI-Labore wie Moonshot. Das Unternehmen hat etwa 150 Mitarbeiter, wächst aber schnell.

Die Geschichte hat gezeigt, dass ein kleines, gut finanziertes, fokussiertes Startup oft die Grenzen des Machbaren verschieben kann. deepSeek hat nicht die Bürokratie eines Google, und da das Unternehmen selbst finanziert ist, kann es Ideen schnell umsetzen. Wie Google betreibt DeepSeek jedoch (größtenteils) sein eigenes Datenzentrum und ist nicht auf externe Parteien oder Anbieter angewiesen. Das eröffnet mehr Spielraum für Experimente und ermöglicht Innovationen über den gesamten Stack hinweg.

Wir sind der Meinung, dass sie heute das beste Labor für "offene Gewichte" sind und Meta's Llama, Mistral und andere ausstechen.

Kosten und Leistung von DeepSeek

Die Preisgestaltung und die Effizienz von DeepSeek haben in dieser Woche einen Aufruhr ausgelöst, wobei die Hauptschlagzeile die "6 Millionen Dollar" Ausbildungskosten von DeepSeek V3 waren. Das ist falsch. Das ist so, als würde man auf einen bestimmten Teil der Materialliste eines Produkts hinweisen und ihm die gesamten Kosten zuschreiben. Die Kosten für die Vorschulung machen nur einen sehr kleinen Teil der Gesamtkosten aus.

Ausbildungskosten

Wir glauben, dass die Zahlen vor dem Training weit von den tatsächlichen Ausgaben für das Modell entfernt sind. Wir glauben, dass in der Geschichte des Unternehmens weit mehr als 500 Millionen Dollar für Hardware ausgegeben wurden. Um neue architektonische Innovationen zu entwickeln, werden beträchtliche Ausgaben für das Testen neuer Ideen, neuer architektonischer Ideen und für die Ablation während der Modellentwicklung getätigt. Die Entwicklung von Multi-Head Latent Attention, einer Schlüsselinnovation von DeepSeek, dauerte Monate und kostete das gesamte Team Arbeitskraft und GPU-Zeit.

Die in dem Papier genannten Kosten von 6 Millionen Dollar beziehen sich nur auf die GPU-Kosten für die Pre-Training-Läufe, die nur einen Bruchteil der Gesamtkosten des Modells ausmachen. Darin sind wichtige Teile des Puzzles, wie Forschung und Entwicklung und die Gesamtbetriebskosten der Hardware selbst, nicht enthalten. Zum Vergleich: Claude 3.5 Sonnet kostete zig Millionen Dollar für das Training, und wenn das alles wäre, was Anthropic bräuchte, würden sie nicht Milliarden Dollar von Google und zig Milliarden von Amazon erhalten. Das liegt daran, dass sie experimentieren, neue Architekturen entwickeln, Daten sammeln und bereinigen, ihre Mitarbeiter bezahlen müssen usw.

Wie kommt es also, dass DeepSeek einen so großen Cluster hat? Die Verzögerung bei den Exportkontrollen ist der Schlüssel und wird im folgenden Abschnitt über den Export erörtert.

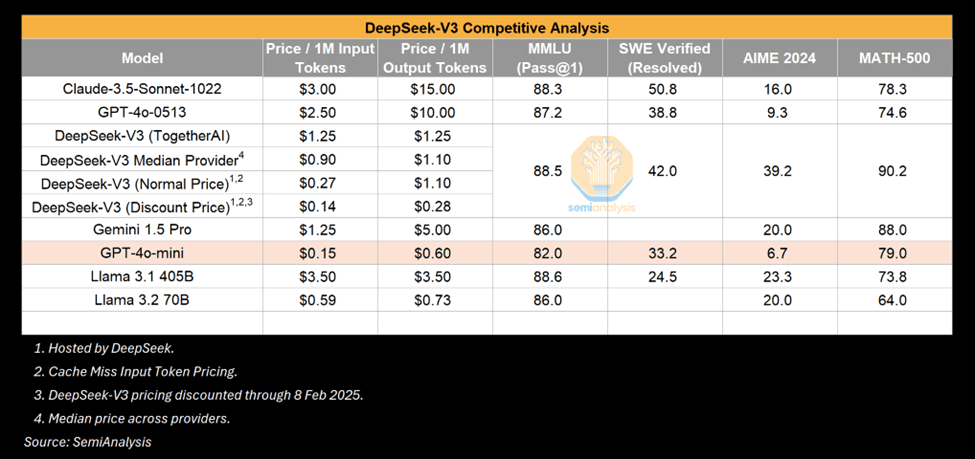

Die Lücke schließen - V3 Leistung

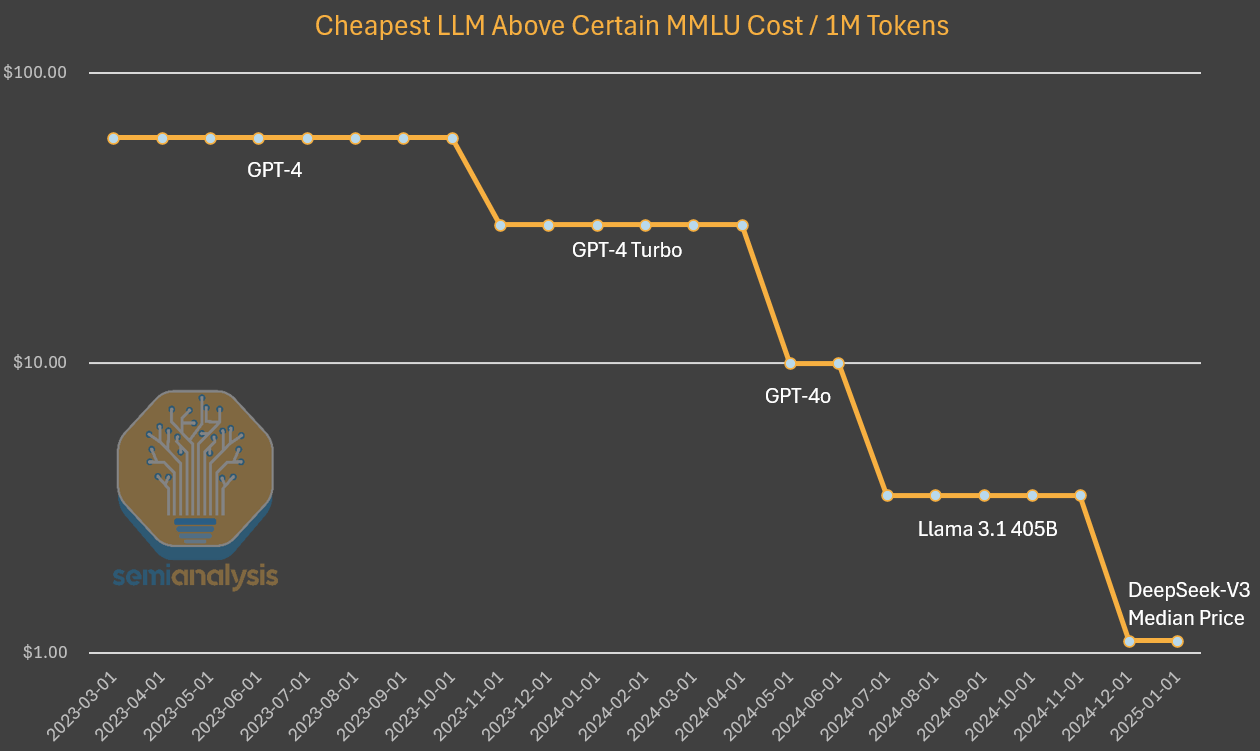

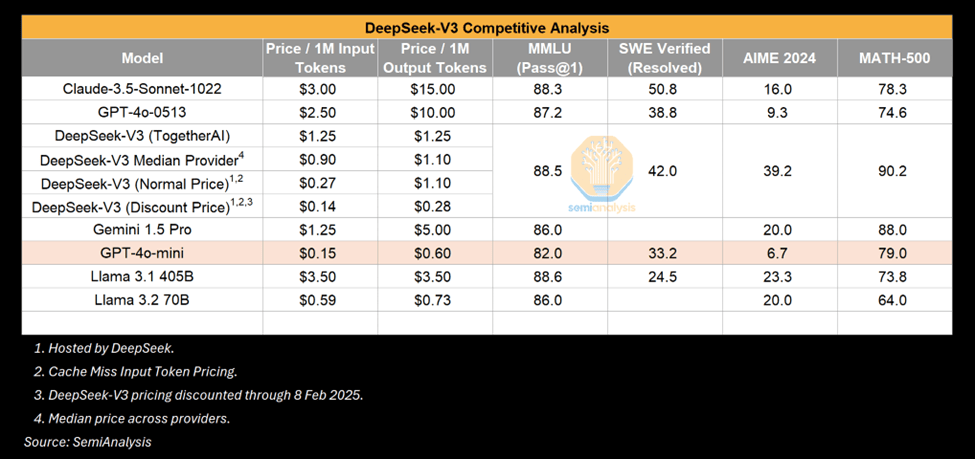

V3 ist zweifelsohne ein beeindruckendes Modell, aber es ist wichtig zu betonen, dass Im Gegensatz zu dem, was beeindruckend ist.. Viele haben das V3 mit dem GPT-4o verglichen und betont, dass das V3 die Leistung des 4o übertrifft. Das ist wahr, aber das GPT-4o ist auf der Mai 2024KI entwickelt sich rasant weiter, und Mai 2024 ist eine neue Ära in Bezug auf algorithmische Verbesserungen. Und es überrascht uns nicht, dass nach einer bestimmten Zeit mit weniger Berechnungen eine vergleichbare oder größere Leistung erreicht wird. Der Zusammenbruch der Inferenzkosten ist ein Zeichen für die Verbesserung der KI.

-

Quelle: SemiAnalysis

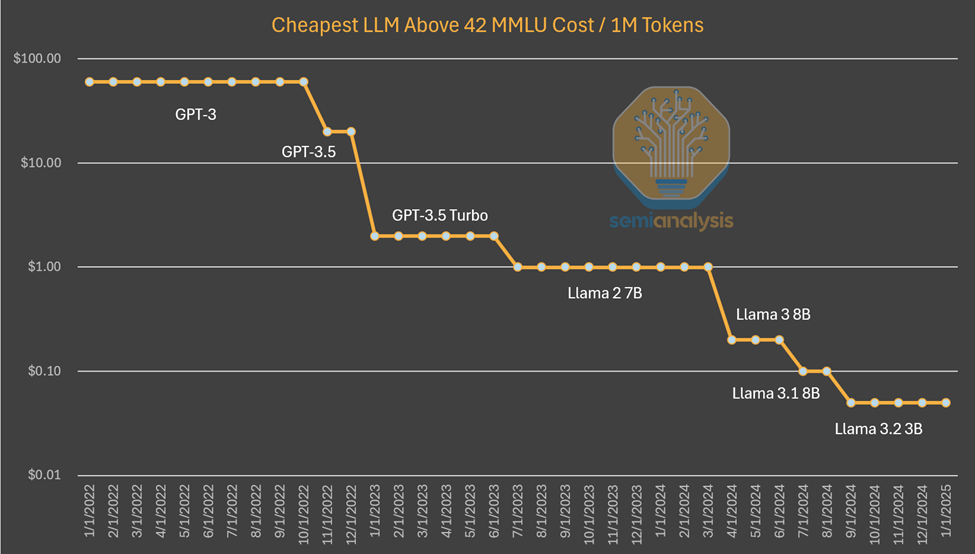

Ein Beispiel ist, dass kleine Modelle, die auf Laptops ausgeführt werden können, eine vergleichbare Leistung haben wie GPT-3, das einen Supercomputer für das Training und mehrere GPUs für die Schlussfolgerungen benötigt. Mit anderen Worten: Algorithmische Verbesserungen ermöglichen weniger Berechnungen, um Modelle mit denselben Fähigkeiten zu trainieren und Schlussfolgerungen zu ziehen, und dieses Muster funktioniert immer wieder. Dieses Mal wurde die Welt aufmerksam, denn es kam von der sino eines Labors. Aber dass kleinere Modelle besser werden, ist nichts Neues.

-

Quellen: SemiAnalysis, Artificialanalysis.ai, Anakin.ai, a16z

Das Muster, das wir bisher beobachtet haben, ist, dass die KI-Labors mehr absolute Dollar ausgeben, um mehr Die Intelligenz von Anthropic. Der algorithmische Fortschritt wird auf das Vierfache pro Jahr geschätzt, was bedeutet, dass jedes Jahr, das verstreicht, nur viermal weniger Berechnungen erfordert, um die gleiche Leistung zu erzielen.Dario, der CEO von Anthropic, glaubt, dass der algorithmische Fortschritt sogar noch schneller ist und eine 10-fache Verbesserung bringt. Bei der Preisgestaltung für GPT-3-Qualitätsinferenzen sind die Kosten um den Faktor 1200 gesunken.

Bei der Untersuchung der Kosten des GPT-4 ist ein ähnlicher Kostenrückgang festzustellen, wenn auch zu einem früheren Zeitpunkt in der Kurve. Der Rückgang der Kostendifferenz im Laufe der Zeit lässt sich dadurch erklären, dass die Kapazität nicht mehr konstant gehalten wird, wie in der obigen Grafik. In diesem Fall sehen wir, dass algorithmische Verbesserungen und Optimierungen zu einer 10-fachen Kostensenkung und einer 10-fachen Kapazitätserhöhung geführt haben.

-

Quellen: SemiAnalysis, OpenAI, Gemeinsam.ai

Um es klar zu sagen: DeepSeek ist einzigartig, weil es dieses Niveau an Kosten und Fähigkeiten überhaupt erst erreicht hat. Sie sind einzigartig in der Freigabe von offenen Gewichten, aber die vorherigen Mistral DeepSeek hat dieses Kostenniveau erreicht, aber seien Sie nicht überrascht, wenn die Kosten bis Ende des Jahres noch einmal um das Fünffache sinken.

Ist die Leistung von R1 mit der von o1 vergleichbar?

Andererseits konnte R1 vergleichbare Ergebnisse erzielen wie das erst im September angekündigte o1. Wie konnte DeepSeek so schnell aufholen?

Die Antwort ist, dass die Inferenz ein neues Paradigma mit schnelleren Iterationsraten und leichter zu erreichenden Zielen ist, bei dem ein geringer Rechenaufwand im Vergleich zu früheren Paradigmen zu bedeutenden Gewinnen führen kann. Wie in unserem Bericht "Scaling Laws" beschrieben, stützten sich frühere Paradigmen auf Pre-Training, das immer teurer und schwieriger wird, robuste Gewinne zu erzielen.

Das neue Paradigma konzentriert sich auf die Ermöglichung von Inferenzfähigkeiten durch die Generierung synthetischer Daten und das Verstärkungslernen im Nachtraining bestehender Modelle, was zu schnelleren Gewinnen zu einem niedrigeren Preis führt. Die niedrigere Einstiegshürde in Verbindung mit einfachen Optimierungen bedeutet, dass DeepSeek in der Lage ist, den o1-Ansatz schneller als üblich zu replizieren. Da die Teilnehmer herausfinden, wie sie in diesem neuen Paradigma besser skalieren können, erwarten wir, dass sich der zeitliche Abstand bei den Matching-Fähigkeiten vergrößern wird.

Bitte beachten Sie, dass das R1-Papier Nicht erwähnt Berechnungen verwendet. Das ist kein Zufall - die Erzeugung der synthetischen Daten, die für das Post-Training von R1 verwendet werden, ist sehr rechenintensiv. Dies schließt das Verstärkungslernen nicht mit ein. r1 ist ein sehr gutes Modell, das bestreiten wir nicht, und dass es den Inferenzvorteil so schnell aufholt, ist objektiv beeindruckend.

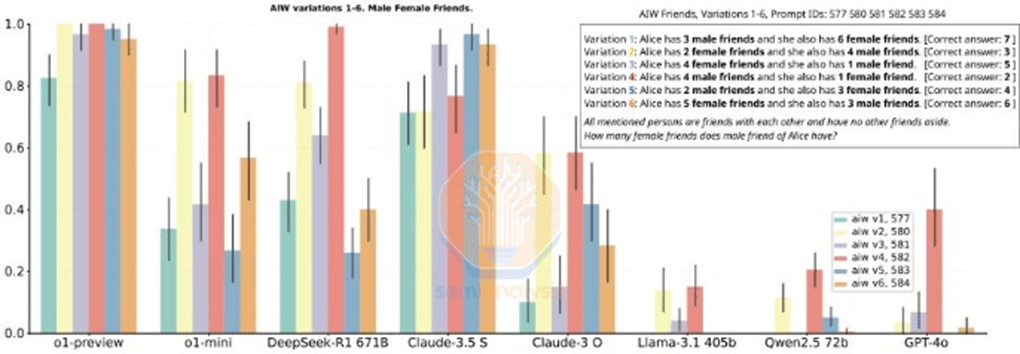

Einige der von R1 erwähnten Benchmarks sind jedoch auch Irreführend. Ein Vergleich zwischen R1 und o1 ist schwierig, da R1 nicht ausdrücklich auf Benchmarks eingeht, bei denen es nicht führend ist. Während R1 bei der Inferenzleistung mithalten kann, ist es nicht in jeder Hinsicht ein klarer Gewinner, und in vielen Fällen ist es schlechter als o1.

-

Quelle: (Noch) eine Geschichte von Aufstieg und Fall. DeepSeek R1

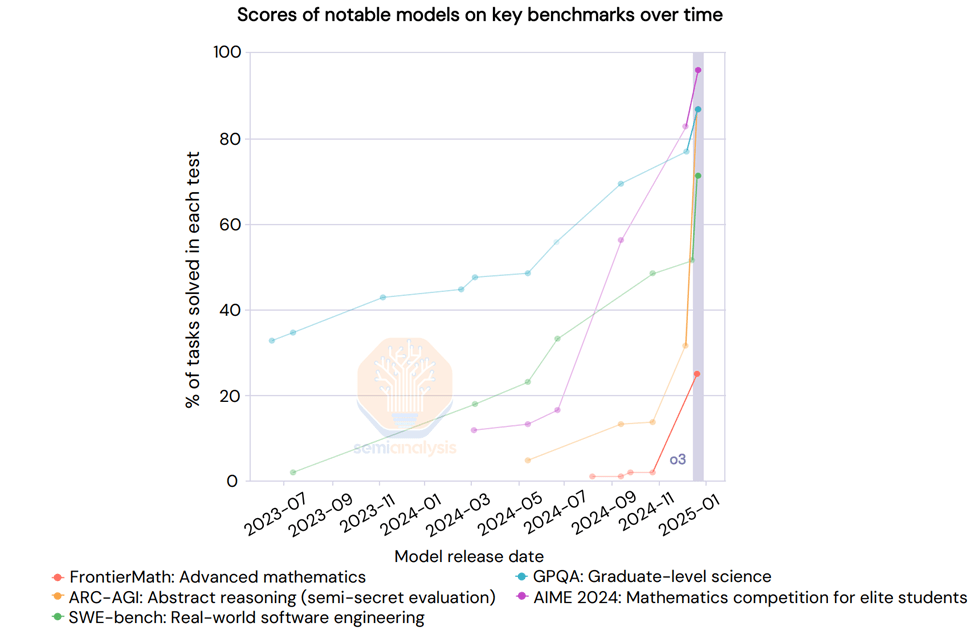

Wir haben o3 noch nicht erwähnt. o3 ist deutlich leistungsfähiger als R1 oder o1. Tatsächlich hat OpenAI kürzlich Ergebnisse für o3 veröffentlicht, bei denen der Benchmark Scaling vertikal war. "Deep Learning ist gegen die Wand gefahren", aber auf eine andere Art und Weise.

-

Quelle: AI Action Summit

Googles Inferenzmodell ist so gut wie R1

Während um R1 ein regelrechter Hype entstanden ist, hat ein 2,5 Billionen Dollar schweres US-Unternehmen vor einem Monat ein billigeres Inferenzmodell veröffentlicht: Googles Zwillinge Flash 2.0 Thinking. das Modell ist verfügbar und über die API zugänglich Viel billiger als der R1., auch wenn die Kontextlänge des Modells größer ist.

Flash 2.0 Thinking schlägt R1 in den angegebenen Benchmarks, obwohl Benchmarks nicht die ganze Geschichte erzählen. Google hat nur 3 Benchmarks veröffentlicht, also ist es ein unvollständiges Bild. Nichtsdestotrotz glauben wir, dass Googles Modell robust ist und in vielerlei Hinsicht mit dem R1 konkurrieren kann, jedoch keinem Hype ausgesetzt ist. Das könnte an Googles fehlender Markteintrittsstrategie und der schlechten Nutzererfahrung liegen, aber das R1 war auch eine Überraschung in China.

-

Quelle: SemiAnalysis

Um es klar zu sagen: Nichts davon schmälert die herausragenden Leistungen von DeepSeek, dessen Struktur als schnell wachsendes, gut finanziertes, intelligentes und fokussiertes Startup so ist, dass es bei der Veröffentlichung von Inferenzmodellen überdurchschnittlich gut abschneidet Meta und andere Giganten aus einem Grund, der lobenswert ist.

Technische Errungenschaften

DeepSeek hat den Code geknackt und Innovationen freigesetzt, die von führenden Labors noch nicht realisiert wurden. Wir gehen davon aus, dass alle von DeepSeek veröffentlichten Verbesserungen von westlichen Labors fast sofort nachgeahmt werden.

Worin bestehen diese Verbesserungen? Die meisten der architektonischen Errungenschaften beziehen sich speziell auf V3, das auch das Basismodell für R1 ist. Lassen Sie uns diese Neuerungen genauer beschreiben.

Ausbildung (vor und nach der Ausbildung)

DeepSeek V3 nutzt die Vorteile des beispiellosen Umfangs von mehreren Token Prediction (MTP) sind zusätzliche Aufmerksamkeitsmodule, die die nächsten paar Token anstelle eines einzelnen Tokens vorhersagen, was die Leistung des Modells während des Trainings verbessert und während der Inferenz verworfen werden kann. Dies ist ein Beispiel für eine algorithmische Innovation, mit der eine bessere Leistung bei geringerem Rechenaufwand erreicht wird.

Es gibt noch weitere Vorbehalte, wie z. B. die FP8-Genauigkeit in der Ausbildung, aber führende US-Labors führen schon seit einiger Zeit FP8-Ausbildungen durch.

DeepSeek v3 ist auch ein hybrides Expertenmodell, d. h. ein großes Modell, das aus vielen anderen kleineren Experten besteht, die sich auf unterschiedliche Dinge spezialisiert haben, eine Art emergentes Verhalten. Eine der Herausforderungen, mit denen das MoE-Modell konfrontiert ist, besteht darin, zu bestimmen, welcher Token zu welchem Teilmodell oder "Experten" geht. DeepSeek implementiert ein "Gated Network", das Token in ausgewogener Weise an den richtigen Experten weiterleitet, ohne die Modellleistung zu beeinträchtigen. Das bedeutet, dass das Routing sehr effizient ist und jedes Token während des Trainings nur wenige Parameter im Verhältnis zur Gesamtgröße des Modells ändert. Dies erhöht die Trainingseffizienz und senkt die Inferenzkosten.

Trotz der Bedenken, dass Effizienzgewinne durch hybride Experten (MoE) die Investitionen verringern könnten, weist Dario darauf hin, dass die Wirtschaftlichkeit leistungsfähigerer KI-Modelle so groß ist, dass alle Einsparungen schnell in den Aufbau größerer Modelle reinvestiert werden. die verbesserte Effizienz von MoE verringert nicht die Gesamtinvestitionen, sondern beschleunigt vielmehr die KI-Skalierungsbemühungen. Diese Unternehmen konzentrieren sich auf die Skalierung von Modellen auf mehr Berechnungen und machen sie durch Algorithmen effizienter.

Im Fall von R1 hat es davon profitiert, dass es ein starkes Basismodell (v3) hat, zum Teil aufgrund von Reinforcement Learning (RL). Dies ist zum Teil auf das Reinforcement Learning (RL) zurückzuführen, das zwei Schwerpunkte hat: Formatierung (um sicherzustellen, dass es ein kohärentes Ergebnis liefert) und Nützlichkeit und Unschädlichkeit (um sicherzustellen, dass das Modell nützlich ist). Bei der Feinabstimmung des Modells entsteht auf einem synthetischen Datensatz die Fähigkeit, Schlussfolgerungen zu ziehen. Dies.Wie in unserem Artikel Skalierungsgesetze beschriebenDies ist bei o1 geschehen. Beachten Sie, dass in der R1-Veröffentlichung keine Berechnungen erwähnt werden, da die Erwähnung der verwendeten Rechenleistung darauf hindeuten würde, dass mehr GPUs zur Verfügung standen, als in der Beschreibung angegeben. RL in dieser Größenordnung erfordert eine Menge Berechnungen, insbesondere um synthetische Daten zu erzeugen.

Darüber hinaus scheinen einige der von DeepSeek verwendeten Daten aus den Modellen von OpenAI zu stammen, was unserer Meinung nach Auswirkungen auf die Strategie für die Extraktion aus dem Output haben wird. Dies ist bereits in den AGB verboten, aber ein neuer Trend könnte eine Form von KYC (Know Your Customer) sein, um Extraktionen zu blockieren.

Apropos Extraktion: Der vielleicht interessanteste Teil des R1-Papiers ist die Möglichkeit der Feinabstimmung von Nicht-Inferenz-Minimodellen durch die Verwendung von Ausgaben von Inferenzmodellen, um sie in Inferenzmodelle umzuwandeln. Der verwaltete Datensatz enthält insgesamt 800.000 Stichproben, und nun kann jeder seine eigenen Datensätze mit den CoT-Ausgaben von R1 erstellen und mit Hilfe dieser Ausgaben Inferenzmodelle erstellen. Wir werden wahrscheinlich mehr kleine Modelle sehen, die Inferenzfähigkeiten demonstrieren und so die Leistung kleiner Modelle verbessern.

Mehrstufige Aufmerksamkeit (MLA)

MLA ist eine Schlüsselinnovation, die zu einer erheblichen Senkung der Inferenzkosten von DeepSeek geführt hat. Der Grund dafür ist, dass MLA im Vergleich zu Standard-Attention die Menge an KV-Caching, die pro Abfrage erforderlich ist, um etwa 93.3%Der KV-Cache ist Transformator Ein Speichermechanismus im Modell zur Speicherung von Daten, die den Kontext eines Dialogs darstellen, wodurch unnötige Berechnungen vermieden werden.

Wie in unserem Artikel "Skalierungsgesetze" beschrieben, wächst der KV-Cache mit der Größe des Dialogkontexts und stellt eine erhebliche Speichergrenze dar. Eine deutliche Verringerung der pro Abfrage benötigten KV-Cache-Menge würde die pro Abfrage benötigte Hardwaremenge reduzieren und damit die Kosten senken. Wir glauben jedoch, dass DeepSeek Inferenz zum Selbstkostenpreis anbietet, um Marktanteile zu gewinnen, ohne tatsächlich Geld zu verdienen. google Gemini Flash 2 Thinking ist immer noch billiger und Google wird es wahrscheinlich nicht zum Selbstkostenpreis anbieten. insbesondere der MLA hat die Aufmerksamkeit vieler führender US-Labore auf sich gezogen. MLA ist in DeepSeek V2 enthalten, das im Mai 2024 auf den Markt kommen soll. DeepSeek profitiert außerdem von einer höheren Inferenz-Workload-Effizienz mit dem H20 im Vergleich zum H100 aufgrund der höheren Speicherbandbreite und -kapazität des H20. Das Unternehmen kündigte auch eine Partnerschaft mit Huawei an, aber bisher gab es nur sehr wenig Arbeit an Ascend-Computern.

Die Auswirkungen, die wir am interessantesten finden, sind insbesondere die Auswirkungen auf die Gewinnspannen und was dies für das Ökosystem insgesamt bedeutet. Im Folgenden werfen wir einen Blick auf die künftige Preisstruktur in der gesamten KI-Branche und erläutern, warum wir glauben, dass DeepSeek die Preise subventioniert und warum wir erste Anzeichen dafür sehen, dass das Jevons-Paradoxon ins Spiel kommt. Wir kommentieren die Auswirkungen auf Exportkontrollen, wie CCPs auf die wachsende Dominanz von DeepSeek reagieren könnten, und vieles mehr.