Allgemeine Einführung

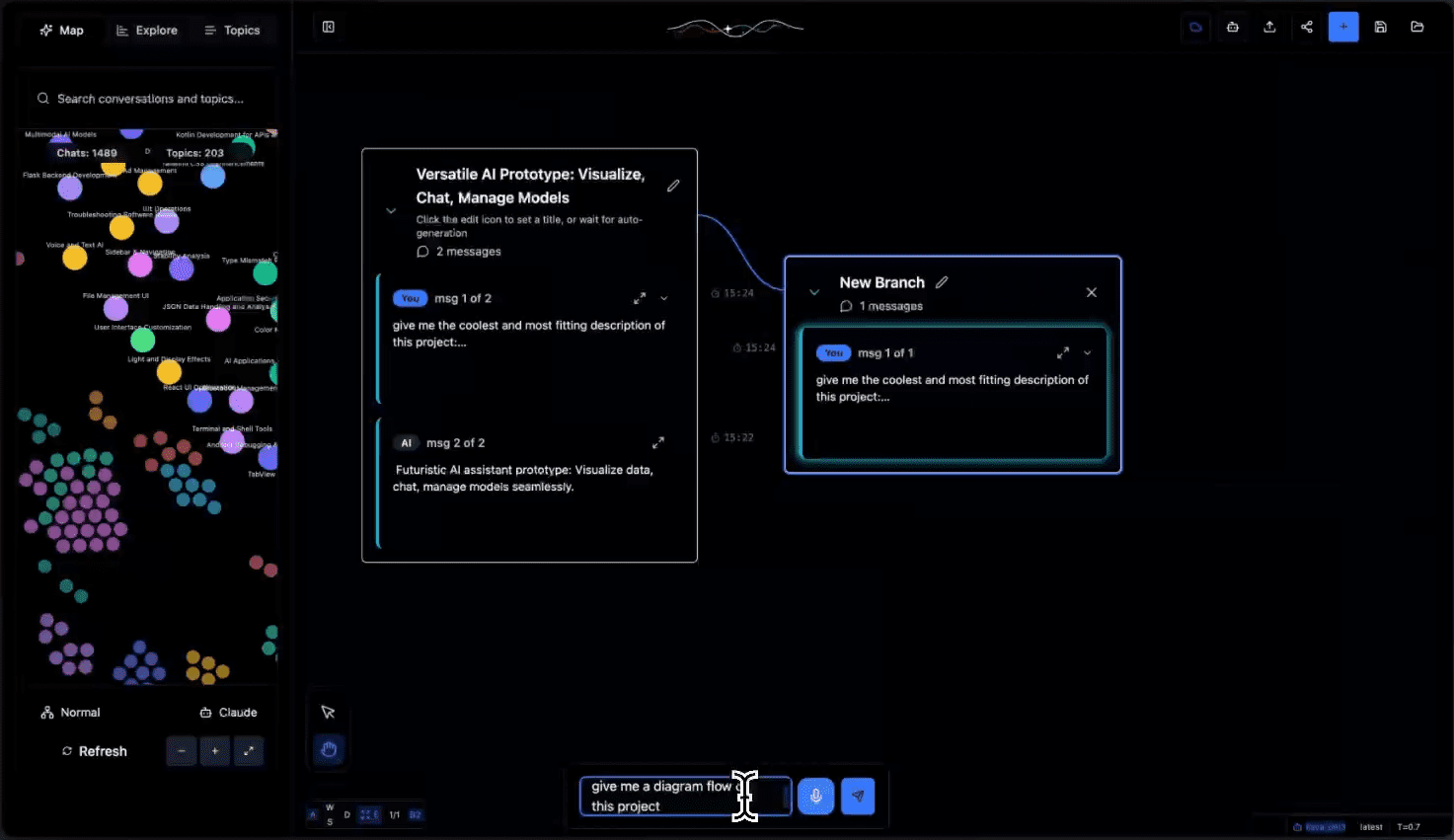

Tangent ist ein innovatives KI-Dialog-Canvas-Tool, das die visuelle Interaktion von Excalidraw mit der Flexibilität von ComfyUI kombiniert und sich auf die Schaffung einer neuen explorativen Erfahrung für LLM-Gespräche (Large Language Model) konzentriert. Im Gegensatz zu herkömmlichen Chat-Schnittstellen verwandelt Tangent KI-Dialoge in visuelle Experimente und gibt den Benutzern die Freiheit, verschiedene Dialogpfade zu verzweigen, zusammenzuführen und zu vergleichen. Tangent unterstützt ein lokales Offline-First Deployment-Modell, das sich vollständig auf lokale Modelle stützt, und wird derzeit hauptsächlich durch Ollama implementiert, mit Plänen zur Unterstützung weiterer Backends. Das Projekt steht unter der Apache 2.0-Lizenz, ermutigt die Gemeinschaft zu Beiträgen und bietet eine neue experimentelle Plattform für die Erforschung von KI-Dialogen.

Funktionsliste

- Wiederbelebung und Fortsetzung des Dialogs: Überwindung kontextueller Beschränkungen und nahtlose Wiederaufnahme eines früheren Dialogs

- Verzweigungssystem: Erstellen von Verzweigungen an jedem Dialogknoten, um mehrere Dialogrichtungen zu testen

- Lokale Offline-Bereitstellung: Läuft vollständig auf einem lokalen Modell und schützt private Daten.

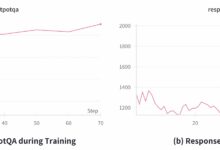

- Dynamisches Themenclustering: automatische Erkennung von Konversationsthemen und deren Einteilung in Kategorien zur Optimierung des Navigationserlebnisses

- Kompatibilität der Datenexporte: Unterstützung der Datenexportformate Claude und ChatGPT

- Visueller Dialogbaum: Darstellung von Dialogzweigen und experimentellen Prozessen in einer Baumstruktur

- API-Unterstützung: Eine vollständige REST-API ist für die Verarbeitung und Verwaltung von Dialogdaten verfügbar.

- Statusverfolgung in Echtzeit: Überwachung des Fortschritts der Dialogverarbeitung und des Aufgabenstatus

Hilfe verwenden

1. die Vorbereitung der Umwelt

1.1 Installieren Sie die erforderlichen Abhängigkeiten:

- Flüstern.cpp: für die Sprachverarbeitung

git clone https://github.com/ggerganov/whisper.cpp cd whisper.cpp sh . /models/download-ggml-model.sh base.de make

- Ollama: Lokale Modell-Laufzeitumgebung

- Besuchen Sie https://ollama.com/, um die entsprechende Version für Ihr System herunterzuladen.

- Überprüfen Sie die Installation:

ollama --version - Laden Sie die erforderlichen Modelle herunter:

ollama pull all-minilm ollama pull qwen2.5-coder:7b

1.2 Starten Sie den Ollama-Dienst:

ollama dienen

2. die Backend-Einrichtung

2.1 Initialisieren Sie die Python-Umgebung:

cd tangent-api

Quelle my_env/bin/activate

pip install -r anforderungen.txt

2.2 Konfigurieren Sie das lokale Modell:

cd src

python3 app.py --embedding-model "custom-embedding-model" --generation-model "custom-generation-model"

Der Back-End-Dienst wird unter http://localhost:5001/api gestartet.

3. die Front-End-Einrichtung

cd simplified-ui

npm i

npm starten

Besuchen Sie http://localhost:3000, um die Schnittstelle zu nutzen.

4. eine Beschreibung der Nutzung der Hauptfunktionen

4.1 Verwaltung des Dialogs:

- Erstellen Sie einen neuen Dialog: Klicken Sie auf die Schaltfläche "+" in der oberen rechten Ecke des Bildschirms.

- Verzweigungsdialog: Klicken Sie mit der rechten Maustaste auf einen beliebigen Dialogknoten und wählen Sie "Verzweigung erstellen".

- Dialoge zusammenführen: Ziehen Sie Dialoge aus verschiedenen Zweigen auf den Zielknoten, um sie zusammenzuführen.

4.2 Organisation des Themas:

- Automatisches Clustering: Das System analysiert automatisch den Inhalt des Dialogs, um Themen-Tags zu generieren.

- Themenfilterung: Finden Sie schnell relevante Unterhaltungen über die Themenliste auf der linken Seite.

- Manuelle Beschriftung: unterstützt benutzerdefinierte Themenbeschriftungen und Kategorien

4.3 Datenimport und -export:

- Unterstützung für den Import von Dialogprotokollen aus Claude und ChatGPT

- Konversationsprotokolle können in verschiedene Formate exportiert werden

- Bereitstellung einer API-Schnittstelle zur Automatisierung der Verarbeitung

5) Leitlinien für die Verwendung der API

Wichtigste Endpunkte:

- POST

/api/prozeßVerarbeitung der hochgeladenen Dialogdaten - GET

/api/prozess/status/Abfrage des Bearbeitungsstatus - POST

/api/chats/saveDialogdaten speichern - GET

/api/chats/load/: Laden bestimmter Dialoge - GET

/api/topicsAbrufen der Liste der generierten Themen