Allgemeine Einführung

Pieces-OS ist ein Open-Source-Projekt, das darauf abzielt, die GRPC-Streams von Pieces-OS rückgängig zu machen und in eine standardmäßige OpenAI API-Schnittstelle zu konvertieren. Das Projekt wird von Nekohy entwickelt und ist Open Source unter GPL-3.0 zum Lernen und zur Kommunikation, nicht zur kommerziellen Nutzung. Das Projekt bietet eine Vielzahl von Modellkompatibilität und Unterstützung für Vercel One-Click Deployment.

umgekehrte Richtung Stücke eine Minute kostenlose Bereitstellung von API-Schnittstellen, die die Modelle Claude, GPT und Gemini unterstützen. Bieten Siego version.

Funktionsliste

- GRPC FlussumkehrGRPC: Konvertiert GRPC-Streams von Pieces-OS in die Standard-OpenAI-Schnittstelle.

- Unterstützung mehrerer Modelle: Kompatibel Claude Serie, GPT-Serie, Gemini-Serie und viele andere Modelle.

- Bereitstellung mit einem Klick: Unterstützung Ein-Klick-Bereitstellung der Vercel Plattformdie von den Benutzern schnell und einfach erstellt werden kann.

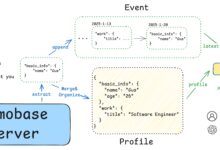

- Konfiguration des Cloud-ModellsBereitstellung von Profilen für Cloud-Modelle, damit Benutzer je nach Bedarf verschiedene Modelle extrahieren und verwenden können.

- Verwaltung von API-AnfragenVerwalten Sie Präfixpfade, Schlüssel, Wiederholungen usw. für API-Anfragen, indem Sie Umgebungsvariablen konfigurieren.

Hilfe verwenden

Ablauf der Installation

- Klonprojekt: Verwendung

Git-KlonBefehl, um das Projekt lokal zu klonen.git clone https://github.com/Nekohy/pieces-os.git - Installation von Abhängigkeiten: Wechseln Sie in das Projektverzeichnis und installieren Sie

paket.jsonAbhängigkeitsbibliotheken, die in der Dateicd stücke-os npm installieren - Auslöseverfahren: Implementierung

node index.jsLeiten Sie das Verfahren ein.node index.js

Verwendung Prozess

- Eine Liste von Modellen erhalten: Holen Sie sich die Liste der verfügbaren Modelle mit dem folgenden Befehl.

curl --request GET 'http://127.0.0.1:8787/v1/models' --header 'Content-Type: application/json' - Anfrage senden: Verwenden Sie den folgenden Befehl, um eine Chat-Anfrage zu senden.

curl --request POST 'http://127.0.0.1:8787/v1/chat/completions' --header 'Content-Type: application/json' --data '{ "messages": [ { 'Rolle': 'Benutzer', 'Inhalt':[ { "content": "Hallo!" } ], "model": "gpt-4o", "stream": true }'

Konfiguration der Umgebungsvariablen

- API_PREFIXPräfix-Pfad für API-Anfragen, Standardwert ist

'/'. - API_KEYSchlüssel: Der Schlüssel für die API-Anfrage, standardmäßig eine leere Zeichenkette.

- MAX_RETRY_COUNTMaximale Anzahl von Wiederholungsversuchen, Standardwert ist

3. - RETRY_DELAYWiederholungsverzögerung: Verzögerungszeit in Millisekunden, Standardwert ist

5000(5 Sekunden). - PORT: der Port, auf dem der Dienst lauscht. Der Standardwert ist

8787.

Modell Konfiguration

Das Projekt bietet Profile für mehrere Modelle cloud_model.jsonDer Benutzer kann je nach Bedarf verschiedene Modelle extrahieren und verwenden. Zum Beispiel:

- Claude Serie::

claude-3-5-sonnet@20240620, undclaude-3-haiku@20240307usw. - GPT-Serie::

gpt-3.5-turbo, undgpt-4, undgpt-4-turbousw. - Gemini Serie::

gemini-1.5-flash, undgemini-1.5-prousw.

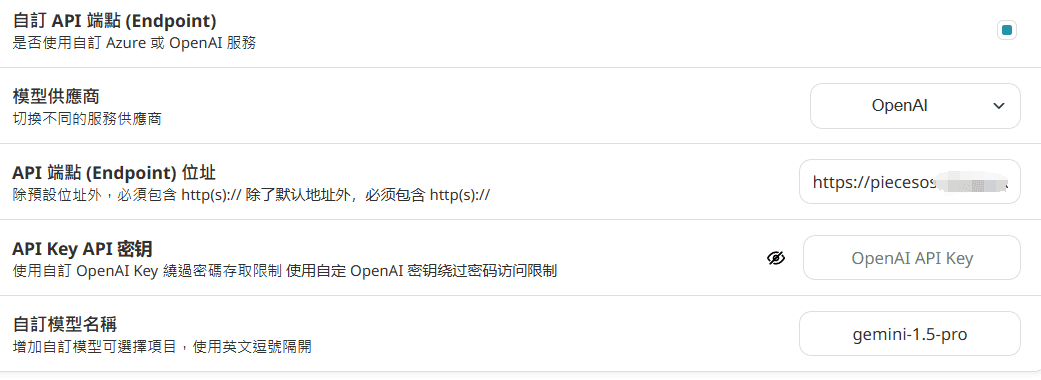

Wie Sie es nach der Bereitstellung verwenden

Konfiguriert in nextchat:

Geben Sie den Domainnamen direkt ein, fügen Sie ihn nicht nach der URL hinzu./v1/models , und /v1/chat/erledigungen

API_KEY in Vercel nicht konfiguriert ist, dann ist keine Eingabe erforderlich.

Konfiguration in der immersiven Übersetzung: (aufgrund von Gleichzeitigkeitsproblemen nicht empfohlen)

https://你的域名/v1/chat/completions

Wenn apikey nicht festgelegt ist, füllen Sie die Leerzeichen aus.