Allgemeine Einführung

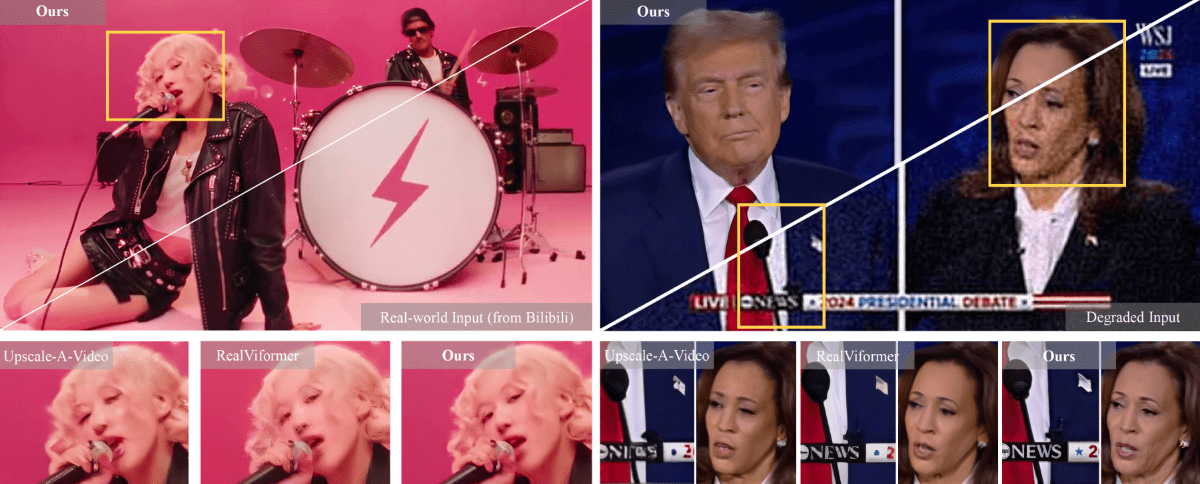

STAR (Spatial-Temporal Augmentation with Text-to-Video Models) ist ein innovativer Rahmen für Video-Superauflösung, der gemeinsam von der Nanjing University, ByteDance und der Southwest University entwickelt wurde. Das Projekt widmet sich der Lösung von Schlüsselproblemen in der realen Video-Superauflösungsverarbeitung und erreicht eine qualitativ hochwertige Verbesserung von Videobildern durch die Kombination von a priori Wissen über Text-zu-Video (T2V)-Diffusionsmodelle. Die Besonderheit des STAR-Modells liegt in seiner Fähigkeit, gleichzeitig räumliche Detailtreue und zeitliche Konsistenz zu erhalten, was mit traditionellen GAN-basierten Ansätzen oft schwer zu vereinbaren ist. Das Projekt bietet zwei Implementierungsversionen: ein leichtes und ein schweres Modell zur Qualitätsreduzierung auf der Grundlage von I2VGen-XL und ein schweres Modell zur Qualitätsreduzierung auf der Grundlage von CogVideoX-5B, das sich an die Anforderungen der Videoverbesserung in verschiedenen Szenarien anpassen lässt.

Funktionsliste

- Unterstützt die Super-Resolution-Rekonstruktion für viele Arten der Videoverschlechterung (leicht und schwer)

- Automatische Generierung von Stichwörtern, Unterstützung für die Erstellung von Videobeschreibungen mit Hilfe von Tools wie Pllava

- Bereitstellung einer Online-Demo-Plattform (HuggingFace Spaces)

- Unterstützung der Videoeingangsverarbeitung mit einer Auflösung von 720x480

- Bereitstellung von vollständigem Inferenzcode und vortrainierten Modellen

- Integration des Local Information Enhancement Module (LIEM) zur Verbesserung der Qualität der detaillierten Rekonstruktion des Bildschirms

- Unterstützung der Stapelverarbeitung von Videos

- Bietet flexible Optionen zur Modellgewichtung

Hilfe verwenden

1. ökologische Konfiguration

Zunächst müssen Sie die Laufzeitumgebung wie folgt konfigurieren:

- Klonen Sie das Code-Repository:

git clone https://github.com/NJU-PCALab/STAR.git

cd STAR

- Erstellen und aktivieren Sie die conda-Umgebung:

conda create -n star python=3.10

conda star aktivieren

pip install -r anforderungen.txt

sudo apt-get update && apt-get install ffmpeg libsm6 libxext6 -y

2. die Modellauswahl und das Herunterladen

STAR bietet zwei Versionen des Modells an:

- I2VGen-XL-basiertes Modell:

- light_deg.pt: für die Verarbeitung von Videos mit Lichtverschlechterung

- heavy_deg.pt: für stark degradierte Videoverarbeitung

- CogVideoX-5B-basiertes Modell:

- Speziell entwickelt, um stark degradierte Videos zu verarbeiten

- Unterstützt nur Eingaben mit einer Auflösung von 720x480

Laden Sie die entsprechenden Modellgewichte von HuggingFace herunter und platzieren Sie sie in dervortrainiertes_Gewicht/Katalog.

3. der Ablauf der Videoverarbeitung

- Bereiten Sie Testdaten vor:

- Legen Sie das zu bearbeitende Video in den Ordner

Eingabe/Video/Verzeichnis (auf der Festplatte des Computers) - Vorbereitung des Stichworts (drei Möglichkeiten):

- unaufgefordertes Wort

- Automatisch generiert mit Pllava

- Manuelles Schreiben von Videobeschreibungen

- Legen Sie das zu bearbeitende Video in den Ordner

- Konfigurieren Sie die Verarbeitungsparameter:

- Änderungen

video_super_auflösung/scripts/inference_sr.shDie Pfadkonfiguration in der Datei- video_folder_path: Pfad des Eingangsvideos

- txt_file_path: Pfad der Prompt-Datei

- model_path: Pfad der Modellgewichtung

- save_dir: Speicherpfad der Ausgabe

- Änderungen

- Argumentation einleiten:

bash video_super_resolution/scripts/inference_sr.sh

Hinweis: Wenn Sie ein Problem mit einem Speicherüberlauf (OOM) haben, können Sie eine neue Datei in derinferenz_sr.shMitteltöniges Moll (in der Musik)frame_lengthParameter.

4. besondere Konfiguration des Modells CogVideoX-5B

Wenn Sie das Modell CogVideoX-5B verwenden, sind zusätzliche Schritte erforderlich:

- Schaffen Sie eine eigene Umgebung:

conda create -n star_cog python=3.10

conda star_cog aktivieren

cd cogvideox-basiert/sat

pip install -r anforderungen.txt

- Laden Sie zusätzliche Abhängigkeiten herunter:

- VAE und T5 Encoder müssen heruntergeladen werden

- Update

cogvideox-based/sat/configs/cogvideox_5b/cogvideox_5b_infer_sr.yamlDie Pfadkonfiguration in der Datei - Ersetzen der Datei transformer.py