Allgemeine Einführung

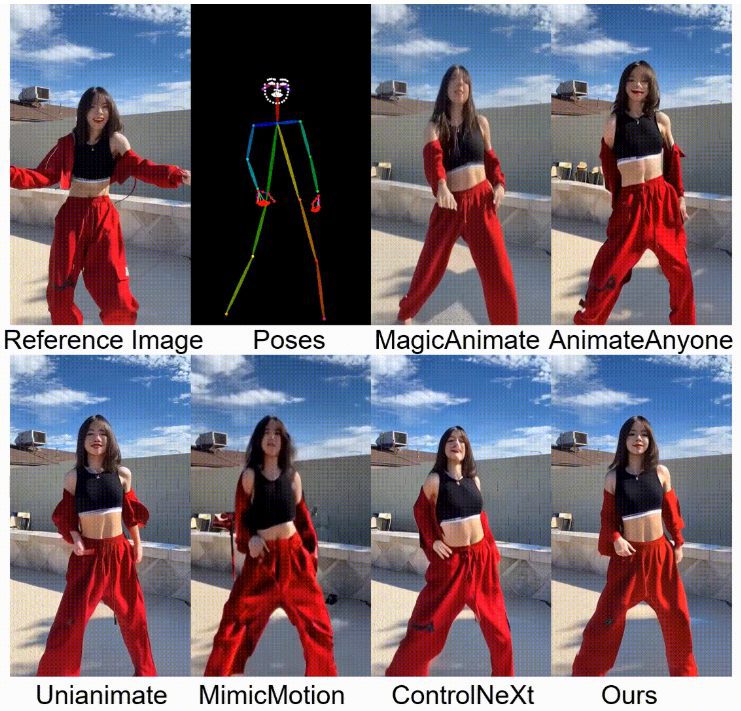

StableAnimator ist ein innovatives End-to-End-Framework für identitätserhaltende Videodiffusion, das in der Lage ist, qualitativ hochwertige Videos auf der Grundlage eines Referenzbildes und einer Reihe von Posen ohne jegliche Nachbearbeitung zu synthetisieren. StableAnimator wurde in Zusammenarbeit mit Forschern der Fudan University, Microsoft Research Asia, Huya Inc und der Carnegie Mellon University entwickelt und gewährleistet die Identitätskonsistenz in Videos. Das Framework schneidet in mehreren Benchmarks gut ab und erzeugt originalgetreue, identitätserhaltende Porträtanimationen.

Funktionsliste

- Identitätserhaltung VideogenerierungGenerieren Sie qualitativ hochwertige Videos auf der Grundlage von Referenzbildern und Pose-Sequenzen, um die Konsistenz der Identität zu gewährleisten.

- Keine NachbearbeitungDas resultierende Video erfordert keine Nachbearbeitung mit Gesichtertauschwerkzeugen oder Modellen zur Gesichtswiederherstellung.

- Global Content-Aware Facial EncoderWeitere Optimierung der Einbettung von Gesichtern durch Interaktion mit der Einbettung von Bildern.

- Verteilungsorientierter IdentitätsadapterZeitschicht: Verhinderung von Störungen auf der Zeitschicht bei gleichzeitiger Wahrung der Identitätskonsistenz.

- Hamilton-Jacobi-Bellman-OptimierungGesichtsqualität: Die Gesichtsqualität wird durch das Lösen der HJB-Gleichung während des Argumentationsprozesses weiter verbessert.

Hilfe verwenden

Ablauf der Installation

- Klon-LagerKlonen Sie das StableAnimator-Repository, indem Sie den folgenden Befehl in einem Terminal ausführen:

git clone https://github.com/Francis-Rings/StableAnimator.git

- Installation von Abhängigkeiten: Wechseln Sie in das Repository-Verzeichnis und installieren Sie die erforderlichen Abhängigkeiten:

cd StableAnimator

pip install -r anforderungen.txt

- Ausführen der AnwendungStarten Sie die Anwendung mit folgendem Befehl:

python app.py

Verwendung Prozess

- Vorbereiten von Referenzbildern und Posenfolgen: Stellen Sie sicher, dass Sie ein Referenzbild und eine Reihe von Posenbildern haben, die für die Erstellung der Animation verwendet werden sollen.

- Ausführen von Inferenzskripten: Verwenden Sie den folgenden Befehl, um das Inferenzskript auszuführen und die Videoanimation zu erzeugen:

python inference_basic.py --reference_image path_to_reference_image --pose_sequence path_to_pose_sequence

- Generierte Ergebnisse anzeigenDas erzeugte Video wird im angegebenen Ausgabeverzeichnis gespeichert, und Sie können das Ergebnis mit einem beliebigen Videoplayer ansehen.

Detaillierte Funktionsweise

- Identitätserhaltung VideogenerierungStableAnimator ist in der Lage, durch die Bereitstellung eines Referenzbildes und einer Abfolge von Posen qualitativ hochwertige Videoanimationen zu erzeugen und dabei sicherzustellen, dass die Identität der Personen im Video mit dem Referenzbild übereinstimmt.

- Global Content-Aware Facial EncoderDieses Modul optimiert die Gesichtseinbettung weiter, indem es mit der Bildeinbettung interagiert, um eine hohe Wiedergabetreue der Gesichtsdetails im generierten Video zu gewährleisten.

- Verteilungsorientierter IdentitätsadapterWährend der Erstellung des Videos gewährleistet das Modul die Identitätskonsistenz im Video durch Ausrichtungsverfahren, die Störungen auf der Zeitebene verhindern.

- Hamilton-Jacobi-Bellman-OptimierungDie Qualität und Konsistenz der Gesichter im generierten Video wird durch das Lösen der HJB-Gleichung während des Inferenzprozesses weiter verbessert.