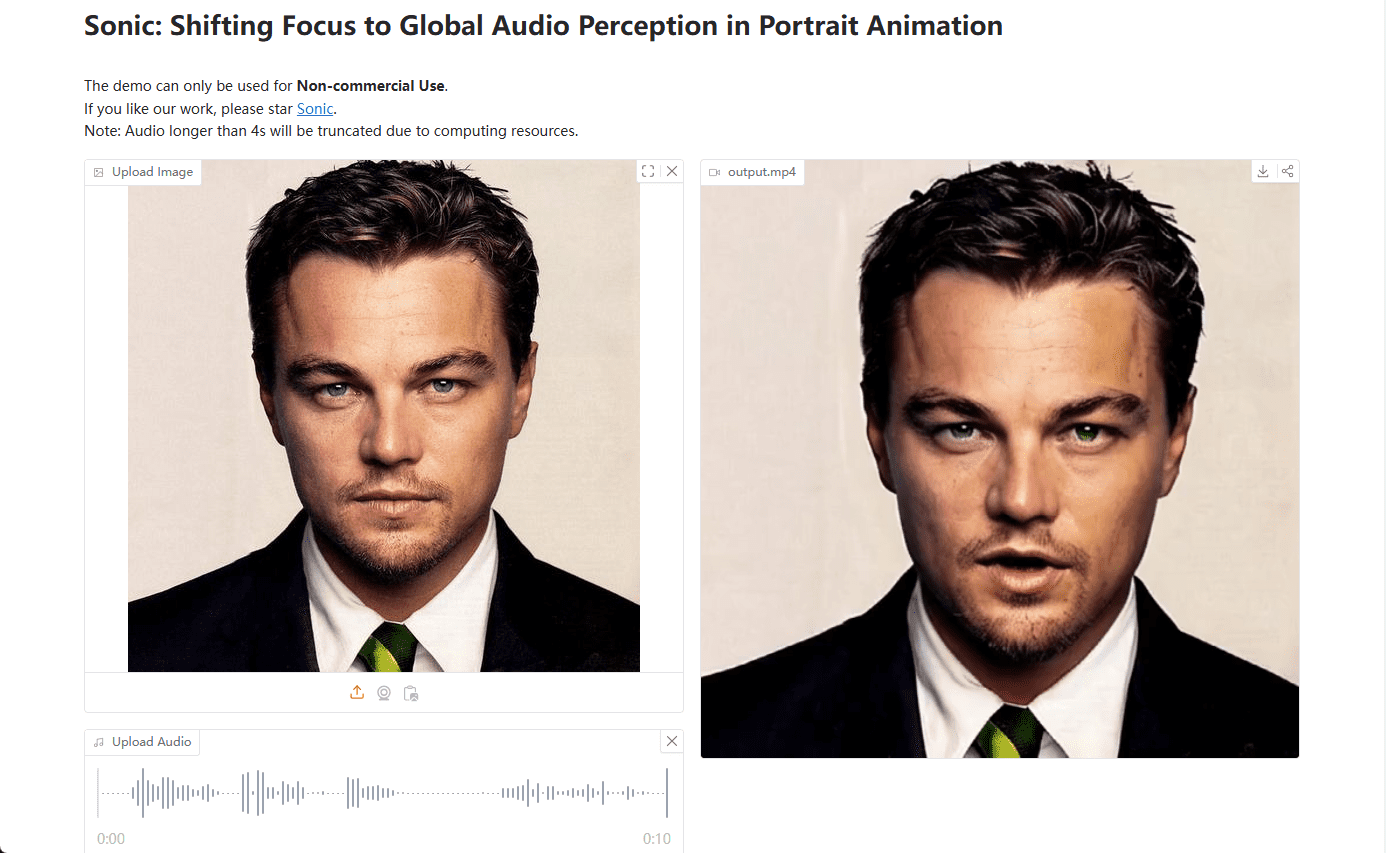

Sonic: Audio-gesteuerte Porträtbilder erzeugen digitale Demo-Videos mit lebendiger Mimik

Allgemeine Einführung

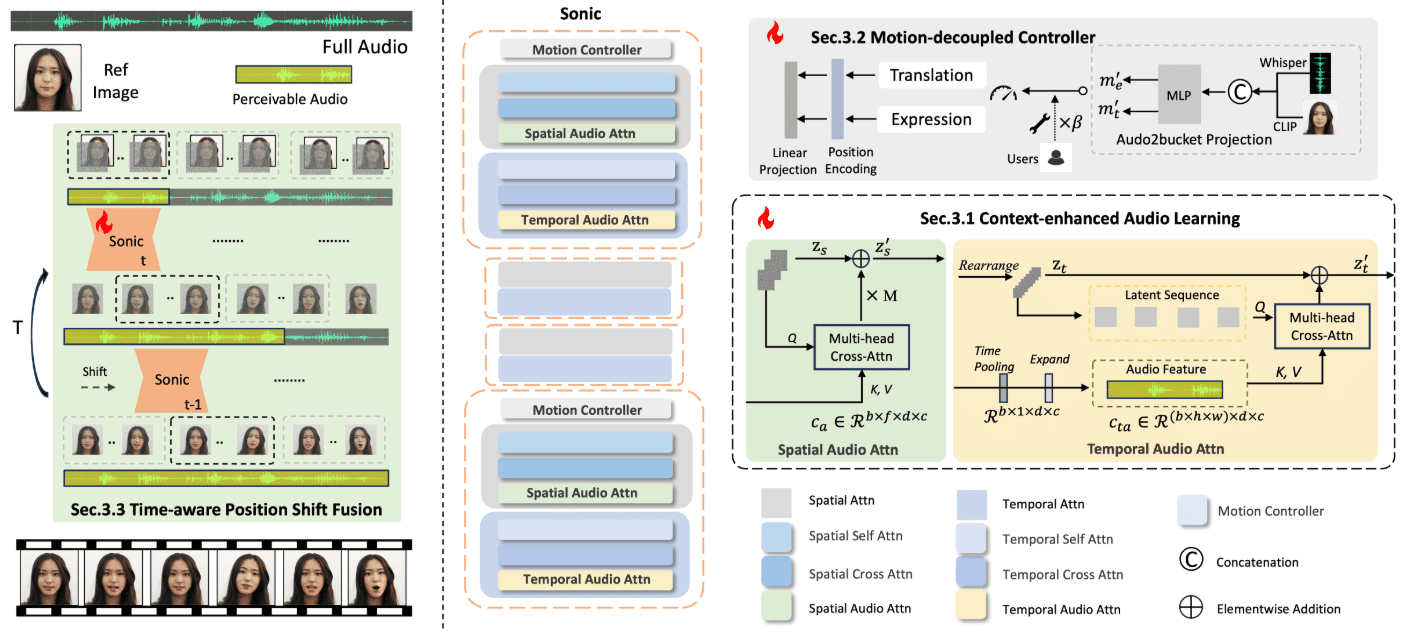

Sonic ist eine innovative Plattform, die sich auf die globale Audiowahrnehmung konzentriert und darauf ausgelegt ist, lebendige Porträtanimationen zu erzeugen, die durch Audio gesteuert werden. Die von einem Forscherteam von Tencent und der Universität Zhejiang entwickelte Plattform nutzt Audioinformationen zur Steuerung von Gesichtsausdrücken und Kopfbewegungen, um natürliche und flüssige Animationsvideos zu erzeugen.Zu den Kerntechnologien von Sonic gehören kontextbezogenes Audio-Lernen, bewegungsentkoppelte Steuerungen und zeitbewusste Module zur Positionsverschiebung. Diese Technologien ermöglichen es Sonic, stabile und realistische Langform-Videos mit unterschiedlichen Bildstilen und verschiedenen Arten von Audio-Inputs zu erzeugen.

Der Code und die Gewichte für dieses Projekt werden freigegeben (bereits freigegeben), nachdem es die interne Open-Source-Prüfung bestanden hat.Installationsanweisungen für Windows-Benutzer.

Demo: https://huggingface.co/spaces/xiaozhongji/Sonic

Funktionsliste

- Kontexterweitertes Audio-LernenDie Extraktion von Audiowissen aus langen Zeitsegmenten liefert a priori Informationen über Gesichtsausdrücke und Lippenbewegungen.

- Regler zur BewegungsentkopplungUnabhängige Steuerung von Kopf- und Mimikbewegungen für eine natürlichere Animation.

- Zeitabhängige Fusion von PositionsverschiebungenZusammenführung von globalen Audioinformationen zur Erzeugung langer und stabiler Videos.

- Vielseitige VideoerstellungUnterstützung für verschiedene Bildstile und mehrere Auflösungen für die Videoerstellung.

- Vergleich mit Open- und Closed-Source-MethodenZeigt die Stärken von Sonic im Ausdruck und in der natürlichen Kopfbewegung.

Hilfe verwenden

Einbauverfahren

Die Sonic-Plattform wird derzeit einer internen Open-Source-Prüfung unterzogen. Sobald die Prüfung abgeschlossen ist, werden der Code und die Gewichte auf GitHub hochgeladen:

- Besuchen Sie die GitHub-Seite von Sonic.

- Klon-Lagerhaus:

git clone https://github.com/jixiaozhong/Sonic.git - Installieren Sie die Abhängigkeit:

pip install -r requirements.txt - Laden Sie die vortrainierten Modellgewichte herunter und legen Sie sie im angegebenen Verzeichnis ab.

Verwendungsprozess

- Vorbereiten der DateneingabeSammelt Videobilder und Audiodateien, die für die Animation erstellt werden müssen.

- Führen Sie das generierte Skript aus: Führen Sie den Generierungsprozess mit Hilfe der mitgelieferten Skripte durch, zum Beispiel:

python generate.py --image input.jpg --audio input.wav - Anpassungsparameter: Passen Sie die Parameter im Generierungsskript nach Bedarf an, um die besten Ergebnisse zu erzielen.

- Ansicht AusgabeDas erzeugte Video wird im angegebenen Ausgabeverzeichnis gespeichert.

Detaillierte Funktionsweise

- Kontexterweitertes Audio-LernenDurch das Lernen aus langen Audiosegmenten kann Sonic subtile Veränderungen im Ton erfassen und so eine natürlichere Mimik und Lippenbewegung erzeugen.

- Regler zur BewegungsentkopplungDer Controller steuert die Kopfbewegung und die Mimikbewegung getrennt, wodurch die erzeugte Animation realistischer wird. Der Benutzer kann den Animationseffekt optimieren, indem er die Parameter des Controllers anpasst.

- Zeitabhängige Fusion von PositionsverschiebungenDieses Modul sorgt dafür, dass das erzeugte Video über einen langen Zeitraum hinweg stabil bleibt, indem es globale Audioinformationen fusioniert. Der Benutzer kann die Glätte und Stabilität des Videos steuern, indem er die Zeitfensterparameter anpasst.

- Vielseitige VideoerstellungSonic unterstützt verschiedene Bildstile (z. B. Zeichentrick, realistisch) und mehrere Auflösungen für die Videoerzeugung. Die Benutzer können die geeigneten Bild- und Audioeingänge nach ihren Bedürfnissen auswählen und Videoeffekte erzeugen, die ihren Erwartungen entsprechen.

Sonic Ein-Klick-Installationsprogramm

Baidu: https://pan.baidu.com/share/init?surl=iCR4l4ClSRZswm1E2K_NNA&pwd=8520

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...