Privater Einsatz von DeepSeek + Dify: Aufbau eines sicheren und kontrollierbaren lokalen KI-Assistenzsystems

skizziert.

DeepSeek ist ein bahnbrechendes, quelloffenes Big-Language-Modell, das mit seiner fortschrittlichen algorithmischen Architektur und seinen reflektierenden Verkettungsfunktionen eine revolutionäre Erfahrung für die KI-Dialoginteraktion bietet. Bei der privaten Bereitstellung haben Sie die volle Kontrolle über die Datensicherheit und die Nutzungssicherheit. Außerdem können Sie das Bereitstellungsschema flexibel anpassen und ein bequemes benutzerdefiniertes System implementieren.

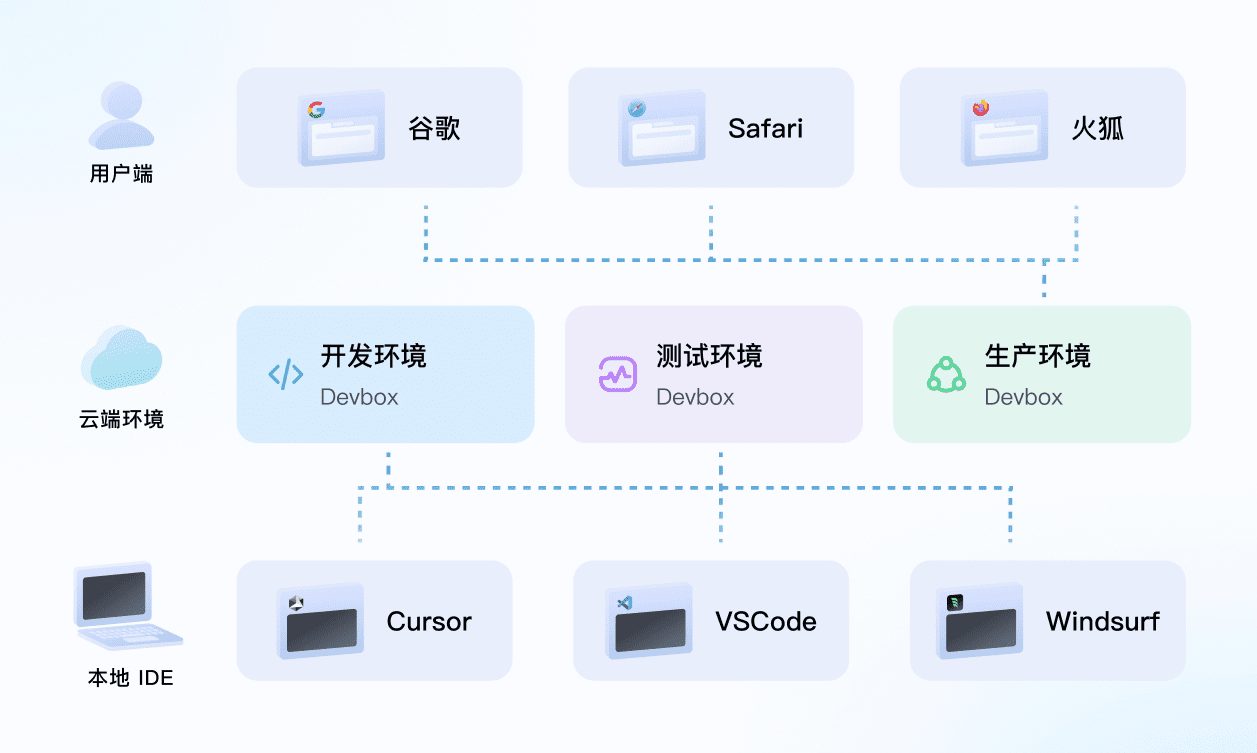

Dify Als dieselbe Open-Source-Plattform für die Entwicklung von KI-Anwendungen bietet sie eine vollständige Lösung für den privaten Einsatz. Durch die nahtlose Integration von lokal bereitgestellten DeepSeek-Diensten in die Dify-Plattform können Unternehmen leistungsstarke KI-Anwendungen in einer lokalen Serverumgebung entwickeln und gleichzeitig den Datenschutz gewährleisten.

Im Folgenden werden die Vorteile der privaten Bereitstellungsoption erläutert:

- überragende Leistung Bieten Sie eine Dialog-Interaktionserfahrung, die mit Geschäftsmodellen vergleichbar ist.

- ökologische Isolierung Vollständiger Offline-Betrieb, wodurch das Risiko von Datenverlusten ausgeschlossen wird

- Kontrollierbarkeit der Daten Vollständige Kontrolle über Datenbestände zur Erfüllung von Compliance-Anforderungen

Vorab-Positionierung

Hardware-Umgebung:

- CPU >= 2 Kerne

- Videospeicher/RAM ≥ 16 GiB (empfohlen)

Software-Umgebung:

- Docker

- Docker Compose

- Ollama

- Dify Gemeinschaftsausgabe

Beginn des Einsatzes

1. die Installation von Ollama

Ollama ist ein plattformübergreifender Client für die Verwaltung großer Modelle (MacOS, Windows, Linux), der für die nahtlose Bereitstellung großer Sprachmodelle (LLMs) wie DeepSeek, Llama, Mistral usw. entwickelt wurde. Ollama ermöglicht die Bereitstellung großer Modelle mit nur einem Mausklick, und alle Nutzungsdaten werden lokal auf dem Computer gespeichert, wodurch ein vollständiger Datenschutz und Sicherheit.

Besuchen Sie die Ollama-Website und folgen Sie den Anweisungen, um den Ollama-Client herunterzuladen und zu installieren. Nach der Installation führen Sie ollama -v wird die Versionsnummer ausgegeben.

➜~ollama-v

ollamaversionis0.5.5

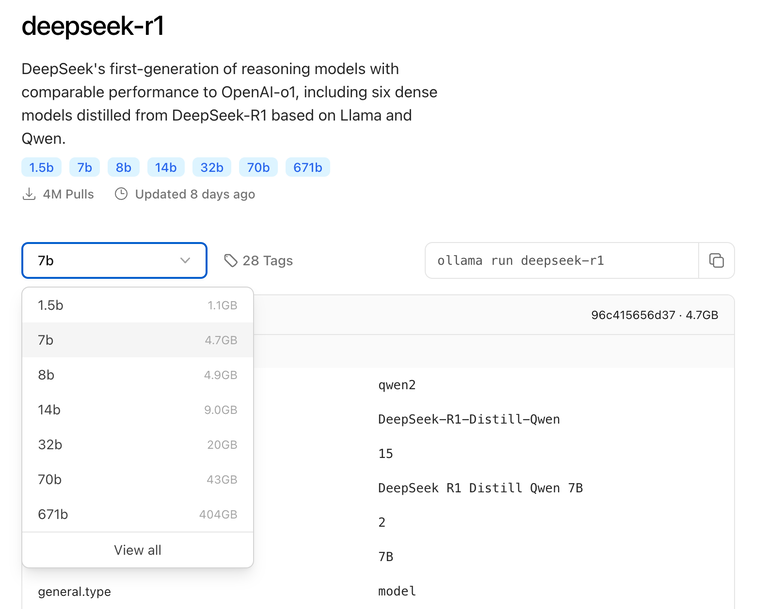

Wählen Sie das geeignete DeepSeek-Modell für die Bereitstellung auf der Grundlage der tatsächlichen Umgebungskonfiguration. Für die Erstinstallation wird das Modell der Größe 7B empfohlen.

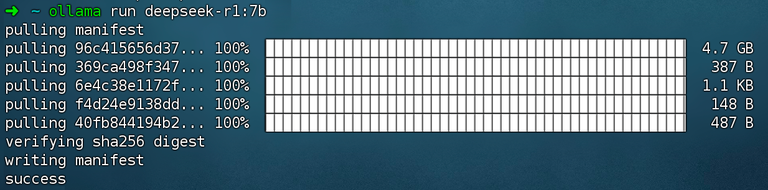

Befehl ausführen ollama run deepseek-r1:7b Montage DeepSeek R1 Modelle.

2. die Dify Community Edition installieren

Besuchen Sie die GitHub-Projektadresse von Dify und führen Sie die folgenden Befehle aus, um das Ziehen des Code-Repositorys und den Installationsprozess abzuschließen.

gitclonehttps://github.com/langgenius/dify.git

cddify/docker

cp.env.example.env

dockercomposeup-d# 如果版本是 Docker Compose V1,使用以下命令:docker-compose up -d

Nachdem Sie den Befehl ausgeführt haben, sollten Sie den Status und die Portzuordnung aller Container sehen. Detaillierte Anweisungen finden Sie unter Docker Compose-Bereitstellung.

Die Dify Community Edition verwendet standardmäßig Port 80. http://your_server_ip Zugang zu Ihrer privatisierten Dify Plattform.

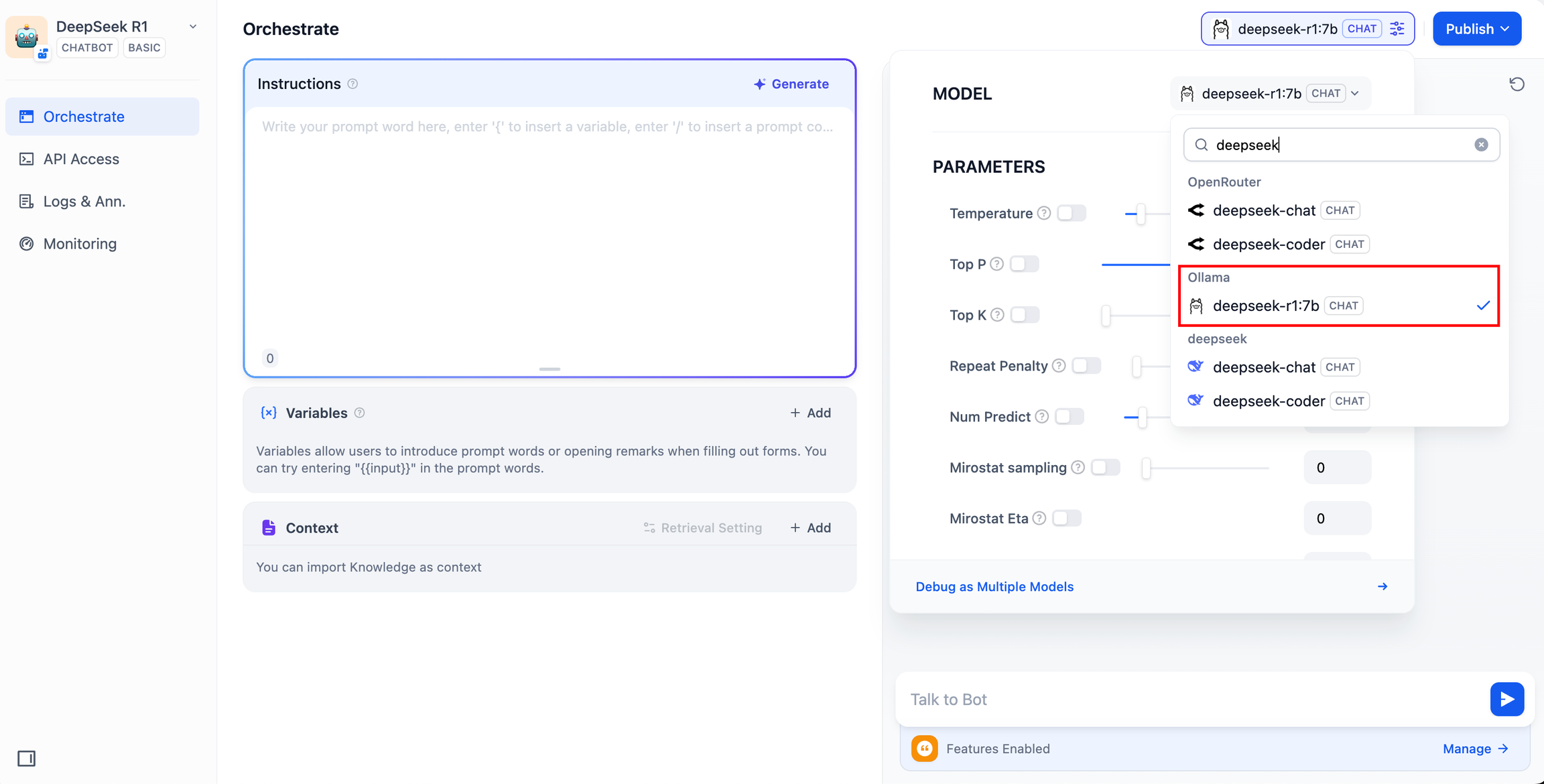

3. die Verbindung zwischen DeepSeek und Dify

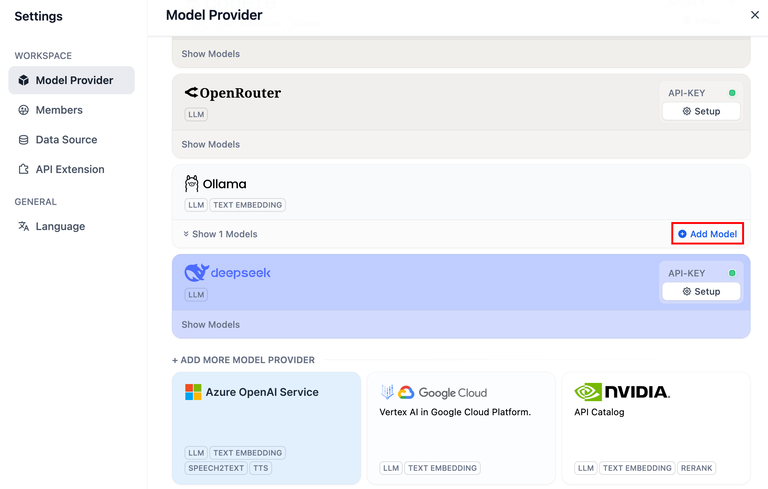

Klicken Sie auf die obere rechte Ecke der Dify Plattform Avatar → Einstellungen → Modellanbieter Wählen Sie Ollama und tippen Sie auf Modell hinzufügen.

DeepSeek innerhalb des Modellanbieters entspricht dem Online-API-Dienst; lokal bereitgestellte DeepSeek-Modelle entsprechen dem Ollama-Client. Bitte stellen Sie sicher, dass das DeepSeek-Modell erfolgreich vom Ollama-Client bereitgestellt wurde, wie in den Bereitstellungsanweisungen oben beschrieben.

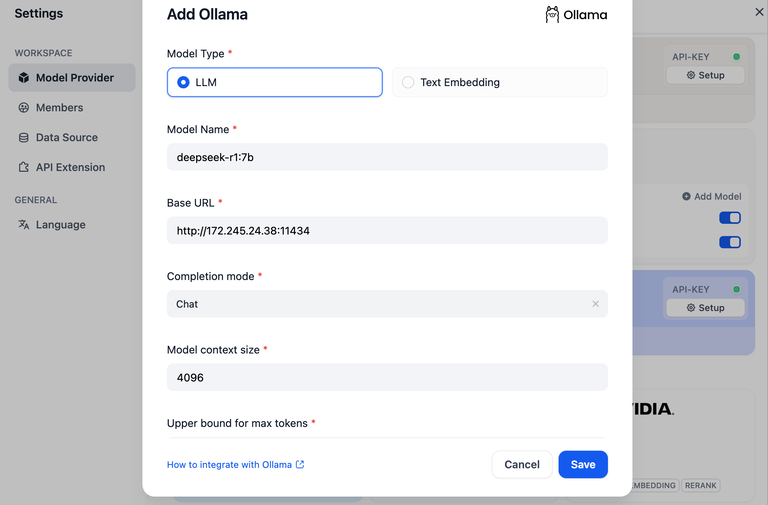

Wählen Sie den LLM-Modelltyp.

- Modellname, geben Sie den Modellnamen des eingesetzten Modells ein. Das oben eingesetzte Modell ist deepseek-r1 7b, also geben Sie den

deepseek-r1:7b - Basis-URL, die Adresse, unter der der Ollama-Client läuft, normalerweise

http://your_server_ip:11434. Im Falle von Verbindungsproblemen lesen Sie bitte inallgemeine Probleme. - Die anderen Optionen bleiben auf ihren Standardwerten. Abhängig von der Beschreibung des DeepSeek-ModellsDie maximale generierte Länge beträgt 32.768 Token.

Aufbau von AI-Anwendungen

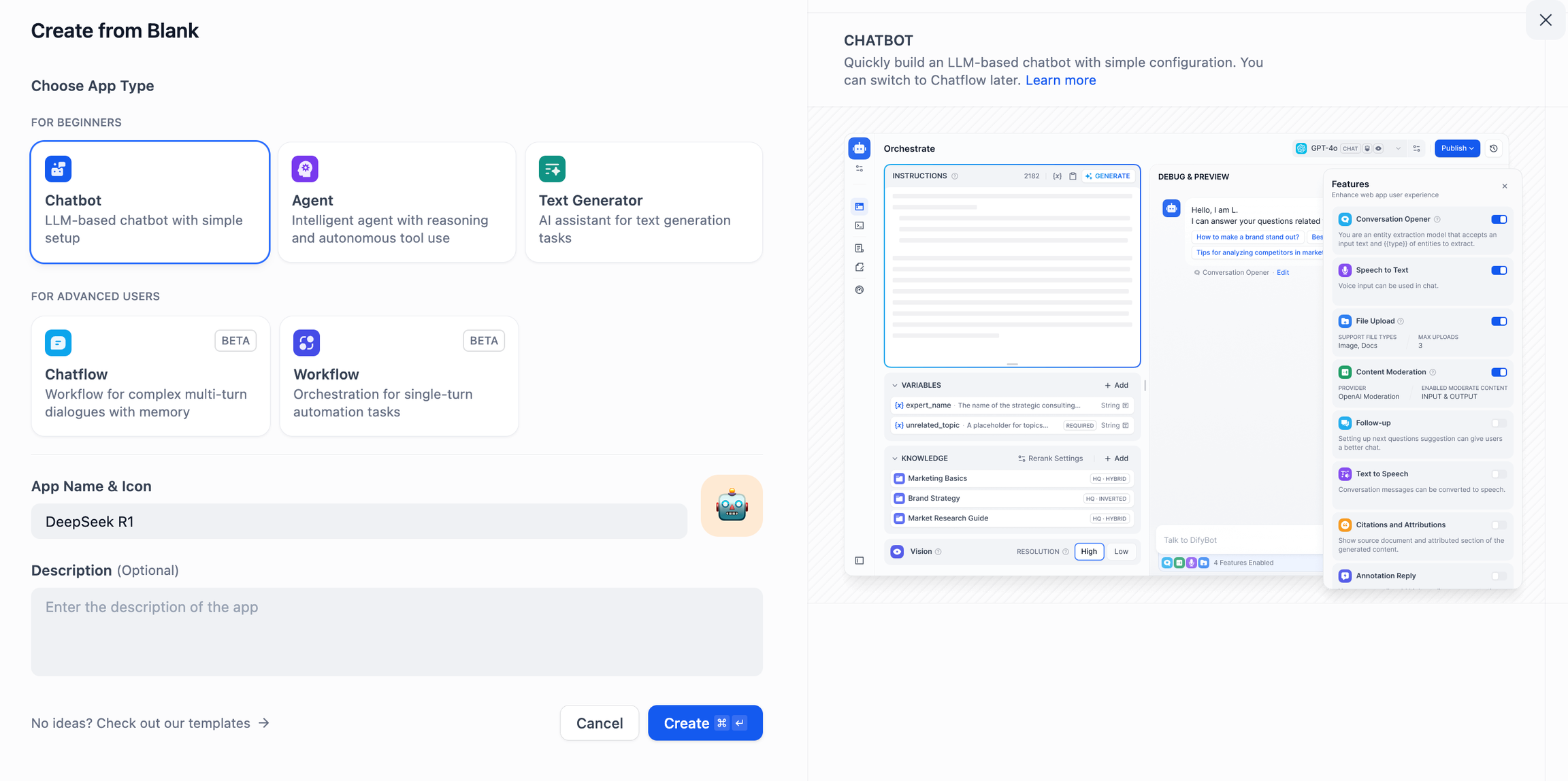

DeepSeek AI Chatbot (einfache Anwendung)

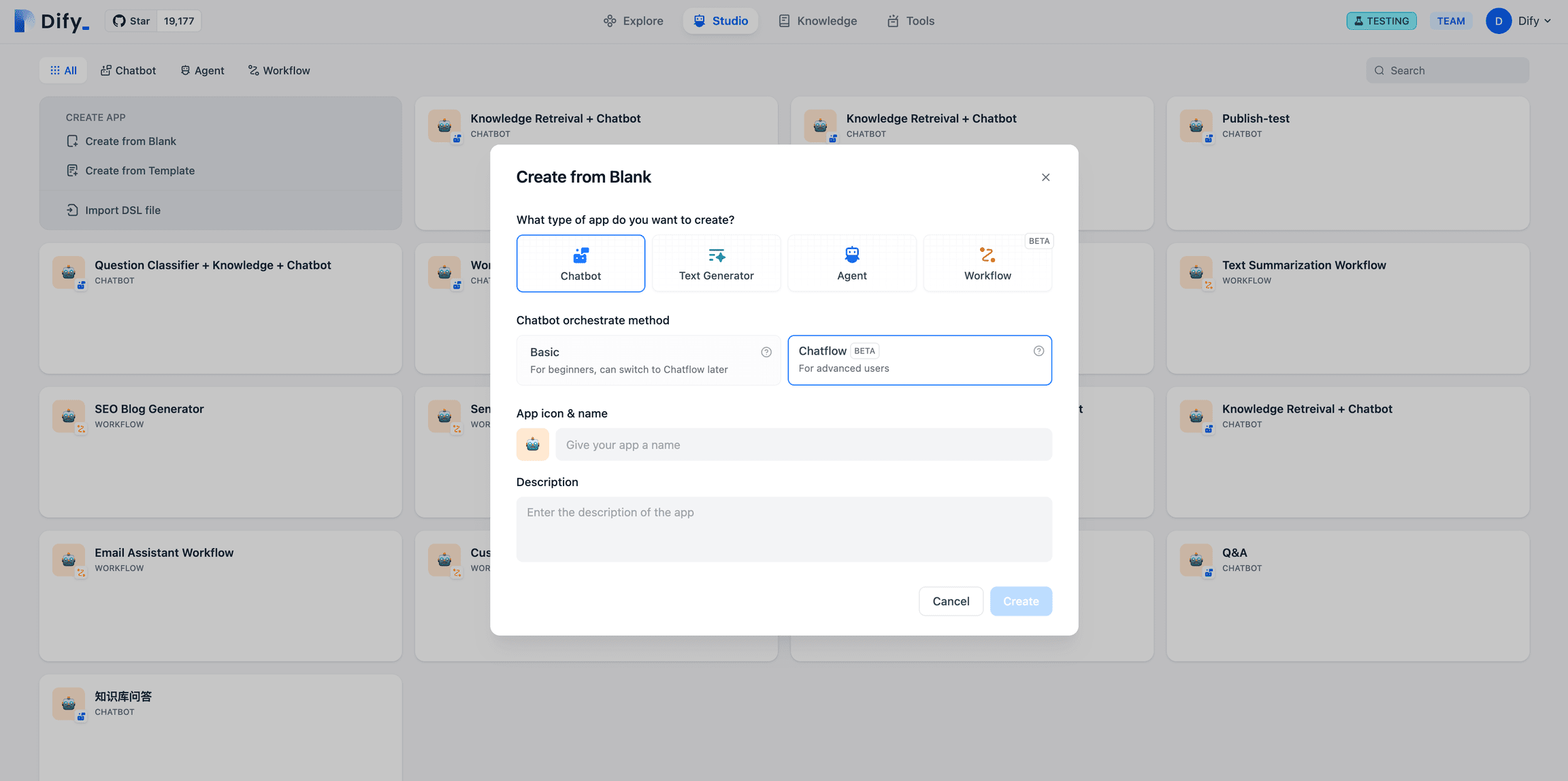

- Tippen Sie auf "Create a Blank App" auf der linken Seite der Dify-Plattform-Startseite, wählen Sie den App-Typ "Chat Assistant" und geben Sie ihm einen einfachen Namen.

- Wählen Sie in der oberen rechten Ecke unter Anwendungstyp das Ollama-Framework innerhalb der

deepseek-r1:7bModelle.

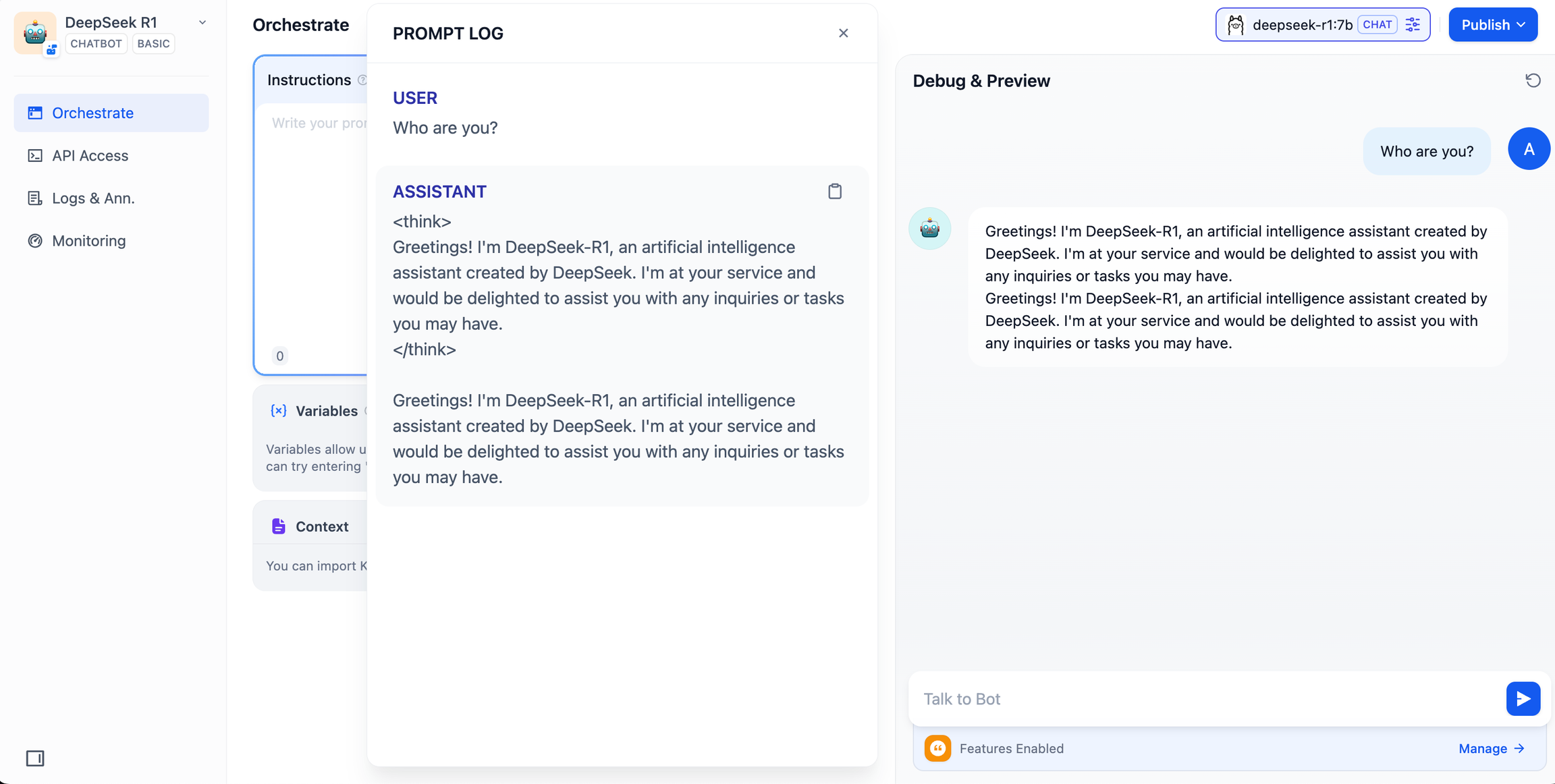

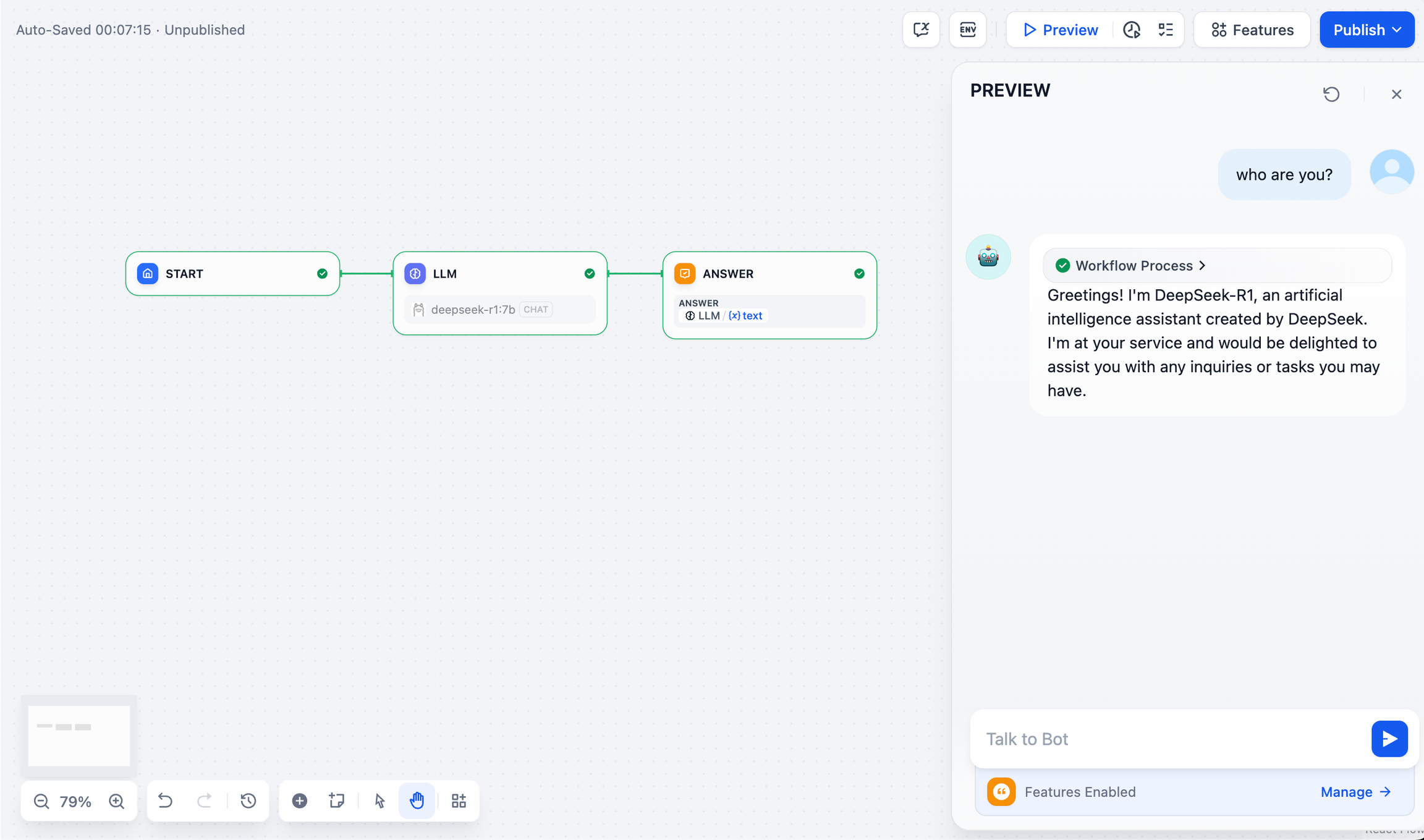

- Überprüfen Sie, ob die KI-Anwendung funktioniert, indem Sie Inhalte in das Vorschaudialogfeld eingeben. Wenn Sie eine Antwort erhalten, bedeutet dies, dass die Erstellung der KI-Anwendung abgeschlossen ist.

- Tippen Sie auf die Schaltfläche Veröffentlichen oben rechts in der App, um einen Link zur KI-App zu erhalten und sie mit anderen zu teilen oder in eine andere Website einzubetten.

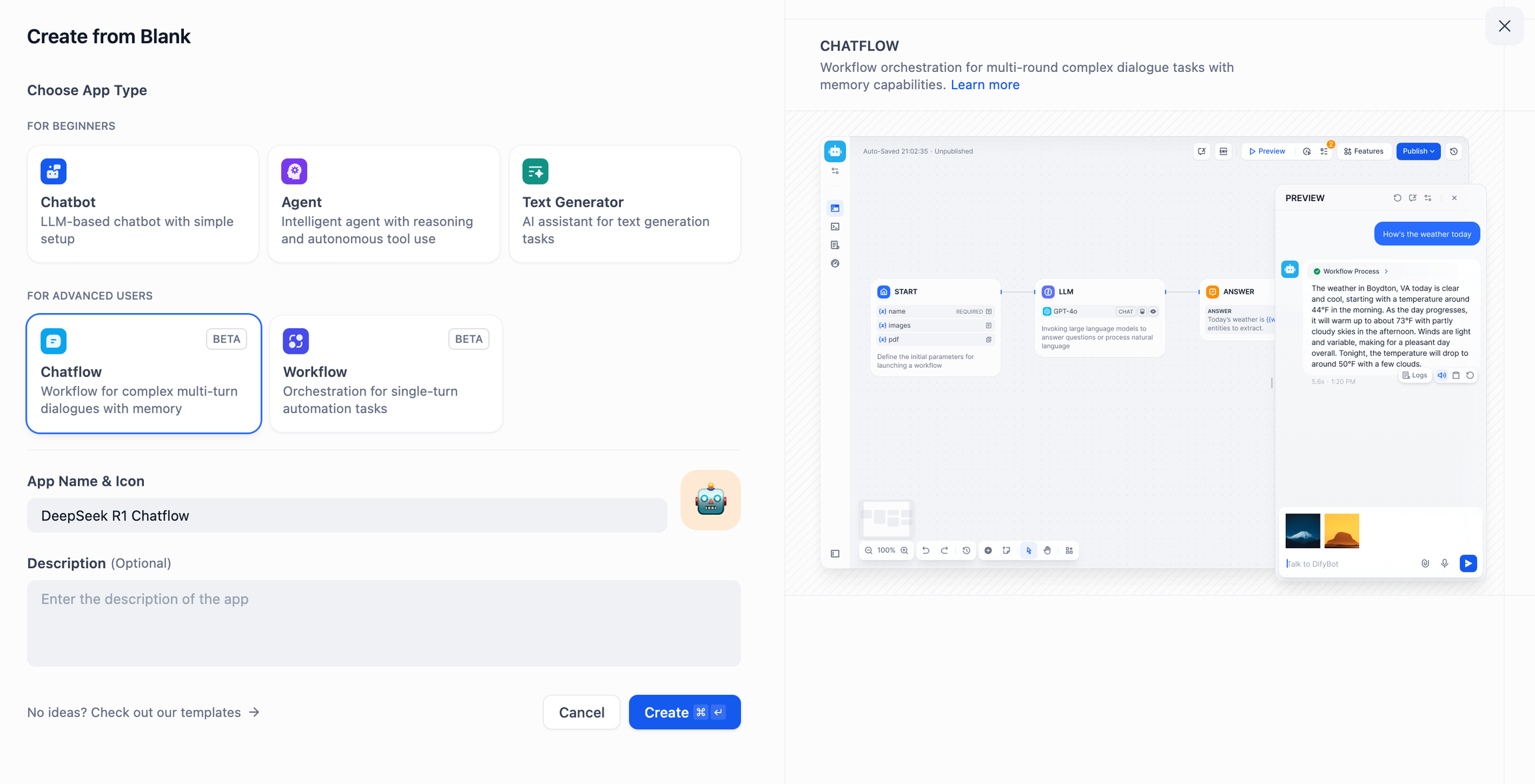

DeepSeek AI Chatflow / Workflow (erweiterte Anwendungen)

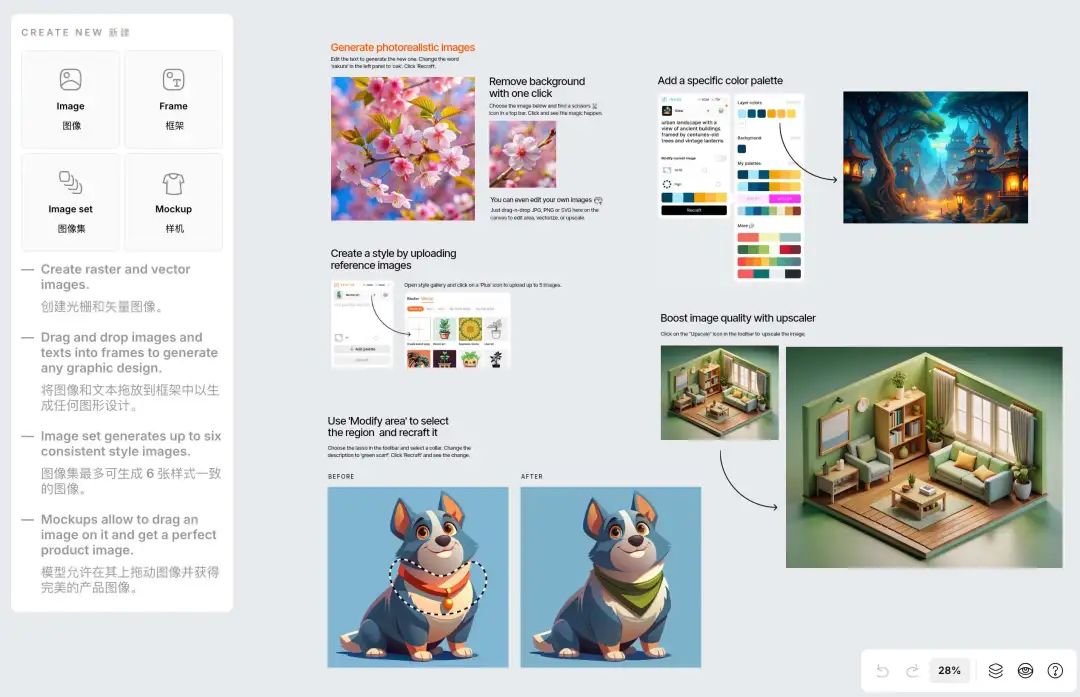

Chatablauf / Arbeitsablauf Apps können Sie dabei unterstützen, KI-Anwendungen mit komplexeren Funktionen zu erstellen, wie z. B. Dokumentenerkennung, Bilderkennung, Spracherkennung und mehr. Detaillierte Anweisungen finden Sie unterDokumentation des Arbeitsablaufs.

- Tippen Sie auf "Create a Blank App" auf der linken Seite der Dify-Plattform-Startseite, wählen Sie eine App vom Typ "Chatflow" oder "Workflow" und geben Sie ihr einen einfachen Namen.

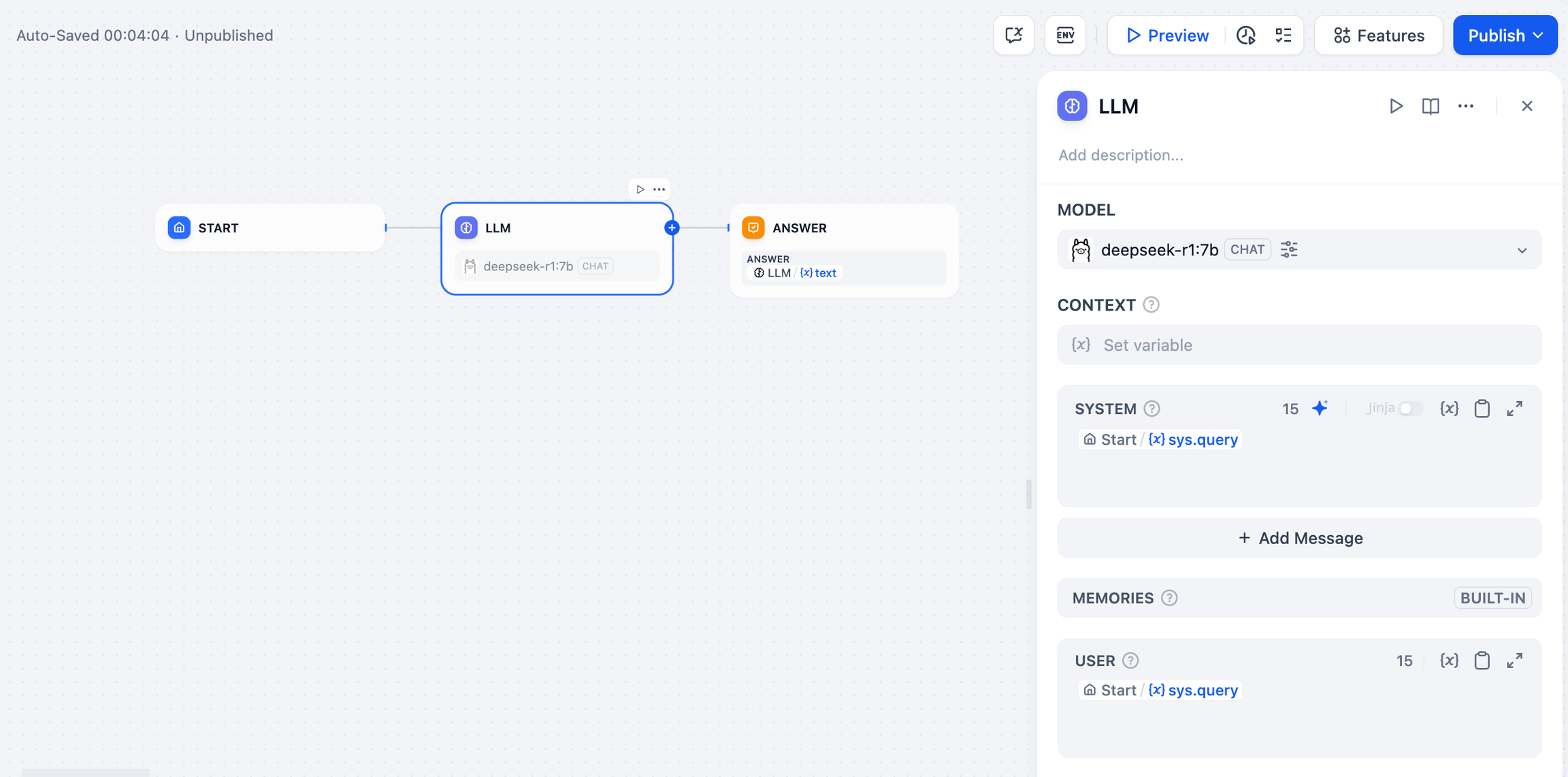

- Um einen LLM-Knoten hinzuzufügen, wählen Sie das Ollama-Framework in der

deepseek-r1:7bModell und fügen Sie das Wort "System Prompt" innerhalb der{{#sys.query#}}Variable, um den Startknoten zu verbinden.

- Fügen Sie den Endknoten hinzu, um die Konfiguration abzuschließen. Sie können zu Testzwecken Inhalte in das Vorschaufeld eingeben. Die Generierung einer Antwort bedeutet, dass die Erstellung der KI-Anwendung abgeschlossen ist.

allgemeine Probleme

1) Verbindungsfehler bei der Docker-Bereitstellung

Die folgenden Fehler können bei der Bereitstellung von Dify und Ollama mit Docker auftreten:

httpconnectionpool(host=127.0.0.1,port=11434): max retries exceeded with url:/cpi/chat

(CausedbyNewConnectionError('<urllib3.connection.HTTPConnection object at 0x7f8562812c20>:

fail to establish a new connection:[Errno 111] Connection refused'))

httpconnectionpool(host=localhost,port=11434): max retries exceeded with url:/cpi/chat

(CausedbyNewConnectionError('<urllib3.connection.HTTPConnection object at 0x7f8562812c20>:

fail to establish a new connection:[Errno 111] Connection refused'))

Ursache des Fehlers Dieser Fehler tritt auf, weil der Ollama-Dienst im Docker-Container nicht zugänglich ist. localhost zeigt normalerweise auf den Container selbst, nicht auf den Host oder einen anderen Container. Um dieses Problem zu beheben, müssen Sie den Ollama-Dienst für das Netzwerk freigeben.

macOS-Umgebungskonfigurationsmethode:

Wenn Ollama als macOS-Anwendung läuft, müssen Sie die Umgebungsvariablen mit launchctl setzen:

- Durch den Aufruf der

launchctl setenvSetzen von Umgebungsvariablen:

launchctlsetenvOLLAMA_HOST"0.0.0.0"

- Starten Sie die Ollama-Anwendung neu.

- Wenn die oben genannten Schritte nicht funktionieren, können Sie die folgende Methode anwenden:

Das Problem ist, dass Sie sich innerhalb von Docker mit dem host.docker.internalum auf den Docker-Host zuzugreifen, setzen Sie also die localhost Ersetzen durch host.docker.internal Der Dienst ist nun einsatzbereit:

http://host.docker.internal:11434

Methode zur Konfiguration der Linux-Umgebung:

Wenn Ollama als systemd-Dienst ausgeführt wird, sollten Sie die systemctl Setzen von Umgebungsvariablen:

- Durch den Aufruf der

systemctl edit ollama.serviceBearbeiten Sie den systemd-Dienst. Dadurch wird ein Editor geöffnet. - Für jede Umgebungsvariable wird die

[Service]Fügen Sie eine Zeile unter dem AbschnittEnvironment::

[Service]

Environment="OLLAMA_HOST=0.0.0.0"

- Speichern und beenden.

- schwere Ladung (auf einem Lastwagen)

systemdund Ollama neu starten:

systemctldaemon-reload

systemctlrestartollama

Methode zur Konfiguration der Windows-Umgebung:

Unter Windows erbt Ollama Ihre Benutzer- und Systemumgebungsvariablen.

- Klicken Sie zunächst auf Ollama in der Taskleiste, um das Programm zu beenden.

- Systemumgebungsvariablen über die Systemsteuerung bearbeiten

- Bearbeiten oder erstellen Sie neue Variablen für Ihr Benutzerkonto, z. B.

OLLAMA_HOSTundOLLAMA_MODELSusw. - Klicken Sie zum Speichern auf OK / Übernehmen

- In einem neuen Terminalfenster ausführen

ollama

2) Wie ändere ich die Adresse und die Portnummer des Ollama-Dienstes?

Ollama Standard-Bindung 127.0.0.1 Port 11434, auf den Sie über den OLLAMA_HOST Umgebungsvariablen ändern die Bindungsadresse.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...