Titans: Auswendiglernen in der Prüfungszeit Original: https://arxiv.org/pdf/2501.00663v1

Titans Architecture Inoffizielle Umsetzung: https://github.com/lucidrains/titans-pytorch

Erstens, Hintergrund und Motivation: Die Grenzen des Transformators und die Inspiration des menschlichen Gedächtnisses

1. Beschränkungen des Transformers: ein Engpass bei der Verarbeitung langer Sequenzen

Transformator Seit seiner Einführung konnte das Modell aufgrund seiner Leistungsfähigkeit einen wesentlichen Beitrag zur Entwicklung des Modells leistenMechanismus der Selbstaufmerksamkeitdie in Bereichen wie der Verarbeitung natürlicher Sprache und dem Computerbild revolutionäre Fortschritte gemacht hat. Mit zunehmender Aufgabenkomplexität treten bei Transformer jedoch allmählich einige kritische Probleme beim Umgang mit langen Sequenzen auf:

- Hohe Berechnungskomplexität begrenzt die Skalierbarkeit des Modells :.

- Der Mechanismus der Selbstbeobachtung erfordert die Berechnung der einzelnen Token Ähnlichkeit mit allen anderen Token in der Sequenz, mit Zeit- und Raumkomplexität von O(N²)die N ist die Sequenzlänge.

- Das bedeutet, dass der Rechen- und Speicherbedarf mit zunehmender Sequenzlänge in quadratischen Schritten ansteigt, was die Fähigkeit des Modells, lange Sequenzen zu verarbeiten, stark einschränkt. So ist Transformer oft überfordert, wenn es um Aufgaben wie lange Texte, das Verstehen von Videos oder die Vorhersage langfristiger Zeitreihen geht.

Abbildung 1: Der Berechnungsprozess des Selbstbeobachtungsmechanismus.

- Begrenztes Kontextfenster zur Erfassung von Abhängigkeiten über große Entfernungen :.

- Um den Rechenaufwand zu verringern, verwenden Transformers in der Regel ein Kontextfenster fester Länge (z. B. 512 oder 1024), was bedeutet, dass sich das Modell nur auf die Informationen innerhalb des aktuellen Fensters konzentrieren kann.

- Viele reale Aufgaben erfordern jedoch Modelle, die Abhängigkeiten über längere Zeiträume hinweg erfassen können, z. B. das Verstehen von Kontextinformationen in langen Texten oder Dialogen, die Integration von Informationen aus verschiedenen Zeitpunkten in Videos und die Erstellung von Vorhersagen anhand langfristiger Trends und Muster in historischen Daten.

2. Der Lineartransformator-Kompromiss: Wirkungsgrad versus Leistung

Um den rechnerischen Engpass von Transformer zu lösen, schlagen die Forscher dasLineartransformatorDie wichtigsten Verbesserungen sind:

- Ersetzen von softmax durch eine Kernel-Funktion. Ersetzt man die Softmax-Berechnung im Selbstbeobachtungsmechanismus durch eine Kernel-Funktion, reduziert sich der Rechenaufwand auf O(N).

- Parallelisierbares Reasoning. Der Rechenprozess des Lineartransformators kann als zyklische Form dargestellt werden, was eine effizientere Argumentation ermöglicht.

Der Lineartransformator hat jedoch auch einige Einschränkungen:

- Verschlechterung der Leistung.

- Durch den Kernel-Trick wird das Modell zu einem linearen rekurrenten Netz degradiert, bei dem die Daten zu einem matrixwertigen Zustand komprimiert werden, was zu einer Leistung führt, die der des Standard-Transformers unterlegen ist.

- Bei dieser Art der Komprimierung ist es schwierig, komplexe nichtlineare Abhängigkeiten effektiv zu erfassen.

- Probleme mit der Speicherverwaltung.

- Der Linear Transformer komprimiert historische Daten in eine Matrix fester Größe, aber bei sehr langen Kontexten führt diese Komprimierung zu einerSpeicherüberlaufwas die Leistung des Modells beeinträchtigt.

Abbildung 2: Speicheraktualisierungsprozess für den Lineartransformator.

3. Inspiration des menschlichen Gedächtnissystems: Stärkung der Mechanismen für das Langzeitgedächtnis

Um die oben genannten Herausforderungen zu bewältigen, begannen die Autorenmenschliches GedächtnissystemIn Anlehnung an die

- Die Beziehung zwischen Gedächtnis und Lernen: die

- Die Arbeit stützt sich auf Definitionen des Gedächtnisses und des Lernens aus der neuropsychologischen Literatur, wobei das Gedächtnis als neuronale Aktualisierung verstanden wird, die durch einen Input ausgelöst wird, und Lernen als der Prozess des Erwerbs effektiver und nützlicher Erinnerungen mit einem bestimmten Ziel definiert wird.

- Dies bedeutet, dassEffektives Lernen kann nicht ohne einen starken Gedächtnismechanismus erreicht werden.

- Die mehrstufige Natur des menschlichen Gedächtnisses: die

- Das menschliche Gedächtnissystem ist keine einheitliche Struktur, sondern besteht aus mehreren Teilsystemen, wie dem Kurzzeitgedächtnis, dem Arbeitsgedächtnis und dem Langzeitgedächtnis, die jeweils unterschiedliche Funktionen und Organisationsstrukturen haben und unabhängig voneinander arbeiten können.

- Diese Vielschichtigkeit ermöglicht es dem Menschen, Informationen effizient zu speichern, abzurufen und zu verwalten.

- Unzulänglichkeiten der bestehenden Modelle.

- Bestehende neuronale Netzarchitekturen (von Hopfield-Netzen bis hin zu LSTMs und Transformers) haben Probleme bei der Generalisierung, Längenextrapolation und Inferenz, Fähigkeiten, die für viele komplexe Aufgaben in der realen Welt entscheidend sind.

- Diese Architekturen waren zwar vom menschlichen Gehirn inspiriert, hatten aber alle nicht die Fähigkeit zurflüchtige Erinnerungeffektive Modellierung derMehrstufigkeit des GedächtnissystemsDie Simulation.

Zwei, Kerninnovation: Neuronales Langzeitspeicher-Modul und Titans-Architektur

Auf der Grundlage dieser Überlegungen schlagen die Autoren die folgenden Neuerungen vor:

1. Modul Neuronales Langzeitgedächtnis

(1) Gestaltungskonzept.

- Meta-kontextuelle Lernmechanismen.

- Das Modul ist konzipiert alsMetamodellLernen, wie man während der Prüfung Daten in seinen Parametern speichert.

- diese Art vonOnline-LernenAnsatz ermöglicht es dem Modell, sein Gedächtnis dynamisch an die aktuelle Eingabe anzupassen, anstatt sich auf Erinnerungen zu verlassen, die während des Vortrainings festgelegt wurden.

- Überraschungsbasierte Gedächtnisaktualisierungen : Die

- Die Autoren stützen sich auf den menschlichen Gedächtnismechanismus, wonach "überraschende Ereignisse mit größerer Wahrscheinlichkeit erinnert werden", und schlagen eine Methode vor, die aufÜberraschungsgradDer Mechanismus der Gedächtnisaktualisierung.

- ÜberraschungsgradDurch die Berechnung des neuronalen Netzes in Bezug auf die EingabeGradientJe größer der Gradient ist, desto mehr unterscheiden sich die Eingabedaten von den historischen Daten und sind es wert, dass man sie sich merkt.

- Mit dieser Methode lassen sich die wichtigsten Informationen in den Daten erfassen und im Langzeitgedächtnis speichern.

- Im Gegensatz dazu kann der Linear Transformer nur lineare Transformationen auf der Grundlage der aktuellen Eingabedaten durchführen, was die effektive Erfassung weitreichender Abhängigkeiten erschwert.

Abbildung 3: Überraschungsbasierter Speicheraktualisierungsmechanismus.

(2) Schlüsseltechnologien.

- Momentum-Mechanismen.

- Um zu verhindern, dass das Modell durch ein einziges überraschendes Ereignis zu sehr beeinflusst wird, haben die Autoren dieEigendynamik-MechanismusDabei wird die Überraschung der vergangenen Momente berücksichtigt.

- Das bedeutet, dass das Modell die Überraschungen sowohl der aktuellen als auch der historischen Eingaben berücksichtigt, was zu sanfteren Speicheraktualisierungen führt.

- Abschwächungsmechanismen.

- Um einen Speicherüberlauf zu verhindern, haben die Autoren auch dieZerfallsmechanismusMit Hilfe derGewichtsverfalleine Art, unwichtige Informationen allmählich zu vergessen.

- Der Mechanismus kann als eineGating-Mechanismusdie bei Bedarf selektiv Speicher löschen kann.

- Die Autoren weisen darauf hin, dass dieser Zerfallsmechanismus eine Verallgemeinerung des Vergessensmechanismus in modernen rekurrenten Modellen ist und der Optimierung von metaneuronalen Netzen unter kleinteiligem Gradientenabstieg, Impuls- und Gewichtszerfall entspricht.

(3) Speicherstrukturen.

- Im Gegensatz zum traditionellen linearen Gedächtnismodell verwendeten die Autoren einMehrschichtiges Perzeptron (MLP) als ein Speichermodul.

- MLP hat eine stärkere nichtlineare Darstellung und kann komplexe Informationen effizienter speichern und abrufen.

- Im Gegensatz dazu können lineare Transformatoren nur matrixwertige Zustände zur Speicherung von Informationen verwenden, was die Erfassung komplexer nichtlinearer Beziehungen erschwert.

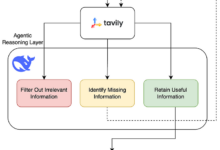

2. Titans Architektur: Integration von Langzeit- und Kurzzeitgedächtnis

Nach der Entwicklung des neuronalen Langzeitspeichermoduls haben die Autoren weiter darüber nachgedacht, wie es effektiv in eine Deep-Learning-Architektur integriert werden kann, und die Titans-Architektur mit den folgenden Hauptmerkmalen vorgeschlagen:

(1) Drei Superköpfe, die im Tandem arbeiten.

- Kern.

- Es besteht aus dem Kurzzeitgedächtnis und ist für den Hauptprozess der Datenverarbeitung zuständig.

- ausnutzenAufmerksamkeitsmechanismen für endliche Fenstergrößenwie Sliding Window Attention (SWA) oder Fully Connected Attention (FCA).

- Das Kurzzeitgedächtnis kann wie folgt betrachtet werdenKurzzeitgedächtnisdie dazu dient, Abhängigkeiten im aktuellen Kontext zu erfassen.

- Langfristiges Gedächtnis.

- Verantwortlich für die Speicherung/Erinnerung von Informationen aus der langen Vergangenheit.

- Das oben beschriebene Modul für das neuronale Langzeitgedächtnis wird verwendet.

- Das Langzeitgedächtnis kann wie folgt betrachtet werdenflüchtige Erinnerungdie dazu dient, Informationen über einen längeren Zeitraum zu speichern und abzurufen.

- Persistentes Gedächtnis.

- ist ein Satz von erlernbaren, aber datenunabhängigen Parametern, die a priori Wissen über die Aufgabe kodieren.

- Ähnlich wie die Parameter der vollständig verbundenen Ebene in Transformer, aber mit anderer Funktionalität.

- Das persistente Gedächtnis kann betrachtet werden alsMetaspeicherdie zur Speicherung von aufgabenbezogenem Wissen, wie Grammatikregeln, Wissen über den gesunden Menschenverstand usw., verwendet wird.

Abbildung 4: Schematische Darstellung der Titans-Architektur (MAC-Variante).

(2) Drei verschiedene Arten der Integration.

- Erinnerung als Kontext (MAC).

- Verknüpfung von langen und dauerhaften Erinnerungen mit Eingabesequenzen als zusätzliche Information zum aktuellen Kontext.

- Aufmerksamkeitsmechanismen bestimmen, welche Informationen im Langzeitgedächtnis gespeichert werden müssen.

- Zum Testzeitpunkt wurden die Parameter des Langzeitgedächtnisses beibehalten und das Aufmerksamkeitsmodul für kontextbezogenes Lernen gewichtet, während das Langzeitgedächtnismodul weiterhin Informationen lernte/erinnerte.

- Diese Konstruktion ermöglicht es dem Modell, die Informationen des Langzeitgedächtnisses auf der Grundlage der aktuellen Eingaben flexibel zu nutzen.

- Erinnerung als Gating (MAG).

- Verwendung der Sliding-Window-Aufmerksamkeit als Kurzzeitgedächtnis und neuronaler Speichermodule als Langzeitgedächtnis.

- Kombination der beiden durch Gating-Mechanismen, z.B. Normalisierung der beiden durch lernfähige vektorwertige Gewichte und anschließende Anwendung einer nichtlinearen Aktivierungsfunktion.

- Dieser Entwurf kann als eine Mehrkopfarchitektur betrachtet werden, bei der die verschiedenen Köpfe unterschiedlich strukturiert sind.

Abbildung 5: Verschiedene Varianten der Titans-Architektur (MAC und MAG). - Speicher als Schicht (MAL).

- Die Verwendung des neuronalen Speichermoduls als Schicht eines tiefen neuronalen Netzes komprimiert vergangene und aktuelle Kontextinformationen vor dem Aufmerksamkeitsmodul.

- Dieses Design ist in der Literatur häufiger anzutreffen, zum Beispiel das H3-Modell.

(3) Stärken.

- Flexiblere Speicherverwaltung.

- Durch die Verwendung von Speichermodulen als kontextabhängige Verzweigungen ist die Titans-Architektur in der Lage, die Informationen des Langzeitgedächtnisses dynamisch auf der Grundlage der aktuellen Eingabe zu nutzen.

- Dies bietet mehr Flexibilität als der traditionelle Ansatz, Speichermodule als Schichten zu verwenden.

- Stärkerer Ausdruck.

- Durch die Synergie der drei Superköpfe kann die Titans-Architektur lange sequentielle Daten effizienter verarbeiten und die Vorteile von Kurzzeitspeicher, Langzeitspeicher und persistentem Speicher integrieren.

- Skalierbarkeit.

- Im Vergleich zu Transformer ist die Titans-Architektur besser skalierbar, wenn es um lange Sequenzen geht, und sie ist in der Lage, eine hohe Leistung über ein größeres Kontextfenster hinweg beizubehalten.

Drittens, Experimentelle Ergebnisse und Analyse: Validierung der Titans-Architektur

Die Autoren führten umfangreiche Experimente mit verschiedenen Aufgaben durch, um die Leistung der Titans-Architektur und ihrer Varianten zu bewerten:

1. Linguistische Modellierung und Common Sense Reasoning.

- Versuchsaufbau.

- Es wurden drei Titans-Modelle unterschiedlicher Größe (340M, 400M, 760M Parameter) sowie mehrere Basismodelle einschließlich Transformer++, RetNet, GLA, Mamba, Mamba2, DeltaNet, TTT und Gated DeltaNet verwendet.

- Der FineWeb-Edu-Datensatz wurde als Trainingsdaten verwendet.

- Wichtigste Ergebnisse.

- Im ungemischten Modell erzielte das neuronale Langzeitgedächtnismodul die beste Leistung sowohl bei der Perplexität als auch bei der Genauigkeit.

- Alle drei Varianten von Titans (MAC, MAG, MAL) schnitten besser ab als Samba (Mamba + Aufmerksamkeit) und Gated DeltaNet-H2 (Gated DeltaNet + Aufmerksamkeit).

- MAC schneidet bei der Bewältigung von Abhängigkeiten über große Entfernungen besser ab, während sowohl MAG als auch MAC die MAL-Variante übertreffen.

Abbildung 6: Vergleich der Leistung von Titans mit dem Basismodell bei Aufgaben zur Sprachmodellierung und zum Schlussfolgern mit gesundem Menschenverstand.

2. Mission "Die Nadel im Heuhaufen".

- Versuchsaufbau.

- Mit Hilfe der Aufgabe Single NIAH (S-NIAH) im RULER-Benchmarking wurde die Abruffähigkeit des Modells bei Sequenzen von 2K, 4K, 8K und 16K Länge bewertet.

- Wichtigste Ergebnisse.

- Das Modul Neuronales Langzeitgedächtnis erzielte bei allen drei Aufgaben die besten Ergebnisse.

- Auch die Titans-Varianten schnitten gut ab, wobei die MAC-Variante am besten abschnitt.

3. BABILong Benchmarking.

- Versuchsaufbau.

- Die Aufgabe erfordert, dass das Modell über verteilte Sachinformationen in extrem langen Dokumenten nachdenkt.

- Es gibt Einstellungen für weniger Stichproben und für die Feineinstellung.

- Wichtigste Ergebnisse.

- In der Einstellung mit weniger Stichproben übertrifft Titans alle Basismodelle, einschließlich der Modelle mit einer größeren Anzahl von Parametern, wie GPT-4 und GPT4o-mini.

- Auch bei der Feinabstimmung übertrifft Titans alle Modelle, selbst sehr große Modelle wie GPT-4.

- Im Vergleich zu transformatorbasierten Speichermodellen (RMT) weisen die Titans eine bessere Leistung auf, was vor allem auf ihre starken Speicherkapazitäten zurückzuführen ist.

Abbildung 7: Vergleich der Leistung von Titans mit dem Basismodell beim BABILong-Benchmark.

4. Zeitreihenprognosen.

- Versuchsaufbau.

- Unter Verwendung des Simba-Frameworks wurde das Mamba-Modul durch ein neuronales Langzeitgedächtnismodul ersetzt.

- Evaluiert anhand von ETT-, ECL-, Verkehrs- und Wetter-Benchmark-Datensätzen.

- Wichtigste Ergebnisse.

- Das neuronale Langzeitspeichermodul übertrifft alle Baselines, einschließlich Mamba, Linear Model und Transformer-basierte Architekturen.

5. DNA-Modellierung.

- Versuchsaufbau.

- Bewerten Sie die nachgelagerte Aufgabenleistung von vortrainierten Modellen anhand von GenomicsBenchmarks.

- Wichtigste Ergebnisse.

- Titans (LMM) ist bei verschiedenen nachgelagerten Genomikaufgaben wettbewerbsfähig und kann mit den modernsten Methoden mithalten.

6. Analyse der Effizienz.

- Wichtigste Ergebnisse.

- Das Neuronale Langzeitgedächtnismodul ist im Vergleich zu anderen rekurrenten Modellen etwas langsamer zu trainieren, was vor allem auf den tieferen Speicher und den komplexeren Transformationsprozess sowie auf den in Mamba2 implementierten hoch optimierten Kernel zurückzuführen ist.

- Titans (MAL) ist schneller als die Baseline und das Speichermodul, was vor allem auf die Verwendung des hoch optimierten FlashAttention-Kernels zurückzuführen ist.

7. Studien zur Ablation.

- Wichtigste Ergebnisse.

- Alle Komponenten des neuronalen Speicherdesigns tragen positiv zur Leistung bei, wobei Gewichtsverfall, Impuls, Faltung und persistenter Speicher den größten Beitrag leisten.

- Das Architekturdesign hat ebenfalls einen signifikanten Einfluss auf die Leistung, wobei MAC und MAG bei Aufgaben zur Sprachmodellierung und zum logischen Schlussfolgern nahezu gleich gut abschneiden, während MAC bei Aufgaben mit langem Kontext besser abschneidet.

Vier, Innovative Punkte und Stärken der Arbeit

- Es wird ein neues neuronales Langzeitgedächtnismodul vorgeschlagen: das

- Es nutzt Schlüsselelemente menschlicher Gedächtnismechanismen wie Überraschung, Impuls und Vergessen, um eine effizientere Gedächtnisaktualisierung und -speicherung zu erreichen.

- Ein tiefes neuronales Netz wird als Speichermodul verwendet, um dem Modell mehr Ausdruckskraft zu verleihen.

- Die Titans-Architektur wurde so konzipiert, dass sie Langzeit- und Kurzzeitgedächtnis kombiniert.

- Es werden drei verschiedene Integrationsansätze vorgeschlagen, die flexible Optionen für unterschiedliche Anwendungsszenarien bieten.

- Durch die Synergie der drei Superköpfe, Kern, Langzeitspeicher und persistenter Speicher, kann das Modell lange sequentielle Daten effizienter verarbeiten.

- Hervorragende Beherrschung mehrerer Aufgaben.

- Ob bei der Sprachmodellierung, dem logischen Schlussfolgern, der Zeitreihenvorhersage oder der DNA-Modellierung - die Titans-Architektur zeigt eine starke Leistung, die bestehende Transformer- und lineare Schleifenmodelle übertrifft.

- Skalierbar.

- Die Fähigkeit, eine hohe Leistung über ein größeres Kontextfenster aufrechtzuerhalten, eröffnet die Möglichkeit, sehr lange Sequenzen zu verarbeiten.

Fünf, Zukunftsaussichten

Die Titans-Architektur hat zwar in vielerlei Hinsicht beeindruckende Ergebnisse erbracht, doch gibt es immer noch die folgenden Richtungen, die weiter erforscht werden sollten.

- Erforschung komplexerer Speichermodularchitekturen: die

- Zum Beispiel die Einführung hierarchischer Speicherstrukturen oder die Kombination von Speichermodulen mit anderen Modellen wie graphischen neuronalen Netzen.

- Entwicklung effizienterer Mechanismen für die Aktualisierung und Speicherung des Speichers.

- So werden beispielsweise Sparsifizierungstechniken oder Quantisierungstechniken eingesetzt, um den Speicherverbrauch und die Rechenkosten zu reduzieren.

- Anwendung der Titans-Architektur auf ein breiteres Spektrum von Bereichen.

- Beispiele hierfür sind Videoverstehen, Robotersteuerung, Empfehlungssysteme usw.

- Erforschung effektiverer Ausbildungsstrategien.

- Zum Beispiel die Einführung fortschrittlicherer Optimierungsalgorithmen oder die Verwendung von Meta-Learning zur Beschleunigung der Modellschulung.

- Untersuchung der Interpretierbarkeit der Architektur der Titanen.

- Ein tieferes Verständnis der Art und Weise, wie Titans Informationen im Langzeitgedächtnis speichert und nutzt, könnte neue Ideen für den Aufbau leistungsfähigerer KI-Systeme liefern.

Sechs, Zusammenfassungen

Das ist der zentrale Beitrag dieses Papiers:

- Ein neuartiges neuronales Langzeitgedächtnismodul wird vorgeschlagenDas Design ist vom menschlichen Gedächtnissystem inspiriert und beinhaltet Schlüsselkonzepte des Deep Learning wie Gradientenabstieg, Momentum und Gewichtsabnahme.

- Die Architektur der Titanen gebautdie das Langzeit- und das Kurzzeitgedächtnis organisch miteinander verbindet und drei verschiedene Integrationsmethoden erforscht, die flexible Optionen für unterschiedliche Anwendungsszenarien bieten.

- Die überragende Leistung von Titans wurde in strengen Versuchen nachgewiesen.die bei mehreren Aufgaben gut abschneidet, vor allem bei Aufgaben mit langem Kontext, und dabei eine gute Skalierbarkeit und höhere Genauigkeit aufweist.