Allgemeine Einführung

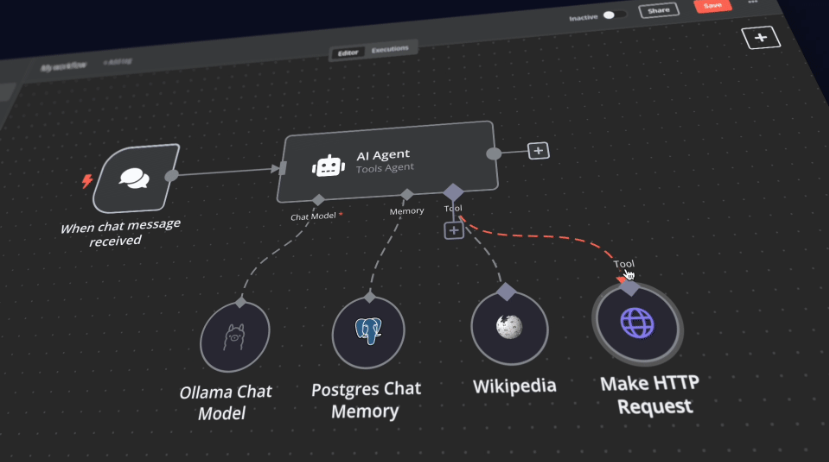

Das n8n Self-Hosted AI Starter Kit ist eine Open-Source-Docker-Compose-Vorlage, die für die schnelle Initialisierung einer umfassenden lokalen KI- und Low-Code-Entwicklungsumgebung entwickelt wurde. Die vom n8n-Team kuratierte Suite kombiniert die selbst gehostete n8n-Plattform mit einer Reihe von kompatiblen KI-Produkten und -Komponenten, damit Benutzer schnell selbst gehostete KI-Workflows erstellen können. Die Suite umfasst die Low-Code-Plattform n8n, die plattformübergreifende LLM-Plattform Ollama, den Hochleistungs-Vektorspeicher Qdrant und eine PostgreSQL-Datenbank für eine Vielzahl von KI-Anwendungsszenarien wie intelligente Agenten, Dokumentenzusammenfassung, intelligente Chatbots und die Analyse privater Finanzdokumente.

Funktionsliste

- n8n Low-Code-PlattformBietet über 400 integrierte und fortschrittliche KI-Komponenten zur Unterstützung schneller Build-Workflows.

- Ollama-PlattformPlattformübergreifende LLM-Plattform mit Unterstützung für die Installation und Ausführung der neuesten nativen LLM.

- Qdrant-VektorspeicherOpen-Source-Hochleistungs-Vektorspeicher mit einer umfassenden API.

- PostgreSQL-DatenbankZuverlässige Datenbank für die Verarbeitung großer Datenmengen.

- Intelligente AgentenKI-Agenten für die Planung von Besprechungen und Aufgaben.

- DokumentzusammenfassungSichere Zusammenfassung von PDF-Dokumenten des Unternehmens und Vermeidung von Datenverlusten.

- Intelligente ChatbotsIntelligente Slack-Bots, die die Unternehmenskommunikation und den IT-Betrieb verbessern.

- Analyse der privaten FinanzunterlagenPrivate Analyse von Finanzdokumenten zu den geringstmöglichen Kosten.

Hilfe verwenden

Ablauf der Installation

- Klon-Lager::

bash

git clone https://github.com/n8n-io/self-hosted-ai-starter-kit.git

cd selbstgehostetes-ai-starter-kit

- n8n mit Docker Compose ausführen::

- Für Benutzer von Nvidia-GPUs:

docker compose --profile gpu-nvidia upHinweis: Wenn Sie noch nie eine Nvidia GPU mit Docker verwendet haben, folgen Sie den Anweisungen für Ollama Docker.

- Für Mac/Apple Silicon Benutzer:

- Option 1: Läuft vollständig auf der CPU:

docker compose --profile cpu up - Option 2: Führen Sie Ollama auf Ihrem Mac aus und verbinden Sie sich mit der n8n-Instanz:

docker compose upÄndern Sie dann die Ollama-Zugangsdaten, indem Sie

http://host.docker.internal:11434/Als Gastgeber.

- Option 1: Läuft vollständig auf der CPU:

- Für andere Benutzer:

docker compose --profile cpu up

- Für Benutzer von Nvidia-GPUs:

Richtlinien für die Verwendung

- Start n8n::

- Interviews

http://localhost:5678geben Sie die n8n-Schnittstelle ein. - Melden Sie sich mit Ihrem Standardkonto an oder erstellen Sie ein neues Konto.

- Interviews

- Arbeitsabläufe erstellen::

- Klicken Sie in der n8n-Oberfläche auf "Neuer Workflow".

- Ziehen Sie den gewünschten Knoten aus dem linken Menü auf die Arbeitsfläche.

- Konfigurieren Sie die Parameter und Verbindungen für jeden Knoten.

- Laufende Workflows::

- Sobald die Konfiguration abgeschlossen ist, klicken Sie auf die Schaltfläche Ausführen, um den Workflow auszuführen.

- Anzeigen der Ergebnisse und Protokolle der Workflow-Ausführung.

Schnellstart und Nutzung

Das Herzstück des Self-Hosted AI Starter Kits ist eine Docker Compose-Datei mit vorkonfigurierten Netzwerk- und Speichereinstellungen, so dass keine zusätzliche Installation erforderlich ist. Sobald Sie die Installationsschritte abgeschlossen haben, folgen Sie einfach den folgenden Schritten, um loszulegen:

- Öffnen Sie http://localhost:5678/设置n8n. Dieser Vorgang muss nur einmal durchgeführt werden.

- Öffnen Sie den mitgelieferten Workflow: http://localhost:5678/workflow/srOnR8PAY3u4RSwb.

- OptionTest ArbeitsablaufStarten Sie die Ausführung des Workflows.

- Wenn Sie diesen Arbeitsablauf zum ersten Mal ausführen, müssen Sie möglicherweise warten, bis der Ollama-Download von Llama 3.2 abgeschlossen ist. Sie können den Fortschritt in den Protokollen der Docker-Konsole nachsehen.

Besuchen Sie dazu http://localhost:5678/来打开n8n.

Mit Ihrer n8n-Instanz haben Sie Zugriff auf über 400 Integrationen sowie eine Reihe von grundlegenden und fortgeschrittenen KI-Knoten wie KI-Agent, Textklassifizierer und Informationsextraktor-Knoten. Stellen Sie sicher, dass die lokale Laufzeit den Ollama-Knoten als Sprachmodell und Qdrant als Vektorspeicher verwendet.

"zur Kenntnis nehmenDieses Starter-Kit wurde entwickelt, um Ihnen den Einstieg in selbst gehostete KI-Workflows zu erleichtern. Es ist zwar nicht vollständig für Produktionsumgebungen optimiert, aber es kombiniert leistungsstarke Komponenten, die nahtlos zusammenarbeiten, und ist damit ideal für Proof-of-Concept-Projekte. Sie können es an Ihre Bedürfnisse anpassen.

"

Upgrade-Anweisungen

-

Für Nvidia-GPU-Einstellungen:

docker compose --profile gpu-nvidia pull

docker compose create && docker compose --profile gpu-nvidia up

Für Mac-/Apfel-Silikon-Benutzer

docker compose pull

docker compose create && docker compose up

-

Für Nicht-GPU-Einstellungen:

docker compose --profile cpu pull

docker compose create && docker compose --profile cpu up